Rumah >Peranti teknologi >AI >Wayformer: Rangkaian perhatian yang mudah dan berkesan untuk ramalan gerakan

Wayformer: Rangkaian perhatian yang mudah dan berkesan untuk ramalan gerakan

- PHPzke hadapan

- 2023-04-09 21:31:121327semak imbas

Kertas arXiv "Wayformer: Motion Forecasting melalui Rangkaian Perhatian Mudah & Cekap", yang dimuat naik pada Julai 2022, adalah hasil kerja Google Waymo.

Ramalan pergerakan untuk pemanduan autonomi ialah tugas yang mencabar kerana senario pemanduan yang kompleks menghasilkan pelbagai bentuk input statik dan dinamik yang bercampur. Cara terbaik untuk mewakili dan menggabungkan maklumat sejarah tentang geometri jalan, ketersambungan lorong, keadaan lampu isyarat yang berubah-ubah masa, dan set ejen dinamik serta interaksi mereka ke dalam pengekodan yang cekap ialah masalah yang tidak dapat diselesaikan . Untuk memodelkan set ciri input yang pelbagai ini, terdapat banyak pendekatan untuk mereka bentuk sistem yang sama kompleks dengan set modul khusus modaliti yang berbeza. Ini mengakibatkan sistem yang sukar untuk menskalakan, menskalakan atau menukar kualiti dan kecekapan dengan cara yang ketat.

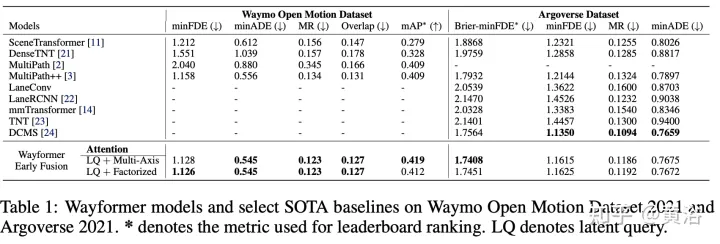

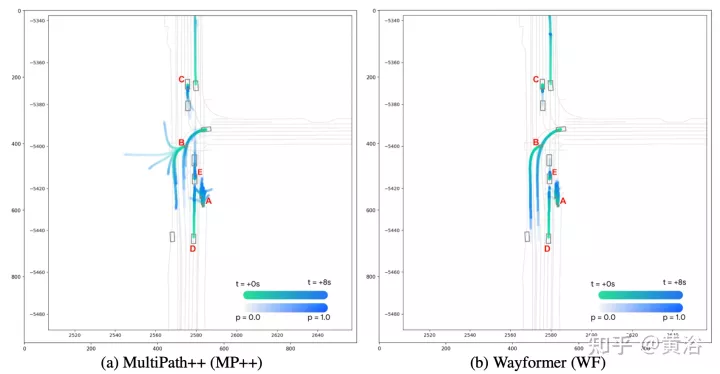

The Wayformer dalam artikel ini ialah satu siri seni bina ramalan gerakan berasaskan perhatian yang ringkas dan serupa. Wayformer menyediakan penerangan model padat yang terdiri daripada pengekod dan penyahkod pemandangan berasaskan perhatian. Dalam pengekod tempat kejadian, pemilihan mod input pra-gabungan, pasca-gabungan dan hierarki mod input dikaji. Untuk setiap jenis gabungan, terokai strategi yang menukar kecekapan dan kualiti melalui perhatian penguraian atau perhatian pertanyaan terpendam. Struktur pra-gabungan adalah mudah dan bukan sahaja mod-agnostik, tetapi juga mencapai hasil terkini pada kedua-dua Waymo Open Movement Dataset (WOMD) dan papan pendahulu Argoverse.

Adegan memandu terdiri daripada data berbilang modal, seperti maklumat jalan raya, status lampu isyarat, sejarah ejen dan interaksi. Untuk modaliti, terdapat Konteks dimensi ke-4, yang mewakili "set matlamat kontekstual" untuk setiap ejen yang dimodelkan (iaitu perwakilan pengguna jalan raya yang lain).

Sejarah IntelekMengandungi satu siri keadaan ejen masa lalu serta keadaan semasa. Untuk setiap langkah masa, pertimbangkan ciri yang mentakrifkan keadaan ejen, seperti x, y, halaju, pecutan, kotak sempadan, dsb., serta dimensi konteks.

Tensor interaksi mewakili hubungan antara ejen. Bagi setiap ejen yang dimodelkan, bilangan tetap konteks jiran terdekat di sekitar ejen yang dimodelkan dipertimbangkan. Ejen kontekstual ini mewakili ejen yang mempengaruhi tingkah laku ejen yang dimodelkan.

Peta jalan mengandungi ciri jalan di sekeliling ejen. Segmen peta jalan diwakili sebagai polylines, koleksi segmen yang ditentukan oleh titik akhirnya dan diberi anotasi dengan maklumat jenis yang menghampiri bentuk jalan. Gunakan segmen peta jalan yang paling hampir dengan ejen pemodelan. Sila ambil perhatian bahawa ciri jalan tidak mempunyai dimensi masa dan dimensi masa 1 boleh ditambah.

Untuk setiap ejen, maklumat lampu isyarat mengandungi keadaan isyarat trafik yang paling hampir dengan ejen. Setiap titik isyarat trafik mempunyai ciri yang menerangkan lokasi dan keyakinan isyarat.

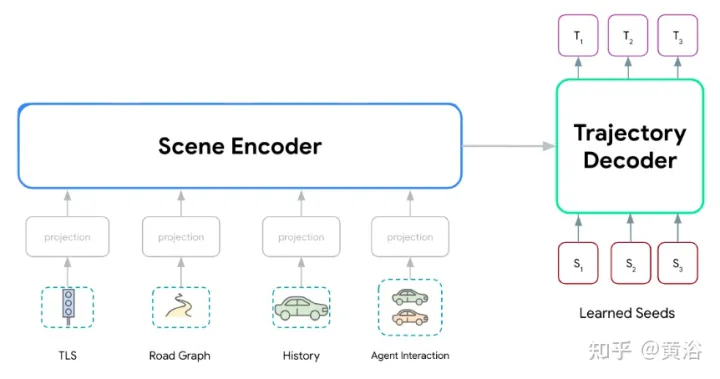

Siri model Wayformer, yang terdiri daripada dua komponen utama: pengekod pemandangan dan penyahkod. Pengekod pemandangan terutamanya terdiri daripada satu atau lebih pengekod perhatian, yang digunakan untuk meringkaskan adegan memandu. Penyahkod ialah satu atau lebih modul perhatian silang pengubah standard, yang memasukkan pertanyaan awal yang dipelajari dan kemudian menjana trajektori dengan pengekodan pemandangan silang perhatian.

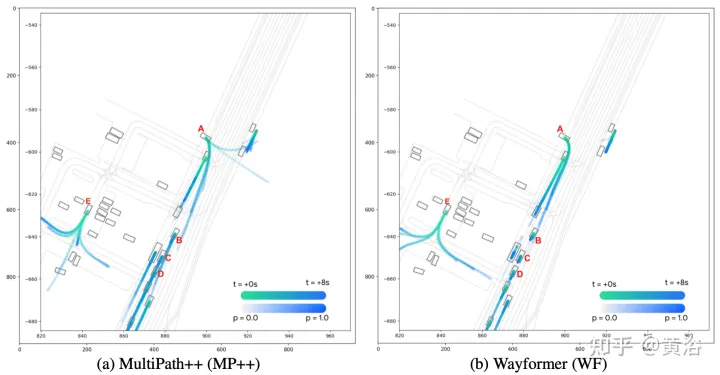

Seperti yang ditunjukkan dalam rajah, model Wayformer memproses input berbilang modal untuk menghasilkan pengekodan pemandangan: Pengekodan pemandangan ini digunakan sebagai konteks penyahkod, menjana k kemungkinan trajektori meliputi berbilang modaliti dalam ruang output.

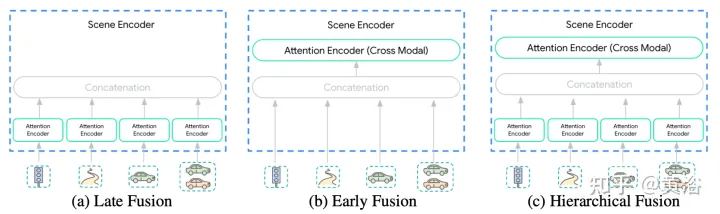

Kepelbagaian input kepada pengekod adegan menjadikan penyepaduan ini tugas yang tidak remeh. Modaliti mungkin tidak diwakili pada tahap atau skala abstraksi yang sama: {pixels vs target objects}. Oleh itu, beberapa modaliti mungkin memerlukan lebih banyak pengiraan daripada yang lain. Penguraian pengiraan antara mod bergantung pada aplikasi dan sangat penting untuk jurutera. Tiga tahap gabungan dicadangkan di sini untuk memudahkan proses ini: {Post, Pre, Grade}, seperti yang ditunjukkan dalam rajah:

Post fusion ialah gerakan ramalan Pendekatan yang paling biasa untuk model di mana setiap modaliti mempunyai pengekod khusus tersendiri. Menetapkan lebar pengekod ini supaya sama mengelak daripada memperkenalkan lapisan unjuran tambahan dalam output. Tambahan pula, dengan berkongsi kedalaman yang sama merentas semua pengekod, ruang penerokaan dikurangkan kepada saiz yang boleh diurus. Maklumat hanya dibenarkan untuk dipindahkan merentasi modaliti dalam lapisan perhatian silang penyahkod trajektori.

Pra-gabunganDaripada mendedikasikan pengekod perhatian kendiri kepada setiap modaliti, kami mengurangkan parameter khusus modaliti kepada lapisan unjuran. Pengekod adegan dalam rajah terdiri daripada pengekod perhatian kendiri tunggal ("pengekod rentas modal"), membenarkan rangkaian mempunyai fleksibiliti maksimum dalam memberikan kepentingan merentas modaliti sambil mempunyai bias induktif minimum.

Penyatuan Hierarki Sebagai kompromi antara dua ekstrem pertama, volum diuraikan dalam cara hierarki antara pengekod perhatian kendiri khusus modaliti dan pengekod rentas mod. Seperti yang dilakukan dalam pasca gabungan, lebar dan kedalaman dikongsi dalam pengekod perhatian dan pengekod mod silang. Ini secara berkesan membahagikan kedalaman pengekod pemandangan antara pengekod khusus modaliti dan pengekod rentas mod.

Rangkaian pengubah tidak berskala baik kepada jujukan berbilang dimensi yang besar disebabkan oleh dua faktor berikut:

- (a) Perhatian kendiri adalah kuadratik kepada panjang jujukan input.

- (b) Rangkaian suapan hadapan kedudukan ialah subrangkaian yang mahal.

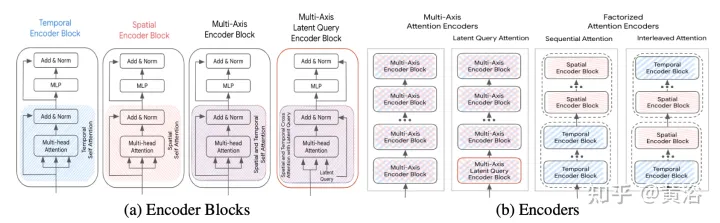

Kaedah pecutan dibincangkan di bawah (S ialah dimensi spatial, T ialah dimensi domain masa), dan rangka kerjanya adalah seperti yang ditunjukkan dalam rajah:

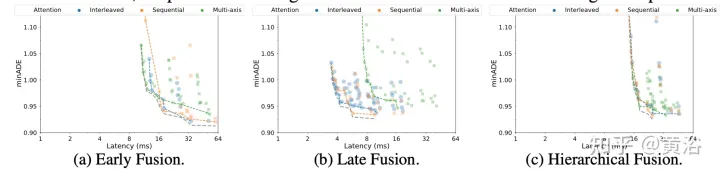

Perhatian Berbilang Paksi: Ini merujuk kepada tetapan pengubah lalai, yang menggunakan perhatian kendiri dalam kedua-dua dimensi spatial dan temporal, dan dijangka paling mahal dari segi pengiraan. Kerumitan pengiraan gabungan anterior, posterior dan hierarki dengan perhatian berbilang paksi ialah O(Sm2×T2).

Perhatian terfaktor: Kerumitan pengiraan perhatian kendiri ialah kuadratik panjang jujukan input. Ini menjadi lebih jelas dalam jujukan berbilang dimensi, kerana setiap dimensi tambahan meningkatkan saiz input dengan faktor pendaraban. Sebagai contoh, beberapa modaliti input mempunyai dimensi masa dan ruang, jadi skala kos pengiraan O(Sm2×T2). Untuk mengurangkan keadaan ini, pertimbangkan untuk menguraikan perhatian sepanjang dua dimensi. Kaedah ini mengeksploitasi struktur berbilang dimensi bagi jujukan input dan mengurangkan kos subrangkaian perhatian kendiri daripada O(S2×T2) kepada O(S2)+O(T2) dengan menggunakan perhatian kendiri dalam setiap dimensi secara individu.

Walaupun perhatian terurai berpotensi untuk mengurangkan usaha pengiraan berbanding perhatian berbilang paksi, kerumitan diperkenalkan apabila menggunakan perhatian kendiri pada susunan setiap dimensi. Di sini kita membandingkan dua paradigma perhatian terurai:

- Perhatian berurutan (perhatian berurutan) : Pengekod lapisan N terdiri daripada blok pengekod temporal N/2 dan satu lagi N/2 Ia terdiri blok pengekod spatial.

- Perhatian bersilang : Pengekod lapisan N terdiri daripada blok pengekod temporal dan ruang berselang-seli N/2 kali.

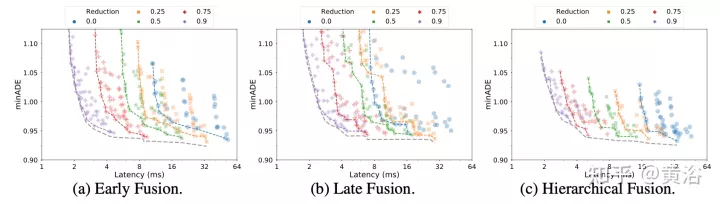

Perhatian pertanyaan terpendam : Satu lagi cara untuk menyelesaikan kos pengiraan jujukan input yang besar ialah menggunakan pertanyaan terpendam dalam blok pengekod pertama, di mana input dipetakan ke ruang terpendam. Pembolehubah terpendam ini diproses selanjutnya oleh satu siri blok pengekod yang menerima dan mengembalikan ruang terpendam. Ini membolehkan kebebasan sepenuhnya dalam menetapkan resolusi ruang terpendam, mengurangkan kos pengiraan komponen perhatian kendiri dan rangkaian suapan ke hadapan kedudukan dalam setiap blok. Tetapkan jumlah pengurangan (R=Lout/Lin) sebagai peratusan panjang jujukan input. Dalam gabungan pasca dan gabungan hierarki, faktor pengurangan R kekal tidak berubah untuk semua pengekod perhatian.

Peramal Wayformer mengeluarkan campuran Gaussian, mewakili trajektori yang mungkin diambil oleh ejen. Untuk menjana ramalan, penyahkod Transformer digunakan, yang memasukkan satu set pertanyaan awal yang dipelajari (Si) dan melakukan perhatian silang dengan benam pemandangan pengekod untuk menjana benam bagi setiap komponen campuran Gaussian.

Memandangkan pembenaman komponen tertentu dalam campuran, lapisan unjuran linear menghasilkan kemungkinan log bukan kanonik bagi komponen itu, menganggarkan keseluruhan kemungkinan campuran. Untuk menjana trajektori, satu lagi unjuran lapisan linear digunakan, mengeluarkan 4 siri masa yang sepadan dengan min dan sisihan piawai logaritma Gaussian yang diramalkan pada setiap langkah masa.

Semasa latihan, pecahkan kerugian kepada kerugian klasifikasi dan regresi masing-masing. Dengan mengandaikan k Gaussians yang diramalkan, kemungkinan campuran dilatih untuk memaksimumkan kebarangkalian log bagi trajektori sebenar.

Jika peramal mengeluarkan campuran Gaussian dengan berbilang mod, adalah sukar untuk membuat alasan dan langkah penanda aras selalunya mengehadkan bilangan trajektori yang dipertimbangkan. Oleh itu, semasa proses penilaian, pengagregatan trajektori digunakan, mengurangkan bilangan mod yang dipertimbangkan sambil mengekalkan kepelbagaian campuran keluaran asal.

Keputusan percubaan adalah seperti berikut:

Nota tentang penguraian

Pertanyaan terpendam

Atas ialah kandungan terperinci Wayformer: Rangkaian perhatian yang mudah dan berkesan untuk ramalan gerakan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI