Rumah >Peranti teknologi >AI >Penyelidikan baharu daripada Google dan DeepMind: Bagaimanakah kecenderungan induktif mempengaruhi penskalaan model?

Penyelidikan baharu daripada Google dan DeepMind: Bagaimanakah kecenderungan induktif mempengaruhi penskalaan model?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-09 20:21:011285semak imbas

Penskalaan model Transformer telah membangkitkan minat penyelidikan ramai sarjana sejak beberapa tahun kebelakangan ini. Walau bagaimanapun, tidak banyak yang diketahui tentang sifat penskalaan bagi bias induktif yang berbeza yang dikenakan oleh seni bina model. Selalunya diandaikan bahawa penambahbaikan pada skala tertentu (pengiraan, saiz, dll.) boleh dipindahkan ke skala dan kawasan pengiraan yang berbeza.

Walau bagaimanapun, adalah penting untuk memahami interaksi antara seni bina dan undang-undang penskalaan, dan ia adalah kepentingan penyelidikan yang besar untuk mereka bentuk model yang berprestasi baik pada skala yang berbeza. Beberapa soalan masih perlu dijelaskan: Adakah skala seni bina model berbeza? Jika ya, bagaimanakah kecenderungan induktif mempengaruhi prestasi penskalaan? Bagaimanakah ia mempengaruhi tugas huluan (pra-latihan) dan hiliran (pemindahan)?

Dalam kertas kerja baru-baru ini, penyelidik di Google berusaha untuk memahami kesan bias induktif (seni bina) pada penskalaan model bahasa . Untuk melakukan ini, para penyelidik telah melatih dan memperhalusi sepuluh seni bina model yang berbeza merentas berbilang kawasan dan skala pengiraan (daripada 15 juta hingga 40 bilion parameter). Secara keseluruhannya, mereka telah melatih dan memperhalusi lebih daripada 100 model seni bina dan saiz yang berbeza serta membentangkan cerapan dan cabaran dalam menskalakan sepuluh seni bina yang berbeza ini.

Pautan kertas: https://arxiv.org/pdf/2207.10551.pdf

Mereka juga ambil perhatian bahawa penskalaan model ini tidak semudah yang disangka, iaitu butiran rumit penskalaan berkait rapat dengan pilihan seni bina yang dikaji secara terperinci dalam kertas kerja ini. Contohnya, ciri Universal Transformers (dan ALBERT) ialah perkongsian parameter. Pilihan seni bina ini menyelewengkan tingkah laku penskalaan dengan ketara berbanding Transformer standard bukan sahaja dari segi prestasi, tetapi juga dari segi metrik pengiraan seperti FLOP, kelajuan dan bilangan parameter. Sebaliknya, model seperti Switch Transformers adalah berbeza sama sekali, dengan hubungan luar biasa antara FLOP dan kuantiti parameter.

Khususnya, sumbangan utama artikel ini adalah seperti berikut:

- Terbitan pertama berbeza bias induktif dan undang-undang penskalaan seni bina model . Para penyelidik mendapati bahawa faktor penskalaan ini berbeza-beza dengan ketara merentas model dan menyatakan bahawa ini merupakan pertimbangan penting dalam pembangunan model. Ternyata daripada kesemua sepuluh seni bina yang mereka anggap, Transformer vanila mempunyai prestasi penskalaan yang terbaik, walaupun ia bukan yang terbaik dari segi mutlak bagi setiap kawasan pengiraan.

- Penyelidik telah memerhatikan bahawa model yang berfungsi dengan baik dalam satu kawasan penskalaan pengiraan tidak semestinya model terbaik di rantau penskalaan pengiraan yang lain. Selain itu, mereka mendapati bahawa sesetengah model, semasa berprestasi baik di kawasan pengiraan rendah, sukar untuk skala. Ini bermakna sukar untuk mendapatkan gambaran lengkap tentang kebolehskalaan model dengan membandingkan titik demi titik dalam kawasan pengiraan tertentu.

- Penyelidik mendapati bahawa kebingungan pra-latihan huluan mungkin kurang relevan dengan pemindahan hiliran apabila ia melibatkan penskalaan seni bina model yang berbeza. Oleh itu, seni bina asas dan berat sebelah induktif juga penting untuk migrasi hiliran.

- Para penyelidik menyerlahkan kesukaran penskalaan di bawah seni bina tertentu dan menunjukkan bahawa sesetengah model tidak berskala (atau berskala dengan arah aliran negatif). Mereka juga mendapati kecenderungan untuk model perhatian temporal linear (seperti Performer) sukar untuk skala.

Kaedah dan Eksperimen

Dalam bab ketiga kertas kerja, penyelidik menggariskan persediaan percubaan keseluruhan dan memperkenalkan model yang dinilai dalam eksperimen.

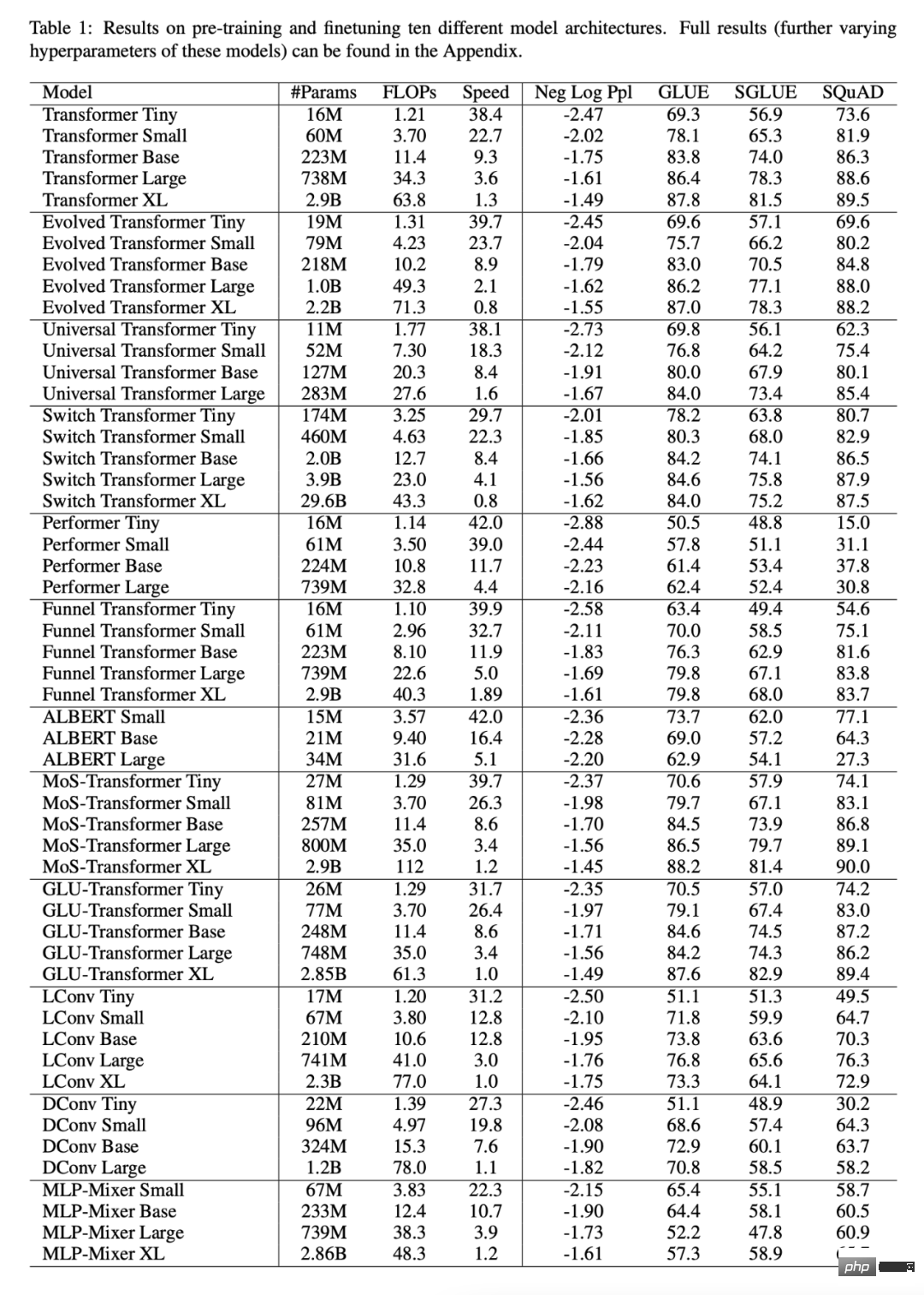

Jadual 1 di bawah menunjukkan keputusan utama artikel ini, termasuk bilangan parameter boleh dilatih, FLOP (laluan hadapan tunggal) dan kelajuan (langkah sesaat), dsb., sebagai tambahan kepada Sahkan kebingungan (pra-latihan huluan) dan keputusan pada 17 tugasan hiliran.

Adakah semua model berskala dengan cara yang sama?

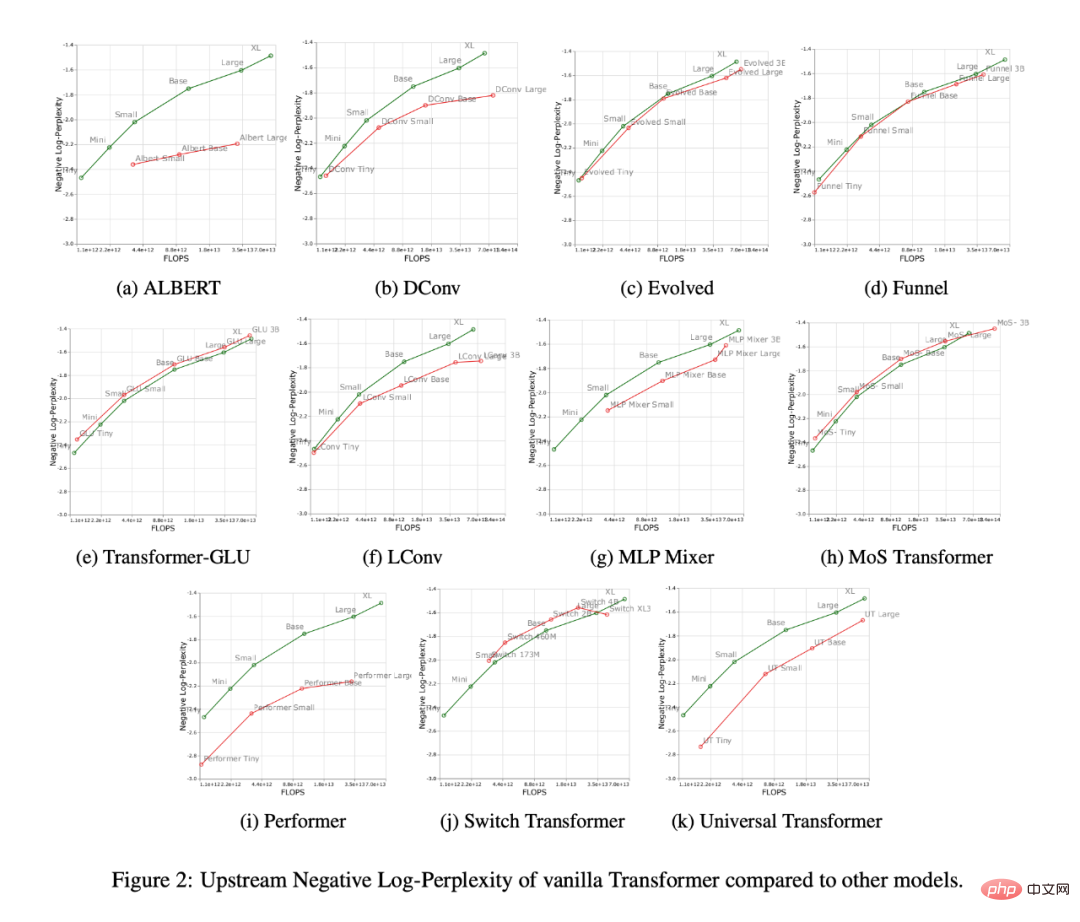

Rajah 2 di bawah menunjukkan gelagat penskalaan semua model apabila meningkatkan bilangan FLOP. Dapat diperhatikan bahawa tingkah laku penskalaan semua model adalah agak unik dan berbeza, iaitu kebanyakannya berbeza daripada Transformer standard. Mungkin penemuan terbesar di sini ialah kebanyakan model (cth., LConv, Evolution) kelihatan berprestasi setanding atau lebih baik daripada Transformer standard, tetapi gagal menskalakan dengan belanjawan pengiraan yang lebih tinggi.

Satu lagi trend yang menarik ialah Transformer "linear", seperti Performer, tidak berskala. Seperti yang ditunjukkan dalam Rajah 2i, berbanding dari asas ke skala besar, kebingungan pra-latihan hanya menurun sebanyak 2.7%. Untuk Transformer vanila angka ini ialah 8.4%.

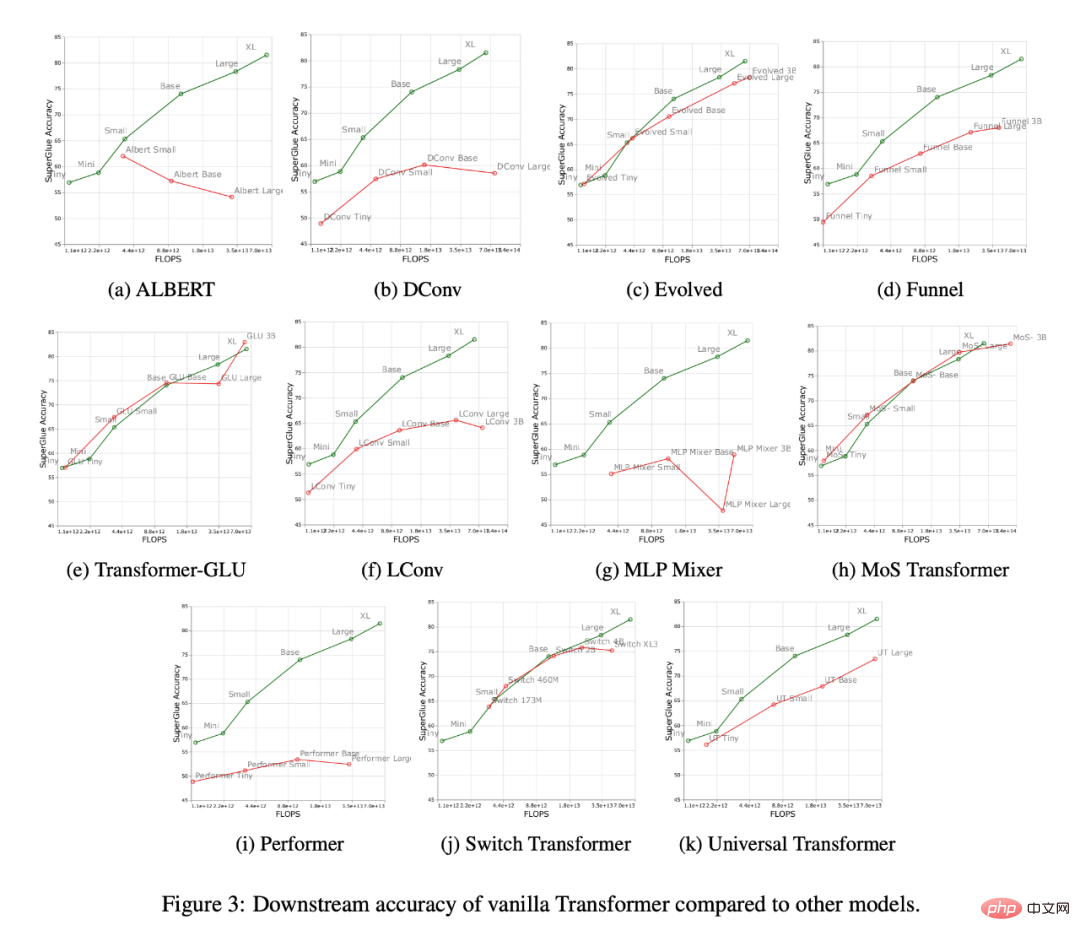

Rajah 3 di bawah menunjukkan lengkung penskalaan semua model pada tugas migrasi hiliran Ia boleh didapati bahawa berbanding dengan Transformer, kebanyakan model mempunyai perbezaan Keluk penskalaan, berubah dengan ketara dalam tugas hiliran. Perlu diingat bahawa kebanyakan model mempunyai lengkung penskalaan huluan atau hiliran yang berbeza.

Penyelidik mendapati beberapa model, seperti Funnel Transformer dan LConv, nampaknya berprestasi agak baik di hulu, tetapi banyak terjejas di hiliran. Bagi Performer pula, jurang prestasi antara huluan dan hiliran nampaknya lebih luas. Perlu diingat bahawa tugas hiliran SuperGLUE selalunya memerlukan perhatian pseudo-silang pada pengekod, yang model seperti konvolusi tidak dapat mengendalikan (Tay et al., 2021a).

Oleh itu, penyelidik mendapati bahawa walaupun sesetengah model mempunyai prestasi huluan yang baik, mereka mungkin masih menghadapi kesukaran mempelajari tugasan hiliran.

Adakah model terbaik berbeza untuk setiap skala?

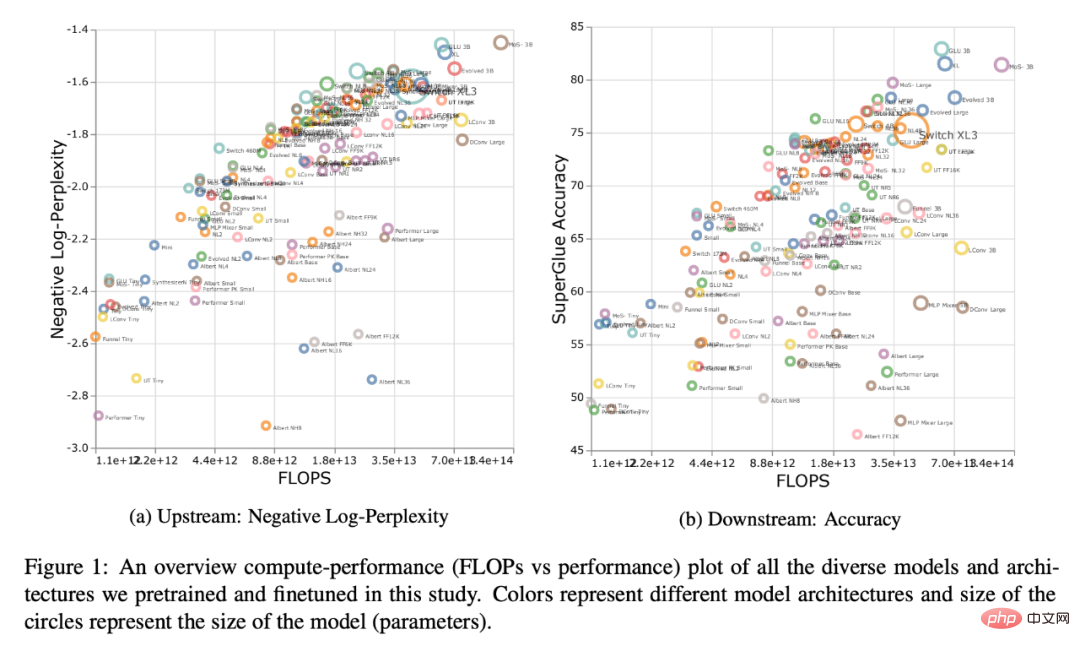

Rajah 1 di bawah menunjukkan sempadan Pareto apabila dikira dari segi prestasi huluan atau hiliran. Warna plot mewakili model yang berbeza, dan boleh diperhatikan bahawa model optimum mungkin berbeza untuk setiap skala dan kawasan pengiraan. Selain itu, ini juga boleh dilihat dalam Rajah 3 di atas. Contohnya, Transformer Evolved nampaknya berprestasi sama seperti Transformer standard dalam kawasan kecil ke kecil (hiliran), tetapi ini berubah dengan cepat apabila meningkatkan model. Para penyelidik juga memerhatikan ini dalam MoS-Transformer, yang menunjukkan prestasi yang lebih baik daripada Transformer biasa di beberapa kawasan, tetapi tidak di kawasan lain.

Hukum penskalaan bagi setiap model

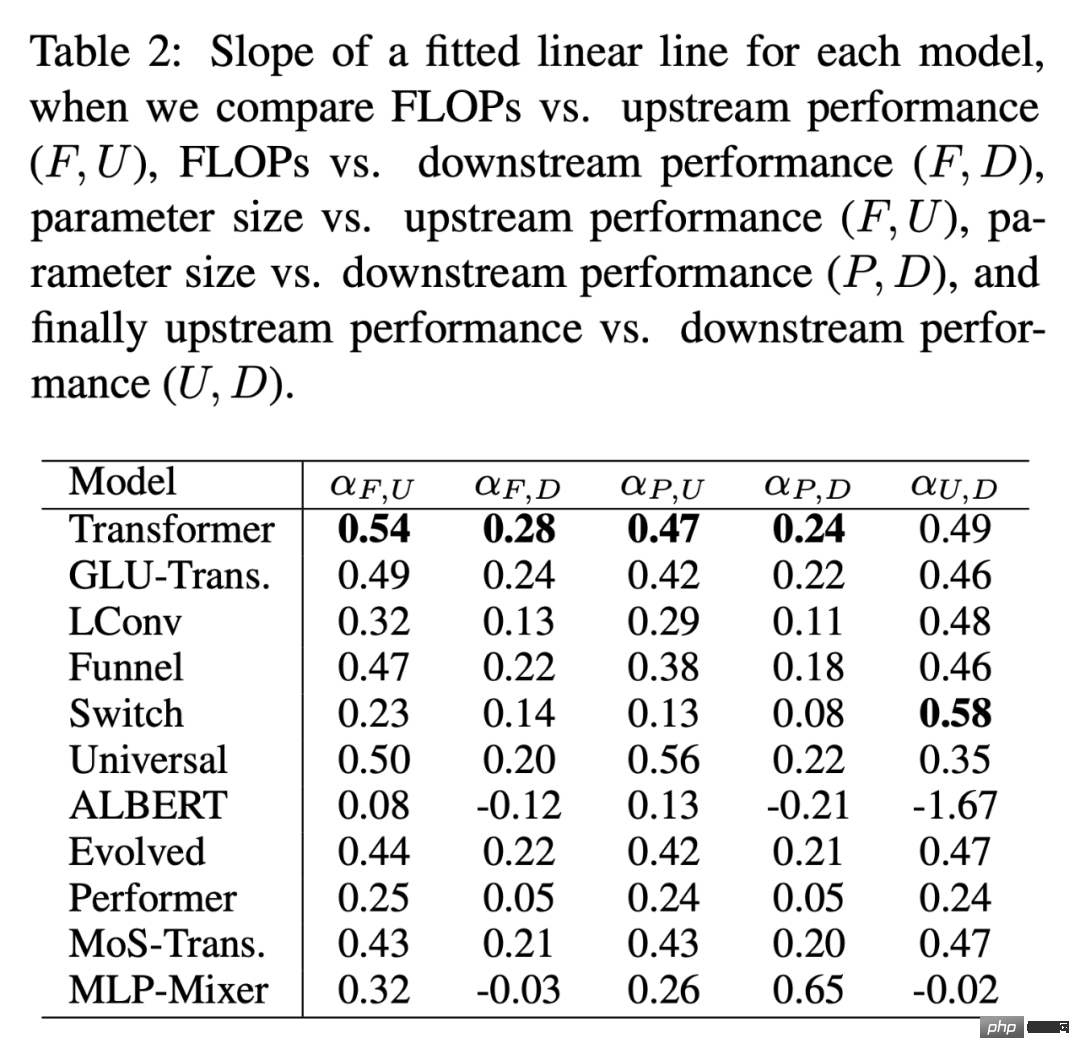

Jadual 2 di bawah memberikan pemasangan setiap model dalam pelbagai kes Kecerunan lurus linear baris α. Para penyelidik memperoleh α dengan memplot F (FLOPs), U (perplexity hulu), D (ketepatan hiliran), dan P (bilangan parameter). Secara umum, α menerangkan kebolehskalaan model, cth. α_F,U memplot FLOP terhadap prestasi huluan. Satu-satunya pengecualian ialah α_U,D, yang merupakan ukuran prestasi huluan dan hiliran, dengan nilai α_U,D tinggi yang bermaksud penskalaan model yang lebih baik kepada tugas hiliran. Secara keseluruhan, nilai alfa ialah ukuran prestasi model berbanding penskalaan.

Adakah Protokol Penskalaan mempengaruhi seni bina model dengan cara yang sama?

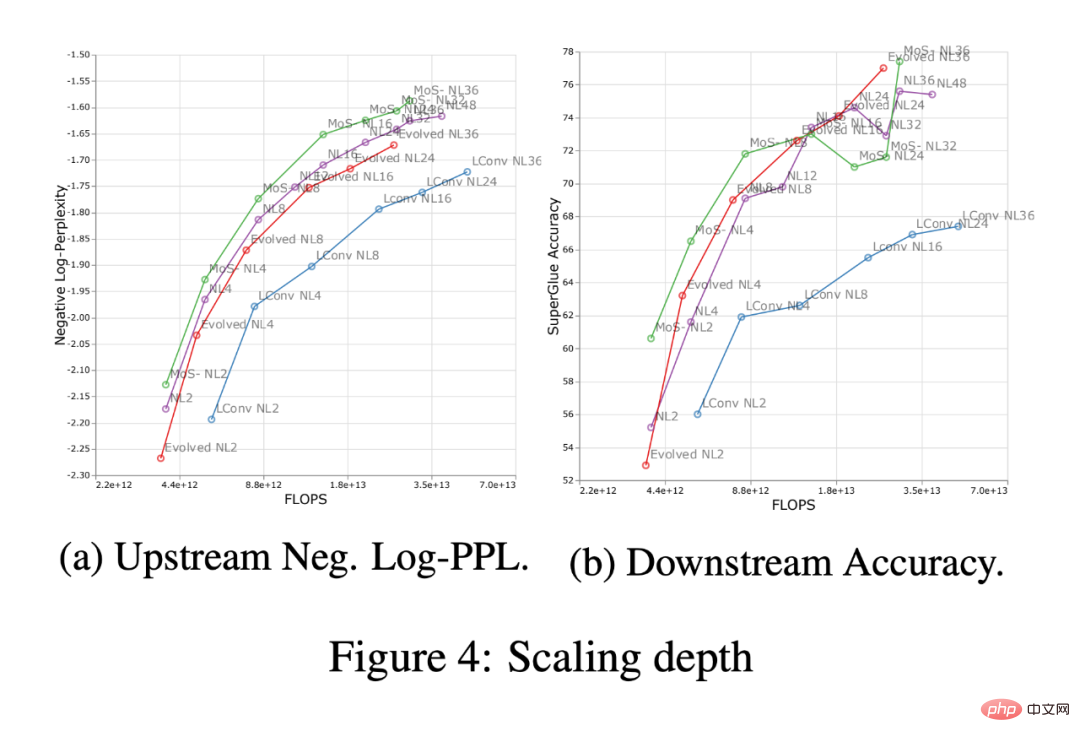

Rajah 4 di bawah menunjukkan kesan kedalaman penskalaan dalam empat seni bina model (MoS-Transformer, Transformer, Evolved Transformer, LConv).

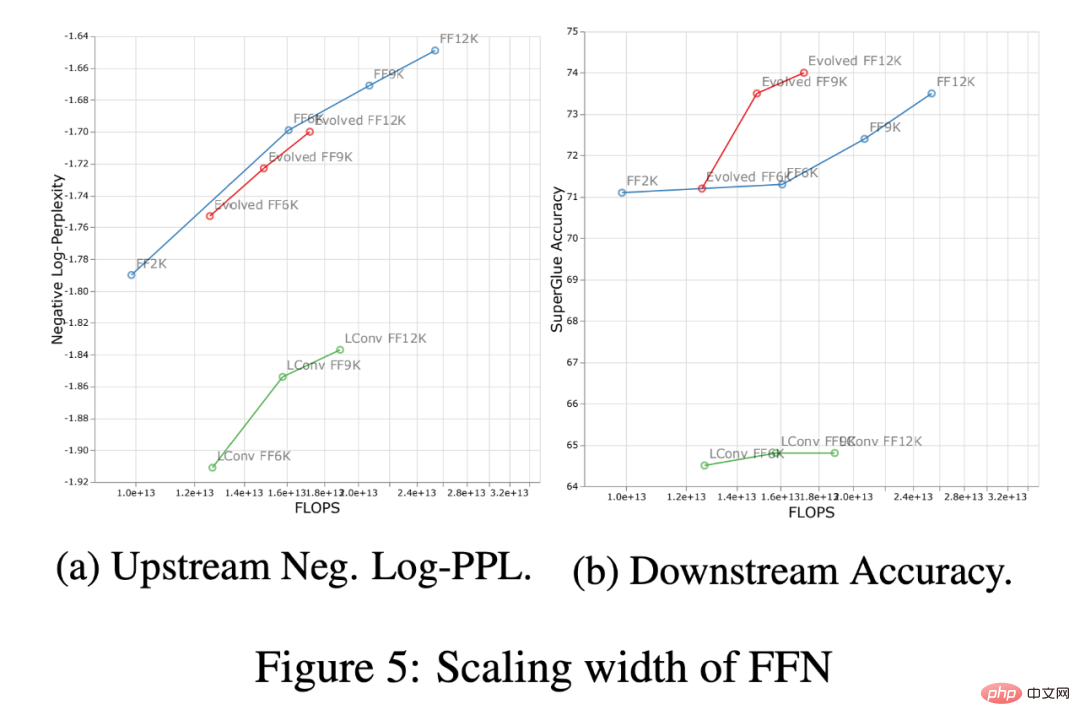

Rajah 5 di bawah menunjukkan kesan lebar penskalaan merentas empat seni bina yang sama. Pertama, pada lengkung huluan (negatif log-perplexity) dapat diperhatikan bahawa walaupun terdapat perbezaan yang jelas dalam prestasi mutlak antara seni bina yang berbeza, trend penskalaan kekal hampir sama. Hilir, kecuali LConv, penskalaan dalam (Rajah 4 di atas) nampaknya berfungsi sama pada kebanyakan seni bina. Selain itu, nampaknya Transformer Evolved berfungsi sedikit lebih baik apabila menggunakan penskalaan lebar berbanding penskalaan lebar. Perlu diambil perhatian bahawa penskalaan kedalaman mempunyai kesan yang lebih besar pada penskalaan hiliran daripada penskalaan lebar.

Untuk butiran penyelidikan lanjut, sila rujuk kertas asal.

Atas ialah kandungan terperinci Penyelidikan baharu daripada Google dan DeepMind: Bagaimanakah kecenderungan induktif mempengaruhi penskalaan model?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI