Rumah >Peranti teknologi >AI >Menggabungkan dua model dengan sifar halangan, sambungan linear model ResNet yang besar mengambil masa hanya beberapa saat, memberi inspirasi kepada penyelidikan baharu pada rangkaian saraf

Menggabungkan dua model dengan sifar halangan, sambungan linear model ResNet yang besar mengambil masa hanya beberapa saat, memberi inspirasi kepada penyelidikan baharu pada rangkaian saraf

- 王林ke hadapan

- 2023-04-09 15:41:031693semak imbas

Pembelajaran mendalam telah dapat mencapai pencapaian tersebut berkat keupayaannya untuk menyelesaikan masalah pengoptimuman bukan cembung berskala besar dengan relatif mudah. Walaupun pengoptimuman bukan cembung adalah NP-keras, beberapa algoritma mudah, biasanya varian keturunan kecerunan stokastik (SGD), telah menunjukkan keberkesanan yang mengejutkan dalam memasang rangkaian saraf yang besar.

Dalam artikel ini, beberapa sarjana dari University of Washington menulis artikel "Git Re-Basin: Merging Models Modulo Permutation Symmetries" Mereka mengkaji algoritma SGD dalam bukan dimensi tinggi. pengoptimuman cembung dalam pembelajaran mendalam Keberkesanan yang tidak munasabah pada isu ini. Mereka diilhamkan oleh tiga soalan:

1 Mengapakah SGD berprestasi baik dalam pengoptimuman landskap kehilangan pembelajaran mendalam bukan cembung berdimensi tinggi, manakala dalam tetapan pengoptimuman bukan cembung yang lain, seperti pembelajaran dasar, Kekukuhan pengoptimuman trajektori dan sistem pengesyoran dikurangkan dengan ketara?

Di manakah minima tempatan? Mengapa kehilangan berkurangan dengan lancar dan monoton apabila interpolasi secara linear antara pemberat permulaan dan pemberat latihan akhir?

3 Mengapakah dua model yang dilatih secara bebas dengan pemulaan rawak dan susunan batching data yang berbeza mencapai prestasi yang hampir sama? Di samping itu, mengapa keluk kehilangan latihan mereka kelihatan sama pdf

Kenapa ni? Pada tahun 2019, Brea et al mendapati bahawa unit tersembunyi dalam rangkaian saraf mempunyai simetri susunan. Ringkasnya: kita boleh menukar mana-mana dua unit dalam lapisan tersembunyi rangkaian, dan fungsi rangkaian akan kekal sama. Entezari et al. 2021 membuat spekulasi bahawa simetri pilih atur ini mungkin membolehkan kami menyambungkan titik dalam ruang berat secara linear tanpa menjejaskan kerugian.

Di bawah ini kami menggunakan contoh daripada salah seorang pengarang kertas kerja untuk menggambarkan tujuan utama artikel tersebut, supaya semua orang akan mengetahui dengan lebih jelas.

Andaikata anda melatih model A dan rakan anda melatih model B, data latihan kedua-dua model itu mungkin berbeza. Tidak mengapa, menggunakan Git Re-Basin yang dicadangkan dalam artikel ini, anda boleh menggabungkan dua model A+B dalam ruang berat tanpa merosakkan kehilangan.

Pengarang kertas menyatakan bahawa Git Re-Basin boleh digunakan pada mana-mana rangkaian saraf (NN), dan mereka menunjukkannya buat kali pertama Sambungan linear penghalang sifar boleh dilakukan antara dua model terlatih secara bebas (tanpa pra-latihan) (ResNets).

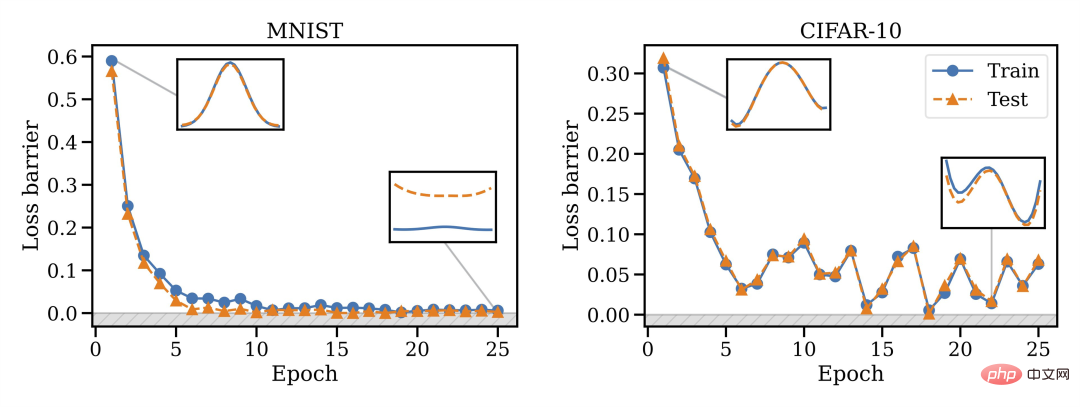

Mereka mendapati bahawa keupayaan penggabungan adalah hak milik latihan SGD, penggabungan tidak berfungsi pada permulaan, tetapi perubahan fasa berlaku, jadi penggabungan akan menjadi mungkin dari semasa ke semasa.

Mereka mendapati bahawa keupayaan penggabungan adalah hak milik latihan SGD, penggabungan tidak berfungsi pada permulaan, tetapi perubahan fasa berlaku, jadi penggabungan akan menjadi mungkin dari semasa ke semasa.

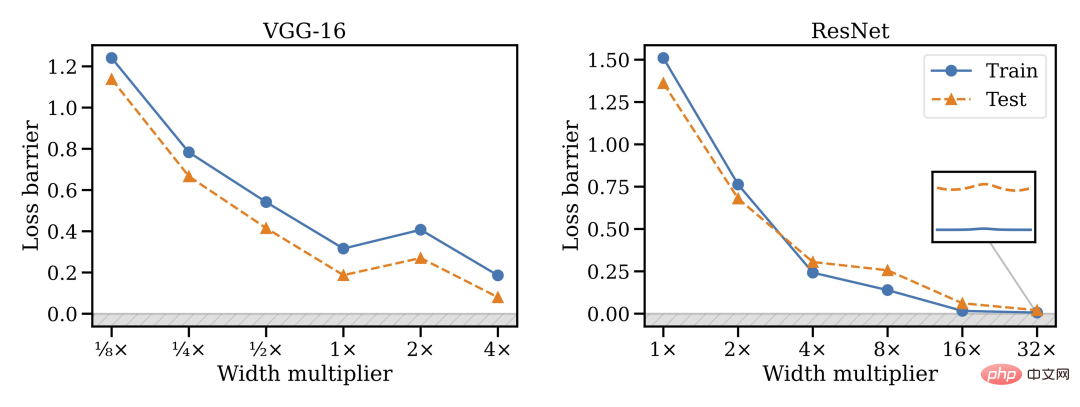

Mereka juga mendapati bahawa lebar model berkait rapat dengan kebolehcantuman, iaitu lebih luas adalah lebih baik.

Selain itu, tidak semua seni bina boleh digabungkan: VGG nampaknya lebih sukar untuk digabungkan berbanding ResNets.

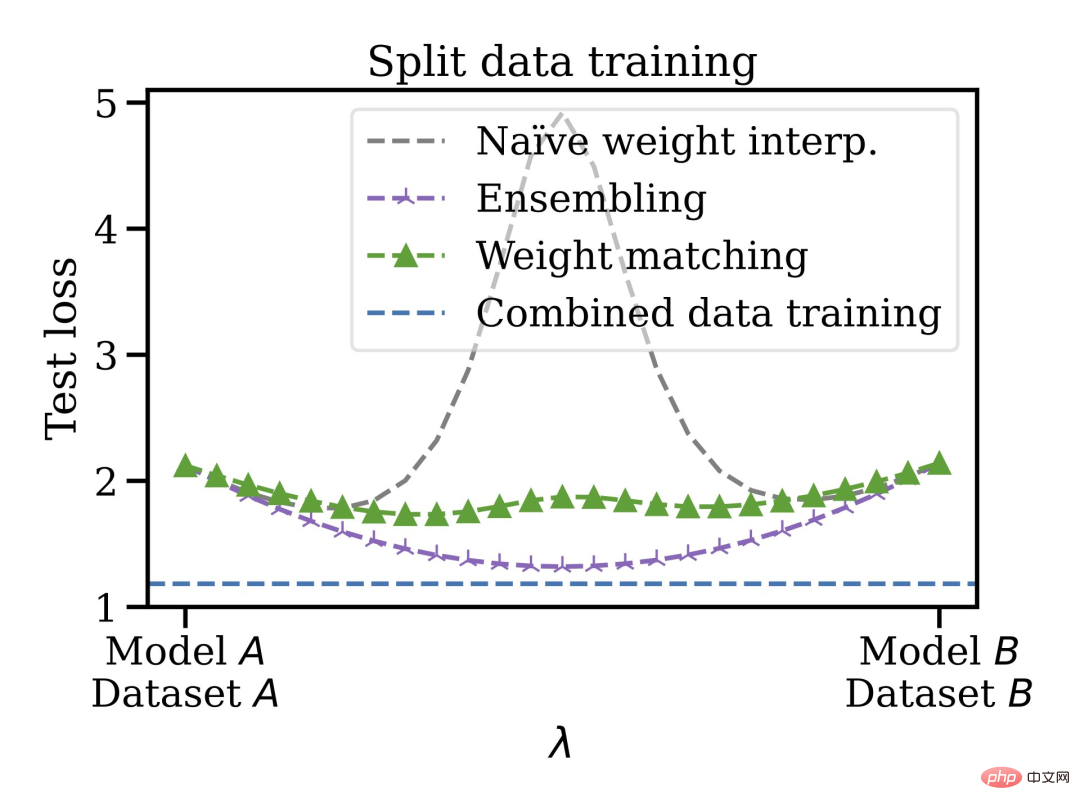

Kaedah penggabungan ini mempunyai kelebihan lain, anda boleh melatih model pada set data bercabang dan berat sebelah dan kemudian menggabungkannya bersama-sama dalam ruang pemberat. Sebagai contoh, anda mempunyai beberapa data di AS dan beberapa di EU. Atas sebab tertentu data tidak boleh dicampur. Anda boleh melatih model yang berasingan terlebih dahulu, kemudian menggabungkan pemberat, dan akhirnya membuat generalisasi kepada set data yang digabungkan.

Kaedah penggabungan ini mempunyai kelebihan lain, anda boleh melatih model pada set data bercabang dan berat sebelah dan kemudian menggabungkannya bersama-sama dalam ruang pemberat. Sebagai contoh, anda mempunyai beberapa data di AS dan beberapa di EU. Atas sebab tertentu data tidak boleh dicampur. Anda boleh melatih model yang berasingan terlebih dahulu, kemudian menggabungkan pemberat, dan akhirnya membuat generalisasi kepada set data yang digabungkan.

Oleh itu, model terlatih boleh dicampur tanpa memerlukan pra-latihan atau penalaan halus. Penulis menyatakan bahawa dia berminat untuk mengetahui arah pembangunan masa depan sambungan mod linear dan tampalan model, yang mungkin digunakan untuk bidang seperti pembelajaran bersekutu, latihan teragih dan pengoptimuman pembelajaran mendalam.

Akhir sekali, disebutkan bahawa algoritma pemadanan berat dalam Bab 3.2 hanya mengambil masa kira-kira 10 saat untuk dijalankan, jadi ia menjimatkan banyak masa. Bab 3 kertas kerja juga memperkenalkan tiga kaedah untuk memadankan unit model A dan model B Rakan yang tidak jelas tentang algoritma pemadanan boleh menyemak kertas asal.

Komen netizen dan soalan pengarang

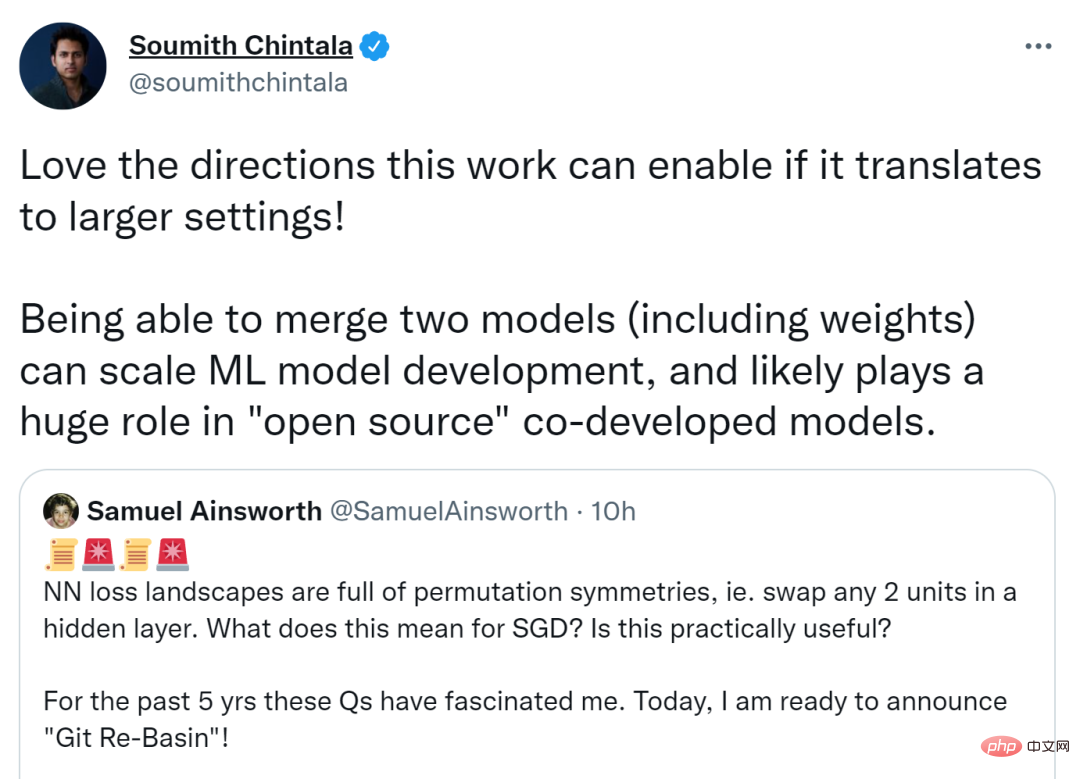

Kertas kerja ini mencetuskan perbincangan hangat di Twitter, Soumith Chintala, pengasas bersama PyTorch, berkata jika penyelidikan ini boleh dipindahkan ke lagi Lebih besar tetapan, lebih baik arah yang boleh diambil. Menggabungkan dua model (termasuk pemberat) boleh mengembangkan pembangunan model ML dan mungkin memainkan peranan besar dalam pembangunan bersama model sumber terbuka.

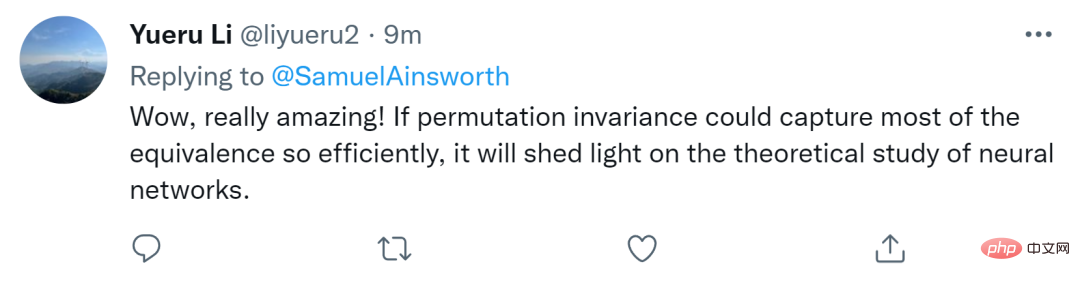

Orang lain percaya bahawa jika invarian pilih atur boleh menangkap kebanyakan kesetaraan dengan begitu cekap, ia akan memberikan inspirasi untuk penyelidikan teori mengenai rangkaian saraf.

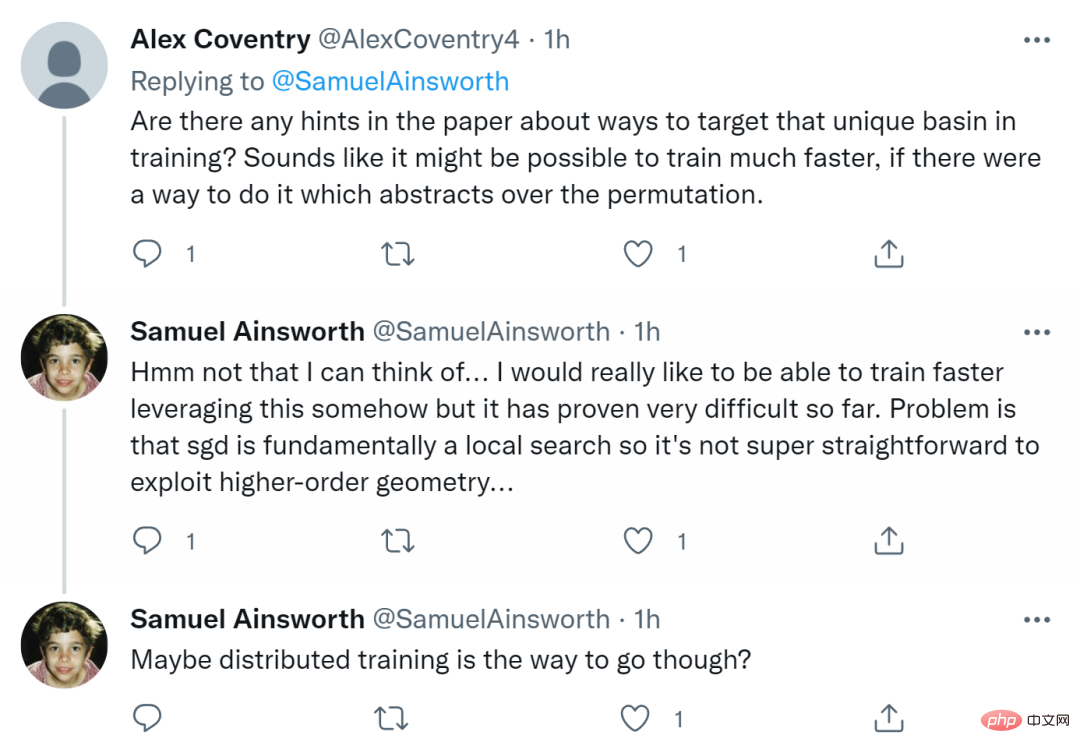

Samuel Ainsworth, pengarang pertama kertas kerja dan Ph.D dari Universiti Washington, turut menjawab beberapa soalan yang dibangkitkan oleh netizen.

Pertama sekali seseorang bertanya, "Adakah terdapat sebarang petua dalam kertas kerja tentang menyasarkan lembangan unik dalam latihan? Jika terdapat cara untuk mengabstrak pilih atur, latihan mungkin lebih pantas. "

Ainsworth menjawab bahawa dia tidak memikirkan perkara ini. Dia benar-benar berharap untuk dapat berlatih lebih cepat entah bagaimana, tetapi setakat ini ia terbukti sangat sukar. Masalahnya ialah SGD pada asasnya adalah carian tempatan, jadi tidak semudah itu untuk mengeksploitasi geometri peringkat tinggi. Mungkin latihan yang diedarkan adalah cara untuk pergi.

Ada juga yang bertanya sama ada ia boleh digunakan untuk RNN dan Transformers? Ainsworth berkata ia berfungsi pada dasarnya, tetapi dia belum mencubanya lagi. Masa akan menentukan.

Akhirnya seseorang mencadangkan, "Ini nampaknya sangat penting untuk latihan yang diedarkan untuk "menjadi kenyataan"? Mungkinkah adakah DDPM ( Denoising diffusion probability model) tidak menggunakan blok sisa ResNet 》

Ainsworth menjawab bahawa walaupun dia tidak begitu biasa dengan DDPM, dia secara terus terang menyatakan bahawa ia akan digunakan? untuk Latihan yang diedarkan akan menjadi sangat menarik.

Atas ialah kandungan terperinci Menggabungkan dua model dengan sifar halangan, sambungan linear model ResNet yang besar mengambil masa hanya beberapa saat, memberi inspirasi kepada penyelidikan baharu pada rangkaian saraf. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI