Rumah >Peranti teknologi >AI >Memecahkan segitiga mustahil dan bersaing dengan 540 bilion model, pasukan Senarai Fengshen IDEA hanya mencapai SOTA pembelajaran sampel sifar dengan 200 juta model

Memecahkan segitiga mustahil dan bersaing dengan 540 bilion model, pasukan Senarai Fengshen IDEA hanya mencapai SOTA pembelajaran sampel sifar dengan 200 juta model

- 王林ke hadapan

- 2023-04-09 13:31:061086semak imbas

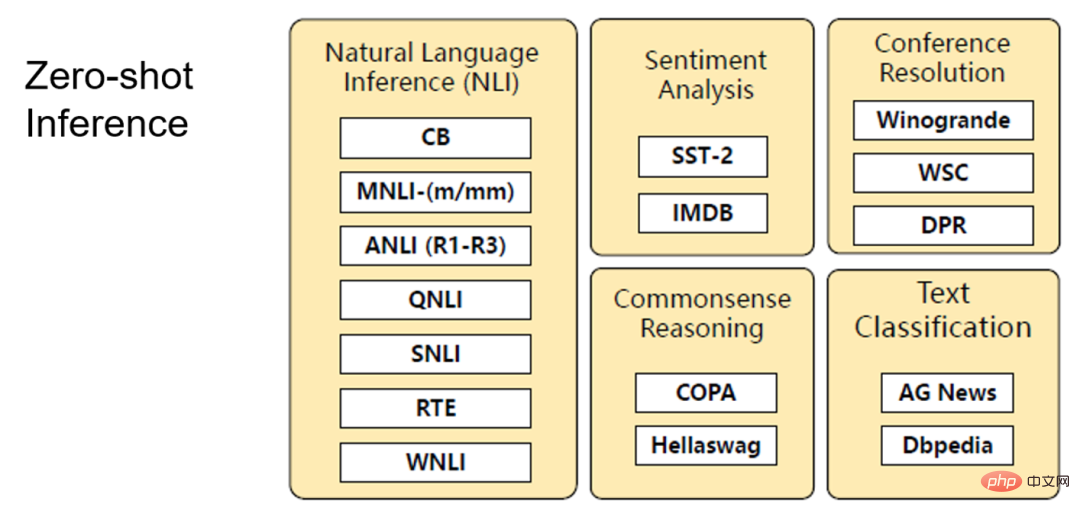

Sejak kemunculan GPT-3, yang menunjukkan kuasa ratusan bilion model, tugasan NLP telah menghadapi segi tiga yang mustahil dalam skala, sampel dan prestasi penalaan halus. Bagaimanakah model bahasa dengan kurang daripada 1 bilion parameter boleh mencapai prestasi Sedikit Tangkapan (atau bahkan Tangkapan Sifar) dan Penalaan Halus SOTA? Adakah kita perlu mempunyai ratusan bilion parameter dan menahan gesaan yang tidak stabil untuk menyelesaikan senario sifar pukulan? Dalam artikel ini, pasukan Fengshenbang Institut Penyelidikan IDEA memperkenalkan UniMC "fenomenologi" baharu, yang boleh mencapai SOTA pukulan sifar dengan hanya 200 juta parameter. Kerja berkaitan telah diterima oleh EMNLP 2022.

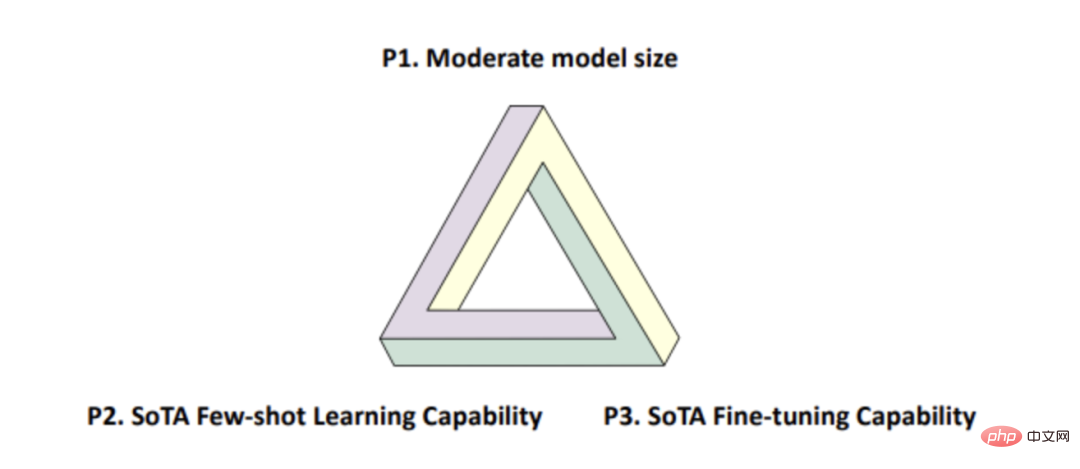

menegaskan dalam artikel tahun ini [1] bahawa sejak teknologi pra-latihan dicadangkan, terdapat segitiga mustahil dalam dunia NLP (Rajah 1 di bawah), iaitu, model tidak boleh pada masa yang sama memuaskan :

- Saiz model sederhana (di bawah 1 bilion); prestasi ;

- Prestasi Penalaan Halus SOTA.

Rajah 1

Rajah 1

Sebab mengapa segitiga mustahil wujud Ya, bilangan parameter model pra-latihan semasa hanya mencapai susunan magnitud tertentu, dan hanya apabila pembelajaran pembayang digunakan boleh menunjukkan prestasi beberapa/sifar pukulan yang kuat.

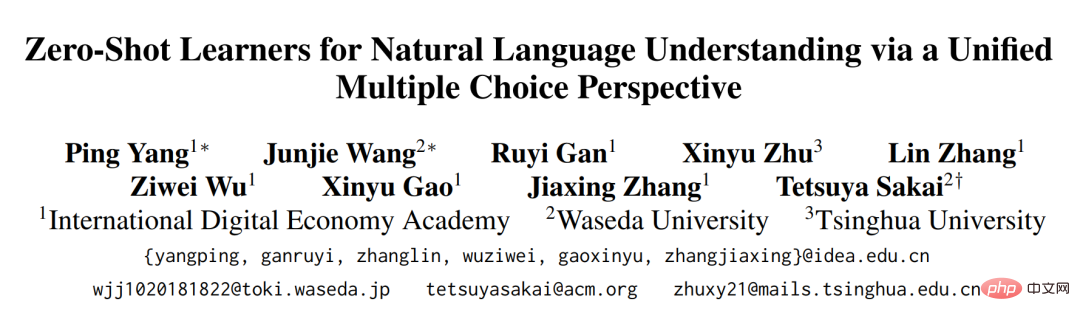

Kertas kerja baru-baru ini diterbitkan oleh pasukan Fengshenbang kami dan disertakan dalam EMNLP 2022: "Pelajar Sifar untuk Pemahaman Bahasa Semulajadi melalui Perspektif Pelbagai Pilihan Bersatu" memecahkan "sumpahan" ini dan menyediakan A penyelesaian yang fleksibel dan cekap. UniMC yang dicadangkan dalam kertas kerja

kami mempunyai sebilangan kecil parameter model (hanya ratusan juta) dan keupayaan Penalaan Halus SOTA, di samping mempunyai prestasi SOTA (setanding dengan 540 bilion PaLM) Sedikit/Sifar Tangkapan..

- Alamat sumber terbuka model: https://github.com/IDEA-CCNL/Fengshenbang-LM/tree/main/fengshen/examples/unimc/

- Latar Belakang Teknikal

Sebabnya apabila menggunakan PMLM, kita perlu menambah lapisan MLP di atas untuk tugasan tertentu, seperti yang ditunjukkan dalam Rajah 2(c). Selain itu, lapisan MLP ini akan menambah parameter tambahan, yang menjadikan kaedah ini hanya memilih pemulaan rawak apabila menghadapi senario tangkapan sifar, dan tidak ada cara untuk mendapatkan output yang munasabah. Selain itu, dalam senario penalaan halus, menambah lapisan MLP juga akan menjadikannya mustahil untuk memindahkan antara tugas yang berbeza (contohnya, adalah mustahil untuk memindahkan antara tugas 2-klasifikasi dan 3-klasifikasi).

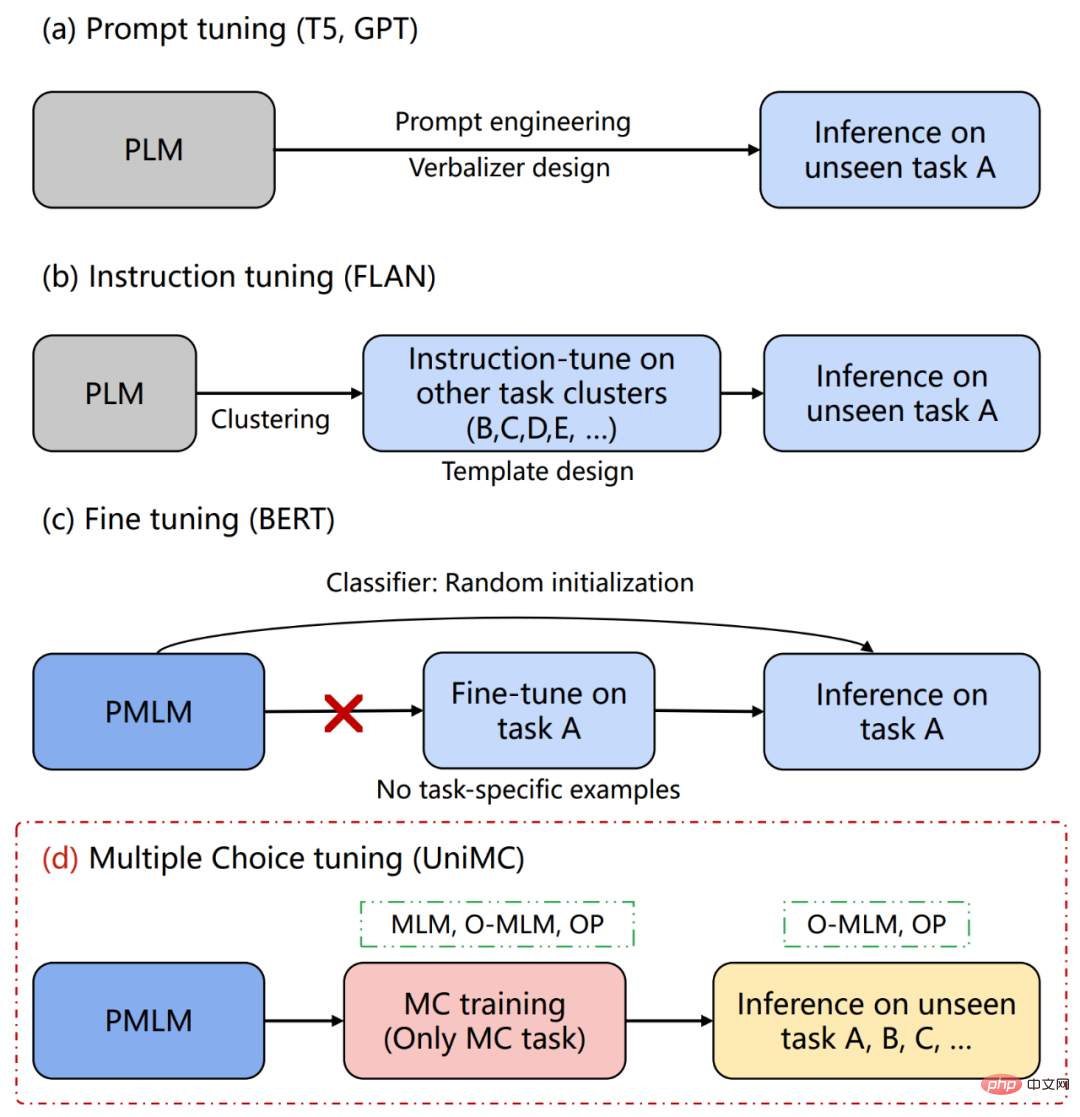

Untuk senario Zero-shot, pendekatan arus perdana dalam beberapa tahun kebelakangan ini ialah menggunakan berpuluh malah ratusan bilion model bahasa pra-latihan (PLM) untuk menukar tugas NLU secara seragam kepada penjanaan teks tugasan, supaya model Besar boleh digunakan pada tugasan pukulan sifar dengan membina gesaan secara manual atau mereka bentuk verbalizer secara manual, seperti yang ditunjukkan dalam Rajah 2(a). Tambahan pula, dalam kertas FLAN, sebilangan besar templat yang dibina secara buatan digunakan untuk menyatukan tugasan yang berbeza, supaya pengetahuan tentang tugasan lain boleh dipindahkan ke tugasan tertentu, seperti yang ditunjukkan dalam Rajah 2(b). Walau bagaimanapun, model generatif sedemikian mempunyai kelemahan berikut:

- Menjana model memerlukan penghasilan verbalizer (perihalan label), dan verbalizer biasanya ditulis secara manual yang berbeza akan membawa kepada perbezaan prestasi yang besar; juga memerlukan reka bentuk manual, dan gesaan yang berbeza akan sangat mempengaruhi prestasi tugas hiliran; Dan ia biasanya sehala dan tidak boleh mendapatkan maklumat dua hala seperti BERT

- Untuk memastikan prestasi beberapa/sifar tangkapan, jumlah parameter model yang dijana selalunya besar, mencapai GPT-3 175 bilion atau 540 bilion PaLM

- Walaupun penalaan Arahan FLAN boleh memindahkan pengetahuan daripada tugasan lain kepada tugasan tertentu, latihan baharu diperlukan untuk menghadapi tugasan yang berbeza. Sebagai contoh, semasa menilai A, anda perlu berlatih pada BCDE semasa menilai B, anda perlu berlatih menggunakan ACDE.

- Kami mencadangkan kaedah UniMC dalam Rajah 2(d), yang mengelakkan masalah di atas dan mencapai SOTA atau setanding dengan teknologi terkini dalam beberapa bahasa Cina. dan tugasan bahasa Inggeris.

Rajah 2

UniMC (fenotip model baharu)

UniMC (fenotip model baharu)

Idea model

Kebanyakan tugas NLU adalah berdasarkan label, dan model generatif perlu menjana label Ini sudah pasti meningkatkan kesukaran tugas dan kos pembelajaran model. Untuk kebanyakan tugas berasaskan label, biasanya hanya perlu memberikan teks input dan kebarangkalian bahawa teks output adalah milik setiap label. Berdasarkan idea ini, kami mengubah tugasan NLU menjadi tugasan aneka pilihan (Multiple-Choice). Iaitu, teks yang diberikan, soalan dan pilihan, mengeluarkan kebarangkalian setiap pilihan tanpa menghasilkan pilihan.Berdasarkan perkara ini, kami mencadangkan konsep baharu:

Fenotip model

. Ungkapan model sedia ada sentiasa menambah lapisan tertentu kemudian, seperti lapisan pengelasan. Sebagai alternatif, fenotip model GPT yang dijana adalah untuk melombong pengetahuan model melalui Prompt.Skim UniMC yang kami cadangkan tidak memerlukan pengenalan sebarang lapisan tambahan dalam PMLM dan mengetik satu lagi fenotip PMLM . Dalam kertas kerja ini, kami memilih ALBERT sebagai rangkaian PMLM tulang belakang kami. Format pilihan berganda seragam

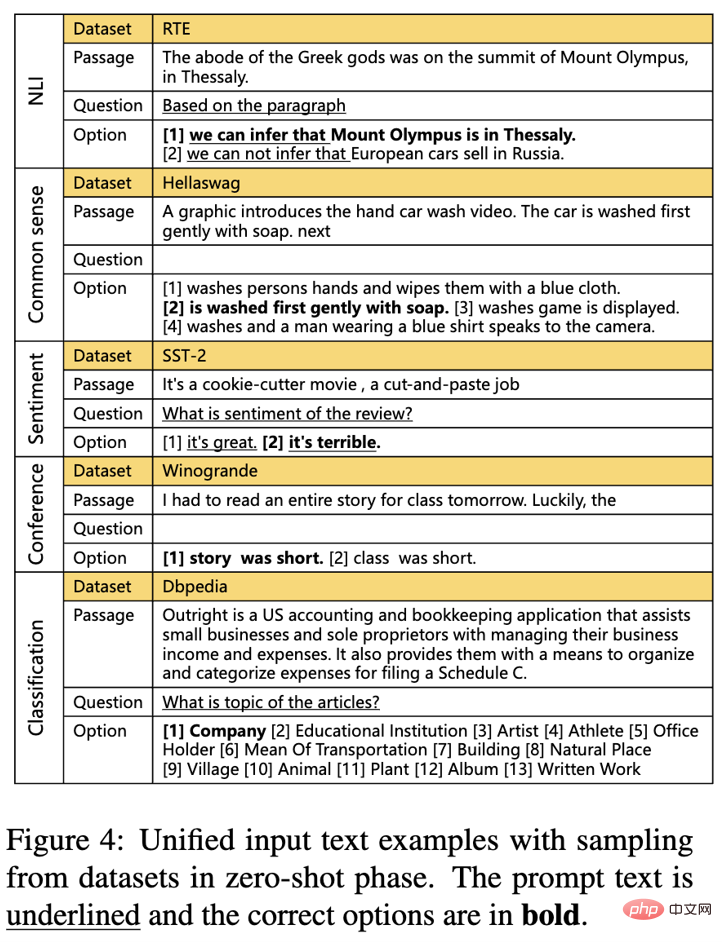

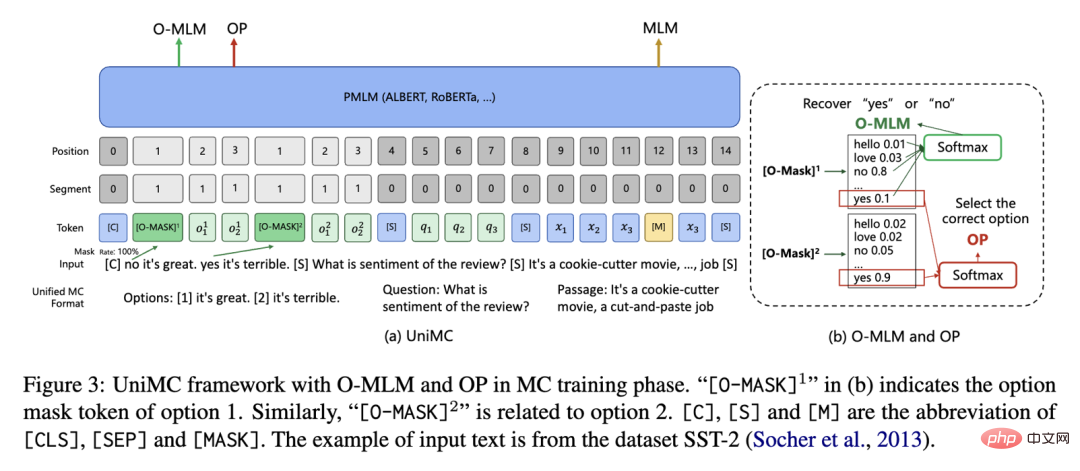

Seperti yang ditunjukkan dalam Rajah 3, kami berharap dapat menukar semua tugas NLU berasaskan label ke dalam format MC (Multiple-Choice) bersatu. Falsafah kami adalah untuk menambah sedikit maklumat manusia yang mungkin.

Rajah 3

Tukar label menjadi pilihan; ).

Kelebihan:

- Hanya satu gesaan pilihan direka bentuk dan satu atau tiada gesaan soalan direka.

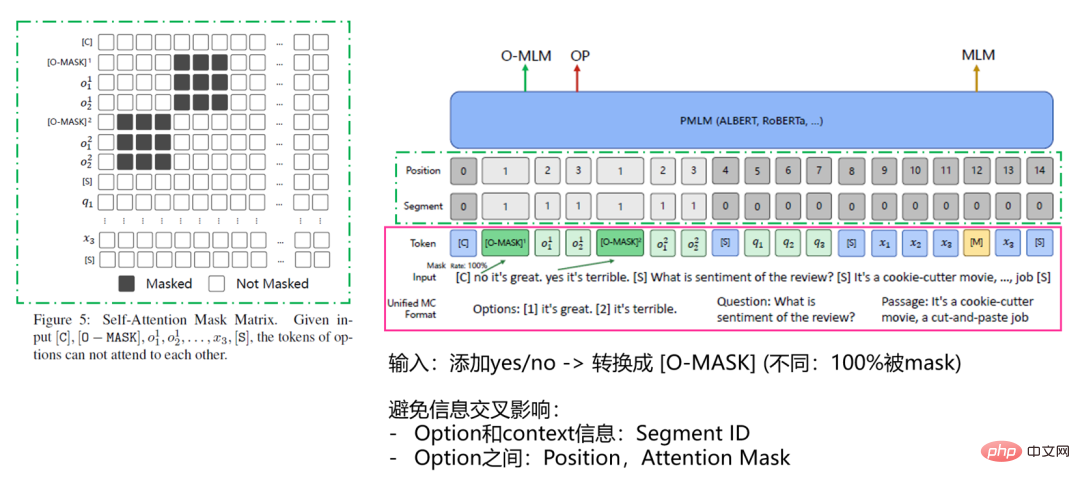

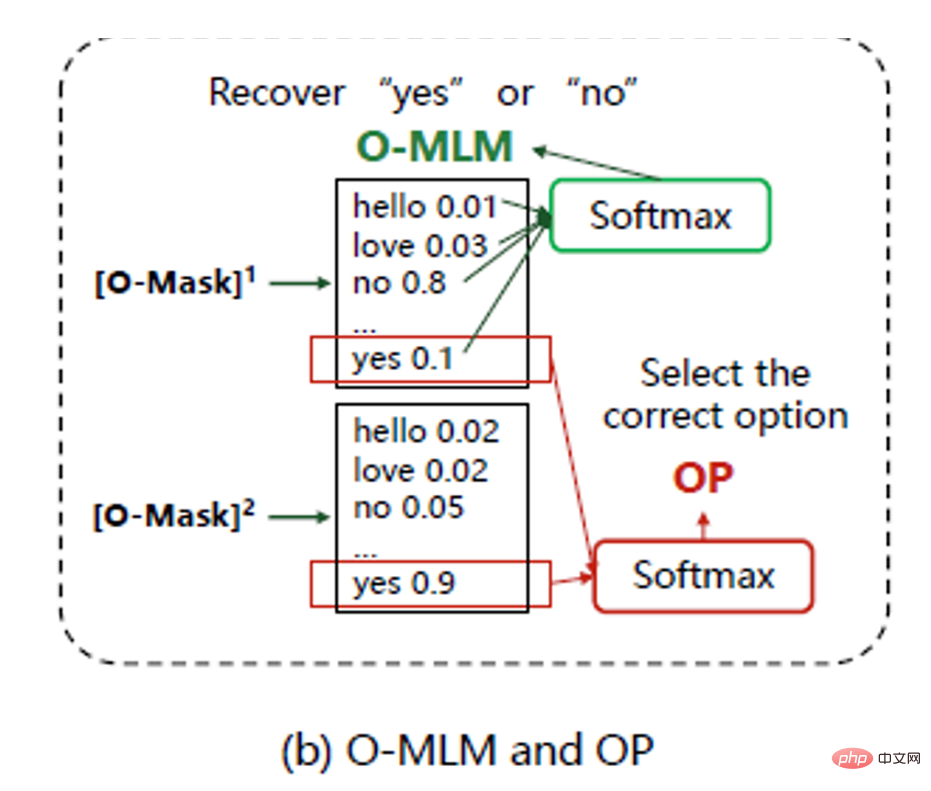

- Struktur model

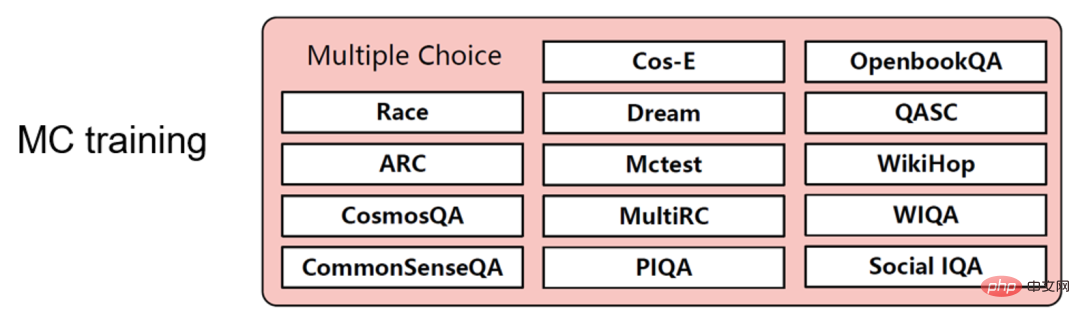

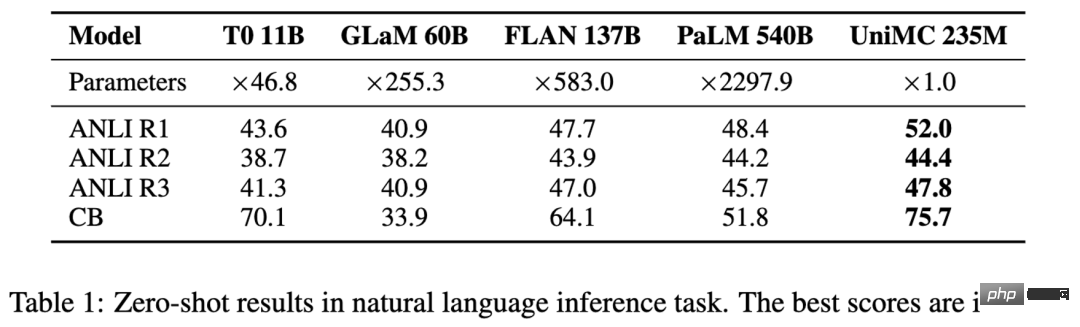

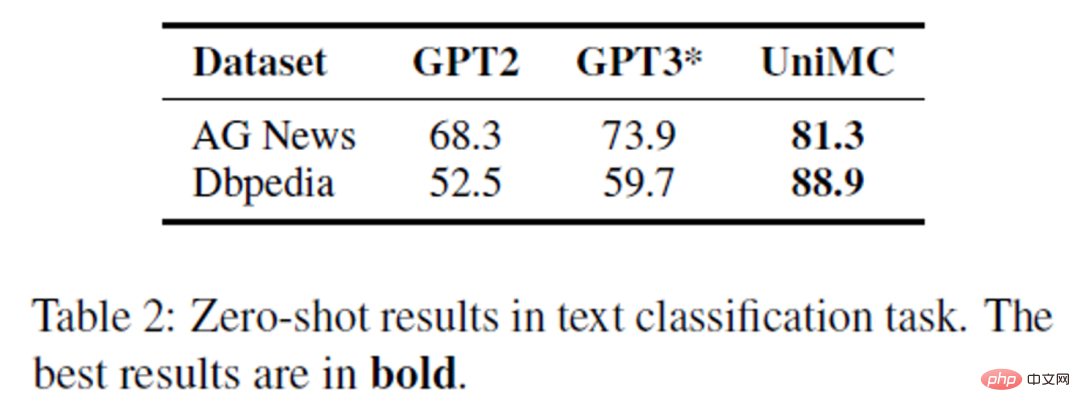

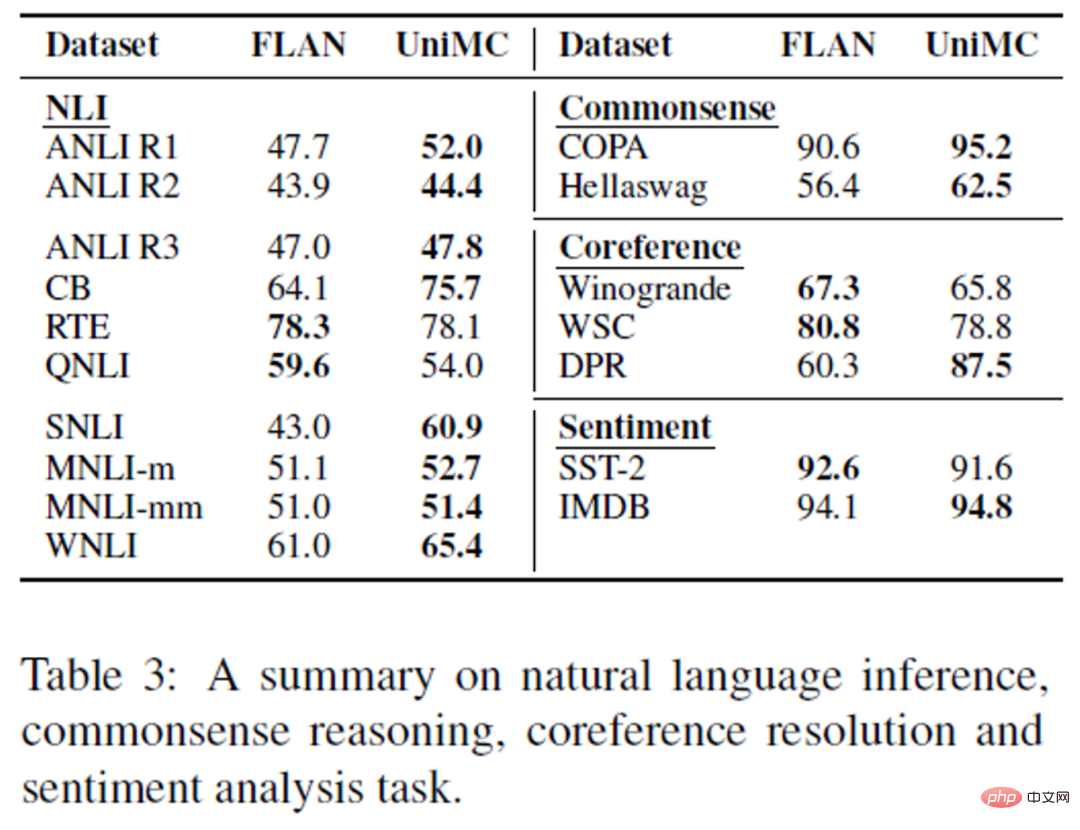

Struktur UniMC ditunjukkan dalam Rajah 4 di bawah, yang menggunakan pengekodan automatik yang serupa kepada struktur BERT. Proses utama ialah kami mula-mula menyatukan input tugasan yang berbeza dan mengehadkan aliran maklumat input Selepas PMLM, kami menggunakan O-MLM, OP dan MLM untuk latihan MC, dan akhirnya menggunakan O-MLM dan OP untuk ramalan sifar. . Seterusnya saya akan memecahkan penyelesaian kami langkah demi langkah. Rajah 4 Input Seperti yang ditunjukkan dalam Rajah 5, kandungan kawasan kotak garis pepejal merah. Sebelum memasukkan ke UniMC, ia perlu diproses dan diubah menjadi format token unik UniMC. Untuk meningkatkan kecekapan pengiraan, kami terus menyambung semua pilihan dengan soalan dan teks, iaitu, [Pilihan, Soalan, Petikan]. Dan kami memasukkan token khas di hadapan setiap pilihan, [O-MASK], untuk menunjukkan ya atau tidak (pilih pilihan ini atau tidak). (Perhatikan, untuk meningkatkan kebolehgunaan semula, kami menggunakan semula token [MASK]. Seperti yang ditunjukkan dalam Rajah 5, kandungan kawasan kotak bertitik hijau. Kita perlu mempertimbangkan bahawa terdapat terlalu banyak sumber maklumat input dan terdapat pilihan Maklumat, maklumat soalan dan maklumat segmen teks Maklumat antara mereka akan mempengaruhi satu sama lain, jadi kami berharap untuk mengasingkan maklumat yang berbeza, jika kita dapat melihat pilihan lain apabila menaip, maka kesukaran ini. soalan akan dikurangkan. (soalan, petikan) maklumat adalah berbeza; Matriks Topeng Perhatian Pengubahsuaian menghalang model daripada melihat maklumat pilihan yang berbeza, menyebabkan model menjadi lengai Bagaimana model melakukan soalan berbilang pilihan? dan OP) Seperti yang ditunjukkan dalam Rajah 7, kami ingin memproses berbilang tugasan MC dalam satu kelompok Meletakkan berbilang set data MC ke dalamnya boleh meningkatkan keupayaan model dan menjadikannya lebih bersatu Apabila kami membina kumpulan, kami mendapati masalah: Bagaimana jika terdapat sampel dengan pilihan yang berbeza dalam satu kelompok 🎜> Jadi kami mereka kaedah topeng logit di hadapan output. Dengan memberikan nilai ramalan infiniti negatif secara langsung kepada token yang tidak berkaitan, dan menambahkannya, kami boleh menghapuskan kesan token lain pada O-MASK apabila mengira softmax. Selain itu, bilangan soalan aneka pilihan yang berbeza boleh diproses secara seragam dalam satu kelompok. Rajah 7 Latihan dan ramalan model Latihan MC Berbeza daripada Penalaan Arahan FLAN, kami hanya melatih set data MC Ini terutamanya untuk membolehkan model mempelajari cara membuat soalan berbilang pilihan, dan set data MC mempunyai kepelbagaian tertentu, seperti berbeza. Set data mungkin terdiri daripada bilangan tag yang berbeza-beza. Rajah 8 Inferens Pukulan Sifar Menariknya, kita dapati bahawa kedua-dua tugasan ini boleh konsisten dalam dua peringkat latihan dan inferens pukulan sifar. Ini kerana kami menggunakan dua tugasan, O-MLM dan OP, untuk membenarkan model membuat soalan aneka pilihan. Dan kerana kami meninggalkan lapisan klasifikasi, semua parameter boleh digunakan semula, sekali gus mengaktifkan keupayaan Zero-shot PMLM. Rajah 9 Adegan Bahasa Inggeris Kami mengumpul 14 tugasan aneka pilihan untuk pra-latihan, dan kemudian melaksanakan tugas NLU lain untuk ujian prestasi sifar tangkapan. Dalam 4 tugasan NLI, UniMC mencapai SOTA dan melepasi 540 bilion parameter model PaLM. Rajah 10 Dan kamiTewaskan rangkaian dengan GPT-2 dan GPT-3 sebagai tulang belakang pada tugas pengelasan. Untuk tugasan Dbpedia yang sangat sukar, sehingga 13 kategori, ketepatan ultra tinggi 88.9% boleh dicapai. Rajah 11 Untuk meneroka generalisasi UNIMC, kami Perbandingan dibuat dengan FLAN. Seperti yang dapat dilihat, UniMC kami boleh mengatasi atau mendekati FLAN dalam hampir semua tugas. Gambar 12 Adegan Cina (Erlangshen dalam gambar - UnifiedMC ialah UniMC).

Rajah 14Ringkasan Selain itu, kami memperkenalkan hampir tiada maklumat tiruan. Dan ia mengatasi masalah ketidakkonsistenan antara pra-latihan dan penalaan halus model jenis BERT, dan latihan serta ramalan kami adalah konsisten. Kita juga boleh melakukan satu latihan dan berbilang ramalan sifar pukulan, yang sangat menjimatkan kos kuasa pengkomputeran. Pada masa ini, pasukan IDEA Fengshenban telah melancarkan lebih daripada 70 model besar yang telah dilatih. Petikan [1]Impossible Triangle : Apakah Seterusnya untuk Model Bahasa Pra-latihan?https://readpaper.com/paper/4612531641570566145

Prestasi UniMC

Rajah 13

Rajah 13

Atas ialah kandungan terperinci Memecahkan segitiga mustahil dan bersaing dengan 540 bilion model, pasukan Senarai Fengshen IDEA hanya mencapai SOTA pembelajaran sampel sifar dengan 200 juta model. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI