Rumah >Peranti teknologi >AI >Pembelajaran pelbagai tugasan berskala besar Jeff Dean SOTA telah dikritik, dan memerlukan kos sebanyak AS$60,000 untuk menghasilkan semula

Pembelajaran pelbagai tugasan berskala besar Jeff Dean SOTA telah dikritik, dan memerlukan kos sebanyak AS$60,000 untuk menghasilkan semula

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-09 10:31:08991semak imbas

Pada Oktober 2021, Jeff Dean secara peribadi menulis artikel yang memperkenalkan seni bina pembelajaran mesin baharu-Pathways.

Tujuannya sangat mudah, iaitu untuk membolehkan AI menjangkau puluhan ribu tugas, memahami pelbagai jenis data dan mencapainya dengan kecekapan yang sangat tinggi pada masa yang sama:

Lebih daripada setengah tahun kemudian, pada Mac 2022, Jeff Dean akhirnya mengeluarkan kertas Pathways.

Pautan kertas: https://arxiv.org/abs/2203.12533

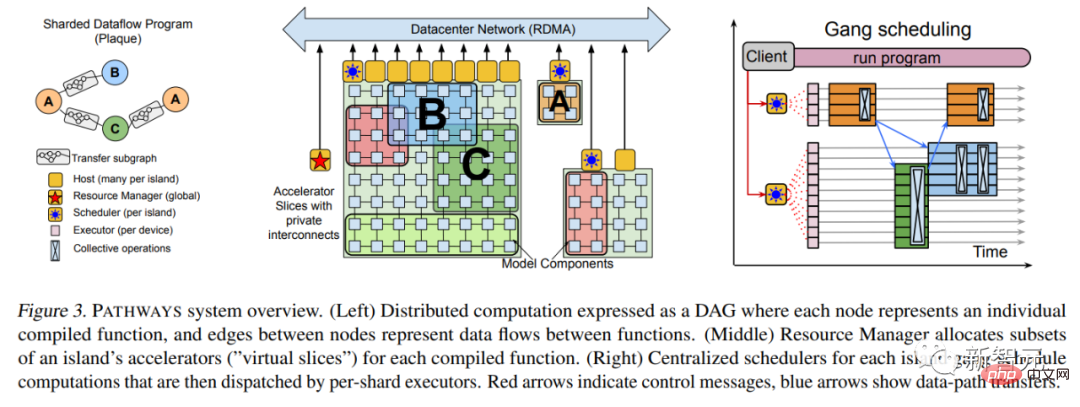

Antaranya, banyak maklumat teknikal adalah tambah Butiran, seperti seni bina sistem yang paling asas, dsb.

Pada April 2022, Google menggunakan model bahasa Pathways untuk muncul, secara berturut-turut memecahkan SOTA beberapa tugas pemprosesan bahasa semula jadi ini mempunyai 540 bilion parameter sekali lagi membuktikan bahawa "kuasa boleh melakukan keajaiban".

Selain menggunakan sistem Pathways yang berkuasa, kertas kerja memperkenalkan bahawa latihan PaLM menggunakan 6144 TPU v4 dan set data berkualiti tinggi sebanyak 780 bilion token, dan bahagian tertentu mereka korpus berbilang bahasa bukan Inggeris.

Alamat kertas: https://arxiv.org/abs/2204.02311

Baru-baru ini, karya baharu Jeff Dean menyebabkan satu lagi kekecohan Tekaan semua orang tentang Pathways.

Satu lagi kepingan teka-teki Pathways telah disatukan?

Hanya terdapat dua pengarang kertas ini: Jeff Dean yang terkenal dan jurutera Itali Andrea Gesmundo.

Apa yang menarik ialah Gesmundo bukan sahaja sangat rendah diri, tetapi Jeff Dean, yang baru sahaja meletupkan Imagennya sendiri dua hari lalu, langsung tidak menyebutnya di Twitter.

Selepas membacanya, beberapa netizen membuat spekulasi bahawa ini mungkin merupakan komponen Laluan seni bina AI generasi akan datang.

Alamat kertas: https://arxiv.org/abs/2205.12755

Idea artikel ini adalah sebagai berikut:

Dengan menggabungkan tugas baharu secara dinamik ke dalam sistem berjalan yang besar, serpihan model pembelajaran mesin berbilang tugas yang jarang boleh digunakan untuk meningkatkan kualiti tugas baharu dan boleh dikongsi secara automatik di kalangan tugas berkaitan Serpihan model.

Pendekatan ini boleh meningkatkan kualiti setiap tugas dan meningkatkan kecekapan model dari segi masa penumpuan, bilangan contoh latihan, penggunaan tenaga, dsb. Rangka kerja masalah pembelajaran mesin yang dicadangkan dalam artikel ini boleh dianggap sebagai generalisasi dan sintesis pemformalisasi pembelajaran berbilang tugas standard dan berterusan.

Di bawah rangka kerja ini, tidak kira betapa besarnya set tugasan, ia boleh diselesaikan bersama.

Selain itu, dari semasa ke semasa, set tugasan boleh dikembangkan dengan menambah aliran tugas baharu yang berterusan. Perbezaan antara tugas pra-latihan dan tugas hiliran juga hilang.

Oleh kerana, apabila tugasan baharu ditambah, sistem akan mencari cara untuk menggabungkan pengetahuan dan perwakilan sedia ada dengan keupayaan model baharu untuk mencapai tahap kualiti tinggi bagi setiap tugasan baharu . Pengetahuan dan perwakilan yang dipelajari semasa menyelesaikan tugasan baharu juga boleh digunakan dalam mana-mana tugasan masa hadapan, atau untuk meneruskan pembelajaran tentang tugasan sedia ada.

Kaedah ini dipanggil "Mutation Multi-Task Network" atau µ2Net. (μ=Mutasi)

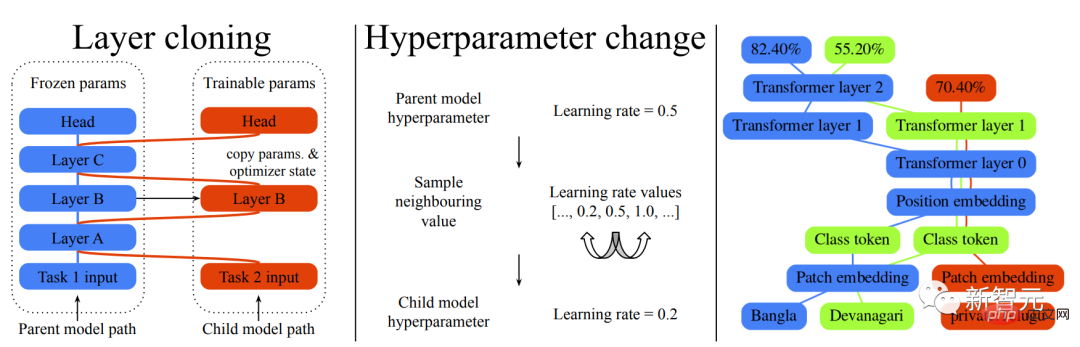

Dua jenis model mutasi untuk eksperimen pembelajaran berterusan berskala besar

Ringkasnya, ia adalah untuk menjana rangkaian berbilang tugas berskala besar untuk bersama-sama menyelesaikan pelbagai tugas. Bukan sahaja kualiti dan kecekapan setiap tugasan dipertingkatkan, tetapi model ini juga boleh dikembangkan dengan menambah tugasan baharu secara dinamik.

Semakin banyak pengetahuan yang tertanam dalam sistem terkumpul melalui pembelajaran tugasan sebelumnya, semakin tinggi kualiti penyelesaian untuk tugasan seterusnya.

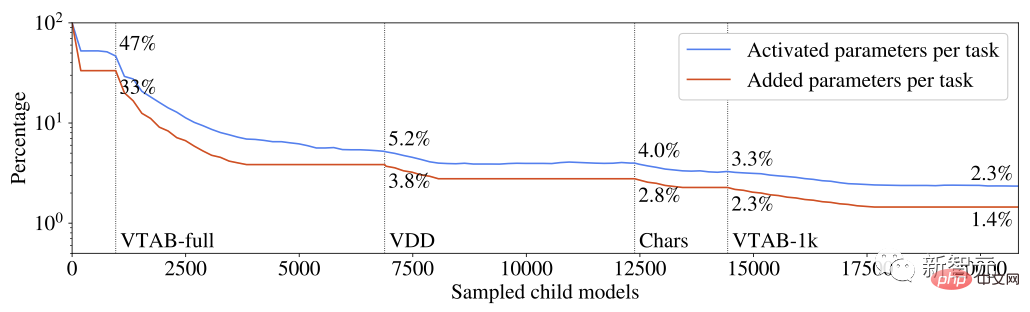

Selain itu, dari segi mengurangkan parameter yang baru ditambah bagi setiap tugasan, kecekapan menyelesaikan tugasan baharu boleh dipertingkatkan secara berterusan. Model berbilang tugas yang dijana jarang diaktifkan, dan model itu menyepadukan mekanisme penghalaan berasaskan tugas Apabila model berkembang, peningkatan dalam kos pengiraan setiap tugasan dijamin terhad.

Parameter diaktifkan dan meningkat mengikut setiap tugasan mengambil kira peratusan daripada jumlah parameter sistem berbilang tugas

Dipelajari daripada setiap tugasan Pengetahuan dibahagikan kepada bahagian yang boleh digunakan semula oleh pelbagai tugas. Eksperimen telah menunjukkan bahawa teknik chunking ini mengelakkan masalah biasa model pembelajaran berbilang tugas dan berterusan, seperti pelupaan bencana, gangguan kecerunan dan pemindahan negatif.

Penerokaan ruang laluan tugas dan pengenalpastian subset pengetahuan sedia ada yang paling relevan untuk setiap tugasan dipandu oleh algoritma evolusi yang direka untuk melaraskan keseimbangan penerokaan/ Eksploitasi secara dinamik tanpa perlu melaraskan meta-parameter secara manual. Logik evolusi yang sama digunakan untuk melaraskan komponen model berbilang tugas hiperparameter secara dinamik.

Memandangkan ia dipanggil "rangkaian mutasi", bagaimana anda menerangkan mutasi ini?

Rangkaian saraf dalam sering ditakrifkan oleh seni bina dan hiperparameter. Seni bina dalam artikel ini terdiri daripada satu siri lapisan rangkaian saraf. Setiap lapisan memetakan vektor input kepada vektor keluaran dimensi pembolehubah, dan butiran instantiasi rangkaian, seperti konfigurasi pengoptimum atau prapemprosesan data, ditentukan oleh hiperparameter.

Jadi mutasi yang disebutkan di sini juga terbahagi kepada dua kategori, mutasi klon lapisan dan mutasi hiperparameter.

Mutasi klon lapisan mencipta salinan mana-mana lapisan model induk yang boleh dilatih oleh model kanak-kanak. Jika lapisan model induk tidak dipilih untuk pengklonan, keadaan semasa dibekukan dan dikongsi dengan model anak untuk memastikan invarian model sedia ada.

Mutasi hiperparameter digunakan untuk mengubah suai konfigurasi yang diwarisi oleh lapisan anak daripada lapisan induk. Nilai baharu untuk setiap hiperparameter boleh diambil daripada set nilai yang sah. Untuk hiperparameter berangka, set nilai yang sah diisih sebagai senarai, dan pensampelan dihadkan kepada nilai bersebelahan untuk menggunakan kekangan perubahan tambahan.

Mari kita lihat kesan sebenar:

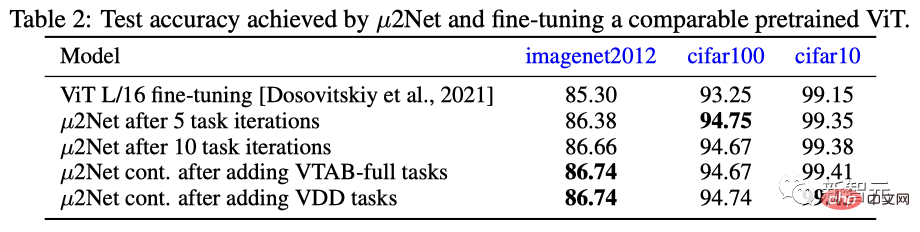

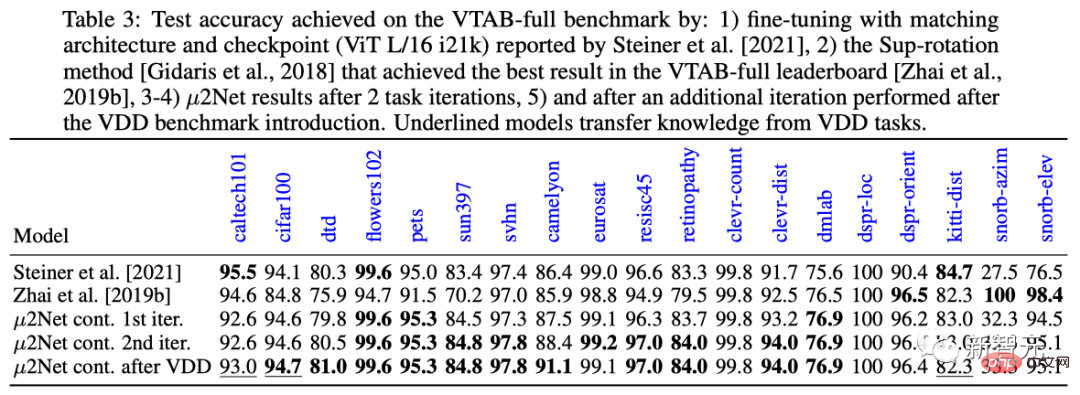

Pada tiga set data ImageNet 2012, cifar100 dan cifar10, µ2Net adalah dalam 5 Prestasi selepas lelaran tugas dan 10 lelaran tugasan melebihi model penalaan halus terlatih ViT yang paling serba boleh dan berprestasi terbaik semasa.

Dari segi pengembangan tugas, selepas menambah VTAB penuh dan tugas pembelajaran berterusan VDD, prestasi µ2Net telah dipertingkatkan lagi, dan prestasi tugas pembelajaran berterusan VDD pada set data cifar10 telah mencapai 99.43 % daripada keputusan terbaik.

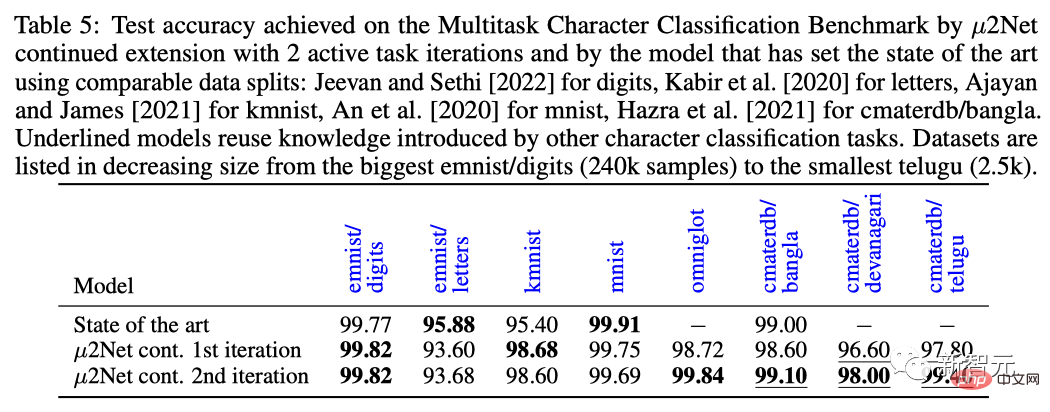

Pada tugasan penanda aras klasifikasi aksara berbilang tugas, selepas dua lelaran tugas, µ2Net menyegarkan semula tahap SOTA pada kebanyakan set data, dengan saiz set data antara 2.5k hingga 240k saiz sampel berbeza-beza.

Ringkasnya, di bawah seni bina ini, lebih banyak tugasan model belajar, lebih banyak pengetahuan yang dipelajari sistem dan lebih mudah untuk menyelesaikan tugasan baharu.

Sebagai contoh, seni bina ViT-L (307 juta parameter) boleh berkembang menjadi sistem berbilang tugas dengan 130.87 bilion parameter dan menyelesaikan 69 tugasan.

Selain itu, kesederhanaan pengaktifan parameter mengekalkan usaha pengiraan dan penggunaan memori bagi setiap tugasan yang berterusan apabila sistem berkembang. Eksperimen menunjukkan bahawa purata bilangan parameter tambahan untuk setiap tugasan dikurangkan sebanyak 38%, manakala sistem berbilang tugas hanya mengaktifkan 2.3% daripada jumlah parameter untuk setiap tugas.

Sudah tentu, pada ketika ini, ia hanyalah seni bina dan percubaan awal.

Netizen: Kertas itu sangat bagus, tetapi...

Walaupun kertas itu hebat, sesetengah orang nampaknya tidak membeli ia.

Sesetengah netizen yang suka mendedahkan pakaian baharu maharaja disiarkan di reddit, mengatakan bahawa mereka tidak lagi percaya pada cinta... Oh tidak, kertas AI yang dihasilkan oleh "makmal/institusi penyelidikan terkemuka " .

Netizen dengan ID "Mr. Acurite" berkata bahawa dia secara semula jadi percaya pada keputusan operasi data dan model dalam kertas ini.

Walau bagaimanapun, ambil kertas kerja ini oleh guru Jeff Dean sebagai contoh Kertas 18 halaman membincangkan tentang evolusi yang rumit dan algoritma pembelajaran berbilang tugas. menangkap sangat.

Walau bagaimanapun, terdapat dua perkara yang perlu dibuat:

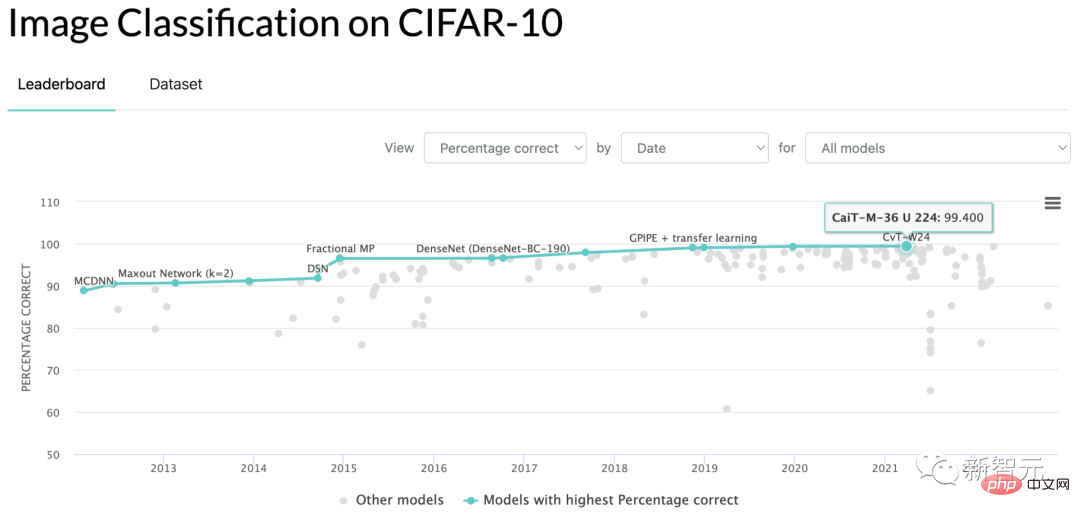

Pertama, apa yang dicadangkan oleh Jeff Dean dalam kertas itu membuktikan bahawa dia lebih baik daripada pertandingan. Keputusan skor larian ialah ketepatan ujian penanda aras CIFAR-10 ialah 99.43, yang lebih baik daripada SOTA semasa 99.40...

Saya tidak boleh mengatakan ini penipuan, tetapi sangat sukar untuk diterangkan dengan kata-kata.

Kedua, pada penghujung kertas, terdapat jadual penggunaan masa bagi algoritma larian TPU untuk mendapatkan hasil akhir, yang berjumlah 17810 jam.

Dengan mengandaikan seseorang yang tidak bekerja di Google mahu mengeluarkan semula hasil kertas tersebut dan menyewa TPU pada harga pasaran AS$3.22 sejam untuk menjalankannya semula, kosnya ialah AS$57,348.

Apakah maksudnya? Adakah anda perlu menetapkan ambang kecekapan walaupun untuk kertas harian?

Sudah tentu pendekatan ini kini menjadi trend dalam industri, termasuk tetapi tidak terhad kepada pemain besar seperti Google dan OpenAI. Semua orang mencurahkan beberapa idea kepada model untuk menambah baik status quo, dan banyak data dan penanda aras yang telah diproses.

Kemudian, selagi keputusan larian secara berangka lebih tinggi daripada lawan dengan genap dua tempat perpuluhan selepas mata peratusan, penyelidik dengan yakin boleh menambah baris tajuk tesis baharu ke resume!

Bagaimanakah ini benar-benar akan menggalakkan kalangan akademik dan industri? Pelajar siswazah biasa tidak mampu membelanjakan wang untuk mengesahkan kesimpulan anda, dan syarikat biasa tidak boleh menggunakan penanda aras yang membosankan dalam projek.

Ayat yang sama, apa maksudnya?

Adakah ini zon selesa yang boleh diterima di dunia AI? Sekumpulan kecil syarikat besar, dan kadangkala sekolah tinggi, menunjukkan setiap hari bahawa saya mempunyai wang dan boleh melakukan apa sahaja yang saya mahu, tetapi anda tidak mempunyai wang dan terpaksa ketinggalan?

Sekiranya kita terus seperti ini, sebaiknya kita membuka jurnal sains komputer lain untuk mengumpul kertas yang hasilnya boleh diterbitkan semula pada kad grafik tersendiri gred pengguna dalam masa lapan jam.

Dalam thread, pelajar siswazah dengan tugasan tesis mengeluh satu demi satu.

Seorang netizen yang IDnya ialah "Mesin Vektor Sokongan" berkata bahawa dia adalah seorang pengamal di makmal kecil Kerana momentum ini, dia hampir hilang motivasi untuk terus terlibat pembelajaran yang mendalam.

Kerana dengan bajet makmal saya sendiri, saya tidak dapat bersaing dengan gergasi ini, dan saya tidak dapat menghasilkan hasil penanda aras yang menunjukkan prestasi bahagian bawah.

Walaupun anda mempunyai idea teori baru, sukar untuk menulis kertas yang boleh lulus semakan. Ini kerana penyemak kertas semasa telah membangunkan "bias gambar yang indah" kerana keupayaan pengeluar utama Imej yang digunakan untuk ujian dalam kertas itu tidak kelihatan baik, dan semuanya sia-sia.

Itu tidak bermakna pengeluar gergasi tidak berguna Projek seperti GPT dan DALL-E benar-benar hebat. Tetapi jika mesin saya sendiri tidak boleh berjalan, mengapa saya perlu teruja?

Seorang lagi netizen yang merupakan pelajar kedoktoran muncul dan mengulas siaran itu untuk menyokong "mesin vektor sokongan".

Pelajar kedoktoran menyerahkan kertas mengenai model aliran dua tahun lalu, yang tertumpu terutamanya pada penemuan ruang potensi data yang boleh dijadikan sampel, dan tidak memberi kesan kepada kualiti penjanaan imej model.

Akibatnya, komen kritikal yang diberikan oleh penggred kertas ialah: "Imej yang dijana tidak kelihatan sebaik yang dijana oleh GAN."

Seorang lagi pelajar siswazah dengan nama ID "Uday" juga berkata bahawa pengkritik yang menilai kertas yang diserahkannya untuk persidangan pada tahun 2021 ialah: "Data tidak cukup mewah."

Nampaknya tenaga manusia tidak sekuat wang Ia benar-benar trend di seluruh dunia bahawa psikologi Timur dan Barat tidak sama, dan Taoisme antara China dan negara luar tidak rosak.

Hanya dalam tempoh tiga puluh tahun di Hedong dan tiga puluh tahun di Hexi, mungkin pelaksanaan akar umbi algoritma dan permodalan sejagat akan membawa keajaiban kedua pemula garaj mengalahkan IBM.

Atas ialah kandungan terperinci Pembelajaran pelbagai tugasan berskala besar Jeff Dean SOTA telah dikritik, dan memerlukan kos sebanyak AS$60,000 untuk menghasilkan semula. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI