Rumah >Peranti teknologi >AI >Pembelajaran mendalam mencecah dinding? Siapa yang mengacaukan sarang tebuan antara LeCun dan Marcus?

Pembelajaran mendalam mencecah dinding? Siapa yang mengacaukan sarang tebuan antara LeCun dan Marcus?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-09 09:41:081204semak imbas

Protagonis hari ini ialah sepasang musuh lama yang menyayangi antara satu sama lain dalam industri AI:

Yann LeCun dan Gary Marcus

Sebelum kita secara rasmi bercakap tentang "perselisihan baru" ini, mari dahulu Mari kita semak semula "kebencian lama" antara dua tuhan yang agung.

Pertempuran antara LeCun dan Marcus

Ketua saintis kecerdasan buatan di Facebook dan profesor di New York University, 2018 Pemenang Anugerah Turing (Turing Award) Yann LeCun menerbitkan artikel dalam majalah NOEMA sebagai tindak balas kepada komen Gary Marcus sebelum ini tentang AI dan pembelajaran mendalam.

Sebelum ini, Marcus menerbitkan artikel dalam majalah Nautilus, mengatakan bahawa pembelajaran mendalam telah "tidak dapat bergerak ke hadapan"

Marcus ialah seorang yang menonton keseronokan tanpa mengambil sebarang masalah.

Sebaik sahaja berlaku sedikit gangguan, dia berkata "AI sudah mati", menyebabkan kekecohan dalam bulatan!

Saya telah menyiarkan berkali-kali sebelum ini, memanggil GPT-3 "Karut" dan "omong kosong".

Bukti kuku besi ada di sini:

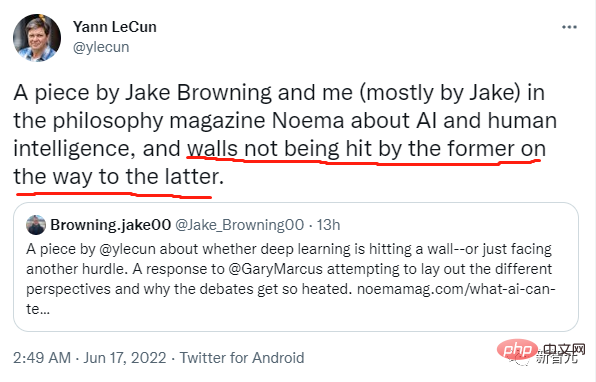

Lelaki yang baik, dia sebenarnya berkata bahawa "pembelajaran mendalam telah melanda dinding ", melihat betapa berleluasanya Komen, LeCun, bintang besar dalam industri AI, tidak boleh duduk diam dan segera menghantar respons!

Dan berkata, jika anda mahu beratur, saya akan menemani anda!

LeCun menyangkal pandangan Marcus satu persatu dalam artikel tersebut.

Mari kita lihat bagaimana tuan menulis dalam jawapan~~

Berikut ialah artikel panjang LeCun:

Teknologi utama kecerdasan buatan kontemporari ialah pembelajaran mendalam (DL ) ) Rangkaian Neural (NN), algoritma pembelajaran kendiri berskala besar yang cemerlang dalam mengenal pasti dan mengeksploitasi corak dalam data. Sejak awal, pengkritik percaya bahawa rangkaian saraf telah melanda "dinding yang tidak dapat diatasi tetapi setiap kali, ia terbukti menjadi halangan sementara."

Pada tahun 1960-an, NN tidak dapat menyelesaikan fungsi tak linear. Tetapi keadaan ini tidak bertahan lama Ia telah diubah pada tahun 1980-an dengan kemunculan backpropagation, tetapi "tembok tidak dapat diatasi" baru muncul lagi, iaitu, sangat sukar untuk melatih sistem.

Pada tahun 1990-an, manusia membangunkan prosedur yang dipermudahkan dan struktur piawai, yang menjadikan latihan lebih dipercayai, tetapi tidak kira apa keputusan yang dicapai, nampaknya sentiasa ada "dinding yang tidak dapat diatasi". data latihan dan kuasa pengiraan.

Pembelajaran mendalam mula menjadi arus perdana pada tahun 2012, apabila GPU terkini boleh melatih set data ImageNet yang besar, dengan mudah mengalahkan semua pesaing. Tetapi kemudian, suara keraguan muncul: orang menemui "tembok baharu" - latihan pembelajaran mendalam memerlukan sejumlah besar data yang dilabel secara manual.

Namun, dalam beberapa tahun kebelakangan ini, keraguan ini menjadi tidak bermakna, kerana pembelajaran penyeliaan kendiri telah mencapai keputusan yang agak baik, seperti GPT-3, yang tidak memerlukan data berlabel.

Halangan yang tidak dapat diatasi hari ini ialah "penaakulan simbolik," iaitu keupayaan untuk memanipulasi simbol dalam cara algebra atau logik. Seperti yang kita pelajari semasa kanak-kanak, menyelesaikan masalah matematik memerlukan memanipulasi simbol langkah demi langkah mengikut peraturan yang ketat (cth., menyelesaikan persamaan).

Gary Marcus, pengarang "The Algebraic Mind" dan pengarang bersama "Rebooting AI", baru-baru ini percaya bahawa DL tidak dapat membuat kemajuan selanjutnya kerana rangkaian saraf mengalami kesukaran memproses operasi simbolik tersebut. Sebaliknya, ramai penyelidik DL percaya bahawa DL sudah melakukan penaakulan simbolik dan akan terus bertambah baik.

Inti perbahasan ini ialah peranan simbol dalam kecerdasan buatan Terdapat dua pandangan yang berbeza: satu percaya bahawa penaakulan simbolik mesti dikodkan secara keras dari awal, manakala yang lain percaya bahawa mesin boleh belajar melalui pengalaman kebolehan menaakul secara simbolik. Oleh itu, pokok persoalannya ialah bagaimana kita harus memahami kecerdasan manusia, dan oleh itu bagaimana kita harus mengejar kecerdasan buatan yang boleh mencapai tahap manusia.

Jenis kecerdasan buatan yang berbeza

Perkara yang paling penting tentang penaakulan simbolik ialah ketepatan: mengikut pilih atur dan gabungan, simbol boleh mempunyai banyak susunan yang berbeza, seperti "(3-2)- 1 dan 3- (2-1)" adalah penting, jadi cara melaksanakan penaakulan simbolik yang betul dalam susunan yang betul adalah penting.

Marcus percaya bahawa penaakulan jenis ini adalah teras kognisi dan penting untuk menyediakan logik tatabahasa asas untuk bahasa dan operasi asas untuk matematik. Dia percaya bahawa ini boleh memanjangkan kebolehan kita yang lebih asas, dan di sebalik kebolehan ini, terdapat logik simbolik yang mendasari.

Kecerdasan buatan yang kita kenali bermula dari kajian penaakulan seperti ini, sering dipanggil "kecerdasan buatan simbolik". Tetapi memperhalusi kepakaran manusia menjadi satu set peraturan adalah sangat mencabar dan memakan masa dan kos buruh yang besar. Ini adalah apa yang dipanggil "kesesakan pemerolehan pengetahuan."

Walaupun mudah untuk menulis peraturan untuk matematik atau logik, dunia itu sendiri adalah hitam dan putih dan sangat kabur Ternyata mustahil untuk manusia menulis peraturan yang mengawal setiap corak atau untuk setiap Konsep kabur simbol definisi.

Walau bagaimanapun, perkembangan sains dan teknologi telah mencipta rangkaian saraf, dan rangkaian saraf yang terbaik ialah menemui corak dan menerima kesamaran.

Rangkaian saraf ialah persamaan yang agak mudah yang mempelajari fungsi untuk menyediakan output yang sesuai untuk apa sahaja input kepada sistem.

Sebagai contoh, untuk melatih rangkaian dua klasifikasi, letakkan sejumlah besar data sampel (di sini, kami mengambil kerusi sebagai contoh) ke dalam rangkaian saraf dan melatihnya untuk beberapa zaman , pelaksanaan terakhir membolehkan rangkaian berjaya membuat kesimpulan sama ada imej baharu adalah kerusi.

Secara terang-terangan, ini bukan sekadar persoalan tentang kecerdasan buatan, tetapi lebih penting lagi, apakah kecerdasan dan cara otak manusia berfungsi. ”

Rangkaian saraf ini boleh dilatih dengan tepat kerana fungsi yang melaksanakannya boleh dibezakan dengan kata lain, jika AI simbolik adalah serupa dengan token diskret yang digunakan dalam logik simbolik, maka rangkaian saraf adalah fungsi kalkulus yang berterusan.

Ini membolehkan pembelajaran perwakilan yang lebih baik dengan memperhalusi parameter, yang bermaksud ia boleh memuatkan data dengan lebih sesuai tanpa masalah kurang muat atau terlalu muat Walau bagaimanapun, apabila ia berkaitan dengan Kecairan ini mencipta yang baharu "dinding" apabila ia berkaitan dengan peraturan yang ketat dan token diskret: apabila kita menyelesaikan persamaan, kita biasanya mahukan jawapan yang tepat, bukan jawapan anggaran.

Di sinilah AI Symbolic bersinar, jadi Marcus mencadangkan hanya menggabungkan kedua-duanya: memasukkan modul manipulasi simbolik berkod keras di atas modul DL.

Ini menarik kerana kedua-dua pendekatan saling melengkapi dengan baik, jadi nampaknya "hibrid" modul dengan cara kerja yang berbeza akan memaksimumkan kelebihan kedua-dua pendekatan.

Tetapi perbahasan beralih kepada sama ada manipulasi simbolik perlu dibina ke dalam sistem di mana simbol dan keupayaan manipulasi direka oleh manusia dan modul itu tidak boleh dibezakan - dan oleh itu tidak serasi dengan DL.

"penaakulan simbolik" legenda

Hipotesis ini sangat kontroversi.

Rangkaian saraf tradisional percaya bahawa kita tidak perlu melakukan penaakulan simbolik secara manual, tetapi boleh mempelajari penaakulan simbolik, iaitu, menggunakan contoh simbolik untuk melatih mesin melakukan jenis penaakulan yang betul, membolehkannya mempelajari penyiapan corak abstrak. Pendek kata, mesin boleh belajar memanipulasi simbol di dunia, walaupun tanpa simbol buatan tangan terbina dalam dan peraturan manipulasi simbol.

Model bahasa berskala besar kontemporari seperti GPT-3 dan LaMDA menunjukkan potensi pendekatan ini. Keupayaan mereka untuk memanipulasi simbol adalah menakjubkan, dan model ini mempamerkan penaakulan akal yang menakjubkan, kebolehan gabungan, kebolehan berbilang bahasa, kebolehan logik dan matematik, dan juga kebolehan yang menakutkan untuk meniru orang mati.

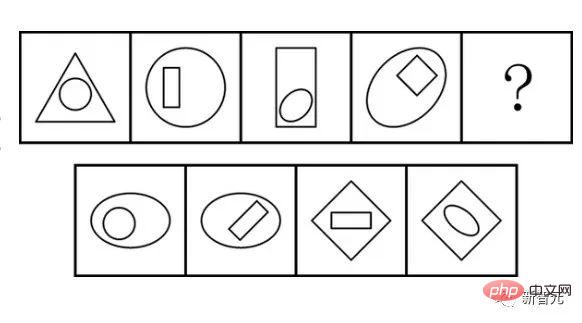

Tetapi ini sebenarnya tidak boleh dipercayai. Jika anda meminta DALL-E untuk membuat arca Rom seorang ahli falsafah dengan janggut, cermin mata dan baju tropika, ia akan menjadi luar biasa. Tetapi jika anda memintanya untuk melukis burung pemburu yang memakai mainan merah jambu mengejar tupai, kadangkala anda akan mendapat burung pemburu yang memakai mainan merah jambu atau tupai.

Ia berfungsi dengan baik apabila ia boleh menetapkan semua sifat kepada satu objek, tetapi ia tersekat apabila terdapat berbilang objek dan berbilang sifat. Sikap ramai penyelidik adalah bahawa ini adalah "tembok" untuk DL di jalan menuju kecerdasan yang lebih seperti manusia.

Jadi, adakah operasi simbolik perlu dikodkan dengan keras atau boleh dipelajari

Ini bukan yang Marcus faham.

Dia beranggapan bahawa penaakulan simbolik adalah semua-atau-tiada - kerana DALL-E tidak mempunyai simbol dan peraturan logik untuk mendasarkan operasinya, ia sebenarnya tidak membuat alasan menggunakan simbol. Oleh itu, banyak kegagalan model bahasa besar menunjukkan bahawa mereka bukan penaakulan yang benar, tetapi hanya tiruan mekanikal tanpa emosi.

Adalah mustahil untuk Marcus memanjat pokok yang cukup besar untuk sampai ke bulan. Oleh itu, dia percaya bahawa model bahasa DL semasa tidak lebih dekat dengan bahasa sebenar daripada Nim Chimpsky (cimpanzi jantan yang boleh menggunakan Bahasa Isyarat Amerika). Masalah DALL-E bukanlah kekurangan latihan. Ia hanyalah sistem yang tidak memahami struktur logik asas ayat, dan oleh itu tidak dapat memahami dengan betul bagaimana bahagian yang berbeza harus disambungkan menjadi satu keseluruhan.

Sebaliknya, Geoffrey Hinton dan yang lain percaya bahawa rangkaian saraf boleh berjaya memanipulasi simbol tanpa memerlukan simbol berkod keras dan penaakulan algebra. Matlamat DL bukanlah manipulasi simbolik di dalam mesin, sebaliknya belajar untuk menjana simbol yang betul daripada sistem di dunia.

Penolakan untuk mencampurkan kedua-dua modaliti itu bukanlah terburu-buru tetapi berdasarkan perbezaan falsafah sama ada seseorang percaya penaakulan simbolik boleh dipelajari.

Logik asas pemikiran manusia

Kritikan Marcus terhadap DL berpunca daripada perdebatan berkaitan dalam sains kognitif tentang cara kecerdasan berfungsi dan perkara yang menjadikan manusia unik. Pandangannya konsisten dengan aliran pemikiran "nativis" yang terkenal dalam psikologi, yang berpendapat bahawa banyak ciri utama kognisi adalah semula jadi - sebenarnya, kita sebahagian besarnya dilahirkan mengetahui cara dunia berfungsi.

Inti persepsi semula jadi ini ialah keupayaan untuk memanipulasi simbol (tetapi sama ada ini ditemui di seluruh alam semula jadi atau unik kepada manusia masih belum disimpulkan). Bagi Marcus, keupayaan untuk memanipulasi simbol ini mendasari banyak ciri asas akal sehat: mengikut peraturan, abstraksi, penaakulan sebab, pengenalan semula butiran, generalisasi dan banyak lagi kebolehan lain.

Ringkasnya, kebanyakan pemahaman kita tentang dunia diberikan secara semula jadi, dan pembelajaran adalah tentang memperkayakan butiran.

Terdapat satu lagi pandangan empirikal yang mematahkan idea di atas: manipulasi simbol jarang berlaku dan terutamanya keupayaan komunikasi yang dipelajari yang diperoleh oleh nenek moyang manusia purba kita secara beransur-ansur sejak 2 juta tahun yang lalu.

Dari perspektif ini, kebolehan kognitif utama ialah kebolehan pembelajaran bukan simbolik yang berkaitan dengan keupayaan kelangsungan hidup yang lebih baik, seperti mengenal pasti mangsa dengan cepat, meramalkan kemungkinan tindakan mereka dan membangunkan respons mahir.

Pandangan ini berpendapat bahawa kebanyakan kebolehan kognitif yang kompleks diperoleh melalui kebolehan pembelajaran umum yang diselia sendiri. Ia juga menganggap bahawa kebanyakan kebolehan kognitif kompleks kita tidak bergantung pada operasi simbolik. Sebaliknya, mereka mensimulasikan pelbagai senario dan meramalkan hasil terbaik.

Pandangan empirikal ini menganggap simbol dan manipulasi simbol hanyalah satu lagi kebolehan yang dipelajari, diperoleh apabila manusia semakin bergantung pada tingkah laku kerjasama untuk berjaya. Ini melihat simbol sebagai ciptaan yang kami gunakan untuk menyelaraskan kerjasama antara kumpulan - seperti perkataan, tetapi juga peta, penerangan ikonik, ritual dan juga peranan sosial.

Perbezaan antara dua pandangan ini sangat jelas. Bagi tradisi nativis, simbol dan manipulasi simbol sememangnya wujud dalam minda, dan penggunaan perkataan dan nombor berasal daripada kapasiti primitif ini. Pandangan ini menerangkan dengan menarik kebolehan yang timbul daripada penyesuaian evolusi (walaupun penjelasan tentang bagaimana atau mengapa manipulasi simbol berkembang menjadi kontroversi).

Dari perspektif tradisi empiris, simbol dan penaakulan simbolik ialah ciptaan komunikatif yang berguna yang timbul daripada kebolehan pembelajaran umum dan dunia sosial kita yang kompleks. Ini menganggap perkara simbolik yang berlaku dalam kepala kita, seperti pengiraan dalaman dan monolog dalaman, sebagai amalan luaran yang timbul daripada penggunaan matematik dan bahasa.

Bidang kecerdasan buatan dan sains kognitif saling berkait rapat, jadi tidak hairanlah bahawa pertempuran ini muncul semula di sini. Memandangkan kejayaan mana-mana perspektif dalam kecerdasan buatan sebahagiannya (tetapi hanya sebahagiannya) membuktikan satu atau lain pendekatan dalam sains kognitif, tidaklah menghairankan bahawa perdebatan ini menjadi sengit.

Kunci kepada masalah ini bukan sahaja cara menyelesaikan masalah dengan betul dalam bidang kecerdasan buatan kontemporari, tetapi juga kecerdasan buatan dan bagaimana otak berfungsi.

Patutkah saya bertaruh pada AI atau gagal?

Mengapa kenyataan "pembelajaran mendalam melanda dinding" begitu provokatif?

Jika Marcus betul, maka pembelajaran mendalam tidak akan dapat mencapai AI seperti manusia, tidak kira berapa banyak seni bina baharu yang dihasilkannya, atau berapa banyak kuasa pengkomputeran yang dimasukkan ke dalamnya.

Teruskan menambah lebih banyak lapisan pada rangkaian saraf hanya akan menjadikan perkara lebih mengelirukan, kerana manipulasi simbol sebenar memerlukan manipulator simbol semula jadi. Oleh kerana operasi simbolik semacam ini adalah asas kepada beberapa kebolehan akal, DL hanya akan "tidak memahami" apa-apa.

Sebaliknya, jika penyokong DL dan ahli empiris betul, apa yang membingungkan ialah idea untuk memasukkan modul untuk manipulasi simbol.

Dalam kes ini, sistem pembelajaran mendalam sudah pun melakukan penaakulan simbolik dan akan terus bertambah baik apabila mereka menggunakan lebih banyak pembelajaran penyeliaan kendiri multimodal, model dunia ramalan yang semakin berguna, dan Pengembangan memori kerja untuk simulasi dan hasil penilaian untuk lebih baik memenuhi kekangan.

Memperkenalkan modul manipulasi simbolik tidak akan mencipta AI yang lebih seperti manusia Sebaliknya, ia akan memaksa semua operasi "penaakulan" untuk melalui kesesakan yang tidak perlu, yang akan membawa kita lebih jauh daripada "seperti manusia. kecerdasan". Ini mungkin memotong salah satu aspek pembelajaran mendalam yang paling menarik: keupayaannya untuk menghasilkan penyelesaian yang lebih baik daripada manusia.

Setelah berkata demikian, semua ini tidak membenarkan gembar-gembur bodoh: memandangkan sistem semasa tidak sedar, mereka tidak dapat memahami kita, pembelajaran pengukuhan tidak mencukupi, dan anda tidak boleh membina humanoid hanya dengan meningkatkannya secara pintar. Tetapi semua isu ini adalah "isu tepi" dalam perbahasan utama: Adakah operasi simbolik perlu dikodkan dengan keras Atau bolehkah ia dipelajari?

Ini adalah seruan untuk berhenti mempelajari model hibrid (iaitu, model? dengan model manipulator simbolik yang tidak boleh dibezakan)? Orang harus memilih apa yang berkesan.

Walau bagaimanapun, penyelidik telah mengusahakan model hibrid sejak 1980-an, tetapi mereka belum terbukti sebagai pendekatan yang berkesan dan dalam banyak kes berkemungkinan jauh lebih rendah daripada rangkaian saraf.

Secara umum, seseorang harus tertanya-tanya sama ada pembelajaran mendalam telah mencapai had atasnya.

Atas ialah kandungan terperinci Pembelajaran mendalam mencecah dinding? Siapa yang mengacaukan sarang tebuan antara LeCun dan Marcus?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI