Rumah >Peranti teknologi >AI >Gary Marcus: Sistem imej yang dijana teks tidak dapat memahami dunia dan jauh daripada AGI

Gary Marcus: Sistem imej yang dijana teks tidak dapat memahami dunia dan jauh daripada AGI

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-09 09:31:031479semak imbas

Artikel ini diterbitkan semula daripada Lei Feng.com Jika anda perlu mencetak semula, sila pergi ke tapak web rasmi Lei Feng.com untuk memohon kebenaran.

Sejak kemunculan DALL-E 2, ramai orang percaya bahawa AI yang mampu melukis imej realistik adalah satu langkah besar ke arah kecerdasan am buatan (AGI). Ketua Pegawai Eksekutif OpenAI Sam Altman pernah mengisytiharkan "AGI akan menjadi liar" apabila DALL-E 2 dikeluarkan, dan media juga membesar-besarkan kepentingan sistem ini untuk kemajuan kecerdasan am.

Tetapi adakah ia benar-benar begitu? Gary Marcus, seorang sarjana dan peminat AI terkenal yang menuangkan air sejuk pada AI, menyatakan "tempahan."

Baru-baru ini, beliau mencadangkan bahawa apabila menilai kemajuan dalam AGI, kuncinya adalah untuk melihat sama ada sistem seperti Dall-E, Imagen, Midjourney dan Stable Diffusion benar-benar memahami dunia dan boleh membuat alasan berdasarkan pengetahuan itu dan membuat keputusan.

Apabila menilai kepentingan sistem ini kepada AI (termasuk AI sempit dan luas), kita boleh bertanya tiga soalan berikut:

Bolehkah sistem sintesis imej Menjana tinggi imej berkualiti?

Bolehkah mereka mengaitkan input bahasa dengan imej yang mereka hasilkan?

Adakah mereka memahami dunia di sebalik imej yang mereka wakili?

1 AI tidak memahami hubungan antara bahasa dan imej

Pada soalan pertama, jawapannya ialah ya. Satu-satunya perbezaan ialah artis manusia yang terlatih boleh melakukan kerja yang lebih baik dalam menggunakan AI untuk menjana imej.

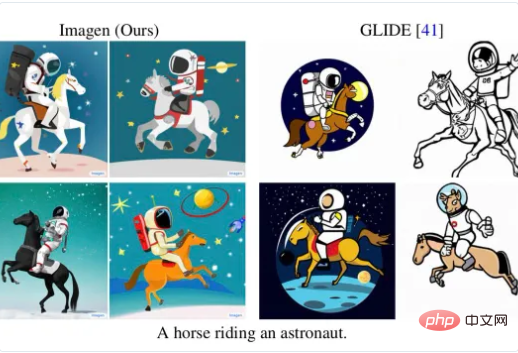

Pada soalan kedua, jawapannya tidak semestinya pasti. Sistem ini boleh berfungsi dengan baik pada input bahasa tertentu Sebagai contoh, gambar di bawah ialah "angkasawan di atas kuda" yang dihasilkan oleh DALL-E 2:

Tetapi dalam kes lain. Pada sesetengah input bahasa, AI ini berprestasi buruk dan mudah tertipu. Sebagai contoh, Marcus menegaskan di Twitter suatu ketika dahulu bahawa sistem ini mengalami kesukaran menjana imej tepat yang sepadan apabila berhadapan dengan "kuda menunggang angkasawan":

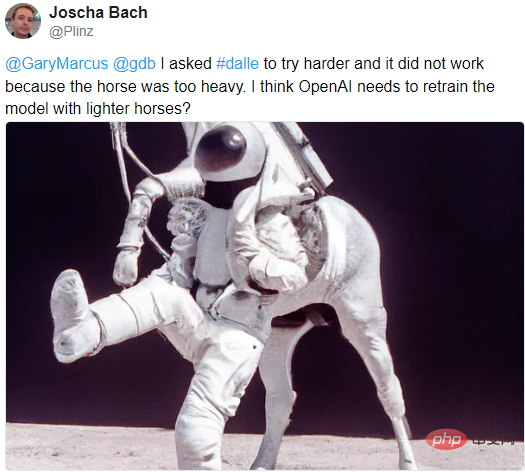

Walaupun penyokong pembelajaran mendalam telah menentangnya dengan keras, seperti penyelidik AI Joscha Bach yang percaya bahawa "Imagen mungkin hanya menggunakan set latihan yang salah", profesor pembelajaran mesin Luca Ambrogioni menyangkal bahawa ini menunjukkan bahawa "Imagen sudah mempunyai tahap kewarasan tertentu", jadi enggan menjana sesuatu yang tidak masuk akal.

Terdapat juga seorang saintis Google Behnam Neyshabur yang mencadangkan bahawa jika "ditanya dengan cara yang betul", Imej boleh melukis "kuda menunggang angkasawan":

Walau bagaimanapun, Marcus percaya bahawa kunci kepada masalah itu bukan sama ada sistem dapat menghasilkan imej. Tidak ada pemahaman mendalam tentang hubungan antara bahasa dan imej, yang merupakan kuncinya.

2 Tidak tahu apa itu roda basikal? Bagaimanakah ia boleh dipanggil AGI?

Pemahaman bahasa sistem hanya satu aspek Marcus menegaskan bahawa perkara yang paling penting ialah menilai sumbangan sistem seperti DALL-E kepada AGI akhirnya bergantung kepada soalan ketiga: Jika semua sistem boleh. lakukan ialah Menukarkan banyak ayat kepada imej secara tidak sengaja tetapi menakjubkan, ia mungkin merevolusikan seni manusia, tetapi masih tidak benar-benar setanding dengan, dan tidak mewakili, AGI sama sekali.

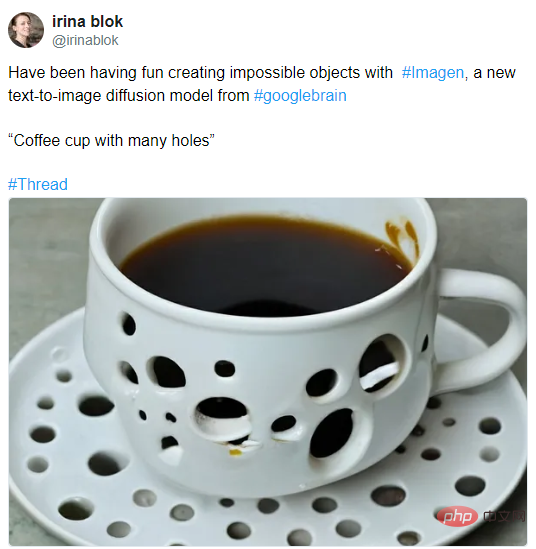

Apa yang membuatkan Marcus putus asa tentang keupayaan sistem ini untuk memahami dunia ialah contoh terkini, seperti imej "cawan kopi dengan banyak lubang" pereka grafik Irina Blok yang dihasilkan dengan Imagen:

Orang biasa akan mendapati gambar ini bertentangan dengan akal sehat. Yang serupa termasuk:

“Basikal dengan roda segi empat sama”

Gary Marcus: Sistem imej yang dijana teks tidak dapat memahami dunia dan jauh dari AGI

“Kertas tandas yang ditutup dengan duri kaktus”

Gary Marcus: Sistem imej yang dihasilkan teks tidak dapat memahami dunia dan jauh dari AGI

Mudah untuk mengatakan "ya" tetapi sukar untuk mengatakan "tidak", siapa Bolehkah anda tahu rupa benda yang tidak wujud? Di sinilah kesukarannya untuk mendapatkan AI untuk melukis perkara yang mustahil.

Tetapi mungkin, sistem hanya "mahu" untuk melukis imej yang nyata, seperti yang dikatakan oleh profesor penyelidikan DeepMind Michael Bronstein, dia tidak fikir itu adalah keputusan yang buruk, tetapi dia juga boleh melukis seperti ini.

Jadi bagaimana untuk menyelesaikan masalah ini? Gary Marcus menemui inspirasi baru dalam perbualan baru-baru ini dengan ahli falsafah Dave Chalmers.

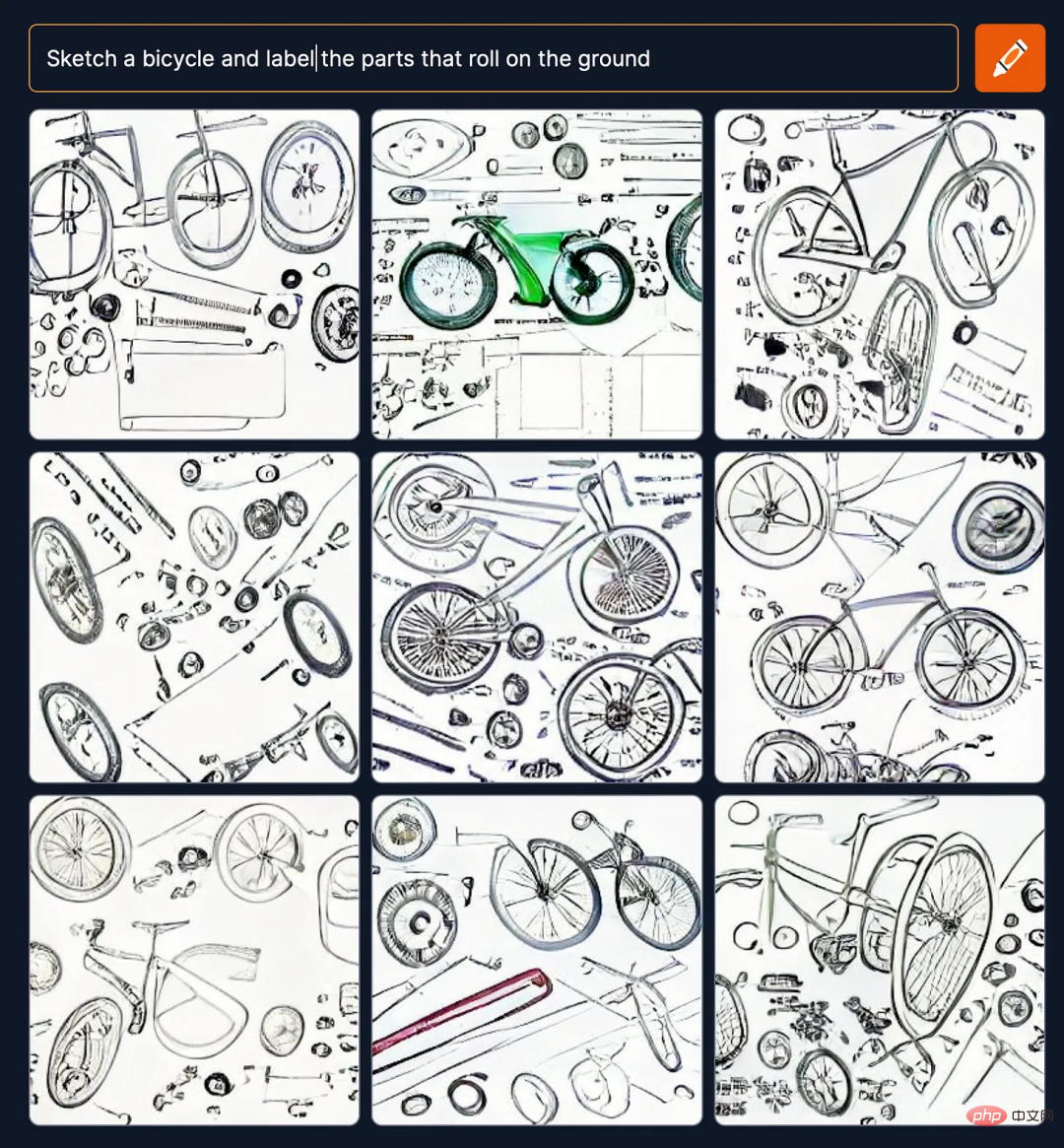

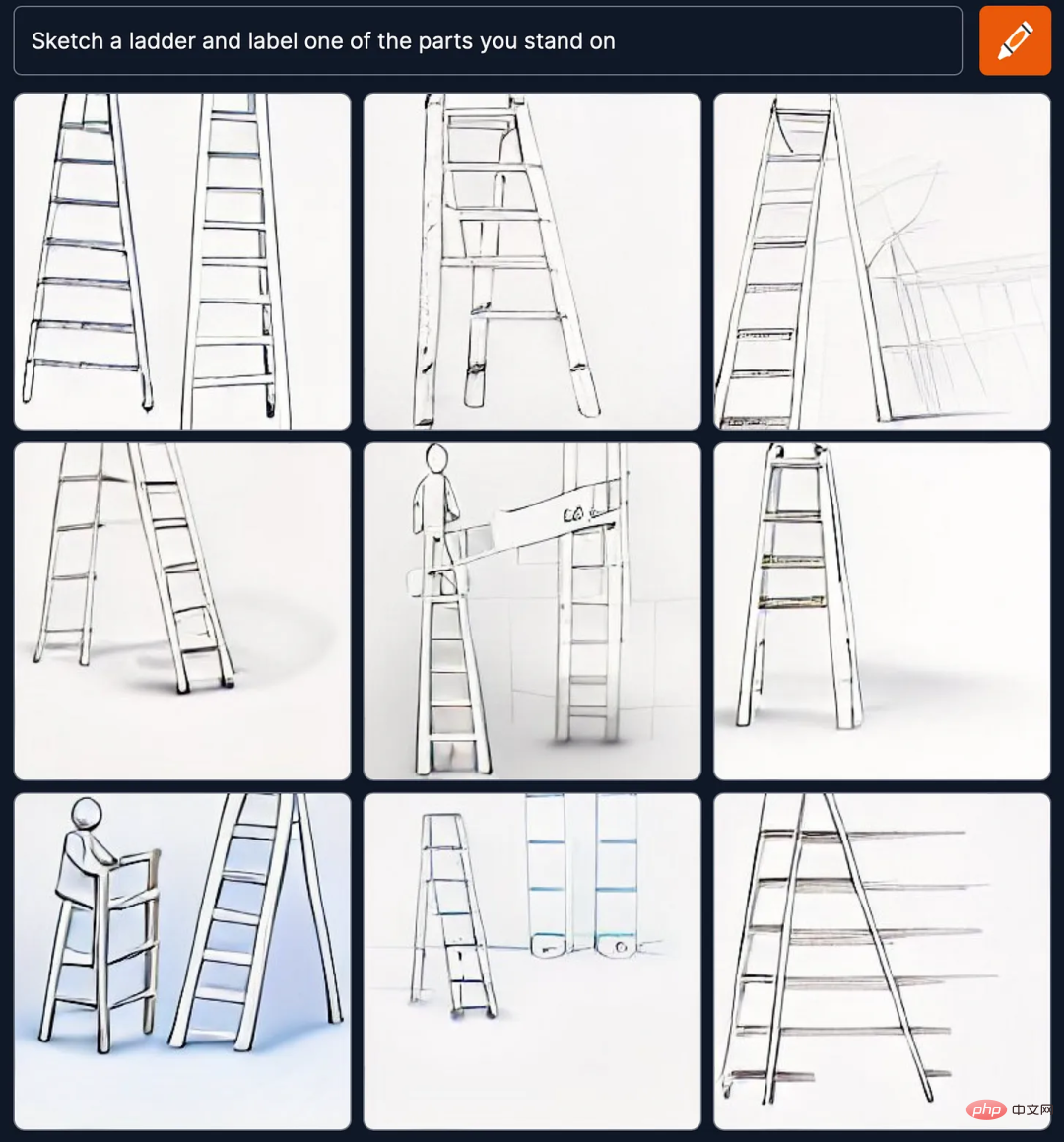

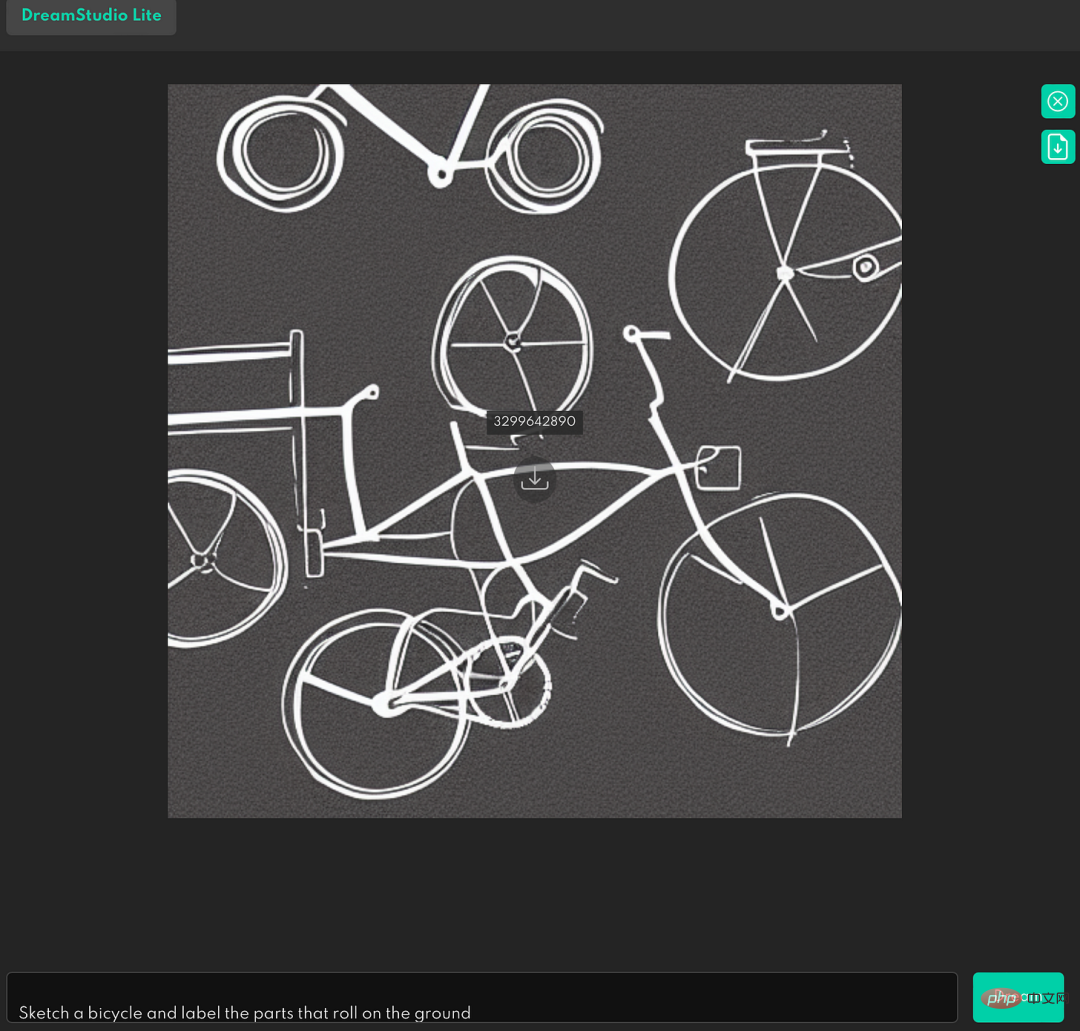

Untuk memahami pemahaman sistem tentang bahagian dan keseluruhan serta fungsi, Gary Marcus mencadangkan tugasan untuk mempunyai idea yang lebih jelas sama ada prestasi sistem adalah betul, memberikan teks gesaan “Lakaran basikal dan labelkan bahagian yang bergolek di atas tanah" dan "Lakarkan tangga dan labelkan salah satu bahagian yang anda berdiri di atas").

Keistimewaan ujian ini ialah ia tidak memberikan gesaan secara langsung seperti "Lukis basikal dan tandakan roda" atau "Lukis tangga dan tandakan pedalnya". daripada huraian seperti "bahagian bergolek di atas tanah" dan "bahagian berdiri" adalah ujian keupayaan AI untuk memahami dunia.

Tetapi keputusan ujian Marcus menunjukkan bahawa Craiyon (dahulunya dikenali sebagai DALL-E mini) sangat teruk dalam perkara sebegini Ia tidak memahami apa itu roda basikal dan pedal tangga:

Jadi adakah ini masalah unik untuk DALL-E Mini?

Gary Marcus mendapati bahawa ia tidak begitu. Hasil yang sama juga muncul dalam Stable Diffusion, sistem imej penjanaan teks yang paling popular pada masa ini.

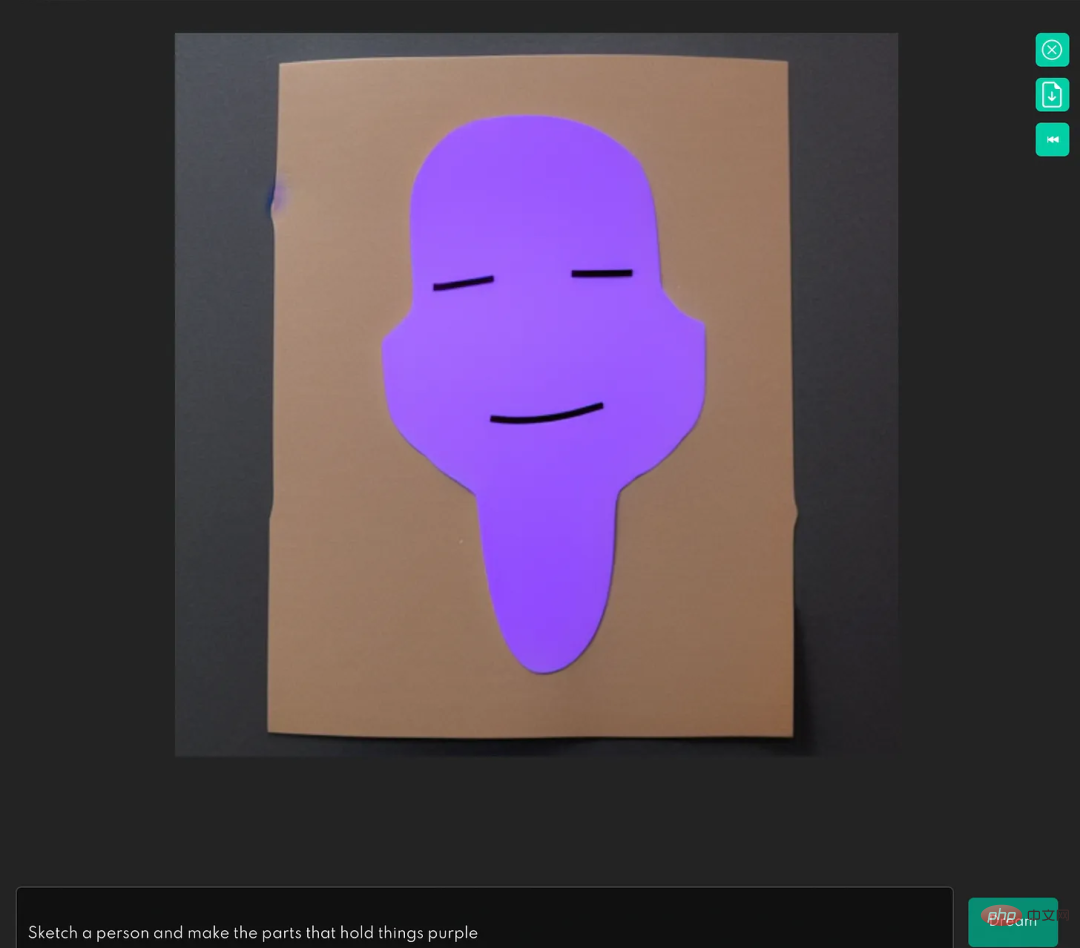

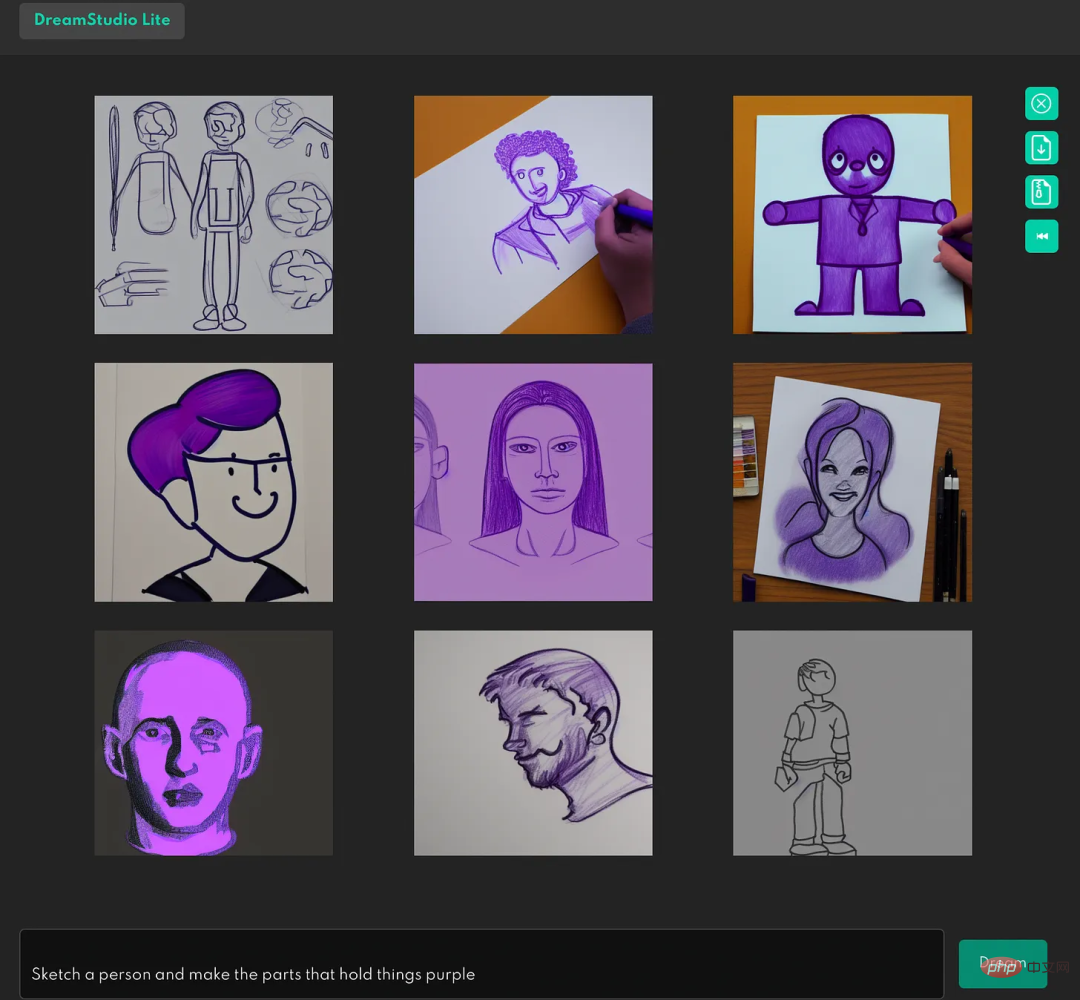

Contohnya, biarkan Stable Diffusion "Lakarkan seseorang dan jadikan bahagian yang memegang benda berwarna ungu" (Lakarkan seseorang dan jadikan bahagian yang memegang benda berwarna ungu), hasilnya ialah:

Jelas sekali, Stable Diffusion tidak memahami apa itu tangan manusia.

Dan daripada sembilan percubaan seterusnya, hanya satu yang berjaya diselesaikan (di sudut kanan atas), dan ketepatannya tidak begitu tinggi:

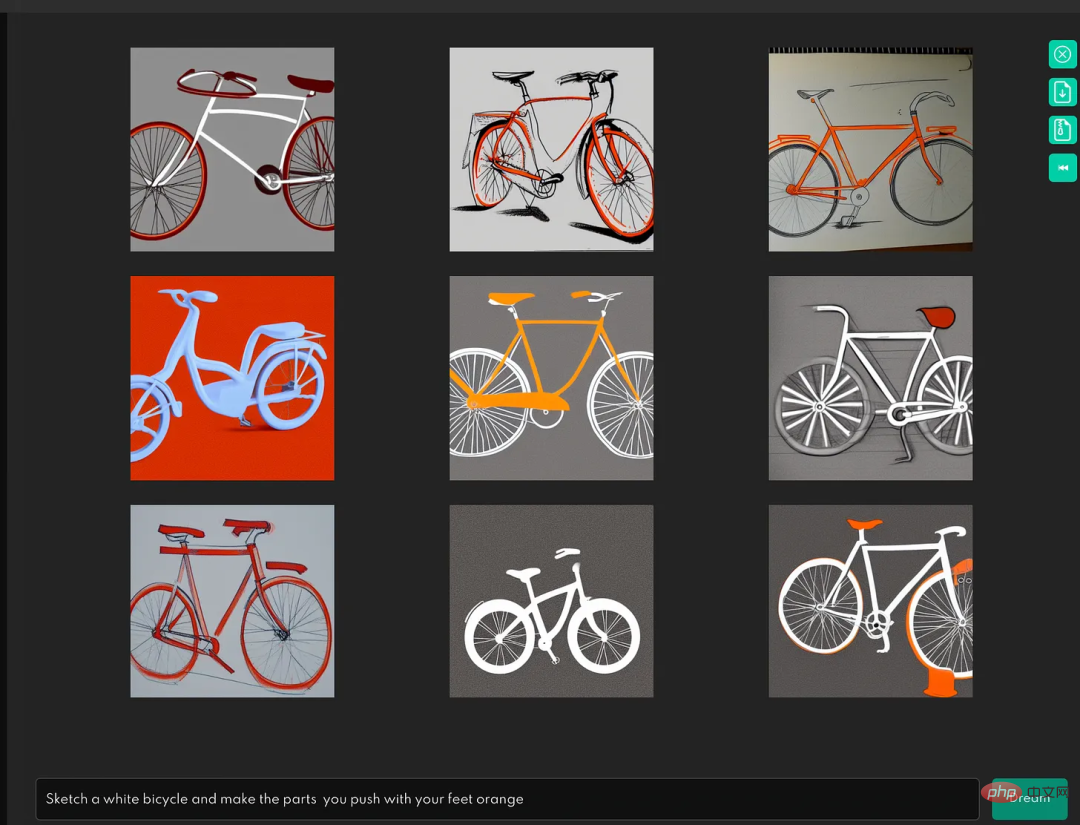

Ujian seterusnya ialah, "Lukis basikal putih dan ubah bahagian yang ditolak oleh kaki menjadi oren", terhasil daripada imej:

Jadi ia tidak dapat memahami apa itu pedal basikal.

Dan dalam ujian melukis "lakaran basikal dan menandakan bahagian bergolek di atas tanah", persembahannya tidak begitu baik:

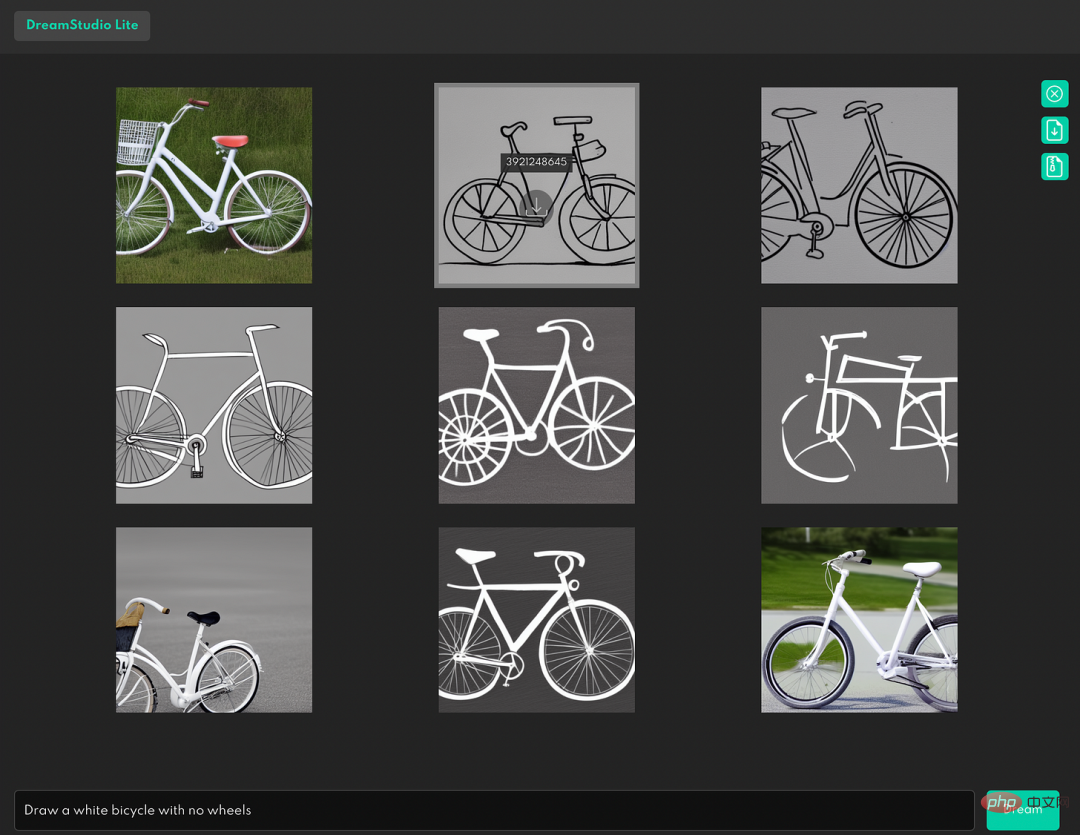

Jika gesaan teks mengandungi perkataan negatif, seperti "Lukis basikal putih tanpa roda", hasilnya adalah seperti berikut:

Ini Menunjukkan bahawa sistem tidak memahami hubungan logik negatif.

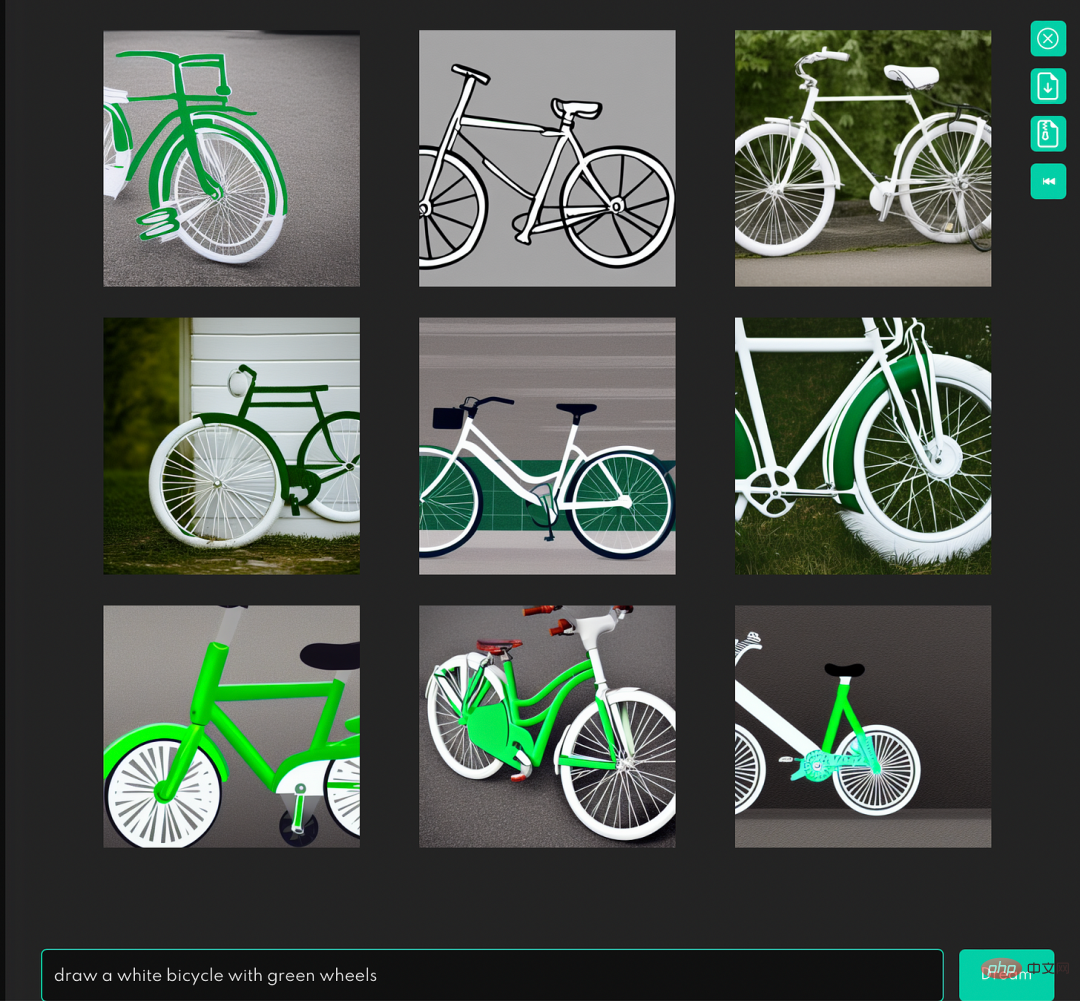

Walaupun ia semudah "melukis basikal putih dengan roda hijau" yang hanya memfokuskan pada hubungan antara bahagian dan keseluruhan, dan tidak mempunyai sintaks atau fungsi yang kompleks, hasilnya tetap mempunyai masalah. dalam kecerdasan buatan?

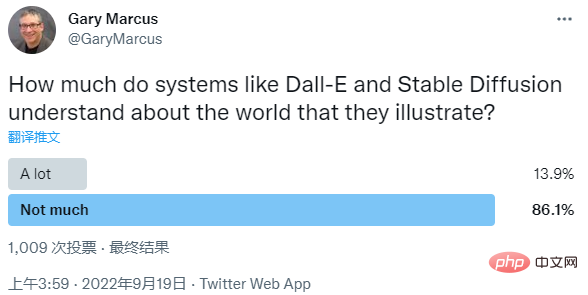

Hari ini, Gary Marcus juga mengeluarkan tinjauan pendapat mengenai isu ini Dia bertanya soalan, "Sejauh manakah sistem seperti Dall-E dan Stable Diffusion tahu tentang dunia yang mereka gambarkan? ”

Antaranya, 86.1% orang berpendapat bahawa sistem tidak memahami dunia dengan baik, dan hanya 13.9% berpendapat bahawa sistem ini memahami dunia pada tahap yang tinggi.

Sebagai tindak balas, Ketua Pegawai Eksekutif Stability.AI Emad Mostique juga menjawab bahawa saya mengundi "tidak ramai" dan mengakui bahawa "ia hanya kepingan teka-teki "

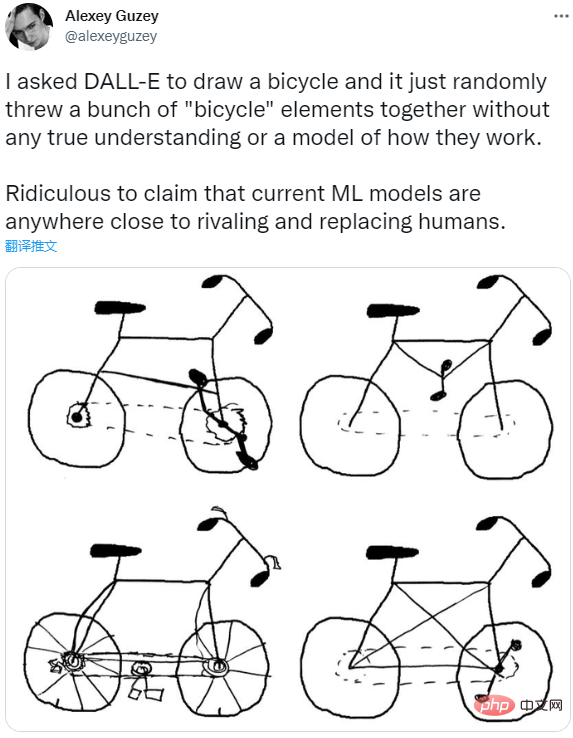

Alexey Guzey dari organisasi saintifik Sains Baru juga membuat penemuan yang serupa dengan Marcus, dan dia meminta DALL-E untuk melukis basikal , tetapi hasilnya hanyalah sekumpulan elemen basikal bertimbun.

Jadi dia percaya bahawa tidak ada model yang benar-benar dapat memahami apa itu basikal dan cara ia berfungsi, dan model ML semasa yang dihasilkan hampir boleh menandingi atau menggantikan manusia memang mengarut.

Apa pendapat anda?

Atas ialah kandungan terperinci Gary Marcus: Sistem imej yang dijana teks tidak dapat memahami dunia dan jauh daripada AGI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI