Rumah >Peranti teknologi >AI >Penyelidikan itu dipersoalkan, Jeff Dean menjawab: Kami tidak cuba mendapatkan SOTA baharu, dan pengiraan kos juga salah.

Penyelidikan itu dipersoalkan, Jeff Dean menjawab: Kami tidak cuba mendapatkan SOTA baharu, dan pengiraan kos juga salah.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-08 16:21:151350semak imbas

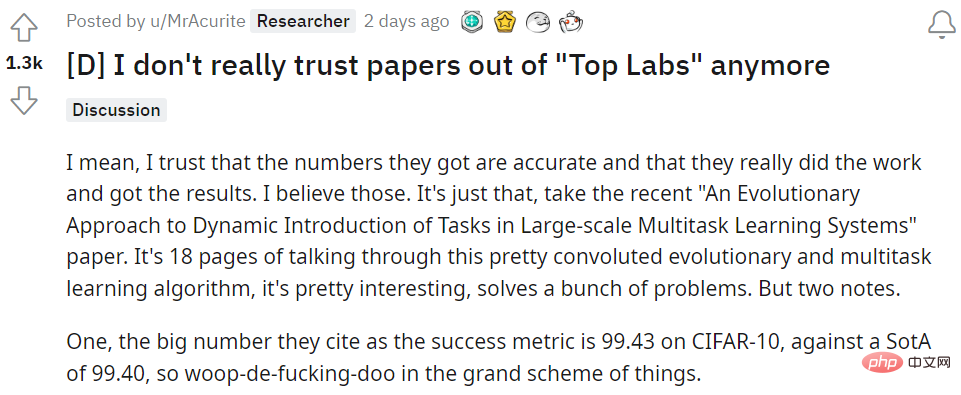

Semalam, topik paling popular di seluruh komuniti adalah tidak lebih daripada seorang penyelidik pembelajaran mesin tentang reddit yang mempersoalkan penyertaan pemimpin Google AI Jeff Dean dalam kertas kerja. Kertas kerja, "Pendekatan Evolusi untuk Pengenalan Dinamik Tugas dalam Sistem Pembelajaran Berbilang Tugas Berskala Besar," telah diserahkan kepada platform kertas pracetak arXiv pada hari Khamis.

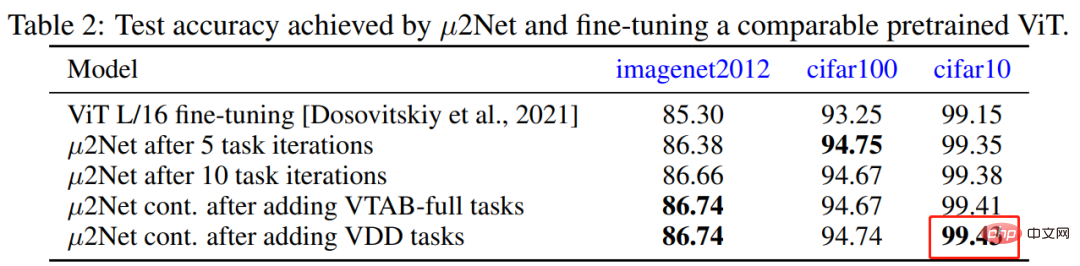

Dalam kertas kerja, Jeff Dean et al mencadangkan algoritma evolusi yang boleh menjana model berbilang tugas berskala besar, sambil turut menyokong penambahan tugasan baharu yang dinamik dan berterusan model jarang diaktifkan dan disepadukan dengan penghalaan berasaskan tugas. Kaedah baharu ini mencapai keputusan kompetitif pada 69 tugas pengelasan imej, seperti mencapai ketepatan pengiktirafan tinggi industri baharu sebanyak 99.43% pada CIFAR-10 untuk model yang dilatih hanya pada data awam.

SOTA baharu yang dilaksanakan pada CIFAR-10 inilah yang telah dipersoalkan, SOTA sebelumnya ialah 99.40. "Menghasilkan hasil ini memerlukan sejumlah 17,810 jam teras TPU," katanya "Jika anda tidak bekerja di Google, itu bermakna anda perlu membayar $3.22/jam atas permintaan dan model terlatih berharga $57,348."

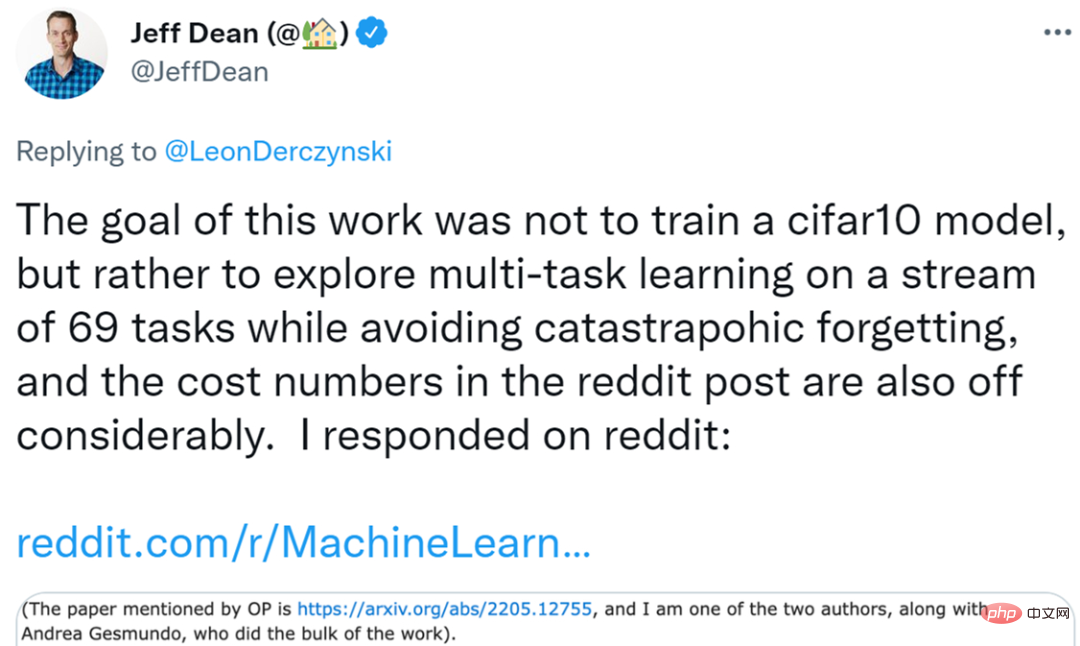

Oleh itu, dia bertanya pada jiwanya, "Jeff Dean membelanjakan wang yang cukup untuk menyara keluarga empat orang selama lima tahun, mencapai peningkatan 0.03% pada CIFAR-10, dan mencipta SOTA baharu. Semuanya berbaloi. "Persoalan ini telah dikumandangkan oleh ramai orang di lapangan. Sesetengah penyelidik juga berkata dengan pesimis, "Saya hampir kehilangan minat dalam pembelajaran mendalam. Sebagai seorang pengamal di makmal kecil, pada asasnya mustahil untuk bersaing dengan gergasi teknologi dari segi belanjawan pengkomputeran. Walaupun anda mempunyai idea teori yang baik, Terdapat mungkin juga bias dalam persekitaran arus perdana yang menyukarkan untuk melihat cahaya mata Ini mewujudkan medan permainan yang tidak adil." Ketika topik itu terus berkembang, Jeff Dean secara peribadi bertindak balas di reddit. Beliau berkata, "Matlamat penyelidikan kami bukan untuk mendapatkan model cifar10 yang lebih berkualiti, dan terdapat juga masalah dengan kaedah pengiraan kos pengarang asal." Jeff Dean Teks jawapan penuh Kertas kerja ini telah disiapkan oleh Andrea Gesmundo dan saya, dan Andrea Gesmundo melakukan kebanyakan kerja di atas kertas itu.

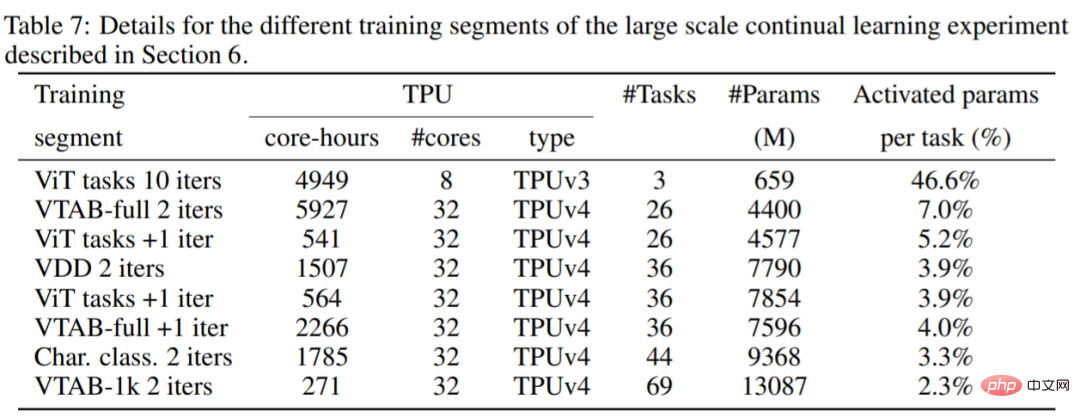

Eksperimen kajian ini menunjukkan bahawa kami boleh memperkenalkan 69 aliran tugas berbeza secara dinamik daripada beberapa penanda aras tugas visualisasi bebas, akhirnya menghasilkan sistem berbilang tugas yang boleh bersama-sama menghasilkan imej berkualiti tinggi untuk semua penyelesaian tugasan ini. Model yang terhasil jarang diaktifkan untuk sebarang tugasan tertentu, dengan sistem memperkenalkan semakin sedikit parameter baharu untuk tugasan baharu (lihat Rajah 2 di bawah). Sistem multitasking hanya memperkenalkan 1.4% parameter baharu untuk tugasan tambahan pada penghujung aliran tugas ini, dengan setiap tugas mengaktifkan purata 2.3% daripada jumlah parameter model. Terdapat banyak perkongsian perwakilan antara tugas, dan proses evolusi membantu menentukan bila ia masuk akal dan bila parameter baharu yang boleh dilatih harus diperkenalkan untuk tugasan baharu.

Eksperimen kajian ini menunjukkan bahawa kami boleh memperkenalkan 69 aliran tugas berbeza secara dinamik daripada beberapa penanda aras tugas visualisasi bebas, akhirnya menghasilkan sistem berbilang tugas yang boleh bersama-sama menghasilkan imej berkualiti tinggi untuk semua penyelesaian tugasan ini. Model yang terhasil jarang diaktifkan untuk sebarang tugasan tertentu, dengan sistem memperkenalkan semakin sedikit parameter baharu untuk tugasan baharu (lihat Rajah 2 di bawah). Sistem multitasking hanya memperkenalkan 1.4% parameter baharu untuk tugasan tambahan pada penghujung aliran tugas ini, dengan setiap tugas mengaktifkan purata 2.3% daripada jumlah parameter model. Terdapat banyak perkongsian perwakilan antara tugas, dan proses evolusi membantu menentukan bila ia masuk akal dan bila parameter baharu yang boleh dilatih harus diperkenalkan untuk tugasan baharu.

Melainkan anda mempunyai tugas yang sangat mendesak dan perlu melatih tugas cifar10+68 dengan cepat, sebenarnya, jenis penyelidikan ini boleh menggunakan sumber dengan harga awalan dengan mudah, iaitu $0.97/jam TPUv4, $0.60/jam TPUv3 (bukan mereka Kata anda perlu membayar harga atas permintaan $3.22/jam). Di bawah andaian ini, pengiraan kos awan awam yang diterangkan dalam Jadual 7 ialah kira-kira $13,960 (menggunakan harga yang boleh didahulukan sebanyak 12,861 jam cip TPUv4 dan jam cip TPUv3 2,474.5), atau lebih kurang $202/tugas.

Saya fikir adalah penting untuk mempunyai model dengan pengaktifan yang jarang dan dapat memperkenalkan tugas baharu secara dinamik ke dalam sistem sedia ada yang boleh berkongsi perwakilan di mana sesuai ) dan mengelakkan pelupaan bencana, ini kajian sekurang-kurangnya patut diterokai. Sistem ini juga mempunyai kelebihan bahawa tugas baharu boleh dimasukkan secara automatik ke dalam sistem tanpa perlu dirumus secara khusus untuknya (inilah yang dilakukan oleh proses carian evolusi), yang nampaknya merupakan sifat berguna sistem pembelajaran berterusan.

Kod kertas ini adalah sumber terbuka dan anda boleh melihatnya sendiri.

Alamat kod: https://github.com/google-research/google-research/tree/master/muNet

Pengarang siaran asal membalas Jeff Dean

Saya juga mempunyai idea untuk membina modul dalam model untuk setiap tugasan. Adakah anda tahu bagaimana anak rusa boleh berjalan dalam beberapa minit selepas dilahirkan? Sebaliknya, pada masa itu, anak rusa yang baru lahir pada dasarnya tidak mempunyai "data latihan" untuk belajar merasakan pergerakan atau model dunia, dan sebaliknya terpaksa mengeksploitasi struktur khusus dalam otak yang perlu diwarisi agar anak jantan itu Mempunyai kemahiran asas. . Struktur ini akan sangat berguna, jadi dalam erti kata ia akan dengan cepat digeneralisasikan kepada tugas kawalan yang baharu tetapi berkaitan.

Saya juga mempunyai idea untuk membina modul dalam model untuk setiap tugasan. Adakah anda tahu bagaimana anak rusa boleh berjalan dalam beberapa minit selepas dilahirkan? Sebaliknya, pada masa itu, anak rusa yang baru lahir pada dasarnya tidak mempunyai "data latihan" untuk belajar merasakan pergerakan atau model dunia, dan sebaliknya terpaksa mengeksploitasi struktur khusus dalam otak yang perlu diwarisi agar anak jantan itu Mempunyai kemahiran asas. . Struktur ini akan sangat berguna, jadi dalam erti kata ia akan dengan cepat digeneralisasikan kepada tugas kawalan yang baharu tetapi berkaitan. Jadi kertas ini membuatkan saya berfikir tentang pembangunan struktur warisan sedia ada yang boleh digunakan untuk mempelajari tugas baharu dengan lebih cekap.

Penyelidik di makmal lain mungkin mempunyai idea yang sama tetapi mendapat keputusan yang lebih teruk kerana mereka tidak mampu untuk beralih daripada persediaan sedia ada mereka kepada platform awan yang besar. Dan, kerana komuniti kini terlalu tertumpu pada keputusan SOTA, penyelidikan mereka tidak boleh diterbitkan. Walaupun kosnya ialah "hanya" $202/tugas, ia memerlukan banyak lelaran untuk membetulkannya.

Jadi bagi kita yang tidak mempunyai akses kepada belanjawan pengkomputeran yang besar, pada asasnya kita hanya mempunyai dua pilihan. Salah satunya adalah berdoa dan berharap Google akan mengedarkan model sedia ada secara terbuka dan kami boleh memperhalusinya mengikut keperluan kami. Tetapi ternyata model itu mungkin telah mempelajari bias atau kelemahan musuh yang tidak dapat kita hapuskan. Yang kedua ialah tidak berbuat apa-apa dan berbaring.

Jadi, masalah saya bukan hanya dengan kajian ini. Jika OpenAI mahu membelanjakan ratusan bilion dolar (secara kiasan) pada GPT-4, maka berikan lebih kuasa. Ini ialah budaya saintifik dan penerbitan yang terlalu menghargai kemewahan, jumlah besar dan kemewahan, berbanding membantu orang menjadi lebih baik dalam kerja sebenar. Kertas kegemaran saya ialah "Pembelajaran Perwakilan dengan Pengekodan Ramalan Kontrastif" oleh van der Oord pada 2019, yang menggunakan tugas pra-latihan tanpa pengawasan dan kemudian menyelia latihan pada subset kecil label untuk mencapai hasil ketepatan berlabel replika dan berbincang peningkatan ini dari perspektif kecekapan data. Saya menghasilkan semula dan menggunakan hasil ini dalam kerja saya, menjimatkan masa dan wang saya. Berdasarkan kertas kerja ini, saya sanggup menjadi pelajar kedoktorannya.

Walau bagaimanapun, OpenAI mencadangkan model pengubah GPT-3 yang lebih besar dalam kertas kerja "Model Bahasa adalah Pelajar Sedikit Pelajaran", yang menerima hampir 4,000 petikan dan Anugerah Kertas Terbaik NeurIPS 2020, dan turut memenangi perhatian seluruh media .

Atas ialah kandungan terperinci Penyelidikan itu dipersoalkan, Jeff Dean menjawab: Kami tidak cuba mendapatkan SOTA baharu, dan pengiraan kos juga salah.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI