Rumah >Peranti teknologi >AI >Sepuluh Soalan tentang Kepintaran Buatan: Apabila AI menjadi semakin kompleks, di manakah masa depan?

Sepuluh Soalan tentang Kepintaran Buatan: Apabila AI menjadi semakin kompleks, di manakah masa depan?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-08 16:21:031130semak imbas

Dalam beberapa tahun kebelakangan ini, kecerdasan buatan telah mengalami letupan, pembangunan, dan baru-baru ini penurunan beransur-ansur dalam populariti Nampaknya kecerdasan buatan telah menjadi permainan yang hanya boleh dimainkan oleh syarikat besar.

Sebabnya ialah "ambang" untuk kecerdasan buatan semakin tinggi.

Tidak lama dahulu, Jeff Dean, tokoh wakil Google AI, menerbitkan karya baharu, tetapi ia menimbulkan kekecohan dalam industri. Sebabnya bukan kerja itu sendiri hebat. Kajian ini hanya bertambah baik sebanyak 0.03% berbanding keputusan terkini, tetapi ia menelan belanja lebih daripada $57,000 kuasa pengkomputeran TPU, yang merupakan masalah besar.

Ramai orang mengatakan bahawa penyelidikan AI semasa telah menjadi representasi perjuangan untuk kuasa dan sumber pengkomputeran, dan sarjana biasa tidak lagi boleh belajar.

Ramai orang masih mempunyai keraguan seperti ini: Apakah perubahan yang dibawa oleh kecerdasan buatan kepada kita? Apa lagi yang boleh dilakukan selain bermain Go, dan apakah masa depannya?

Dengan soalan ini, kami mempunyai komunikasi yang mendalam dengan Dr. Feng Ji. Beliau ialah pengarah eksekutif Institut Penyelidikan Sinovation Ventures Nanjing AI dan pengasas Bei Yang Quantitative Beliau mempunyai pengalaman penyelidikan selama bertahun-tahun dalam bidang AI. Melalui perbualan ini, kami mendapat pemahaman baharu tentang pembangunan dan pelaksanaan AI pada masa hadapan.

1 Adakah inovasi kecerdasan buatan menemui siling?

Google sememangnya telah menerima banyak perhatian tentang isu ini baru-baru ini, saya rasa terdapat tiga isu yang patut difikirkan:

Pertama, besar. pengeluar telah mula beransur-ansur Bergerak ke arah "estetik ganas", bermaksud menggunakan "data ultra-besar" + "kuasa pengkomputeran ultra-besar" untuk meneroka siling rangkaian saraf dalam secara ganas. Namun, di manakah sempadan dan had pendekatan ini?

Kedua, dari perspektif penyelidikan akademik dan saintifik, adakah kaedah ini satu-satunya jalan keluar untuk AI? Malah, sudah banyak penyelidikan yang meneroka laluan teknikal lain, seperti cara mengubah daripada kecerdasan persepsi kepada kecerdasan kognitif, cara menggunakan jumlah data yang agak kecil untuk menyelesaikan masalah yang dihadapi oleh kecerdasan buatan, dsb.

Ketiga, adakah kuasa pengkomputeran yang besar itu benar-benar diperlukan untuk aplikasi praktikal dalam industri? Terdapat sejumlah besar tugas dalam industri yang berkaitan dengan bukan pertuturan, imej dan teks, yang juga memaksa komuniti akademik untuk membangunkan beberapa algoritma yang lebih cekap.

2 Algoritma kecerdasan buatan, hanya rangkaian neural dalam?

Sebelum tahun 1990-an, teknologi perwakilan "kecerdasan buatan" masih berasaskan "simbolisme", iaitu berdasarkan penaakulan logik, teknologi seperti Perancangan dan Pencarian.

Selepas 2010, perubahan penting dalam kecerdasan buatan bermula, iaitu menggunakan teknologi rangkaian saraf untuk mewakili tugas persepsi ini dengan lebih baik. Walau bagaimanapun, masih terdapat sejumlah besar masalah "holy grail" kecerdasan buatan yang belum diselesaikan, seperti cara melakukan penaakulan logik, cara melakukan akal sehat, bagaimana untuk memodelkan memori yang lebih baik, dsb.

Untuk menyelesaikan masalah ini, adakah cukup untuk menggunakan rangkaian neural dalam? Ini mungkin hala tuju penting seterusnya yang lebih dititikberatkan oleh akademia dan industri.

3 Masa depan kecerdasan buatan: persepsi vs kognisi?

Apa yang dipanggil "kecerdasan buatan persepsi" sebenarnya merupakan contoh yang mewakili kejayaan pelaksanaan kecerdasan buatan dalam beberapa tahun kebelakangan ini, seperti pengecaman imej, pertuturan ke teks dan beberapa tugas penjanaan teks .

Tetapi yang lebih penting, bagaimana untuk beralih daripada tugas persepsi kepada tugas kognitif, terutamanya cara menggunakan kecerdasan buatan untuk mencapai penaakulan logik dan akal , dengan itu benar-benar merealisasikan kecerdasan buatan am?

Sebagai tindak balas kepada masalah ini, setahu saya, terdapat tiga laluan teknikal utama dalam bidang akademik.

Pertama, masih ikuti laluan rangkaian saraf dan cuba selesaikan masalah dengan sentiasa mengumpul data dan kuasa pengkomputeran.

Kedua, cuba perkenalkan teknologi symbolism iaitu gabungan connectionism + symbolism.

Ketiga, teruskan memperbaiki teknik penaakulan logik tradisional, dan laluan ini juga yang paling sukar.

4 Data: Bagaimana untuk mengekstrak minyak dalam era digital?

Data telah menjadi semakin penting kepada kejuruteraan kecerdasan buatan. Industri telah mencadangkan konsep baharu yang dipanggil model pembangunan "berpusatkan data". Sebaliknya, ia sebelum ini dipanggil "berpusatkan model".

Secara tradisinya, jurutera menghabiskan lebih banyak masa tentang cara membina model dan cara melaraskan parameter untuk menjadikan sistem berprestasi lebih baik. Tetapi pada masa kini, 80% perhatian semua orang tertumpu pada cara menjadikan set data lebih baik, cara menjadikan set latihan lebih baik, cara menjadikan set latihan lebih seimbang, dan kemudian biarkan model dilatih pada set data yang baik dan dapatkan hasil yang lebih baik.

Apabila permintaan kami untuk privasi data semakin meningkat, beberapa kesan negatif dan keperluan bukan teknikal yang dibawa oleh data juga semakin meningkat. Sebagai contoh, apabila beberapa institusi melakukan pemodelan bersama, data tidak boleh dikongsi di kalangan institusi untuk melindungi privasi data. Jadi teknologi seperti pembelajaran bersekutu direka untuk mencapai pemodelan bersama sambil melindungi privasi data.

Kini semua orang secara beransur-ansur menyedari bahawa perbezaan antara setiap organisasi dalam pembangunan industri tertentu adalah data mereka. Sekarang terdapat rangka kerja perisian sumber terbuka yang sangat mudah dan pelaksanaan perkakasan yang sangat cekap, jurutera telah beralih kepada fokus pada data - Ini ialah Anjakan Paradigma, iaitu anjakan paradigma.

Beijing Quantitative, yang saya inkubasi sendiri, ialah dana lindung nilai dengan teknologi AI sebagai terasnya. Di dalam syarikat, jumlah data yang perlu disimpan setiap hari adalah kira-kira 25-30TB. Jadi kita menghadapi masalah "dinding memori".

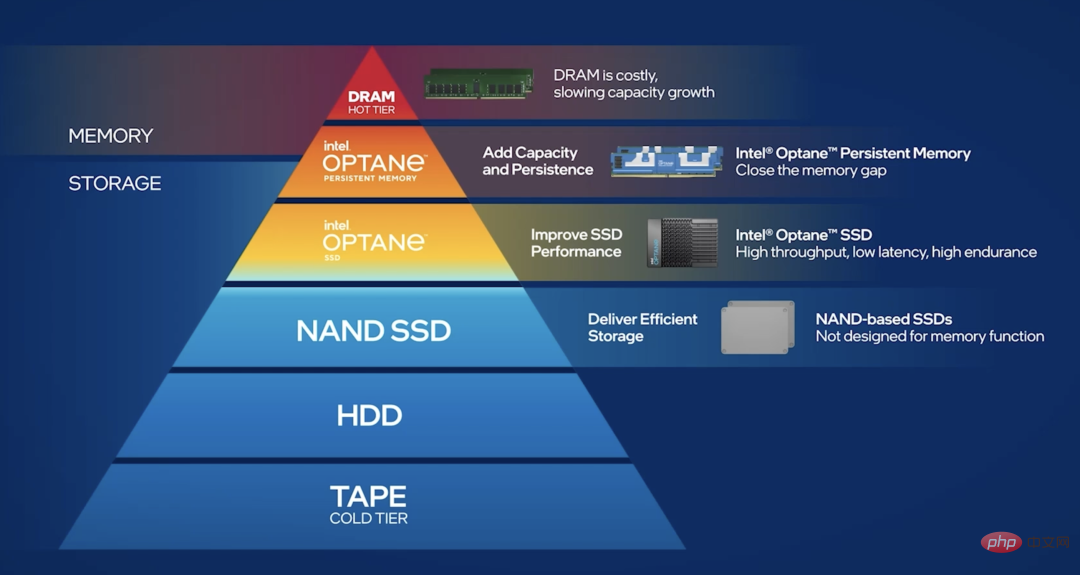

Untuk mengatasi tekanan yang dibawa oleh data besar pada memori, kami membahagikan data kepada data sejuk, data panas dan data panas. "Data sejuk" bermaksud kekerapan capaian data tidak begitu tinggi dan ia boleh digugurkan ke dalam pangkalan data. "Data panas" bermakna kita perlu melakukan banyak tugas membaca dan menulis, dan data secara amnya bertaburan, dan jumlah membaca dan menulis setiap kali adalah sangat besar. Jadi bagaimana untuk menyimpan data panas dengan cara yang diedarkan?

Berbanding dengan penyelesaian SSD tulen, kini terdapat penyelesaian yang lebih baik, seperti ingatan berterusan Optane: ia berada di antara memori dan SSD Dengan cara ini, panas data boleh disimpan dalam cara yang diedarkan, yang boleh mengurangkan masalah "dinding memori" pada tahap tertentu.

5Adakah infrastruktur IT "asli AI" akan muncul?

Kini terdapat konsep yang sangat popular dipanggil "cloud native", yang menggalakkan pembinaan semula infrastruktur pengkomputeran awan. Dan "AI-asli" untuk kecerdasan buatan sebenarnya telah berlaku. Terutama dalam tempoh 10 tahun yang lalu, inovasi perkakasan komputer sebenarnya telah dibangunkan di sekitar aplikasi kecerdasan buatan.

Sebagai contoh, permintaan semasa kami untuk pengkomputeran dipercayai dalam awan semakin meningkat. Sebagai contoh, proses pengiraan model AI ialah harta intelek teras syarikat Jika ia diletakkan pada awan atau platform awam, secara semulajadi akan timbul kebimbangan tentang risiko proses pengiraan dicuri.

Dalam kes ini, adakah terdapat sebarang penyelesaian berasaskan perkakasan? Jawapannya adalah ya. Contohnya, kami menggunakan kotak pasir privasi SGX pada cip Intel, yang boleh melindungi pengiraan kami dalam perkakasan Ini sebenarnya merupakan asas yang sangat penting untuk kerjasama merentas organisasi.

Ini adalah contoh yang sangat tipikal, iaitu, bermula daripada permintaan, mendorong pengeluar cip atau perkakasan untuk menyediakan penyelesaian yang sepadan.

6 Perkakasan kecerdasan buatan sama dengan GPU?

Pandangan ini memang berat sebelah. Ambil kerja harian BeiYang Quantitative sebagai contoh Apabila kita melakukan perdagangan kuantitatif, jika kita menyalin data dari CPU ke GPU dan kemudian menyalinnya semula, ia akan terlambat untuk banyak tugas perdagangan kuantitatif. Dalam erti kata lain, kita perlu mempunyai versi CPU berprestasi tinggi bagi pelaksanaan model kecerdasan buatan.

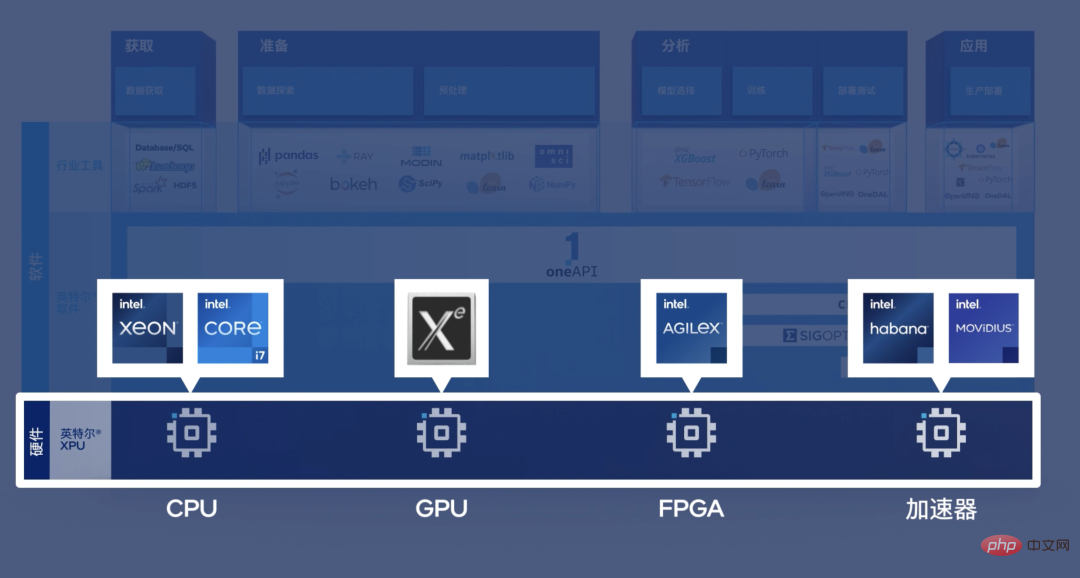

Untuk contoh lain, kami mempunyai banyak tugas yang memerlukan analisis dan pemprosesan data secara langsung pada kad rangkaian, dan kad rangkaian biasanya mempunyai cip FPGA Jika data yang diprosesnya perlu dipindahkan ke GPU Sudah terlambat untuk bangun. Untuk senario kependaman rendah seperti ini yang memerlukan bantuan teknologi kecerdasan buatan, kami memerlukan seni bina heterogen.

Dengan kata lain, sama ada FPGA, ASIC, CPU atau GPU, ia mempunyai kegunaan yang berbeza dalam senario yang berbeza.

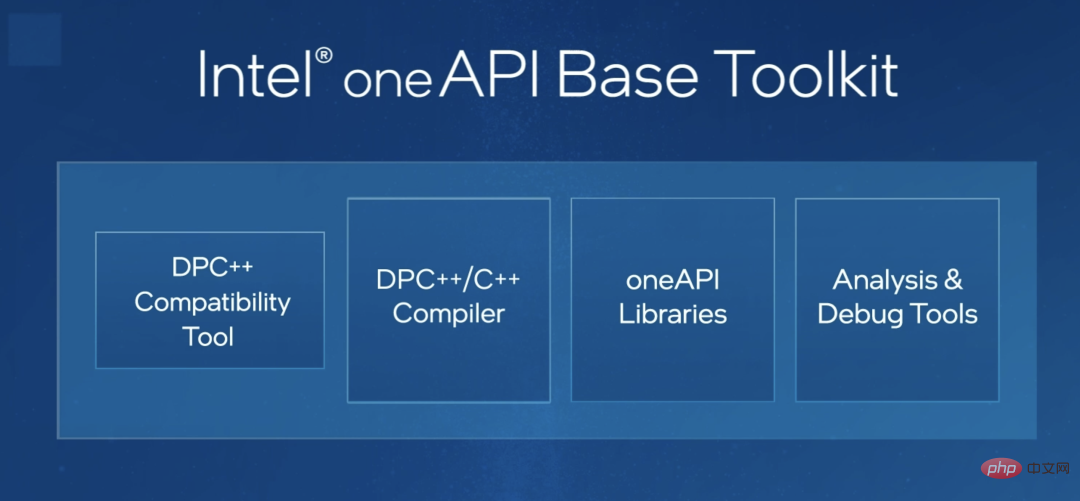

Mengenai pengaturcaraan untuk platform heterogen, saya melihat bahawa industri telah membuat beberapa percubaan. Sebagai contoh, oneAPI Intel, saya fikir ia adalah alat yang sangat penting. Dalam erti kata lain, oneAPI membenarkan set kod yang sama menyesuaikan diri secara automatik kepada CPU, FPGA atau jenis cip lain. Ini akan mengurangkan kesukaran pengaturcaraan untuk jurutera dan membolehkan mereka memberi tumpuan kepada inovasi algoritma.

Saya rasa ini sangat penting untuk mempromosikan aplikasi heterogen.

7 Apakah hala tuju lain untuk pembangunan kecerdasan buatan pada masa hadapan?

Saya rasa penyelesaian hujung ke hujung yang lebih baik mungkin diperlukan. Kini kami sebenarnya telah menaik taraf daripada "Perisian 1.0" kepada era "Perisian 2.0". Dalam erti kata lain, Daripada pembinaan kejuruteraan perisian yang kompleks dipacu peraturan kepada kaedah pembinaan kejuruteraan perisian dipacu data.

Sebelum ini, kami terpaksa bergantung pada kebijaksanaan yang hebat untuk menulis satu siri sistem yang hebat untuk menjadikan keseluruhan program berjalan. Ini serupa dengan jam tangan mekanikal Pengaturcara terbaik menumpukan pada membina operasi "gear" dan cara membuat "jam tangan" ini berjalan.

Sekarang, jika saya tidak tahu bagaimana untuk menentukan set peraturan operasi ini, maka berikan sahaja kepada sejumlah besar data atau algoritma pembelajaran mesin ini akan menjana a Algoritma baharu, dan algoritma baharu ini adalah apa yang kami mahu dapatkan. Pendekatan ini sedikit seperti membina robot yang membina robot.

Dalam era perisian 2.0, paradigma pembangunan keseluruhan kejuruteraan perisian akan mengalami perubahan besar Kami sangat berharap untuk mendapatkan penyelesaian menyeluruh untuk melaksanakannya dengan lebih mudah pembangunan kejuruteraan perisian "Berpusatkan data".

8 Bagaimanakah kecerdasan buatan akan dilaksanakan pada masa hadapan?

Saya rasa ada dua aspek. Pertama, dari perspektif industri, kita masih perlu bermula dari prinsip pertama, iaitu berdasarkan keperluan kita sendiri dan mengambil kira banyak faktor bukan teknikal. Sebagai contoh, saya melihat sebuah syarikat yang ingin membangunkan sistem pengecaman muka untuk keselamatan komuniti, tetapi setiap pintu masuk dan keluar memerlukan empat GPU yang sangat mahal Ini adalah contoh biasa untuk tidak bermula daripada keperluan dan kos.

Kedua, penyelidikan akademik tidak semestinya mengikut trend. Seperti yang kami katakan pada mulanya, tidak perlu bersaing antara satu sama lain mengenai saiz model: jika anda mempunyai satu dengan ratusan bilion, saya akan membina satu dengan trilion, dan jika anda mempunyai satu dengan trilion, saya akan membina satu.

Malah, terdapat sebilangan besar tugasan yang memerlukan parameter berskala kecil, atau hanya sebilangan kecil sampel boleh disediakan kerana kos dan kekangan lain. Dalam keadaan sedemikian, bagaimana untuk berinovasi dan membuat kejayaan? Ini adalah tanggungjawab yang harus dipikul oleh komuniti akademik.

9 Adakah keusahawanan kecerdasan buatan masih menjadi topik hangat?

Kita boleh memikirkannya pada penghujung 1990-an, ia menelan belanja 20,000 hingga 30,000 yuan untuk membina tapak web, kerana terdapat sangat sedikit orang yang mempunyai kemahiran pengaturcaraan rangkaian pada masa itu. Tetapi hari ini, mungkin mana-mana pelajar sekolah menengah boleh membina laman web dengan hanya satu klik tetikus.

Dengan kata lain, pengetahuan rangkaian sudah ada dalam setiap kit alat pengaturcara biasa.

Malah, perkara yang sama berlaku untuk teknologi kecerdasan buatan. Sekitar tahun 2015, mungkin tidak lebih daripada 1,000 orang di dunia yang boleh membina rangka kerja pembelajaran yang mendalam dan menjalankannya pada GPU. Tetapi sekarang setelah mengalami pertumbuhan eksponen, ramai orang tahu bagaimana untuk melakukannya. Kami mempunyai sebab untuk mempercayai bahawa dalam masa kira-kira lima tahun, mana-mana pengaturcara akan mempunyai penyelesaian kecerdasan buatan yang lebih kaya dalam kit alatnya, dan ambang untuk pelaksanaannya pasti akan terus diturunkan. Hanya dengan cara ini teknologi kecerdasan buatan boleh digunakan dengan lebih biasa dalam setiap syarikat.

Oleh itu, Makmal AI di kilang besar pasti akan hilang. Sama seperti sekitar tahun 2000, banyak syarikat mempunyai Makmal Internet, yang merupakan makmal khusus untuk semua hal berkaitan rangkaian syarikat, dan makmal ini menyediakan output teknikal kepada jabatan perniagaan lain. Ini kerana terdapat sangat sedikit orang yang mengetahui teknologi ini, jadi mereka perlu melakukan ini.

Begitu juga dengan Makmal AI Apabila ambang pelaksanaan teknologi AI berkurangan secara beransur-ansur, dan sebilangan besar orang dalam jabatan perniagaan juga memiliki teknologi yang serupa, maka Makmal AI jenis ini akan. pasti hilang. Saya fikir ini adalah produk sementara dalam proses pembangunan teknologi, yang merupakan perkara yang baik. Apabila pengeluar besar tidak mempunyai Makmal AI, ini mungkin akan menjadi era apabila kecerdasan buatan benar-benar berkembang.

10 Bagaimanakah kecerdasan buatan boleh memberi manfaat kepada orang ramai?

Pertama, kita juga memerlukan restu Hukum Moore. Masih terdapat sejumlah besar tugas yang memerlukan banyak kuasa pengkomputeran. Kita mesti terus mengulang perkakasan dan mengemas kini algoritma. Hanya apabila perkara yang perlu dijalankan pada kluster boleh dijalankan pada telefon mudah alih boleh AI dilaksanakan dalam jumlah yang besar.

Kedua, tumpuan inovasi kecerdasan buatan mesti beralih daripada perniagaan Internet kepada beberapa industri tradisional. Pada masa lalu, tenaga semua orang tertumpu pada cara menggunakan kecerdasan buatan untuk mencipta penyelesaian visual yang lebih baik, atau sistem pengesyoran yang lebih baik, atau perisian P-picture yang lebih baik. Tetapi dalam ekonomi sebenar, sebenarnya terdapat sejumlah besar jabatan dan perniagaan yang menjana data. Apabila data ekonomi sebenar ini dapat dimaklumkan dengan lebih baik, nilai yang mereka bawa mungkin jauh melebihi ekonomi maya semasa.

Atas ialah kandungan terperinci Sepuluh Soalan tentang Kepintaran Buatan: Apabila AI menjadi semakin kompleks, di manakah masa depan?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI