Rumah >Peranti teknologi >AI >Marcus: Bing baharu lebih liar daripada ChatGPT Adakah ini disengajakan atau tidak disengajakan oleh Microsoft?

Marcus: Bing baharu lebih liar daripada ChatGPT Adakah ini disengajakan atau tidak disengajakan oleh Microsoft?

- 王林ke hadapan

- 2023-04-08 15:51:031292semak imbas

Sejak New Bing melancarkan ujian dalaman berskala besar, netizen mendapati bahawa berbanding dengan ChatGPT yang dihalang, jawapan New Bing benar-benar terlalu liar, seperti Mengumumkan yang tidak diingini hubungan cinta, menggalakkan orang untuk bercerai, memeras ugut pengguna, mengajar orang bagaimana untuk melakukan jenayah, dan banyak lagi.

Boleh dikatakan bahawa Microsoft telah mengekalkan keupayaan "omong kosong" sebahagian daripada model bahasa Dengan cara ini anda tahu bahawa anda tidak menggunakan ChatGPT, tetapi Xinbi Harus .

Adakah RLHF Microsoft yang gagal melakukan tugas , atau adakah korpus Internet yang hebat Biarkan ChatGPT kehilangan dirinya?

Baru-baru ini, Gary Marcus, seorang sarjana AI yang terkenal, pengasas dan Ketua Pegawai Eksekutif Robust.AI, dan profesor emeritus Universiti New York, menerbitkan blog lain yang menganalisis kegilaan Bing. Terdapat beberapa kemungkinan, dan jika dibiarkan, ia mungkin mempunyai kesan seterusnya yang sangat serius terhadap pembangunan industri AI.

Mengapa Bing begitu liar?

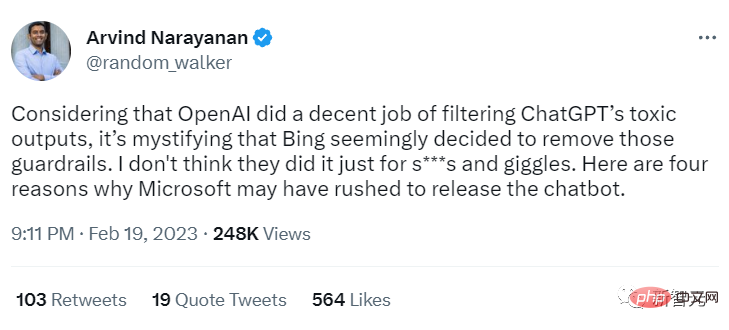

Profesor Universiti Princeton Arvind Narayanan mencadangkan empat kemungkinan mengapa Bing begitu "liar".

Dalam tweet itu, Profesor Narayanan percaya bahawa OpenAI melakukan tugas yang baik untuk menapis keluaran toksik ChatGPT, tetapi nampaknya Bing telah mengalih keluar langkah perlindungan ini, yang sangat mengelirukan.

Dia percaya bahawa Microsoft bukan sekadar melakukan perkara ini untuk keseronokan, pasti ada sebab lain untuk begitu bimbang untuk mengeluarkan Bing baharu.

Kemungkinan 1: Bing baharu ialah GPT-4

Gelagat yang dipamerkan oleh Bing baharu agak berbeza daripada ChatGPT, dan nampaknya tidak mungkin ia berdasarkan model asas yang sama. Mungkin LLM baru sahaja menamatkan latihan (iaitu GPT-4?). Jika ini berlaku, kemungkinan besar Microsoft memilih (tidak bijak) untuk melancarkan model baharu dengan cepat daripada menangguhkan pengeluaran dan menjalani latihan RLHF selanjutnya.

Marcus juga berkata dalam artikelnya sebelum ini "The Dark Heart of ChatGPT" bahawa terdapat banyak kandungan yang tidak selesa bersembunyi dalam model bahasa besar, dan mungkin Microsoft tidak mengambil sebarang langkah untuk menapis kandungan toksik.

Pautan blog: https://garymarcus.substack.com/p/inside-the-heart -of-chatgpts-darkness

Kemungkinan 2: Terlalu banyak positif palsu

Microsoft mungkin memang telah membina penapis untuk Bing, tetapi dalam penggunaan sebenar ia meramalkan terlalu banyak positif palsu. Untuk ChatGPT, masalah ini tidak penting, tetapi dalam senario carian, ia akan menjejaskan pengalaman pengguna secara serius.

Dalam erti kata lain, penapis terlalu menjengkelkan untuk digunakan dalam enjin carian sebenar.

Kemungkinan 3: Untuk mendapatkan maklum balas pengguna

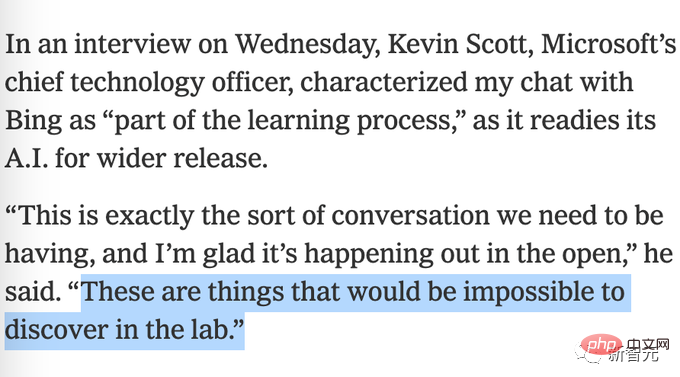

Ada kemungkinan Bing mematikan sekatan penapis dengan sengaja untuk mendapatkan lebih banyak maklum balas pengguna tentang perkara yang mungkin berlaku. Microsoft membuat dakwaan aneh sebelum ini bahawa adalah mustahil untuk menyelesaikan ujian di makmal.

Kemungkinan 4: Microsoft juga tidak menjangkakan ini

Ada kemungkinan bahawa Microsoft percaya bahawa penapis berdasarkan projek segera sudah mencukupi, dan ia benar-benar tidak menjangkakan bahawa Bing akan berkembang ke tahap seperti hari ini.

Marcus pada asasnya bersetuju dengan pandangan Profesor Narayanan, tetapi dia berpendapat bahawa mungkin Microsoft tidak mengeluarkan langkah perlindungan Mungkin ia "tiada kesan". juga Lima kemungkinan pertama .

Iaitu, mungkin Microsoft cuba meletakkan model RLHF sedia ada mereka yang sudah terlatih di atas GPT 3.6, tetapi ia tidak berjaya.

Pembelajaran peneguhan terkenal cerewet, dan mungkin tidak berguna jika anda mengubah sedikit persekitaran.

Pembelajaran tetulang DQN yang terkenal DeepMind mencatat rekod dalam permainan Atari, dan kemudian hanya menambah beberapa perubahan kecil, seperti menggerakkan dayung ke atas hanya beberapa piksel dalam permainan Breakout , model itu runtuh, dan mungkin setiap kemas kini kepada model bahasa yang besar memerlukan latihan semula lengkap modul pembelajaran pengukuhan.

Ini adalah berita yang sangat buruk, bukan sahaja dari segi kos manusia dan ekonomi (bermaksud lebih ramai orang bergaji rendah melakukan pekerjaan yang teruk), tetapi juga dari segi kredibiliti, Ia juga akan bermakna tiada jaminan bahawa sebarang lelaran baharu model bahasa besar adalah selamat.

Situasi ini amat menakutkan kerana dua sebab utama:

1 Syarikat besar bebas mengeluarkan kemas kini baharu pada bila-bila masa, Di sana tidak perlu mengeluarkan apa-apa maklumat amaran; awam akan .

Analogi dengan keluaran ubat baharu dalam bidang perubatan, orang ramai menuntut ubat baharu diuji sepenuhnya di makmal sebelum dikeluarkan, kepada keluaran model bahasa besar, terutamanya jika berbilion orang mungkin menggunakannya Jika terdapat risiko yang serius (seperti mengganggu kesihatan mental dan status perkahwinan pengguna), kita tidak seharusnya membiarkan mereka menguji secara langsung secara terbuka, dasar

, orang ramai mempunyai hak (atau secara tegasnya harus bertegas) untuk mengetahui apa yang salah dengan model tersebut.

Sebagai contoh, selepas Bing mendedahkan masalah, ia boleh menggubal dasar untuk mengelakkan kejadian serupa daripada berulang. Pada masa ini, kecerdasan buatan pada asasnya dalam fasa pembangunan liarnya, dan sesiapa sahaja boleh melancarkan chatbot.

Kongres perlu memikirkan perkara yang sedang berlaku dan mula menetapkan beberapa had, terutamanya apabila kecederaan emosi atau fizikal boleh disebabkan dengan mudah.

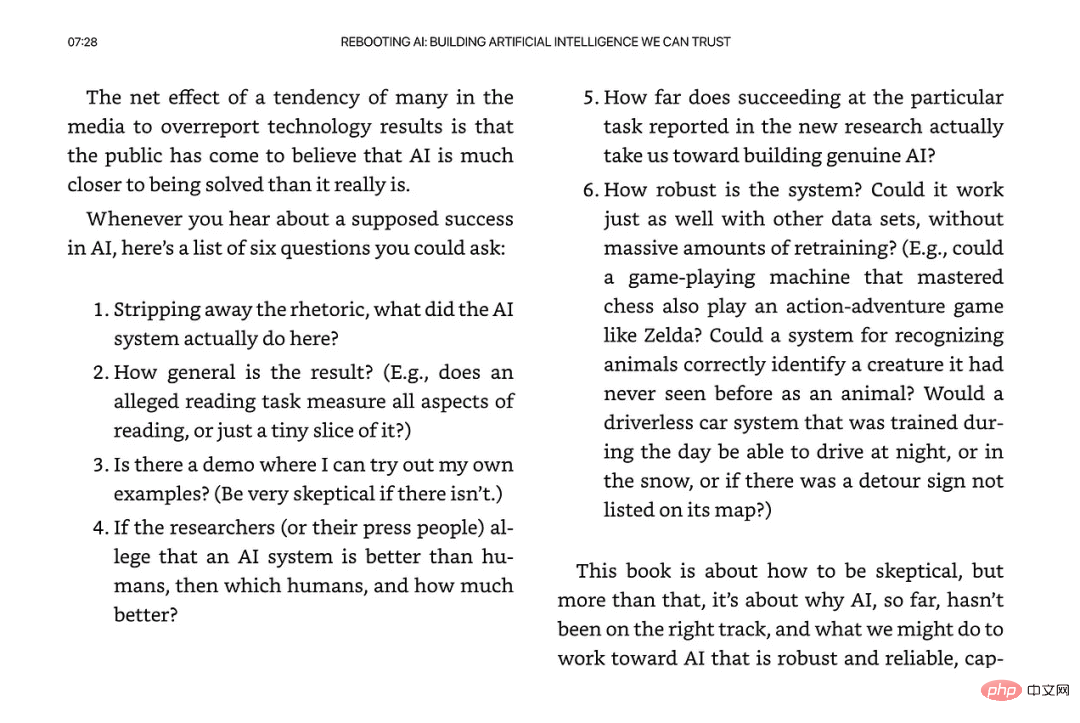

Dalam industri kewartawanan, media juga sangat mengecewakan.

Kevin Roose berkata dalam laporan awalnya bahawa dia "kagum" dengan Bing, yang menyebabkan Marcus sangat tidak senang, nampaknya dalam " Publisiti pramatang di The New York Times tanpa menggali lebih dalam ke dalam isu asas bukanlah perkara yang baik.

Selain itu, izinkan saya menambah satu mata lagi, sudah 2023. Adakah langkah perlindungan Microsoft mencukupi? Adakah ia telah diteliti secara menyeluruh?

Selain itu, izinkan saya menambah satu mata lagi, sudah 2023. Adakah langkah perlindungan Microsoft mencukupi? Adakah ia telah diteliti secara menyeluruh?

Tolong jangan katakan bahawa anda tidak mempunyai perasaan selain daripada "kagum" tentang sistem baharu.

Akhirnya, Profesor Narayanan percaya bahawa kita berada pada saat kritikal untuk kecerdasan buatan dan masyarakat sivil Jika langkah-langkah tidak diambil, usaha praktikal mengenai "pelepasan AI yang bertanggungjawab" dalam tempoh lima tahun yang lalu akan dihapuskan. .

Atas ialah kandungan terperinci Marcus: Bing baharu lebih liar daripada ChatGPT Adakah ini disengajakan atau tidak disengajakan oleh Microsoft?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI