Rumah >Peranti teknologi >AI >Mengapakah model berasaskan pokok masih mengatasi pembelajaran mendalam pada data jadual?

Mengapakah model berasaskan pokok masih mengatasi pembelajaran mendalam pada data jadual?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-08 14:41:031658semak imbas

Pembelajaran mendalam telah mencapai kemajuan besar dalam bidang seperti imej, bahasa dan juga audio. Walau bagaimanapun, pembelajaran mendalam berprestasi biasa-biasa sahaja apabila memproses data jadual. Memandangkan data jadual mempunyai ciri seperti ciri tidak sekata, saiz sampel yang kecil dan nilai ekstrem yang besar, adalah sukar untuk mencari invarian yang sepadan.

Model berasaskan pokok tidak boleh dibezakan dan tidak boleh dilatih bersama dengan modul pembelajaran mendalam, jadi mencipta seni bina pembelajaran mendalam khusus jadual ialah bidang penyelidikan yang sangat aktif. Banyak kajian telah mendakwa boleh mengalahkan atau menyaingi model berasaskan pokok, tetapi kajian mereka telah dipenuhi dengan banyak keraguan.

Hakikat bahawa pembelajaran pada data jadual tidak mempunyai tanda aras yang mantap memberikan penyelidik banyak kebebasan apabila menilai kaedah mereka. Tambahan pula, kebanyakan set data jadual yang tersedia dalam talian adalah kecil berbanding penanda aras dalam subdomain pembelajaran mesin lain, menjadikan penilaian lebih sukar.

Untuk mengurangkan kebimbangan ini, penyelidik dari Institut Maklumat dan Automasi Kebangsaan Perancis, Universiti Sorbonne dan institusi lain telah mencadangkan penanda aras data jadual yang boleh menilai model pembelajaran mendalam terkini bahawa model berasaskan pokok masih SOTA pada set data jadual bersaiz sederhana.

Untuk kesimpulan ini, artikel memberikan bukti konklusif bahawa pada data jadual, lebih mudah untuk mencapai ramalan yang baik menggunakan kaedah berasaskan pokok daripada pembelajaran mendalam (malah seni bina moden), penyelidik telah menemui sebab-sebabnya.

Alamat kertas: https://hal.archives-ouvertes.fr/hal-03723551/document Perlu disebut bahawa salah seorang pengarang makalah itu ialah Gaël Varoquaux, yang merupakan salah seorang pemimpin projek Scikit-Learn. Projek ini kini telah menjadi salah satu perpustakaan pembelajaran mesin paling popular di GitHub. Artikel "Scikit-learn: Machine learning in Python" oleh Gaël Varoquaux mempunyai 58,949 petikan.

Sumbangan artikel ini boleh diringkaskan sebagai:

Kajian ini mewujudkan penanda aras baharu (memilih 45 set data terbuka) dan kongsi set data ini melalui OpenML, yang menjadikannya mudah digunakan.

Kajian ini membandingkan model pembelajaran mendalam dan model berasaskan pokok di bawah pelbagai tetapan data jadual dan mempertimbangkan kos untuk memilih hiperparameter. Kajian itu juga berkongsi hasil mentah daripada carian stokastik, yang akan membolehkan penyelidik menguji algoritma baharu secara murah untuk belanjawan pengoptimuman hiperparameter tetap.

Pada data jadual, model berasaskan pokok masih mengatasi kaedah pembelajaran mendalam

Tanda aras baharu merujuk kepada 45 set data jadual dan tanda aras yang dipilih adalah seperti berikut:

- Lajur heterogen, lajur harus sepadan dengan ciri yang berbeza, sekali gus tidak termasuk set data imej atau isyarat.

- Berdimensi rendah, nisbah set data d/n kurang daripada 1/10.

- Set data tidak sah, padam set data dengan sedikit maklumat yang tersedia.

- Data I.I.D (yang diedarkan secara bebas), mengalih keluar set data atau siri masa seperti aliran.

- Data dunia sebenar, mengalih keluar set data tiruan tetapi menyimpan beberapa set data simulasi.

- Set data tidak boleh terlalu kecil, padam set data dengan terlalu sedikit ciri (

- Padamkan set data yang terlalu mudah.

- Padamkan set data untuk permainan seperti poker dan catur, kerana set data ini bersifat deterministik.

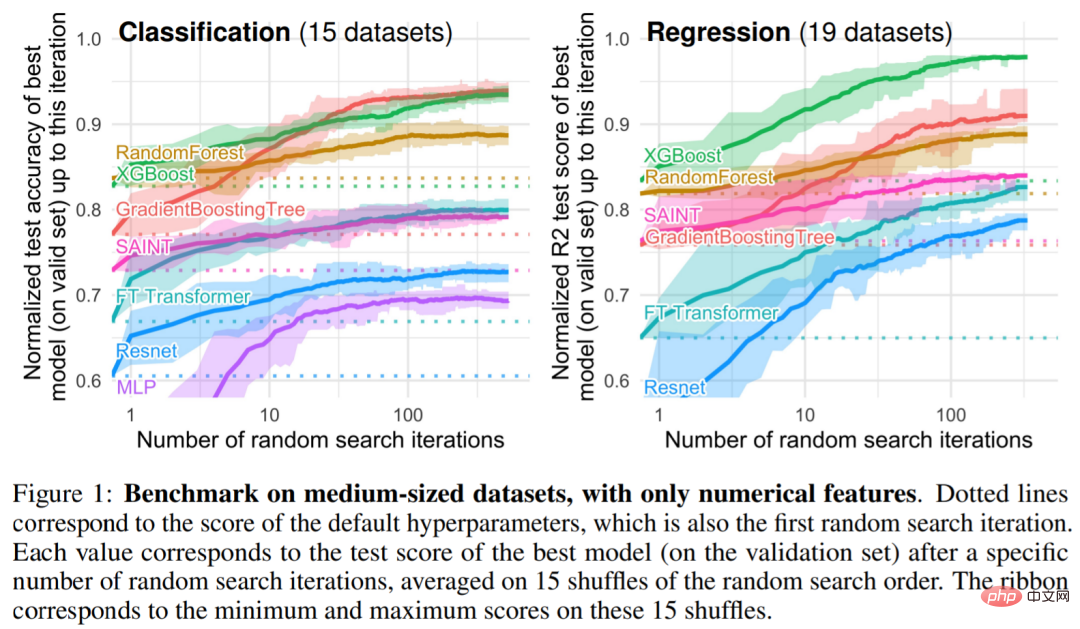

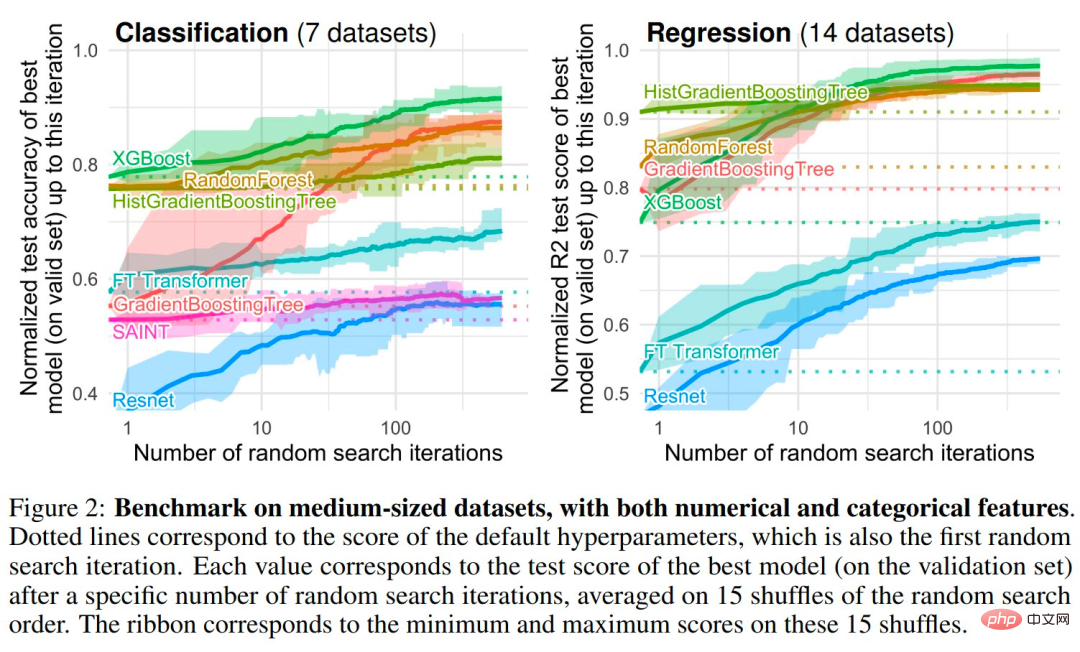

Antara model berasaskan pokok, penyelidik memilih 3 model SOTA: RandomForest Scikit Learn, GradientBoostingTrees (GBTs) dan XGBoost. Kajian itu menjalankan penanda aras berikut pada model dalam: MLP, Resnet, FT Transformer, SAINT. Rajah 1 dan Rajah 2 memberikan hasil penanda aras untuk pelbagai jenis set data

Penyiasatan empirikal: mengapa model berasaskan pokok masih mengatasi pembelajaran mendalam pada data jadual

Induktif Bias . Model berasaskan pokok mengalahkan rangkaian saraf merentasi pelbagai pilihan hiperparameter. Malah, kaedah terbaik untuk memproses data jadual mempunyai dua sifat yang sama: kaedah ensemble, bagging (hutan rawak) atau boosting (XGBoost, GBT), dan pelajar lemah yang digunakan dalam kaedah ini ialah pokok keputusan.

Penemuan 1: Rangkaian Neural (NN) cenderung penyelesaian yang terlalu lancar

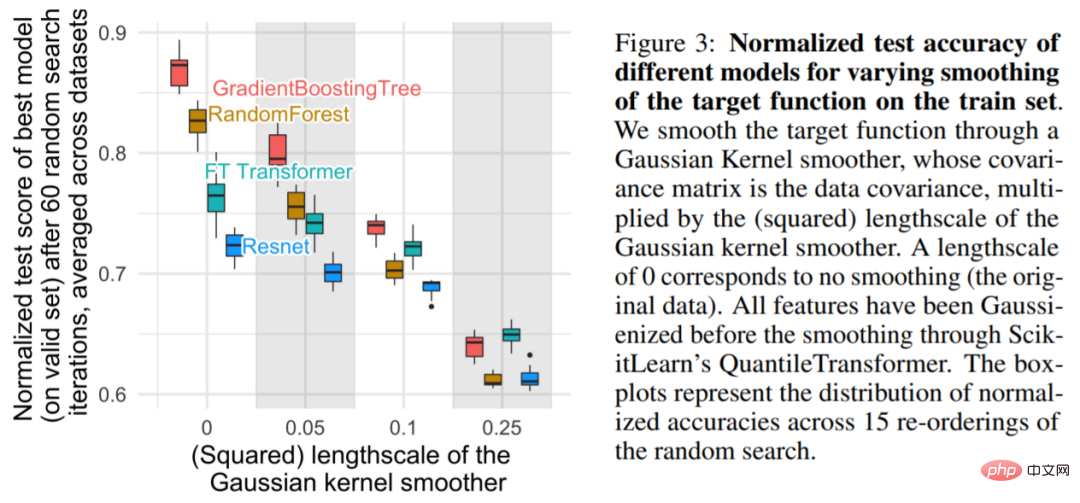

Seperti yang ditunjukkan dalam Rajah 3 Ia ditunjukkan bahawa untuk skala yang lebih kecil, melicinkan fungsi objektif pada set latihan dengan ketara mengurangkan ketepatan model berasaskan pokok, tetapi mempunyai sedikit kesan ke atas NN. Keputusan ini menunjukkan bahawa fungsi objektif dalam set data tidak lancar dan NN mengalami kesukaran menyesuaikan diri dengan fungsi tidak teratur ini berbanding model berasaskan pokok. Ini konsisten dengan penemuan Rahaman et al., yang mendapati bahawa NNs berat sebelah ke arah fungsi frekuensi rendah. Model berasaskan pokok keputusan mempelajari fungsi pemalar sekeping tanpa berat sebelah.

Penemuan 2: Ciri tidak bermaklumat boleh lebih mempengaruhi NN seperti MLP

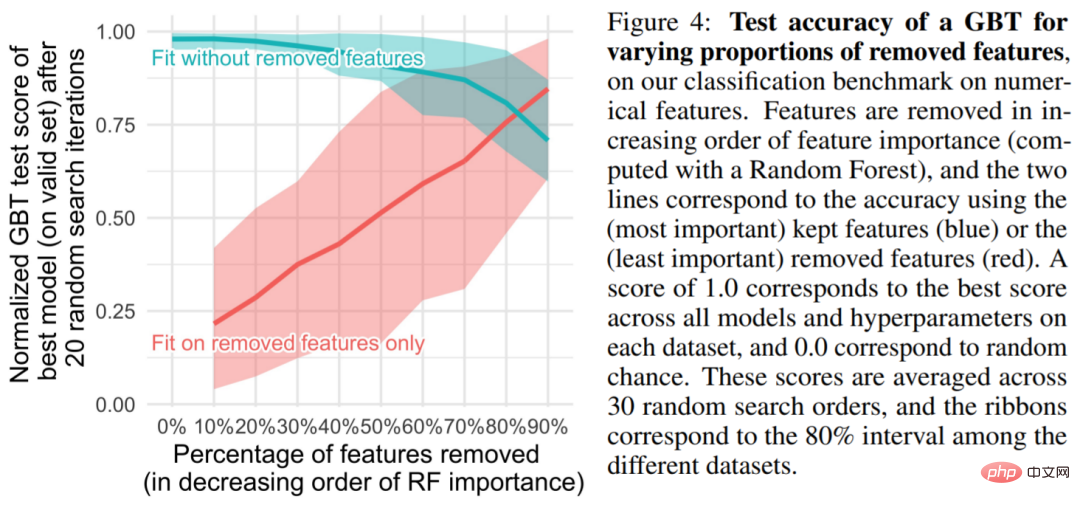

Set data jadual mengandungi banyak ciri tidak bermaklumat, dan bagi setiap set data, kajian akan memilih untuk membuang bahagian tertentu ciri (biasanya diisih mengikut hutan rawak) berdasarkan kepentingan ciri tersebut. Seperti yang dapat dilihat daripada Rajah 4, mengalih keluar lebih separuh daripada ciri mempunyai sedikit kesan ke atas ketepatan pengelasan GBT.

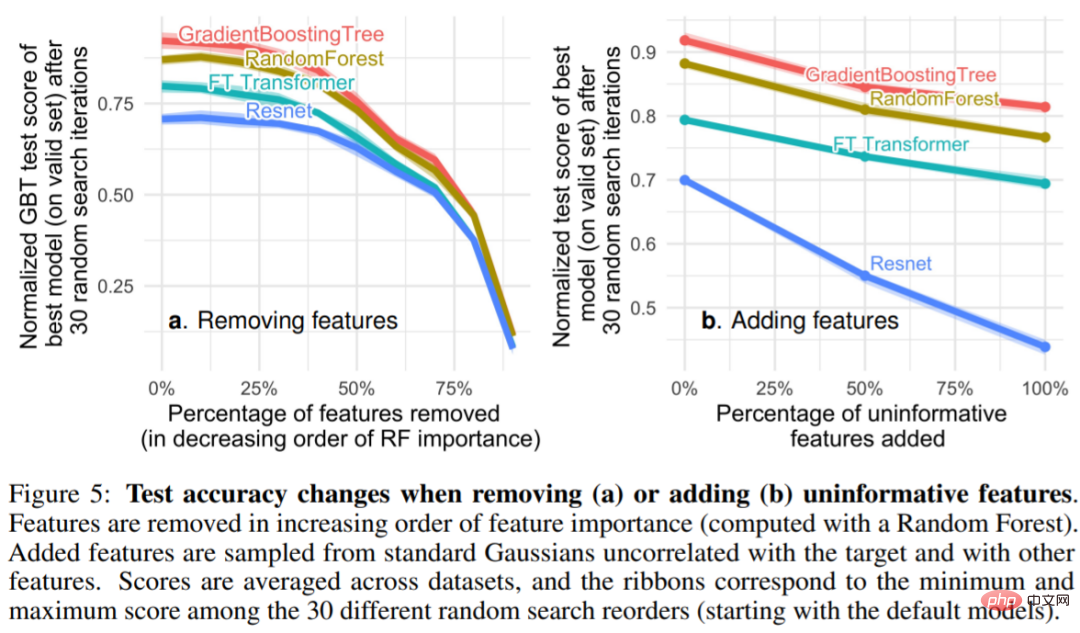

Rajah 5 Dapat dilihat bahawa mengalih keluar ciri tidak bermaklumat (5a) mengurangkan perbezaan antara MLP (Resnet) dan model lain (jurang prestasi antara FT Transformers dan model berasaskan pokok), sambil menambah ciri tidak bermaklumat meluaskan jurang, menunjukkan bahawa MLP kurang teguh berbanding ciri tidak bermaklumat. Dalam Rajah 5a, apabila penyelidik mengeluarkan sebahagian besar ciri, ciri maklumat berguna juga dialih keluar sewajarnya. Rajah 5b menunjukkan bahawa penurunan ketepatan yang disebabkan oleh mengalih keluar ciri ini boleh dikompensasikan dengan mengalih keluar ciri tidak bermaklumat, yang lebih membantu MLP berbanding model lain (pada masa yang sama, kajian ini juga membuang ciri berlebihan dan tidak menjejaskan model prestasi).

Penemuan 3: Melalui putaran, data adalah bukan invarian

Mengapa MLP lebih mudah terdedah kepada ciri tidak bermaklumat berbanding model lain? Satu jawapan ialah MLP adalah invarian putaran: proses mempelajari MLP pada set latihan dan menilainya pada set ujian adalah invarian apabila putaran digunakan pada latihan dan ciri set ujian. Malah, sebarang proses pembelajaran invarian putaran mempunyai kerumitan sampel kes terburuk yang berkembang secara linear sekurang-kurangnya dalam bilangan ciri yang tidak berkaitan. Secara intuitif, untuk mengalih keluar ciri yang tidak berguna, algoritma invarian putaran mesti terlebih dahulu mencari orientasi asal ciri tersebut dan kemudian memilih ciri yang paling kurang bermaklumat.

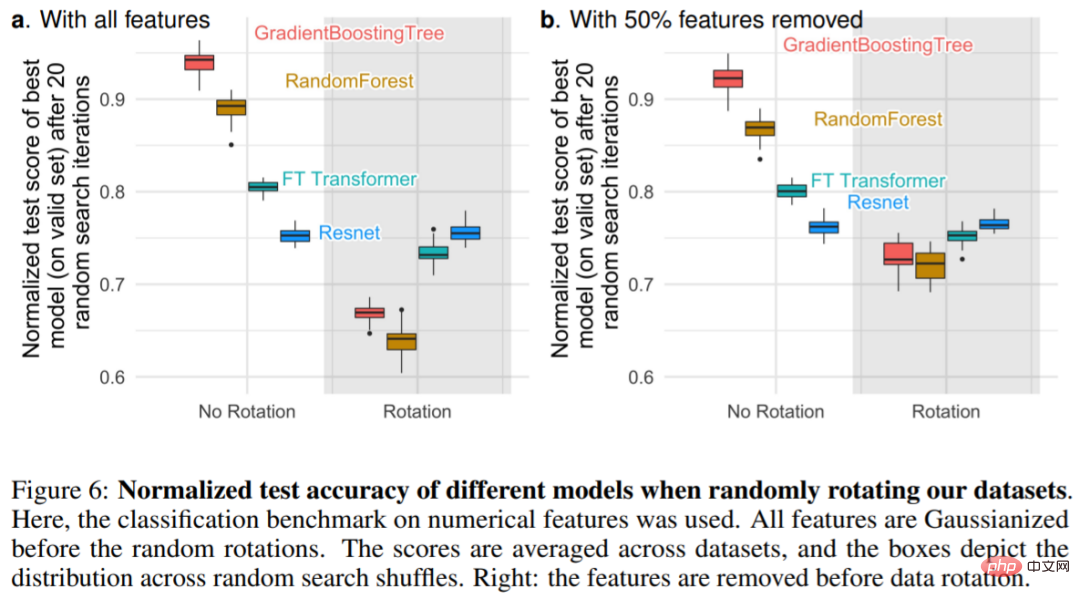

Rajah 6a menunjukkan perubahan dalam ketepatan ujian apabila set data diputar secara rawak, mengesahkan bahawa hanya Resnets adalah invarian putaran. Terutamanya, putaran rawak membalikkan susunan prestasi: hasilnya ialah NN di atas model berasaskan pokok dan Resnet di atas FT Transformers, menunjukkan bahawa invarian putaran adalah tidak diingini. Malah, data jadual selalunya mempunyai makna individu, seperti umur, berat badan, dsb. Seperti yang ditunjukkan dalam Rajah 6b: Mengalih keluar separuh ciri yang paling tidak penting dalam setiap set data (sebelum putaran) mengurangkan prestasi semua model kecuali Resnets, tetapi berbanding menggunakan semua ciri tanpa mengalih keluar ciri , penurunan adalah lebih kecil.

Atas ialah kandungan terperinci Mengapakah model berasaskan pokok masih mengatasi pembelajaran mendalam pada data jadual?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI