Rumah >Peranti teknologi >AI >Perkara besar sedang berlaku dalam kecerdasan buatan, dan LeCun juga telah berubah

Perkara besar sedang berlaku dalam kecerdasan buatan, dan LeCun juga telah berubah

- 王林ke hadapan

- 2023-04-08 13:11:131588semak imbas

Pemprosesan simbol ialah proses biasa dalam logik, matematik dan sains komputer yang menganggap pemikiran sebagai operasi algebra. Selama hampir 70 tahun, perdebatan paling asas dalam bidang kecerdasan buatan ialah sama ada sistem kecerdasan buatan harus berdasarkan pemprosesan simbolik atau pada sistem saraf yang serupa dengan otak manusia.

Sebenarnya terdapat kemungkinan ketiga sebagai jalan tengah - model hibrid. Model hibrid cuba untuk mendapatkan yang terbaik daripada kedua-dua dunia dengan menggabungkan pembelajaran dipacu data rangkaian saraf dengan keupayaan abstraksi berkuasa pemprosesan simbolik. Di sini juga saya telah bekerja untuk kebanyakan kerjaya saya.

Dalam artikel terbaru yang diterbitkan dalam majalah NOEMA, Yann LeCun, pemenang Anugerah Turing dan ketua saintis kecerdasan buatan Meta, dan Jacob Browning, "ahli falsafah residen" LeCun Lab, turut terlibat dalam kontroversi ini . Artikel itu nampaknya menawarkan alternatif baharu, tetapi pemeriksaan lebih dekat mendedahkan bahawa ideanya bukanlah baharu dan tidak meyakinkan.

Yann LeCun dan Jacob Browning secara rasmi menjawab pandangan bahawa "pembelajaran mendalam telah menghantam dinding" buat kali pertama dalam artikel yang diterbitkan dalam majalah NOEMA, menyatakan bahawa "daripada Pada permulaannya, pengkritik telah Pramatang mempercayai bahawa rangkaian saraf telah melanda dinding yang tidak dapat diatasi ternyata hanya halangan sementara setiap masa."

Pada permulaan artikel, mereka nampaknya berhujah terhadap model hibrid, yang sering ditakrifkan sebagai Ia adalah sistem yang menggabungkan pembelajaran mendalam rangkaian saraf dan pemprosesan simbol. Tetapi pada akhirnya, LeCun secara tidak biasa mengakui dalam banyak perkataan bahawa sistem hibrid wujud-bahawa ia penting, bahawa ia adalah cara yang mungkin ke hadapan, dan bahawa kita sentiasa mengetahui perkara ini. Artikel itu sendiri bercanggah.

Mengenai sebab percanggahan ini timbul, satu-satunya sebab yang boleh saya fikirkan ialah LeCun dan Browning entah bagaimana percaya bahawa model yang mempelajari pemprosesan simbolik bukanlah model hibrid. Tetapi pembelajaran adalah masalah yang sedang berkembang (bagaimana sistem timbul?), dan bagaimana sistem yang dibangunkan berfungsi (dengan satu atau dua mekanisme) adalah masalah pengiraan: dengan sebarang ukuran yang munasabah, Sistem yang menggunakan kedua-dua mekanisme rangkaian simbolik dan saraf ialah sistem hibrid. . (Mungkin apa yang mereka maksudkan sebenarnya ialah AI lebih seperti hibrid terpelajar daripada hibrid semula jadi. Tetapi hibrid terpelajar masih hibrid.)

Sekitar tahun 2010, pemprosesan simbolik dianggap sebagai perkataan yang tidak baik oleh penyokong pembelajaran mendalam ; menjelang 2020, memahami asal usul pemprosesan simbolik telah menjadi keutamaan kami.

Saya fikir pemprosesan simbol sama ada semula jadi, atau sesuatu yang lain secara tidak langsung menyumbang kepada pemerolehan pemprosesan simbol. Lebih cepat kita mengetahui asas yang membolehkan sistem mempelajari abstraksi simbolik, lebih cepat kita boleh membina sistem yang memanfaatkan semua pengetahuan di dunia dengan betul, dan lebih cepat sistem akan menjadi lebih selamat, boleh dipercayai dan boleh dijelaskan.

Namun, mula-mula kita perlu memahami selok-belok perbahasan penting ini dalam sejarah pembangunan kecerdasan buatan.

Perintis AI awal Marvin Minsky dan John McCarthy percaya bahawa pemprosesan simbolik adalah satu-satunya cara yang munasabah ke hadapan, manakala perintis rangkaian saraf Frank Rosenblatt percaya bahawa AI akan dibina dengan lebih baik di sekitar penggabungan set "nod" seperti neuron. Boleh mengendalikan struktur data untuk melakukan angkat berat statistik.

Kedua-dua kemungkinan ini tidak saling eksklusif. "Rangkaian saraf" yang digunakan dalam kecerdasan buatan bukanlah rangkaian neuron biologi literal. Sebaliknya, ia adalah model digital yang dipermudahkan yang mempunyai sedikit persamaan dengan otak biologi sebenar, tetapi dengan kerumitan yang minimum. Pada dasarnya, neuron abstrak ini boleh disambungkan dalam pelbagai cara, beberapa daripadanya boleh secara langsung membolehkan pemprosesan logik dan simbolik. Kemungkinan ini telah diakui secara jelas seawal tahun 1943 dalam salah satu kertas terawal dalam bidang, A Logical Calculus of the Ideas Inmanent in Nervous Activity.

Frank Rosenblatt pada 1950-an, dan David Rumelhart dan Jay McClelland pada 1980-an, mencadangkan rangkaian saraf sebagai alternatif kepada pemprosesan simbol Geoffrey Hinton secara amnya menyokong kedudukan ini.

Sejarah yang kurang diketahui di sini ialah pada awal 2010-an, LeCun, Hinton, dan Yoshua Bengio begitu bersemangat tentang rangkaian neural berbilang lapisan ini yang akhirnya menjadi praktikal sehingga mereka mahu menghapuskan simbol pemprosesan sepenuhnya. Menjelang 2015, pembelajaran mendalam masih berada dalam era riang, bersemangat, dan LeCun, Bengio, dan Hinton menulis manifesto tentang pembelajaran mendalam dalam Alam Semulajadi. Artikel itu berakhir dengan serangan terhadap simbol, dengan alasan bahawa "paradigma baharu diperlukan untuk menggantikan operasi berasaskan peraturan pada ungkapan simbolik dengan operasi pada vektor besar."

Malah, Hinton sangat yakin bahawa pemprosesan simbol adalah jalan buntu sehingga pada tahun yang sama dia memberikan ceramah di Universiti Stanford yang dipanggil "Simbol Aetherial"—menyamakan simbol dengan salah satu kesilapan terbesar dalam sejarah sains.

Begitu juga, rakan usaha sama Hinton, Rumelhart dan McClelland membuat perkara yang sama pada tahun 1980-an, berhujah dalam buku 1986 bahawa simbol bukanlah "intipati pengiraan manusia."

Apabila saya menulis artikel mempertahankan pemprosesan simbol pada 2018, LeCun memanggil pandangan sistem hibrid saya "kebanyakannya salah" di Twitter. Pada masa itu, Hinton juga membandingkan kerja saya dengan membuang masa pada "enjin petrol" dan bahawa "enjin elektrik" adalah cara terbaik ke hadapan. Malah pada November 2020, Hinton mendakwa bahawa "pembelajaran mendalam akan dapat melakukan segala-galanya."

Oleh itu, apabila LeCun dan Browning kini menulis, tanpa ironi, bahawa "semua orang yang bekerja dalam pembelajaran mendalam bersetuju bahawa pemprosesan simbolik adalah ciri yang diperlukan untuk mencipta AI seperti manusia," mereka meningkatkan dekad sejarah perdebatan. Seperti yang dikatakan oleh profesor kecerdasan buatan Universiti Stanford, Christopher Manning: "Kedudukan LeCun telah berubah sedikit sebanyak."

Pada tahun 2010-an, ramai dalam komuniti pembelajaran mesin menegaskan (tanpa bukti nyata) bahawa "simbol adalah tidak munasabah secara biologi". Sepuluh tahun kemudian, LeCun sedang mempertimbangkan pendekatan baharu yang merangkumi pemprosesan simbol, sama ada ia semula jadi atau dipelajari. Pandangan baru LeCun dan Browning bahawa pemprosesan simbolik adalah penting mewakili konsesi besar untuk bidang pembelajaran mendalam.

Penyelewengan kedudukan saya;

Usaha untuk mengecilkan model hibrid Skop;

- Bincangkan mengapa pemprosesan simbol dipelajari daripada semula jadi.

- Sebagai contoh, LeCun dan Browning berkata: "Marcus percaya bahawa jika anda tidak mempunyai manipulasi simbolik pada mulanya, anda tidak akan memilikinya kemudian. pada permulaan , anda tidak akan pernah memilikinya)." Malah, saya menyatakannya dengan jelas dalam buku 2001 saya "The Algebraic Mind": Kami tidak pasti sama ada pemprosesan simbolik adalah semula jadi.

Saya menjawab terus terang: Sudah tentu. Setahu saya, tiada siapa yang menafikan bahawa pemprosesan simbolik boleh dipelajari. Saya menjawab soalan ini pada tahun 2001 dalam Bahagian 6.1 Pemikiran Algebra, dan walaupun saya fikir ia tidak mungkin, saya tidak mengatakan ia sama sekali mustahil. Sebaliknya, saya membuat kesimpulan: "Eksperimen dan teori ini sememangnya tidak menjamin bahawa kebolehan pemprosesan simbol adalah semula jadi, tetapi ia sesuai dengan idea itu." pertama ialah perspektif "kebolehbelajaran": sepanjang Pemikiran Algebra, saya menunjukkan bahawa jenis sistem tertentu (pada asasnya pelopor kepada sistem yang lebih mendalam hari ini) gagal Pelbagai aspek pemprosesan simbol dipelajari, jadi tiada jaminan bahawa mana-mana sistem akan dapat belajar pemprosesan simbol. Seperti perkataan asal dalam buku saya:

Sesetengah perkara mesti fitrah. Tetapi tidak ada konflik sebenar antara "alam" dan "memupuk." Alam menyediakan satu set mekanisme yang membolehkan kita berinteraksi dengan persekitaran kita, satu set alat untuk mengekstrak pengetahuan dari dunia, dan satu set alat untuk mengeksploitasi pengetahuan ini. Tanpa beberapa alat pembelajaran semula jadi, kita tidak akan belajar sama sekali.Ahli psikologi perkembangan Elizabeth Spelke pernah berkata: "Saya fikir sistem dengan beberapa titik permulaan terbina dalam (seperti objek, set, peranti untuk pemprosesan simbol, dll.) akan menjadi lebih baik daripada Batu tulis kosong tulen adalah lebih berkesan untuk memahami dunia." Malah, karya LeCun sendiri yang paling terkenal mengenai rangkaian saraf konvolusi juga boleh menggambarkan perkara ini.

Perkara kedua ialah bayi manusia menunjukkan beberapa bukti kebolehan pemprosesan simbolik. Dalam set eksperimen pembelajaran peraturan yang sering disebut dari makmal saya, bayi menyamaratakan pelbagai corak abstrak melangkaui contoh khusus di mana mereka dilatih. Kerja susulan mengenai kebolehan penaakulan logik tersirat bayi manusia akan mengesahkan lagi perkara ini.

Malangnya, LeCun dan Browning benar-benar mengelak kedua-dua mata saya. Anehnya, mereka sebaliknya menyamakan simbol pembelajaran dengan pemerolehan kemudian seperti "peta, perwakilan bergambar, ritual, dan juga peranan sosial," nampaknya tidak menyedari bahawa saya dan beberapa saintis kognitif lain belajar daripada kesusasteraan yang luas dalam sains kognitif Pemikiran tentang bayi, kanak-kanak, dan haiwan bukan manusia. Jika seekor kambing boleh merangkak menuruni bukit sejurus selepas kelahiran, mengapa rangkaian saraf yang baru lahir tidak boleh menambah sedikit pemprosesan simbol

Akhirnya, membingungkan mengapa LeCun dan Browning pergi ke? masalah sedemikian untuk berhujah menentang sifat semula jadi pemprosesan simbol Mereka tidak memberikan hujah berprinsip yang kuat terhadap sifat semula jadi, dan tidak juga memberikan sebarang alasan berprinsip untuk membuktikannya

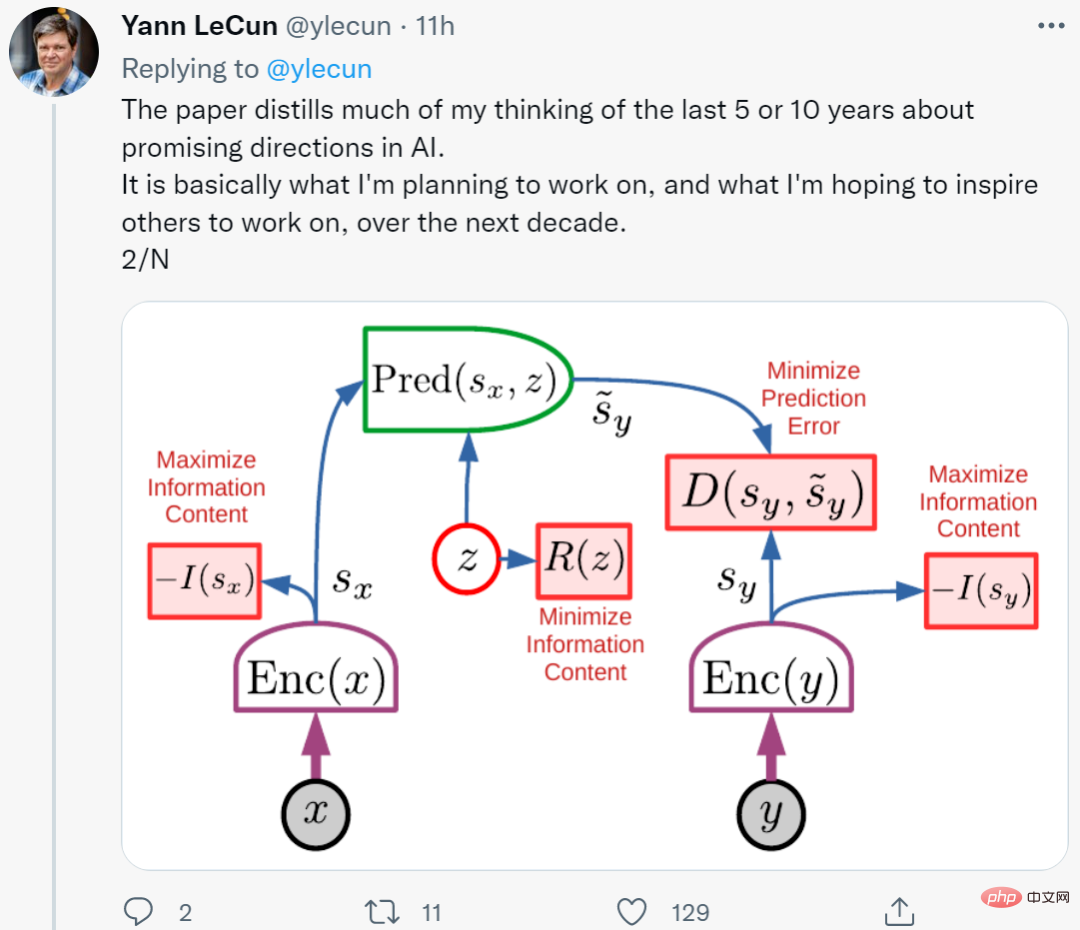

Perlu diperhatikan bahawa LeCun's penyelidikan terkini termasuk beberapa pemprosesan simbol "semula jadi". Seni bina baharunya yang diumumkan baru-baru ini terdiri daripada enam modul secara keseluruhan, kebanyakannya boleh laras tetapi semuanya terbina dalam.

Selain itu, LeCun dan Browning tidak menyatakan cara menyelesaikan masalah tertentu yang terkenal dalam pemahaman dan penaakulan bahasa, kerana model bahasa tidak mempunyai mekanisme pemprosesan simbol semula jadi. Sebaliknya, mereka hanya menggunakan prinsip induksi untuk menerangkan peranan pembelajaran mendalam: "Memandangkan pembelajaran mendalam telah mengatasi masalah dari 1 hingga N, kita harus percaya bahawa ia boleh mengatasi masalah N+1. "

Sebaliknya, mereka hanya menggunakan prinsip induksi untuk menerangkan peranan pembelajaran mendalam: "Memandangkan pembelajaran mendalam telah mengatasi masalah dari 1 hingga N, kita harus percaya bahawa ia boleh mengatasi masalah N+1. "

Pandangan ini sangat lemah. Perkara yang patut difikirkan dan dipersoalkan oleh orang ramai ialah had pembelajaran mendalam.

Kedua, terdapat beberapa sebab konkrit yang kukuh mengapa pembelajaran mendalam sudah pun menghadapi cabaran berprinsip, iaitu masalah kombinatorial, sistematisasi dan pemahaman bahasa. Masalah ini bergantung pada "pengertian" dan "anjakan pengedaran". Semua orang dalam bidang ini kini menyedari bahawa peralihan pengedaran adalah tumit Achilles bagi rangkaian saraf semasa. Ini juga merupakan pandangan perintis sistem pembelajaran mendalam hari ini dalam "Pemikiran Algebra".

Sebenarnya, pembelajaran mendalam hanyalah sebahagian daripada membina mesin pintar. Teknik sedemikian kekurangan kaedah untuk mencirikan hubungan sebab akibat (seperti hubungan antara penyakit dan gejalanya) dan mungkin memberikan cabaran dalam menangkap konsep abstrak. Pembelajaran mendalam tidak mempunyai kaedah penaakulan logik yang jelas dan masih jauh untuk mengintegrasikan pengetahuan abstrak.

Sudah tentu, pembelajaran mendalam telah membuat banyak kemajuan, dan ia mahir dalam pengecaman corak, tetapi ia tidak mencapai kemajuan yang mencukupi pada beberapa masalah asas seperti penaakulan, dan sistem masih sangat tidak boleh dipercayai.

Ambil model baharu Minerva yang dibangunkan oleh Google sebagai contoh Ia mempunyai berbilion-bilion token semasa latihan, tetapi masih sukar untuk menyelesaikan masalah mendarab nombor 4 digit. Ia mencapai ketepatan 50 peratus pada peperiksaan matematik sekolah menengah, tetapi disebut-sebut sebagai "peningkatan besar." Oleh itu, masih sukar untuk membina sistem yang menguasai penaakulan dan abstraksi dalam bidang pembelajaran mendalam. Kesimpulan semasa ialah: bukan sahaja terdapat masalah dengan pembelajaran mendalam, tetapi pembelajaran mendalam "selalu mempunyai masalah."

Saya nampaknya situasi dengan pengendalian simbol mungkin sama seperti biasa:

Di bawah pengaruh "pemikiran algebra" selama 20 tahun, sistem semasa masih tidak dapat mengekstrak pemprosesan simbolik (seperti pendaraban) dengan pasti, walaupun dalam menghadapi set data dan latihan yang besar. Contoh manusia bayi dan kanak-kanak kecil menunjukkan bahawa, sebelum pendidikan formal, manusia mampu menyamaratakan konsep kompleks bahasa semula jadi dan penaakulan (mungkin bersifat simbolik).

Sedikit perlambangan terbina dalam boleh meningkatkan kecekapan pembelajaran. Kejayaan LeCun sendiri dengan konvolusi (kekangan terbina dalam tentang cara rangkaian saraf disambungkan) menggambarkan keadaan ini dengan baik. Sebahagian daripada kejayaan AlphaFold 2 berpunca daripada perwakilan semula jadi biologi molekul yang dibina dengan teliti, dan sebahagian lagi datang daripada peranan model. Makalah baharu daripada DeepMind mengatakan mereka telah membuat sedikit kemajuan dalam membina penaakulan sistematik tentang pengetahuan semula jadi tentang sasaran.

Dan tiada apa yang dikatakan oleh LeCun dan Browning yang mengubahnya.

Mengambil langkah ke belakang, dunia boleh dibahagikan secara kasar kepada tiga bahagian:

- Sistem dengan peralatan pemprosesan simbol terpasang sepenuhnya di kilang (seperti hampir semua bahasa pengaturcaraan yang diketahui).

- Sistem dengan peranti pembelajaran semula jadi kekurangan pemprosesan simbolik, tetapi memandangkan data dan persekitaran latihan yang sesuai, sudah memadai untuk mendapatkan pemprosesan simbolik.

- Walaupun dengan latihan yang mencukupi, adalah mustahil untuk mendapatkan sistem dengan mekanisme pemprosesan simbol yang lengkap.

Sistem pembelajaran mendalam semasa termasuk dalam kategori ketiga: tiada mekanisme pemprosesan simbol pada mulanya, dan tiada mekanisme pemprosesan simbol yang boleh dipercayai dalam proses itu.

LeCun dan Browning nampaknya bersetuju dengan hujah saya baru-baru ini terhadap penskalaan apabila mereka menyedari bahawa penskalaan berfungsi dengan baik untuk menambah lebih banyak lapisan, lebih banyak data, tetapi ia tidak mencukupi. Kami bertiga mengakui keperluan untuk beberapa idea baharu.

Selain itu, pada peringkat makro, pernyataan LeCun baru-baru ini dalam banyak cara sangat hampir dengan pernyataan 2020 saya bahawa kami berdua menekankan kepentingan memahami, menaakul dan memiliki model dunia yang lebih kaya. Kita semua bersetuju bahawa pemprosesan simbol memainkan peranan penting (walaupun mungkin berbeza). Kita semua bersetuju bahawa teknik pembelajaran pengukuhan yang popular pada masa ini tidak dapat memenuhi semua keperluan, dan juga penskalaan tulen.

Perbezaan terbesar dalam pemprosesan simbol ialah jumlah struktur sedia ada yang diperlukan dan keupayaan untuk memanfaatkan pengetahuan sedia ada. Pemprosesan simbolik mahu mengeksploitasi sebanyak mungkin pengetahuan sedia ada, manakala pembelajaran mendalam mahu sistem bermula dari awal sebanyak mungkin.

Pada tahun 2010-an, pemprosesan simbolik merupakan istilah yang tidak popular dalam kalangan penyokong pembelajaran mendalam Pada tahun 2020-an, kita harus menjadikan keutamaan untuk memahami asal usul kaedah ini, walaupun bagi mereka yang paling bersemangat tentang rangkaian saraf AI telah mengiktiraf kepentingan pemprosesan simbolik dalam mencapai AI. Soalan lama dalam komuniti neurosimbolik ialah: Bagaimanakah pembelajaran dipacu data dan perwakilan simbolik boleh berfungsi secara harmoni dalam satu kecerdasan yang lebih berkuasa? Yang menggembirakan, LeCun akhirnya komited untuk berusaha ke arah matlamat itu.

Pautan asal: https://www.noemamag.com/deep-learning-alone-isnt-getting-us-to-human-like-ai/

Atas ialah kandungan terperinci Perkara besar sedang berlaku dalam kecerdasan buatan, dan LeCun juga telah berubah. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI