Rumah >Peranti teknologi >AI >Aplikasi dan penyelidikan carian industri berdasarkan model bahasa pra-terlatih

Aplikasi dan penyelidikan carian industri berdasarkan model bahasa pra-terlatih

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-08 11:31:111788semak imbas

1 Latar belakang carian industri

1 >

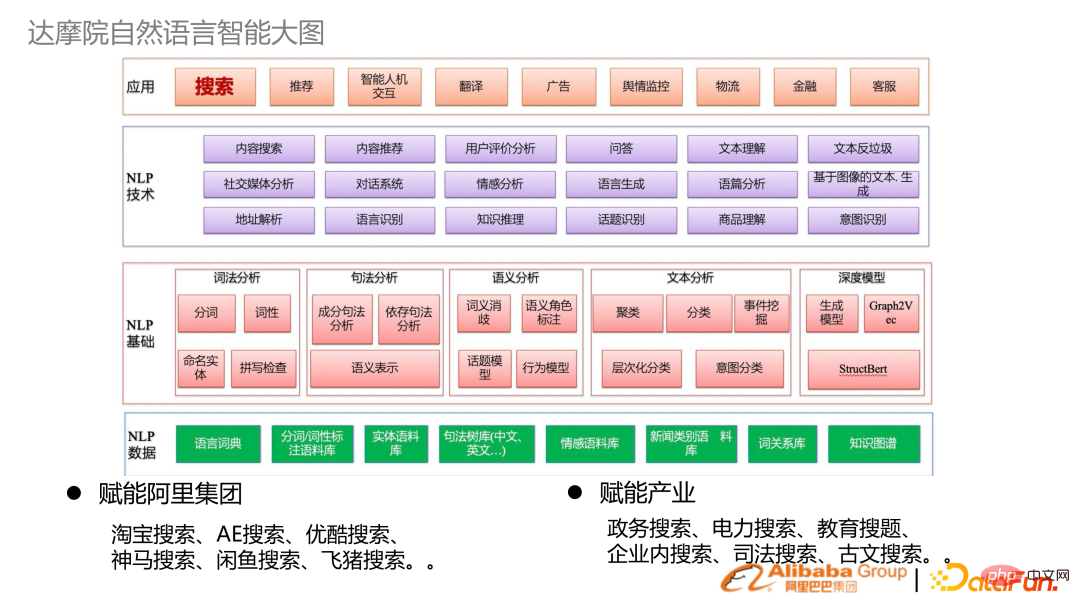

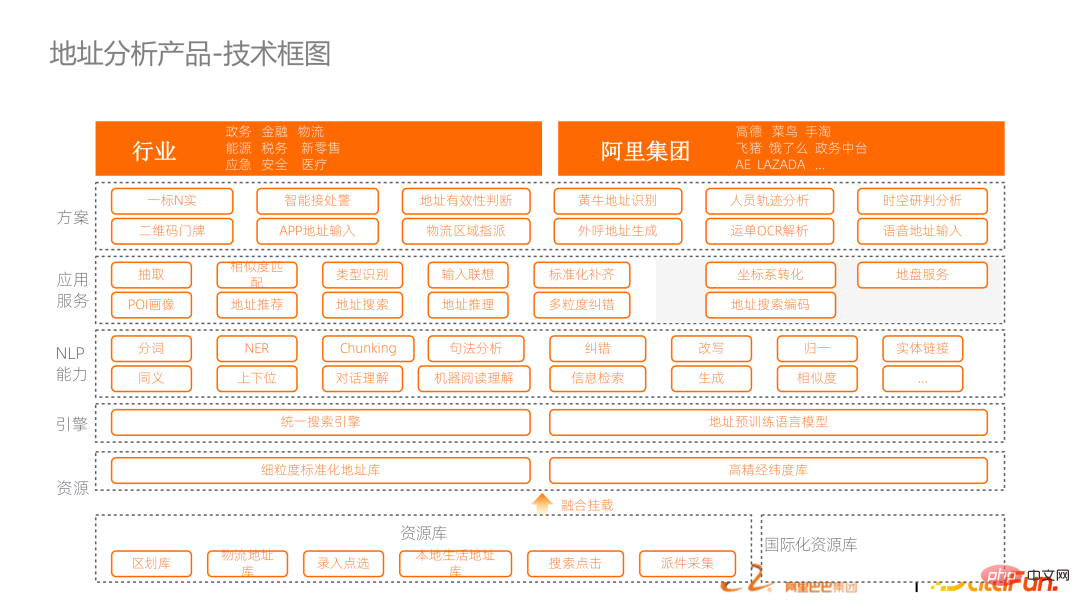

Gambar di atas ialah gambarajah blok teknikal kecerdasan pemprosesan bahasa semulajadi DAMO Academy, yang merangkumi dari bawah ke atas:

- Data NLP, leksikon asas NLP, semantik sintaksis, teknologi analisis dan teknologi NLP lapisan atas

- Aplikasi industri: Sebagai tambahan kepada melakukan Selain penyelidikan asas, ia juga memperkasakan Kumpulan Alibaba dan menyepadukan Alibaba Cloud untuk memperkasakan industri. Banyak senario industri untuk pemerkasaan adalah carian.

- 2 Sifat pencarian industri

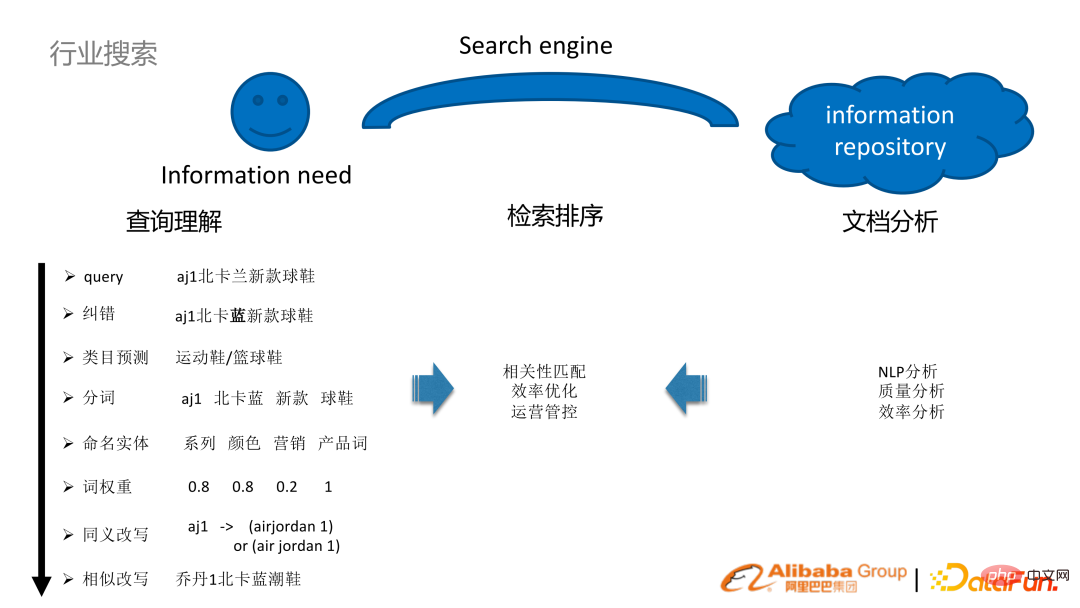

Ambil senario e-dagang sebagai contoh. Sebagai contoh, pengguna mencari kasut baharu biru aj1 North Carolina di kedai e-dagang. Untuk lebih memahami pertanyaan pengguna sedemikian, satu siri tugasan perlu dilakukan:

- Analisis pemahaman pertanyaan: pembetulan ralat NLP, perkataan segmentasi dan kategori Ramalan, berat perkataan pengecaman entiti, penulisan semula pertanyaan dan teknologi lain

- (luar talian) analisis dokumen: analisis NLP, analisis kualiti dan kecekapan

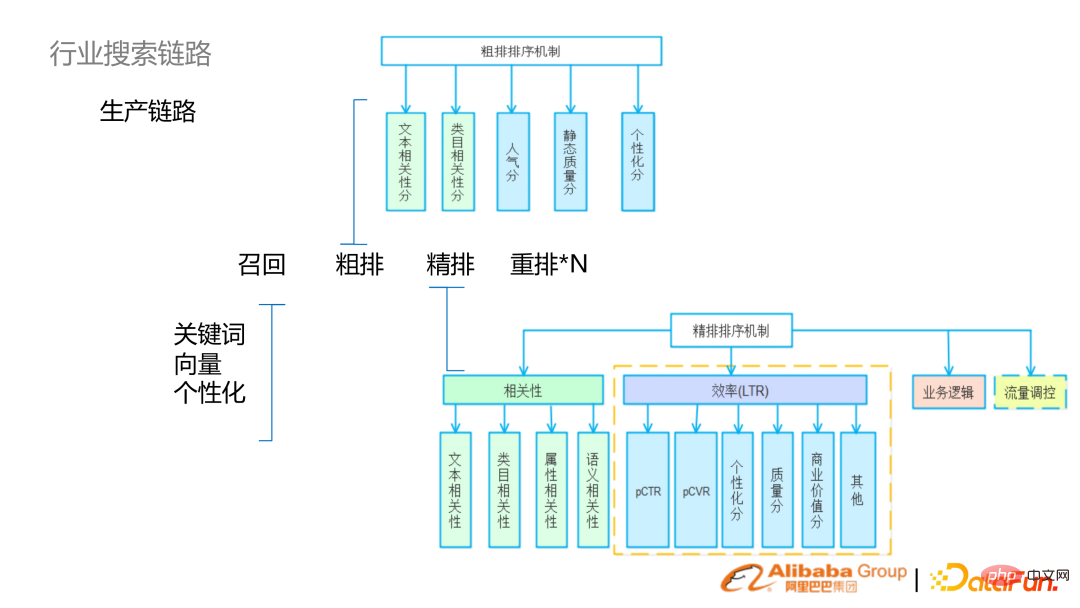

- 3 pautan carian industri

.

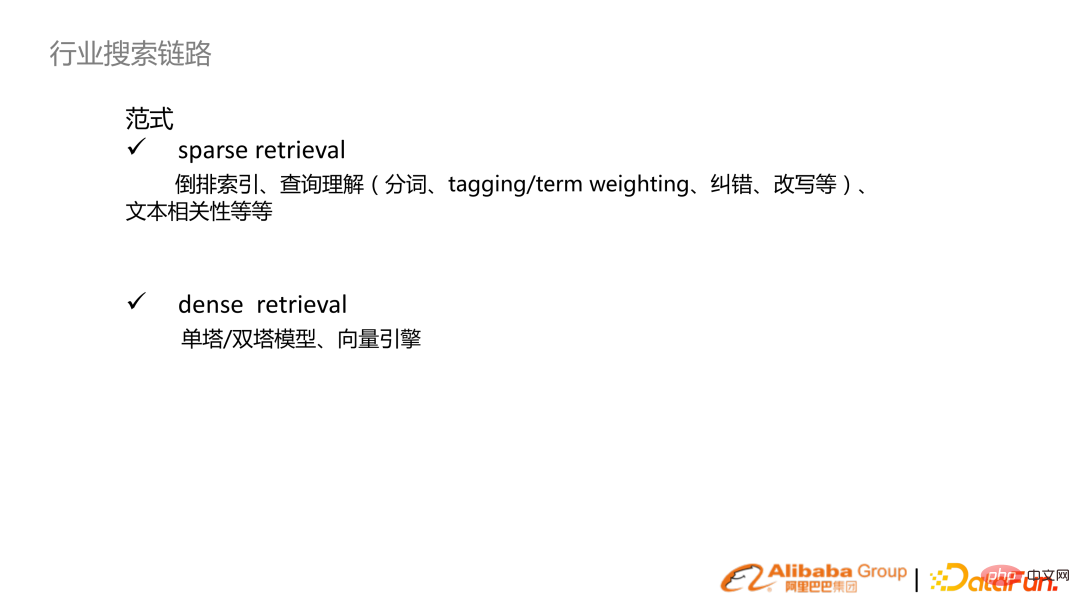

Jika dibahagikan mengikut paradigma pencarian, ia secara umumnya dibahagikan kepada perolehan jarang dan perolehan padat.

pendapatan jarang: Secara tradisional berasaskan perkataan atau berasaskan perkataan untuk membina indeks terbalik dan berdasarkan ini untuk membina satu siri keupayaan untuk pemahaman pertanyaan , termasuk beberapa pengisihan perkaitan teks, dsb.;

- pendapatan padat: Dengan peningkatan model bahasa pra-latihan, menara tunggal dan menara berganda direalisasikan berdasarkan model pangkalan pra-terlatih, dan kemudian digabungkan dengan enjin vektor untuk mewujudkan mekanisme carian.

- Secara amnya, carian terbahagi kepada pautan: ingat, pengisihan (isihan kasar, isihan halus) Susun, menyusun semula).

Fasa ingat semula:

- Pengingatan semula kata kunci bagi perolehan jarang tradisional

- pengingat semula vektor perolehan padat, ingatan diperibadikan

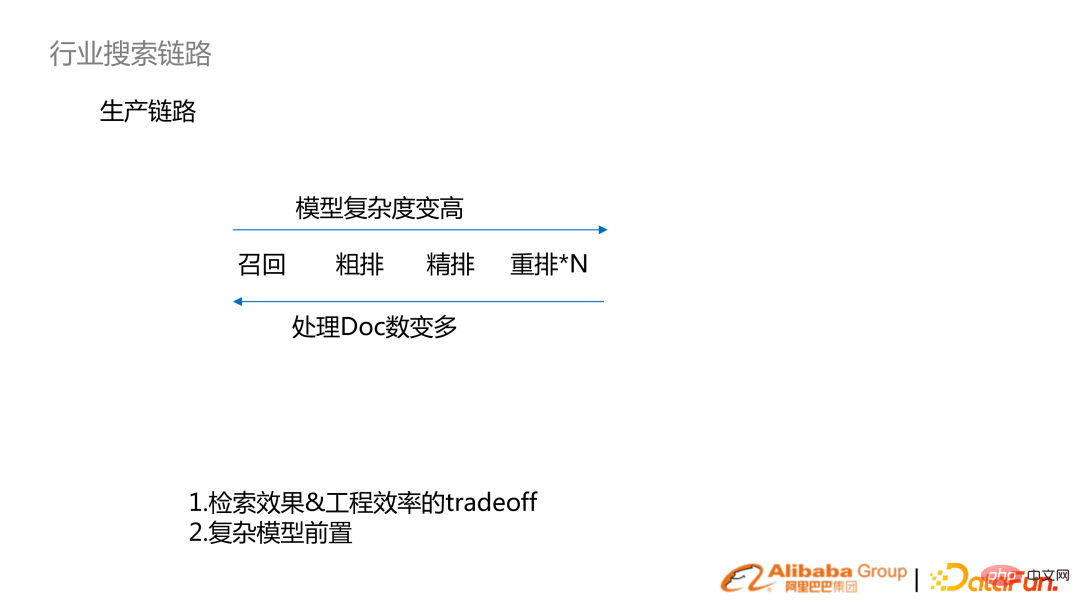

- dari kiri ke kanan, kerumitan model dan ketepatan kesan menjadi lebih tinggi. Dari kanan ke kiri, bilangan Dokumen yang diproses meningkat. Ambil e-dagang Taobao sebagai contoh, seperti penarikan balik (berbilion), kedudukan awal (ratusan ribu), kedudukan halus (ratusan, ribuan), dan penyusunan semula (puluhan).

Pautan pengeluaran carian ialah sistem di mana kesan perolehan semula dan kecekapan kejuruteraan adalah pertukaran. Apabila kuasa pengkomputeran meningkat, model kompleks mula diganti. Sebagai contoh, model yang telah diisih dengan halus kini akan beransur-ansur beralih ke peringkat pengisihan kasar atau ingat semula.

Pautan pengeluaran carian ialah sistem di mana kesan perolehan semula dan kecekapan kejuruteraan adalah pertukaran. Apabila kuasa pengkomputeran meningkat, model kompleks mula diganti. Sebagai contoh, model yang telah diisih dengan halus kini akan beransur-ansur beralih ke peringkat pengisihan kasar atau ingat semula.

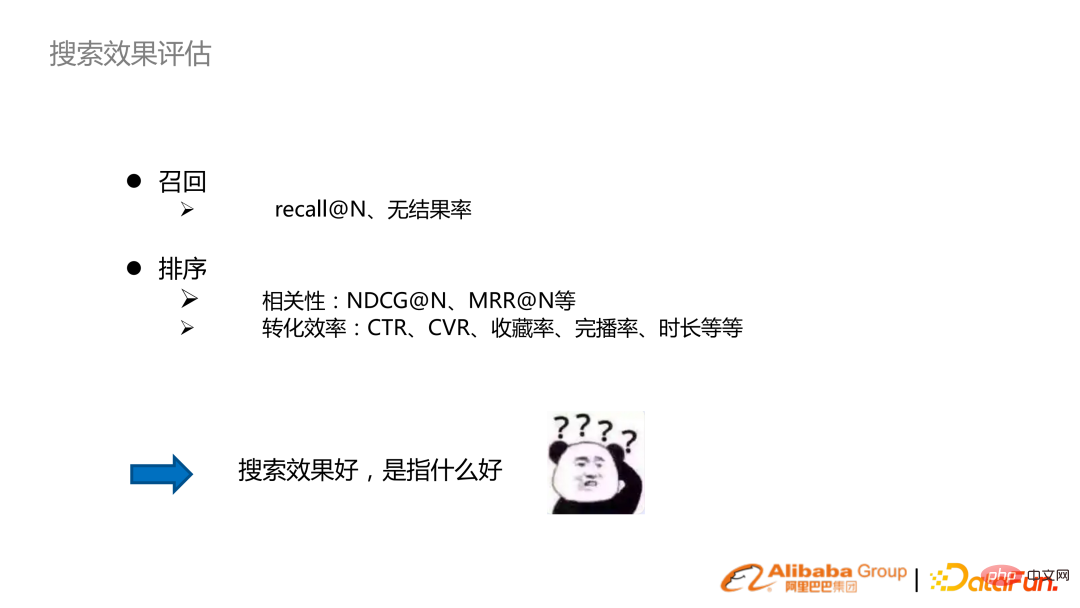

Penilaian prestasi carian:

Kedudukan: perkaitan, kecekapan penukaran (hampir dengan perniagaan)

- Perkaitan: NDCG, MRR

- Kecekapan penukaran: kadar klik lalu, kadar penukaran

- 4. Carian di Internet pengguna dan Internet industri

: UV carian Internet pengguna adalah sangat besar, dan Internet perindustrian disasarkan kepada pekerja dalam kerajaan dan perusahaan.

- Penunjuk pencarian carian: Dalam menggunakan Internet, selain mengejar hasil carian dan carian yang tepat, kami juga mengejar kadar penukaran yang tinggi. Dalam Internet perindustrian, ia lebih kepada keperluan untuk pemadanan maklumat, jadi fokus pada ingatan dan perkaitan.

- Keperluan Sistem Kejuruteraan: Keperluan QPS Internet Pengguna akan menjadi sangat tinggi, dan sejumlah besar tingkah laku pengguna akan terkumpul, yang memerlukan Terdapat analisis log masa nyata dan latihan model masa nyata. Keperluan untuk Internet industri akan lebih rendah.

- Arah Algoritma: Internet Pengguna akan diperolehi daripada analisis gelagat pengguna luar talian, garisan hampir dan dalam talian dan pemodelan Faedah yang lebih besar. Tingkah laku pengguna Internet industri adalah jarang, jadi ia akan memberi lebih perhatian kepada pemahaman kandungan, seperti NLP atau pemahaman visual termasuk sumber rendah dan pembelajaran pemindahan.

- 2. Penyelidikan tentang teknologi berkaitan

1. Sistem AliceMind

AliceMind ialah sistem model bahasa pra-latihan hierarki yang dibina oleh DAMO Academy. Mengandungi model umum pra-latihan, berbilang bahasa, berbilang modal, dialog, dsb., dan merupakan asas untuk semua tugasan NLP.

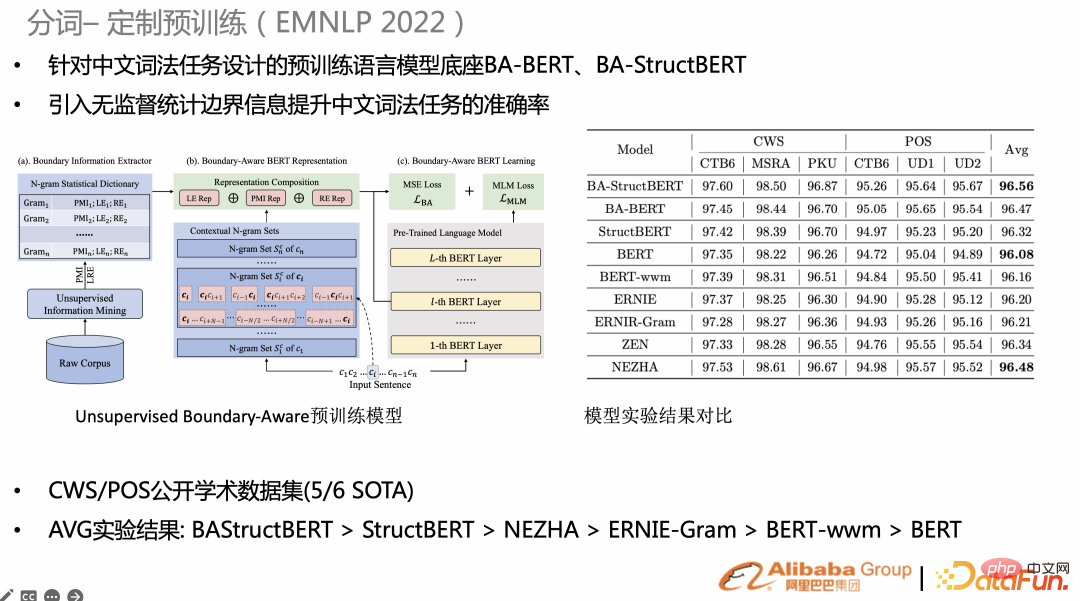

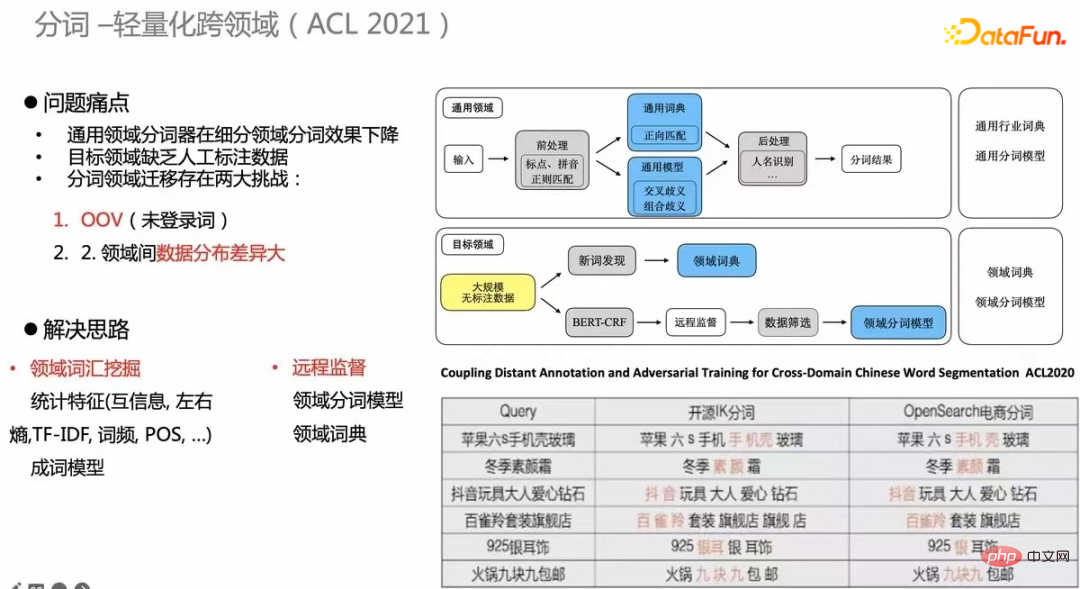

2. Pembahagian perkataan

Segmentasi perkataan carian (kuasa atom) , Ia menentukan kebutiran indeks perolehan, dan juga berkaitan dengan korelasi seterusnya dan kebutiran BM25. Untuk tugasan khusus, jika anda menyesuaikan beberapa pra-latihan, kesannya akan lebih baik daripada pra-latihan umum. Sebagai contoh, penyelidikan baru-baru ini berharap untuk menambah maklumat statistik yang tidak diselia pada tugas pra-latihan BERT asli, seperti perkataan statistik, kebutiran Gram atau entropi sempadan, dan kemudian menambah mse-loss pada pra-latihan. Pada CWS/POS dan NER (gambar kanan), banyak tugasan telah mencapai SOTA.

Satu lagi penyelidikan merentas bidang. Kos pelabelan data dan membina tugas penyeliaan setiap masa adalah sangat tinggi, jadi adalah perlu untuk membina mekanisme pembahagian kata tanpa pengawasan merentas domain. Jadual di sudut kanan bawah adalah contoh Kualiti pembahagian perkataan e-dagang telah dipertingkatkan dengan ketara berbanding pembahagian perkataan sumber terbuka Kaedah ini juga telah dikeluarkan kepada ACL2020.

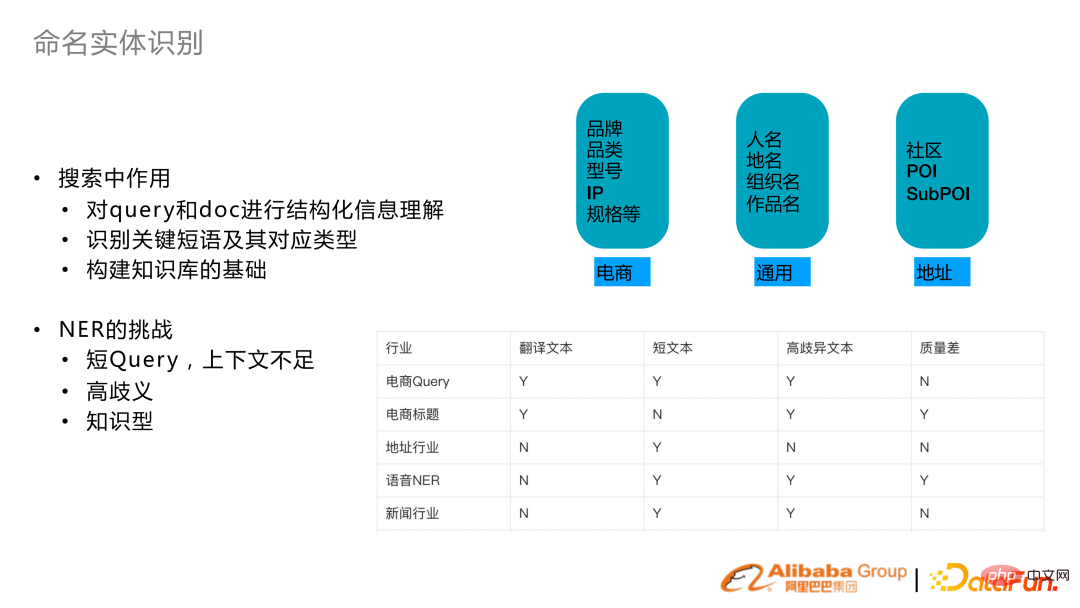

3 bernama pengiktirafan entiti

Carian bernama pengecaman entiti terutamanya melibatkan pemahaman berstruktur tentang pertanyaan dan Dokumen serta mengenal pasti frasa dan jenis utama. Pada masa yang sama, pembinaan graf pengetahuan carian juga bergantung pada fungsi NER.

Mencari NER juga datang dengan beberapa cabaran. Sebab utama ialah pertanyaan selalunya agak pendek dan kurang konteks. Sebagai contoh, entiti pertanyaan dalam e-dagang adalah sangat samar-samar dan berpengetahuan. Oleh itu, idea pengoptimuman teras NER dalam beberapa tahun kebelakangan ini adalah untuk meningkatkan perwakilan NER melalui konteks atau pengenalan pengetahuan.

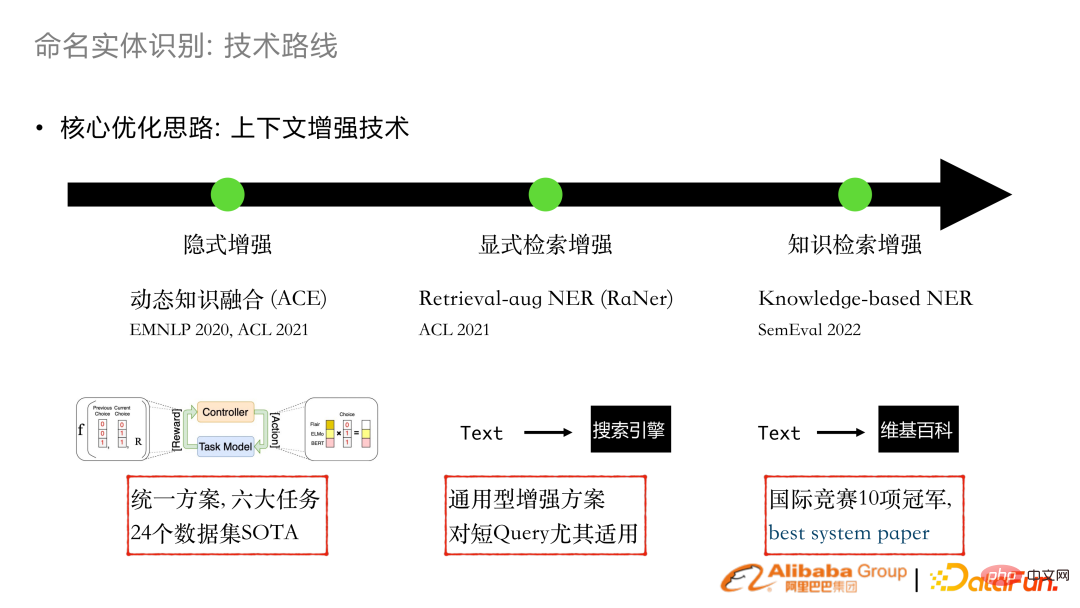

Pada tahun 2020 dan 2021, kami melakukan pembenaman kombo peningkatan tersirat. Dengan menyepadukan pengekstrak perkataan sedia ada atau perwakilan GLUE secara dinamik, ia boleh digunakan pada banyak tugas perniagaan untuk mencapai SOTA.

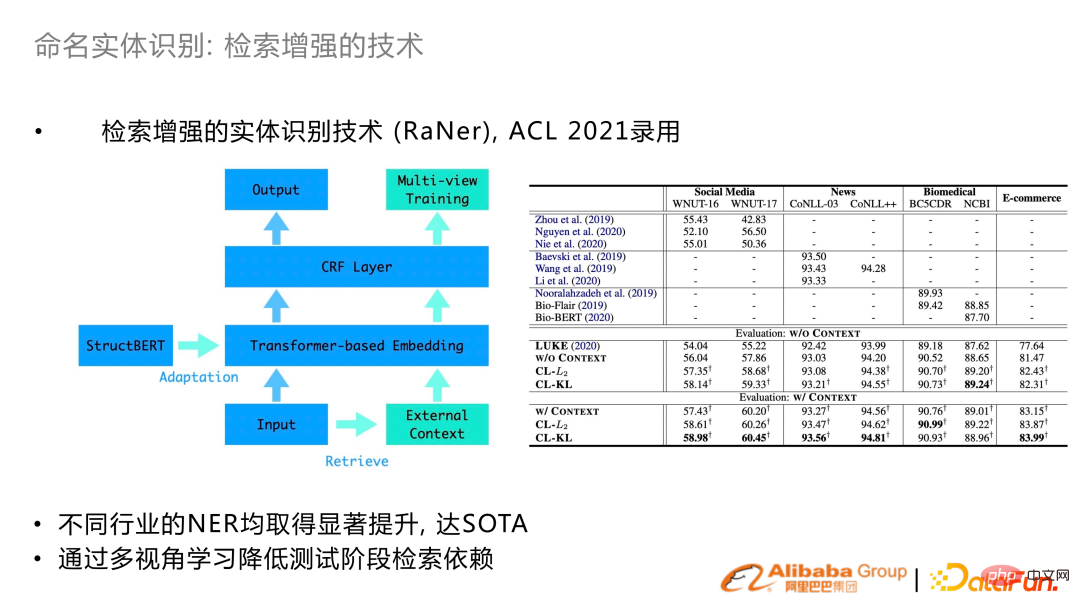

Pada tahun 2021, peningkatan perolehan secara eksplisit akan dibangunkan Konteks teks akan dipertingkatkan melalui enjin carian dan disepadukan ke dalam struktur pengubah. Karya ini diterbitkan dalam ACL 2021.

Berdasarkan kerja ini, kami mengambil bahagian dalam penilaian NER berbilang bahasa SemEval 2022 dan memenangi 10 kejuaraan, serta kertas sistem terbaik.

Peningkatan perolehan semula: Sebagai tambahan kepada ayat input itu sendiri, konteks tambahan ialah diambil dan disambungkan kepada input, digabungkan dengan kehilangan KL untuk membantu pembelajaran. Mendapat SOTA dalam banyak set data sumber terbuka.

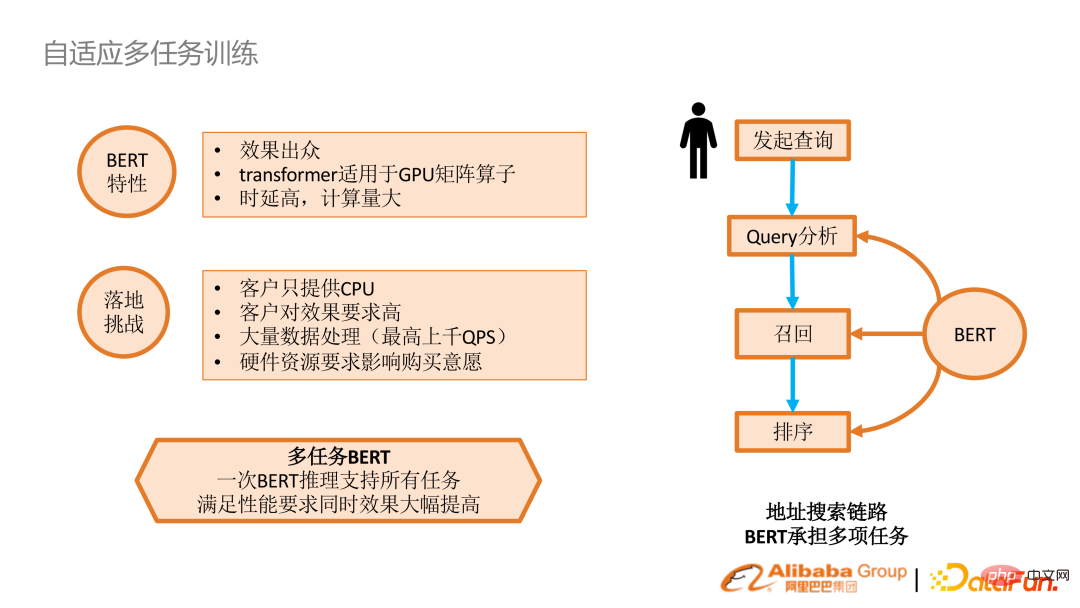

4. Latihan pelbagai tugas adaptif

BERT sendiri sangat berkesan, tetapi pengeluaran sebenar sangat kecil Terdapat kluster GPU, dan inferens diperlukan untuk setiap tugas, yang sangat mahal dari segi prestasi. Kami memikirkan sama ada kami hanya boleh melakukan inferens sekali, dan kemudian menyesuaikan setiap tugas dengan sendirinya selepas pengekod, supaya kami boleh mendapatkan hasil yang lebih baik.

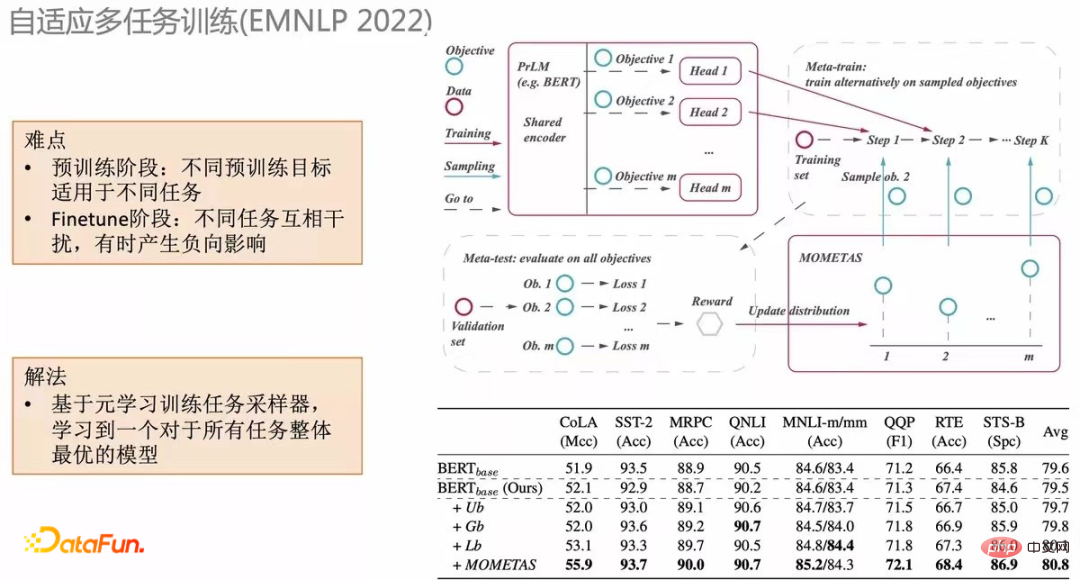

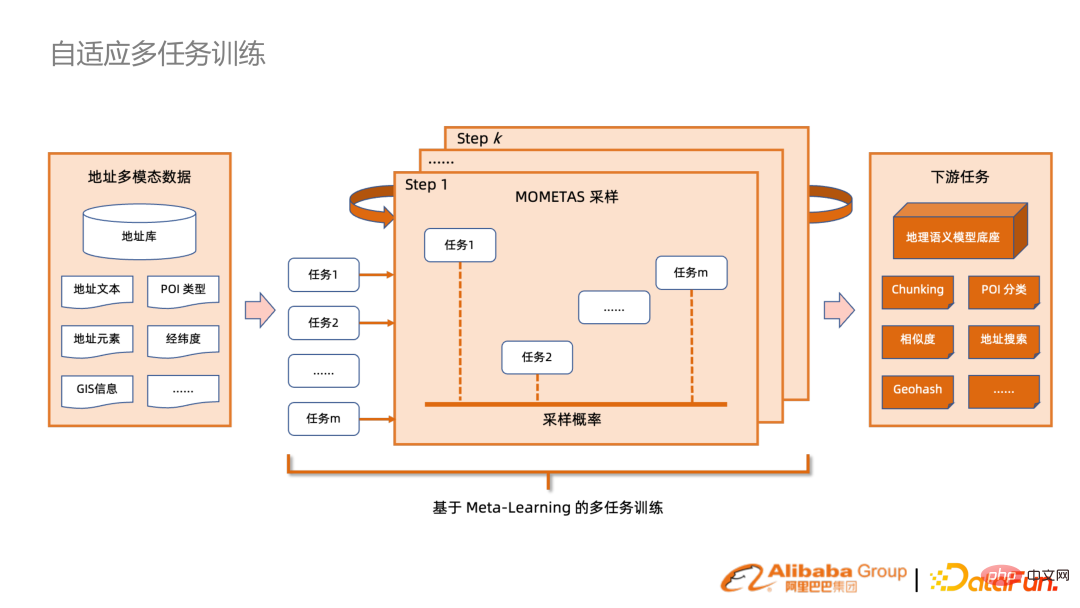

Cara intuitif ialah dengan menggabungkan tugasan analisis pertanyaan NLP melalui rangka kerja meta-tugas. Tetapi meta-tugas tradisional ialah pengedaran sampel seragam. Kami mencadangkan MOMETAS, kaedah berasaskan meta-pembelajaran adaptif yang menyesuaikan diri pensampelan untuk tugasan yang berbeza. Dalam proses mempelajari pelbagai tugasan, kami akan menggunakan data pengesahan secara berkala untuk ujian untuk melihat kesan pembelajaran tugasan yang berbeza. ganjaran seterusnya membimbing persampelan latihan sebelumnya. (Jadual di bawah) Menggabungkan mekanisme ini pada banyak tugas mempunyai banyak penambahbaikan berbanding UB (pengagihan seragam).

Gunakan mekanisme di atas pada senario mencari banyak industri, dan faedah akan dicapai melalui BERT hanya sekali Pengekodan dan penyimpanan boleh digunakan semula secara langsung dalam banyak tugas hiliran, yang boleh meningkatkan prestasi dengan banyak.

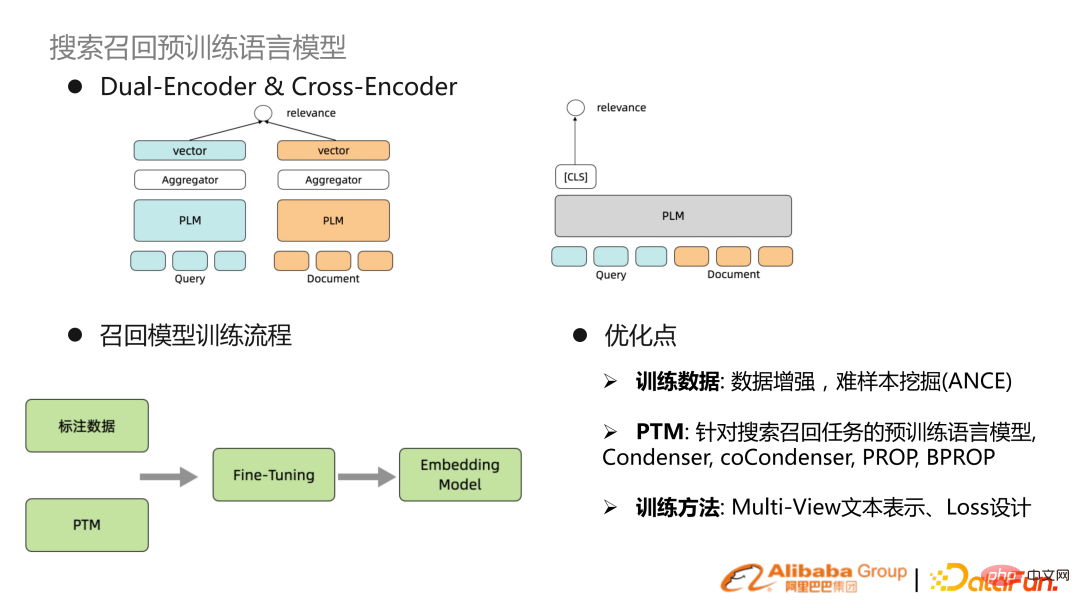

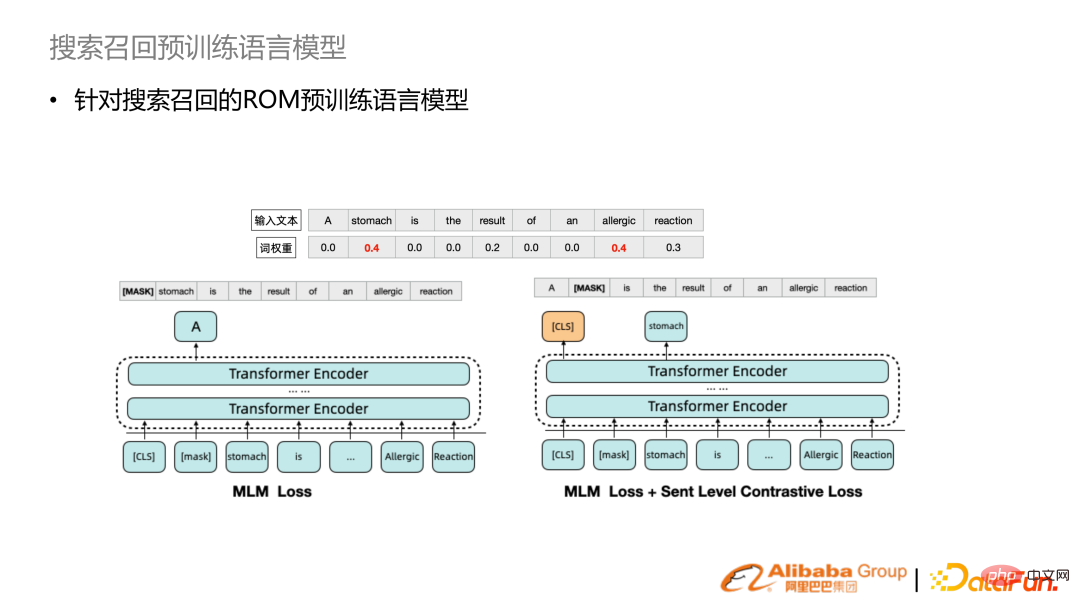

5 Cari mengingat semula model bahasa pra-latihan

Pendapatan mendalam. , Ia tidak lebih daripada dua menara atau menara tunggal Paradigma latihan biasa adalah isyarat yang diawasi dan model yang telah dilatih dilakukan untuk mendapatkan pembenaman, dan pertanyaan dan dokumen diwakili. Laluan pengoptimuman terkini terutamanya adalah peningkatan data atau perlombongan sampel yang sukar, dan yang lain adalah mengoptimumkan model bahasa yang telah dilatih. BERT asli bukanlah perwakilan teks yang sesuai untuk carian, jadi terdapat model bahasa yang telah dilatih untuk mencari perwakilan teks. Pengoptimuman lain terletak pada perwakilan teks berbilang paparan dan reka bentuk kehilangan khas.

Berbanding dengan pensampelan rawak BERT asli, kami menggabungkan pemberat kata carian untuk menambah baik perkataan dengan pemberat perkataan yang lebih tinggi untuk menambah baik persampelan Secara kebarangkalian, perwakilan yang dipelajari adalah lebih sesuai untuk pencarian semula. Selain itu, pembelajaran perbandingan peringkat ayat ditambah. Menggabungkan kedua-dua mekanisme ini, model bahasa pra-terlatih ROM dicadangkan.

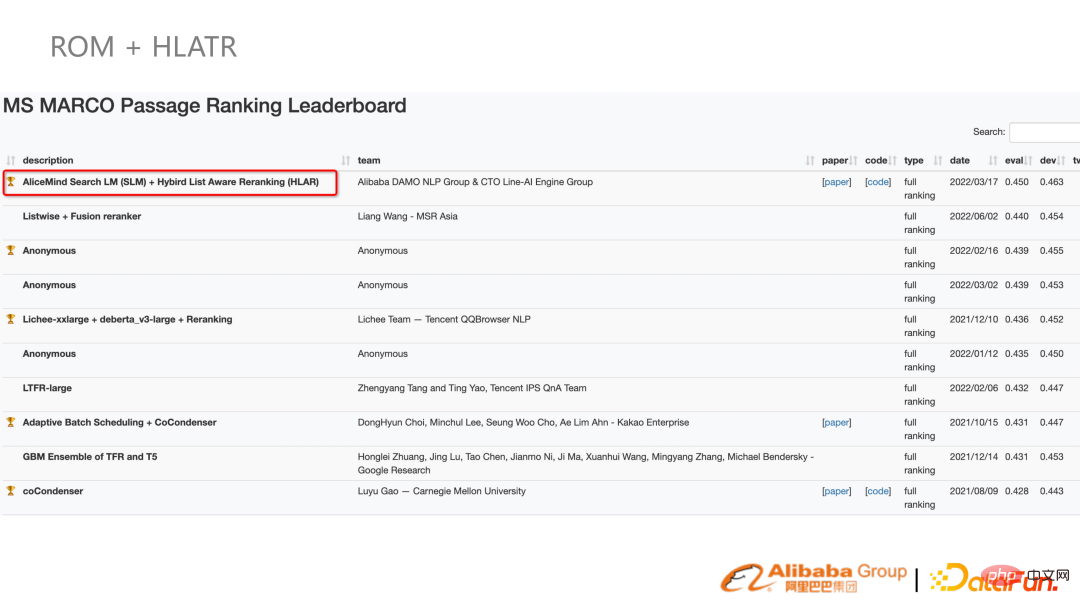

Lakukan eksperimen di MS MARCO untuk membandingkan kaedah sebelumnya untuk mencapai hasil yang terbaik. Dalam tugas carian adegan sebenar, ia juga boleh membawa peningkatan yang hebat. Pada masa yang sama, model ini turut mengambil bahagian dalam ranking MS.

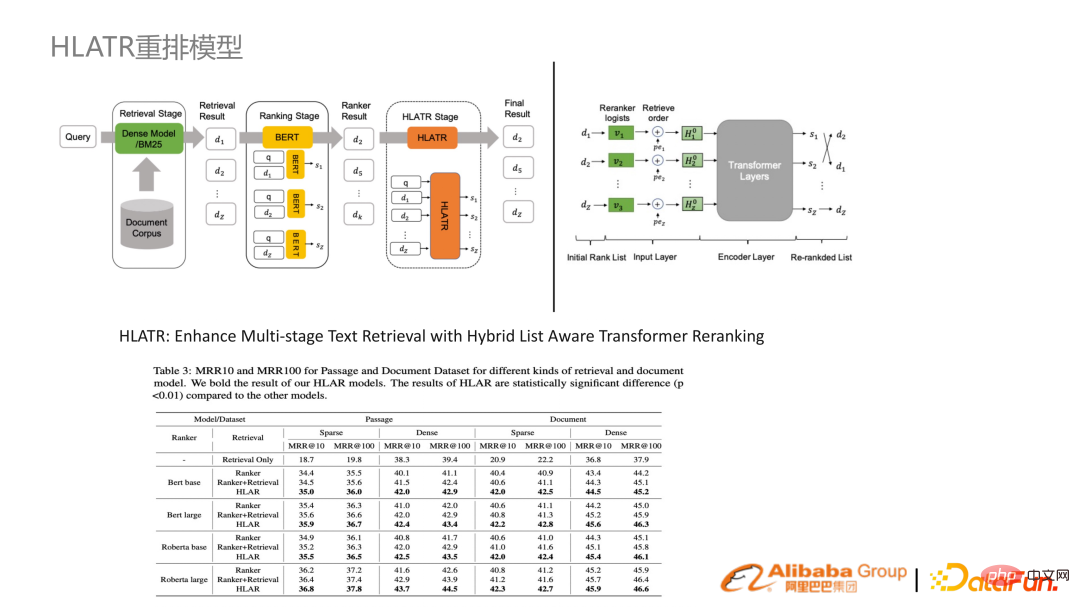

6. Model penyusunan semula HLATR

Kecuali peringkat ingat semula ROM Di samping itu, dalam peringkat penarafan halus dan penarafan semula, satu set penarafan semula Transformer sedar senarai dicadangkan, yang bermaksud bahawa hasil banyak pengelas peringkat halus disepadukan secara organik melalui Transformer, menghasilkan peningkatan yang agak besar.

Menggabungkan dua penyelesaian ROM dan HLATR, keputusan dari Mac hingga sekarang (Julai) masih SOTA.

3. Aplikasi carian industri

1 🎜>

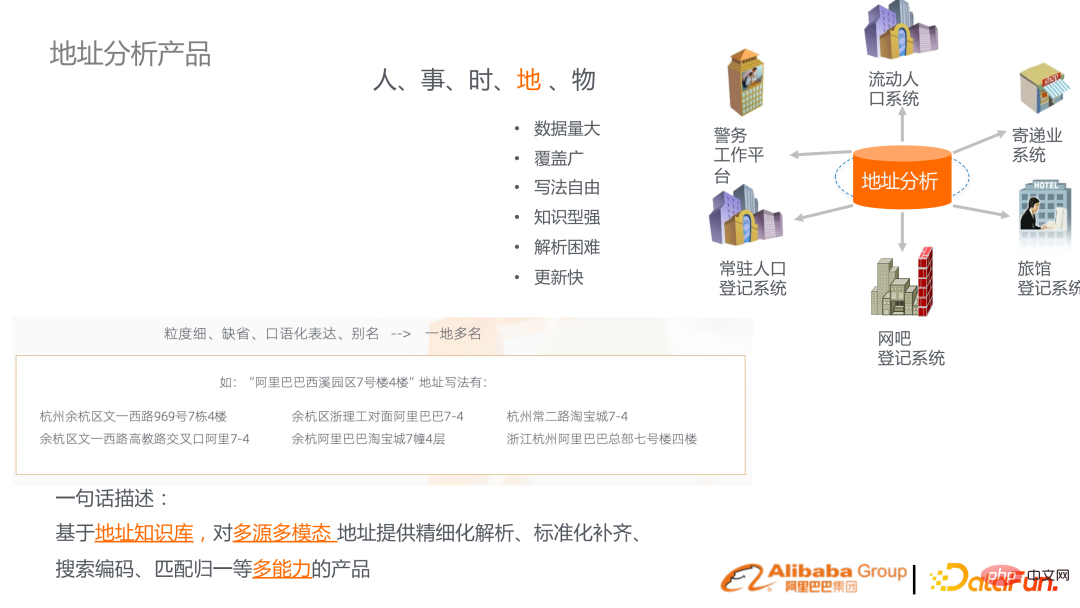

Produk analisis alamat yang dibangunkan oleh DAMO Academy adalah berdasarkan fakta bahawa terdapat banyak alamat surat-menyurat dalam pelbagai industri. Alamat surat-menyurat Cina mempunyai banyak ciri, seperti banyak lalai dalam ungkapan bahasa sehari-hari. Pada masa yang sama, alamat itu sendiri ialah orang atau benda, dan ia merupakan unit entiti penting yang menghubungkan banyak entiti dalam dunia objektif. Oleh itu, berdasarkan ini, satu set graf pengetahuan alamat telah diwujudkan untuk menyediakan penghuraian, penyiapan, carian dan analisis alamat.

Ini ialah gambarajah blok teknikal produk. Dari bawah ke atas, ia termasuk pembinaan graf pengetahuan alamat dan model bahasa pra-latihan alamat, termasuk rangka kerja berasaskan enjin carian untuk menyambungkan keseluruhan pautan. Keupayaan penanda aras yang dinyatakan di atas disediakan dalam bentuk API dan dibungkus ke dalam penyelesaian industri.

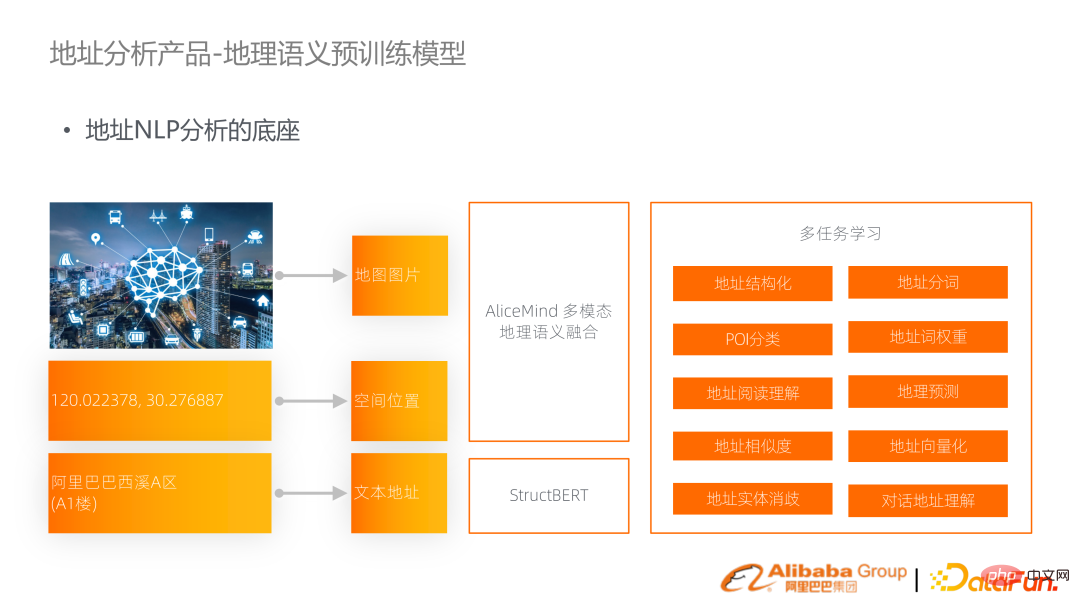

Salah satu perkara yang lebih penting dalam teknologi ini ialah model bahasa pra-latihan semantik geografi. Alamat akan diwakili sebagai rentetan dalam teks, tetapi sebenarnya ia sering diwakili sebagai longitud dan latitud dalam ruang, dan terdapat gambar yang sepadan pada peta. Oleh itu, maklumat ketiga-tiga modaliti ini disepadukan secara organik ke dalam model bahasa geo-semantik berbilang modal untuk menyokong tugasan di lokasi.

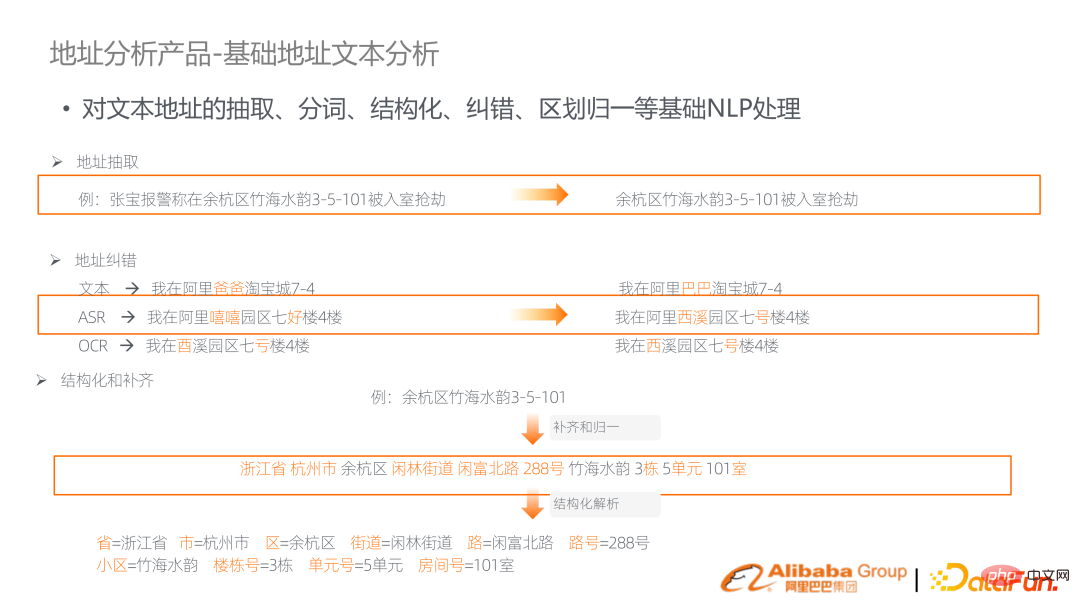

Seperti yang dinyatakan di atas, banyak keupayaan asas yang berkaitan dengan alamat diperlukan, seperti pembahagian perkataan, pembetulan ralat, analisis struktur , dsb.

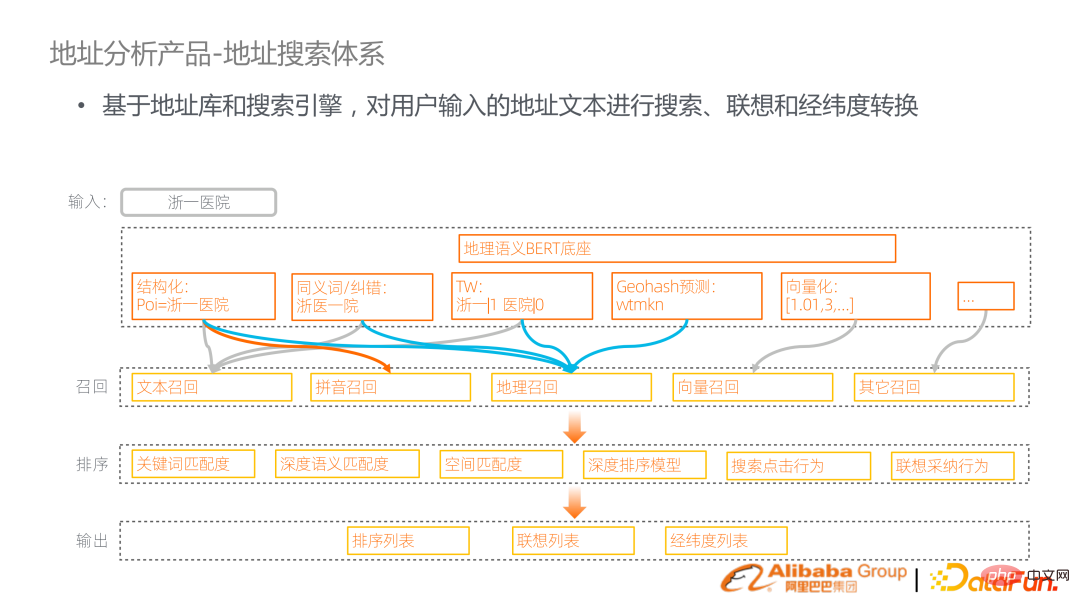

Pautan teras adalah untuk merapatkan mereka dengan merapatkan model bahasa pra-latihan geografi, menangani tugas asas dan mencetuskan enjin carian. Contohnya, jika anda mencari Hospital Zhejiang No. 1, anda boleh melakukan penstrukturan, pembetulan sinonim, pemberat istilah, vektorisasi dan ramalan Geohash padanya. Buat ingatan semula berdasarkan hasil analisis. Pautan ini ialah pautan carian standard yang melakukan panggilan semula teks, ingatan semula pinyin, ingat semula vektor, dan juga menambah ingatan geografi. Ingat kembali diikuti oleh pengisihan berbilang peringkat, termasuk gabungan ciri berbilang butiran.

Aplikasi intuitif sistem carian alamat adalah untuk mengisi alamat dan mencari dalam adegan cadangan, atau mencari dalam peta Amap, yang perlu dipetakan ke ruang Pada satu ketika.

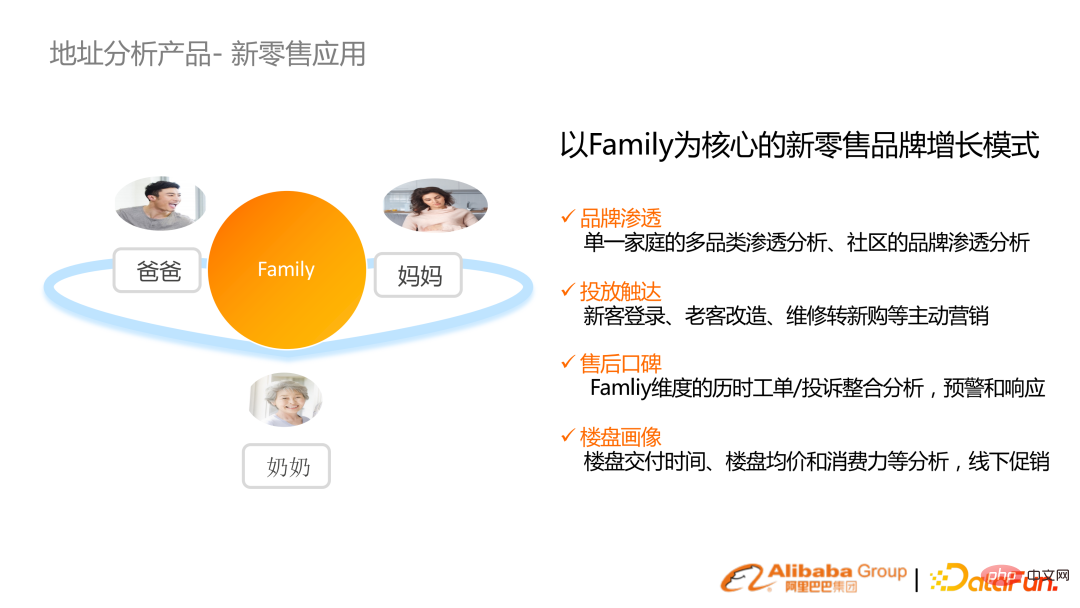

Seterusnya, kami akan memperkenalkan dua lagi penyelesaian aplikasi perindustrian. Yang pertama ialah ID Keluarga runcit baharu Keperluan teras adalah untuk mengekalkan sistem pengurusan pelanggan Walau bagaimanapun, maklumat pengguna dalam setiap sistem tidak disambungkan dan penyepaduan yang berkesan tidak dapat dicapai.

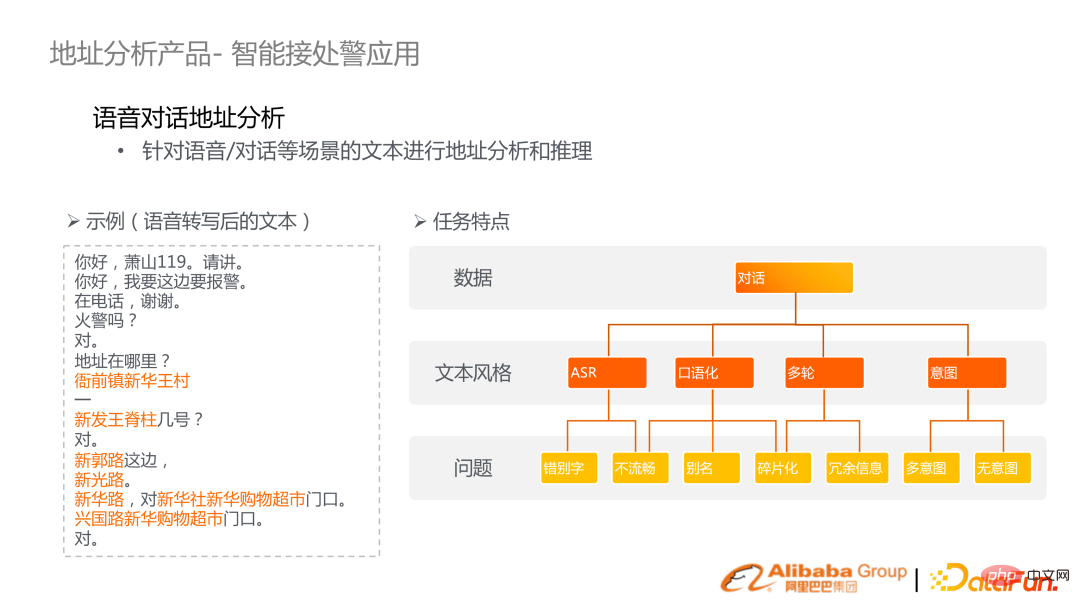

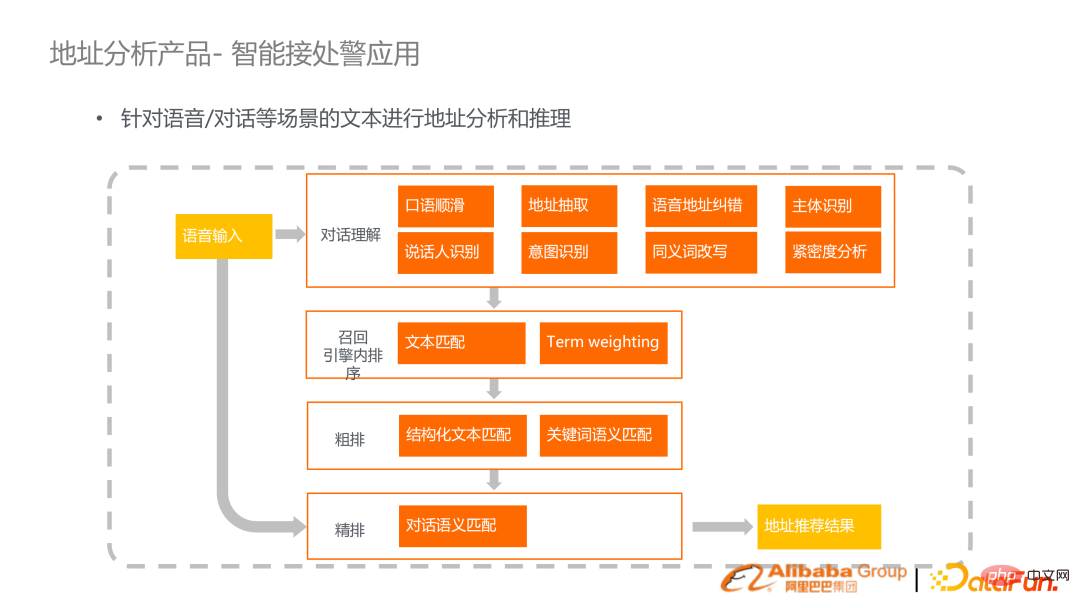

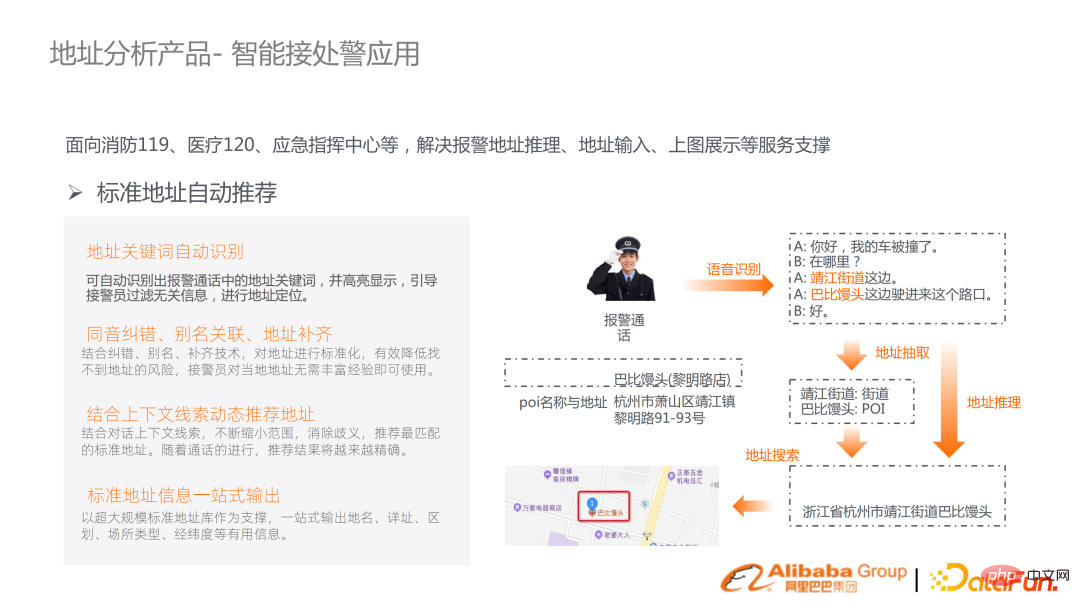

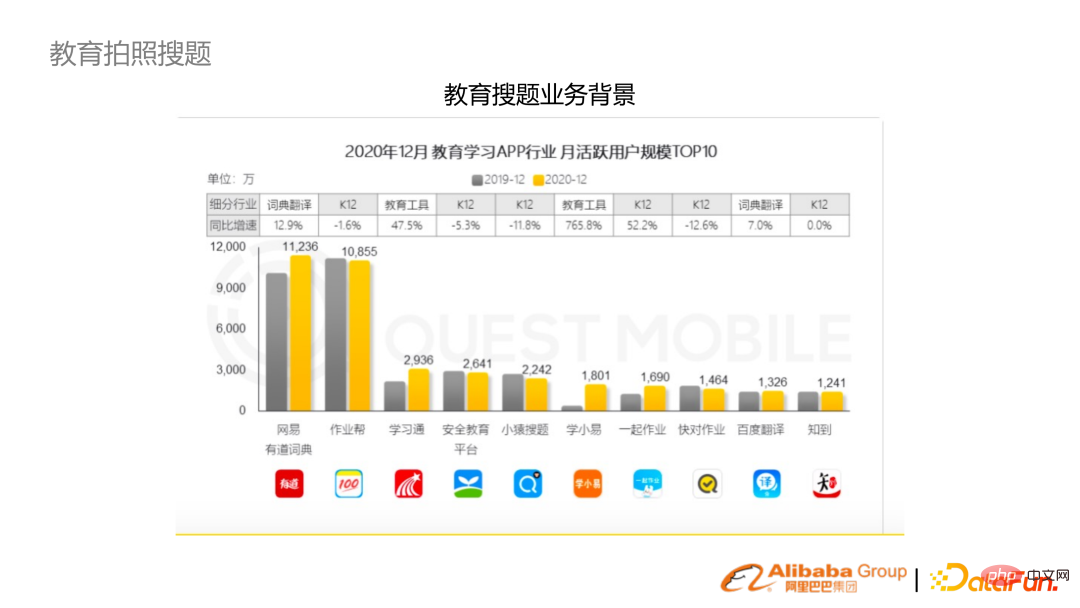

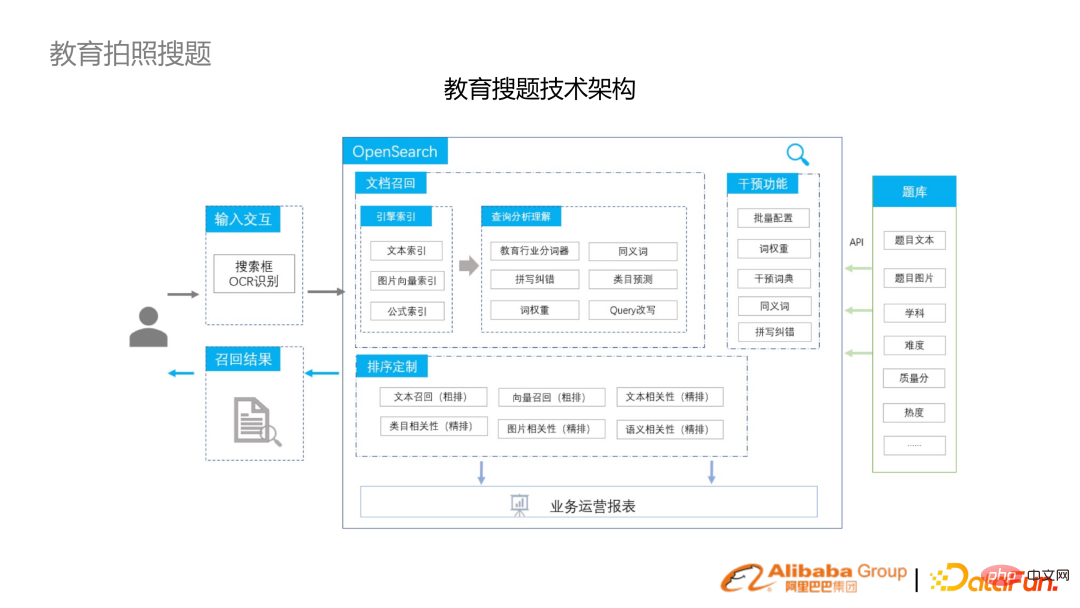

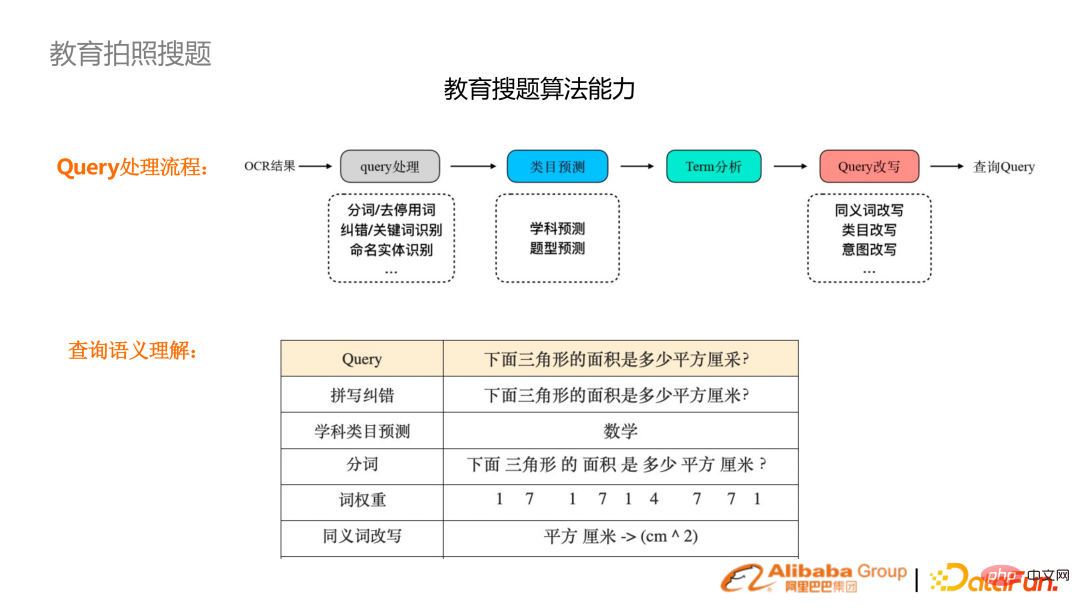

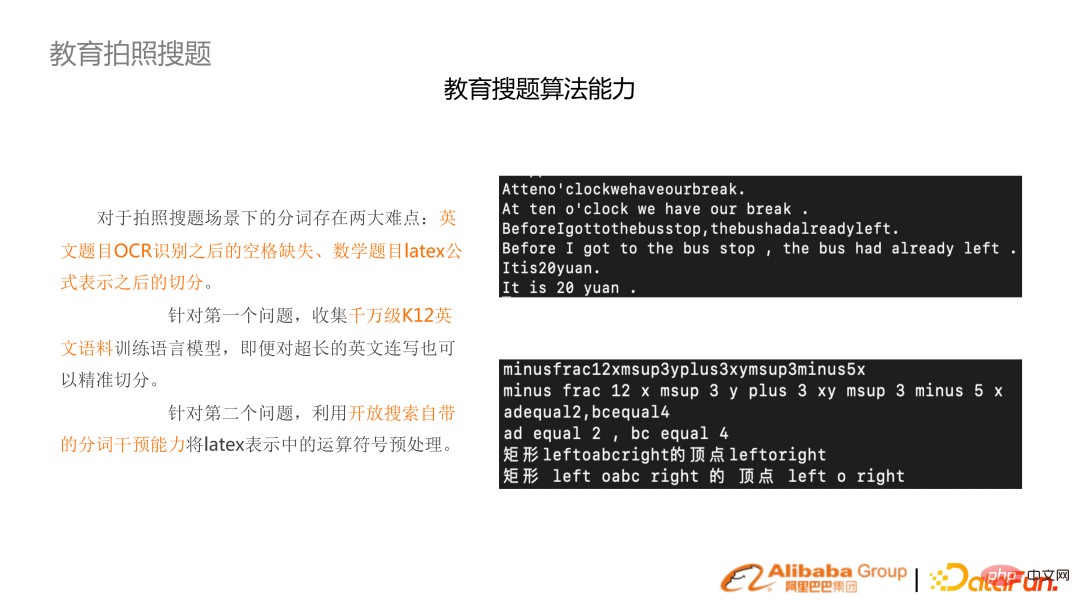

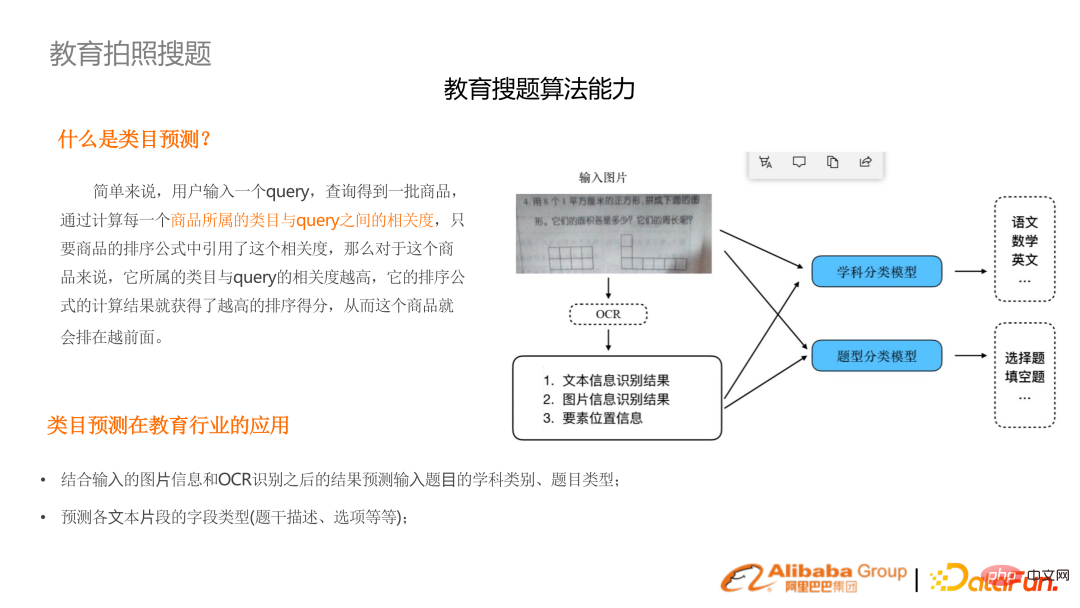

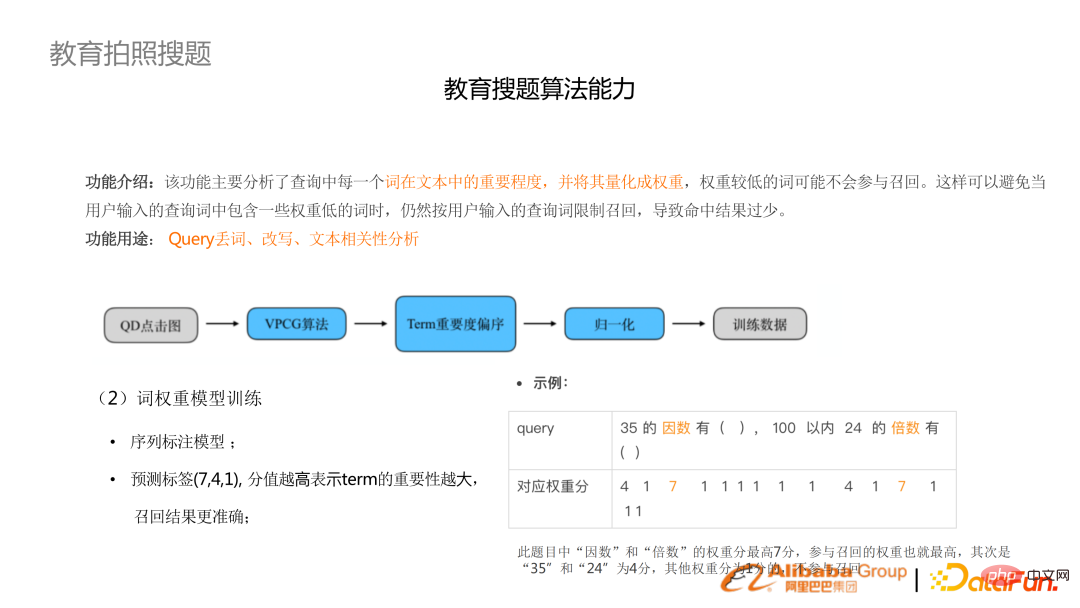

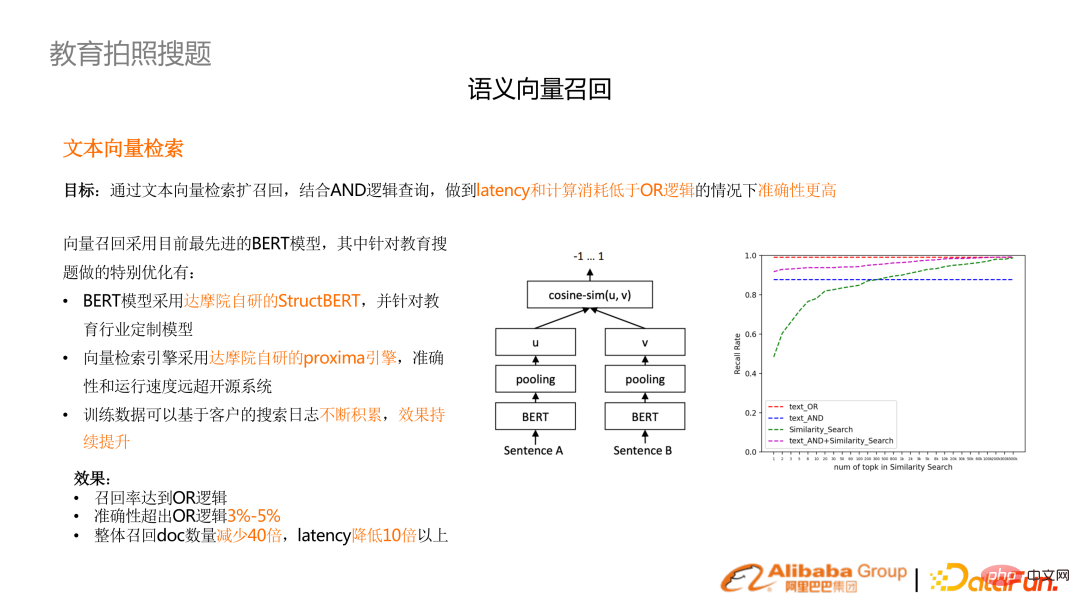

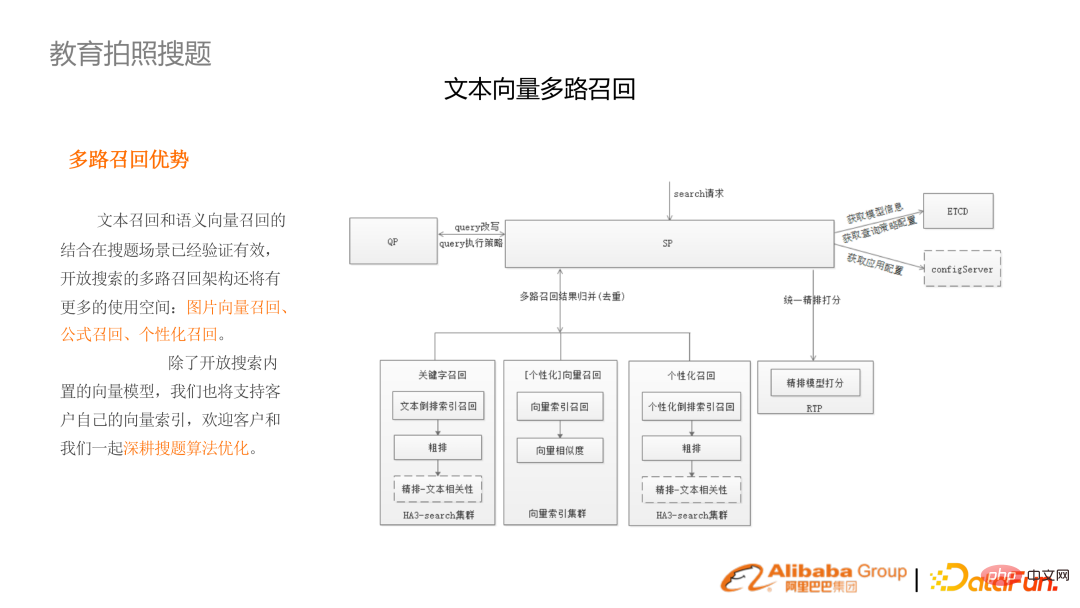

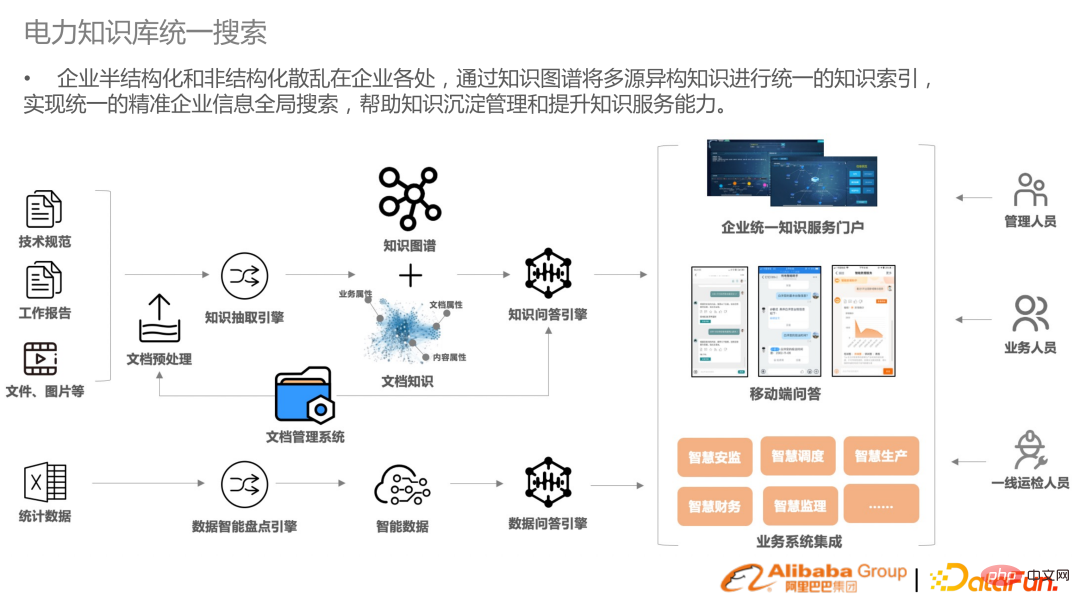

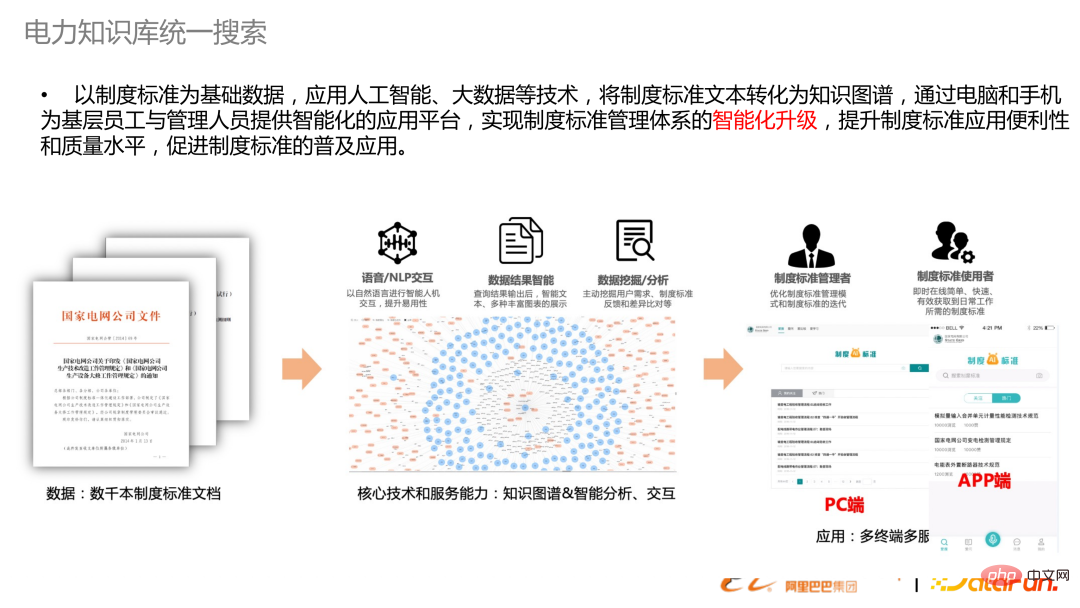

Sebagai contoh, jika pengeluar jenama menjual penghawa dingin, keluarga akan mendaftarkan pelbagai alamat dan nombor telefon mudah alih disebabkan pembelian, pemasangan dan penyelenggaraan, tetapi alamat yang sepadan sebenarnya adalah alamat yang sama . Teknologi penormalan carian alamat yang telah ditetapkan menormalkan alamat dengan perwakilan yang berbeza, menjana cap jari dan mengagregatkan ID pengguna yang berbeza ke dalam konsep Keluarga. Konsep penyatuan keluarga , boleh mencapai analisis penembusan yang lebih baik, jangkauan pengiklanan dan aktiviti pemasaran lain di bawah runcit baharu. Senario aplikasi lain ialah 119, 129, kecemasan dan aplikasi penerima penggera pintar lain. Kerana keselamatan diri dan harta benda orang ramai terlibat, setiap detik penting. Kami berharap dapat meningkatkan kecekapan ini dengan menggabungkan pengecaman pertuturan dan teknologi pemahaman semantik teks. (contoh di sebelah kiri) Adegan mempunyai banyak ciri, seperti kesilapan menaip, unfluency, colloquialism, dll. dalam Transkripsi ASR. Matlamatnya adalah untuk membuat kesimpulan lokasi penggera berdasarkan analisis transkripsi pertuturan automatik. Kami telah mencadangkan penyelesaian sistem yang lengkap, termasuk pembetulan ralat bahasa pertuturan yang lancar untuk pemahaman dialog, pengecaman niat dan satu set mekanisme carian dan penarikan balik untuk mencapai pengesyoran alamat akhirnya. Pautan itu agak matang dan telah dilaksanakan dalam sistem perlindungan kebakaran di ratusan bandar di China mengenal pasti lokasi tertentu daripada perbualan penggera, menggabungkan pengesyoran, pemadanan, dan alamat pagar untuk menentukan lokasi tertentu dan menghantar penggera dengan sewajarnya. Seterusnya, kami akan memperkenalkan industri pendidikan Perniagaan pengumpulan foto juga mempunyai banyak permintaan dalam To C dan untuk guru. Soalan carian foto mempunyai beberapa ciri ia mempunyai bank soalan yang dikemas kini secara berperingkat dan mempunyai pangkalan pengguna yang besar. Di samping itu, bidang yang sepadan dengan disiplin yang berbeza dan kumpulan umur sangat berpengetahuan. Pada masa yang sama, ia adalah algoritma berbilang modal, dengan satu set pautan daripada OCR kepada pemahaman semantik dan carian seterusnya. Dalam beberapa tahun kebelakangan ini, satu set lengkap pautan daripada algoritma ke sistem telah dibina untuk pengumpulan foto. Sebagai contoh, selepas mengambil gambar pada telefon mudah alih dan pengecaman OCR, satu siri tugasan seperti pembetulan ejaan, ramalan subjek, pembahagian perkataan dan pemberatan perkataan akan dilakukan untuk membantu mendapatkan semula. Memandangkan OCR tidak mengenali ruang dalam bahasa Inggeris, satu set model algoritma pra-latihan Bahasa Inggeris K12 telah dilatih untuk melakukan Slice Bahasa Inggeris. Pada masa yang sama, subjek dan jenis soalan tidak diketahui dan perlu diramalkan terlebih dahulu. Gunakan multimodaliti untuk menggabungkan imej dan teks untuk pemahaman niat. Soalan carian foto berbeza daripada carian pengguna biasa Carian pengguna selalunya mempunyai pertanyaan yang lebih pendek, manakala soalan carian foto Ia adalah selalunya soalan yang lengkap. Banyak perkataan dalam soalan adalah tidak penting, dan perlu melakukan analisis berat perkataan, membuang perkataan yang tidak penting atau menyusunnya untuk menurunkan tarafnya. Kesan pengoptimuman yang paling jelas dalam senario carian foto ialah penarikan semula vektor. Keperluan prestasi menyukarkan penggunaan mekanisme penarikan balik OR, dan perlu menggunakan logik DAN Ciri yang sepadan ialah terdapat sedikit penarikan balik. Untuk meningkatkan ingatan semula, anda perlu melakukan lebih banyak modul berlebihan seperti pemberat istilah dan pembetulan ralat. (Gambar kanan) Kesan ingat berbilang saluran melalui teks tambah vektor melebihi logik OR tulen dan kependaman dikurangkan sebanyak 10 kali ganda. Pautan carian foto termasuk penarikan semula vektor imej, penarikan semula formula dan ingatan diperibadikan. Berikan dua contoh. Yang pertama ialah hasil OCR teks biasa (Lajur kiri) Hasil lama adalah berdasarkan ES, ringkas ATAU ingat, ditambah dengan hasil BM25 (Lajur kanan) Pautan selepas ingatan berbilang saluran dan ingatan korelasi telah banyak bertambah baik. Yang kedua ialah mengambil gambar yang mengandungi grafik, yang mesti digabungkan dengan penarikan semula gambar dalam berbilang saluran. Terdapat banyak data separa berstruktur dan tidak berstruktur dalam carian perusahaan, menyediakan carian bersatu untuk membantu perusahaan menyepadukan sumber data. Bukan sahaja dalam tenaga elektrik, industri lain juga mempunyai keperluan yang sama. Carian di sini bukan lagi carian sempit, tetapi juga termasuk AI dokumen pra-pemprosesan dan pembinaan graf pengetahuan, serta keupayaan untuk merapatkan Soal Jawab. Di atas ialah gambarajah skematik untuk mencipta satu set teks standard institusi dalam pangkalan pengetahuan kuasa elektrik, daripada penstrukturan kepada mendapatkan semula kepada aplikasi.

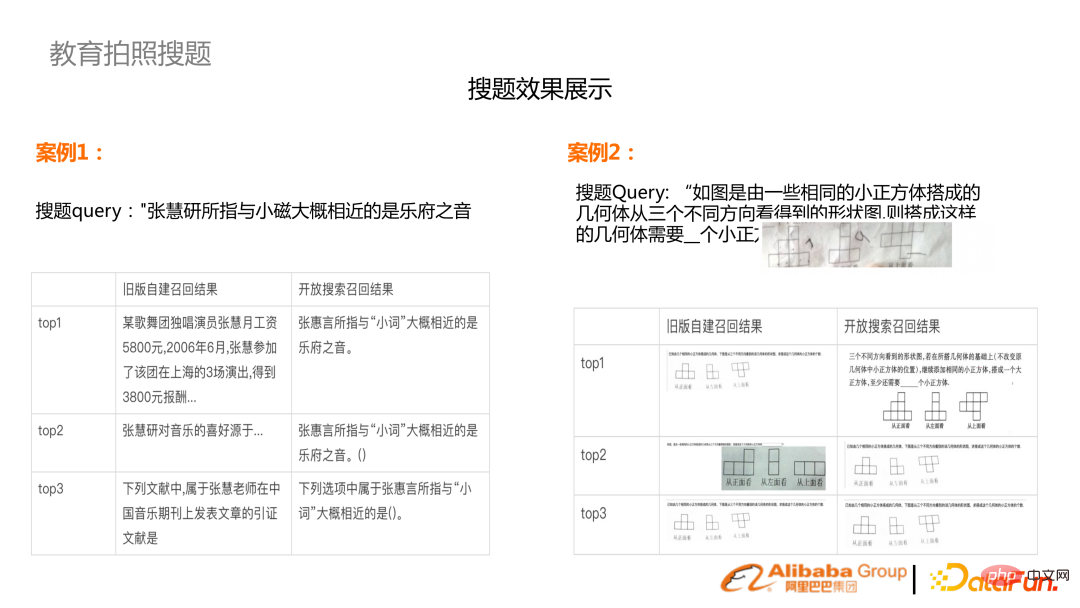

2 soalan carian foto Pendidikan

3. Pencarian bersatu asas pengetahuan kuasa

Atas ialah kandungan terperinci Aplikasi dan penyelidikan carian industri berdasarkan model bahasa pra-terlatih. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI