Rumah >Peranti teknologi >AI >AIGC berkembang terlalu pantas! Meta mengeluarkan pensintesis video 4D berasaskan teks pertama: Adakah pemodel permainan 3D juga akan diberhentikan?

AIGC berkembang terlalu pantas! Meta mengeluarkan pensintesis video 4D berasaskan teks pertama: Adakah pemodel permainan 3D juga akan diberhentikan?

- 王林ke hadapan

- 2023-04-08 11:21:15897semak imbas

Model generatif AI telah mencapai kemajuan besar dalam tempoh yang lalu Setakat medan imej , pengguna boleh menjana imej dengan memasukkan gesaan bahasa semula jadi (seperti DALL-E 2, Stable Diffusion). , ia juga boleh dilanjutkan dalam dimensi masa untuk menjana video berterusan (seperti Phenaki), atau dalam dimensi spatial untuk terus menjana model 3D (seperti Dreamfusion).

Tetapi setakat ini, tugasan ini masih dalam keadaan penyelidikan terpencil, dan tiada persimpangan teknikal antara satu sama lain.

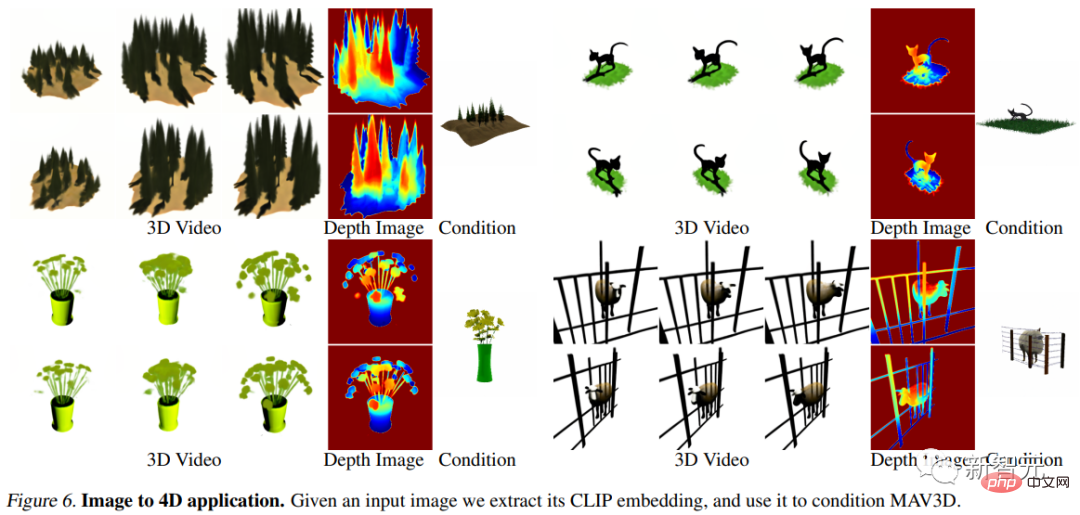

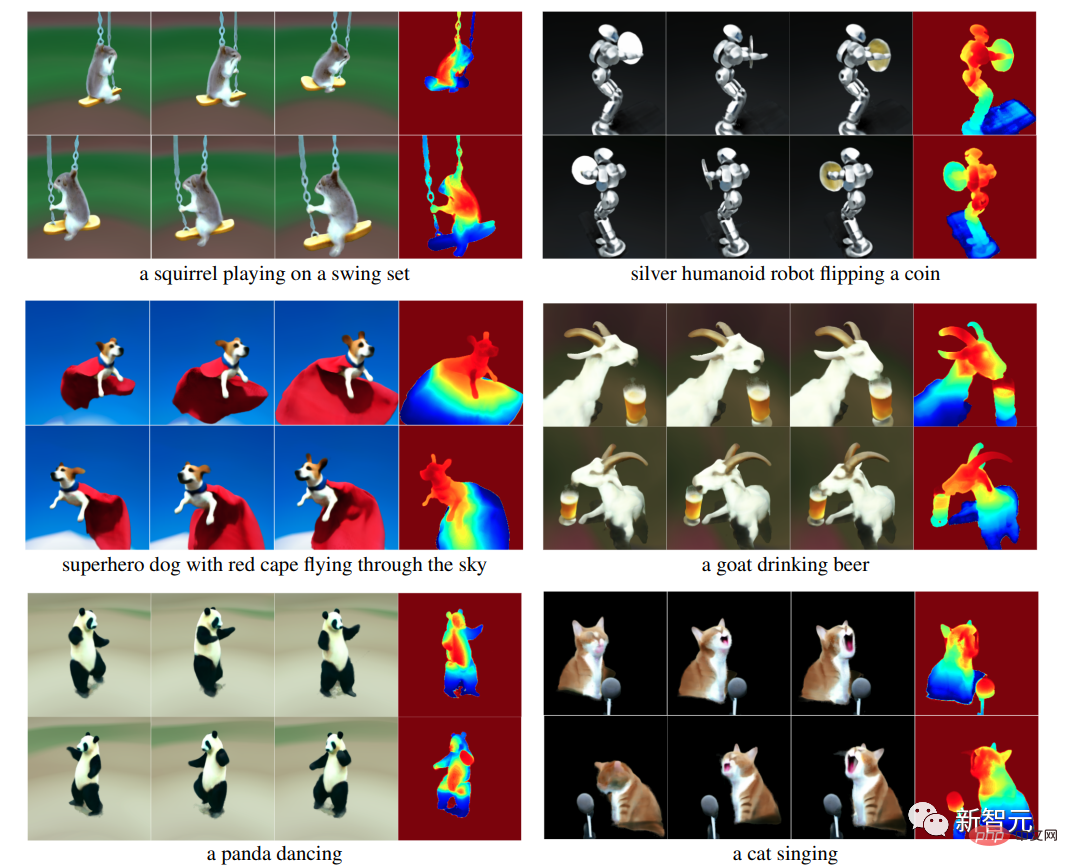

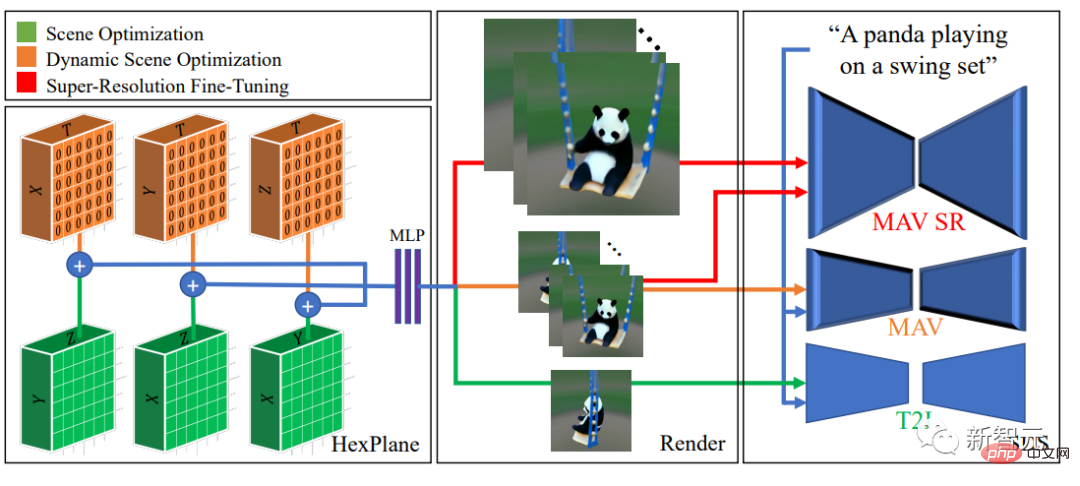

Baru-baru ini, penyelidik Meta AI menggabungkan kelebihan video dan model generasi 3D dan mencadangkan teks serba baharu kepada sistem penjanaan empat dimensi (3D + masa) MAV3D (MakeA- Video3D) , mengambil penerangan bahasa semula jadi sebagai input dan mengeluarkan perwakilan pemandangan tiga dimensi dinamik yang boleh dipaparkan dari sebarang perspektif.

Pautan kertas: https://arxiv.org/abs/2301.11280

Pautan projek: https://make-a-video3d.github.io/

MAV3D juga yang pertama tersedia Menghasilkan model pemandangan dinamik tiga dimensi berdasarkan penerangan teks yang diberikan.

Kaedah yang dicadangkan menggunakan medan sinaran saraf dinamik (NeRF) 4D untuk mengoptimumkan perwakilan pemandangan, ketumpatan dan ketekalan gerakan dengan menanyakan model berasaskan resapan teks-ke-video (T2V), output video dinamik yang dijana daripada teks yang disediakan boleh dilihat dari sebarang kedudukan dan sudut kamera, dan digubah ke dalam persekitaran 3D yang sewenang-wenangnya.

Kaedah ini boleh digunakan untuk menjana aset 3D untuk permainan video, kesan visual atau realiti tambahan dan maya.

Berbeza daripada tugas penjanaan imej dan penjanaan video, terdapat sejumlah besar data kapsyen tersedia untuk latihan di Internet, tetapi tidak ada satu Tiada koleksi model 4D siap.

Corgi bermain bola

MAV3D's latihan Tidak memerlukan sebarang data 3D atau 4D, model T2V hanya perlu dilatih pada pasangan imej teks dan video tidak berlabel.

Dalam bahagian percubaan, para penyelidik menjalankan eksperimen kuantitatif dan kualitatif yang komprehensif untuk membuktikan keberkesanan kaedah, yang meningkatkan dengan ketara garis dasar dalaman yang telah ditetapkan sebelum ini.

Teks ke adegan dinamik 4D

Disebabkan kekurangan data latihan, penyelidik telah memikirkan beberapa idea untuk menyelesaikan tugasan ini.

Satu pendekatan mungkin ialah mencari penjana video 2D yang telah terlatih dan mengekstrak pembinaan semula 4D daripada video yang dijana. Walau bagaimanapun, membina semula bentuk objek boleh ubah bentuk daripada video masih merupakan masalah yang sangat mencabar, iaitu Struktur Tidak Tegar daripada Gerakan (NRSfM) .

Tugas menjadi mudah jika anda diberi berbilang sudut pandang serentak sesuatu objek. Walaupun persediaan berbilang kamera jarang berlaku dalam data dunia sebenar, para penyelidik percaya bahawa penjana video sedia ada secara tersirat menjana model sudut pandang sewenang-wenangnya tempat kejadian.

Iaitu, penjana video boleh digunakan sebagai persediaan berbilang kamera "statistik" untuk membina semula geometri dan fotometri objek boleh ubah bentuk.

Algoritma MAV3D mencapai matlamat ini dengan mengoptimumkan Medan Sinaran Neural (NeRF) dinamik dan menyahkod teks input ke dalam video, mensampel sudut pandangan rawak di sekeliling objek.

Secara langsung menggunakan penjana video untuk mengoptimumkan NeRF dinamik tidak mencapai hasil yang memuaskan Masih terdapat beberapa masalah yang perlu diatasi semasa proses pelaksanaan:

1. Perwakilan adegan 3D dinamik yang boleh dipelajari dari hujung ke hujung diperlukan

2 set data berskala besar pasangan (teks, 4D) tersedia untuk pembelajaran; memerlukan sejumlah besar memori dan kuasa Pengkomputeran;

Model MAV3DModel MAV3D adalah berdasarkan kerja terkini pada medan sinaran saraf (NeRF), menggabungkan hasil dalam kecekapan (statik) NeRF dan NeRF dinamik, Dan mewakili pemandangan 4D sebagai satu set enam satah ciri berbilang resolusi.

Untuk menyelia perwakilan ini tanpa data (teks, 4D) yang sepadan, para penyelidik mencadangkan saluran latihan berbilang peringkat untuk pemaparan adegan dinamik dan menunjukkan bahawa setiap kepentingan setiap komponen dalam mencapai tahap tinggi. hasil yang berkualiti.

Pemerhatian utama ialah menggunakan model Teks-ke-Video (T2V), Pensampelan Penyulingan Skor (SDS) digunakan untuk mengoptimumkan secara langsung dinamik Senario boleh membawa kepada artifak visual dan penumpuan suboptimum.

Jadi penyelidik memilih untuk menggunakan model teks-ke-imej (T2I) dahulu untuk memadankan pemandangan 3D statik dengan gesaan teks, dan kemudian mempertingkatkan model pemandangan 3D secara dinamik.

Selain itu, istilah penetapan pergerakan dan kehilangan SDS sedar temporal baharu diperkenalkan dalam model, yang terbukti secara eksperimen sebagai kritikal untuk gerakan yang realistik dan mencabar.

dan diskalakan kepada output peleraian yang lebih tinggi melalui peringkat penalaan halus resolusi super sedar temporal tambahan.

Akhir sekali, gunakan SDS modul resolusi super model T2V untuk mendapatkan maklumat kecerunan resolusi tinggi untuk pembelajaran diselia model adegan 3D, meningkatkan kesetiaan visualnya dan membolehkan inferens Output resolusi yang lebih tinggi diambil sampel semasa proses.

Bahagian eksperimenMetrik penilaian

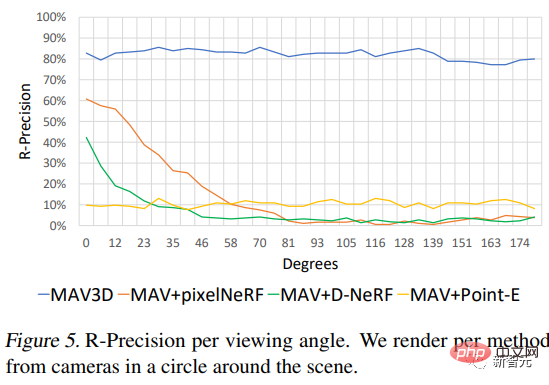

Gunakan CLIP R-Precision untuk menilai video yang dihasilkan , boleh digunakan untuk mengukur ketekalan antara teks dan adegan yang dijana, dan boleh mencerminkan ketepatan mendapatkan semula isyarat input daripada bingkai yang diberikan. Para penyelidik menggunakan varian ViT-B/32 CLIP dan bingkai yang diekstrak dalam pandangan dan langkah masa yang berbeza.

Di samping itu, empat metrik kualitatif digunakan, yang boleh diperolehi dengan meminta annotator manusia untuk keutamaan mereka di antara dua video yang dihasilkan. ii) kesetiaan kepada isyarat teks; (iii) jumlah pergerakan; dan (iv) keaslian pergerakan .

Perbandingan teks-ke-4D

Memandangkan tiada kaedah untuk menukar teks kepada 4D sebelum , jadi penyelidik menubuhkan tiga garis dasar berdasarkan kaedah penjanaan T2V untuk perbandingan. Urutan bingkai dua dimensi akan ditukar kepada urutan perwakilan adegan tiga dimensi menggunakan tiga kaedah berbeza.

Jujukan pertama diperolehi oleh pemapar adegan neural satu pukulan (Point-E); dengan kedudukan kamera diekstrak menggunakan COLMAP.

Ia boleh dilihat bahawa kaedah tersebut melebihi model garis dasar pada metrik ketepatan R objektif dan dinilai lebih tinggi oleh anotasi manusia pada semua metrik.

Selain itu, penyelidik juga meneroka prestasi kaedah di bawah sudut kamera yang berbeza.

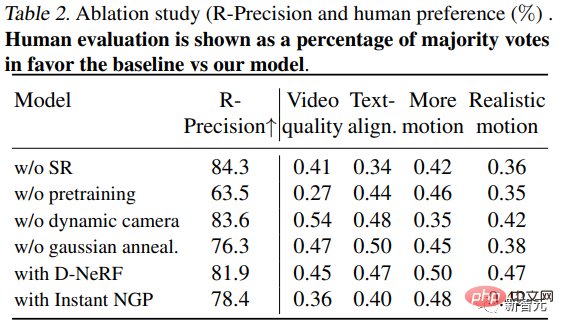

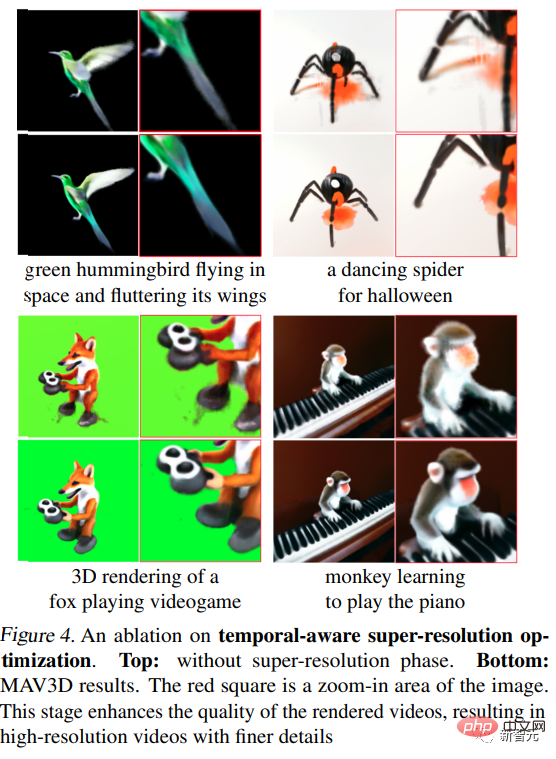

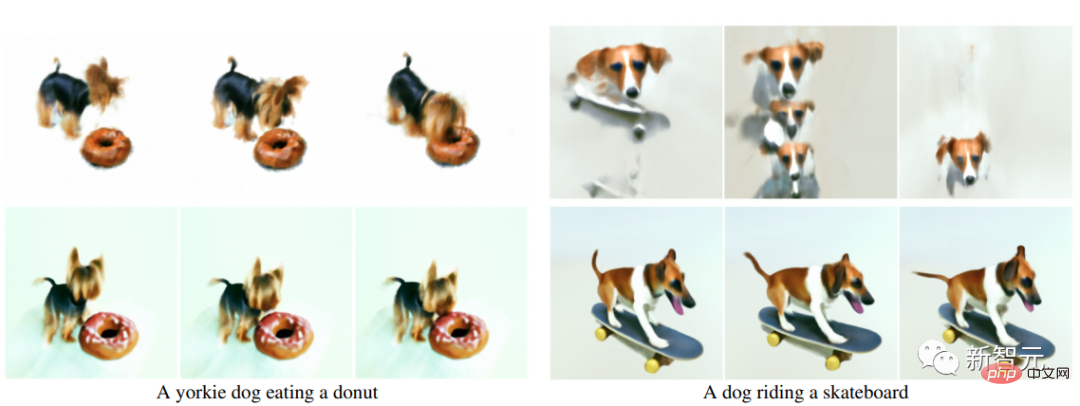

Percubaan Ablasi

1 Apabila model yang dilatih dengan penalaan halus resolusi (SR) mempunyai bilangan langkah yang sama seperti MAV3D (peringkat 3), anotasi manusia lebih cenderung untuk memilih model yang dilatih dengan SR dari segi kualiti, penjajaran teks dan gerakan .

Selain itu, penalaan halus resolusi super meningkatkan kualiti video yang dipaparkan, membuat video beresolusi tinggi dengan butiran yang lebih halus dan kurang hingar.

2 Tiada pra-latihan : Langkah-langkah untuk mengoptimumkan adegan dinamik secara langsung (tanpa latihan pra-latihan statik) ialah. sama seperti MAV3D Dalam kes, hasilnya adalah kualiti pemandangan yang jauh lebih rendah atau penumpuan yang lemah: dalam 73% dan 65% kes, model yang dilatih dengan statik lebih diutamakan dari segi kualiti video dan gerakan realistik.

Atas ialah kandungan terperinci AIGC berkembang terlalu pantas! Meta mengeluarkan pensintesis video 4D berasaskan teks pertama: Adakah pemodel permainan 3D juga akan diberhentikan?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI