Rumah >Peranti teknologi >AI >CV membuka era model besar! Google mengeluarkan ViT terbesar dalam sejarah: 22 bilion parameter, persepsi visual hampir dengan manusia

CV membuka era model besar! Google mengeluarkan ViT terbesar dalam sejarah: 22 bilion parameter, persepsi visual hampir dengan manusia

- 王林ke hadapan

- 2023-04-07 15:09:081461semak imbas

Transformer sudah pasti penyumbang terbesar kepada kemakmuran bidang pemprosesan bahasa semula jadi, dan juga merupakan infrastruktur model bahasa berskala besar seperti GPT-4.

Walau bagaimanapun, berbanding dengan berpuluh bilion parameter model bahasa, bidang penglihatan komputer tidak mendapat banyak manfaat Transformer Pada masa ini, model Transformer visual terbesar ViT-. e Bilangan parameter hanya 4 bilion parameter.

Baru-baru ini, Google mengeluarkan kertas kerja di mana penyelidik mencadangkan kaedah yang cekap dan stabil melatih model Vision Transformers (ViT) berskala besar, berjaya meningkatkan bilangan parameter ViT kepada 22 bilion.

Pautan kertas: https://arxiv.org/abs/2302.05442

Untuk mencapai pengembangan model, ViT-22B menggabungkan idea daripada model bahasa lain (seperti model PaLM), menggunakan normalisasi QK untuk meningkatkan kestabilan latihan dan mencadangkan Kaedah baharu operasi linear selari tak segerak meningkatkan kecekapan latihan dan boleh dilatih pada Cloud TPU dengan kecekapan perkakasan yang lebih tinggi.

Apabila menjalankan eksperimen pada model ViT-22B untuk menilai prestasi tugas hiliran, ViT-22B juga menunjukkan keupayaan yang serupa dengan model bahasa berskala besar, iaitu, apabila skala model meningkat, prestasi Ia juga sentiasa bertambah baik.

ViT-22B juga boleh digunakan dalam PaLM-e Model besar yang digabungkan dengan model bahasa boleh meningkatkan tahap teknikal tugasan robot dengan ketara.

Para penyelidik juga memerhatikan lagi kelebihan lain yang dibawa mengikut skala, termasuk keseimbangan yang lebih baik antara keadilan dan prestasi, selaras dengan persepsi visual manusia dari segi bias bentuk/tekstur , dan keteguhan yang lebih baik.

Seni bina model

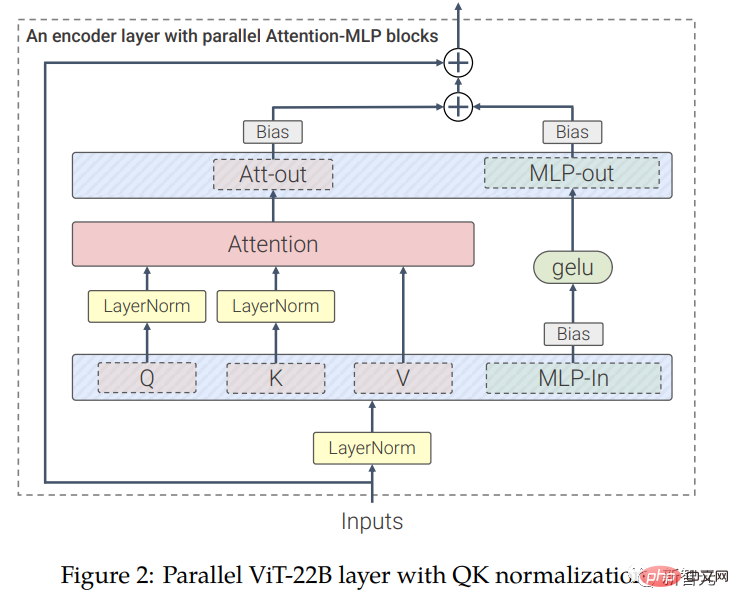

ViT-22B ialah model berdasarkan seni bina Transformer Berbanding dengan seni bina ViT asal, para penyelidik telah membuat tiga pengubahsuaian utama untuk meningkatkan kecekapan latihan. dan kestabilan latihan.

Lapisan selari

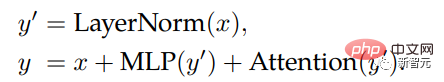

ViT-22B melaksanakan blok perhatian dan blok MLP secara selari, manakala Transformer asal dilaksanakan secara berurutan.

Latihan model PaLM juga menggunakan kaedah ini, yang boleh meningkatkan kelajuan latihan model besar sebanyak 15% tanpa penurunan prestasi.

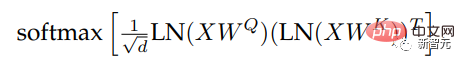

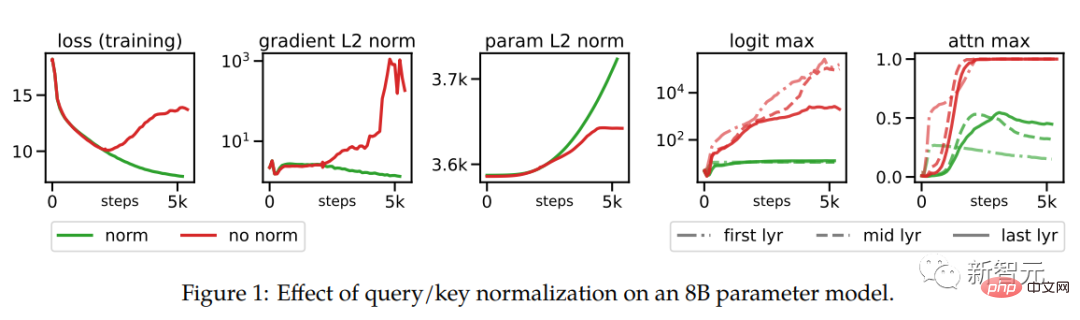

penormalan pertanyaan/kunci (QK)

Dalam proses mengembangkan ViT, penyelidik menggunakan 8 bilion parameter It telah diperhatikan dalam sejumlah besar model bahawa kehilangan latihan mula menyimpang selepas beberapa ribu langkah latihan, terutamanya disebabkan oleh ketidakstabilan yang disebabkan oleh nilai log perhatian yang terlalu besar, mengakibatkan pemberat perhatian sifar-entropi ( hampir satu-panas).

Untuk menyelesaikan masalah ini, penyelidik menggunakan LayerNorm untuk Query dan Key sebelum pengiraan perhatian pendaraban titik

Hasil percubaan pada model parameter 8 bilion ditunjukkan dalam rajah di bawah.

Alih keluar istilah offset pada unjuran QKV dan LayerNorms

Seperti model PaLM, ViT-22B mengalih keluar istilah bias daripada unjuran QKV, dan tiada istilah berat sebelah (bias) dan pemusatan dalam semua LayerNorms, meningkatkan penggunaan perkakasan sebanyak 3% , dan tiada kerugian dalam kualiti.

Walau bagaimanapun, tidak seperti PaLM, ViT-22B menggunakan istilah bias untuk (dalaman dan luaran) lapisan bersambung padat MLP, yang boleh diperhatikan Kualiti mempunyai bertambah baik, dan kelajuan tidak berkurangan.

Dalam modul pengekod ViT-22B, lapisan benam, termasuk tampalan pengekstrakan, unjuran linear dan benam kedudukan tambahan adalah sama seperti yang digunakan dalam ViT asal, dan pengumpulan perhatian berbilang kepala digunakan untuk mengagregat maklumat dalam setiap perwakilan per-token kepala.

Saiz tampalan ViT-22B ialah 14×14, dan resolusi imej ialah 224×224 (diproses terlebih dahulu oleh pemangkasan permulaan dan flip mendatar rawak).

operasi linear selari tak segerak

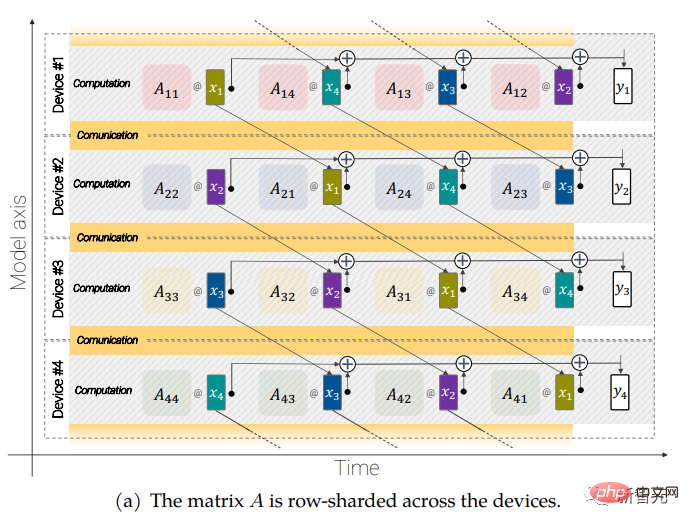

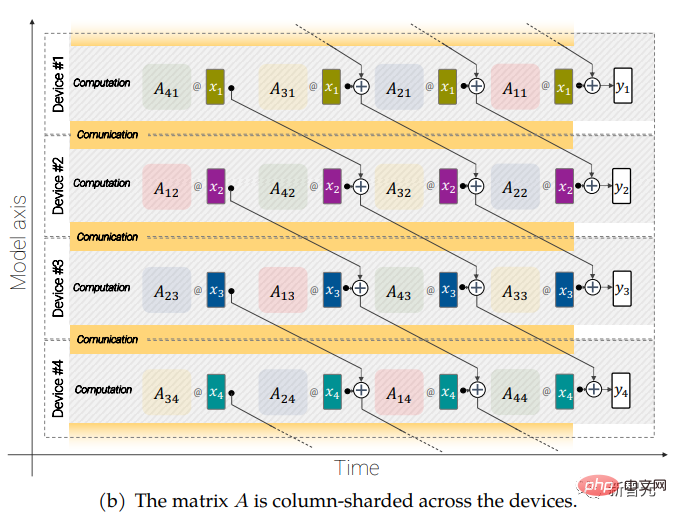

Model berskala besar juga memerlukan sharding ), iaitu mengedarkan parameter model merentasi peranti pengkomputeran yang berbeza Di samping itu, penyelidik juga mengaktifkan pengaktifan (aktivasi, perwakilan perantaraan input).

Oleh kerana kedua-dua input dan matriks itu sendiri diedarkan merentasi pelbagai peranti, malah operasi mudah seperti pendaraban matriks memerlukan penjagaan khas.

Para penyelidik membangunkan kaedah yang dipanggil operasi linear selari tak segerak yang boleh dilakukan secara serentak semasa mengira dalam unit pendaraban matriks (unit yang menyumbang sebahagian besar kuasa pengkomputeran dalam TPU) . Komunikasikan pengaktifan dan pemberat antara peranti.

Kaedah tak segerak meminimumkan masa menunggu komunikasi masuk, dengan itu meningkatkan kecekapan peranti.

Matlamat operasi linear selari tak segerak adalah untuk mengira pendaraban matriks y = Ax, tetapi matriks A dan pengaktifan x kedua-duanya diedarkan pada peranti yang berbeza dan memerlukan komunikasi dan pengiraan bertindih merentas peranti. mencapai ini. Matriks A dibelah lajur merentas peranti Setiap matriks mengandungi kepingan bersebelahan, dengan setiap blok diwakili sebagai Aij Lihat kertas asal untuk mendapatkan butiran lanjut.

Hasil eksperimen

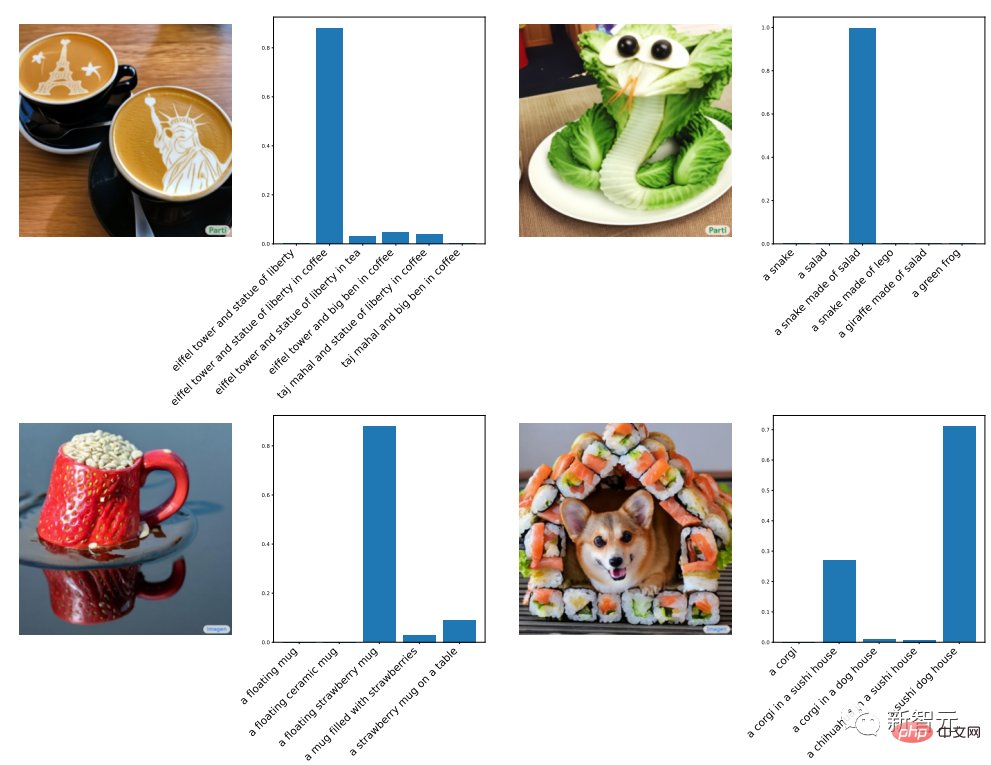

Untuk menggambarkan bahawa perwakilan yang dipelajari oleh ViT-22B sangat kaya, para penyelidik menggunakan penalaan LiT untuk melatih teks Model digunakan untuk menjana perwakilan untuk menjajarkan teks dan imej.

Berikut ialah hasil percubaan yang diperoleh menggunakan imej luar pengedaran yang dijana oleh Parti dan Imagen Anda boleh melihat keupayaan generalisasi klasifikasi imej sifar bagi ViT-22B Ia sangat berkuasa dan boleh mengecam objek dan pemandangan ghaib hanya daripada imej semula jadi yang dirangkak dari web.

Kertas kerja ini juga membincangkan kesan ViT-22B pada klasifikasi video, anggaran kedalaman dan tugasan pembahagian semantik.

Sejajar dengan pengecaman sasaran manusia

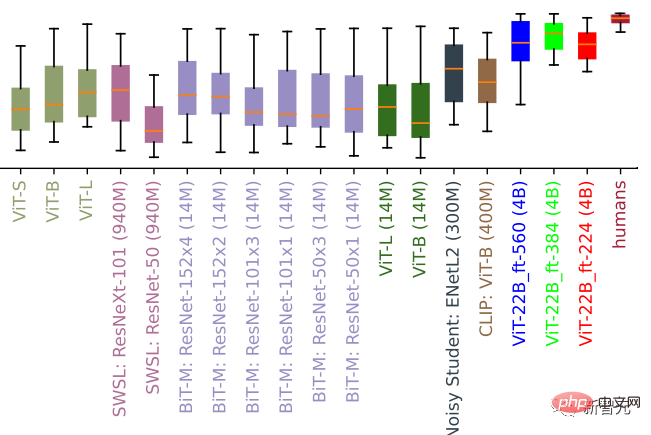

Untuk mengesahkan ketekalan keputusan pengelasan ViT-22B dengan keputusan pengelasan manusia, para penyelidik memperhalusi ViT-22B dan menukar pengedaran Ia diperhalusi pada resolusi berbeza set data OOD, di mana data perbandingan manusia tersedia melalui kotak alat model-vs-manusia.

Kotak alat ini terutamanya mengukur tiga penunjuk utama: Bagaimanakah model mengendalikan herotan (ketepatan)? Apakah perbezaan antara ketepatan manusia dan model (perbezaan dalam ketepatan)? Sejauh manakah persamaan corak ralat (konsistensi ralat) orang dan model?

Penilaian sisihan bentuk (nilai yang lebih besar mewakili lebih banyak sisihan bentuk). Banyak model penglihatan mempunyai bias bentuk rendah/tekstur tinggi, dan ViT-22B, diperhalusi pada ImageNet, mempunyai bias bentuk tertinggi yang direkodkan antara model ML setakat ini, lebih hampir kepada bias bentuk manusia

Hasil eksperimen menunjukkan bahawa walaupun tidak semua penyelesaian yang diperhalusi berprestasi baik, varian ViT-22B mencapai tahap tertinggi baharu pada ketiga-tiga metrik.

Selain itu, model ViT-22B juga mempunyai sisihan bentuk tertinggi yang direkodkan dalam kalangan model visual. Ini bermakna bahawa mereka terutamanya menggunakan bentuk objek dan bukannya tekstur objek untuk membuat keputusan klasifikasi, dan keputusan strategi adalah serupa dengan persepsi manusia (bias bentuknya ialah 96%).

Model standard (cth., ResNet-50 dengan 20-30% bias bentuk) lazimnya mengelaskan berdasarkan tekstur, manakala model dengan berat sebelah bentuk tinggi cenderung memfokus pada bentuk (dikenal pasti di bawah) ( untuk kucing), ViT-22B menunjukkan lebih banyak persamaan dengan pengecaman objek visual manusia, walaupun masih terdapat banyak perbezaan antara persepsi manusia dan model.

Kucing atau gajah? Kereta atau jam? Burung atau basikal? Imej dengan bentuk satu objek dan tekstur objek lain yang berbeza boleh digunakan untuk mengukur sisihan bentuk/teks

prestasi luar pengedaran

Mengukur prestasi pada set data OOD membantu menilai generalisasi model.

Dalam percubaan ini, penyelidik membina pemetaan label daripada JFT ke ImageNet dan daripada ImageNet kepada set data luar pengedaran yang berbeza seperti ObjectNet.

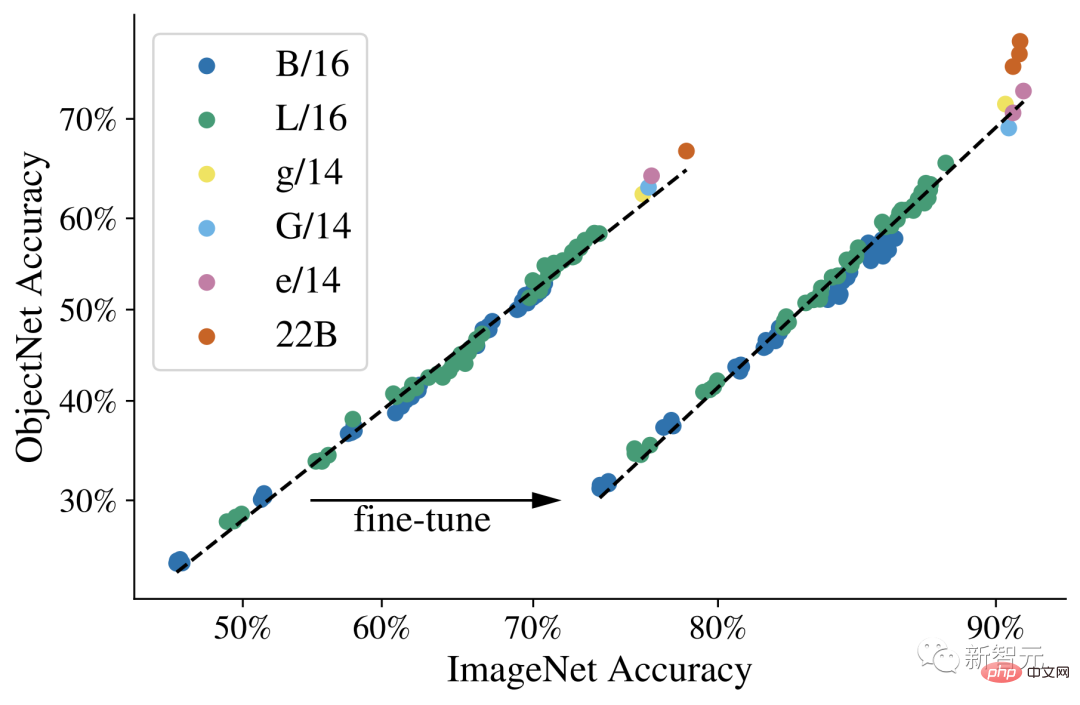

Keputusan selepas pra-latihan pada data ini ditunjukkan di bawah, dan kemudian model diperhalusi sepenuhnya pada ImageNet.

Dapat diperhatikan bahawa penskalaan Vision Transformers boleh meningkatkan prestasi OOD: walaupun ketepatan ImageNet mencapai ketepuan, ia dapat dilihat bahawa perubahan daripada ViT-e pada ObjectNet Model ViT-22B boleh meningkatkan prestasi dengan ketara.

Probe Linear

Probe Linear ialah teknik yang meletakkan satu lapisan linear di atas model beku Berbanding dengan penalaan halus penuh, kaedah ini mempunyai Ia lebih murah untuk melatih dan lebih mudah untuk disediakan.

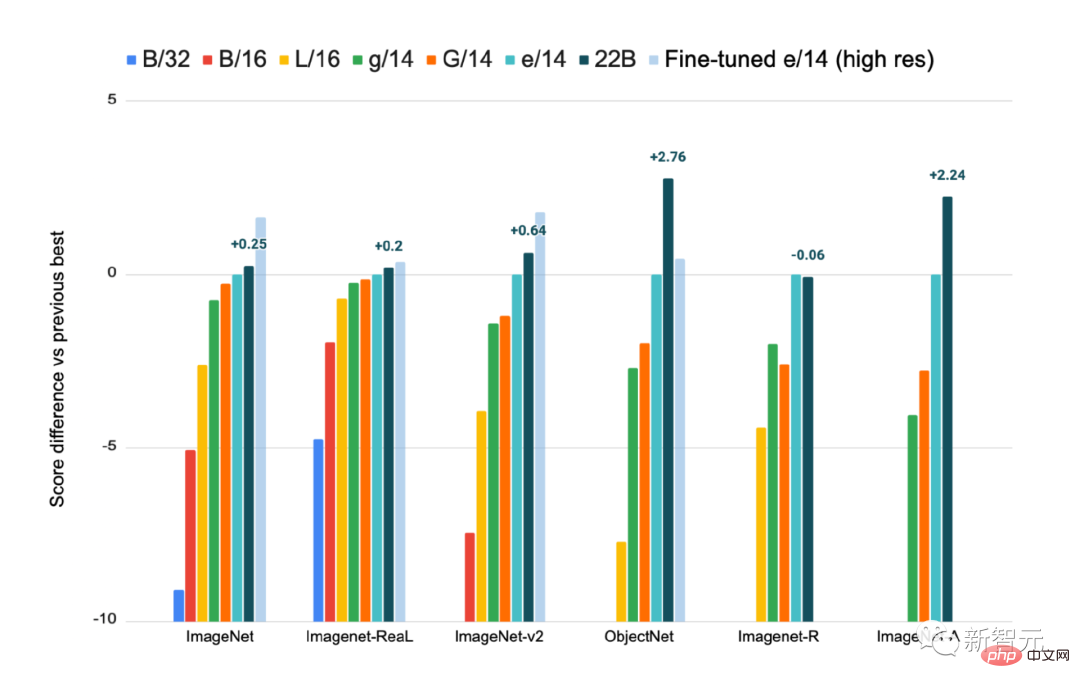

Hasil pengesanan linear yang dilatih pada ImageNet, pada ImageNet-Real, ImageNet-v2, ObjectNet, ImageNet-R dan ImageNet- Evaluation pada set data A, menyediakan ViT-e/14 diperhalusi resolusi tinggi sebagai rujukan

Dapat diperhatikan daripada keputusan bahawa prestasi pengesanan linear ViT-22B adalah hampir sama dengan menggunakan penalaan halus terkini bagi model yang lebih kecil pada imej resolusi tinggi, di mana latihan dengan resolusi yang lebih tinggi biasanya jauh lebih mahal tetapi boleh mencapai hasil yang lebih baik pada banyak tugas.

Penyulingan

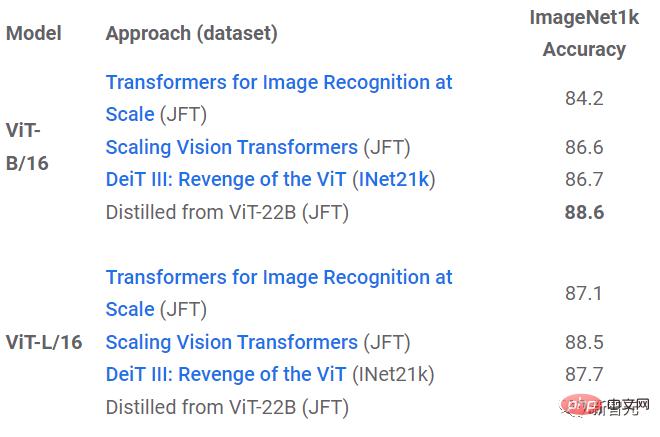

Menggunakan kaedah penyulingan, pengetahuan model yang lebih besar boleh ditukar kepada pengetahuan model yang lebih kecil, yang boleh meningkatkan kos model besar dan kelajuan larian yang lebih perlahan Kecekapan operasi model.

Ia boleh didapati daripada keputusan eksperimen bahawa pengetahuan tentang ViT-22B boleh dipindahkan kepada model yang lebih kecil seperti ViT-B/16 dan ViT- L/16, dan menyegarkan rekod prestasi pada ImageNet di bawah saiz model yang sama.

Kesaksamaan dan Kecondongan

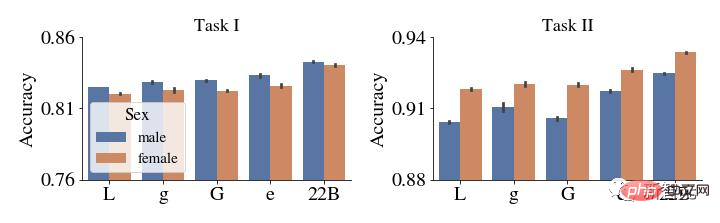

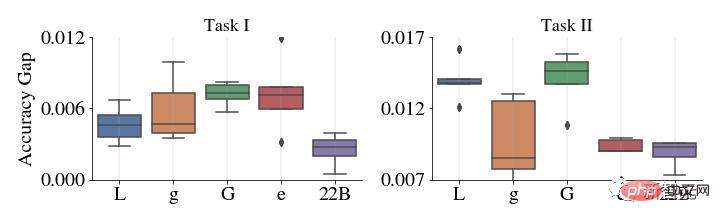

Model pembelajaran mesin terdedah kepada bias tidak adil yang tidak diingini, seperti mencari korelasi palsu atau merentasi jurang prestasi subkumpulan, para penyelidik mendapati bahawa meningkatkan model boleh membantu mengurangkan masalah ini.

Pertama, skala ialah pertukaran yang menjanjikan, walaupun model dilatih dan kemudian diproses selepas itu untuk mengawal pariti demografinya ke tahap yang ditetapkan dan boleh diterima Di bawah tahap, prestasi juga bertambah baik apabila skala meningkat.

Di atas: Ketepatan setiap subkumpulan dalam CelebA sebelum debias. Di bawah: Paksi-y menunjukkan perbezaan mutlak dalam prestasi untuk dua subkumpulan khusus yang diserlahkan dalam contoh ini (perempuan dan lelaki). Berbanding dengan model ViT yang lebih kecil, jurang prestasi ViT-22B adalah sangat kecil.

Lebih penting lagi, ini terpakai bukan sahaja pada kes di mana prestasi diukur dari segi ketepatan, tetapi juga untuk ukuran lain seperti penentukuran, iaitu ukuran kebenaran anggaran kebarangkalian model Diukur secara statistik, klasifikasi semua subkumpulan cenderung bertambah baik dengan peningkatan saiz, dan ViT-22B mengurangkan jurang prestasi antara subkumpulan.

Kesimpulan

Para penyelidik mencadangkan ViT-22B, model Transformer visual terbesar pada masa ini, yang mengandungi 22 bilion parameter.

Dengan membuat pengubahsuaian kecil tetapi penting pada seni bina model asal, penggunaan perkakasan yang lebih tinggi dan kestabilan latihan telah dicapai, menghasilkan model yang meningkatkan had atas prestasi pada beberapa penanda aras.

Menggunakan model beku untuk menjana benam, hanya perlu melatih beberapa lapisan di atas, seseorang boleh mencapai prestasi yang sangat baik, dan keputusan penilaian seterusnya menunjukkan bahawa ViT-22B Menunjukkan persamaan yang lebih besar dengan persepsi visual manusia dari segi bias bentuk dan tekstur, dan memberikan kelebihan dari segi keadilan dan keteguhan.

Atas ialah kandungan terperinci CV membuka era model besar! Google mengeluarkan ViT terbesar dalam sejarah: 22 bilion parameter, persepsi visual hampir dengan manusia. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI