Peranti teknologi

Peranti teknologi AI

AI Superkomputer AI super Google menghancurkan NVIDIA A100! Prestasi TPU v4 meningkat sebanyak 10 kali ganda, butiran didedahkan buat kali pertama

Superkomputer AI super Google menghancurkan NVIDIA A100! Prestasi TPU v4 meningkat sebanyak 10 kali ganda, butiran didedahkan buat kali pertamaWalaupun Google menggunakan cip AI yang paling berkuasa pada masa itu, TPU v4, di pusat datanya sendiri seawal 2020.

Tetapi baru 4 April tahun ini Google mengumumkan butiran teknikal superkomputer AI ini buat kali pertama.

Alamat kertas: https://arxiv.org/abs/2304.01433

Berbanding dengan TPU v3, prestasi TPU v4 adalah 2.1 kali lebih tinggi, dan selepas menyepadukan 4096 cip, prestasi superkomputer dipertingkatkan sebanyak 10 kali ganda.

Selain itu, Google juga mendakwa cipnya sendiri lebih pantas dan lebih cekap tenaga berbanding Nvidia A100.

Bersaing dengan A100, 1.7 kali lebih pantas

Dalam kertas itu, Google menyatakan bahawa untuk sistem saiz yang setanding, TPU v4 It boleh memberikan prestasi 1.7 kali lebih baik daripada NVIDIA A100, di samping meningkatkan kecekapan tenaga sebanyak 1.9 kali.

Selain itu, kelajuan pengkomputeran besar Google adalah kira-kira 4.3 hingga 4.5 kali lebih pantas daripada Graphcore IPU Bow.

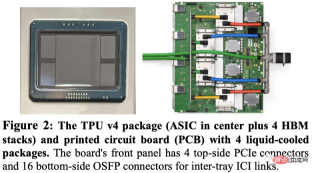

Google mempamerkan pakej TPU v4, serta 4 pakej yang dipasang pada papan litar.

Seperti TPU v3, setiap TPU v4 mengandungi dua TensorCore (TC). Setiap TC mengandungi empat unit pendaraban matriks (MXU) 128x128, unit pemprosesan vektor (VPU) dengan 128 saluran (16 ALU setiap saluran) dan 16 memori vektor MiB (VMEM).

Dua TC berkongsi memori biasa (CMEM) 128 MiB.

Perlu diambil perhatian bahawa cip A100 telah dilancarkan pada masa yang sama dengan TPU generasi keempat Google, jadi bagaimanakah prestasi khusus mereka dibandingkan?

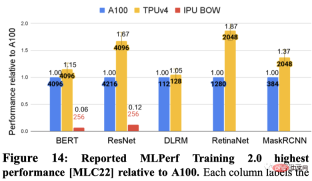

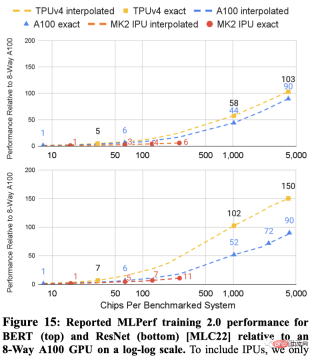

Google menunjukkan prestasi terpantas setiap DSA dalam 5 penanda aras MLPerf secara berasingan. Ini termasuk BERT, ResNET, DLRM, RetinaNet dan MaskRCNN.

Antaranya, Graphcore IPU menyerahkan keputusan dalam BERT dan ResNET.

Berikut menunjukkan keputusan kedua-dua sistem pada ResNet dan BERT Garis putus-putus antara titik adalah interpolasi berdasarkan bilangan cip.

Hasil MLPerf untuk kedua-dua skala TPU v4 dan A100 kepada sistem yang lebih besar daripada IPU (4096 cip lwn. 256 cip).

Untuk sistem bersaiz serupa, TPU v4 adalah 1.15x lebih pantas daripada A100 pada BERT dan kira-kira 4.3x lebih pantas daripada IPU. Untuk ResNet, TPU v4 masing-masing adalah 1.67x dan kira-kira 4.5x lebih pantas.

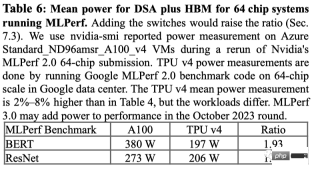

Mengenai penggunaan kuasa pada penanda aras MLPerf, A100 menggunakan secara purata 1.3x hingga 1.9x lebih kuasa.

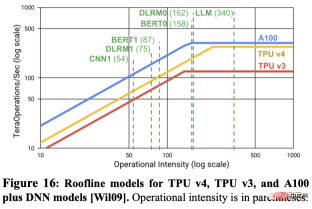

Adakah FLOPS puncak meramalkan prestasi sebenar? Ramai orang dalam bidang pembelajaran mesin percaya bahawa operasi titik terapung puncak sesaat adalah proksi yang baik untuk prestasi, tetapi sebenarnya tidak.

Sebagai contoh, TPU v4 adalah 4.3x hingga 4.5x lebih pantas pada dua penanda aras MLPerf daripada IPU Bow pada sistem saiz yang sama, walaupun hanya mempunyai kelebihan 1.10x dalam operasi titik terapung puncak sesaat.

Contoh lain ialah operasi titik terapung puncak A100 sesaat ialah 1.13 kali ganda berbanding TPU v4, tetapi untuk bilangan cip yang sama, TPU v4 adalah 1.15 hingga 1.67 kali lebih pantas.

Rajah berikut menggunakan model Roofline untuk menunjukkan hubungan antara FLOPS puncak/saat dan lebar jalur memori.

Jadi, persoalannya, kenapa Google tidak membandingkan dengan H100 terbaru Nvidia?

Google berkata kerana H100 dibina menggunakan teknologi yang lebih baharu selepas pelancaran cip Google, ia tidak membandingkan produk generasi keempatnya dengan cip H100 perdana Nvidia semasa.

Walau bagaimanapun, Google membayangkan bahawa ia sedang membangunkan TPU baharu untuk bersaing dengan Nvidia H100, tetapi tidak memberikan butiran. Penyelidik Google Jouppi berkata dalam temu bual dengan Reuters bahawa Google mempunyai "barisan pengeluaran untuk cip masa depan."

TPU vs GPU

Semasa ChatGPT dan Bard "bertempur", kedua-dua raksasa itu juga bekerja keras di belakang tabir untuk memastikan mereka berjalan - Sokongan NVIDIA CUDA GPU (Unit Pemprosesan Grafik) dan TPU tersuai Google (Unit Pemprosesan Tensor).

Dalam erti kata lain, ini bukan lagi mengenai ChatGPT lwn. Bard, tetapi TPU lwn. GPU dan betapa cekapnya mereka boleh melakukan pendaraban matriks.

Disebabkan reka bentuk yang sangat baik dalam seni bina perkakasan, GPU NVIDIA sangat sesuai untuk tugas pendaraban matriks - bertukar secara berkesan antara berbilang teras CUDA Laksanakan pemprosesan selari .

Oleh itu, model latihan mengenai GPU telah menjadi konsensus dalam bidang pembelajaran mendalam sejak 2012, dan ia tidak berubah sehingga hari ini.

Dengan pelancaran NVIDIA DGX, NVIDIA mampu menyediakan penyelesaian perkakasan dan perisian sehenti untuk hampir semua tugasan AI, yang tidak dapat disediakan oleh pesaing kerana kekurangan hak harta intelek .

Sebaliknya, Google melancarkan unit pemprosesan tensor (TPU) generasi pertama pada 2016, yang bukan sahaja menyertakan ASIC tersuai (litar bersepadu khusus), dan juga dioptimumkan untuk unitnya sendiri. Rangka kerja TensorFlow. Ini juga memberi kelebihan kepada TPU dalam tugas pengkomputeran AI lain selain pendaraban matriks, malah boleh mempercepatkan tugasan penalaan halus dan inferens.

Selain itu, penyelidik di Google DeepMind juga telah menemui cara untuk mencipta algoritma pendaraban matriks yang lebih baik - AlphaTensor.

Walau bagaimanapun, walaupun Google telah mencapai keputusan yang baik melalui teknologi yang dibangunkan sendiri dan kaedah pengoptimuman pengkomputeran AI yang baru muncul, kerjasama Microsoft dan Nvidia yang telah lama terjalin dan mendalam telah bergantung pada masing-masing. kepakaran dalam industri Pengumpulan produk secara serentak telah memperluaskan kelebihan daya saing kedua-dua pihak.

TPU generasi keempat

Kembali pada tahun 2021 di persidangan Google I/O, Pichai mengumumkannya untuk yang pertama masa TPU cip AI generasi terbaharu Google v4.

"Ini ialah sistem terpantas yang pernah kami gunakan di Google dan satu kejayaan bersejarah bagi kami." Peningkatan ini telah menjadi titik penting dalam persaingan antara syarikat yang membina superkomputer AI, kerana model bahasa besar seperti Google's Bard atau OpenAI's ChatGPT telah dilaksanakan pada skala parameter Explosive growth.

Jadi model besar ini perlu diedarkan merentasi ribuan cip, dan kemudian cip tersebut perlu bekerja bersama selama berminggu-minggu, atau lebih lama lagi, untuk melatih model itu. Pada masa ini, PaLM, model bahasa terbesar yang didedahkan secara terbuka oleh Google setakat ini, mempunyai 540 bilion parameter, yang dibahagikan kepada dua superkomputer 4000 cip untuk latihan dalam masa 50 hari. Google berkata superkomputernya boleh mengkonfigurasi semula sambungan antara cip dengan mudah untuk mengelakkan masalah dan melakukan penalaan prestasi. Penyelidik Google Norm Jouppi dan Jurutera Terbilang Google David Patterson menulis dalam catatan blog tentang sistem, “Pensuisan litar membolehkan pintasan Mengatasi gagal Komponen menjadi mudah. Fleksibiliti ini malah membolehkan kami menukar topologi interkoneksi superkomputer untuk mempercepatkan prestasi model pembelajaran mesin, yang telah berada dalam talian sejak 2020 di pusat data yang terletak di Mayes County, Oklahoma. Google mengatakan bahawa Midjourney menggunakan sistem ini untuk melatih modelnya dan versi terkini V5 membolehkan semua orang melihat penjanaan imej yang menakjubkan.

Baru-baru ini, Pichai berkata dalam temu bual dengan New York Times bahawa Bard akan dipindahkan dari LaMDA ke PaLM. Kini dengan berkat superkomputer TPU v4, Bard hanya akan menjadi lebih kuat.

Atas ialah kandungan terperinci Superkomputer AI super Google menghancurkan NVIDIA A100! Prestasi TPU v4 meningkat sebanyak 10 kali ganda, butiran didedahkan buat kali pertama. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Mengubah Pelaporan Kewangan dengan AI dan NLG - Analytics VidhyaApr 15, 2025 am 10:35 AM

Mengubah Pelaporan Kewangan dengan AI dan NLG - Analytics VidhyaApr 15, 2025 am 10:35 AMPelaporan Kewangan berkuasa AI: merevolusikan pandangan melalui generasi bahasa semula jadi Dalam persekitaran perniagaan dinamik hari ini, analisis kewangan yang tepat dan tepat pada masanya adalah penting untuk membuat keputusan strategik. Pelaporan kewangan tradisional

Adakah robot Google Deepmind ini akan bermain di Sukan Olimpik 2028?Apr 15, 2025 am 10:16 AM

Adakah robot Google Deepmind ini akan bermain di Sukan Olimpik 2028?Apr 15, 2025 am 10:16 AMRobot Tenis Jadual Google Deepmind: Era Baru dalam Sukan dan Robotik Sukan Olimpik Paris 2024 mungkin berakhir, tetapi era baru dalam sukan dan robotik adalah berkemungkinan, terima kasih kepada Google Deepmind. Penyelidikan terobosan mereka ("Mencapai Kompet Tahap Manusia

Membina WebApp Wawasan Makanan dengan Model Gemini Flash 1.5Apr 15, 2025 am 10:15 AM

Membina WebApp Wawasan Makanan dengan Model Gemini Flash 1.5Apr 15, 2025 am 10:15 AMMembuka Kecekapan dan Skala dengan Gemini Flash 1.5: WebApp Wawasan Makanan Flask Dalam landskap AI yang pesat berkembang, kecekapan dan skalabiliti adalah yang paling utama. Pemaju semakin mencari model berprestasi tinggi yang meminimumkan kos dan latenc

Melaksanakan ejen AI menggunakan llamaindexApr 15, 2025 am 10:11 AM

Melaksanakan ejen AI menggunakan llamaindexApr 15, 2025 am 10:11 AMMemanfaatkan kuasa agen AI dengan llamaindex: panduan langkah demi langkah Bayangkan pembantu peribadi yang memahami permintaan anda dan melaksanakannya dengan sempurna, sama ada pengiraan cepat atau mengambil berita pasaran terkini. Artikel ini meneroka

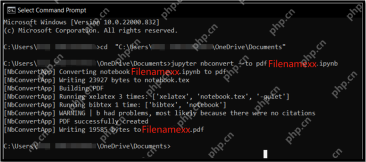

5 kaedah untuk menukar fail .ipynb ke pdf- analitik vidhyaApr 15, 2025 am 10:06 AM

5 kaedah untuk menukar fail .ipynb ke pdf- analitik vidhyaApr 15, 2025 am 10:06 AMFail Notebook Jupyter (.iPynb) digunakan secara meluas dalam analisis data, pengkomputeran saintifik, dan pengekodan interaktif. Walaupun buku nota ini bagus untuk membangun dan berkongsi kod dengan saintis data lain, kadang -kadang anda perlu mengubahnya menjadi format yang lebih umum, seperti PDF. Panduan ini akan membimbing anda melalui pelbagai cara untuk menukar fail .ipynb ke PDF, serta petua, amalan terbaik, dan cadangan penyelesaian masalah. Jadual Kandungan Mengapa menukar .ipynb ke pdf? Cara menukar fail .ipynb ke pdf Menggunakan UI Notebook Jupyter Menggunakan NBConve

Panduan Komprehensif mengenai Kes Kuantisasi dan Penggunaan LLMApr 15, 2025 am 10:02 AM

Panduan Komprehensif mengenai Kes Kuantisasi dan Penggunaan LLMApr 15, 2025 am 10:02 AMPengenalan Model bahasa yang besar (LLMs) merevolusi pemprosesan bahasa semulajadi, tetapi saiz besar dan tuntutan pengiraannya membatasi penggunaan. Kuantisasi, teknik untuk mengecilkan model dan kos pengiraan yang lebih rendah, adalah solu penting

Panduan komprehensif untuk selenium dengan pythonApr 15, 2025 am 09:57 AM

Panduan komprehensif untuk selenium dengan pythonApr 15, 2025 am 09:57 AMPengenalan Panduan ini meneroka gabungan kuat selenium dan python untuk automasi dan ujian web. Selenium mengautomasikan interaksi pelayar, meningkatkan kecekapan ujian untuk aplikasi web yang besar. Tutorial ini memberi tumpuan o

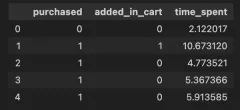

Panduan untuk Memahami Syarat InteraksiApr 15, 2025 am 09:56 AM

Panduan untuk Memahami Syarat InteraksiApr 15, 2025 am 09:56 AMPengenalan Istilah interaksi dimasukkan dalam pemodelan regresi untuk menangkap kesan dua atau lebih pembolehubah bebas dalam pemboleh ubah bergantung. Kadang -kadang, ia bukan hanya hubungan mudah antara kawalan

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

VSCode Windows 64-bit Muat Turun

Editor IDE percuma dan berkuasa yang dilancarkan oleh Microsoft

EditPlus versi Cina retak

Saiz kecil, penyerlahan sintaks, tidak menyokong fungsi gesaan kod

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini

Dreamweaver CS6

Alat pembangunan web visual

DVWA

Damn Vulnerable Web App (DVWA) ialah aplikasi web PHP/MySQL yang sangat terdedah. Matlamat utamanya adalah untuk menjadi bantuan bagi profesional keselamatan untuk menguji kemahiran dan alatan mereka dalam persekitaran undang-undang, untuk membantu pembangun web lebih memahami proses mengamankan aplikasi web, dan untuk membantu guru/pelajar mengajar/belajar dalam persekitaran bilik darjah Aplikasi web keselamatan. Matlamat DVWA adalah untuk mempraktikkan beberapa kelemahan web yang paling biasa melalui antara muka yang mudah dan mudah, dengan pelbagai tahap kesukaran. Sila ambil perhatian bahawa perisian ini