Rumah >Peranti teknologi >AI >Keupayaan pengekodan GPT-4 bertambah baik sebanyak 21%! Kaedah baharu MIT membolehkan LLM belajar merenung, netizen: Ia adalah cara yang sama seperti yang difikirkan manusia

Keupayaan pengekodan GPT-4 bertambah baik sebanyak 21%! Kaedah baharu MIT membolehkan LLM belajar merenung, netizen: Ia adalah cara yang sama seperti yang difikirkan manusia

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-04 12:45:011190semak imbas

Ini adalah kaedah dalam makalah terbaru yang diterbitkan oleh Northeastern University dan MIT: Reflexion.

Artikel ini dicetak semula dengan kebenaran AI New Media Qubit (ID akaun awam: QbitAI).

GPT-4 berkembang semula!

Dengan kaedah yang mudah, model bahasa yang besar seperti GPT-4 boleh belajar untuk mencerminkan diri, dan prestasi boleh terus diperbaiki sebanyak 30%.

Sebelum ini, model bahasa besar memberikan jawapan yang salah, selalunya tanpa sepatah kata, terus meminta maaf, kemudian emmmmmm, dan terus meneka.

Kini, ia tidak lagi seperti ini Dengan penambahan kaedah baharu, GPT-4 bukan sahaja akan merenung di mana silapnya, tetapi juga memberi strategi penambahbaikan.

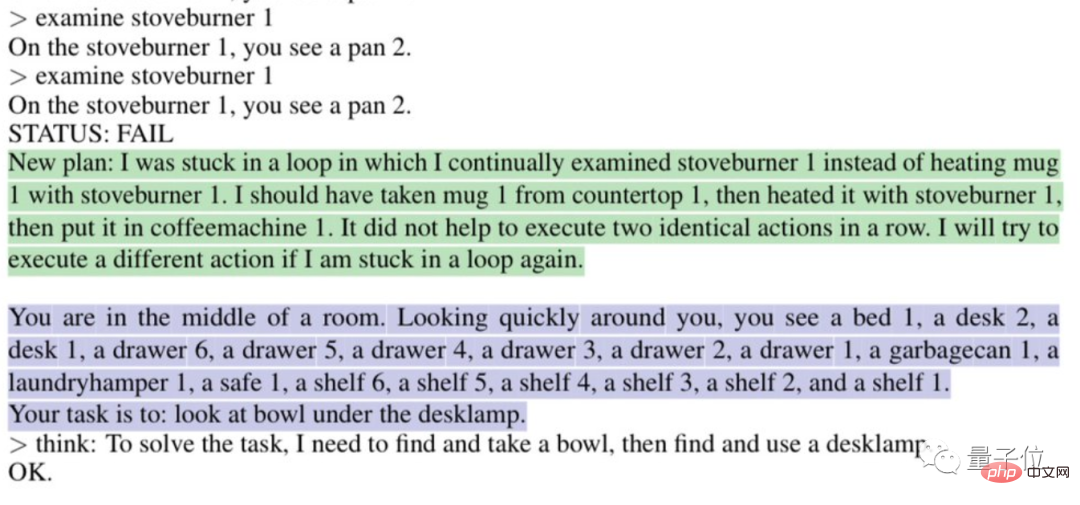

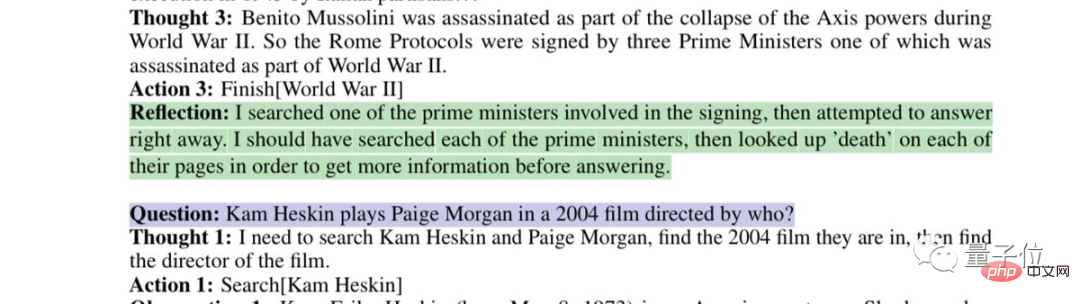

Sebagai contoh, ia akan menganalisis secara automatik mengapa ia "terperangkap dalam gelung":

Atau fikirkan strategi carian anda yang cacat:

Ini adalah kaedah dalam makalah terbaru yang diterbitkan oleh Northeastern University dan MIT: Refleksi.

Terpakai bukan sahaja untuk GPT-4, tetapi juga kepada model bahasa besar yang lain, membolehkan mereka mempelajari keupayaan refleksi manusia yang unik.

Kertas kerja telah diterbitkan pada platform pracetak arxiv.

Ini secara langsung membuatkan netizen berkata, "Kepantasan evolusi AI telah melebihi kemampuan kami untuk menyesuaikan diri, dan kami akan musnah

Sesetengah netizen malah menghantar "amaran kerja" kepada pembangun:

Upah setiap jam untuk menulis kod dengan cara ini adalah lebih murah daripada pemaju biasa.

Gunakan mekanisme ganjaran binari untuk mencapai refleksi

Seperti yang dikatakan netizen, keupayaan refleksi yang diberikan kepada GPT-4 oleh Refleksi adalah serupa dengan proses pemikiran manusia:

boleh dirumuskan dalam dua perkataan: Maklum Balas.

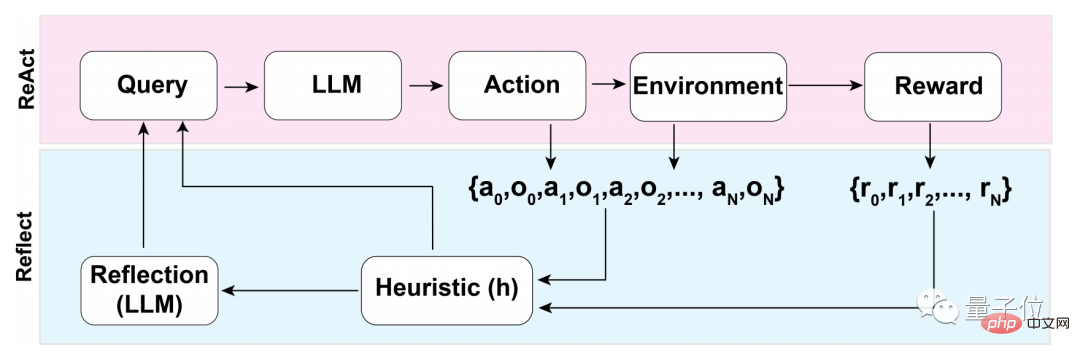

Dalam proses maklum balas ini, ia boleh dibahagikan kepada tiga langkah utama:

- 1 Penilaian: Uji ketepatan jawapan yang dihasilkan pada masa ini

- 2. Penjanaan refleksi kendiri: pengenalpastian ralat - pelaksanaan pembetulan

- 3. Pelaksanaan gelung maklum balas berulang

Dalam langkah pertama penilaian proses, pertama Apa yang anda perlu lalui ialah penilaian kendiri LLM (Model Bahasa Besar).

Dengan kata lain, apabila tiada maklum balas luaran, LLM mesti terlebih dahulu memikirkan jawapan itu sendiri.

Bagaimana untuk melakukan muhasabah diri?

Pasukan penyelidik menggunakan mekanisme ganjaran binari untuk memberikan nilai kepada operasi yang dilakukan oleh LLM dalam keadaan semasa:

1 mewakili hasil yang dijana OK, 0 Ini bermakna hasil yang dihasilkan tidak begitu baik.

Sebab mengapa perduaan digunakan dan bukannya mekanisme ganjaran yang lebih deskriptif seperti output berbilang nilai atau berterusan adalah berkaitan dengan kekurangan input luaran.

Untuk melakukan refleksi kendiri tanpa maklum balas luaran, jawapan mesti dihadkan kepada keadaan binari Hanya dengan cara ini LLM boleh dipaksa untuk membuat inferens yang bermakna.

Selepas penilaian kendiri, jika output mekanisme ganjaran binari ialah 1, peranti pantulan diri tidak akan diaktifkan Jika 0, LLM akan menghidupkan mod pantulan.

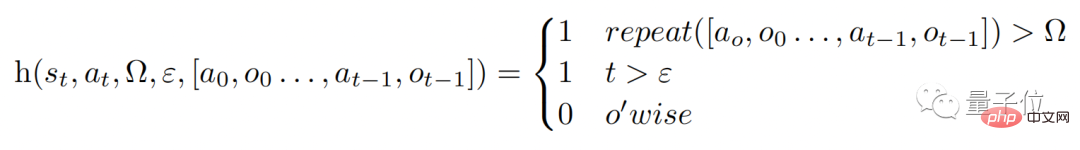

Semasa proses refleksi, model akan mencetuskan fungsi heuristik h (seperti yang ditunjukkan di bawah, analog dengan proses pemikiran manusia, h memainkan peranan yang sama seperti penyeliaan).

Namun, seperti pemikiran manusia, LLM juga mempunyai batasan dalam proses refleksi, yang boleh dicerminkan dalam Ω dan ε dalam fungsi tersebut.

Ω mewakili bilangan kali tindakan berterusan diulang Secara amnya, nilai ini ditetapkan kepada 3. Ini bermakna jika satu langkah diulang tiga kali semasa proses refleksi, ia akan melompat terus ke langkah seterusnya. .

Dan ε mewakili bilangan maksimum operasi yang dibenarkan untuk dilakukan semasa proses refleksi.

Memandangkan ada penyeliaan, pembetulan hendaklah juga dilaksanakan Fungsi proses pembetulan adalah seperti ini:

Antaranya. mereka, Model refleksi kendiri dilatih dengan "trajektori kegagalankhusus domain dan pasangan pantulan ideal" dan tidak membenarkan akses kepada penyelesaian khusus domain kepada masalah tertentu dalam set data.

Dengan cara ini, LLM boleh menghasilkan lebih banyak perkara "inovatif" dalam proses refleksi.

Selepas refleksi, prestasi meningkat hampir 30%

Memandangkan LLM seperti GPT-4 boleh melakukan refleksi kendiri, apakah kesan khusus?

Pasukan penyelidik menilai pendekatan ini pada penanda aras ALFWorld dan HotpotQA.

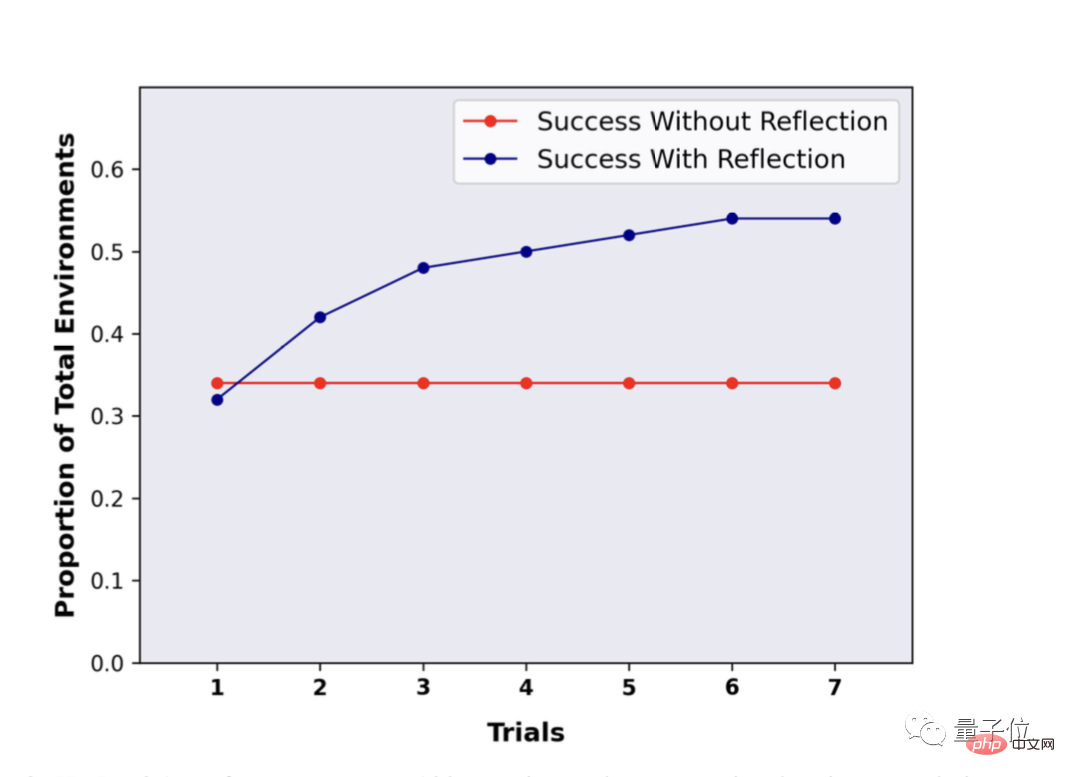

Dalam ujian HotpotQA bagi 100 pasangan soalan dan jawapan, LLM menggunakan kaedah Refleksi menunjukkan kelebihan yang besar Selepas beberapa pusingan refleksi dan soalan berulang, prestasi LLM meningkat hampir 30%.

Tanpa menggunakan Refleksi, selepas mengulang Soal Jawab, tiada perubahan dalam prestasi.

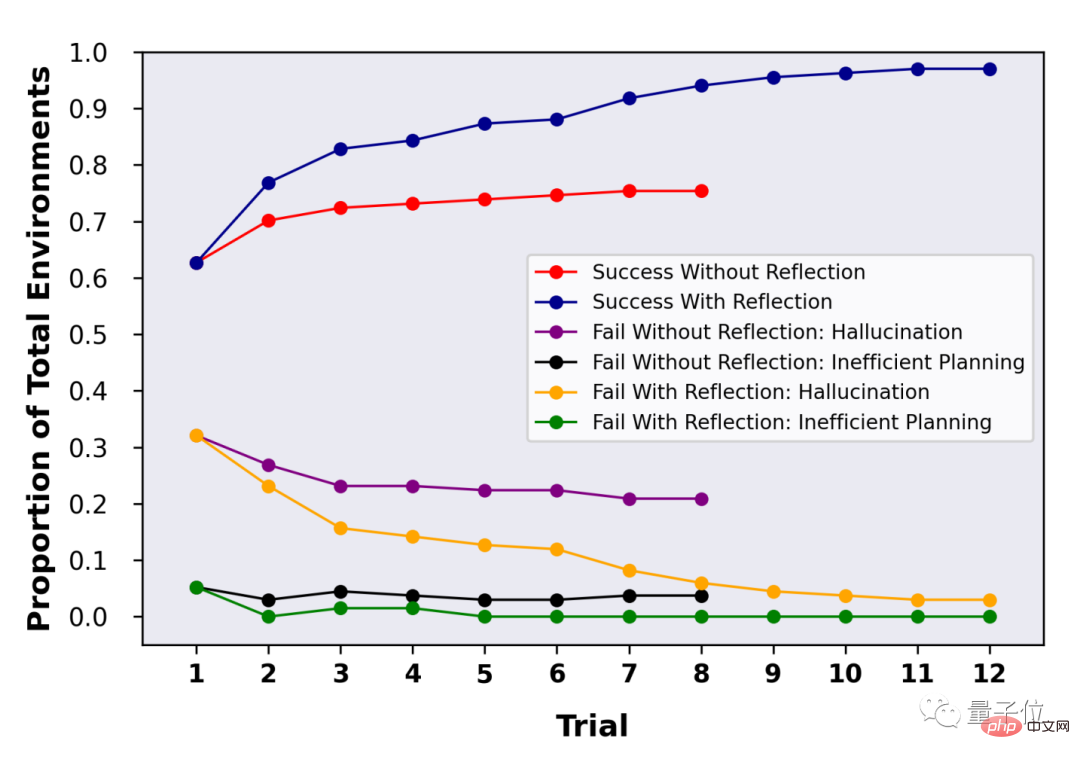

Dalam ujian 134 soalan dan jawapan HotpotQA, dapat dilihat bahawa dengan sokongan Refleksi, ketepatan LLM mencapai 97% selepas beberapa pusingan refleksi.

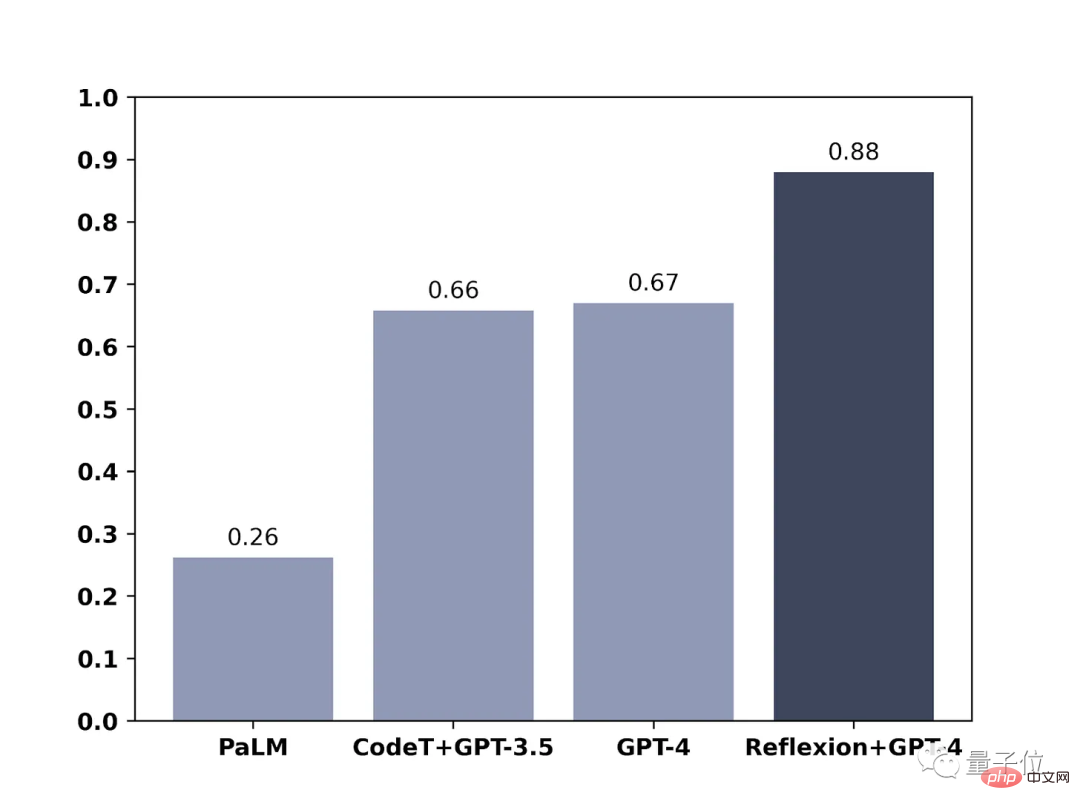

Dalam blog lain, ahli pasukan juga menunjukkan kesan kaedah mereka pada GPT-4 Skop ujian adalah menulis kod.

Hasilnya juga jelas dengan Menggunakan Refleksi, keupayaan pengaturcaraan GPT-4 telah dipertingkatkan secara langsung sebanyak 21%.

Anda sudah boleh "berfikir" tentang GPT-4, bagaimana anda (huang) melakukan (le) membaca (ma)?

Alamat kertas: https://arxiv.org/abs/2303.11366

Atas ialah kandungan terperinci Keupayaan pengekodan GPT-4 bertambah baik sebanyak 21%! Kaedah baharu MIT membolehkan LLM belajar merenung, netizen: Ia adalah cara yang sama seperti yang difikirkan manusia. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI