Rumah >Peranti teknologi >AI >Model GAN berskala ultra besar yang pertama! Kelajuan penjanaan adalah 20+ kali lebih pantas daripada Diffusion, dan imej dihasilkan dalam 0.13 saat Ia menyokong sehingga 16 juta piksel.

Model GAN berskala ultra besar yang pertama! Kelajuan penjanaan adalah 20+ kali lebih pantas daripada Diffusion, dan imej dihasilkan dalam 0.13 saat Ia menyokong sehingga 16 juta piksel.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-04 11:50:071411semak imbas

Dengan keluaran DALL-E 2 oleh OpenAI, model autoregresif dan resapan telah menjadi standard baharu untuk model generatif berskala besar semalaman, Generative Adversarial Networks (GAN) telah menjadi pilihan arus perdana dan diperoleh daripada StyleGAN dan teknologi lain.

Di sebalik populariti AIGC, dari sudut teknikal, seni bina model penjanaan imej telah mengalami perubahan yang besar.

Dengan keluaran DALL-E 2 oleh OpenAI, model autoregresif dan resapan telah menjadi standard baharu untuk model generatif berskala besar semalaman telah Mereka semua adalah pilihan arus perdana dan telah memperoleh teknologi seperti StyleGAN.

Peralihan seni bina daripada GAN kepada model penyebaran juga menimbulkan persoalan: bolehkah skala model GAN ditingkatkan? , sebagai contoh, bolehkah kami meningkatkan lagi prestasi dalam set data besar seperti LAION?

Baru-baru ini, penyelidik dari Universiti Sains dan Teknologi Pohang (Korea Selatan), Carnegie Mellon University, dan Adobe Research membangkitkan isu ketidakstabilan yang disebabkan oleh peningkatan kapasiti seni bina StyleGAN seni bina rangkaian permusuhan generatif baharu, GigaGAN, mematahkan had saiz model dan menunjukkan bahawa GAN masih boleh kompeten sebagai model sintesis teks ke imej.

Pautan kertas: https://arxiv.org/abs/2303.05511

Pautan projek: https://mingukkang. github.io/GigaGAN/

GigaGAN mempunyai tiga kelebihan utama.

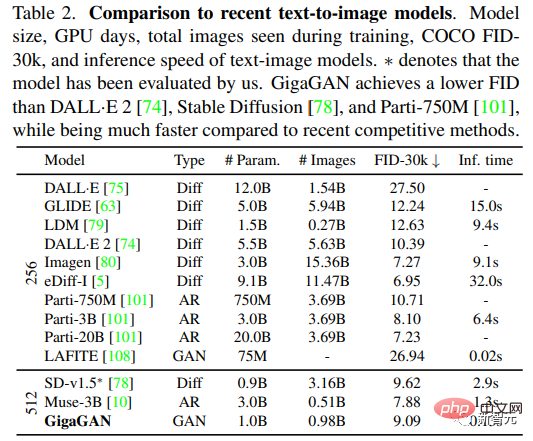

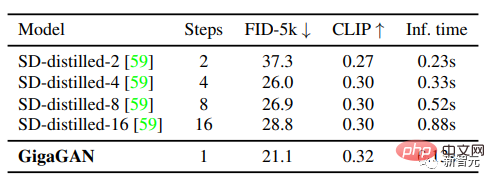

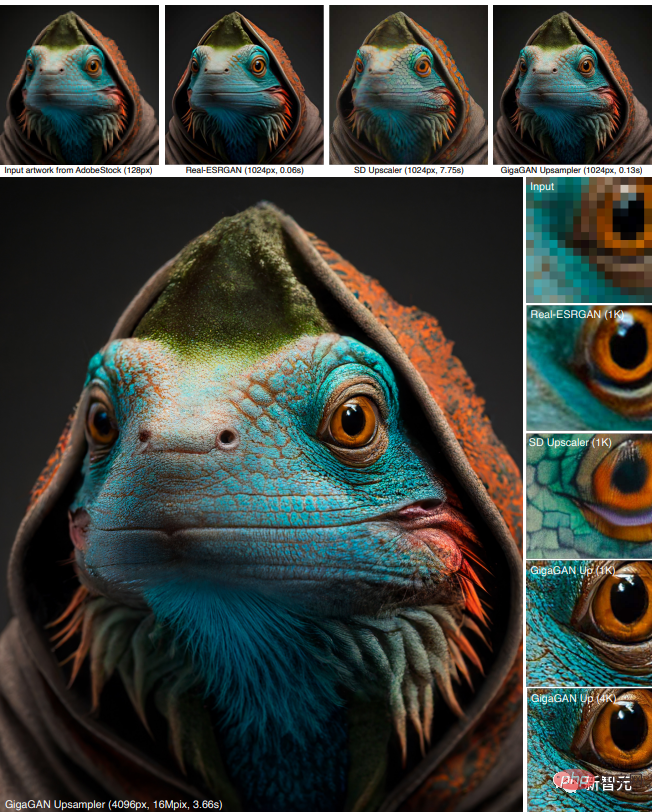

1. Ia lebih pantas semasa inferens Berbanding dengan Stable Diffusion-v1.5 dengan tahap parameter yang sama, kelajuan penjanaan pada resolusi 512 dipendekkan daripada 2.9 saat kepada 0.13 saat. .

2. Imej resolusi tinggi boleh disintesis, contohnya, imej 16 megapiksel boleh disintesis dalam 3.66 detik.

3. Menyokong pelbagai aplikasi penyuntingan ruang terpendam, seperti interpolasi pendam, pencampuran gaya dan operasi aritmetik vektor.

Satu siri model yang dikeluarkan baru-baru ini, seperti DALL-E 2, Imagen, Parti dan Stable Diffusion, telah memulakan era baharu penjanaan imej, mencapai tahap kualiti imej dan fleksibiliti model yang belum pernah terjadi sebelumnya.

Paradigma yang dominan pada masa ini "model resapan" dan "model autoregresif" kedua-duanya bergantung pada pedang bermata dua penaakulan berulang, kerana kaedah lelaran boleh melakukan latihan yang stabil dengan matlamat mudah, tetapi dalam penaakulan Kos pengiraan yang lebih tinggi akan ditanggung dalam proses tersebut.

Sebaliknya, Generative Adversarial Network (GAN) hanya memerlukan satu hantaran ke hadapan untuk menjana imej, jadi ia sememangnya lebih cekap.

Walaupun model GAN mendominasi "era sebelumnya" pemodelan generatif, disebabkan ketidakstabilan dalam proses latihan, melanjutkan GAN memerlukan pelarasan yang teliti terhadap struktur rangkaian dan pertimbangan latihan, jadi walaupun GAN sangat baik dalam memodelkan kategori objek tunggal atau berbilang, menskalakan kepada set data yang kompleks (apatah lagi penjanaan objek dunia terbuka) masih mencabar.

Jadi pada masa ini model yang sangat besar, data dan sumber pengkomputeran tertumpu terutamanya pada model penyebaran dan autoregresif.

Dalam kerja ini, penyelidik terutamanya menangani soalan berikut:

Bolehkah GAN terus berkembang dan berpotensi mendapat manfaat daripada sumber ini? Atau adakah GAN sudah mencapai hadnya? Apakah yang menghalang pengembangan GAN selanjutnya? Bolehkah halangan ini diatasi?

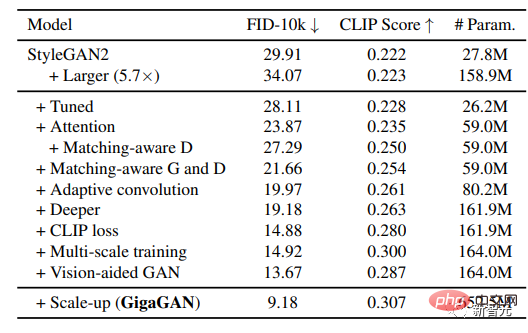

Para penyelidik mula-mula menjalankan eksperimen dengan StyleGAN2 dan memerhatikan bahawa hanya mengembangkan rangkaian tulang belakang akan membawa kepada latihan yang tidak stabil Selepas mengenal pasti beberapa isu utama Akhirnya, teknik untuk menstabilkan latihan sambil meningkatkan kapasiti model dicadangkan.

Pertama, kembangkan kapasiti penjana secara berkesan dengan mengekalkan sekumpulan penapis dan mengambil gabungan linear sampel tertentu.

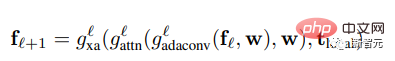

Menyesuaikan beberapa teknik yang biasa digunakan dalam konteks model penyebaran dan mengesahkan bahawa ia boleh membawa peningkatan prestasi yang serupa kepada GAN, seperti menggabungkan mekanisme perhatian diri (imej sahaja) dan Perhatian silang (teks imej) yang dijalin dengan lapisan konvolusi meningkatkan prestasi.

Selain itu, penyelidik memperkenalkan semula latihan berskala dan menemui skema baharu yang boleh meningkatkan penjajaran teks imej dan menjana butiran frekuensi rendah dalam output.

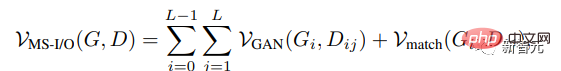

Latihan berbilang skala membolehkan penjana berasaskan GAN menggunakan parameter dalam blok resolusi rendah dengan lebih cekap, menghasilkan penjajaran teks imej dan kualiti imej yang lebih baik.

Penjana

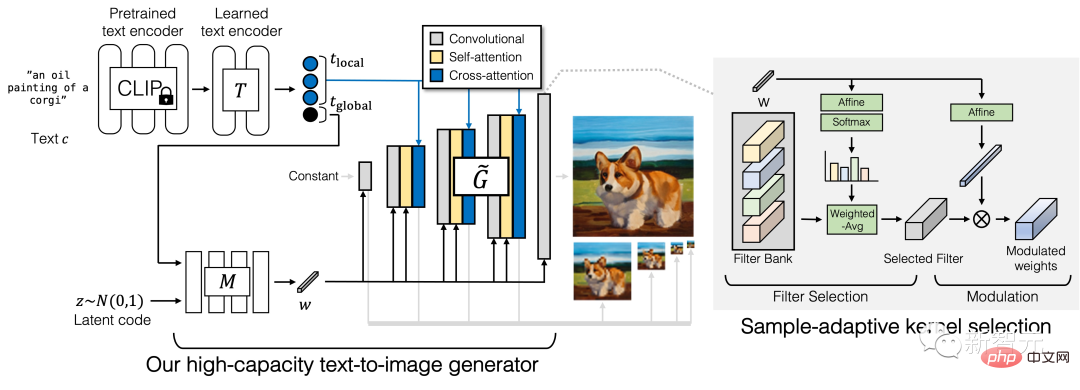

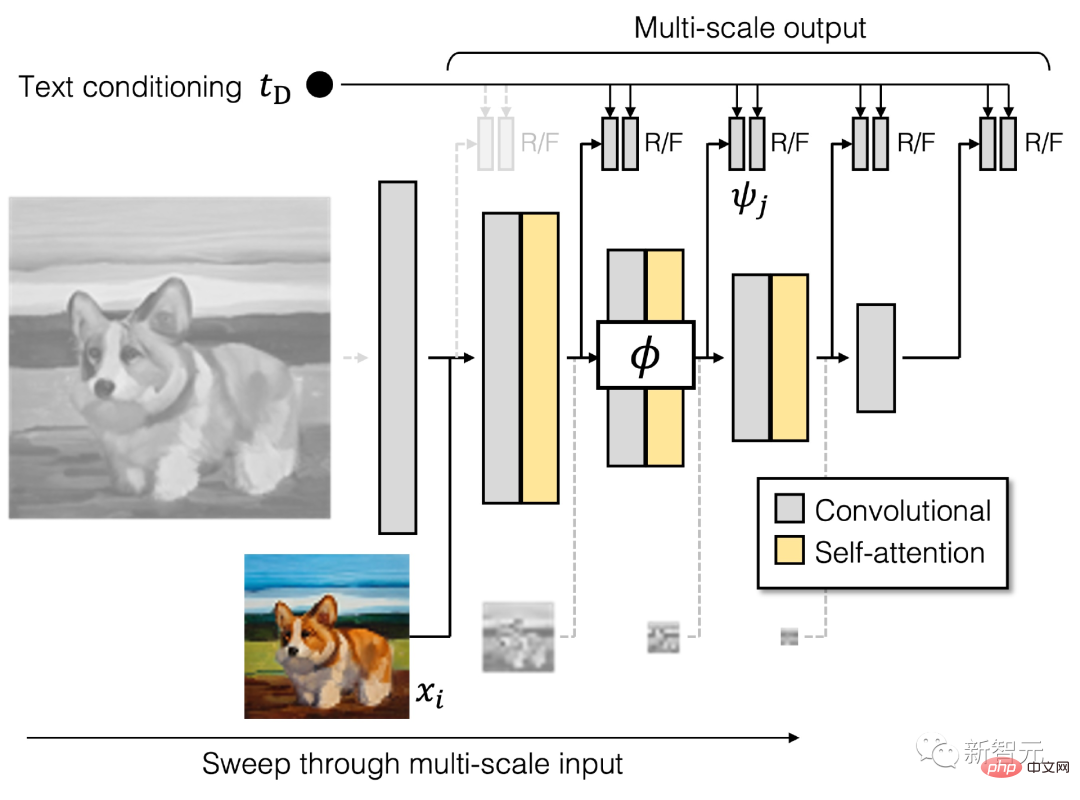

Penjana GigaGAN terdiri daripada cawangan pengekodan teks, rangkaian pemetaan gaya dan rangkaian sintesis berbilang skala), ditambah dengan perhatian yang stabil dan pemilihan kernel adaptif.

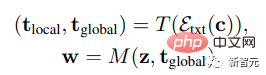

Dalam cawangan pengekodan teks, model CLIP terlatih dan lapisan perhatian yang dipelajari T mula-mula digunakan untuk mengekstrak pembenaman teks, dan kemudian proses pembenaman dihantar ke rangkaian pemetaan gaya M, Jana vektor gaya w

serupa dengan StyleGAN Rangkaian sintesis menggunakan pengekodan gaya sebagai modulasi dan pembenaman teks sebagai perhatian . Hasilkan piramid imej, dan atas dasar ini, perkenalkan sampel algoritma pemilihan kernel adaptif untuk mencapai pemilihan adaptif kernel convolution berdasarkan keadaan teks input.

Pendiskriminasi

Sama seperti penjana, diskriminator GigaGAN terdiri daripada dua cabang, yang digunakan untuk memproses keadaan imej dan teks masing-masing.

Cawangan teks mengendalikan cawangan teks yang serupa dengan penjana; cawangan imej menerima piramid imej sebagai input dan membuat ramalan bebas untuk setiap skala imej.

Beberapa fungsi kehilangan tambahan diperkenalkan dalam formula untuk menggalakkan penumpuan pantas.

Penilaian yang sistematik dan terkawal pada tugas sintesis imej teks berskala besar adalah sukar kerana kebanyakan model sedia ada tidak tersedia secara terbuka, walaupun jika kod latihan tersedia, kos melatih model baharu dari awal akan menjadi mahal.

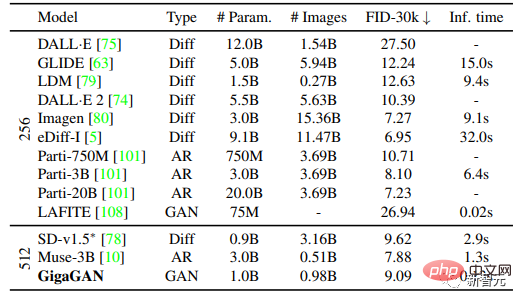

Para penyelidik memilih untuk membandingkan dengan Imagen, Model Resapan Terpendam (LDM), Resapan Stabil dan Parti dalam eksperimen mereka, sambil mengakui bahawa terdapat perbezaan yang ketara dalam set data latihan, nombor lelaran, saiz kelompok, dan saiz model terdapat perbezaan yang ketara.

Untuk penunjuk penilaian kuantitatif, Frechet Inception Distance (FID) digunakan terutamanya untuk mengukur ketulenan pengedaran output, dan skor CLIP digunakan untuk menilai penjajaran teks imej.

Lima eksperimen berbeza telah dijalankan dalam kertas:

1 Tunjukkan keberkesanan kaedah yang dicadangkan dengan menggabungkan setiap komponen teknikal secara beransur-ansur; . sambil menjana keputusan ratusan kali lebih pantas daripada model resapan atau autoregresif; 🎜>

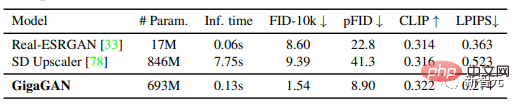

4. Mengesahkan kelebihan upsampler GigaGAN berbanding upsampler lain dalam tugasan resolusi super bersyarat dan tanpa syarat;

5 Keputusan menunjukkan bahawa GAN berskala besar masih menikmati operasi ruang terpendam GAN yang berterusan dan terurai, membolehkan mod penyuntingan imej baharu.

Selepas melaraskan parameter, penyelidik mencapai kestabilan dan kebolehpercayaan pada set data berskala besar seperti Latihan LAION2B-en daripada GAN berbilion parameter lanjutan (GigaGAN).

Dan kaedah ini menggunakan pendekatan berbilang peringkat, mula-mula menjana pada 64 × 64, dan kemudian meningkatkan pensampelan kepada 512 × 512, kedua-dua rangkaian adalah modular dan cukup berkuasa untuk digunakan secara plug-and-play.

Hasilnya menunjukkan bahawa rangkaian pensampelan GAN berhawa teks boleh berfungsi sebagai pensampel tinggi yang cekap dan berkualiti tinggi untuk model resapan asas (seperti DALL-E 2) walaupun tidak pernah melihat imej model resapan semasa latihan.

Bersama-sama, keputusan ini menjadikan GigaGAN jauh mengatasi model GAN sebelumnya, 36 kali lebih besar daripada StyleGAN2, 6 kali lebih besar daripada StyleGAN-XL dan XMC-GAN.

Walaupun volum 1 bilion parameter GiGAN masih lebih rendah daripada model sintetik terbesar yang dikeluarkan baru-baru ini, seperti Imagen (3B) , DALL-E 2 (5.5B) dan Parti (20B), tetapi tiada ketepuan jisim berkenaan dengan saiz model masih belum diperhatikan.

GigaGAN mencapai FID sifar 9.09 pada set data COCO2014, yang lebih rendah daripada FID DALL-E 2, Parti-750M dan Stable Diffusion

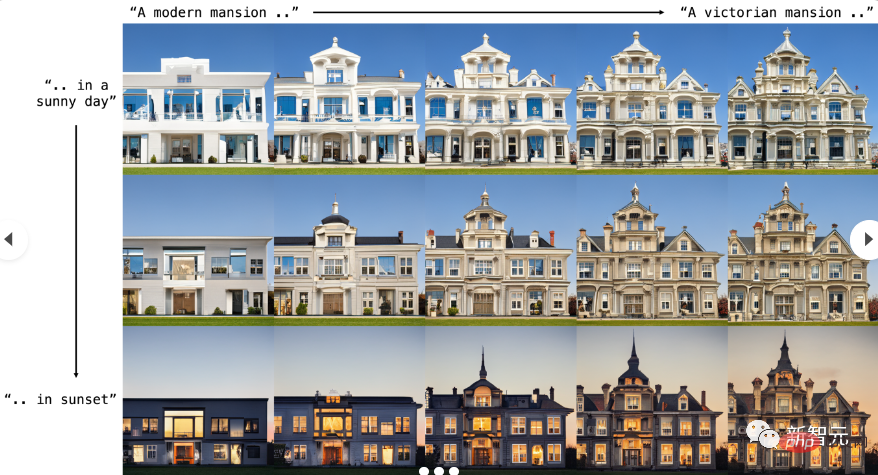

Interpolasi segera

GigaGAN boleh menginterpolasi dengan lancar antara gesaan Empat penjuru dalam rajah di bawah dibentuk oleh penjanaan kod Terpendam yang sama , tetapi dengan gesaan teks yang berbeza.

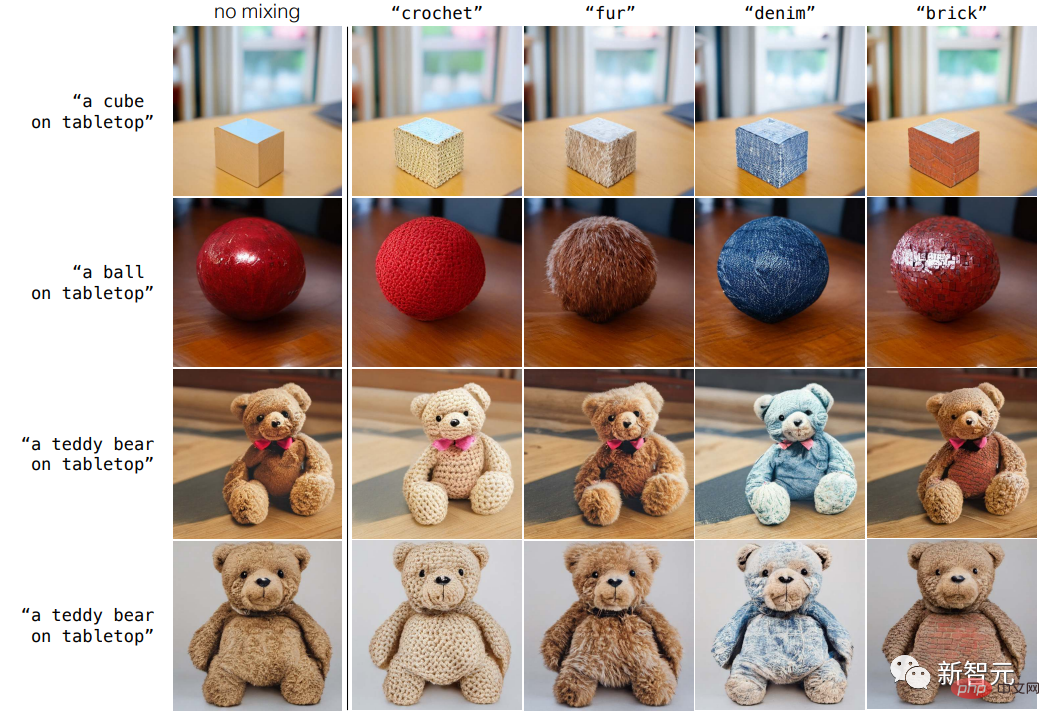

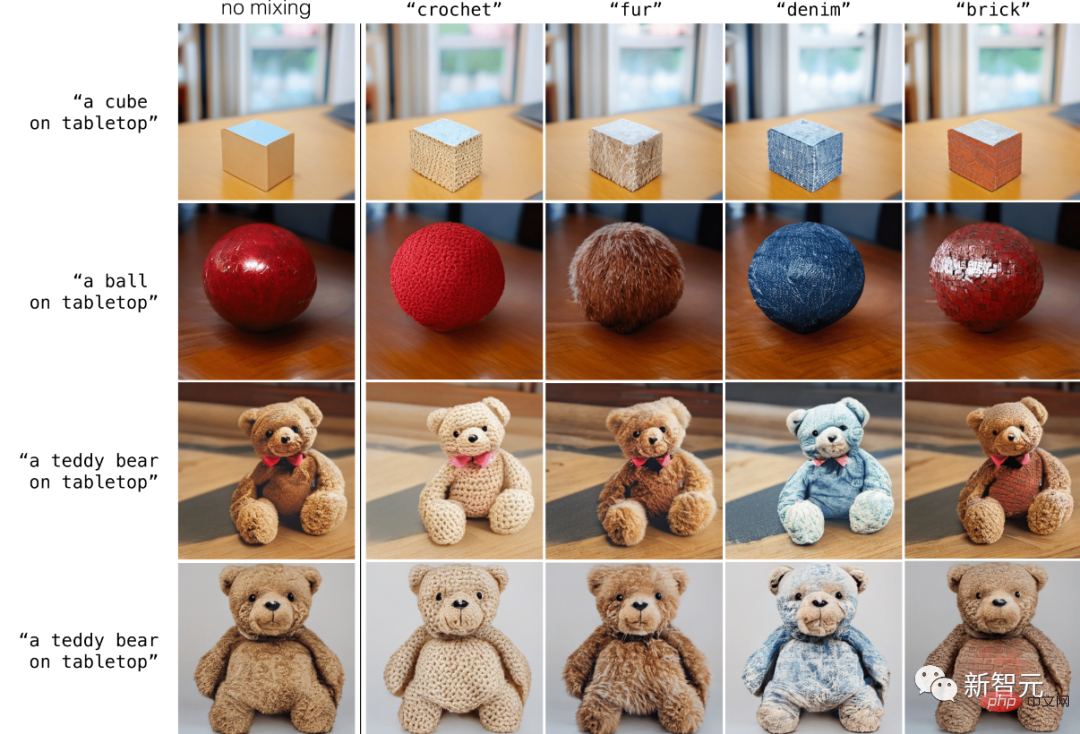

Campuran segera terurai

GigaGAN dikhaskan Ruang pendam yang dipisahkan membolehkan penggabungan gaya kasar satu sampel dengan gaya halus sampel lain, dan GigaGAN boleh mengawal gaya secara langsung melalui pembayang teks.

Pertukaran sytle kasar ke halus

Berasaskan GAN seni bina model mengekalkan ruang terpendam yang diasingkan, membolehkan gaya kasar satu sampel dicampur dengan gaya halus sampel lain.

Rujukan:

https://mingukkang.github.io/GigaGAN/

Atas ialah kandungan terperinci Model GAN berskala ultra besar yang pertama! Kelajuan penjanaan adalah 20+ kali lebih pantas daripada Diffusion, dan imej dihasilkan dalam 0.13 saat Ia menyokong sehingga 16 juta piksel.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI