Rumah >Peranti teknologi >AI >kertas 30 muka surat! Kerja baharu oleh pasukan Yu Shilun: tinjauan komprehensif AIGC, sejarah pembangunan daripada GAN ke ChatGPT

kertas 30 muka surat! Kerja baharu oleh pasukan Yu Shilun: tinjauan komprehensif AIGC, sejarah pembangunan daripada GAN ke ChatGPT

- WBOYke hadapan

- 2023-04-04 11:50:021755semak imbas

2022 boleh dikatakan sebagai tahun pertama AI generatif. Baru-baru ini, pasukan Yu Shilun menerbitkan tinjauan komprehensif tentang AIGC, memperkenalkan sejarah pembangunan daripada GAN kepada ChatGPT.

Tahun 2022 yang baru berlalu sudah pasti merupakan titik tunggal ledakan AI generatif.

Sejak 2021, AI generatif telah dipilih ke dalam "Kitaran Hype Teknologi Kecerdasan Buatan" Gartner selama dua tahun berturut-turut dan dianggap sebagai trend teknologi AI yang penting pada masa hadapan.

Baru-baru ini, pasukan Yu Shilun menerbitkan tinjauan komprehensif tentang AIGC, memperkenalkan sejarah pembangunan daripada GAN kepada ChatGPT.

Alamat kertas: https://arxiv.org/pdf/2303.04226.pdf

Artikel ini memetik sebahagian daripada kertas kerja untuk pengenalan.

Ketunggalan telah tiba?

Dalam beberapa tahun kebelakangan ini, kandungan yang dijana kecerdasan buatan (AIGC, juga dikenali sebagai AI generatif) telah menarik perhatian meluas di luar komuniti sains komputer.

Seluruh masyarakat telah mula berminat dengan pelbagai produk penjanaan kandungan yang dibangunkan oleh syarikat teknologi besar, seperti ChatGPT dan DALL-E-2.

AIGC merujuk kepada penggunaan teknologi kecerdasan buatan generatif (GAI) untuk menjana kandungan dan secara automatik boleh mencipta sejumlah besar kandungan dalam masa yang singkat.

ChatGPT ialah sistem AI yang dibangunkan oleh OpenAI untuk membina perbualan. Sistem ini dapat memahami dan bertindak balas terhadap bahasa manusia secara berkesan dengan cara yang bermakna.

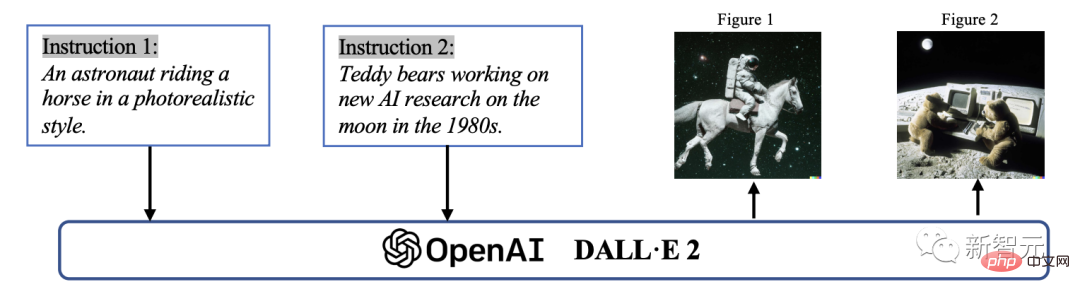

Selain itu, DALL-E-2 ialah satu lagi model GAI tercanggih yang dibangunkan oleh OpenAI, yang mampu mencipta imej unik berkualiti tinggi daripada penerangan teks dalam beberapa minit.

Contoh AIGC dalam penjanaan imej

Secara teknikal, AIGC merujuk kepada arahan yang diberikan yang boleh membimbing model untuk menyelesaikan tugas, menggunakan GAI untuk menjana kepuasan Kandungan arahan. Proses penjanaan ini biasanya terdiri daripada dua langkah: mengekstrak maklumat niat daripada arahan, dan menjana kandungan berdasarkan niat yang diekstrak.

Namun, seperti yang telah dibuktikan oleh kajian lepas, paradigma model GAI termasuk dua langkah di atas bukanlah sesuatu yang baru.

Berbanding dengan kerja sebelumnya, titik teras kemajuan AIGC terkini adalah untuk melatih model generatif yang lebih kompleks pada set data yang lebih besar, menggunakan rangka kerja model asas yang lebih besar dan mempunyai akses kepada pelbagai sumber pengkomputeran.

Sebagai contoh, rangka kerja utama GPT-3 adalah sama dengan GPT-2, tetapi saiz data pra-latihan meningkat daripada WebText (38GB) kepada CommonCrawl (570GB selepas penapisan), dan saiz model asas meningkat daripada 1.5B kepada 175B.

Oleh itu, GPT-3 mempunyai keupayaan generalisasi yang lebih baik daripada GPT-2 pada pelbagai tugas.

Selain faedah yang dibawa oleh peningkatan volum data dan kuasa pengkomputeran, penyelidik juga meneroka cara untuk menggabungkan teknologi baharu dengan algoritma GAI.

Sebagai contoh, ChatGPT menggunakan Pembelajaran Pengukuhan dengan Maklum Balas Manusia (RLHF) untuk menentukan tindak balas yang paling sesuai kepada arahan yang diberikan, dengan itu meningkatkan kebolehpercayaan dan ketepatan model dari semasa ke semasa. Pendekatan ini membolehkan ChatGPT memahami dengan lebih baik pilihan manusia dalam perbualan yang panjang.

Pada masa yang sama, dalam CV, Stable Diffusion yang dicadangkan oleh Stability AI pada tahun 2022 juga telah mencapai kejayaan besar dalam penjanaan imej.

Tidak seperti kaedah sebelumnya, model resapan generatif boleh membantu menjana imej resolusi tinggi dengan mengawal keseimbangan antara penerokaan dan eksploitasi, dengan itu mencapai kepelbagaian dalam imej yang dijana, selaras dengan persamaan gabungan data latihan.

Dengan menggabungkan kemajuan ini, model tersebut telah mencapai kemajuan yang ketara dalam misi AIGC dan telah diterima pakai oleh industri yang pelbagai seperti seni, pengiklanan dan pendidikan.

Dalam masa terdekat, AIGC akan terus menjadi bidang penting dalam penyelidikan pembelajaran mesin.

Secara amnya, model GAI boleh dibahagikan kepada dua jenis: model single-modal dan multi-modal

Oleh itu, jalankan kajian menyeluruh terhadap penyelidikan lepas dan ketahui Masalah ini di lapangan adalah penting. Ini adalah tinjauan pertama yang memfokuskan pada teknologi teras dan aplikasi dalam bidang AIGC.

Ini adalah tinjauan komprehensif pertama AIGC yang meringkaskan GAI dari segi teknologi dan aplikasi.

Tinjauan sebelum ini terutamanya memperkenalkan GAI daripada perspektif yang berbeza, termasuk penjanaan bahasa semula jadi, penjanaan imej dan penjanaan pembelajaran mesin berbilang mod. Walau bagaimanapun, kerja-kerja terdahulu ini hanya tertumpu pada bahagian tertentu AIGC.

Dalam tinjauan ini, kami mula-mula menyemak teknologi asas yang biasa digunakan dalam AIGC. Kemudian, ringkasan komprehensif algoritma GAI lanjutan disediakan lagi, termasuk penjanaan unimodal dan multimodal. Selain itu, kertas kerja mengkaji aplikasi dan potensi cabaran AIGC.

Akhirnya, hala tuju masa depan bidang ini dititikberatkan. Secara ringkasnya, sumbangan utama kertas kerja ini adalah seperti berikut: - Untuk pengetahuan terbaik kami, kami adalah yang pertama memberikan definisi formal dan tinjauan komprehensif tentang proses generatif AIGC dan AI-augmented.

-Kami menyemak sejarah dan teknologi asas AIGC, dan menjalankan analisis menyeluruh tentang kemajuan terkini dalam tugasan dan model GAI dari perspektif penjanaan unimodal dan penjanaan multimodal.

-Artikel ini membincangkan cabaran utama yang dihadapi oleh AIGC dan trend penyelidikan masa hadapan.

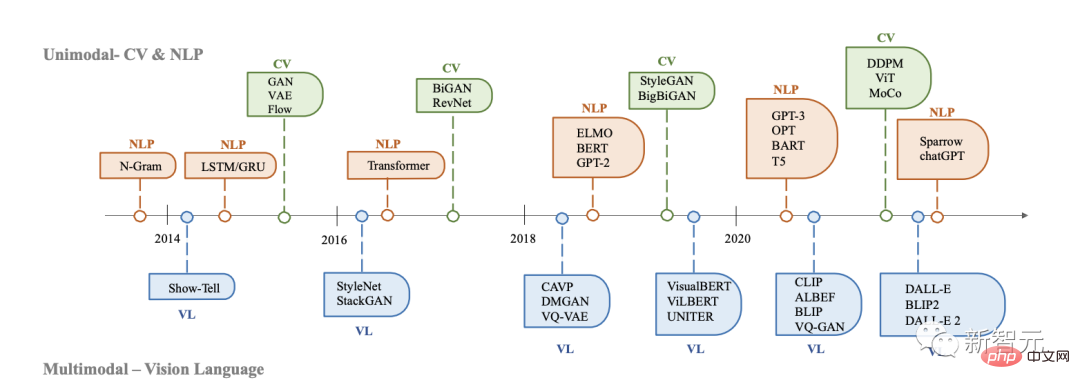

Sejarah AI Generatif

Model generatif mempunyai sejarah panjang dalam kecerdasan buatan, sejak pembangunan Hidden Markov Models (HMMs) dan Gaussian Mixture Models (GMMs) pada tahun 1950-an.

Model ini menjana data berterusan seperti pertuturan dan siri masa. Walau bagaimanapun, barulah kemunculan pembelajaran mendalam barulah prestasi model generatif meningkat dengan ketara.

Dalam model generatif dalam awal, domain yang berbeza biasanya tidak banyak bertindih.

Sejarah perkembangan AI generatif dalam CV, NLP dan VL

Dalam NLP, kaedah tradisional untuk menghasilkan ayat ialah menggunakan bahasa N-gram model pembelajaran pengedaran perkataan, dan kemudian cari urutan terbaik. Walau bagaimanapun, kaedah ini tidak dapat menyesuaikan dengan ayat yang panjang dengan berkesan.

Untuk menyelesaikan masalah ini, Rangkaian Neural Berulang (RNN) kemudiannya diperkenalkan kepada tugas pemodelan bahasa, membolehkan kebergantungan yang agak panjang dimodelkan.

Kedua ialah pembangunan Memori Jangka Pendek Panjang (LSTM) dan Unit Berulang Berpagar (GRU), yang menggunakan mekanisme gating untuk mengawal ingatan semasa latihan. Kaedah ini mampu mengendalikan kira-kira 200 token dalam sampel, yang menandakan peningkatan yang ketara berbanding model bahasa N-gram.

Sementara itu, dalam CV, sebelum kemunculan kaedah berasaskan pembelajaran mendalam, algoritma penjanaan imej tradisional menggunakan teknik seperti sintesis tekstur (PTS) dan pemetaan tekstur.

Algoritma ini berdasarkan ciri rekaan tangan dan mempunyai keupayaan terhad dalam menghasilkan imej yang kompleks dan pelbagai.

Pada 2014, Generative Adversarial Networks (GAN) mula-mula dicadangkan dan menjadi mercu tanda dalam bidang kecerdasan buatan kerana hasil yang mengagumkan dalam pelbagai aplikasi.

Pengekod auto variasi (VAE) dan kaedah lain, seperti model resapan generatif, juga telah dibangunkan untuk menyediakan kawalan yang lebih halus ke atas proses penjanaan imej dan membolehkan penjanaan imej berkualiti tinggi.

Pembangunan model generatif dalam bidang yang berbeza telah mengikuti laluan yang berbeza, tetapi pada akhirnya terdapat persimpangan: seni bina Transformer.

Pada 2017, Transformer telah diperkenalkan dalam tugasan NLP oleh Vaswani et al., dan kemudiannya digunakan pada CV, dan kemudian menjadi seni bina dominan untuk banyak model generatif dalam pelbagai bidang.

Dalam bidang NLP, banyak model bahasa berskala besar yang terkenal, seperti BERT dan GPT, menggunakan seni bina Transformer sebagai blok binaan utama mereka. Kelebihan berbanding blok binaan sebelum ini iaitu LSTM dan GRU.

Dalam CV, Vision Transformer (ViT) dan Swin Transformer kemudiannya mengembangkan lagi konsep ini, menggabungkan seni bina Transformer dengan komponen penglihatan, membolehkan ia digunakan pada sistem pautan bawah berasaskan imej.

Selain penambahbaikan yang dibawa oleh Transformer kepada satu modaliti, silang ini juga membolehkan model dari medan berbeza digabungkan bersama untuk melaksanakan tugas berbilang modal.

Contoh model multimodal ialah CLIP. CLIP ialah model bahasa visual bersama. Ia menggabungkan seni bina Transformer dengan komponen visual, membenarkan latihan pada sejumlah besar data teks dan imej.

Disebabkan gabungan pengetahuan visual dan linguistik dalam pra-latihan, CLIP juga boleh digunakan sebagai pengekod imej dalam penjanaan kiu multi-modal. Ringkasnya, kemunculan model berasaskan Transformer telah merevolusikan penjanaan kecerdasan buatan dan membawa kepada kemungkinan latihan berskala besar.

Dalam beberapa tahun kebelakangan ini, penyelidik juga telah mula memperkenalkan teknologi baharu berdasarkan model ini.

Contohnya, dalam NLP, untuk membantu model memahami keperluan tugasan dengan lebih baik, orang kadangkala lebih suka petunjuk beberapa pukulan. Ia merujuk kepada memasukkan dalam gesaan beberapa contoh yang dipilih daripada set data.

Dalam bahasa visual, penyelidik menggabungkan model khusus corak dengan matlamat pembelajaran kontrastif yang diselia sendiri untuk memberikan perwakilan yang lebih berkuasa.

Pada masa hadapan, apabila AIGC menjadi semakin penting, semakin banyak teknologi akan diperkenalkan, yang akan memberikan tenaga yang hebat kepada bidang ini.

Asas AIGC

Dalam bahagian ini, model asas AIGC yang biasa digunakan diperkenalkan.

Model Asas

Transformer

Transformer ialah seni bina tulang belakang bagi banyak model terkini, seperti GPT-3, DALL -E-2, Codex dan Gopher.

Ia mula-mula dicadangkan untuk menyelesaikan pengehadan model tradisional, seperti RNN, dalam memproses jujukan panjang berubah-ubah dan kesedaran konteks.

Seni bina Transformer terutamanya berdasarkan mekanisme perhatian kendiri, membolehkan model memberi perhatian kepada bahagian berlainan jujukan input.

Transformer terdiri daripada pengekod dan penyahkod. Pengekod menerima urutan input dan menjana perwakilan tersembunyi, manakala penyahkod menerima perwakilan tersembunyi dan menjana jujukan output.

Setiap lapisan pengekod dan penyahkod terdiri daripada perhatian berbilang kepala dan rangkaian saraf suapan ke hadapan. Perhatian berbilang kepala ialah komponen teras Transformer, yang belajar untuk menetapkan pemberat yang berbeza berdasarkan perkaitan teg.

Pendekatan penghalaan maklumat ini membolehkan model mengendalikan kebergantungan jangka panjang dengan lebih baik dan, oleh itu, meningkatkan prestasi dalam pelbagai tugas NLP.

Satu lagi kelebihan Transformer ialah seni binanya menjadikannya sangat selari dan membolehkan data mengatasi bias induktif. Ciri ini menjadikan Transformer sangat sesuai untuk pra-latihan berskala besar, membolehkan model berasaskan Transformer menyesuaikan diri dengan tugas hiliran yang berbeza.

Model bahasa pra-latihan

Sejak pengenalan seni bina Transformer, ia telah menjadi pilihan arus perdana untuk pemprosesan bahasa semula jadi kerana keselarian dan keupayaan pembelajarannya.

Secara umumnya, model bahasa pra-latihan berasaskan Transformer ini biasanya boleh dibahagikan kepada dua kategori mengikut tugas latihan mereka: model bahasa autoregresif dan model bahasa topeng.

Memandangkan ayat yang terdiri daripada berbilang token, matlamat pemodelan bahasa bertopeng, seperti BERT dan RoBERTa, adalah untuk meramalkan kebarangkalian token bertopeng yang diberikan maklumat kontekstual.

Contoh model bahasa bertopeng yang paling ketara ialah BERT, yang merangkumi pemodelan bahasa bertopeng dan tugas ramalan ayat seterusnya. RoBERTa menggunakan seni bina yang sama seperti BERT, meningkatkan prestasinya dengan meningkatkan jumlah data pra-latihan dan menggabungkan objektif pra-latihan yang lebih mencabar.

XL-Net juga berdasarkan BERT, yang menggabungkan operasi pilih atur untuk menukar susunan ramalan bagi setiap lelaran latihan, membolehkan model mempelajari lebih banyak maklumat silang silang.

Model bahasa autoregresif, seperti GPT-3 dan OPT, memodelkan kebarangkalian yang diberikan token sebelumnya, dan oleh itu merupakan model bahasa kiri ke kanan. Tidak seperti model bahasa bertopeng, model bahasa autoregresif lebih sesuai untuk tugasan generatif.

Pembelajaran peneguhan daripada maklum balas manusia

Walaupun dilatih mengenai data berskala besar, AIGC mungkin tidak sentiasa mengeluarkan kandungan yang konsisten dengan niat pengguna.

Untuk menjadikan output AIGC lebih sepadan dengan pilihan manusia, pembelajaran pengukuhan daripada maklum balas manusia (RLHF) telah digunakan untuk model penalaan halus dalam pelbagai aplikasi, seperti Sparrow, InstructGPT dan ChatGPT.

Biasanya, keseluruhan proses RLHF merangkumi tiga langkah berikut: pra-latihan, pembelajaran ganjaran dan penalaan halus pembelajaran pengukuhan.

Pengkomputeran

Perkakasan

Dalam beberapa tahun kebelakangan ini, teknologi perkakasan telah mencapai kemajuan yang ketara, memudahkan latihan model besar.

Pada masa lalu, melatih rangkaian saraf yang besar menggunakan CPU boleh mengambil masa beberapa hari atau minggu. Walau bagaimanapun, dengan peningkatan kuasa pengkomputeran, proses ini telah dipercepatkan dengan beberapa urutan magnitud.

Sebagai contoh, GPU NVIDIA A100 NVIDIA adalah 7 kali lebih pantas daripada V100 dan 11 kali lebih pantas daripada T4 dalam proses inferens berskala besar BERT.

Selain itu, Unit Pemprosesan Tensor (TPU) Google direka khusus untuk pembelajaran mendalam, memberikan prestasi pengkomputeran yang lebih tinggi berbanding GPU A100.

Mempercepatkan kemajuan dalam kuasa pengkomputeran telah meningkatkan kecekapan latihan model kecerdasan buatan dengan ketara, memberikan kemungkinan baharu untuk pembangunan model besar dan kompleks.

Latihan Teragih

Satu lagi peningkatan utama ialah latihan teragih.

Dalam pembelajaran mesin tradisional, latihan biasanya dilakukan pada mesin menggunakan pemproses tunggal. Pendekatan ini berfungsi dengan baik untuk set data dan model kecil, tetapi menjadi tidak praktikal apabila berurusan dengan set data besar dan model kompleks.

Dalam latihan teragih, tugas latihan diagihkan kepada berbilang pemproses atau mesin, yang meningkatkan kelajuan latihan model dengan banyak.

Sesetengah syarikat juga telah mengeluarkan rangka kerja yang memudahkan proses latihan teragih timbunan pembelajaran mendalam. Rangka kerja ini menyediakan alatan dan API yang membolehkan pembangun mengagihkan tugas latihan dengan mudah merentas berbilang pemproses atau mesin tanpa perlu mengurus infrastruktur asas.

Pengkomputeran Awan

Pengkomputeran Awan juga memainkan peranan penting dalam melatih model besar. Sebelum ini, model sering dilatih secara tempatan. Kini, dengan perkhidmatan pengkomputeran awan seperti AWS dan Azure yang menyediakan akses kepada sumber pengkomputeran yang berkuasa, penyelidik dan pengamal pembelajaran mendalam boleh mencipta kluster GPU atau TPU yang besar yang diperlukan untuk latihan model besar atas permintaan.

Secara kolektif, kemajuan ini memungkinkan untuk membangunkan model yang lebih kompleks dan tepat, membuka kemungkinan baharu dalam pelbagai bidang penyelidikan dan aplikasi kecerdasan buatan.

Pengenalan kepada pengarang

Philip S. Yu ialah seorang sarjana dalam bidang sains komputer, Fellow ACM/IEEE, dan seorang profesor terkemuka di Jabatan Sains Komputer di Universiti of Illinois di Chicago (UIC).

Beliau telah membuat pencapaian yang terkenal di dunia dalam teori dan teknologi perlombongan dan pengurusan data besar. Sebagai tindak balas kepada cabaran data besar dari segi skala, kelajuan dan kepelbagaian, beliau telah mencadangkan penyelesaian yang berkesan dan canggih dalam kaedah dan teknologi perlombongan dan pengurusan data, terutamanya dalam mengintegrasikan data yang pelbagai, aliran data perlombongan, corak kerap dan subruang. .

Beliau juga membuat sumbangan perintis dalam bidang teknologi pemprosesan pangkalan data selari dan teragih, dan menggunakannya pada sistem IBM S/390 Parallel Sysplex, berjaya menyepadukan kerangka utama IBM tradisional Peralihan kepada seni bina mikropemproses selari.

Atas ialah kandungan terperinci kertas 30 muka surat! Kerja baharu oleh pasukan Yu Shilun: tinjauan komprehensif AIGC, sejarah pembangunan daripada GAN ke ChatGPT. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI