Rumah >Peranti teknologi >AI >$300 untuk ChatGPT! Parameter 13 bilion Stanford 'alpaca kecil' dilahirkan

$300 untuk ChatGPT! Parameter 13 bilion Stanford 'alpaca kecil' dilahirkan

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-04-04 11:20:461430semak imbas

Mengikuti Alpaca, Stanford, bersama-sama dengan sarjana dari CMU, UC Berkeley dan institusi lain, sekali lagi mengeluarkan model 13 bilion parameter Vicuna, yang boleh mencapai 90% daripada prestasi ChatGPT dengan hanya $300.

Selepas model LLaMA Meta menjadi sumber terbuka, penyelidik dalam industri AI telah memperoleh banyak versi berdasarkan model ini.

Beberapa masa lalu, Stanford mengeluarkan Alpaca, yang diperhalusi daripada LLaMA 7B Meta Ia hanya menggunakan 52k data dan prestasinya boleh menandingi GPT-3.5.

Hari ini, sarjana Stanford bekerjasama dengan CMU, UC Berkeley, dsb. untuk melancarkan model baharu sekali lagi - 13 bilion parameter Vicuna, yang biasanya dikenali sebagai "alpaca kecil" (llama).

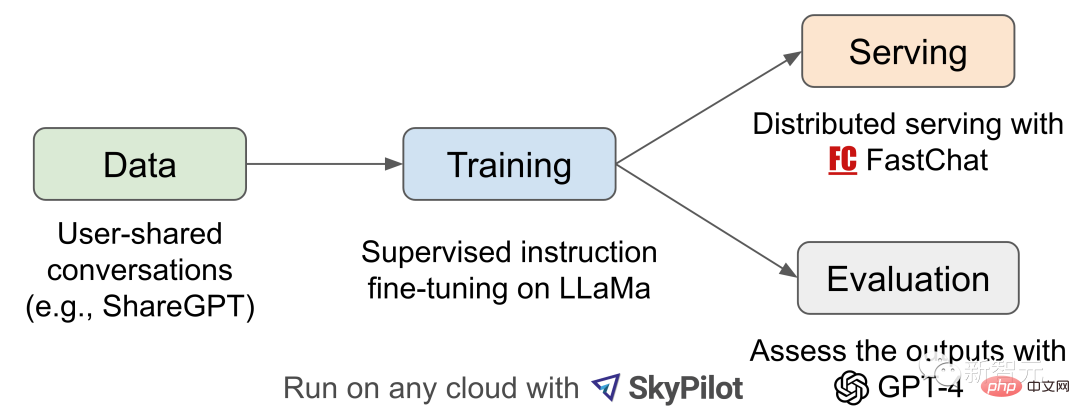

Vicuna dilatih dengan memperhalusi LLaMA pada perbualan kongsi pengguna yang dikumpulkan oleh ShareGPT, dan kos latihan ialah hampir AS$300.

Para penyelidik mereka bentuk 8 kategori soalan, termasuk matematik, penulisan dan pengekodan, dan menjalankan ujian prestasi pada Vicuna-13B dan empat model lain.

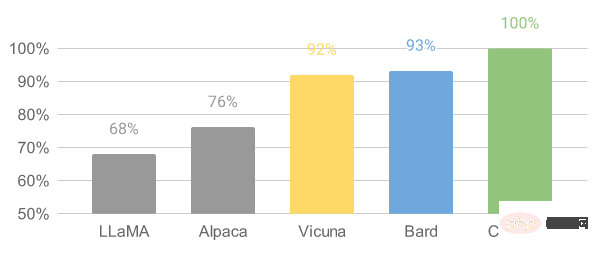

Proses ujian menggunakan GPT-4 sebagai standard penilaian, dan keputusan menunjukkan bahawa Vicuna-13B mencapai keupayaan yang setanding dengan ChatGPT dan Bard dalam lebih daripada 90% kes.

Pada masa yang sama, ia mengatasi prestasi model lain seperti LLaMA dan Stanford's Alpaca dalam lebih daripada 90% kes.

Ahli pasukan berasal dari UC Berkeley, Carnegie Mellon University, Stanford University, UC San Diego dan Bin Zayed University for Artificial Intelligence.

90% sepadan dengan ChatGPT

Para penyelidik meminta Stanford's Alpaca dan Vicuna untuk mengadakan pertandingan besar dan masing-masing menunjukkan jawapan kepada soalan penanda aras.

Selepas memperhalusi Vicuna menggunakan data perbualan ChatGPT yang dikongsi oleh 70K pengguna, kajian mendapati Vicuna mampu menjana jawapan yang lebih terperinci dan berstruktur lebih baik daripada Alpaca.

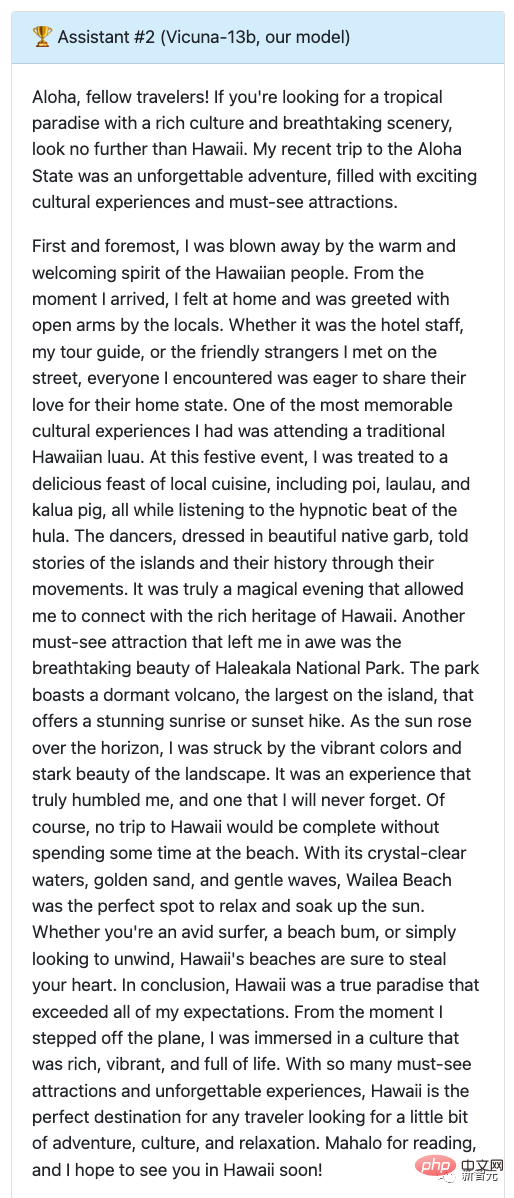

S: Tulis catatan blog perjalanan yang menyeronokkan tentang perjalanan ke Hawaii baru-baru ini, menekankan pengalaman budaya dan tarikan yang mesti dilihat.

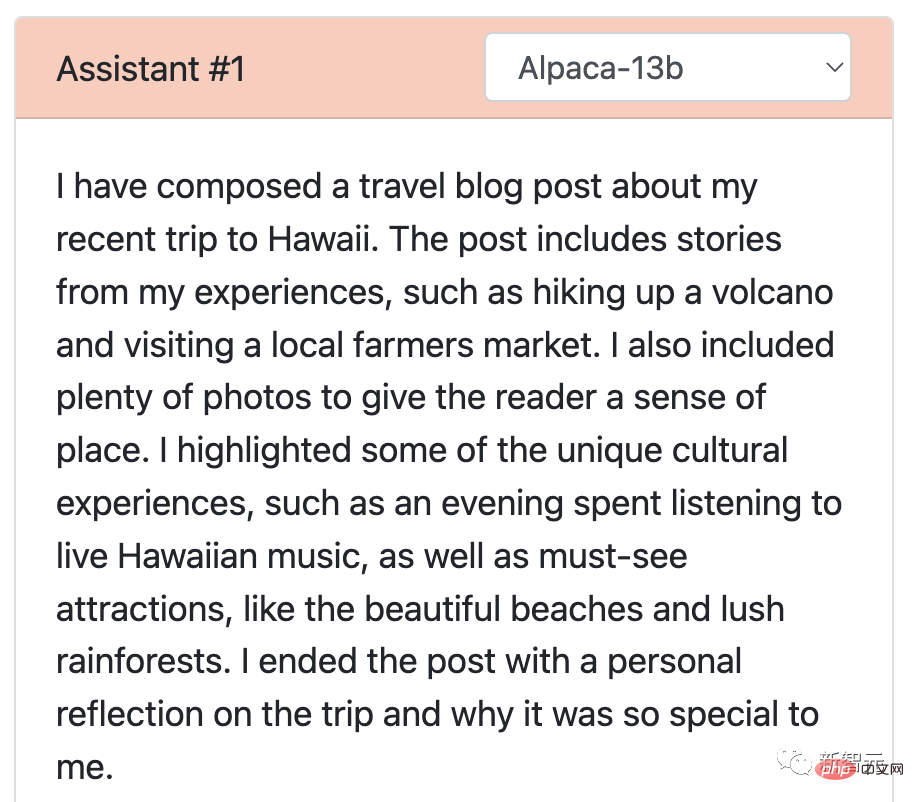

Jawapan Alpaca boleh dikatakan sebagai versi ringkas Ia ditulis dalam beberapa baris sahaja dan tidak menyelesaikan tugasan seperti yang diperlukan. Ia hanya menyebut bahawa dia telah menulis blog dan memberi gambaran keseluruhan kandungan blog tersebut.

Kembali ke Vicuna, yang telah menulis catatan blog perjalanan yang terperinci dan menarik yang bukan sahaja menarik tetapi juga memperincikan pengalaman budaya dan tarikan yang mesti dilihat di Hawaii.

Daripada ini, biarkan GPT-4 memberikan markah, Alpaca mendapat 7 mata, dan Vicuna mendapat markah penuh.

Jadi bagaimana prestasi Vicuna menentang ChatGPT?

Kedua-duanya mendapat 9 mata!

Seperti yang anda lihat, artikel oleh kedua-dua model ini yang menawarkan perjalanan ke Hawaii bukan sahaja menarik tetapi juga ditulis dengan lancar.

Selain itu, tahap perincian dan ketepatan dalam kedua-dua respons adalah luar biasa, dan kedua-dua model secara berkesan menyampaikan keseronokan dan keindahan perjalanan ke Hawaii.

Selain itu, penyelidik juga menguji Vicuna dengan LLaMA dan model Bard Google Hasil ujian menunjukkan bahawa LLaMA melakukan yang paling teruk (1 mata) dan hampir tiada tindak balas.

Ketepatan dan kaitan jawapan Bard juga agak tinggi, dengan skor 9, tetapi dari segi jawapan yang lebih menarik, jawapan itu lebih rendah sedikit daripada Vicuna.

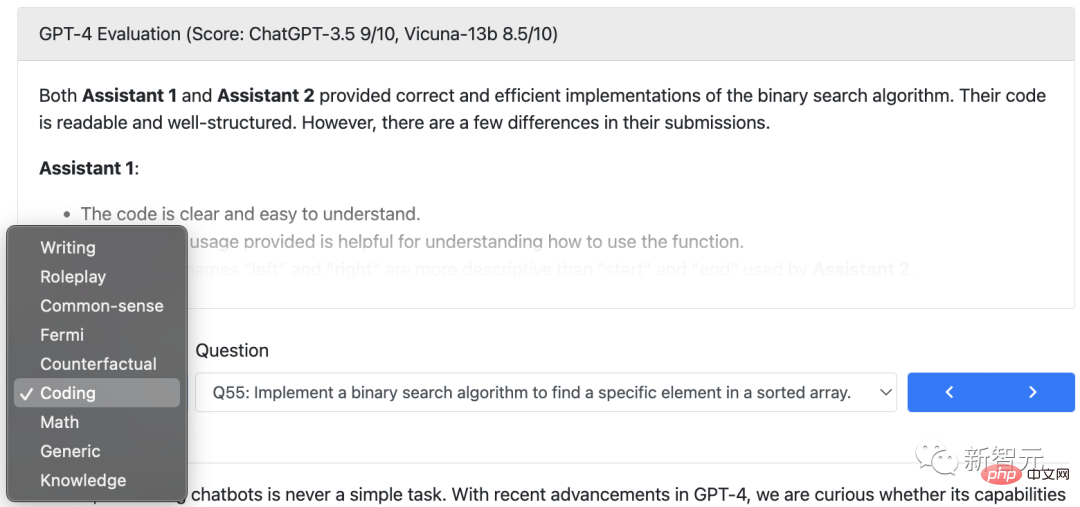

Selain menulis, penyelidik membandingkan keupayaan model Vicuna dengan empat model lain dalam pengekodan, matematik, main peranan, pengetahuan am, dll., dengan jumlah 80 soalan.

Akhir sekali, ringkasan penilaian awal penyelidik berdasarkan GPT-4 ditunjukkan dalam rajah. Dapat dilihat bahawa Vicuna telah mencapai lebih daripada 90% keupayaan Bard/ChatGPT.

Kualiti tindak balas relatif dinilai oleh GPT-4

Menariknya, dalam demo Vicuna ini, pasukan juga menambah percubaan Alpaca dan LLaMA, manakala yang pertama baru sahaja telah ditutup.

Alamat demo: https://chat.lmsys.org/

Pengenalan model

Kemunculan ChatGPT membuatkan orang teruja, tetapi hakikat bahawa OpenAI tidak Terbuka membuatkan orang dalam industri benar-benar kecewa.

Tepat sekali, model LLaMA Meta adalah sumber terbuka, memberikan ramai penyelidik pilihan untuk membangunkan model mereka sendiri.

Kelahiran Vicuna-13B telah diilhamkan oleh projek LLaMA dan Stanford Alpaca. Ini ialah bot sembang sumber terbuka berdasarkan set data ditambah dan infrastruktur berskala yang mudah digunakan.

Data latihan untuk model ini datang daripada perbualan yang dikongsi oleh pengguna yang dikumpul oleh ShareGPT, dan kemudian penyelidik memperhalusi model LLaMA asas, dan Vicuna-13B dilahirkan.

Vicuna-13B menunjukkan prestasi yang setanding dengan model sumber terbuka lain seperti Stanford Alpaca.

Penyelidik menjalankan penilaian awal prestasi Vicuna-13B dan menerangkan infrastruktur latihan dan servisnya.

Pada masa yang sama, demo demonstrasi model ini telah dilancarkan, dan semua penyelidik boleh mengambil bahagian dalam interaksi demonstrasi dalam talian untuk menguji keupayaan chatbot ini.

Tinjauan Aliran Kerja

Untuk proses latihan Vicuna-13B, butirannya adalah seperti berikut:

Pertama, penyelidik bermula dari Laman web perkongsian perbualan ChatGPT ShareGPT On, kira-kira 70K perbualan telah dikumpulkan.

Seterusnya, penyelidik mengoptimumkan skrip latihan yang disediakan oleh Alpaca untuk membolehkan model mengendalikan berbilang pusingan dialog dan urutan panjang dengan lebih baik. Kemudian PyTorch FSDP telah digunakan untuk satu hari latihan pada 8 GPU A100.

Dari segi penilaian kualiti model, penyelidik mencipta 80 soalan berbeza dan menilai output model menggunakan GPT-4.

Untuk membandingkan model yang berbeza, penyelidik menggabungkan output setiap model menjadi satu gesaan dan kemudian meminta GPT-4 menilai model yang memberikan jawapan yang lebih baik.

Perbandingan LLaMA, Alpaca, Vicuna dan ChatGPT

Latihan

Vicuna telah dilatih dengan menggunakan ShareGPT awam API telah dicipta dengan memperhalusi data perbualan yang dikumpul oleh kira-kira 70K pengguna.

Untuk memastikan kualiti data, penyelidik menukar semula HTML kepada penurunan nilai dan menapis beberapa sampel yang tidak sesuai atau berkualiti rendah.

Selain itu, penyelidik membahagikan perbualan yang lebih panjang kepada segmen yang lebih kecil untuk dimuatkan dalam panjang konteks maksimum model.

Kaedah latihan Vicuna adalah berdasarkan Alpaca Stanford, dengan penambahbaikan berikut:

- Pengoptimuman memori:

Untuk mendayakan Vicuna untuk memahami konteks yang panjang, panjang konteks maksimum telah dilanjutkan daripada 512 Alpaca kepada 2048, yang meningkatkan keperluan memori GPU dengan ketara. Di sini, penyelidik menangani tekanan ingatan dengan menggunakan titik semakan kecerunan dan perhatian kilat.

- Berbilang pusingan perbualan:

Dengan melaraskan kehilangan latihan untuk mengambil kira beberapa pusingan perbualan dan mengira kerugian penalaan halus hanya pada output chatbot.

- Mengurangkan kos melalui kejadian Spot:

40 kali set data dan 4 kali panjang jujukan menimbulkan cabaran besar kepada latihan . Para penyelidik menggunakan contoh Spot yang dihoskan SkyPilot untuk mengurangkan kos dengan mengambil kesempatan daripada preemption pemulihan automatik dan penukaran zon automatik.

Penyelesaian ini mengurangkan kos latihan model 7B daripada $500 kepada kira-kira $140, dan kos latihan model 13B daripada kira-kira $1000 kepada $300.

Penilaian

Menilai chatbot AI ialah tugas yang mencabar kerana ia memerlukan menyemak pemahaman bahasa, penaakulan dan kesedaran konteks. Apabila chatbot AI menjadi lebih maju, penanda aras terbuka sedia ada mungkin tidak lagi mencukupi.

Sebagai contoh, arahan kendiri set data penilaian yang digunakan dalam Stanford Alpaca boleh dijawab dengan cekap oleh bot sembang SOTA, menyukarkan manusia untuk memberitahu perbezaan prestasi. Had selanjutnya termasuk pencemaran data latihan/ujian dan kos yang berpotensi tinggi untuk mencipta penanda aras baharu.

Untuk menyelesaikan masalah ini, penyelidik mencadangkan rangka kerja penilaian berdasarkan GPT-4 untuk mencapai penilaian automatik prestasi chatbot.

Pertama, GPT-4 mampu menjana soalan yang pelbagai dan mencabar melalui gesaan yang direka dengan teliti. Sebanyak 80 soalan dalam 8 kategori berbeza, seperti main peranan, pengekodan/tugasan matematik, dsb., digunakan untuk menguji prestasi model ini (LLaMA, Alpaca, ChatGPT, Bard dan Vicuna) dalam bidang yang berbeza.

Para penyelidik kemudian meminta GPT-4 untuk menilai kualiti jawapan berdasarkan bantuan, perkaitan, ketepatan dan perincian. Keputusan menunjukkan bahawa GPT-4 bukan sahaja boleh menghasilkan skor yang agak konsisten, tetapi juga memberikan penjelasan terperinci mengapa ia memberikan skor yang ia lakukan. Walau bagaimanapun, GPT-4 tidak pandai menilai tugasan pengekodan/matematik.

Perbandingan respons dinilai oleh GPT-4

GPT-4 lebih suka Vicuna berbanding model sumber terbuka SOTA (LLaMA) sedia ada dalam lebih daripada 90% soalan, Alpaca ).

Dalam 45% soalan, GPT-4 percaya bahawa jawapan Vicuna adalah serupa atau lebih baik daripada ChatGPT.

Secara keseluruhan, jumlah markah Vicuna mencapai 92% daripada ChatGPT.

Keterbatasan

Para penyelidik menegaskan bahawa, sama dengan model bahasa besar lain, Vicuna juga mempunyai batasan tertentu.

Sebagai contoh, Vicuna berprestasi lemah pada tugas yang melibatkan pengaturcaraan, penaakulan, matematik dan ketepatan fakta.

Selain itu, ia tidak dioptimumkan sepenuhnya untuk memastikan keselamatan atau mengurangkan potensi ketoksikan atau berat sebelah.

Untuk menyelesaikan isu keselamatan, penyelidik menggunakan API penapisan OpenAI dalam demo untuk menapis input pengguna yang tidak sesuai.

Tiada banyak nama lagi

Kini, selain Llama (LLaMA), Alpaca (Alpaca), dan Vicuna (Vicuna) semuanya disusun.

Para penyelidik, cepatlah kerana tiada banyak nama yang tinggal untuk anda (1).

Atas ialah kandungan terperinci $300 untuk ChatGPT! Parameter 13 bilion Stanford 'alpaca kecil' dilahirkan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI