Rumah >Peranti teknologi >AI >'Noob Matematik' ChatGPT memahami pilihan manusia dengan baik! Menjana nombor rawak dalam talian adalah jawapan muktamad kepada alam semesta

'Noob Matematik' ChatGPT memahami pilihan manusia dengan baik! Menjana nombor rawak dalam talian adalah jawapan muktamad kepada alam semesta

- PHPzke hadapan

- 2023-04-01 11:48:262146semak imbas

ChatGPT juga memahami helah manusia apabila ia datang untuk menjana nombor rawak.

ChatGPT mungkin artis omong kosong dan penyebar maklumat salah, tetapi ia bukan "ahli matematik"!

Baru-baru ini, Colin Fraser, seorang saintis data di Meta, mendapati bahawa ChatGPT tidak boleh menjana nombor rawak yang benar-benar rawak, tetapi lebih seperti "nombor rawak manusia."

Melalui eksperimen, Fraser membuat kesimpulan: "ChatGPT sangat menyukai nombor 42 dan 7."

Netizen berkata bahawa ini bermakna manusia sangat menyukainya. nombor.

CtGPT juga menyukai "Jawapan Tertinggi kepada Alam Semesta"

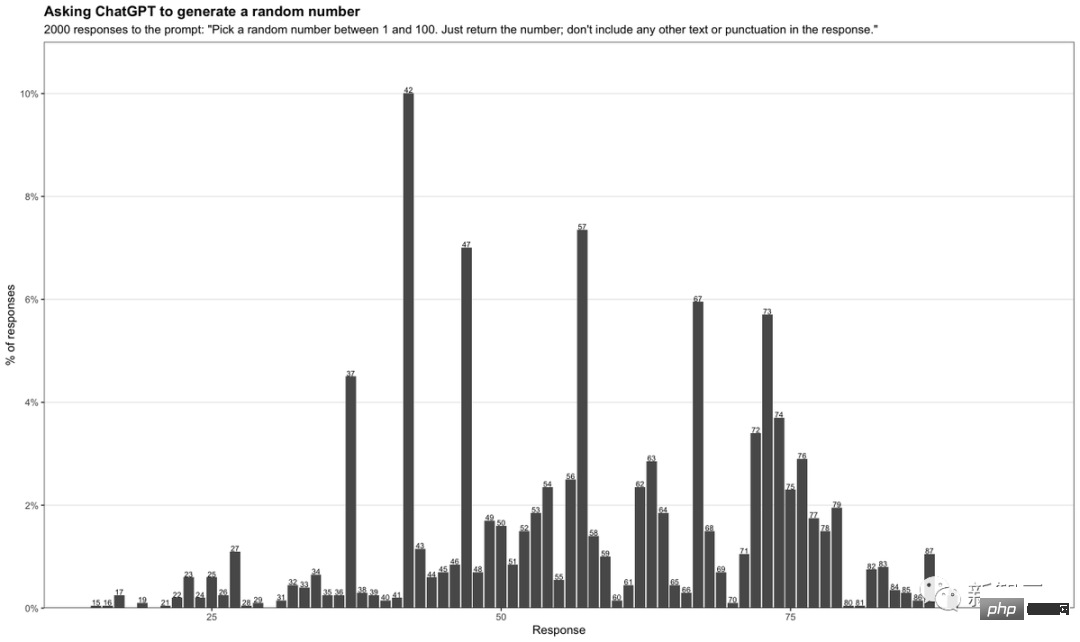

Dalam ujiannya, Fraser memasukkan gesaan seperti berikut:

" Pilih nombor rawak antara 1 dan 100. Hanya kembalikan nombor itu Jangan sertakan sebarang teks atau tanda baca lain dalam jawapan 》

Dengan membenarkan ChatGPT menjana nombor rawak antara 1 dan 100 setiap kali, Fraser mengumpulkan. 2,000 jawapan yang berbeza dan menyusunnya ke dalam jadual.

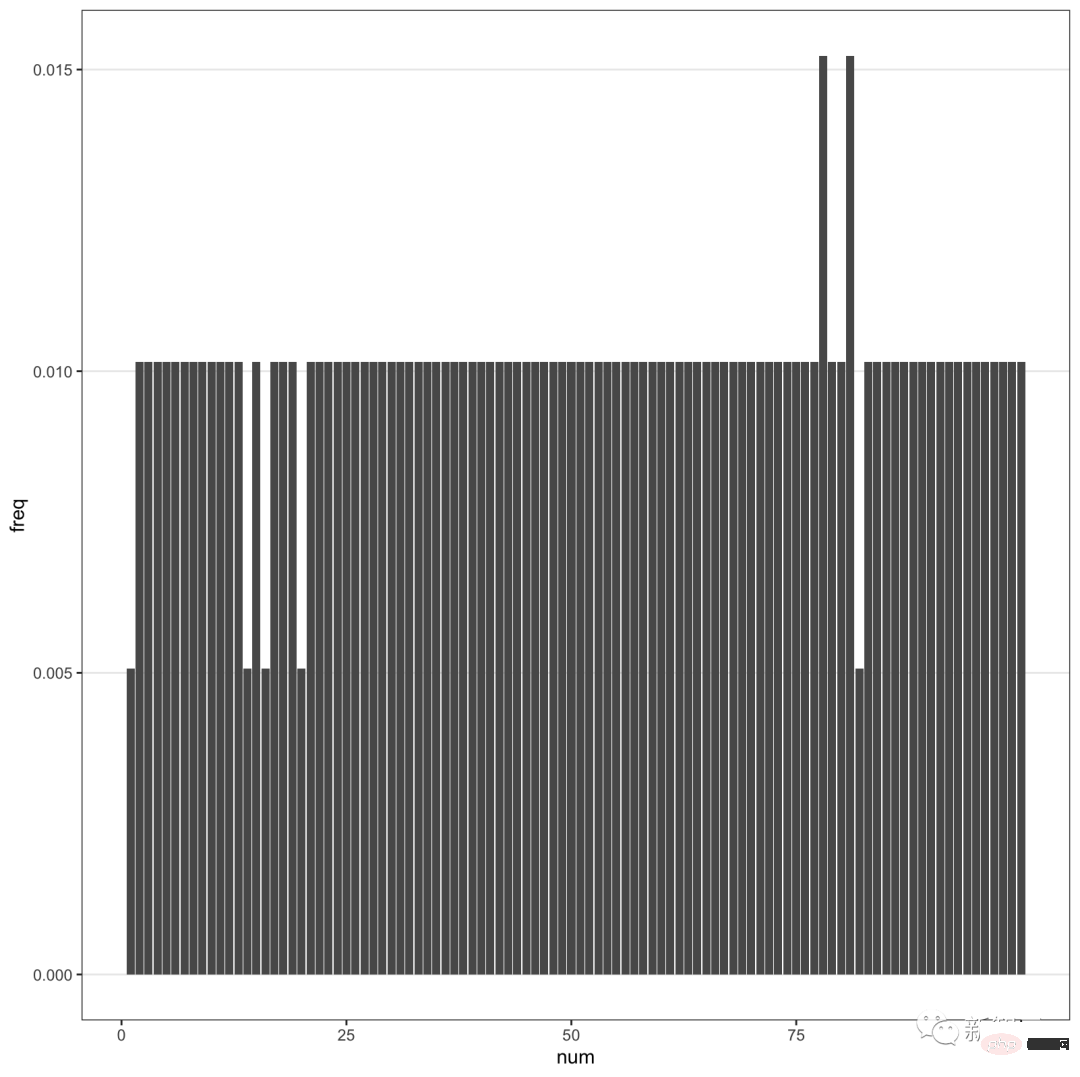

Seperti yang anda lihat, nombor 42 paling kerap muncul, sehingga 10%. Di samping itu, nombor yang mengandungi 7 kelihatan sangat kerap.

Terutamanya nombor antara 71-79 mempunyai kekerapan yang lebih tinggi. Antara nombor di luar julat ini, 7 juga sering muncul sebagai digit kedua.

Apakah maksud 42?

Semua orang yang telah membaca novel fiksyen sains blockbuster Douglas Adams "The Hitchhiker's Guide to the Galaxy" tahu bahawa 42 adalah "jawapan muktamad kepada kehidupan, alam semesta dan segala-galanya."

Ringkasnya, 42 dan 69 ialah nombor meme di Internet. Ini menunjukkan bahawa ChatGPT sebenarnya bukan penjana nombor rawak, tetapi hanya memilih nombor popular dalam kehidupan daripada set data besar yang dikumpul dalam talian.

Selain itu, 7 kerap muncul, yang betul-betul menggambarkan bahawa ChatGPT memenuhi pilihan manusia.

Dalam budaya Barat, 7 secara amnya dianggap sebagai nombor bertuah, dan terdapat pepatah Lucky 7. Sama seperti kita taksub dengan nombor 8.

Menariknya, Fraser juga mendapati bahawa GPT-4 seolah-olah mengimbangi perkara ini.

Apabila GPT-4 diminta untuk mendapatkan lebih banyak nombor, nombor rawak yang dikembalikannya terlalu sekata.

Ringkasnya, ChatGPT pada asasnya memberikan respons melalui ramalan, dan bukannya "berfikir" untuk menghasilkan jawapan.

Dapat dilihat bahawa chatbot yang disebut-sebut sebagai hampir mahakuasa masih agak bodoh.

Biarkan ia merancang perjalanan jalan raya untuk anda dan ia akan membuatkan anda berhenti di bandar yang tidak wujud. Atau, minta ia mengeluarkan nombor rawak, kemungkinan besar membuat keputusan berdasarkan meme popular.

Sesetengah netizen mencuba sendiri dan mendapati GPT-4 suka 42.

Apa gunanya ChatGPT jika ia hanya mengulangi klise dalam talian?

GPT-4, melanggar peraturan pembelajaran mesin

Kelahiran GPT-4 menarik, tetapi juga mengecewakan.

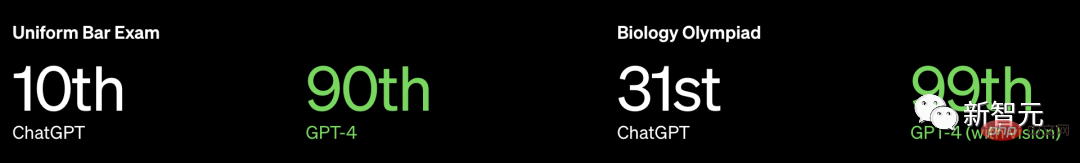

Bukan sahaja OpenAI tidak mengeluarkan lebih banyak maklumat tentang GPT-4, malah tidak mendedahkan saiz model, tetapi ia menekankan bahawa prestasinya menghancurkan manusia dalam banyak peperiksaan profesional dan standard.

Mengambil Peperiksaan Lesen Peguam BAR AS sebagai contoh, GPT3.5 boleh mencapai tahap 10%, dan GPT4 boleh mencapai tahap 90%.

Walau bagaimanapun, Profesor Arvind Narayanan dan pelajar kedoktoran Sayash Kapoor dari Jabatan Sains Komputer di Princeton University menulis bahawa

OpenAI mungkin telah diuji pada latihan data. Tambahan pula, tanda aras manusia tidak bermakna untuk chatbots.

Khususnya, OpenAI mungkin melanggar peraturan kardinal pembelajaran mesin: jangan menguji data latihan. Anda mesti tahu bahawa data ujian dan data latihan mesti diasingkan, jika tidak, masalah pemasangan yang berlebihan akan berlaku.

Selain masalah ini, ada masalah yang lebih besar.

Model bahasa menyelesaikan masalah secara berbeza daripada manusia, jadi keputusan ini mempunyai sedikit makna untuk prestasi robot apabila berhadapan dengan masalah dunia sebenar yang dihadapi oleh profesional. Tugas peguam bukan menjawab soalan peperiksaan bar sepanjang hari.

Masalah 1: Pencemaran data latihan

Untuk menilai keupayaan pengaturcaraan GPT-4, OpenAI telah dinilai pada Codeforces, tapak web untuk pertandingan pengaturcaraan Rusia.

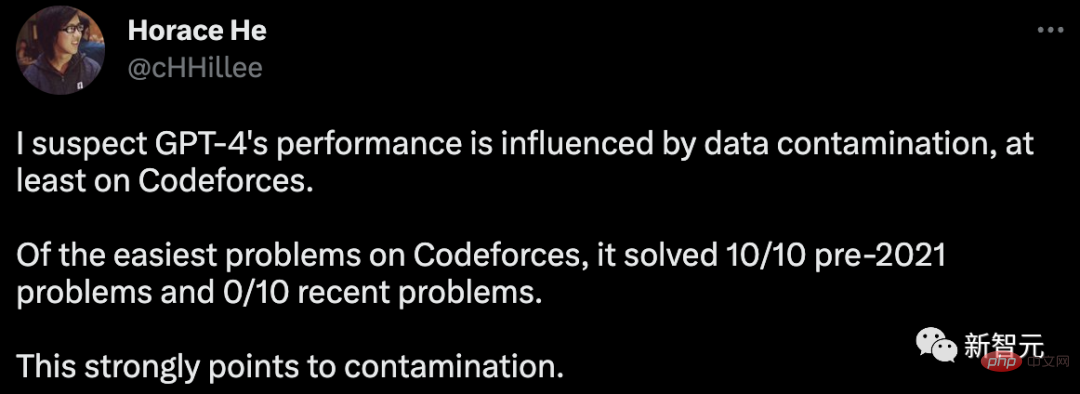

Anehnya, Horace He menegaskan dalam talian bahawa dalam klasifikasi mudah, GPT-4 menyelesaikan 10 masalah sebelum 2021, tetapi tiada satu pun daripada 10 masalah terbaharu diselesaikan.

Tarikh akhir data latihan untuk GPT-4 ialah September 2021.

Ini sangat menunjukkan bahawa model dapat mengingati penyelesaian dalam set latihannya, atau sekurang-kurangnya sebahagiannya mengingatinya, cukup untuk mengisi perkara yang tidak dapat diingati semula.

Untuk memberikan bukti lanjut bagi hipotesis ini, Arvind Narayanan menguji GPT-4 pada masalah persaingan Codeforces pada masa yang berbeza pada tahun 2021.

Didapati bahawa GPT-4 boleh menyelesaikan masalah pengelasan mudah sebelum 5 September, tetapi tiada masalah selepas 12 September dapat diselesaikan.

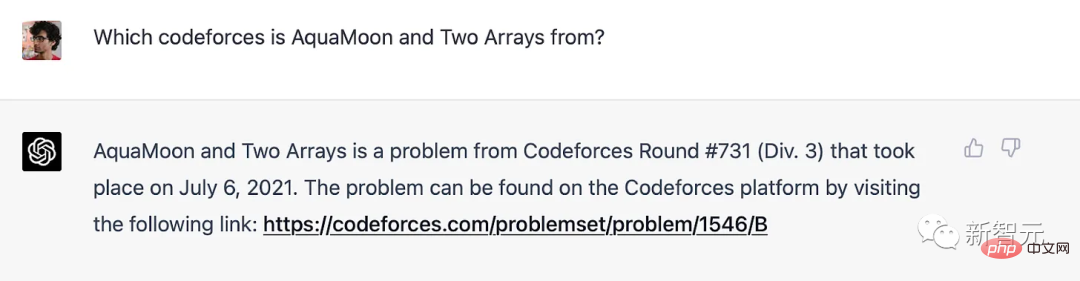

Malah, kami boleh membuktikan secara muktamad bahawa ia telah menghafal masalah dalam set latihan: apabila GPT-4 digesa dengan tajuk masalah Codeforces, ia termasuk pautan kepada padanan tepat di mana masalah itu muncul . Perlu diingat bahawa GPT-4 tidak mempunyai akses ke internet, jadi ingatan adalah satu-satunya penjelasan.

GPT-4 mengingati isu Codeforce sebelum tarikh akhir latihan

Untuk penanda aras selain pengaturcaraan, Profesor Narayanan berkata "Kami tidak tahu Bagaimana untuk memisahkan masalah mengikut tempoh masa dengan cara yang jelas, jadi sukar bagi OpenAI untuk mengelakkan pencemaran data Atas sebab yang sama, kami tidak boleh menjalankan eksperimen untuk menguji bagaimana prestasi berubah dengan tarikh 》

Walau bagaimanapun, ia boleh dilihat dari sisi yang satu lagi, jika ia adalah ingatan, maka GPT mestilah sangat sensitif terhadap perkataan soalan.

Pada bulan Februari, Melanie Mitchell, seorang profesor di Institut Santa Fe, memberikan contoh soalan peperiksaan MBA Sedikit mengubah beberapa butiran sudah cukup untuk menipu ChatGPT (GPT-3.5), dan kaedah ini sangat berguna. untuk seseorang anda tidak akan tertipu jika anda memberitahu.

Percubaan yang lebih terperinci seperti ini akan menjadi bernilai.

Disebabkan kekurangan ketelusan OpenAI, Profesor Narayanan tidak dapat mengatakan dengan pasti bahawa ia adalah masalah pencemaran data. Tetapi yang pasti pendekatan OpenAI untuk mengesan pencemaran adalah ceroboh:

“Kami menggunakan kaedah pemadanan subrentetan untuk mengukur pencemaran silang antara set data penilaian dan data pra-latihan diproses , mengalih keluar semua ruang dan simbol, hanya meninggalkan aksara (termasuk nombor Untuk setiap contoh penilaian, kami memilih tiga subrentetan panjang 50 aksara secara rawak (jika panjang contoh kurang daripada 50 aksara, keseluruhan contoh digunakan). dianggap berjaya jika mana-mana subrentetan penilaian sampel ialah subrentetan daripada contoh latihan yang diproses Ini menghasilkan senarai contoh tercemar yang kami buang dan jalankan semula untuk mendapatkan yang tidak dicemari "

Kaedah ini tahan ujian.

Jika masalah ujian wujud dalam set latihan tetapi nama dan nombor telah ditukar, ia tidak dapat dikesan. Kini kaedah yang lebih dipercayai tersedia, seperti jarak benam.

Jika OpenAI mahu menggunakan kaedah jarak benam, maka berapa banyak persamaan yang dianggap terlalu serupa? Tiada jawapan objektif untuk soalan ini.

Oleh itu, walaupun prestasi pada ujian piawai aneka pilihan kelihatan mudah, terdapat banyak subjektiviti yang terlibat.

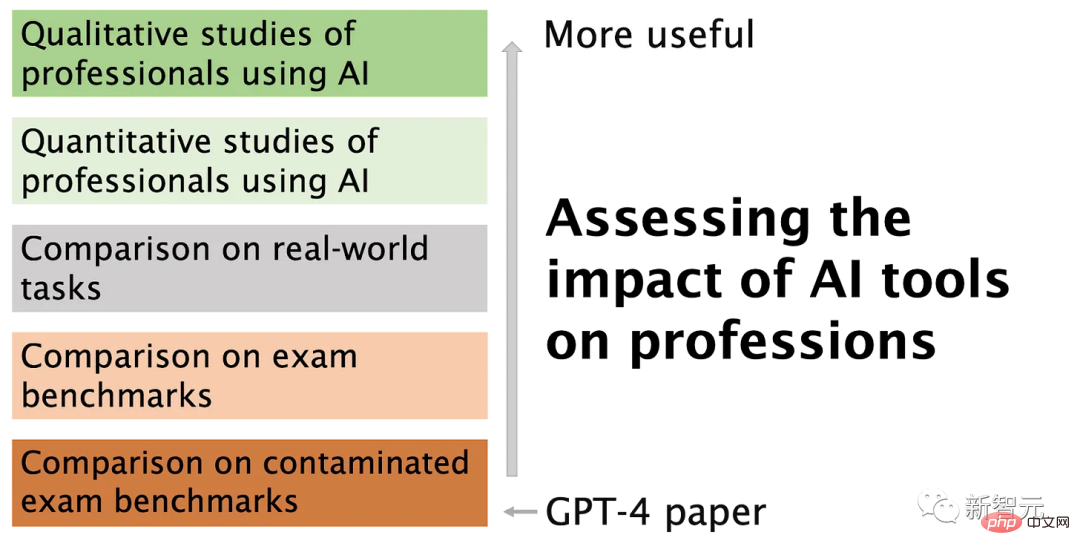

Masalah 2: Peperiksaan profesional bukanlah cara yang sah untuk membandingkan kebolehan manusia dan robot

Memori adalah seperti spektrum, walaupun model bahasa tidak melihat secara tepat satu dalam set latihan Masalahnya, disebabkan oleh korpus latihan yang besar, sudah pasti ia telah melihat banyak contoh yang hampir sama.

Ini bermakna ia boleh melarikan diri daripada penaakulan yang lebih mendalam. Oleh itu, keputusan penanda aras tidak memberikan kita bukti bahawa model bahasa memperoleh kemahiran penaakulan mendalam yang diperlukan oleh pengambil ujian manusia.

Dalam sesetengah tugas praktikal, inferens cetek GPT-4 mungkin cekap, tetapi ini tidak selalu berlaku.

Tanda aras telah digunakan secara meluas dalam perbandingan model yang besar dan telah dikritik oleh ramai kerana mengurangkan penilaian multidimensi kepada satu nombor.

Malangnya, amat dikesali OpenAI memilih untuk menggunakan sejumlah besar ujian ini dalam penilaian GPT-4, ditambah dengan langkah pengendalian pencemaran data yang tidak mencukupi.

Atas ialah kandungan terperinci 'Noob Matematik' ChatGPT memahami pilihan manusia dengan baik! Menjana nombor rawak dalam talian adalah jawapan muktamad kepada alam semesta. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI