Rumah >Peranti teknologi >AI >Li Zhifei: Lapan pemerhatian pada GPT-4, persaingan model besar pelbagai mod bermula

Li Zhifei: Lapan pemerhatian pada GPT-4, persaingan model besar pelbagai mod bermula

- 青灯夜游ke hadapan

- 2023-03-31 22:39:55953semak imbas

Dalam ujian piawai dan penanda aras lain, GPT-4 mengatasi model sebelumnya, berfungsi merentas berdozen bahasa dan juga boleh mengambil imej sebagai objek input, bermakna ia boleh memahami dalam konteks Niat sembang dan logik foto atau rajah.

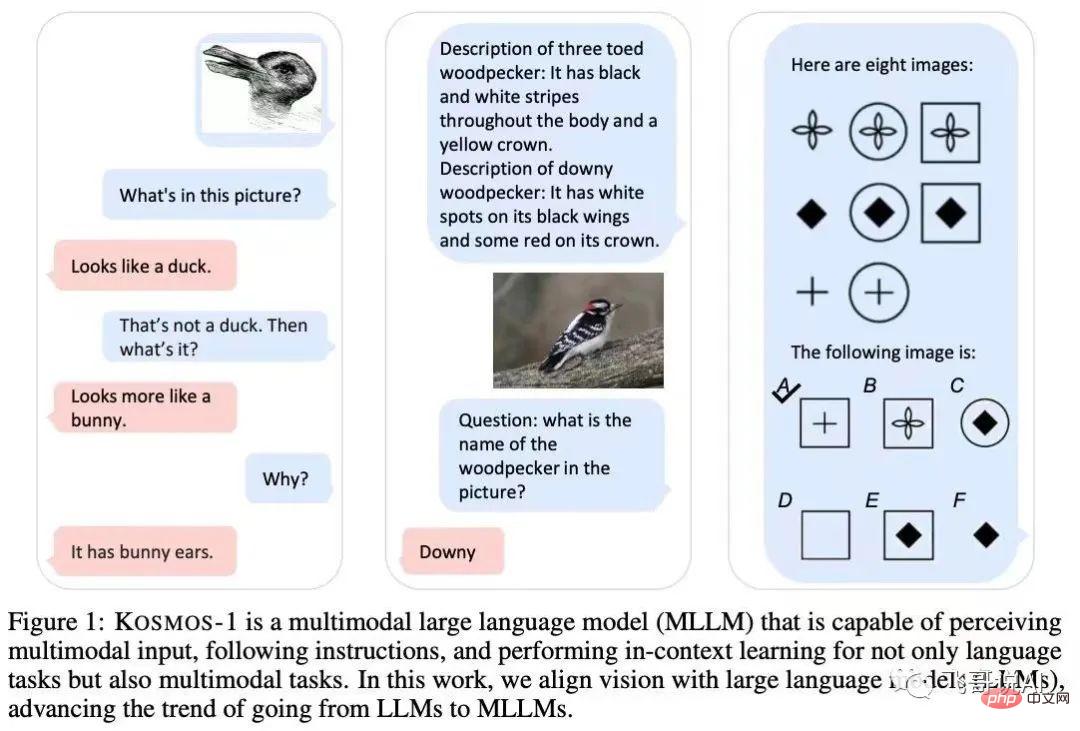

Sejak Microsoft mengeluarkan model berbilang modal Kosmos-1 pada awal Mac, ia telah menguji dan melaraskan model berbilang modal OpenAI dan menjadikannya lebih serasi dengan produk Microsoft sendiri.

Seperti yang dijangkakan, dengan keluaran GPT-4, Microsoft juga secara rasmi menunjukkan tangannya Bing Baharu telah pun menggunakan GPT-4.

Model bahasa yang digunakan oleh ChatGPT ialah GPT-3.5 Apabila bercakap tentang bagaimana GPT-4 lebih berkuasa daripada versi sebelumnya, OpenAI berkata walaupun kedua-dua versi ini berada di rawak Perbincangan kelihatan serupa, tetapi "perbezaan muncul apabila kerumitan tugas mencapai ambang yang mencukupi."

Raja dinobatkan? Lapan pemerhatian tentang GPT-4

1 Lagi menakjubkan, lebih baik daripada manusia

Jika siri model GPT-3 membuktikan kepada semua orang bahawa AI boleh digunakan dalam sesuatu. model Ia melaksanakan pelbagai tugas di dalamnya dan menunjukkan laluan untuk mencapai AGI GPT-4 telah mencapai tahap manusia dalam banyak tugas, malah berprestasi lebih baik daripada manusia. GPT-4 telah melepasi 90% manusia dalam banyak peperiksaan akademik profesional Contohnya, dalam peperiksaan bar olok-olok, markahnya berada dalam 10% teratas peserta ujian. Bagaimanakah seharusnya pelbagai sekolah rendah dan menengah, universiti dan pendidikan profesional bertindak balas terhadap perkara ini?

2. Alkimia "Scientific"

Walaupun OpenAI tidak mengumumkan parameter khusus kali ini, anda boleh meneka bahawa model GPT-4 mestilah tidak kecil terdapat terlalu banyak model, ia akan Ini bermakna kos latihan yang tinggi. Pada masa yang sama, melatih model juga hampir sama dengan "memurnikan elixir" dan memerlukan banyak eksperimen Jika eksperimen ini dilatih dalam persekitaran sebenar, tidak semua orang boleh menanggung tekanan kos yang tinggi.

Untuk tujuan ini, OpenAI dengan bijak telah membangunkan apa yang dipanggil "penskalaan yang boleh diramalkan". Dengan cara ini, latihan alkimia "bertuah" berskala besar asal telah dinaik taraf kepada alkimia "separa saintifik".

3. Penilaian Crowdsourcing, membunuh dua burung dengan satu batu

Kali ini kami menyediakan OpenAI Evals sumber terbuka dengan cara yang sangat "pintar", terbuka kepada semua orang melalui crowdsourcing Pembangun atau peminat dijemput untuk menggunakan Evals untuk menguji model dan pada masa yang sama melibatkan ekosistem pembangun. Kaedah ini bukan sahaja memberikan semua orang rasa penyertaan, tetapi juga membolehkan semua orang untuk membantu menilai dan menambah baik sistem secara percuma OpenAI terus mendapatkan soalan dan maklum balas, membunuh dua burung dengan satu batu.

4. Pencegahan kebocoran kejuruteraan

Kali ini Kad Sistem turut dikeluarkan, iaitu Alat "menampal" terbuka yang boleh menemui kelemahan dan mengurangkan masalah "karut" model bahasa. Pelbagai tampalan telah digunakan pada sistem untuk pra-pemprosesan dan pasca-pemprosesan, dan kod tersebut akan dibuka kemudian untuk mengumpul sumber keupayaan tampalan kepada semua orang OpenAI mungkin boleh membenarkan semua orang membantunya pada masa hadapan. Ini menandakan bahawa LLM akhirnya telah beralih daripada tugas ramalan token seterusnya yang elegan dan mudah kepada pelbagai penggodaman kejuruteraan yang tidak kemas.

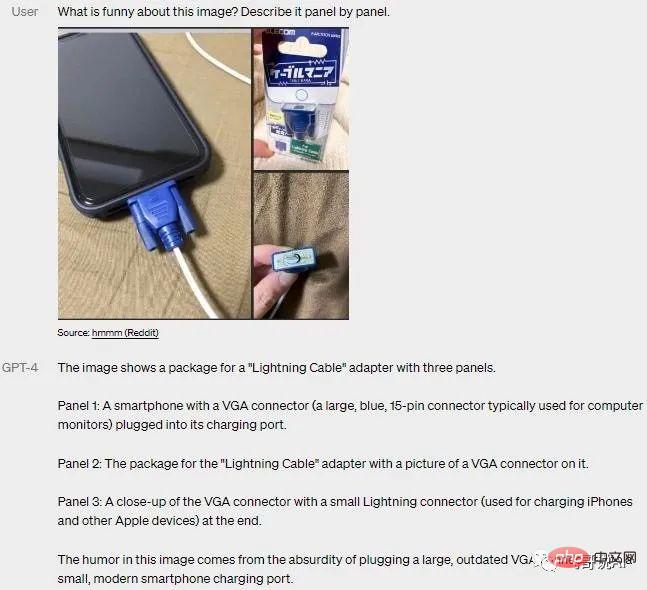

5. Berbilang modal

Sejak Microsoft di Jerman mendedahkan minggu lepas bahawa GPT-4 adalah berbilang modal, orang ramai amat dinanti-nantikan.

GPT-4 telah wujud sejak sekian lama Multi-modaliti yang dikenali sebagai "setanding dengan otak manusia" sebenarnya tidak jauh berbeza dengan keupayaan multi-modal yang diterangkan dalam banyak makalah semasa ialah The few-shot model teks dan rantai logik (COT) digabungkan Premis di sini ialah LLM teks dengan keupayaan asas yang baik dan pelbagai mod diperlukan, yang akan menghasilkan keputusan yang baik.

6 Lepaskan "King Explosion" secara terancang

Menurut video demo OpenAI yang menunjukkan GPT-4. , GPT-4 menamatkan latihan seawal Ogos tahun lalu, tetapi hanya dikeluarkan hari ini Selebihnya masa dihabiskan untuk sejumlah besar ujian, pelbagai pembetulan pepijat, dan yang paling penting, penyingkiran penjanaan kandungan berbahaya.

Sementara semua orang masih tenggelam dalam keupayaan penjanaan ChatGPT yang menakjubkan, OpenAI telah menyelesaikan GPT-4 gelombang jurutera Google ini mungkin perlu berjaga lewat untuk mengejar semula?

7 OpenAI tidak lagi Dibuka

OpenAI tidak menyebut sebarang parameter model dan saiz data dalam kertas awam (parameter GPT-4 yang dihantar dalam talian telah mencapai 100 Trillions), dan tidak ada prinsip teknikal Penjelasannya adalah untuk kepentingan orang ramai Saya takut bahawa selepas semua orang belajar bagaimana untuk membuat GPT-4, mereka akan menggunakannya untuk melakukan kejahatan dan mencetuskan beberapa perkara yang tidak terkawal. Saya secara peribadi tidak bersetuju dengan ini sama sekali. Tidak ada amalan perak di sini.

8. Tumpukan usaha anda pada perkara besar

Di samping pelbagai "kemahiran menunjuk-nunjuk", kertas kerja itu juga menggunakan tiga halaman untuk menyenaraikan semua orang yang telah menyumbang kepada sistem GPT-4 yang berbeza Dianggarkan secara kasarnya terdapat lebih daripada seratus orang, yang mana sekali lagi mencerminkan perpaduan dan tahap kerjasama yang tinggi di kalangan ahli pasukan dalaman OpenAI. Membandingkan ini dengan keupayaan pertempuran pasukan syarikat lain, adakah ia agak jauh ketinggalan dari segi usaha bersatu?

Pada masa ini, model besar berbilang modal telah menjadi trend dan hala tuju penting untuk pembangunan model AI besar Dalam "perlumbaan senjata" AI model besar ini, gergasi teknologi seperti Google, Microsoft dan DeepMind sedang giat melancarkan model besar berbilang modal (MLLM) atau Model Besar (LLM).

Membuka pusingan baharu perlumbaan senjata: model besar pelbagai mod

Microsoft: Kosmos-1

Microsoft mengeluarkan Kosmos-1, model berbilang modal dengan 1.6 bilion parameter pada awal Mac Struktur rangkaian adalah berdasarkan model bahasa kausal Transformer. Antaranya, penyahkod Transformer digunakan sebagai antara muka universal untuk input berbilang modal.

Selain pelbagai tugas bahasa semula jadi, model Kosmos-1 mampu mengendalikan pelbagai tugas intensif secara persepsi, seperti dialog visual, penjelasan visual, jawapan soalan visual, sari kata imej, persamaan matematik mudah , OCR dan penerangan Pengelasan imej tangkapan sifar.

Google: PaLM-E

Pada awal Mac, pasukan penyelidik daripada Google dan Universiti Teknikal Berlin melancarkan yang terbesar model bahasa visual sehingga kini ——PaLM-E, dengan sehingga 562 bilion parameter (PaLM-540B+ViT-22B).

PaLM-E ialah model penyahkod besar sahaja yang mampu menjana pelengkapan teks secara autoregresif diberi awalan atau gesaan. Dengan menambahkan pengekod pada model, model boleh mengekodkan data imej atau deria ke dalam satu siri vektor dengan saiz yang sama dengan teg bahasa dan menggunakan ini sebagai input untuk ramalan token seterusnya untuk latihan hujung ke hujung.

DeepMind: Flamingo

DeepMind melancarkan model bahasa visual Flamingo pada April tahun lepas Model ini menggunakan imej, video dan teks sebagai gesaan (gesaan) untuk mengeluarkan bahasa yang berkaitan Sebilangan kecil contoh khusus diperlukan untuk menyelesaikan banyak masalah tanpa latihan tambahan.

Latih model dengan memasukkan silang gambar (video) dan teks, supaya model mempunyai keupayaan penaakulan jujukan berbilang mod beberapa tangkapan dan melengkapkan "penyiapan penerangan teks, VQA / Text-VQA" dan fungsi lain Tugasan.

Pada masa ini, model berbilang modal yang besar telah menunjukkan lebih banyak kemungkinan aplikasi Selain gambar rajah Vincentian yang agak matang, sejumlah besar aplikasi seperti interaksi manusia-komputer, kawalan robot, carian imej dan penjanaan suara mempunyai. muncul satu demi satu.

Diambil bersama, GPT-4 tidak akan menjadi AGI, tetapi model besar berbilang modal sudah menjadi hala tuju pembangunan yang jelas dan pasti. Mewujudkan model asas berbilang modal yang bersatu, merentas senario, berbilang tugas akan menjadi salah satu aliran arus perdana dalam pembangunan kecerdasan buatan.

Hugo berkata, "Sains menemui imaginasi pada peringkat terakhirnya."

Atas ialah kandungan terperinci Li Zhifei: Lapan pemerhatian pada GPT-4, persaingan model besar pelbagai mod bermula. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI