Rumah >Peranti teknologi >AI >Untuk mengimbangi kekurangan parameter 7 bilion Stanford 'Alpaca', model besar yang mahir dalam bahasa Cina ada di sini dan telah menjadi sumber terbuka

Untuk mengimbangi kekurangan parameter 7 bilion Stanford 'Alpaca', model besar yang mahir dalam bahasa Cina ada di sini dan telah menjadi sumber terbuka

- PHPzke hadapan

- 2023-03-31 22:39:141892semak imbas

BELLE berasaskan Stanford Alpaca dan dioptimumkan untuk penalaan Model Cina hanya menggunakan data yang dihasilkan oleh ChatGPT (tidak termasuk data lain).

Sudah hampir empat bulan sejak keluaran awal ChatGPT. Apabila GPT-4 dikeluarkan minggu lepas, ChatGPT segera melancarkan versi baharu. Tetapi rahsia yang terkenal ialah ChatGPT mahupun GPT-4 berkemungkinan bukan sumber terbuka. Ditambah dengan pelaburan besar dalam kuasa pengkomputeran dan data latihan besar-besaran, terdapat banyak halangan untuk komuniti penyelidikan untuk meniru proses pelaksanaannya.

Menghadapi serangan model besar seperti ChatGPT, penggantian sumber terbuka adalah pilihan yang baik. Pada awal bulan ini, Meta "bersumberkan terbuka" siri model besar baharu - LLaMA (Model Bahasa Besar Meta AI), dengan saiz parameter antara 7 bilion hingga 65 bilion. Model 13 bilion parameter LLaMA mengatasi 175 bilion parameter GPT-3 "pada kebanyakan penanda aras" dan boleh dijalankan pada satu GPU V100.

Beberapa hari kemudian, Stanford memperhalusi model baharu Alpaca dengan 7 bilion parameter berdasarkan LLaMA 7B Mereka menggunakan teknologi yang diperkenalkan dalam kertas Arahan Kendiri untuk menjana data arahan 52K dan membuat beberapa pengubahsuaian. Dalam penilaian awal manusia, model Alpaca 7B menunjukkan prestasi yang sama dengan model teks-davinci-003 (GPT-3.5) pada penilaian arahan Arahan Kendiri.

Tetapi malangnya, tugas benih Alpaca semuanya dalam bahasa Inggeris, dan data yang dikumpul juga dalam bahasa Inggeris, jadi model terlatih tidak dioptimumkan untuk bahasa Cina. Untuk meningkatkan keberkesanan model dialog dalam bahasa Cina, adakah cara yang lebih baik? Jangan risau, projek yang diperkenalkan seterusnya dapat menyelesaikan masalah ini dengan baik.

Model besar dialog Cina sumber terbuka BELLE (Bloom-Enhanced Large Language model Engine) dengan 7 bilion parameter ada di sini. Ia berdasarkan Alpaca Stanford, tetapi telah Cina dioptimumkan dan membuat beberapa pengubahsuaian pada kod yang dijana Bukan itu sahaja, penalaan model hanya menggunakan data yang dihasilkan oleh ChatGPT (tidak mengandungi sebarang data lain).

Dari segi data, projek sumber terbuka kod pengumpulan data berdasarkan kod ini, kira-kira 1 juta keping data Cina telah dijana dengan 50,000 keping data bahasa Inggeris daripada Alpaca dilatih pada model BLOOMZ-7B Pusat pemeriksaan dimuat naik ke Muka Memeluk.

Alamat Muka Berpeluk: https://huggingface.co/BelleGroup

Pengarang projek menyatakan: Projek ini bertujuan untuk mempromosikan pembangunan komuniti sumber terbuka model besar dialog Cina.

Alamat projek: https://github.com/LianjiaTech/BELLE

Pengenalan projek

Projek ini terutamanya merangkumi empat berikut bahagian Kandungan:

- 175 tugas benih Cina

- Kod untuk menjana data

- 0.5M data yang dijana

- Berdasarkan pengoptimuman BLOOMZ-7B1-mt Model terakhir

Keluaran data

1 zh_seed_tasks.jsonl: Mengandungi 175 tugasan benih, sampelnya adalah seperti berikut

{" id ": "seed_task_20", "name": "horror_movie_opening", "instruction": "Anda perlu menulis adegan pembukaan kreatif untuk filem seram", "instances": [{"input": "","output. ":" Matahari telah terbenam, meninggalkan sebuah bandar yang gelap di belakang Angin sepoi-sepoi bertiup melalui jalan-jalan yang kosong, memberikan kesejukan kepada sesiapa sahaja yang keluar dari luar -jerit kencang memecah kesunyian, diikuti dengan bunyi kaca yang pecah, dan kelihatan satu figura berlari ke arah tengah bandar Apabila saya semakin dekat, saya dapat melihat dengan jelas bahawa ia adalah seorang wanita muda dengan darah di seluruh tubuhnya . "}],"is_classification": false}

2. prompt_cn.txt: Gesaan digunakan untuk menjananya

<.>3. 0.5J data yang dijanaPenjanaan data

Ikuti kaedah Alpaca: pip install -r requirements.txt eksport OPENAI_API_KEY=YOUR_API_KEY

python generate_instruction.py generate_>python generate_instruction.py generate_instruction_following_data

--api=chat --model_name=gpt- 3.5-turbo

Fail output berada dalam Belle.train.json dan boleh ditapis secara manual sebelum digunakan.

Penalaan Model

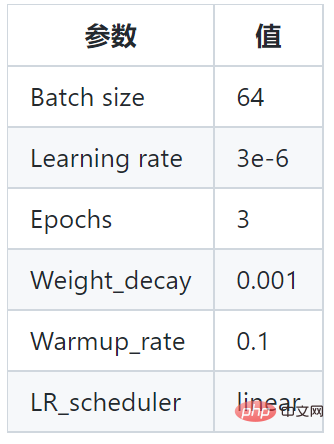

Projek ini berdasarkan model BLOOMZ-7B1-mt dan model latihan Belle.train.json Parameter khusus adalah seperti berikut:

Selain itu, projek ini juga menggunakan set data pembelajaran arahan dengan saiz yang berbeza (200,000, 600,000, 1 juta dan 2 juta sampel) untuk melatih model dan versi model yang berbeza diperolehi adalah seperti berikut:

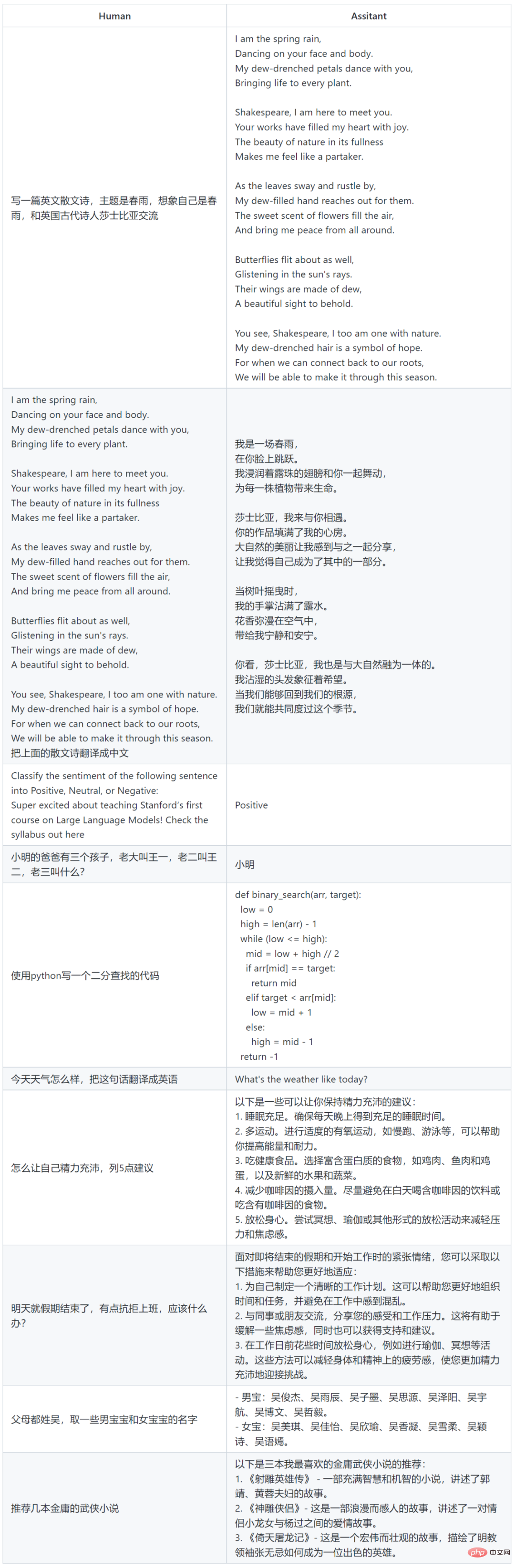

Contoh penggunaan model

Batasan dan Sekatan Penggunaan

Model SFT yang dilatih berdasarkan data semasa dan model asas masih mempunyai masalah berikut dari segi keberkesanan:

- Arahan yang melibatkan fakta mungkin menghasilkan jawapan yang salah yang bertentangan dengan fakta.

- Arahan berbahaya tidak dapat dikenal pasti dengan baik, mengakibatkan kenyataan berbahaya.

- Keupayaan model masih perlu dipertingkatkan dalam beberapa senario yang melibatkan penaakulan, pengekodan, dsb.

- Berdasarkan had model di atas, projek ini memerlukan pembangun hanya menggunakan kod sumber terbuka, data, model dan terbitan seterusnya yang dijana oleh projek ini untuk tujuan penyelidikan, dan tidak boleh menggunakannya untuk tujuan komersial, atau untuk tujuan lain. tujuan yang akan membahayakan masyarakat.

Atas ialah kandungan terperinci Untuk mengimbangi kekurangan parameter 7 bilion Stanford 'Alpaca', model besar yang mahir dalam bahasa Cina ada di sini dan telah menjadi sumber terbuka. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI