Qwen baru sahaja mengeluarkan 8 model baru sebagai sebahagian daripada keluarga terbarunya - Qwen3, mempamerkan keupayaan yang menjanjikan. Model perdana, QWEN3-235B-A22B, mengatasi kebanyakan model lain termasuk DeepSeek-R1, Openai's O1, O3-Mini, Grok 3, dan Gemini 2.5-Pro, dalam tanda aras standard. Sementara itu, QWEN3-30B-A3B kecil mengalahkan QWQ-32B yang mempunyai kira-kira 10 kali parameter diaktifkan sebagai model baru. Dengan keupayaan maju seperti itu, model -model ini terbukti menjadi pilihan yang baik untuk pelbagai aplikasi. Dalam artikel ini, kami akan meneroka ciri -ciri semua model QWEN3 dan belajar cara menggunakannya untuk membina sistem RAG dan agen AI.

Jadual Kandungan

- Apa itu Qwen3?

- Ciri -ciri utama Qwen3

- Cara Mengakses Model Qwen3 melalui API

- Menggunakan Qwen3 untuk kuasa penyelesaian AI anda

- Prasyarat

- Membina ejen AI menggunakan qwen3

- Membina sistem kain menggunakan qwen3

- Aplikasi QWEN3

- Kesimpulan

- Soalan yang sering ditanya

Apa itu Qwen3?

Qwen3 adalah siri terbaru model bahasa besar (LLMS) dalam keluarga Qwen, yang terdiri daripada 8 model yang berbeza. Ini termasuk QWEN3-235B-A22B, QWEN3-30B-A3B, QWEN3-32B, QWEN3-14B, QWEN3-8B, QWEN3-4B, QWEN3-1.7B, dan QWEN3-0.6B. Semua model ini dikeluarkan di bawah lesen Apache 2.0, menjadikannya secara bebas untuk individu, pemaju, dan perusahaan.

Walaupun 6 model ini padat, bermakna mereka secara aktif menggunakan semua parameter semasa kesimpulan dan latihan, 2 daripadanya berwajaran terbuka:

- QWEN3-235B-A22B: Model besar dengan 235 bilion parameter, di mana 22 bilion parameter diaktifkan.

- QWEN3-30B-A3B: MOE yang lebih kecil dengan 30 bilion parameter dan 3 bilion parameter aktif.

Berikut adalah perbandingan terperinci semua model 8 QWEN3:

| Model | Lapisan | Kepala (q/kV) | Tali embedding | Panjang konteks |

| Qwen3-0.6b | 28 | 16/8 | Ya | 32K |

| Qwen3-1.7b | 28 | 16/8 | Ya | 32K |

| Qwen3-4b | 36 | 32/8 | Ya | 32K |

| Qwen3-8b | 36 | 32/8 | Tidak | 128k |

| Qwen3-14b | 40 | 40/8 | Tidak | 128k |

| Qwen3-32b | 64 | 64/8 | Tidak | 128k |

| QWEN3-30B-A3B | 48 | 32/4 | Tidak | 128k |

| QWEN3-235B-A22B | 94 | 64/4 | Tidak | 128k |

Inilah yang dikatakan meja:

- Lapisan: Lapisan mewakili bilangan blok pengubah yang digunakan. Ia termasuk mekanisme perhatian diri pelbagai kepala, rangkaian ke hadapan, pengekodan kedudukan, normalisasi lapisan, dan sambungan sisa. Oleh itu, apabila saya katakan QWEN3-30B-A3B mempunyai 48 lapisan, ini bermakna model menggunakan 48 blok pengubah, disusun secara berurutan atau selari.

- Kepala: Transformers menggunakan perhatian multi-kepala, yang memisahkan mekanisme perhatiannya ke beberapa kepala, masing-masing untuk mempelajari aspek baru dari data. Di sini, q/kv mewakili:

- Q (Kepala pertanyaan): Jumlah bilangan kepala perhatian yang digunakan untuk menjana pertanyaan.

- KV (Kunci dan Nilai): Bilangan kepala kunci/nilai setiap blok perhatian.

Nota: Kepala perhatian ini untuk kunci, pertanyaan, dan nilai adalah sama sekali berbeza daripada vektor kunci, pertanyaan, dan nilai yang dihasilkan oleh perhatian diri.

Juga Baca: Model Qwen3: Cara Mengakses, Prestasi, Ciri, dan Aplikasi

Ciri -ciri utama Qwen3

Berikut adalah beberapa ciri utama model QWEN3:

- Pra-latihan: Proses pra-latihan terdiri daripada tiga peringkat:

- Pada peringkat pertama, model itu pretrained pada lebih daripada 30 trilion token dengan panjang konteks token 4K. Ini mengajar model kemahiran bahasa asas dan pengetahuan umum.

- Pada peringkat kedua, kualiti data telah diperbaiki dengan meningkatkan perkadaran data intensif pengetahuan seperti STEM, pengekodan, dan tugas pemikiran. Model itu kemudian dilatih lebih daripada 5 trilion token tambahan.

- Pada peringkat akhir, data konteks berkualiti tinggi yang berkualiti tinggi digunakan dengan meningkatkan panjang konteks kepada token 32k. Ini dilakukan untuk memastikan model dapat mengendalikan input yang lebih lama dengan berkesan.

- Post-Training: Untuk membangunkan model hibrid yang mampu menunaikan penalaran langkah demi langkah dan pesat, saluran paip latihan 4 peringkat telah dilaksanakan. Ini terdiri daripada:

- Rantaian panjang (COT)

- Pembelajaran Penguatkuasaan Berasaskan Perundangan (RL)

- Fusion mod pemikiran

- Umum RL

- Mod Pemikiran Hibrid: Model Qwen3 Gunakan pendekatan hibrid untuk menyelesaikan masalah, yang menampilkan dua mod baru:

- Mod Pemikiran: Dalam mod ini, model mengambil masa dengan melanggar pernyataan masalah yang rumit ke dalam langkah -langkah kecil dan prosedur untuk menyelesaikannya.

- Mod tidak berfikir: Dalam mod ini, model ini memberikan hasil yang cepat dan kebanyakannya sesuai untuk soalan yang lebih mudah.

- Sokongan berbilang bahasa: Model Qwen3 menyokong 119 bahasa dan dialek. Ini membantu pengguna dari seluruh dunia mendapat manfaat daripada model -model ini.

- Keupayaan Agentik Improvised: Qwen telah mengoptimumkan model QWEN3 untuk pengekodan dan keupayaan agensi yang lebih baik, juga menyokong Protokol Konteks Model (MCP).

Cara Mengakses Model Qwen3 melalui API

Untuk menggunakan model QWEN3, kami akan mengaksesnya melalui API menggunakan API OpenRouter. Inilah cara melakukannya:

- Buat akaun di OpenRouter dan pergi ke bar carian model untuk mencari API untuk model itu.

- Pilih model pilihan anda dan klik pada 'Buat Kunci API' pada halaman pendaratan untuk menghasilkan API baru.

Menggunakan Qwen3 untuk kuasa penyelesaian AI anda

Dalam bahagian ini, kami akan melalui proses membina aplikasi AI menggunakan QWEN3. Kami akan mula membuat ejen perancang perjalanan AI yang menggunakan model, dan kemudian bot RAG Q/A menggunakan Langchain.

Prasyarat

Sebelum membina beberapa penyelesaian AI dunia nyata dengan QWEN3, kita perlu terlebih dahulu meliputi prasyarat asas seperti:

- Kebiasaan dengan command prompt atau terminal dan keupayaan untuk menjalankannya melalui terminal.

- Keupayaan untuk menubuhkan pembolehubah persekitaran.

- Python mesti dipasang: https://www.python.org/downloads/

- Pengetahuan mengenai asas -asas Langchain: https://www.langchain.com/

Membina ejen AI menggunakan qwen3

Dalam bahagian ini, kami akan menggunakan QWEN3 untuk membuat ejen perjalanan AI yang akan memberikan tempat perjalanan utama untuk bandar atau tempat yang anda lawati. Kami juga akan membolehkan ejen mencari Internet untuk mencari maklumat yang dikemas kini, dan menambah alat yang membolehkan penukaran mata wang.

Langkah 1: Menyediakan perpustakaan dan alat

Pertama, kami akan memasang dan mengimport perpustakaan dan alat yang diperlukan untuk membina ejen.

! Pip Pasang Langchain Langchain-Community Openai Duckduckgo-Search

dari langchain.chat_models import Chatopenai

dari alat import langchain.

dari langchain.tools import duckduckgosearchrun

dari langchain.Agents Import Initialize_agent

LLM = Chateopenai (

base_url = "https://openrouter.ai/api/v1",

api_key = "your_api_key",

Model = "QWEN/QWEN3-235B-A22B: Percuma"

)

# Alat carian web

carian = DuckDuckGoSearchRun ()

# Alat untuk destinasiagen

def get_destinations (destinasi):

kembali carian.run (F "Top 3 Tempat Pelancong di {Destinasi}")

DestinasiTool = alat (

Nama = "Destinasi Pencapaian Destinasi",

func = get_destinations,

Penerangan = "Cari tempat teratas untuk dikunjungi di bandar"

)

# Alat untuk mata wang

def convert_usd_to_inr (pertanyaan):

jumlah = [float) untuk s dalam query.split () jika s.replace ('.', '', 1) .isdigit ()]

jika jumlah:

kembali f "{jumlah [0]} usd = {amaun [0] * 83.2: .2f} inr"

kembali "tidak dapat menghuraikan jumlah."

Mata Wang = Alat (

Nama = "Penukar Mata Wang",

func = convert_usd_to_inr,

Penerangan = "Menukar USD ke INR berdasarkan kadar statik"

)

- Search_Tool: DuckDuckGoSearchRun () membolehkan ejen menggunakan carian web untuk mendapatkan maklumat masa nyata mengenai tempat pelancongan yang popular.

- DestinationTool: Memohon fungsi get_destinations (), yang menggunakan alat carian untuk mendapatkan 3 tempat pelancongan teratas di mana -mana bandar tertentu.

- Mata Wang: Menggunakan fungsi Convert_USD_TO_INR () untuk menukar harga dari USD ke INR. Anda boleh menukar 'inr' dalam fungsi untuk menukarnya kepada mata wang pilihan anda.

Juga Baca: Bina pembantu perjalanan chatbot dengan Huggingface, Langchain, dan Mistralai

Langkah 2: Membuat ejen

Sekarang kita telah memulakan semua alat, mari kita teruskan untuk membuat ejen yang akan menggunakan alat dan memberi kita rancangan untuk perjalanan.

Alat = [DestinationTool, CurrencyTool]

agen = initialisasi_agent (

alat = alat,

llm = llm,

agen_type = "sifar-shot-react-deskripsi",

verbose = benar

)

def trip_planner (bandar, usd_budget):

dest = get_destinations (bandar)

inr_budget = convert_usd_to_inr (f "{usd_budget} usd to inr")

kembali f "" "Inilah rancangan perjalanan anda:

*Tempat teratas di {City}*:

{dest}

*Bajet*:

{inr_budget}

Nikmati perjalanan sehari anda! "" "

- Initialize_agent: Fungsi ini mewujudkan ejen dengan langchain menggunakan pendekatan tindak balas sifar, yang membolehkan ejen memahami deskripsi alat.

- Agent_Type: "Zero-Shot-React-Deskripsi" membolehkan Agent LLM untuk menentukan alat yang harus digunakan dalam situasi tertentu tanpa pengetahuan terlebih dahulu, dengan menggunakan keterangan dan input alat.

- Verbose: Verbose membolehkan pembalakan proses pemikiran ejen, jadi kami dapat memantau setiap keputusan yang dibuat oleh ejen, termasuk semua interaksi dan alat yang dipanggil.

- trip_planner: Ini adalah fungsi python yang secara manual memanggil alat dan bukannya bergantung pada ejen. Ia membolehkan pengguna memilih alat terbaik untuk masalah tertentu.

Langkah 3: Memulakan ejen

Dalam bahagian ini, kami akan memulakan ejen dan memerhatikan tindak balasnya.

# Inisialisasi ejen

bandar = "Delhi"

usd_budget = 8500

# Jalankan Perancang Multi-Agen

respons = ejen.run (f "Rancang perjalanan sehari ke {City} dengan anggaran {usd_budget} usd")

dari ipython.display import markdown, paparan

paparan (markdown (respons))

- Penyerahan ejen: ejen.run () menggunakan niat pengguna melalui prompt dan merancang perjalanan.

Output

Membina sistem kain menggunakan qwen3

Dalam bahagian ini, kami akan membuat bot RAG yang menjawab sebarang pertanyaan dalam dokumen input yang berkaitan dari pangkalan pengetahuan. Ini memberikan tindak balas yang bermaklumat menggunakan QWEN/QWEN3-235B-A22B. Sistem ini juga akan menggunakan Langchain, untuk menghasilkan respons yang tepat dan konteks.

Langkah 1: Menyediakan perpustakaan dan alat

Pertama, kami akan memasang dan mengimport perpustakaan dan alat yang diperlukan untuk membina sistem RAG.

! Pip memasang Langchain Langchain-Community Langchain-Core Openai Tiktoken Chromadband-Transformers Duckduckgo-Search

dari langchain_community.document_loaders import Textloader

dari langchain.text_splitter import charactertextsplitter

dari langchain_community.vectorstores import chroma

dari langchain.embeddings import HuggingFaceembeddings

dari langchain.Chains Import Retrievalqa

dari langchain.chat_models import Chatopenai

# Muatkan dokumen anda

loader = Textloader ("/kandungan/my_docs.txt")

docs = loader.load ()

- Dokumen Memuatkan: Kelas "Textloader" Langchain memuat dokumen seperti fail PDF, TXT, atau DOC yang akan digunakan untuk pengambilan Q/A. Di sini saya telah memuat naik my_docs.txt.

- Memilih Persediaan Vektor: Saya telah menggunakan ChromAdb untuk menyimpan dan mencari embeddings dari pangkalan data vektor kami untuk proses Q/A.

Langkah 2: Membuat embeddings

Sekarang bahawa kami telah memuat dokumen kami, mari kita teruskan untuk mewujudkan embeddings daripada itu yang akan membantu dalam meringankan proses pengambilan semula.

# Berpecah ke dalam ketulan

splitter = characterTextSplitter (chunk_size = 300, chunk_overlap = 50)

ketulan = splitter.split_documents (docs)

# Ditanam dengan model Huggingface

embeddings = huggingFaceembedDings (Model_name = "All-Minilm-L6-V2")

db = chroma.from_documents (ketulan, embedding = embeddings)

# Persediaan qwen llm dari OpenRouter

LLM = Chateopenai (

base_url = "https://openrouter.ai/api/v1",

api_key = "your_api_key",

Model = "QWEN/QWEN3-235B-A22B: Percuma"

)

# Buat rantai kain

retriever = db.as_retriever (search_kwargs = {"k": 2})

rag_chain = retrievalqa.from_chain_type (llm = llm, retriever = retriever)

- Pemisahan Dokumen: The CharacterTextSplitter () memisahkan teks ke dalam ketulan yang lebih kecil, yang akan membantu dalam dua perkara. Pertama, ia memudahkan proses pengambilan semula, dan kedua, ia membantu mengekalkan konteks dari bahagian sebelumnya melalui chunk_overlap.

- Dokumen Embedding: Embeddings menukar teks ke dalam vektor embedding dimensi set untuk setiap token. Di sini kita telah menggunakan chunk_size 300, yang bermaksud setiap perkataan/token akan ditukar menjadi vektor 300 dimensi. Sekarang embedding vektor ini akan mempunyai semua maklumat kontekstual perkataan itu berkenaan dengan kata -kata lain dalam bahagian.

- RAG RAG: RAG RAG menggabungkan Chromadb dengan LLM untuk membentuk kain. Ini membolehkan kita mendapatkan jawapan yang sedar secara konteks dari dokumen dan juga dari model.

Langkah 3: Memulakan sistem RAG

# Ajukan soalan

respons = rag_chain.invoke ({"query": "bagaimana saya boleh menggunakan qwen dengan mcp. sila beri saya panduan langkah demi langkah bersama dengan coretan kod yang diperlukan"})

paparan (markdown (respons ['hasil'])))

- Pelaksanaan pertanyaan: Kaedah RAG_CHAIN_INVOKE () akan menghantar pertanyaan pengguna ke sistem RAG, yang kemudiannya mengambil bahagian-bahagian konteks yang relevan dari kedai dokumen (vektor db) dan menghasilkan jawapan yang menyedari konteks.

Output

Anda boleh mencari kod lengkap di sini.

Aplikasi QWEN3

Berikut adalah beberapa lagi aplikasi Qwen3 di seluruh industri:

- Pengekodan automatik: QWEN3 boleh menjana, debug, dan menyediakan dokumentasi untuk kod, yang membantu pemaju menyelesaikan kesilapan tanpa usaha manual. Model parameter 22B cemerlang dalam pengekodan, dengan persembahan yang setanding dengan model seperti DeepSeek-R1, Gemini 2.5 Pro, dan Openai's O3-mini.

- Pendidikan dan Penyelidikan: Arkib QWEN3 Ketepatan Tinggi dalam Matematik, Fizik, dan Penyelesaian Masalah Penalaran Logik. Ia juga menyaingi Gemini 2.5 Pro, sementara cemerlang dengan model seperti Openai's O1, O3-Mini, DeepSeek-R1, dan Grok 3 beta.

- Integrasi Alat Berasaskan Ejen: QWEN3 juga membawa tugas-tugas ejen AI dengan membenarkan penggunaan alat luaran, API, dan MCP untuk aliran kerja multi-langkah dan pelbagai agen dengan templat alat yang memanggilnya, yang seterusnya memudahkan interaksi agentik.

- Tugas Penalaran Lanjutan: Qwen3 menggunakan keupayaan pemikiran yang luas untuk memberikan respons yang optimum dan tepat. Model ini menggunakan pemikiran rantaian untuk tugas-tugas yang kompleks dan mod yang tidak berfikir untuk kelajuan yang dioptimumkan.

Kesimpulan

Dalam artikel ini, kami telah belajar bagaimana untuk membina sistem AI dan RAG yang berkuasa QWEN3. Prestasi tinggi Qwen3, sokongan berbilang bahasa, dan keupayaan penalaran maju menjadikannya pilihan yang kuat untuk pengambilan pengetahuan dan tugas berasaskan ejen. Dengan mengintegrasikan QWEN3 ke dalam saluran paip RAG dan agentik, kita boleh mendapatkan tindak balas yang tepat, konteks, dan lancar, menjadikannya pesaing yang kuat untuk aplikasi dunia sebenar untuk sistem berkuasa AI.

Soalan yang sering ditanya

Q1. Bagaimanakah Qwen3 berbeza dari LLM lain untuk kain?A. QWEN3 mempunyai keupayaan penalaran hibrid yang membolehkannya membuat perubahan dinamik dalam respons, yang membolehkannya mengoptimumkan aliran kerja RAG untuk analisis pengambilan dan kompleks.

S2. Apakah alat yang diperlukan untuk mengintegrasikan kain?A. Ia merangkumi pangkalan data vektor, model embedding, alur kerja Langchain dan API untuk mengakses model.

Q3. Bolehkah Qwen3 membenarkan alat Multistep Chaining dalam aliran kerja ejen?Ya, dengan templat panggilan alat terbina dalam QWEN-Agent, kita boleh menghuraikan dan membolehkan operasi alat berurutan seperti carian web, analisis data, dan generasi laporan.

Q4. Bagaimana untuk mengurangkan latensi dalam tindak balas ejen Qwen3? A. Seseorang dapat mengurangkan latensi dalam banyak cara, beberapa daripadanya adalah:

1. Penggunaan model MOE seperti QWEN3-30B-A3B, yang hanya mempunyai 3 bilion parameter aktif.

2. Dengan menggunakan kesimpulan yang dioptimumkan GPU.

A. Kesalahan biasa termasuk:

1. Kegagalan permulaan pelayan MCP, seperti pemformatan JSON dan init.

2. Kesalahan pasangan tindak balas alat.

3. Limpahan tetingkap konteks.

Atas ialah kandungan terperinci Cara Membina Sistem RAG dan Ejen AI dengan QWEN3. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

7 AI yang kuat meminta setiap pengurus projek perlu menguasai sekarangMay 08, 2025 am 11:39 AM

7 AI yang kuat meminta setiap pengurus projek perlu menguasai sekarangMay 08, 2025 am 11:39 AMGeneratif AI, yang dicontohkan oleh chatbots seperti ChatGPT, menawarkan alat -alat yang berkuasa pengurus projek untuk menyelaraskan aliran kerja dan memastikan projek tetap mengikut jadual dan dalam anggaran. Walau bagaimanapun, penggunaan berkesan bergantung pada kerajinan yang betul. Tepat, terperinci

Mendefinisikan makna AGI yang sukar ditentukan melalui bantuan AI yang bergunaMay 08, 2025 am 11:37 AM

Mendefinisikan makna AGI yang sukar ditentukan melalui bantuan AI yang bergunaMay 08, 2025 am 11:37 AMCabaran untuk menentukan kecerdasan umum buatan (AGI) adalah penting. Tuntutan kemajuan AGI sering tidak mempunyai penanda aras yang jelas, dengan definisi yang disesuaikan agar sesuai dengan arahan penyelidikan yang telah ditetapkan. Artikel ini meneroka pendekatan baru untuk ditentukan

IBM Think 2025 mempamerkan peranan Watsonx.data dalam generatif AIMay 08, 2025 am 11:32 AM

IBM Think 2025 mempamerkan peranan Watsonx.data dalam generatif AIMay 08, 2025 am 11:32 AMIBM Watsonx.Data: Memperkenalkan Stack Data AI Enterprise Posisi IBM Watsonx.data sebagai platform penting bagi perusahaan yang bertujuan untuk mempercepatkan penyampaian penyelesaian AI generasi yang tepat dan berskala. Ini dicapai dengan memudahkan pengadu

Kebangkitan mesin robot humanoid semakin hampir.May 08, 2025 am 11:29 AM

Kebangkitan mesin robot humanoid semakin hampir.May 08, 2025 am 11:29 AMKemajuan pesat dalam robotik, yang didorong oleh kejayaan dalam AI dan sains bahan, bersedia untuk menyambut era baru robot humanoid. Selama bertahun -tahun, automasi perindustrian menjadi tumpuan utama, tetapi keupayaan robot dengan cepat

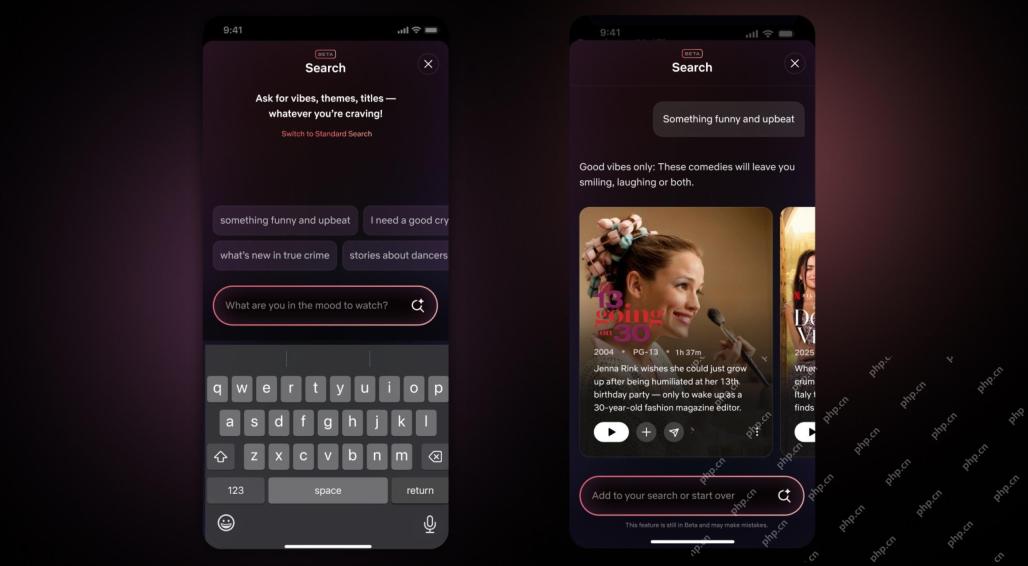

Netflix Revamps Interface-Debut Alat Carian AI dan Reka Bentuk Seperti TiktokMay 08, 2025 am 11:25 AM

Netflix Revamps Interface-Debut Alat Carian AI dan Reka Bentuk Seperti TiktokMay 08, 2025 am 11:25 AMKemas kini terbesar antara muka Netflix dalam satu dekad: lebih bijak, lebih diperibadikan, merangkumi pelbagai kandungan Netflix mengumumkan pembaikan terbesar antara muka penggunanya dalam satu dekad, bukan sahaja rupa baru, tetapi juga menambah lebih banyak maklumat mengenai setiap pertunjukan, dan memperkenalkan alat carian AI yang lebih bijak yang dapat memahami konsep samar -samar seperti "ambien" dan struktur yang lebih fleksibel untuk menunjukkan minat syarikat dalam permainan video yang baru muncul, acara langsung, acara sukan dan jenis kandungan baru. Untuk bersaing dengan trend, komponen video menegak baru di Mobile akan memudahkan peminat untuk menatal melalui treler dan klip, menonton pertunjukan penuh atau berkongsi kandungan dengan orang lain. Ini mengingatkan anda tentang Laman Web Video Short yang tidak terhingga dan sangat berjaya Ti

Jauh sebelum AGI: Tiga Pencapaian AI yang akan mencabar andaMay 08, 2025 am 11:24 AM

Jauh sebelum AGI: Tiga Pencapaian AI yang akan mencabar andaMay 08, 2025 am 11:24 AMPerbincangan yang semakin meningkat tentang kecerdasan umum (AGI) dalam kecerdasan buatan telah mendorong ramai untuk berfikir tentang apa yang berlaku apabila kecerdasan buatan melebihi kecerdasan manusia. Sama ada momen ini dekat atau jauh bergantung kepada siapa yang anda minta, tetapi saya tidak fikir ia adalah peristiwa penting yang harus kita fokuskan. Pencapaian AI yang sebelum ini akan menjejaskan semua orang? Apa tonggak yang telah dicapai? Berikut adalah tiga perkara yang saya fikir telah berlaku. Kecerdasan buatan melepasi kelemahan manusia Dalam filem "Dilema Sosial" 2022, Tristan Harris dari Pusat Teknologi Humane menegaskan bahawa kecerdasan buatan telah melampaui kelemahan manusia. Apa maksudnya? Ini bermaksud kecerdasan buatan telah dapat menggunakan manusia

Venkat Achanta pada transformasi platform TransUnion dan cita -cita AIMay 08, 2025 am 11:23 AM

Venkat Achanta pada transformasi platform TransUnion dan cita -cita AIMay 08, 2025 am 11:23 AMTransUnion's CTO, Ranganath Achanta, spearheaded a significant technological transformation since joining the company following its Neustar acquisition in late 2021. His leadership of over 7,000 associates across various departments has focused on u

Apabila kepercayaan AI melompat, produktiviti mengikutiMay 08, 2025 am 11:11 AM

Apabila kepercayaan AI melompat, produktiviti mengikutiMay 08, 2025 am 11:11 AMBangunan Amanah adalah yang paling penting untuk penggunaan AI yang berjaya dalam perniagaan. Hal ini terutama berlaku memandangkan elemen manusia dalam proses perniagaan. Pekerja, seperti orang lain, pelabuhan kebimbangan mengenai AI dan pelaksanaannya. Penyelidik Deloitte adalah SC

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

SecLists

SecLists ialah rakan penguji keselamatan muktamad. Ia ialah koleksi pelbagai jenis senarai yang kerap digunakan semasa penilaian keselamatan, semuanya di satu tempat. SecLists membantu menjadikan ujian keselamatan lebih cekap dan produktif dengan menyediakan semua senarai yang mungkin diperlukan oleh penguji keselamatan dengan mudah. Jenis senarai termasuk nama pengguna, kata laluan, URL, muatan kabur, corak data sensitif, cangkerang web dan banyak lagi. Penguji hanya boleh menarik repositori ini ke mesin ujian baharu dan dia akan mempunyai akses kepada setiap jenis senarai yang dia perlukan.

Pelayar Peperiksaan Selamat

Pelayar Peperiksaan Selamat ialah persekitaran pelayar selamat untuk mengambil peperiksaan dalam talian dengan selamat. Perisian ini menukar mana-mana komputer menjadi stesen kerja yang selamat. Ia mengawal akses kepada mana-mana utiliti dan menghalang pelajar daripada menggunakan sumber yang tidak dibenarkan.

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini

SublimeText3 versi Inggeris

Disyorkan: Versi Win, menyokong gesaan kod!

Muat turun versi mac editor Atom

Editor sumber terbuka yang paling popular