Pyspark, API Python untuk Apache Spark, memberi kuasa kepada pemaju Python untuk memanfaatkan kuasa pemprosesan yang diedarkan Spark untuk tugas data besar. Ia memanfaatkan kekuatan teras Spark, termasuk pengiraan dalam memori dan keupayaan pembelajaran mesin, yang menawarkan antara muka pythonic yang diperkemas untuk manipulasi dan analisis data yang cekap. Ini menjadikan Pyspark sebagai kemahiran yang sangat dicari dalam landskap data besar. Menyediakan untuk wawancara Pyspark memerlukan pemahaman yang kukuh tentang konsep terasnya, dan artikel ini memberikan 30 soalan dan jawapan utama untuk membantu dalam persiapan itu.

Panduan ini merangkumi konsep Pyspark asas, termasuk transformasi, ciri utama, perbezaan antara RDD dan dataframe, dan topik lanjutan seperti fungsi streaming dan tingkap. Sama ada anda seorang lulusan baru -baru ini atau profesional yang berpengalaman, soalan dan jawapan ini akan membantu anda menguatkan pengetahuan anda dan yakin menangani wawancara Pyspark anda yang seterusnya.

Kawasan utama dilindungi:

- Fundamental Pyspark dan Ciri -ciri Teras.

- Memahami dan memohon RDD dan DataFrames.

- Menguasai transformasi pyspark (sempit dan luas).

- Pemprosesan data masa nyata dengan Streaming Spark.

- Manipulasi Data Lanjutan dengan fungsi tetingkap.

- Teknik pengoptimuman dan penyahpepijatan untuk aplikasi pyspark.

Soalan dan jawapan wawancara Pyspark Top 30 untuk 2025:

Berikut adalah pemilihan 30 soalan wawancara pyspark penting dan jawapan yang komprehensif mereka:

Asas:

Apa itu Pyspark dan hubungannya dengan Apache Spark? Pyspark adalah API Python untuk Apache Spark, yang membolehkan pengaturcara Python menggunakan keupayaan pengkomputeran yang diedarkan Spark untuk pemprosesan data berskala besar.

Ciri -ciri utama Pyspark? Kemudahan Integrasi Python, DataFrame API (PANDAS-Like), Pemprosesan Masa Nyata (Spark Streaming), Pengiraan Memori, dan Perpustakaan Pembelajaran Mesin yang mantap (MLLIB).

RDD vs DataFrame? RDD (dataset yang diedarkan yang berdaya tahan) adalah struktur data asas Spark, yang menawarkan kawalan peringkat rendah tetapi kurang pengoptimuman. DataFrames menyediakan abstraksi yang lebih tinggi, skema yang diperkaya skema, menawarkan prestasi yang lebih baik dan kemudahan penggunaan.

Bagaimanakah Spark SQL Catalyst Optimizer meningkatkan prestasi pertanyaan? Pengoptimal pemangkin menggunakan peraturan pengoptimuman yang canggih (predikat pushdown, lipatan berterusan, dan lain -lain) dan secara bijak merancang pelaksanaan pertanyaan untuk kecekapan yang dipertingkatkan.

Pengurus Kluster Pyspark? Standalone, Apache Mesos, Benang Hadoop, dan Kubernet.

Transformasi dan tindakan:

Penilaian malas di Pyspark? Transformasi tidak dilaksanakan dengan segera; Spark membina pelan pelaksanaan, hanya melaksanakan apabila tindakan dicetuskan. Ini mengoptimumkan pemprosesan.

Perubahan yang sempit dan luas? Transformasi sempit melibatkan pemetaan partition satu sama lain (contohnya,

map,filter). Transformasi yang luas memerlukan pengalihan data merentasi partisi (contohnya,groupByKey,reduceByKey).Membaca CSV ke dalam DataFrame?

df = spark.read.csv('path/to/file.csv', header=True, inferSchema=True)Melakukan pertanyaan SQL pada data data? Daftar DataFrame sebagai pandangan sementara (

df.createOrReplaceTempView("my_table")) dan kemudian gunakanspark.sql("SELECT ... FROM my_table").kaedah

cache()? Cache RDD atau DataFrame dalam ingatan untuk akses lebih cepat dalam operasi berikutnya.DAG Spark (grafik acyclic yang diarahkan)? Mewakili pelan pelaksanaan sebagai graf peringkat dan tugas, membolehkan penjadualan dan pengoptimuman yang cekap.

Mengendalikan data yang hilang dalam dataFrame?

dropna(),fillna(), danreplace()kaedah.

Konsep Lanjutan:

map()vsflatMap()?map()menggunakan fungsi untuk setiap elemen, menghasilkan satu output setiap input.flatMap()menggunakan fungsi yang boleh menghasilkan pelbagai output setiap input, meratakan hasilnya.Pemboleh ubah penyiaran? Pembolehubah baca sahaja cache dalam memori di semua nod untuk akses yang cekap.

Percikan akumulator? Pembolehubah hanya dikemas kini melalui operasi bersekutu dan komutatif (misalnya, kaunter, jumlah).

Bergabung dengan DataFrame? Gunakan kaedah

join(), menentukan keadaan gabungan.Partition di Pyspark? Unit asas paralelisme; Mengawal bilangan mereka memberi kesan prestasi (

repartition(),coalesce()).Menulis DataFrame ke CSV?

df.write.csv('path/to/output.csv', header=True)Spark SQL Catalyst Optimizer (Revisited)? Komponen penting untuk pengoptimuman pertanyaan dalam Spark SQL.

Pyspark udfs (fungsi pengguna yang ditentukan)? Panjangkan fungsi Pyspark dengan menentukan fungsi tersuai menggunakan

udf()dan menentukan jenis pulangan.

Manipulasi dan analisis data:

Agregasi pada DataFrame?

groupBy()diikuti oleh fungsi agregasi sepertiagg(),sum(),avg(),count().kaedah

withColumn()? Menambah lajur baru atau mengubah suai yang ada dalam data data.select()kaedah? Memilih lajur tertentu dari DataFrame.Penapisan baris dalam DataFrame?

filter()atauwhere()kaedah dengan keadaan.Percikan streaming? Memproses aliran data masa nyata dalam batch mini, menggunakan transformasi pada setiap kumpulan.

Pengendalian dan pengoptimuman data:

Mengendalikan data JSON?

spark.read.json('path/to/file.json')Fungsi tetingkap? Lakukan pengiraan merentasi satu set baris yang berkaitan dengan baris semasa (misalnya, jumlah yang berjalan, kedudukan).

Debugging Applications Pyspark? Pembalakan, alat pihak ketiga (Databricks, EMR, Plugin IDE).

Pertimbangan lebih lanjut:

Terangkan konsep siri data dan deserialization di Pyspark dan kesannya terhadap prestasi. (Ini menyelidiki pengoptimuman prestasi)

Bincangkan pendekatan yang berbeza untuk mengendalikan condong data di Pyspark. (Ini memberi tumpuan kepada cabaran prestasi biasa)

Soalan dan jawapan yang diperluaskan ini memberikan panduan penyediaan yang lebih komprehensif untuk wawancara Pyspark anda. Ingatlah untuk mengamalkan contoh pengekodan dan menunjukkan pemahaman anda tentang konsep yang mendasari. Nasib baik!

Atas ialah kandungan terperinci Soalan dan Jawapan Temuduga Pyspark Top 30 Pyspark (2025). Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Tesla's Robovan adalah permata tersembunyi pada penggoda Robotaxi 2024Apr 22, 2025 am 11:48 AM

Tesla's Robovan adalah permata tersembunyi pada penggoda Robotaxi 2024Apr 22, 2025 am 11:48 AMSejak tahun 2008, saya telah memperjuangkan van yang dikongsi bersama-pada masa yang digelar "Robotjitney," kemudian "Vansit" -dan masa depan pengangkutan bandar. Saya meramalkan kenderaan ini sebagai penyelesaian transit generasi akan datang abad ke-21, Surpas

Pertaruhan Kelab Sam di AI untuk menghapuskan cek resit dan meningkatkan runcitApr 22, 2025 am 11:29 AM

Pertaruhan Kelab Sam di AI untuk menghapuskan cek resit dan meningkatkan runcitApr 22, 2025 am 11:29 AMMerevolusikan pengalaman checkout Sistem "Just Go" inovatif Sam Club membina teknologi "imbasan & pergi" yang sedia ada AI yang sedia ada, yang membolehkan ahli mengimbas pembelian melalui aplikasi Sam's Club semasa perjalanan membeli-belah mereka.

AI Omniverse Nvidia berkembang di GTC 2025Apr 22, 2025 am 11:28 AM

AI Omniverse Nvidia berkembang di GTC 2025Apr 22, 2025 am 11:28 AMPredictability dan barisan produk baru NVIDIA di GTC 2025 Nvidia, pemain utama dalam infrastruktur AI, memberi tumpuan kepada peningkatan ramalan untuk pelanggannya. Ini melibatkan penghantaran produk yang konsisten, memenuhi jangkaan prestasi, dan

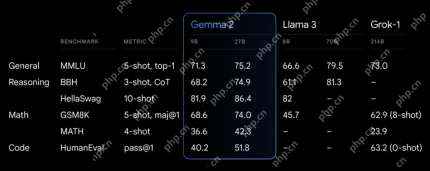

Meneroka keupayaan model Google ' s Gemma 2Apr 22, 2025 am 11:26 AM

Meneroka keupayaan model Google ' s Gemma 2Apr 22, 2025 am 11:26 AMGoogle's Gemma 2: Model bahasa yang kuat dan cekap Model Bahasa Gemma Google, yang disambut untuk kecekapan dan prestasi, telah berkembang dengan kedatangan Gemma 2. Siaran terbaru ini terdiri daripada dua model: parameter 27 bilion ver

Gelombang Seterusnya: Perspektif dengan Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AM

Gelombang Seterusnya: Perspektif dengan Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AMIni memimpin dengan episod data yang menampilkan Dr Kirk Borne, seorang saintis data terkemuka, astrofizik, dan pembesar suara TEDX. Pakar terkenal dalam Big Data, AI, dan Pembelajaran Mesin, Dr. Borne menawarkan pandangan yang tidak ternilai ke dalam keadaan semasa dan masa depan Traje

AI untuk pelari dan atlet: kami membuat kemajuan yang sangat baikApr 22, 2025 am 11:12 AM

AI untuk pelari dan atlet: kami membuat kemajuan yang sangat baikApr 22, 2025 am 11:12 AMTerdapat beberapa perspektif yang sangat berwawasan dalam maklumat ini mengenai maklumat mengenai kejuruteraan yang menunjukkan kepada kita mengapa kecerdasan buatan sangat baik untuk menyokong latihan fizikal orang. Saya akan menggariskan idea teras dari setiap perspektif penyumbang untuk menunjukkan tiga aspek reka bentuk yang merupakan bahagian penting dalam penerokaan penerokaan kecerdasan buatan dalam sukan. Peranti tepi dan data peribadi mentah Idea ini mengenai kecerdasan buatan sebenarnya mengandungi dua komponen -satu yang berkaitan dengan di mana kita meletakkan model bahasa yang besar dan yang lain berkaitan dengan perbezaan antara bahasa manusia dan bahasa yang kita tanda -tanda penting kita "menyatakan" apabila diukur dalam masa nyata. Alexander Amini tahu banyak tentang berlari dan tenis, tetapi dia masih

Jamie Engstrom mengenai Teknologi, Bakat dan Transformasi di CaterpillarApr 22, 2025 am 11:10 AM

Jamie Engstrom mengenai Teknologi, Bakat dan Transformasi di CaterpillarApr 22, 2025 am 11:10 AMKetua Pegawai Maklumat Caterpillar dan Naib Presiden Kanan IT, Jamie Engstrom, mengetuai pasukan global lebih dari 2,200 profesional IT di 28 negara. Dengan 26 tahun di Caterpillar, termasuk empat setengah tahun dalam peranannya sekarang, Engst

Kemas kini foto Google baru menjadikan sebarang foto pop dengan kualiti ultra HDRApr 22, 2025 am 11:09 AM

Kemas kini foto Google baru menjadikan sebarang foto pop dengan kualiti ultra HDRApr 22, 2025 am 11:09 AMAlat HDR Ultra baru Google Photos: Panduan Cepat Tingkatkan foto anda dengan alat Ultra HDR baru Google Photos, mengubah imej standard ke dalam karya-karya bertenaga, tinggi dinamik. Sesuai untuk media sosial, alat ini meningkatkan kesan foto,

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

PhpStorm versi Mac

Alat pembangunan bersepadu PHP profesional terkini (2018.2.1).

ZendStudio 13.5.1 Mac

Persekitaran pembangunan bersepadu PHP yang berkuasa

Versi Mac WebStorm

Alat pembangunan JavaScript yang berguna

Pelayar Peperiksaan Selamat

Pelayar Peperiksaan Selamat ialah persekitaran pelayar selamat untuk mengambil peperiksaan dalam talian dengan selamat. Perisian ini menukar mana-mana komputer menjadi stesen kerja yang selamat. Ia mengawal akses kepada mana-mana utiliti dan menghalang pelajar daripada menggunakan sumber yang tidak dibenarkan.

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma