Pengenalan

Katakan anda berinteraksi dengan rakan yang berpengetahuan tetapi kadang -kadang tidak mempunyai respons konkrit/maklumat atau ketika dia tidak bertindak balas dengan lancar ketika menghadapi pertanyaan rumit. Apa yang kita lakukan di sini adalah serupa dengan prospek yang kini wujud dengan model bahasa yang besar. Mereka sangat membantu, walaupun kualiti dan kaitannya dengan jawapan berstruktur yang disampaikan mungkin memuaskan atau niche.

Dalam artikel ini, kami akan meneroka bagaimana teknologi masa depan seperti fungsi panggilan dan generasi pengambilan semula (RAG) dapat meningkatkan LLM. Kami akan membincangkan potensi mereka untuk mencipta pengalaman perbualan yang lebih dipercayai dan bermakna. Anda akan belajar bagaimana teknologi ini berfungsi, faedah mereka, dan cabaran yang mereka hadapi. Matlamat kami adalah untuk melengkapkan anda dengan pengetahuan dan kemahiran untuk meningkatkan prestasi LLM dalam senario yang berbeza.

Artikel ini didasarkan pada ceramah baru -baru ini yang diberikan oleh Ayush Thakur untuk meningkatkan LLM dengan output berstruktur dan panggilan fungsi, di Sidang Kemuncak Datahack 2024.

Hasil pembelajaran

- Memahami konsep asas dan batasan model bahasa besar.

- Ketahui bagaimana output dan panggilan berstruktur dapat meningkatkan prestasi LLMS.

- Terokai prinsip-prinsip dan kelebihan Generasi Pengambilan Pengambilan (RAG) dalam meningkatkan LLM.

- Kenal pasti cabaran dan penyelesaian utama dalam menilai LLM dengan berkesan.

- Bandingkan keupayaan panggilan fungsi antara model OpenAI dan Llama.

Jadual Kandungan

- Pengenalan

- Apa itu LLMS?

- Berinteraksi dengan LLM: Menggalakkan

- Bagaimanakah aplikasi LLM berbeza daripada pembangunan model?

- Fungsi panggilan dengan LLMS

- Fungsi Panggilan: Penalaan halus

- RAG (Generasi Pengambilan Pengambilan) untuk LLMS

- Penilaian LLMS

- Generasi output yang dikekang untuk LLM

- Menurunkan suhu untuk output yang lebih berstruktur

- Rantaian pemikiran pemikiran untuk LLM

- Fungsi memanggil Openai vs llama

- Mencari LLMS untuk permohonan anda

- Kesimpulan

- Soalan yang sering ditanya

Apa itu LLMS?

Model bahasa yang besar (LLMS) adalah sistem AI maju yang direka untuk memahami dan menjana bahasa semulajadi berdasarkan dataset yang besar. Model seperti GPT-4 dan LLAMA menggunakan algoritma pembelajaran mendalam untuk memproses dan menghasilkan teks. Mereka serba boleh, mengendalikan tugas seperti terjemahan bahasa dan penciptaan kandungan. Dengan menganalisis sejumlah besar data, LLMS mempelajari corak bahasa dan menerapkan pengetahuan ini untuk menghasilkan respons semulajadi. Mereka meramalkan teks dan memformatnya secara logik, membolehkan mereka melakukan pelbagai tugas di seluruh bidang yang berbeza.

Batasan LLMS

Marilah kita meneroka batasan LLMS.

- Ketepatan yang tidak konsisten: Keputusan mereka kadang -kadang tidak tepat atau tidak boleh dipercayai seperti yang diharapkan terutama ketika berurusan dengan situasi yang rumit.

- Kekurangan pemahaman yang benar: Mereka boleh menghasilkan teks yang mungkin munasabah tetapi sebenarnya boleh menjadi maklumat yang salah atau berputar kerana kekurangan wawasan mereka.

- Kekangan data latihan: Output yang mereka hasilkan dihalang oleh data latihan mereka, yang kadang -kadang boleh menjadi bias atau mengandungi jurang.

- Pangkalan Pengetahuan Statik: LLM mempunyai asas pengetahuan statik yang tidak dikemas kini secara real-time, menjadikannya kurang berkesan untuk tugas yang memerlukan maklumat semasa atau dinamik.

Kepentingan output berstruktur untuk LLM

Sekarang kita akan melihat kepentingan output berstruktur LLMS.

- Konsistensi yang dipertingkatkan: Output berstruktur memberikan format yang jelas dan teratur, meningkatkan konsistensi dan kaitan maklumat yang dibentangkan.

- Kegunaan yang lebih baik: Mereka membuat maklumat lebih mudah untuk mentafsir dan menggunakan, terutamanya dalam aplikasi yang memerlukan persembahan data yang tepat.

- Data yang dianjurkan: Format berstruktur membantu dalam menganjurkan maklumat secara logik, yang bermanfaat untuk menghasilkan laporan, ringkasan, atau pandangan yang didorong oleh data.

- Kekurangan kekaburan: Melaksanakan output berstruktur membantu mengurangkan kekaburan dan meningkatkan kualiti keseluruhan teks yang dihasilkan.

Berinteraksi dengan LLM: Menggalakkan

Menggalakkan Model Bahasa Besar (LLMS) melibatkan kerajinan dengan beberapa komponen utama:

- Arahan : Berikan arahan mengenai apa yang perlu dilakukan oleh LLM.

- Konteks : Maklumat latar belakang atau sebelum token untuk memaklumkan respons.

- Data Input : Kandungan utama atau pertanyaan LLM perlu diproses.

- Penunjuk Output : Menentukan format yang dikehendaki atau jenis tindak balas.

Sebagai contoh, untuk mengklasifikasikan sentimen, anda menyediakan teks seperti "Saya fikir makanan itu baik -baik saja" dan meminta LLM untuk mengkategorikannya menjadi sentimen neutral, negatif, atau positif.

Dalam amalan, terdapat pelbagai pendekatan untuk mendorong:

- Input-Output : Secara langsung memasukkan data dan menerima output.

- Rantaian Pemikiran (COT) : Menggalakkan LLM untuk alasan melalui urutan langkah -langkah untuk mencapai output.

- Konsisten diri dengan COT (COT-SC) : Menggunakan pelbagai laluan penalaran dan agregat hasil untuk ketepatan yang lebih baik melalui pengundian majoriti.

Kaedah ini membantu dalam menyempurnakan tindak balas LLM dan memastikan output lebih tepat dan boleh dipercayai.

Bagaimanakah aplikasi LLM berbeza daripada pembangunan model?

Marilah kita melihat jadual di bawah untuk memahami bagaimana aplikasi LLM berbeza daripada pembangunan model.

| Pembangunan model | Aplikasi LLM | |

| Model | Senibina yang disimpan berat & bias | Komposisi Fungsi, API, & Konfigurasi |

| Dataset | Besar, sering dilabelkan | Manusia dijana, sering tidak berlabel |

| Percubaan | Pengoptimuman yang mahal dan panjang | Interaksi frekuensi tinggi yang murah, |

| Penjejakan | Metrik: Kerugian, Ketepatan, Pengaktifan | Aktiviti: Penyelesaian, Maklum Balas, Kod |

| Penilaian | Objektif & Dijadualkan | Subjektif & memerlukan input manusia |

Fungsi panggilan dengan LLMS

Fungsi yang memanggil dengan LLM melibatkan membolehkan model bahasa yang besar (LLMS) untuk melaksanakan fungsi yang telah ditetapkan atau coretan kod sebagai sebahagian daripada proses penjanaan tindak balas mereka. Keupayaan ini membolehkan LLM melakukan tindakan atau perhitungan tertentu di luar penjanaan teks standard. Dengan mengintegrasikan fungsi panggilan, LLM boleh berinteraksi dengan sistem luaran, mengambil data masa nyata, atau melaksanakan operasi kompleks, dengan itu memperluaskan utiliti dan keberkesanannya dalam pelbagai aplikasi.

Faedah panggilan fungsi

- Interaktiviti yang dipertingkatkan: Memanggil fungsi membolehkan LLMs berinteraksi secara dinamik dengan sistem luaran, memudahkan pengambilan data dan pemprosesan masa nyata. Ini amat berguna untuk aplikasi yang memerlukan maklumat terkini, seperti pertanyaan data langsung atau respons peribadi berdasarkan keadaan semasa.

- Peningkatan Fleksibiliti: Dengan melaksanakan fungsi, LLM boleh mengendalikan pelbagai tugas yang lebih luas, dari melakukan pengiraan untuk mengakses dan memanipulasi pangkalan data. Fleksibiliti ini meningkatkan keupayaan model untuk menangani keperluan pengguna yang pelbagai dan menyediakan penyelesaian yang lebih komprehensif.

- Ketepatan yang lebih baik: Panggilan fungsi membolehkan LLM melakukan tindakan tertentu yang dapat meningkatkan ketepatan output mereka. Sebagai contoh, mereka boleh menggunakan fungsi luaran untuk mengesahkan atau memperkayakan maklumat yang mereka hasilkan, yang membawa kepada tindak balas yang lebih tepat dan boleh dipercayai.

- Proses yang diselaraskan: Mengintegrasikan fungsi yang memanggil ke LLM boleh menyelaraskan proses kompleks dengan mengautomasikan tugas berulang dan mengurangkan keperluan untuk campur tangan manual. Automasi ini boleh membawa kepada aliran kerja yang lebih cekap dan masa tindak balas yang lebih cepat.

Batasan fungsi panggilan dengan LLM semasa

- Keupayaan Integrasi Terhad: LLM semasa mungkin menghadapi cabaran dalam mengintegrasikan dengan lancar dengan sistem luaran atau fungsi yang pelbagai. Batasan ini boleh menyekat keupayaan mereka untuk berinteraksi dengan pelbagai sumber data atau melakukan operasi kompleks dengan berkesan.

- Kebimbangan keselamatan dan privasi: Panggilan fungsi boleh memperkenalkan risiko keselamatan dan privasi, terutamanya apabila LLMs berinteraksi dengan data sensitif atau peribadi. Memastikan perlindungan yang mantap dan interaksi yang selamat adalah penting untuk mengurangkan kelemahan yang berpotensi.

- Kekangan Pelaksanaan: Pelaksanaan fungsi oleh LLM boleh dikekang oleh faktor -faktor seperti batasan sumber, masa pemprosesan, atau isu keserasian. Kekangan ini boleh memberi kesan kepada prestasi dan kebolehpercayaan ciri -ciri panggilan fungsi.

- Kerumitan dalam pengurusan: Menguruskan dan mengekalkan keupayaan memanggil fungsi dapat menambah kerumitan kepada penggunaan dan operasi LLMS. Ini termasuk kesilapan mengendalikan, memastikan keserasian dengan pelbagai fungsi, dan menguruskan kemas kini atau perubahan kepada fungsi yang dipanggil.

Fungsi panggilan memenuhi pydantic

Objek Pydantik Memudahkan proses menentukan dan menukarkan skema untuk panggilan fungsi, menawarkan beberapa faedah:

- Penukaran Skema Automatik : Mudah mengubah objek Pydantic menjadi skema siap untuk LLMS.

- Kualiti kod yang dipertingkatkan : Pydantic mengendalikan jenis pemeriksaan, pengesahan, dan aliran kawalan, memastikan kod yang bersih dan boleh dipercayai.

- Pengendalian ralat yang teguh : Mekanisme terbina dalam untuk menguruskan kesilapan dan pengecualian.

- Integrasi Rangka Kerja : Alat seperti pengajar, Marvin, Langchain, dan Llamaindex menggunakan keupayaan Pydantic untuk output berstruktur.

Fungsi Panggilan: Penalaan halus

Meningkatkan fungsi yang memanggil tugas khusus melibatkan penalaan LLMs kecil untuk mengendalikan keperluan pengaturan data tertentu. Dengan memanfaatkan teknik seperti Token Khas dan Lora Fine-penalaan, anda boleh mengoptimumkan pelaksanaan fungsi dan meningkatkan prestasi model untuk aplikasi khusus.

Curation Data : Fokus pada pengurusan data yang tepat untuk panggilan fungsi yang berkesan.

- Single-turn Panggilan Paksa : Melaksanakan eksekusi fungsi satu kali, satu kali.

- Panggilan Selari : Menggunakan fungsi serentak panggilan untuk kecekapan.

- Panggilan bersarang : Mengendalikan interaksi kompleks dengan eksekusi fungsi bersarang.

- Sembang multi-turn : Menguruskan dialog lanjutan dengan panggilan fungsi berurutan.

Token Khas : Gunakan token tersuai untuk menandakan permulaan dan akhir fungsi memerlukan integrasi yang lebih baik.

Latihan Model : Mulakan dengan model berasaskan arahan yang dilatih pada data berkualiti tinggi untuk keberkesanan asas.

LORA FINE-penala : Menggunakan penalaan LORA untuk meningkatkan prestasi model dengan cara yang boleh diurus dan disasarkan.

Ini menunjukkan permintaan untuk plot harga saham NVIDIA (NVDA) dan Apple (AAPL) selama dua minggu, diikuti dengan panggilan fungsi mengambil data saham.

RAG (Generasi Pengambilan Pengambilan) untuk LLMS

Generasi Retrieval-Augmented (RAG) menggabungkan teknik pengambilan semula dengan kaedah generasi untuk meningkatkan prestasi model bahasa besar (LLMS). RAG meningkatkan kaitan dan kualiti output dengan mengintegrasikan sistem pengambilan dalam model generatif. Pendekatan ini memastikan bahawa respons yang dihasilkan lebih kontekstual kaya dan tepat. Dengan menggabungkan pengetahuan luaran, RAG menangani beberapa batasan model generatif semata-mata, yang menawarkan output yang lebih dipercayai dan bermaklumat untuk tugas yang memerlukan ketepatan dan maklumat terkini. Ia menjembatani jurang antara generasi dan pengambilan semula, meningkatkan kecekapan model keseluruhan.

Bagaimana RAG berfungsi

Komponen utama termasuk:

- Loader Dokumen : Bertanggungjawab untuk memuatkan dokumen dan mengekstrak kedua -dua teks dan metadata untuk diproses.

- Strategi Chunking : Menentukan bagaimana teks besar dibahagikan kepada kepingan yang lebih kecil dan terkawal (ketulan) untuk membenamkan.

- Model Embedding : Menukar ketulan ini ke dalam vektor berangka untuk perbandingan dan pengambilan yang cekap.

- Retriever : Mencari ketulan yang paling relevan berdasarkan pertanyaan, menentukan betapa baiknya atau tepat untuk penjanaan tindak balas.

- Parsers Node & Postprocessing : Mengendalikan penapisan dan ambang, memastikan hanya ketulan berkualiti tinggi yang diluluskan ke hadapan.

- Synthesizer Response : Menjana tindak balas yang koheren dari ketulan yang diambil, selalunya dengan panggilan LLM multi-turn atau berurutan.

- Penilaian : Sistem memeriksa ketepatan, faktual, dan mengurangkan halusinasi dalam tindak balas, memastikan ia mencerminkan data sebenar.

Imej ini mewakili bagaimana sistem RAG menggabungkan pengambilan semula dan generasi untuk memberikan jawapan yang didorong oleh data yang tepat.

- Komponen pengambilan semula: Rangka RAG bermula dengan proses pengambilan semula di mana dokumen atau data yang berkaitan diambil dari pangkalan pengetahuan yang telah ditetapkan atau enjin carian. Langkah ini melibatkan pertanyaan pangkalan data menggunakan pertanyaan input atau konteks untuk mengenal pasti maklumat yang paling penting.

- Integrasi Kontekstual: Setelah dokumen yang relevan diambil, mereka digunakan untuk menyediakan konteks untuk model generatif. Maklumat yang diambil diintegrasikan ke dalam input input, membantu LLM menjana respons yang dimaklumkan oleh data dunia sebenar dan kandungan yang relevan.

- Komponen Generasi: Model generatif memproses input yang diperkaya, menggabungkan maklumat yang diambil untuk menghasilkan respons. Respons ini mendapat manfaat daripada konteks tambahan, yang membawa kepada output yang lebih tepat dan kontekstual yang sesuai.

- Penambahbaikan: Dalam sesetengah pelaksanaan, output yang dihasilkan boleh ditapis melalui pemprosesan selanjutnya atau penilaian semula. Langkah ini memastikan bahawa tindak balas akhir sejajar dengan maklumat yang diambil dan memenuhi piawaian kualiti.

Faedah menggunakan kain dengan LLM

- Ketepatan yang lebih baik: Dengan menggabungkan pengetahuan luaran, RAG meningkatkan ketepatan faktual output yang dihasilkan. Komponen pengambilan semula membantu memberikan maklumat terkini dan relevan, mengurangkan risiko menjana respons yang salah atau ketinggalan zaman.

- Kaitan kontekstual yang dipertingkatkan: RAG membolehkan LLMS menghasilkan respons yang lebih kontekstual relevan dengan memanfaatkan maklumat khusus yang diambil dari sumber luaran. Ini menghasilkan output yang lebih baik selaras dengan pertanyaan atau konteks pengguna.

- Peningkatan Liputan Pengetahuan: Dengan RAG, LLMS dapat mengakses pelbagai pengetahuan yang lebih luas di luar data latihan mereka. Liputan yang diperluaskan ini membantu menangani pertanyaan mengenai topik khusus atau khusus yang mungkin tidak diwakili dengan baik dalam pengetahuan pra-terlatih model.

- Pengendalian pertanyaan yang lebih baik: RAG sangat berkesan untuk mengendalikan pertanyaan panjang atau topik yang tidak biasa. Dengan mengambil dokumen yang berkaitan, LLM boleh menjana tindak balas yang bermaklumat walaupun untuk pertanyaan yang kurang umum atau sangat spesifik.

- Pengalaman pengguna yang dipertingkatkan: Penyepaduan pengambilan semula dan generasi memberikan tindak balas yang lebih mantap dan berguna, meningkatkan pengalaman pengguna secara keseluruhan. Pengguna menerima jawapan yang bukan sahaja koheren tetapi juga berasaskan maklumat yang relevan dan terkini.

Penilaian LLMS

Menilai model bahasa yang besar (LLMS) adalah aspek penting untuk memastikan keberkesanan, kebolehpercayaan, dan kebolehgunaannya merentasi pelbagai tugas. Penilaian yang betul membantu mengenal pasti kekuatan dan kelemahan, penambahbaikan panduan, dan memastikan bahawa LLM memenuhi piawaian yang diperlukan untuk aplikasi yang berbeza.

Kepentingan penilaian dalam aplikasi LLM

- Memastikan ketepatan dan kebolehpercayaan: Bantuan penilaian prestasi dalam memahami betapa baik dan konsisten LLM menyelesaikan tugas seperti penjanaan teks, ringkasan, atau menjawab soalan. Dan sementara saya memihak kepada pendekatan yang lebih holistik di dalam kelas, maklum balas yang khusus dengan cara ini sangat berharga untuk jenis aplikasi yang sangat spesifik yang sangat bergantung pada terperinci, dalam bidang seperti ubat atau undang -undang.

- Panduan Model Penambahbaikan: Melalui penilaian, pemaju dapat mengenal pasti kawasan tertentu di mana LLM mungkin jatuh pendek. Maklum balas ini penting untuk penapisan prestasi model, menyesuaikan data latihan, atau mengubah algoritma untuk meningkatkan keberkesanan keseluruhan.

- Langkah -langkah prestasi terhadap penanda aras: Menilai LLMS terhadap tanda aras yang ditubuhkan membolehkan perbandingan dengan model lain dan versi terdahulu. Proses penandaarasan ini membantu kita memahami prestasi model dan mengenal pasti bidang untuk penambahbaikan.

- Memastikan penggunaan etika dan selamat: Ia mempunyai bahagian dalam menentukan sejauh mana LLMs menghormati prinsip -prinsip etika dan piawaian mengenai keselamatan. Ia membantu dalam mengenal pasti kecenderungan, kandungan yang tidak diingini dan faktor lain yang boleh menyebabkan penggunaan teknologi yang bertanggungjawab dikompromikan.

- Menyokong aplikasi dunia nyata: Oleh sebab itu, penilaian yang betul dan menyeluruh diperlukan untuk memahami bagaimana LLM berfungsi dalam amalan. Ini melibatkan menilai prestasi mereka dalam menyelesaikan pelbagai tugas, beroperasi di seluruh senario yang berbeza, dan menghasilkan hasil yang berharga dalam kes-kes dunia sebenar.

Cabaran dalam Menilai LLM

- Subjektiviti dalam metrik penilaian: Banyak metrik penilaian, seperti penghakiman manusia yang relevan atau koheren, boleh menjadi subjektif. Subjektiviti ini menjadikannya mencabar untuk menilai prestasi model secara konsisten dan boleh membawa kepada kebolehubahan dalam hasil.

- Kesukaran mengukur pemahaman yang bernuansa: Menilai keupayaan LLM untuk memahami pertanyaan yang kompleks atau bernuansa adalah sememangnya sukar. Metrik semasa mungkin tidak sepenuhnya menangkap kedalaman pemahaman yang diperlukan untuk output berkualiti tinggi, yang membawa kepada penilaian yang tidak lengkap.

- Isu Skalabiliti: Menilai LLMs menjadi semakin mahal kerana struktur ini berkembang dan menjadi lebih rumit. Ia juga penting untuk diperhatikan bahawa, penilaian komprehensif adalah memakan masa dan memerlukan banyak kuasa pengiraan yang boleh dengan cara menghalang proses ujian.

- Kebimbangan Bias dan Keadilan: Tidak mudah untuk menilai LLM untuk kecenderungan dan keadilan kerana bias boleh mengambil bentuk dan bentuk yang berbeza. Untuk memastikan ketepatan tetap konsisten merentasi demografi dan situasi yang berbeza, kaedah penilaian yang ketat dan rumit adalah penting.

- Sifat bahasa dinamik: Bahasa sentiasa berkembang, dan apa yang menjadi maklumat yang tepat atau relevan dapat berubah dari masa ke masa. Penilai mesti menilai LLM bukan sahaja untuk prestasi semasa mereka tetapi juga untuk kesesuaian mereka untuk trend bahasa yang berkembang, memandangkan sifat dinamik model.

Generasi output yang dikekang untuk LLM

Generasi terkawal melibatkan mengarahkan LLM untuk menghasilkan output yang mematuhi kekangan atau peraturan tertentu. Pendekatan ini adalah penting apabila ketepatan dan kepatuhan kepada format tertentu diperlukan. Sebagai contoh, dalam aplikasi seperti dokumentasi undang -undang atau laporan rasmi, sangat penting bahawa teks yang dihasilkan mengikuti garis panduan dan struktur yang ketat.

Anda boleh mencapai generasi terkawal dengan mendefinisikan templat output, menetapkan sempadan kandungan, atau menggunakan kejuruteraan segera untuk membimbing respons LLM. Dengan menggunakan kekangan ini, pemaju dapat memastikan bahawa output LLM bukan sahaja relevan tetapi juga mematuhi piawaian yang diperlukan, mengurangkan kemungkinan tindak balas yang tidak relevan atau luar topik.

Menurunkan suhu untuk output yang lebih berstruktur

Parameter suhu dalam LLMS mengawal tahap rawak dalam teks yang dihasilkan. Mengurangkan hasil suhu lebih banyak output yang boleh diramal dan berstruktur. Apabila suhu ditetapkan kepada nilai yang lebih rendah (misalnya, 0.1 hingga 0.3), penjanaan tindak balas model menjadi lebih deterministik, memihak kepada kata-kata dan frasa yang lebih tinggi. Ini membawa kepada output yang lebih koheren dan sejajar dengan format yang diharapkan.

Bagi aplikasi di mana konsistensi dan ketepatan adalah penting, seperti ringkasan data atau dokumentasi teknikal, menurunkan suhu memastikan bahawa respons kurang bervariasi dan lebih berstruktur. Sebaliknya, suhu yang lebih tinggi memperkenalkan lebih banyak kebolehubahan dan kreativiti, yang mungkin kurang diingini dalam konteks yang memerlukan pematuhan yang ketat untuk format dan kejelasan.

Rantaian pemikiran pemikiran untuk LLM

Rantaian pemikiran pemikiran adalah teknik yang menggalakkan LLM untuk menjana output dengan mengikuti urutan langkah -langkah logik, sama dengan proses penalaran manusia. Kaedah ini melibatkan memecahkan masalah yang kompleks ke dalam komponen yang lebih kecil, terkawal dan menyatakan proses pemikiran di belakang setiap langkah.

Dengan menggunakan rantaian pemikiran pemikiran, LLM boleh menghasilkan tindak balas yang lebih komprehensif dan baik, yang sangat berguna untuk tugas-tugas yang melibatkan penjelasan penyelesaian masalah atau terperinci. Pendekatan ini bukan sahaja meningkatkan kejelasan teks yang dihasilkan tetapi juga membantu dalam mengesahkan ketepatan respons dengan memberikan pandangan telus mengenai proses penalaran model.

Fungsi memanggil Openai vs llama

Keupayaan panggilan fungsi berbeza antara model OpenAI dan model Llama Meta. Model Openai, seperti GPT-4, menawarkan ciri-ciri panggilan fungsi maju melalui API mereka, yang membolehkan integrasi dengan fungsi luaran atau perkhidmatan. Keupayaan ini membolehkan model melaksanakan tugas -tugas di luar penjanaan teks semata -mata, seperti melaksanakan arahan atau memohon pangkalan data.

Sebaliknya, model Llama dari META mempunyai mekanisme panggilan fungsi mereka sendiri, yang mungkin berbeza dalam pelaksanaan dan skop. Walaupun kedua -dua jenis model menyokong fungsi panggilan, spesifik integrasi, prestasi, dan fungsi mereka boleh berbeza -beza. Memahami perbezaan ini adalah penting untuk memilih model yang sesuai untuk aplikasi yang memerlukan interaksi kompleks dengan sistem luaran atau operasi berasaskan fungsi khusus.

Mencari LLMS untuk permohonan anda

Memilih model bahasa besar yang betul (LLM) untuk aplikasi anda memerlukan menilai keupayaannya, skalabilitas, dan seberapa baik ia memenuhi keperluan data dan integrasi khusus anda.

Adalah baik untuk merujuk kepada penanda aras prestasi pada pelbagai model bahasa besar (LLM) dalam siri yang berbeza seperti Baichuan, ChatGlm, DeepSeek, dan Internlm2. Di sini. Menilai prestasi mereka berdasarkan panjang konteks dan kiraan jarum. Ini membantu mendapatkan idea yang mana LLMs memilih untuk tugas -tugas tertentu.

Memilih model bahasa besar yang betul (LLM) untuk aplikasi anda melibatkan faktor penilaian seperti keupayaan model, keperluan pengendalian data, dan potensi integrasi. Pertimbangkan aspek seperti saiz model, pilihan penalaan, dan sokongan untuk fungsi khusus. Memadankan atribut ini ke keperluan aplikasi anda akan membantu anda memilih LLM yang menyediakan prestasi yang optimum dan sejajar dengan kes penggunaan khusus anda.

Leaderboard LMSYS Chatbot Arena adalah platform yang berkepentingan untuk menduduki ranking model bahasa besar (LLM) melalui perbandingan pasangan manusia. Ia memaparkan kedudukan model berdasarkan undi, menggunakan model Bradley-Terry untuk menilai prestasi dalam pelbagai kategori.

Kesimpulan

Ringkasnya, LLMs berkembang dengan kemajuan seperti fungsi panggilan dan pengambilan semula generasi (RAG). Ini meningkatkan kebolehan mereka dengan menambah output berstruktur dan pengambilan data masa nyata. Walaupun LLMS menunjukkan potensi yang besar, batasan mereka dalam ketepatan dan kemas kini masa nyata menyerlahkan keperluan untuk diperbaiki selanjutnya. Teknik seperti generasi terkawal, menurunkan suhu, dan rantaian pemikiran pemikiran membantu meningkatkan kebolehpercayaan dan kaitan output mereka. Kemajuan ini bertujuan untuk menjadikan LLM lebih berkesan dan tepat dalam pelbagai aplikasi.

Memahami perbezaan antara fungsi yang memanggil model OpenAI dan Llama membantu dalam memilih alat yang tepat untuk tugas -tugas tertentu. Sebagai kemajuan teknologi LLM, menangani cabaran -cabaran ini dan menggunakan teknik ini akan menjadi kunci untuk meningkatkan prestasi mereka di seluruh domain yang berbeza. Memanfaatkan perbezaan ini akan mengoptimumkan keberkesanannya dalam pelbagai aplikasi.

Soalan yang sering ditanya

Q1. Apakah batasan utama LLMS?A. LLM sering berjuang dengan ketepatan, kemas kini masa nyata, dan terhad oleh data latihan mereka, yang boleh memberi kesan kepada kebolehpercayaan mereka.

S2. Bagaimanakah Generasi Pengambilan Generasi (RAG) mendapat manfaat LLMS?A. RAG meningkatkan LLM dengan menggabungkan pengambilan data masa nyata, meningkatkan ketepatan dan kaitan output yang dihasilkan.

Q3. Apakah fungsi yang memanggil dalam konteks LLM?A. Panggilan fungsi membolehkan LLMs melaksanakan fungsi atau pertanyaan khusus semasa penjanaan teks, meningkatkan keupayaan mereka untuk melaksanakan tugas -tugas yang kompleks dan memberikan hasil yang tepat.

Q4. Bagaimanakah penurunan suhu menjejaskan output LLM?A. Menurunkan suhu dalam LLMS menghasilkan output yang lebih berstruktur dan boleh diramal dengan mengurangkan rawak dalam penjanaan teks, yang membawa kepada tindak balas yang lebih jelas dan lebih konsisten.

S5. Apakah rantaian pemikiran pemikiran di LLMS?A. Rantaian pemikiran pemikiran melibatkan maklumat pemprosesan secara berurutan untuk membina hujah atau penjelasan yang logik dan koheren, meningkatkan kedalaman dan kejelasan output LLM.

Atas ialah kandungan terperinci Meningkatkan LLM dengan output berstruktur dan panggilan fungsi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

7 AI yang kuat meminta setiap pengurus projek perlu menguasai sekarangMay 08, 2025 am 11:39 AM

7 AI yang kuat meminta setiap pengurus projek perlu menguasai sekarangMay 08, 2025 am 11:39 AMGeneratif AI, yang dicontohkan oleh chatbots seperti ChatGPT, menawarkan alat -alat yang berkuasa pengurus projek untuk menyelaraskan aliran kerja dan memastikan projek tetap mengikut jadual dan dalam anggaran. Walau bagaimanapun, penggunaan berkesan bergantung pada kerajinan yang betul. Tepat, terperinci

Mendefinisikan makna AGI yang sukar ditentukan melalui bantuan AI yang bergunaMay 08, 2025 am 11:37 AM

Mendefinisikan makna AGI yang sukar ditentukan melalui bantuan AI yang bergunaMay 08, 2025 am 11:37 AMCabaran untuk menentukan kecerdasan umum buatan (AGI) adalah penting. Tuntutan kemajuan AGI sering tidak mempunyai penanda aras yang jelas, dengan definisi yang disesuaikan agar sesuai dengan arahan penyelidikan yang telah ditetapkan. Artikel ini meneroka pendekatan baru untuk ditentukan

IBM Think 2025 mempamerkan peranan Watsonx.data dalam generatif AIMay 08, 2025 am 11:32 AM

IBM Think 2025 mempamerkan peranan Watsonx.data dalam generatif AIMay 08, 2025 am 11:32 AMIBM Watsonx.Data: Memperkenalkan Stack Data AI Enterprise Posisi IBM Watsonx.data sebagai platform penting bagi perusahaan yang bertujuan untuk mempercepatkan penyampaian penyelesaian AI generasi yang tepat dan berskala. Ini dicapai dengan memudahkan pengadu

Kebangkitan mesin robot humanoid semakin hampir.May 08, 2025 am 11:29 AM

Kebangkitan mesin robot humanoid semakin hampir.May 08, 2025 am 11:29 AMKemajuan pesat dalam robotik, yang didorong oleh kejayaan dalam AI dan sains bahan, bersedia untuk menyambut era baru robot humanoid. Selama bertahun -tahun, automasi perindustrian menjadi tumpuan utama, tetapi keupayaan robot dengan cepat

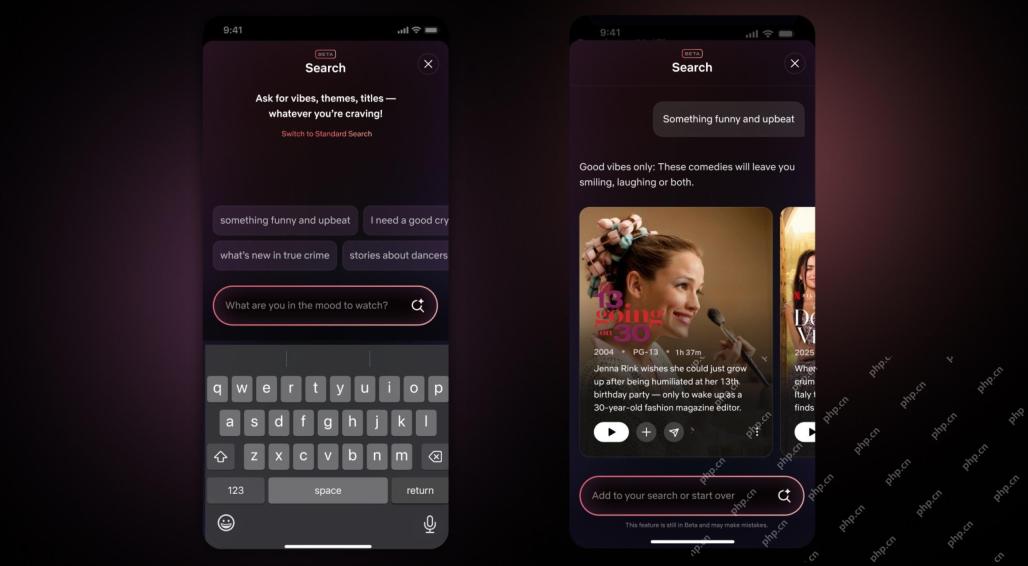

Netflix Revamps Interface-Debut Alat Carian AI dan Reka Bentuk Seperti TiktokMay 08, 2025 am 11:25 AM

Netflix Revamps Interface-Debut Alat Carian AI dan Reka Bentuk Seperti TiktokMay 08, 2025 am 11:25 AMKemas kini terbesar antara muka Netflix dalam satu dekad: lebih bijak, lebih diperibadikan, merangkumi pelbagai kandungan Netflix mengumumkan pembaikan terbesar antara muka penggunanya dalam satu dekad, bukan sahaja rupa baru, tetapi juga menambah lebih banyak maklumat mengenai setiap pertunjukan, dan memperkenalkan alat carian AI yang lebih bijak yang dapat memahami konsep samar -samar seperti "ambien" dan struktur yang lebih fleksibel untuk menunjukkan minat syarikat dalam permainan video yang baru muncul, acara langsung, acara sukan dan jenis kandungan baru. Untuk bersaing dengan trend, komponen video menegak baru di Mobile akan memudahkan peminat untuk menatal melalui treler dan klip, menonton pertunjukan penuh atau berkongsi kandungan dengan orang lain. Ini mengingatkan anda tentang Laman Web Video Short yang tidak terhingga dan sangat berjaya Ti

Jauh sebelum AGI: Tiga Pencapaian AI yang akan mencabar andaMay 08, 2025 am 11:24 AM

Jauh sebelum AGI: Tiga Pencapaian AI yang akan mencabar andaMay 08, 2025 am 11:24 AMPerbincangan yang semakin meningkat tentang kecerdasan umum (AGI) dalam kecerdasan buatan telah mendorong ramai untuk berfikir tentang apa yang berlaku apabila kecerdasan buatan melebihi kecerdasan manusia. Sama ada momen ini dekat atau jauh bergantung kepada siapa yang anda minta, tetapi saya tidak fikir ia adalah peristiwa penting yang harus kita fokuskan. Pencapaian AI yang sebelum ini akan menjejaskan semua orang? Apa tonggak yang telah dicapai? Berikut adalah tiga perkara yang saya fikir telah berlaku. Kecerdasan buatan melepasi kelemahan manusia Dalam filem "Dilema Sosial" 2022, Tristan Harris dari Pusat Teknologi Humane menegaskan bahawa kecerdasan buatan telah melampaui kelemahan manusia. Apa maksudnya? Ini bermaksud kecerdasan buatan telah dapat menggunakan manusia

Venkat Achanta pada transformasi platform TransUnion dan cita -cita AIMay 08, 2025 am 11:23 AM

Venkat Achanta pada transformasi platform TransUnion dan cita -cita AIMay 08, 2025 am 11:23 AMTransUnion's CTO, Ranganath Achanta, spearheaded a significant technological transformation since joining the company following its Neustar acquisition in late 2021. His leadership of over 7,000 associates across various departments has focused on u

Apabila kepercayaan AI melompat, produktiviti mengikutiMay 08, 2025 am 11:11 AM

Apabila kepercayaan AI melompat, produktiviti mengikutiMay 08, 2025 am 11:11 AMBangunan Amanah adalah yang paling penting untuk penggunaan AI yang berjaya dalam perniagaan. Hal ini terutama berlaku memandangkan elemen manusia dalam proses perniagaan. Pekerja, seperti orang lain, pelabuhan kebimbangan mengenai AI dan pelaksanaannya. Penyelidik Deloitte adalah SC

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

SecLists

SecLists ialah rakan penguji keselamatan muktamad. Ia ialah koleksi pelbagai jenis senarai yang kerap digunakan semasa penilaian keselamatan, semuanya di satu tempat. SecLists membantu menjadikan ujian keselamatan lebih cekap dan produktif dengan menyediakan semua senarai yang mungkin diperlukan oleh penguji keselamatan dengan mudah. Jenis senarai termasuk nama pengguna, kata laluan, URL, muatan kabur, corak data sensitif, cangkerang web dan banyak lagi. Penguji hanya boleh menarik repositori ini ke mesin ujian baharu dan dia akan mempunyai akses kepada setiap jenis senarai yang dia perlukan.

Pelayar Peperiksaan Selamat

Pelayar Peperiksaan Selamat ialah persekitaran pelayar selamat untuk mengambil peperiksaan dalam talian dengan selamat. Perisian ini menukar mana-mana komputer menjadi stesen kerja yang selamat. Ia mengawal akses kepada mana-mana utiliti dan menghalang pelajar daripada menggunakan sumber yang tidak dibenarkan.

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini

SublimeText3 versi Inggeris

Disyorkan: Versi Win, menyokong gesaan kod!

Muat turun versi mac editor Atom

Editor sumber terbuka yang paling popular