Semantik adalah penting kerana di NLP ia adalah hubungan antara kata -kata yang sedang dikaji. Salah satu prosedur yang paling mudah tetapi sangat berkesan ialah beg perkataan (cbow) yang berterusan yang memaparkan kata -kata kepada vektor yang sangat bermakna yang dipanggil vektor perkataan. CBow digunakan dalam rangka kerja Word2VEC dan meramalkan perkataan berdasarkan kata -kata yang bersebelahan dengannya yang menangkap makna semantik serta sintaksis bahasa. Dalam artikel ini, pembaca akan belajar tentang operasi model CBow, serta kaedah penggunaannya.

Objektif pembelajaran

- Memahami teori di sebalik model CBow.

- Ketahui perbezaan antara Cbow dan Skip-gram.

- Melaksanakan model CBow dalam Python dengan contoh dataset.

- Menganalisis kelebihan dan batasan CBow.

- Terokai kes penggunaan untuk embeddings perkataan yang dihasilkan oleh cbow.

Jadual Kandungan

- Apakah beg model kata yang berterusan?

- Bagaimana beg perkataan yang berterusan berfungsi

- Senibina Cbow dijelaskan secara terperinci

- Coding cbow dari awal (dengan contoh python)

- Kelebihan beg perkataan yang berterusan

- Batasan beg perkataan yang berterusan

- Soalan yang sering ditanya

Apakah beg model kata yang berterusan?

Beg berterusan kata -kata (cbow) juga merupakan model yang digunakan semasa menentukan perkataan embedding menggunakan rangkaian saraf dan merupakan sebahagian daripada model Word2Vec oleh Tomas Mikolov. Cbow cuba meramalkan perkataan sasaran bergantung pada kata -kata konteks yang memerhatikannya dalam ayat yang diberikan. Dengan cara ini ia dapat menangkap hubungan semantik sehingga kata -kata rapat diwakili rapat di ruang dimensi yang tinggi.

Sebagai contoh, dalam ayat "kucing duduk di atas tikar" , jika saiz tetingkap konteks adalah 2, kata -kata konteks untuk "duduk" adalah ["", "kucing", "on", "the"] , dan tugas model adalah untuk meramalkan perkataan "duduk" .

Cbow beroperasi dengan mengagregatkan kata -kata konteks (contohnya, purata embeddings mereka) dan menggunakan perwakilan agregat ini untuk meramalkan perkataan sasaran. Senibina model melibatkan lapisan input untuk kata -kata konteks, lapisan tersembunyi untuk generasi embedding, dan lapisan output untuk meramalkan perkataan sasaran menggunakan taburan kebarangkalian.

Ia adalah model yang cepat dan cekap yang sesuai untuk mengendalikan kata -kata yang kerap, menjadikannya sesuai untuk tugas -tugas yang memerlukan pemahaman semantik, seperti klasifikasi teks, sistem cadangan, dan analisis sentimen.

Bagaimana beg perkataan yang berterusan berfungsi

Cbow adalah salah satu teknik yang paling mudah tetapi cekap seperti konteks untuk membenamkan perkataan di mana seluruh perbendaharaan kata kata -kata dipetakan ke vektor. Bahagian ini juga menerangkan operasi sistem CBOW sebagai cara untuk memahami kaedah pada tahap yang paling asas, membincangkan idea -idea utama yang menyokong kaedah CBow, serta menawarkan panduan komprehensif kepada susun atur seni bina sistem pengiraan hit CBow.

Memahami konteks dan sasaran perkataan

CBow bergantung pada dua konsep utama: Kata Konteks dan Word Sasaran.

- Kata -kata konteks : Ini adalah kata -kata yang mengelilingi perkataan sasaran dalam saiz tetingkap yang ditetapkan. Sebagai contoh, dalam ayat:

"Rubah coklat cepat melompat ke atas anjing malas" ,

Jika perkataan sasaran adalah "Fox" dan saiz tetingkap konteks adalah 2, kata -kata konteks adalah ["cepat", "coklat", "melompat", "over"] . - Word sasaran : Ini adalah perkataan yang CBow bertujuan untuk meramalkan, memandangkan kata -kata konteks. Dalam contoh di atas, perkataan sasaran adalah "Fox" .

Dengan menganalisis hubungan antara konteks dan kata -kata sasaran di seluruh korpora besar, Cbow menghasilkan embeddings yang menangkap hubungan semantik antara kata -kata.

Proses langkah demi langkah cbow

Berikut adalah pecahan bagaimana kerja cbow, langkah demi langkah:

Langkah1: Penyediaan data

- Pilih korpus teks (misalnya, ayat atau perenggan).

- Menggalakkan teks ke dalam kata -kata dan membina perbendaharaan kata.

- Tentukan saiz tetingkap konteks NNN (misalnya, 2 perkataan di setiap sisi).

Langkah2: Menjana pasangan sasaran konteks

- Untuk setiap perkataan dalam korpus, ekstrak kata -kata konteksnya di sekelilingnya berdasarkan saiz tetingkap.

- Contoh: Untuk ayat "Saya suka pembelajaran mesin" dan n = 2n = 2n = 2, pasangannya adalah: kata -kata sasaran kata -kata cinta ["i", "mesin"] mesin ["cinta", "pembelajaran"]

Langkah 3: Pengekodan satu panas

Tukar kata-kata konteks dan sasaran perkataan menjadi vektor satu panas berdasarkan saiz perbendaharaan kata. Untuk perbendaharaan kata saiz 5, perwakilan satu-panas perkataan "cinta" mungkin kelihatan seperti [0, 1, 0, 0, 0] .

Langkah4: Lapisan Embedding

Lulus kata-kata konteks yang dikodkan satu-panas melalui lapisan embedding. Lapisan ini memaparkan setiap perkataan ke perwakilan vektor yang padat, biasanya dimensi yang lebih rendah daripada saiz perbendaharaan kata.

Langkah 5: Agregasi Konteks

Agregat embeddings semua kata konteks (misalnya, dengan merumuskan atau menjumlahkannya) untuk membentuk vektor konteks tunggal.

Langkah 6: Ramalan

- Makan vektor konteks agregat ke dalam rangkaian saraf yang disambungkan sepenuhnya dengan lapisan output softmax.

- Model ini meramalkan perkataan yang paling mungkin sebagai sasaran berdasarkan taburan kebarangkalian ke atas perbendaharaan kata.

Langkah7: Pengiraan dan pengoptimuman kerugian

- Kirakan ralat antara perkataan sasaran yang diramalkan dan sebenar menggunakan fungsi kehilangan silang entropi.

- Backpropagate ralat untuk menyesuaikan berat dalam lapisan penyembuhan dan ramalan.

Langkah8: Ulangi untuk semua pasangan

Ulangi proses untuk semua pasangan sasaran konteks di korpus sehingga model menumpu.

Senibina Cbow dijelaskan secara terperinci

Beg berterusan Arsitektur Model Kata -kata (CBow) direka untuk meramalkan perkataan sasaran berdasarkan kata -kata konteksnya. Ia adalah rangkaian saraf cetek dengan struktur yang mudah namun berkesan. Senibina CBow terdiri daripada komponen berikut:

Lapisan input

- Perwakilan Input :

Input kepada model adalah kata-kata konteks yang diwakili sebagai vektor yang dikodkan satu-panas .- Jika saiz perbendaharaan kata adalah V, setiap perkataan diwakili sebagai vektor satu-panas saiz V dengan satu 1 pada indeks yang sepadan dengan perkataan, dan 0s di tempat lain.

- Sebagai contoh, jika perbendaharaan kata adalah ["kucing", "anjing", "rubah", "pokok", "burung"] dan perkataan "rubah" adalah perkataan ketiga, vektor satu panas adalah [0,0,1,0,0] [0, 0, 1, 0, 0] [0,0,1,0,0].

- Tetingkap konteks :

Saiz tetingkap konteks n menentukan bilangan perkataan konteks yang digunakan. Jika n = 2, dua perkataan pada setiap sisi perkataan sasaran digunakan.- Untuk ayat: "Fox coklat cepat melompat ke atas anjing malas" dan sasaran perkataan "Fox" , kata -kata konteks dengan n = 2 adalah ["cepat", "coklat", "melompat", "over"] .

Lapisan Embedding

- Tujuan :

Lapisan ini menukarkan vektor satu panas yang wujud dalam dimensi yang tinggi ke dalam vektor dimensi yang padat dan rendah. Berbeza dengan fakta bahawa dalam kata -kata embedding perkataan diwakili sebagai vektor dengan kebanyakan nilai sifar, dalam lapisan embedding, setiap perkataan dikodkan oleh vektor berterusan dimensi yang diperlukan yang mencerminkan ciri -ciri khusus makna perkataan. - Matriks penyembuhan perkataan :

Lapisan embedding mengekalkan matriks penyembuhan perkataan w saiz v × d, di mana v adalah saiz perbendaharaan kata dan d adalah dimensi embedding.- Setiap baris W mewakili penyembuhan perkataan.

- Untuk vektor satu-panas xxx, embedding dikira sebagai w^tx x.

- Konteks Word Embeddings :

Setiap perkataan konteks diubah menjadi vektor padat yang sama menggunakan matriks embedding. Jika saiz tetingkap n = 2, dan kami mempunyai 4 perkataan konteks, embeddings untuk kata -kata ini diekstrak.

Lapisan Tersembunyi: Pengagregatan Konteks

- Tujuan :

Pembasmian kata -kata konteks digabungkan untuk membentuk vektor konteks tunggal. - Kaedah pengagregatan :

- Rata -rata : Embeddings semua kata konteks adalah purata untuk mengira vektor konteks.

- Summation : Daripada purata, embeddings disimpulkan.

- Hasil vektor konteks : Hasilnya adalah satu vektor padat HHH, yang mewakili konteks agregat kata -kata sekitarnya.

Lapisan output

- Tujuan : Lapisan output meramalkan perkataan sasaran menggunakan vektor konteks HHH.

- Lapisan yang disambungkan sepenuhnya : HHH vektor konteks diluluskan melalui lapisan yang disambungkan sepenuhnya, yang mengeluarkan skor mentah untuk setiap perkataan dalam perbendaharaan kata. Skor ini dipanggil logit.

- Fungsi SoftMax : Logit diluluskan melalui fungsi softmax untuk mengira taburan kebarangkalian melalui perbendaharaan kata:

- Word sasaran yang diramalkan : Sebab pertama ialah pada output softmax, algoritma mentakrifkan perkataan sasaran sebagai perkataan dengan kebarangkalian tertinggi.

Fungsi kerugian

- Kerugian silang silang digunakan untuk membandingkan taburan kebarangkalian yang diramalkan dengan perkataan sasaran sebenar (kebenaran tanah).

- Kerugian diminimumkan menggunakan teknik pengoptimuman seperti keturunan kecerunan stokastik (SGD) atau variannya.

Contoh Cbow dalam Tindakan

Input :

Kalimat: "Saya suka pembelajaran mesin" , sasaran perkataan: "mesin" , kata -kata konteks: ["Saya", "cinta", "belajar"] .

Pengekodan satu-panas :

Perbendaharaan Kata: ["Saya", "Cinta", "Mesin", "Belajar", "Ai"]

- Vektor satu panas:

- "I": [1,0,0,0,0] [1, 0, 0, 0, 0] [1,0,0,0,0]

- "Cinta": [0,1,0,0,0] [0, 1, 0, 0, 0] [0,1,0,0,0]

- "Pembelajaran": [0,0,0,1,0] [0, 0, 0, 1, 0] [0,0,0,1,0]

Lapisan Embedding :

- Dimensi embedding: D = 3.

- Menanam matriks w:

Embeddings:

- "Saya": [0.1,0.2,0.3]

- "Cinta": [0.4,0.5,0.6]

- "Pembelajaran": [0.2,0.3,0.4]

Pengagregatan :

- Rata -rata embeddings:

Lapisan output :

- Kirakan logit, gunakan softmax, dan meramalkan perkataan sasaran.

Diagram seni bina cbow

Lapisan Input: ["I", "Cinta", "Pembelajaran"]

-> Pengekodan satu-panas

-> Lapisan Embedding

-> Embeddings padat

-> vektor konteks agregat

-> softmax lapisan yang disambungkan sepenuhnya

Output: perkataan "mesin" yang diramalkan

Coding cbow dari awal (dengan contoh python)

Kami sekarang akan berjalan melalui pelaksanaan model CBow dari awal di Python.

Menyediakan data untuk Cbow

Spike pertama adalah untuk mengubah teks menjadi token, kata-kata yang dihasilkan ke dalam pasangan sasaran konteks dengan konteks sebagai kata-kata yang mengandungi perkataan sasaran.

Corpus = "Fox coklat cepat melompat ke atas anjing malas"

corpus = corpus.lower (). Split () # tokenisasi dan penukaran huruf kecil

# Tentukan saiz tetingkap konteks

C = 2

context_target_pairs = []

# Menghasilkan pasangan sasaran konteks

untuk i dalam julat (c, len (corpus) - c):

konteks = corpus [i - c: i] corpus [i 1: i c 1]

sasaran = corpus [i]

context_target_pairs.append ((konteks, sasaran))

Cetak ("Pasangan sasaran konteks:", context_target_pairs)

Output:

Pasangan sasaran konteks: [(['the', 'cepat', 'fox', 'melompat'], 'coklat'), (['cepat', 'coklat', 'melompat', 'over', 'fox'), ('coklat', 'fox', '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' '' (['melompat', 'lebih', 'malas', 'anjing'], '')]

Membuat Word Dictionary

Kami membina perbendaharaan kata (satu set kata yang unik), kemudian peta setiap perkataan ke indeks yang unik dan sebaliknya untuk mencari yang cekap semasa latihan.

# Buat perbendaharaan kata dan peta setiap perkataan ke indeks

vocab = set (corpus)

word_to_index = {word: idx for idx, word in enumerate (vocab)}

index_to_word = {idx: word for word, idx dalam word_to_index.items ()}

Cetak ("Kamus Word to Index:", word_to_index)

Output:

Word to Index Dictionary: {'Brown': 0, 'Dog': 1, 'Quick': 2, 'Jumps': 3, 'Fox': 4, 'Over': 5, 'the' the 'the' the 'the' the 'the' the ': 6, lazy': 7}

Contoh pengekodan satu panas

Pengekodan satu panas berfungsi dengan mengubah setiap perkataan dalam sistem pembentukan perkataan ke dalam vektor, di mana penunjuk perkataan adalah '1' manakala seluruh tempat mengambil '0,' atas sebab-sebab yang tidak lama lagi akan jelas.

def one_hot_encode (word, word_to_index):

one_hot = np.zeros (len (word_to_index))

one_hot [word_to_index [word]] = 1

kembali one_hot

# Contoh penggunaan untuk perkataan "cepat"

context_one_hot = [one_hot_encode (word, word_to_index) untuk perkataan dalam ['the', 'cepat']]

Cetak ("Pengekodan satu-panas untuk 'cepat':", context_one_hot [1])

Output:

Pengekodan satu panas untuk 'cepat': [0. 0. 1. 0. 0. 0. 0.]

Membina model cbow dari awal

Dalam langkah ini, kami membuat rangkaian neural asas dengan dua lapisan: satu untuk embeddings perkataan dan satu lagi untuk mengira output berdasarkan kata -kata konteks, dengan purata konteks dan lulus melalui rangkaian.

Kelas Cbow:

def __init __ (diri, vocab_size, embedding_dim):

# Secara rawak memulakan berat untuk lapisan embedding dan output

self.w1 = np.random.randn (vocab_size, embedding_dim)

self.w2 = np.random.randn (embedding_dim, vocab_size)

def forward (diri, context_words):

# Kirakan lapisan tersembunyi (purata perkataan konteks)

h = np.mean (context_words, paksi = 0)

# Kirakan lapisan output (kebarangkalian softmax)

output = np.dot (h, self.w2)

output pulangan

def ke belakang (diri, context_words, target_word, learning_rate = 0.01):

# Lulus ke hadapan

h = np.mean (context_words, paksi = 0)

output = np.dot (h, self.w2)

# Kirakan ralat dan kecerunan

ralat = sasaran_word - output

self.w2 = learning_rate * np.outer (h, ralat)

self.w1 = learning_rate * np.outer (context_words, ralat)

# Contoh membuat objek cbow

vocab_size = len (word_to_index)

embedding_dim = 5 # mari kita asumsikan embeddings 5 dimensi

cbow_model = cbow (vocab_size, embedding_dim)

# Menggunakan kata dan sasaran konteks rawak (sebagai contoh)

context_words = [one_hot_encode (word, word_to_index) untuk perkataan dalam ['the', 'cepat', 'fox', 'melompat']]

context_words = np.array (context_words)

context_words = np.mean (context_words, axis = 0) # kata -kata konteks purata

sasaran_word = one_hot_encode ('coklat', word_to_index)

# Lulus melalui model cbow

output = cbow_model.forward (context_words)

Cetak ("Output Cbow Forward Pass:", Output)

Output:

Output Cbow Forward Pass: [[-0.20435729 -0.23851241 -0.08105261 -0.14251447 0.20442154 0.14336586 -0.06523201 0.0255063] [-0.0192184 -0.12958821 0.1019369 0.11101922 -0.17773069 -0.02340574 -0.22222151 -0.23863179] [0.21221977 -0.15263454 -0.015248 0.27618767 0.02959409 0.21777961 0.16619577 -0.20560026] [0.05354038 0.06903295 0.0592706 -0.13509918 -0.00439649 0.18007843 0.1611929 0.2449023] [0.01092826 0.19643582 -0.07430934 -0.16443165 -0.01094085 -0.27452367 -0.13747784 0.31185284]]

Menggunakan Tensorflow untuk Melaksanakan Cbow

Tensorflow memudahkan proses dengan menentukan rangkaian saraf yang menggunakan lapisan penyembuhan untuk mempelajari perwakilan perkataan dan lapisan padat untuk output, menggunakan kata -kata konteks untuk meramalkan perkataan sasaran.

Import Tensorflow sebagai TF

# Tentukan model cbow mudah menggunakan tensorflow

Kelas CbowModel (tf.keras.model):

def __init __ (diri, vocab_size, embedding_dim):

super (cbowmodel, diri) .__ init __ ()

self.embeddings = tf.keras.layers.embedding (input_dim = vocab_size, output_dim = embedding_dim)

self.output_layer = tf.keras.layers.dense (vocab_size, activation = 'softMax')

DEF CALL (Diri, Context_Words):

embedded_context = self.embeddings (context_words)

context_avg = tf.reduce_mean (embedded_context, paksi = 1)

output = self.output_layer (context_avg)

output pulangan

# Contoh penggunaan

Model = CbowModel (vocab_size = 8, embedding_dim = 5)

context_input = np.random.randint (0, 8, saiz = (1, 4)) # input konteks rawak

context_input = tf.convert_to_tensor (context_input, dtype = tf.int32)

# Lulus ke hadapan

output = model (context_input)

Cetak ("Output model cbow tensorflow:", output.numpy ())

Output:

Output model cbow tensorflow: [[0.12362909 0.12616573 0.12758036 0.12601459 0.12477358 0.1237749 0.12319998 0.12486169]]

Menggunakan Gensim untuk Cbow

Gensim menawarkan pelaksanaan CBow dalam fungsi Word2Vec () di mana seseorang tidak perlu bekerja dengan latihan ketika Gensim melatih embeddings Word dari korpus teks.

Import Gensim

dari gensim.models import word2vec

# Sediakan data (senarai senarai perkataan)

corpus = [["the", "cepat", "coklat", "fox"], ["melompat", "over", "the", "malas", "dog"]]

# Melatih model Word2Vec menggunakan CBow

model = word2vec (corpus, vector_size = 5, window = 2, min_count = 1, sg = 0)

# Dapatkan perwakilan vektor perkataan

vektor = model.wv ['fox']

Cetak ("Perwakilan Vektor 'Fox':", Vektor)

Output:

Perwakilan vektor 'Fox': [-0.06810732 -0.01892803 0.11537147 -0.15043275 -0.07872207]

Kelebihan beg perkataan yang berterusan

Kami kini akan meneroka kelebihan beg perkataan yang berterusan:

- Pembelajaran Perwakilan Word yang cekap : Cbow dengan cekap mempelajari perwakilan vektor padat untuk kata -kata dengan menggunakan kata -kata konteks. Ini mengakibatkan vektor dimensi rendah berbanding pengekodan tradisional satu panas, yang boleh dikira mahal.

- Menangkap Hubungan Semantik : Cbow menangkap hubungan semantik antara kata -kata berdasarkan konteks mereka dalam korpus besar. Ini membolehkan model untuk mempelajari persamaan perkataan, sinonim, dan nuansa kontekstual yang lain, yang berguna dalam tugas seperti pengambilan maklumat dan analisis sentimen.

- Skalabiliti : Model CBow sangat berskala dan boleh memproses dataset yang besar dengan cekap, menjadikannya sesuai untuk aplikasi dengan sejumlah besar data teks, seperti enjin carian dan platform media sosial.

- Fleksibiliti Kontekstual : CBow boleh mengendalikan pelbagai konteks (iaitu, bilangan perkataan sekitar yang dipertimbangkan), yang menawarkan fleksibiliti dalam berapa banyak konteks yang diperlukan untuk mempelajari perwakilan perkataan.

- Prestasi yang lebih baik dalam Tugas NLP : Kata-kata kata CBow meningkatkan prestasi tugas NLP hiliran, seperti klasifikasi teks, pengiktirafan entiti yang dinamakan, dan terjemahan mesin, dengan menyediakan perwakilan ciri berkualiti tinggi.

Batasan beg perkataan yang berterusan

Marilah kita membincangkan batasan cbow:

- Sensitiviti kepada Saiz Tetingkap Konteks : Prestasi CBow sangat bergantung pada saiz tetingkap konteks. Tingkap kecil boleh mengakibatkan hanya menangkap hubungan tempatan, sementara tingkap besar boleh mengaburkan kata -kata yang jelas. Mencari saiz konteks yang optimum boleh mencabar dan bergantung kepada tugas.

- Lack of Word Order Sensitivity : CBOW disregards the order of words within the context, meaning it doesn't capture the sequential nature of language. Batasan ini boleh menjadi masalah untuk tugas -tugas yang memerlukan pemahaman yang mendalam tentang perintah perkataan, seperti parsing sintaksis dan pemodelan bahasa .

- Kesukaran dengan kata-kata yang jarang berlaku : perjuangan Cbow untuk menghasilkan embeddings yang bermakna untuk kata-kata jarang atau luar-vocabulary (OOV). Model ini bergantung pada konteks, tetapi data jarang untuk kata -kata yang jarang dapat menyebabkan perwakilan vektor yang lemah.

- Terhad kepada pemahaman kontekstual cetek : Walaupun CBow menangkap makna perkataan berdasarkan kata-kata sekitar, ia mempunyai keupayaan terhad dalam memahami fenomena linguistik yang lebih kompleks, seperti ketergantungan jarak jauh, ironi, atau sindiran, yang mungkin memerlukan model yang lebih canggih seperti transformer.

- Ketidakupayaan untuk mengendalikan polysemy dengan baik : kata -kata dengan pelbagai makna (polysemy) boleh menjadi masalah untuk cbow. Oleh kerana model menghasilkan satu penyembuhan tunggal untuk setiap perkataan, ia mungkin tidak menangkap makna yang berbeza perkataan yang boleh dimiliki dalam konteks yang berbeza, tidak seperti model yang lebih maju seperti Bert atau Elmo .

Kesimpulan

Model Beg Berterusan (CBOW) telah terbukti menjadi pendekatan yang cekap dan intuitif untuk menghasilkan embeddings perkataan dengan memanfaatkan konteks sekitarnya. Melalui seni bina yang mudah namun berkesan, CBow menjembatani jurang antara teks mentah dan perwakilan vektor yang bermakna, membolehkan pelbagai aplikasi NLP. Dengan memahami mekanisme kerja Cbow, kekuatan, dan batasannya, kita mendapat pandangan yang lebih mendalam tentang evolusi teknik NLP. Dengan peranan asasnya dalam generasi penyembuhan, CBow terus menjadi batu loncatan untuk meneroka model bahasa canggih.

Takeaways utama

- Cbow meramalkan perkataan sasaran menggunakan konteks sekitarnya, menjadikannya cekap dan mudah.

- Ia berfungsi dengan baik untuk kata -kata yang kerap, menawarkan kecekapan pengiraan.

- Pembasmian yang dipelajari oleh CBow menangkap kedua -dua hubungan semantik dan sintaksis.

- CBow adalah asas untuk memahami teknik penyembuhan perkataan moden.

- Aplikasi praktikal termasuk analisis sentimen, carian semantik, dan cadangan teks.

Soalan yang sering ditanya

S1: Apakah perbezaan antara cbow dan skip-gram?A: Cbow meramalkan perkataan sasaran menggunakan kata-kata konteks, sementara skip-gram meramalkan perkataan konteks menggunakan perkataan sasaran.

S2: Kenapa Cow Computasi lebih cepat daripada Skip-Gram?A: Cbow memproses pelbagai perkataan konteks secara serentak, sementara skip-gram menilai setiap perkataan konteks secara bebas.

S3: Bolehkah cbow mengendalikan kata -kata langka dengan berkesan?A: Tidak, Skip-gram pada umumnya lebih baik pada perwakilan pembelajaran untuk kata-kata yang jarang berlaku.

S4: Apakah peranan lapisan embedding di Cbow?A: Lapisan embedding mengubah vektor satu panas yang jarang menjadi perwakilan padat, menangkap semantik perkataan.

S5: Adakah CBow masih relevan hari ini?A: Ya, sementara model yang lebih baru seperti Bert wujud, Cbow tetap menjadi konsep asas dalam embeddings word.

Atas ialah kandungan terperinci Memahami Beg Berterusan Kata (Cbow). Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

7 AI yang kuat meminta setiap pengurus projek perlu menguasai sekarangMay 08, 2025 am 11:39 AM

7 AI yang kuat meminta setiap pengurus projek perlu menguasai sekarangMay 08, 2025 am 11:39 AMGeneratif AI, yang dicontohkan oleh chatbots seperti ChatGPT, menawarkan alat -alat yang berkuasa pengurus projek untuk menyelaraskan aliran kerja dan memastikan projek tetap mengikut jadual dan dalam anggaran. Walau bagaimanapun, penggunaan berkesan bergantung pada kerajinan yang betul. Tepat, terperinci

Mendefinisikan makna AGI yang sukar ditentukan melalui bantuan AI yang bergunaMay 08, 2025 am 11:37 AM

Mendefinisikan makna AGI yang sukar ditentukan melalui bantuan AI yang bergunaMay 08, 2025 am 11:37 AMCabaran untuk menentukan kecerdasan umum buatan (AGI) adalah penting. Tuntutan kemajuan AGI sering tidak mempunyai penanda aras yang jelas, dengan definisi yang disesuaikan agar sesuai dengan arahan penyelidikan yang telah ditetapkan. Artikel ini meneroka pendekatan baru untuk ditentukan

IBM Think 2025 mempamerkan peranan Watsonx.data dalam generatif AIMay 08, 2025 am 11:32 AM

IBM Think 2025 mempamerkan peranan Watsonx.data dalam generatif AIMay 08, 2025 am 11:32 AMIBM Watsonx.Data: Memperkenalkan Stack Data AI Enterprise Posisi IBM Watsonx.data sebagai platform penting bagi perusahaan yang bertujuan untuk mempercepatkan penyampaian penyelesaian AI generasi yang tepat dan berskala. Ini dicapai dengan memudahkan pengadu

Kebangkitan mesin robot humanoid semakin hampir.May 08, 2025 am 11:29 AM

Kebangkitan mesin robot humanoid semakin hampir.May 08, 2025 am 11:29 AMKemajuan pesat dalam robotik, yang didorong oleh kejayaan dalam AI dan sains bahan, bersedia untuk menyambut era baru robot humanoid. Selama bertahun -tahun, automasi perindustrian menjadi tumpuan utama, tetapi keupayaan robot dengan cepat

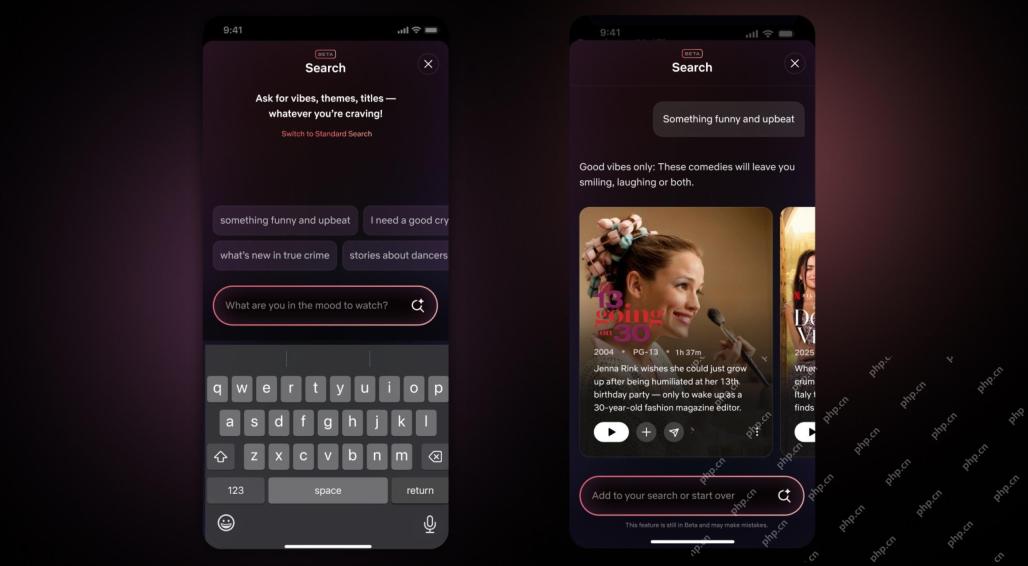

Netflix Revamps Interface-Debut Alat Carian AI dan Reka Bentuk Seperti TiktokMay 08, 2025 am 11:25 AM

Netflix Revamps Interface-Debut Alat Carian AI dan Reka Bentuk Seperti TiktokMay 08, 2025 am 11:25 AMKemas kini terbesar antara muka Netflix dalam satu dekad: lebih bijak, lebih diperibadikan, merangkumi pelbagai kandungan Netflix mengumumkan pembaikan terbesar antara muka penggunanya dalam satu dekad, bukan sahaja rupa baru, tetapi juga menambah lebih banyak maklumat mengenai setiap pertunjukan, dan memperkenalkan alat carian AI yang lebih bijak yang dapat memahami konsep samar -samar seperti "ambien" dan struktur yang lebih fleksibel untuk menunjukkan minat syarikat dalam permainan video yang baru muncul, acara langsung, acara sukan dan jenis kandungan baru. Untuk bersaing dengan trend, komponen video menegak baru di Mobile akan memudahkan peminat untuk menatal melalui treler dan klip, menonton pertunjukan penuh atau berkongsi kandungan dengan orang lain. Ini mengingatkan anda tentang Laman Web Video Short yang tidak terhingga dan sangat berjaya Ti

Jauh sebelum AGI: Tiga Pencapaian AI yang akan mencabar andaMay 08, 2025 am 11:24 AM

Jauh sebelum AGI: Tiga Pencapaian AI yang akan mencabar andaMay 08, 2025 am 11:24 AMPerbincangan yang semakin meningkat tentang kecerdasan umum (AGI) dalam kecerdasan buatan telah mendorong ramai untuk berfikir tentang apa yang berlaku apabila kecerdasan buatan melebihi kecerdasan manusia. Sama ada momen ini dekat atau jauh bergantung kepada siapa yang anda minta, tetapi saya tidak fikir ia adalah peristiwa penting yang harus kita fokuskan. Pencapaian AI yang sebelum ini akan menjejaskan semua orang? Apa tonggak yang telah dicapai? Berikut adalah tiga perkara yang saya fikir telah berlaku. Kecerdasan buatan melepasi kelemahan manusia Dalam filem "Dilema Sosial" 2022, Tristan Harris dari Pusat Teknologi Humane menegaskan bahawa kecerdasan buatan telah melampaui kelemahan manusia. Apa maksudnya? Ini bermaksud kecerdasan buatan telah dapat menggunakan manusia

Venkat Achanta pada transformasi platform TransUnion dan cita -cita AIMay 08, 2025 am 11:23 AM

Venkat Achanta pada transformasi platform TransUnion dan cita -cita AIMay 08, 2025 am 11:23 AMTransUnion's CTO, Ranganath Achanta, spearheaded a significant technological transformation since joining the company following its Neustar acquisition in late 2021. His leadership of over 7,000 associates across various departments has focused on u

Apabila kepercayaan AI melompat, produktiviti mengikutiMay 08, 2025 am 11:11 AM

Apabila kepercayaan AI melompat, produktiviti mengikutiMay 08, 2025 am 11:11 AMBangunan Amanah adalah yang paling penting untuk penggunaan AI yang berjaya dalam perniagaan. Hal ini terutama berlaku memandangkan elemen manusia dalam proses perniagaan. Pekerja, seperti orang lain, pelabuhan kebimbangan mengenai AI dan pelaksanaannya. Penyelidik Deloitte adalah SC

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

MantisBT

Mantis ialah alat pengesan kecacatan berasaskan web yang mudah digunakan yang direka untuk membantu dalam pengesanan kecacatan produk. Ia memerlukan PHP, MySQL dan pelayan web. Lihat perkhidmatan demo dan pengehosan kami.

MinGW - GNU Minimalis untuk Windows

Projek ini dalam proses untuk dipindahkan ke osdn.net/projects/mingw, anda boleh terus mengikuti kami di sana. MinGW: Port Windows asli bagi GNU Compiler Collection (GCC), perpustakaan import yang boleh diedarkan secara bebas dan fail pengepala untuk membina aplikasi Windows asli termasuk sambungan kepada masa jalan MSVC untuk menyokong fungsi C99. Semua perisian MinGW boleh dijalankan pada platform Windows 64-bit.

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Dreamweaver Mac版

Alat pembangunan web visual

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa