Rumah >Peranti teknologi >AI >Pengiktirafan teks adegan menggunakan pengenalan teks berasaskan penglihatan

Pengiktirafan teks adegan menggunakan pengenalan teks berasaskan penglihatan

- Lisa Kudrowasal

- 2025-03-14 09:45:09459semak imbas

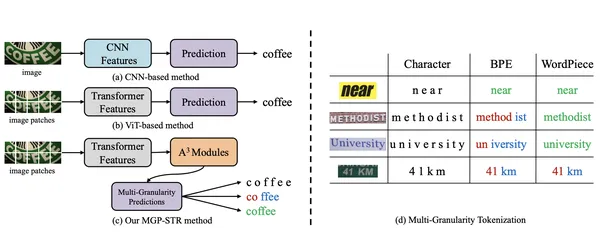

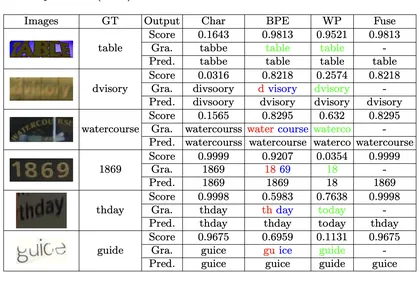

Pengiktirafan teks adegan (STR) kekal sebagai cabaran penting bagi penyelidik kerana pelbagai penampilan teks dalam tetapan dunia nyata. Mengiktiraf teks pada dokumen adalah berbeza daripada mengenal pasti teks pada t-shirt, misalnya. Ramalan multi-granulariti untuk model pengiktirafan teks adegan (MGP-STR), yang diperkenalkan di ECCV 2022, menawarkan pendekatan pecah tanah. MGP-STR menggabungkan keteguhan Transformers Visi (VIT) dengan ramalan linguistik multi-granulariti yang inovatif, meningkatkan keupayaannya untuk mengendalikan tugas STR yang kompleks. Ini menghasilkan ketepatan yang lebih tinggi dan kebolehgunaan yang lebih baik merentasi senario dunia sebenar yang mencabar, memberikan penyelesaian yang mudah namun berkuasa.

Mata pembelajaran utama

- Memahami seni bina dan komponen MGP-STR, termasuk Transformers Visi (VIT).

- Memahami bagaimana ramalan multi-granulariti meningkatkan ketepatan dan penyesuaian pengiktirafan teks adegan.

- Terokai aplikasi praktikal MGP-STR dalam tugas pengiktirafan watak optik dunia (OCR).

- Dapatkan pengalaman praktikal yang melaksanakan dan menggunakan MGP-STR dengan pytorch untuk pengiktirafan teks adegan.

*Artikel ini adalah sebahagian daripada *** Data Science Blogathon.

Jadual Kandungan

- Apa itu mgp-str?

- Aplikasi dan penggunaan kes MGP-STR

- Bermula dengan MGP-STR

- Langkah 1: Mengimport kebergantungan

- Langkah 2: Memuatkan model asas

- Langkah 3: Fungsi penolong untuk ramalan teks dari gambar

- Kesimpulan

- Soalan yang sering ditanya

Apa itu mgp-str?

MGP-STR adalah model STR berasaskan penglihatan tanpa memerlukan model bahasa yang berasingan. Ia mengintegrasikan maklumat linguistik terus ke dalam senibina menggunakan strategi ramalan multi-granulariti (MGP). Pendekatan tersirat ini membolehkan MGP-STR untuk mengatasi kedua-dua model visual semata-mata dan kaedah yang dipertingkatkan bahasa, mencapai hasil STR yang canggih.

Senibina terdiri daripada dua komponen utama:

- Transformer Visi (VIT)

- Modul a³

Gabungan ramalan pada watak, subword, dan tahap perkataan melalui strategi yang mudah namun berkesan memastikan MGP-STR menangkap butiran visual dan linguistik.

Aplikasi dan penggunaan kes MGP-STR

MGP-STR terutamanya untuk tugas OCR pada imej teks. Keupayaannya yang unik untuk secara tersirat menggabungkan pengetahuan linguistik menjadikannya sangat berguna dalam senario dunia nyata dengan teks yang bervariasi dan terdistorsi. Contohnya termasuk:

- Membaca teks dari adegan semula jadi (tanda jalan, papan iklan).

- Mengekstrak teks dari bentuk dan dokumen yang diimbas (tulisan tangan atau dicetak).

- Menganalisis teks dalam tetapan perindustrian (label produk, kod bar).

- Teks Terjemahan/Transkripsi dalam Aplikasi Realiti Tambahan (AR).

- Pengekstrakan maklumat dari dokumen yang diimbas atau gambar bahan bercetak.

- Membantu penyelesaian kebolehcapaian (pembaca skrin).

Ciri dan faedah utama

- Tidak perlu model bahasa bebas

- Ramalan multi-granulariti

- Prestasi terkini

- Mesra pengguna

Bermula dengan MGP-STR

Bahagian ini menunjukkan cara menggunakan MGP-STR untuk pengiktirafan teks adegan pada imej sampel. Anda memerlukan Pytorch, Perpustakaan Transformers, dan Ketergantungan (PIL, Permintaan).

Langkah 1: Mengimport perpustakaan yang diperlukan

Import perpustakaan yang diperlukan: Transformer untuk pengendalian model, PIL untuk manipulasi imej, dan permintaan untuk mengambil imej dalam talian.

<code>from transformers import MgpstrProcessor, MgpstrForSceneTextRecognition import requests import base64 from io import BytesIO from PIL import Image from IPython.display import display, Image as IPImage</code>

Langkah 2: Memuatkan model pra-terlatih

Muatkan model asas MGP-STR dan pemprosesnya daripada memeluk transformer muka.

<code>processor = MgpstrProcessor.from_pretrained('alibaba-damo/mgp-str-base') model = MgpstrForSceneTextRecognition.from_pretrained('alibaba-damo/mgp-str-base')</code>

Langkah 3: Pemprosesan Imej dan Fungsi Ramalan Teks

Buat fungsi untuk memasukkan URL imej, memprosesnya menggunakan MGP-STR, dan REDICTION TEXT. Ini mengendalikan penukaran imej, pengekodan BASE64, dan penyahkodan teks.

<code>def predict(url): image = Image.open(requests.get(url, stream=True).raw).convert("RGB") pixel_values = processor(images=image, return_tensors="pt").pixel_values outputs = model(pixel_values) generated_text = processor.batch_decode(outputs.logits)['generated_text'] buffered = BytesIO() image.save(buffered, format="PNG") image_base64 = base64.b64encode(buffered.getvalue()).decode("utf-8") display(IPImage(data=base64.b64decode(image_base64))) print("\n\n") return generated_text</code>

Contoh (menggunakan URL imej dari teks asal):

Contoh -contoh dengan URL imej dan ramalan ditinggalkan di sini untuk menjimatkan ruang, tetapi mereka akan mengikuti struktur yang sama seperti dalam teks asal, memanggil fungsi predict dengan URL imej yang berbeza.

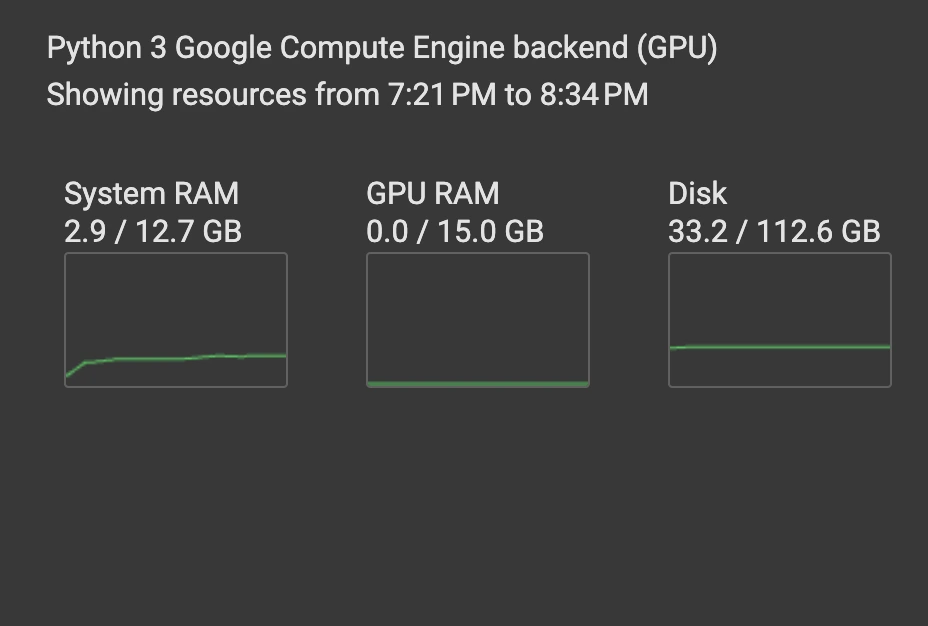

Ketepatan model terbukti dari contoh imej. Kecekapannya patut diberi perhatian, berjalan pada CPU dengan penggunaan RAM yang rendah. Ini menjadikannya mudah disesuaikan untuk penalaan halus pada tugas khusus domain.

Kesimpulan

MGP-STR berkesan menggabungkan pemahaman visi dan bahasa. Ramalan multi-granulariti yang inovatif memberikan pendekatan yang komprehensif untuk STR, meningkatkan ketepatan dan kesesuaian tanpa model bahasa luaran. Senibina yang mudah namun tepat menjadikannya alat yang berharga untuk penyelidik dan pemaju di OCR dan STR. Sifat sumber terbuka menggalakkan kemajuan selanjutnya dalam bidang.

Sumber

- Collab Google: [Pautan] (Ganti dengan pautan sebenar)

- Arxiv: [pautan] (ganti dengan pautan sebenar)

- Github: [link] (ganti dengan pautan sebenar)

- HuggingFace: [Link] (Ganti dengan pautan sebenar)

Mata utama

- MGP-STR mengintegrasikan visi dan bahasa tanpa model bahasa yang berasingan.

- Ramalan multi-granulariti meningkatkan prestasinya merentasi pelbagai cabaran.

- MGP-STR mencapai keputusan terkini dengan seni bina yang mudah.

- Ia mudah disesuaikan untuk pelbagai tugas OCR.

Soalan yang sering ditanya

S1: Apakah MGP-STR dan bagaimana ia berbeza daripada model STR tradisional? A1: MGP-STR mengintegrasikan ramalan linguistik terus ke dalam rangka kerja berasaskan penglihatan menggunakan MGP, menghapuskan keperluan untuk model bahasa berasingan yang terdapat dalam kaedah tradisional.

S2: Apakah dataset yang digunakan untuk melatih MGP-STR? A2: Model asas dilatih di MjSynth dan SynthText.

S3: Bolehkah MGP-STR mengendalikan imej teks yang terdistorsi atau berkualiti rendah? A3: Ya, mekanisme ramalan multi-granularitasnya membolehkan ia menangani cabaran tersebut.

S4: Adakah MGP-STR sesuai untuk bahasa selain bahasa Inggeris? A4: Walaupun dioptimumkan untuk bahasa Inggeris, ia boleh disesuaikan dengan bahasa lain dengan data latihan yang sesuai.

S5: Bagaimanakah modul A³ menyumbang kepada prestasi MGP-STR? A5: Modul A³ menyempurnakan output VIT, membolehkan ramalan peringkat subword dan membenamkan maklumat linguistik.

NOTA: Letak gambar imej tetap sama seperti dalam input asal. Ingatlah untuk menggantikan pautan kurungan dengan pautan sebenar.

Atas ialah kandungan terperinci Pengiktirafan teks adegan menggunakan pengenalan teks berasaskan penglihatan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI