Cina AI membuat langkah-langkah yang ketara, mencabar model terkemuka seperti GPT-4, Claude, dan Grok dengan alternatif sumber terbuka, sumber terbuka seperti DeepSeek-V3 dan Qwen 2.5. Model -model ini cemerlang kerana kecekapan, kebolehcapaian, dan prestasi yang kukuh. Ramai yang beroperasi di bawah lesen komersil yang permisif, memperluaskan rayuan mereka kepada pemaju dan perniagaan.

mari kita menyelidiki ciri-ciri MiniMax-Text-01:

Jadual Kandungan

Senibina Hibrid

- Strategi campuran-of-experts (MOE)

- strategi latihan dan skala

- Pengoptimuman selepas latihan

- Inovasi Utama

- Penanda aras akademik teras

- Tugas Umum Benchmarks

- Tugas Penalaran Benchmarks

- Benchmark Matematik & Pengekodan Benchmark

- Pautan penting

- Kesimpulan

- Senibina Hibrid

MiniMax-Text-01 Cleverly mengimbangi kecekapan dan prestasi dengan mengintegrasikan perhatian kilat, perhatian softmax, dan campuran-eksperts (MOE).

- Mekanisme perhatian linear ini secara drastik mengurangkan kerumitan pengiraan dari O (N²D) ke O (D²N), sesuai untuk pemprosesan konteks panjang. Ia menggunakan pengaktifan silu untuk transformasi input, operasi matriks untuk pengiraan skor perhatian, dan rmsnorm dan sigmoid untuk normalisasi dan skala.

- 1/8 Softmax Perhatian: Mekanisme perhatian tradisional, menggabungkan tali (embedding kedudukan berputar) pada separuh dimensi kepala perhatian, membolehkan panjang ekstrapolasi tanpa mengorbankan prestasi.

- Strategi campuran-of-experts (MOE)

Konfigurasi Pakar:

Infrastruktur Latihan:

memanfaatkan kira -kira 2000 H100 GPU, menggunakan teknik paralelisme lanjutan seperti Parallelism Tensor Pakar (ETP) dan urutan perhatian linear Parallelism Plus (LASP). Dioptimumkan untuk kuantisasi 8-bit untuk kesimpulan yang cekap pada nod 8x80gb H100.

Penalaan halus berulang: Kitaran Fine-Tuning (SFT) dan pembelajaran tetulang (RL), menggunakan DPO luar talian dan GRPO dalam talian untuk penjajaran.

Senibina pasca-norma meningkatkan kestabilan sambungan dan kestabilan latihan.

pemanasan saiz batch:

(Jadual menunjukkan hasil penanda aras untuk tugas umum, tugas penalaran, dan tugas matematik & pengekodan dimasukkan di sini, mencerminkan jadual input asal.)

(pautan parameter penilaian tambahan kekal)

(pautan parameter penilaian tambahan kekal)

Bermula dengan Minimax-Text-01

(Contoh kod untuk menggunakan minimax-text-01 dengan pelukan muka transformer tetap sama.)

Pautan penting

- chatbot

- API ONLINE

Minimax-Text-01 menunjukkan keupayaan yang mengagumkan, mencapai prestasi terkini dalam tugas-tugas konteks panjang dan umum. Walaupun kawasan untuk penambahbaikan wujud, sifat sumber terbuka, keberkesanan kos, dan seni bina inovatif menjadikannya pemain penting dalam bidang AI. Ia amat sesuai untuk aplikasi penalaran yang intensif dan kompleks memori, walaupun penambahbaikan selanjutnya untuk tugas pengekodan mungkin bermanfaat.

Atas ialah kandungan terperinci Token 4m? Minimax-Text-01 Outperforms DeepSeek V3. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

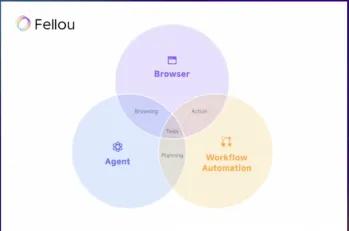

Cuba Fellou Ai dan mengucapkan selamat tinggal kepada Google dan ChatgptMay 12, 2025 am 10:26 AM

Cuba Fellou Ai dan mengucapkan selamat tinggal kepada Google dan ChatgptMay 12, 2025 am 10:26 AMLandskap pelayaran dalam talian telah menjalani transformasi yang signifikan pada tahun lalu. Peralihan ini bermula dengan hasil carian yang dipertingkatkan, diperibadikan dari platform seperti kebingungan dan copilot, dan dipercepat dengan integrasi chatgpt dari web

Penggodaman peribadi akan menjadi beruang yang cukup sengitMay 11, 2025 am 11:09 AM

Penggodaman peribadi akan menjadi beruang yang cukup sengitMay 11, 2025 am 11:09 AMCyberattacks berkembang. Sudahlah hari -hari e -mel phishing generik. Masa depan jenayah siber adalah hiper-peribadi, memanfaatkan data dalam talian yang sedia ada dan AI untuk membuat serangan yang sangat disasarkan. Bayangkan seorang penipu yang mengetahui pekerjaan anda, f anda

Pope Leo XIV mendedahkan bagaimana AI mempengaruhi pilihan namanyaMay 11, 2025 am 11:07 AM

Pope Leo XIV mendedahkan bagaimana AI mempengaruhi pilihan namanyaMay 11, 2025 am 11:07 AMDalam alamat sulungnya ke Kolej Kardinal, kelahiran Chicago Robert Francis Prevost, Paus Leo XIV yang baru dipilih, membincangkan pengaruhnya, Paus Leo XIII, yang Papacy (1878-1903) bertepatan dengan subuh kereta dan

Tutorial Fastapi -MCP untuk Pemula dan Pakar - Analytics VidhyaMay 11, 2025 am 10:56 AM

Tutorial Fastapi -MCP untuk Pemula dan Pakar - Analytics VidhyaMay 11, 2025 am 10:56 AMTutorial ini menunjukkan cara mengintegrasikan model bahasa besar anda (LLM) dengan alat luaran menggunakan Protokol Konteks Model (MCP) dan FastAPI. Kami akan membina aplikasi web yang mudah menggunakan Fastapi dan mengubahnya menjadi pelayan MCP, membolehkan l anda

Dia-1.6b TTS: Model Generasi Teks-ke-Dialog Terbaik-Analisis VidhyaMay 11, 2025 am 10:27 AM

Dia-1.6b TTS: Model Generasi Teks-ke-Dialog Terbaik-Analisis VidhyaMay 11, 2025 am 10:27 AMTerokai Dia-1.6b: Model teks-ke-ucapan yang dibangunkan oleh dua mahasiswa dengan pembiayaan sifar! Model parameter 1.6 bilion ini menghasilkan ucapan yang sangat realistik, termasuk isyarat nonverbal seperti ketawa dan bersin. Panduan artikel ini

3 cara ai dapat membuat bimbingan lebih bermakna dari sebelumnyaMay 10, 2025 am 11:17 AM

3 cara ai dapat membuat bimbingan lebih bermakna dari sebelumnyaMay 10, 2025 am 11:17 AMSaya sepenuh hati bersetuju. Kejayaan saya adalah berkaitan dengan bimbingan mentor saya. Wawasan mereka, terutamanya mengenai pengurusan perniagaan, membentuk dasar kepercayaan dan amalan saya. Pengalaman ini menggariskan komitmen saya kepada mentor

AI menggali potensi baru dalam industri perlombonganMay 10, 2025 am 11:16 AM

AI menggali potensi baru dalam industri perlombonganMay 10, 2025 am 11:16 AMPeralatan perlombongan AI yang dipertingkatkan Persekitaran operasi perlombongan adalah keras dan berbahaya. Sistem kecerdasan buatan membantu meningkatkan kecekapan dan keselamatan keseluruhan dengan menghapuskan manusia dari persekitaran yang paling berbahaya dan meningkatkan keupayaan manusia. Kecerdasan buatan semakin digunakan untuk menguasai trak autonomi, latihan dan pemuat yang digunakan dalam operasi perlombongan. Kenderaan berkuasa AI ini boleh beroperasi dengan tepat dalam persekitaran berbahaya, dengan itu meningkatkan keselamatan dan produktiviti. Sesetengah syarikat telah membangunkan kenderaan perlombongan autonomi untuk operasi perlombongan berskala besar. Peralatan yang beroperasi dalam persekitaran yang mencabar memerlukan penyelenggaraan yang berterusan. Walau bagaimanapun, penyelenggaraan boleh menyimpan peranti kritikal di luar talian dan menggunakan sumber. Penyelenggaraan yang lebih tepat bermakna peningkatan uptime untuk peralatan yang mahal dan diperlukan dan penjimatan kos yang signifikan. AI-didorong

Mengapa ejen AI akan mencetuskan revolusi tempat kerja terbesar dalam 25 tahunMay 10, 2025 am 11:15 AM

Mengapa ejen AI akan mencetuskan revolusi tempat kerja terbesar dalam 25 tahunMay 10, 2025 am 11:15 AMMarc Benioff, Ketua Pegawai Eksekutif Salesforce, meramalkan revolusi tempat kerja yang monumental yang didorong oleh ejen AI, transformasi yang sedang dijalankan dalam Salesforce dan pangkalan pelanggannya. Dia membayangkan peralihan dari pasaran tradisional ke pasaran yang jauh lebih besar yang difokuskan

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

SecLists

SecLists ialah rakan penguji keselamatan muktamad. Ia ialah koleksi pelbagai jenis senarai yang kerap digunakan semasa penilaian keselamatan, semuanya di satu tempat. SecLists membantu menjadikan ujian keselamatan lebih cekap dan produktif dengan menyediakan semua senarai yang mungkin diperlukan oleh penguji keselamatan dengan mudah. Jenis senarai termasuk nama pengguna, kata laluan, URL, muatan kabur, corak data sensitif, cangkerang web dan banyak lagi. Penguji hanya boleh menarik repositori ini ke mesin ujian baharu dan dia akan mempunyai akses kepada setiap jenis senarai yang dia perlukan.

Dreamweaver Mac版

Alat pembangunan web visual

MinGW - GNU Minimalis untuk Windows

Projek ini dalam proses untuk dipindahkan ke osdn.net/projects/mingw, anda boleh terus mengikuti kami di sana. MinGW: Port Windows asli bagi GNU Compiler Collection (GCC), perpustakaan import yang boleh diedarkan secara bebas dan fail pengepala untuk membina aplikasi Windows asli termasuk sambungan kepada masa jalan MSVC untuk menyokong fungsi C99. Semua perisian MinGW boleh dijalankan pada platform Windows 64-bit.

SublimeText3 versi Inggeris

Disyorkan: Versi Win, menyokong gesaan kod!

Versi Mac WebStorm

Alat pembangunan JavaScript yang berguna