Peranti teknologi

Peranti teknologi AI

AI Penalaan Llama 2: Panduan Langkah demi Langkah untuk Menyesuaikan Model Bahasa Besar

Penalaan Llama 2: Panduan Langkah demi Langkah untuk Menyesuaikan Model Bahasa BesarPenalaan Llama 2: Panduan Langkah demi Langkah untuk Menyesuaikan Model Bahasa Besar

Llama Meta mencetuskan lonjakan dalam pembangunan model bahasa besar (LLM), yang bertujuan untuk menyaingi model seperti GPT-3.5. Komuniti sumber terbuka dengan cepat menghasilkan model yang semakin kuat, tetapi kemajuan ini tidak tanpa cabaran. Banyak LLM sumber terbuka mempunyai lesen yang ketat (penggunaan penyelidikan sahaja), memerlukan belanjawan besar untuk penalaan halus, dan mahal untuk digunakan.

lelaran baru Llama menangani isu-isu ini dengan lesen komersial dan kaedah baru yang membolehkan penalaan halus pada GPU gred pengguna dengan memori terhad. Ini demokrasi AI, yang membolehkan organisasi yang lebih kecil membuat model yang disesuaikan.

Panduan ini menunjukkan penalaan Llama-2 di Google Colab, menggunakan teknik yang cekap untuk mengatasi kekangan sumber. Kami akan meneroka metodologi yang meminimumkan penggunaan memori dan mempercepatkan latihan.

imej yang dihasilkan oleh pengarang menggunakan dall-e 3

Fine-Tuning Llama-2: Panduan Langkah demi Langkah

Tutorial ini Fine-sees parameter 7 bilion model Llama-2 pada T4 GPU (tersedia di Google Colab atau Kaggle). VRAM 16GB T4 memerlukan penalaan halus yang cekap parameter, khususnya menggunakan Qlora (ketepatan 4-bit). Kami akan menggunakan ekosistem muka yang memeluk (Transformers, Mempercepatkan, PEFT, TRL, Bitsandbytes).

1. Persediaan:

Pasang perpustakaan yang diperlukan:

<code>%%capture %pip install accelerate peft bitsandbytes transformers trl</code>

Modul Import:

<code>import os

import torch

from datasets import load_dataset

from transformers import (

AutoModelForCausalLM,

AutoTokenizer,

BitsAndBytesConfig,

TrainingArguments,

pipeline,

logging,

)

from peft import LoraConfig

from trl import SFTTrainer</code>

2. Pemilihan Model & Dataset:

Kami akan menggunakan NousResearch/Llama-2-7b-chat-hf (setara dengan mudah diakses dengan Llama-2 rasmi) sebagai model asas dan mlabonne/guanaco-llama2-1k sebagai dataset latihan kami yang lebih kecil.

<code>base_model = "NousResearch/Llama-2-7b-chat-hf" guanaco_dataset = "mlabonne/guanaco-llama2-1k" new_model = "llama-2-7b-chat-guanaco"</code>Imej

yang menggambarkan model muka dan dataset yang memeluk disertakan di sini, sama seperti asal.

3. Memuatkan Data & Model:

Muatkan dataset:

<code>dataset = load_dataset(guanaco_dataset, split="train")</code>

Konfigurasi kuantisasi 4-bit menggunakan qlora:

<code>compute_dtype = getattr(torch, "float16")

quant_config = BitsAndBytesConfig(

load_in_4bit=True,

bnb_4bit_quant_type="nf4",

bnb_4bit_compute_dtype=compute_dtype,

bnb_4bit_use_double_quant=False,

)</code>

Muatkan model Llama-2 dengan kuantisasi 4-bit:

<code>model = AutoModelForCausalLM.from_pretrained(

base_model,

quantization_config=quant_config,

device_map={"": 0}

)

model.config.use_cache = False

model.config.pretraining_tp = 1</code>

Muatkan tokenizer:

<code>tokenizer = AutoTokenizer.from_pretrained(base_model, trust_remote_code=True) tokenizer.pad_token = tokenizer.eos_token tokenizer.padding_side = "right"</code>

imej yang menggambarkan qlora disertakan di sini, sama seperti asal.

4. Konfigurasi PEFT:

Tentukan parameter PEFT untuk penalaan halus yang cekap:

<code>peft_params = LoraConfig(

lora_alpha=16,

lora_dropout=0.1,

r=64,

bias="none",

task_type="CAUSAL_LM",

)</code>

5. Parameter Latihan:

Tetapkan Hyperparameters Latihan (direktori output, zaman, saiz batch, kadar pembelajaran, dan lain -lain). Butiran sama dengan yang asal.

6. Fine-penalaan dengan SFT:

Gunakan SFTTrainer dari perpustakaan TRL untuk penalaan halus yang diselia:

<code>trainer = SFTTrainer(

model=model,

train_dataset=dataset,

peft_config=peft_params,

dataset_text_field="text",

max_seq_length=None,

tokenizer=tokenizer,

args=training_params,

packing=False,

)

trainer.train()

trainer.model.save_pretrained(new_model)

trainer.tokenizer.save_pretrained(new_model)</code>

Tangkapan skrin menunjukkan kemajuan latihan dan penjimatan model disertakan di sini, sama seperti asal.

7. Evaluasi:

Gunakan saluran paip transformers untuk menguji model halus. Contoh disediakan, sama seperti asal.

8. Visualisasi Tensorboard:

Pelancaran Tensorboard untuk memantau metrik latihan.

<code>%%capture %pip install accelerate peft bitsandbytes transformers trl</code>

tangkapan skrin Tensorboard dimasukkan di sini, sama seperti asal.

Kesimpulan:

Panduan ini mempamerkan penalaan halus Llama-2 yang cekap pada perkakasan terhad. Penggunaan QLORA dan teknik lain menjadikan LLM canggih dapat diakses oleh khalayak yang lebih luas. Sumber -sumber dan laluan pembelajaran selanjutnya disebut pada akhirnya, sama seperti yang asal, tetapi tanpa panggilan pemasaran untuk tindakan.

Atas ialah kandungan terperinci Penalaan Llama 2: Panduan Langkah demi Langkah untuk Menyesuaikan Model Bahasa Besar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

7 AI yang kuat meminta setiap pengurus projek perlu menguasai sekarangMay 08, 2025 am 11:39 AM

7 AI yang kuat meminta setiap pengurus projek perlu menguasai sekarangMay 08, 2025 am 11:39 AMGeneratif AI, yang dicontohkan oleh chatbots seperti ChatGPT, menawarkan alat -alat yang berkuasa pengurus projek untuk menyelaraskan aliran kerja dan memastikan projek tetap mengikut jadual dan dalam anggaran. Walau bagaimanapun, penggunaan berkesan bergantung pada kerajinan yang betul. Tepat, terperinci

Mendefinisikan makna AGI yang sukar ditentukan melalui bantuan AI yang bergunaMay 08, 2025 am 11:37 AM

Mendefinisikan makna AGI yang sukar ditentukan melalui bantuan AI yang bergunaMay 08, 2025 am 11:37 AMCabaran untuk menentukan kecerdasan umum buatan (AGI) adalah penting. Tuntutan kemajuan AGI sering tidak mempunyai penanda aras yang jelas, dengan definisi yang disesuaikan agar sesuai dengan arahan penyelidikan yang telah ditetapkan. Artikel ini meneroka pendekatan baru untuk ditentukan

IBM Think 2025 mempamerkan peranan Watsonx.data dalam generatif AIMay 08, 2025 am 11:32 AM

IBM Think 2025 mempamerkan peranan Watsonx.data dalam generatif AIMay 08, 2025 am 11:32 AMIBM Watsonx.Data: Memperkenalkan Stack Data AI Enterprise Posisi IBM Watsonx.data sebagai platform penting bagi perusahaan yang bertujuan untuk mempercepatkan penyampaian penyelesaian AI generasi yang tepat dan berskala. Ini dicapai dengan memudahkan pengadu

Kebangkitan mesin robot humanoid semakin hampir.May 08, 2025 am 11:29 AM

Kebangkitan mesin robot humanoid semakin hampir.May 08, 2025 am 11:29 AMKemajuan pesat dalam robotik, yang didorong oleh kejayaan dalam AI dan sains bahan, bersedia untuk menyambut era baru robot humanoid. Selama bertahun -tahun, automasi perindustrian menjadi tumpuan utama, tetapi keupayaan robot dengan cepat

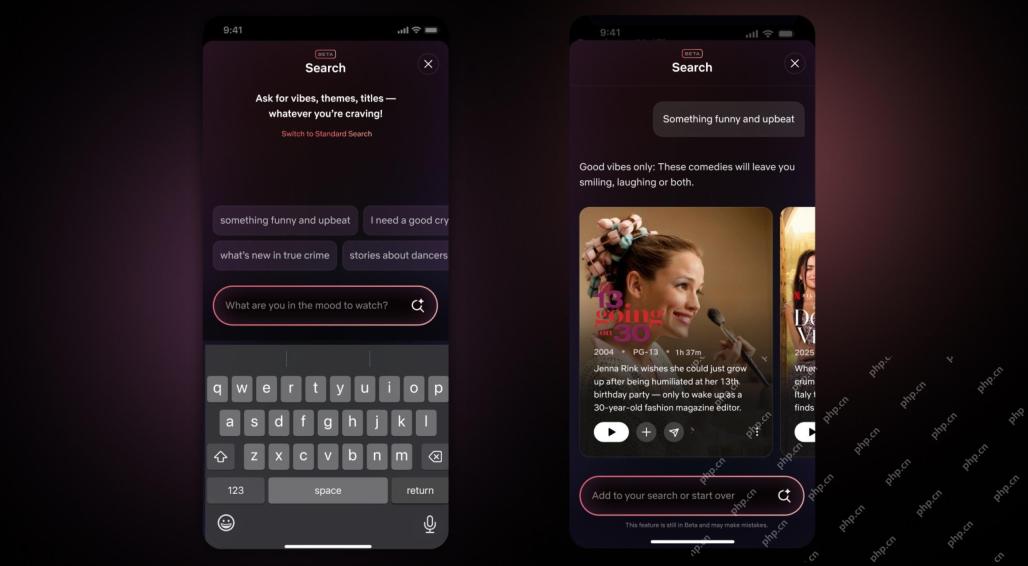

Netflix Revamps Interface-Debut Alat Carian AI dan Reka Bentuk Seperti TiktokMay 08, 2025 am 11:25 AM

Netflix Revamps Interface-Debut Alat Carian AI dan Reka Bentuk Seperti TiktokMay 08, 2025 am 11:25 AMKemas kini terbesar antara muka Netflix dalam satu dekad: lebih bijak, lebih diperibadikan, merangkumi pelbagai kandungan Netflix mengumumkan pembaikan terbesar antara muka penggunanya dalam satu dekad, bukan sahaja rupa baru, tetapi juga menambah lebih banyak maklumat mengenai setiap pertunjukan, dan memperkenalkan alat carian AI yang lebih bijak yang dapat memahami konsep samar -samar seperti "ambien" dan struktur yang lebih fleksibel untuk menunjukkan minat syarikat dalam permainan video yang baru muncul, acara langsung, acara sukan dan jenis kandungan baru. Untuk bersaing dengan trend, komponen video menegak baru di Mobile akan memudahkan peminat untuk menatal melalui treler dan klip, menonton pertunjukan penuh atau berkongsi kandungan dengan orang lain. Ini mengingatkan anda tentang Laman Web Video Short yang tidak terhingga dan sangat berjaya Ti

Jauh sebelum AGI: Tiga Pencapaian AI yang akan mencabar andaMay 08, 2025 am 11:24 AM

Jauh sebelum AGI: Tiga Pencapaian AI yang akan mencabar andaMay 08, 2025 am 11:24 AMPerbincangan yang semakin meningkat tentang kecerdasan umum (AGI) dalam kecerdasan buatan telah mendorong ramai untuk berfikir tentang apa yang berlaku apabila kecerdasan buatan melebihi kecerdasan manusia. Sama ada momen ini dekat atau jauh bergantung kepada siapa yang anda minta, tetapi saya tidak fikir ia adalah peristiwa penting yang harus kita fokuskan. Pencapaian AI yang sebelum ini akan menjejaskan semua orang? Apa tonggak yang telah dicapai? Berikut adalah tiga perkara yang saya fikir telah berlaku. Kecerdasan buatan melepasi kelemahan manusia Dalam filem "Dilema Sosial" 2022, Tristan Harris dari Pusat Teknologi Humane menegaskan bahawa kecerdasan buatan telah melampaui kelemahan manusia. Apa maksudnya? Ini bermaksud kecerdasan buatan telah dapat menggunakan manusia

Venkat Achanta pada transformasi platform TransUnion dan cita -cita AIMay 08, 2025 am 11:23 AM

Venkat Achanta pada transformasi platform TransUnion dan cita -cita AIMay 08, 2025 am 11:23 AMTransUnion's CTO, Ranganath Achanta, spearheaded a significant technological transformation since joining the company following its Neustar acquisition in late 2021. His leadership of over 7,000 associates across various departments has focused on u

Apabila kepercayaan AI melompat, produktiviti mengikutiMay 08, 2025 am 11:11 AM

Apabila kepercayaan AI melompat, produktiviti mengikutiMay 08, 2025 am 11:11 AMBangunan Amanah adalah yang paling penting untuk penggunaan AI yang berjaya dalam perniagaan. Hal ini terutama berlaku memandangkan elemen manusia dalam proses perniagaan. Pekerja, seperti orang lain, pelabuhan kebimbangan mengenai AI dan pelaksanaannya. Penyelidik Deloitte adalah SC

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

MinGW - GNU Minimalis untuk Windows

Projek ini dalam proses untuk dipindahkan ke osdn.net/projects/mingw, anda boleh terus mengikuti kami di sana. MinGW: Port Windows asli bagi GNU Compiler Collection (GCC), perpustakaan import yang boleh diedarkan secara bebas dan fail pengepala untuk membina aplikasi Windows asli termasuk sambungan kepada masa jalan MSVC untuk menyokong fungsi C99. Semua perisian MinGW boleh dijalankan pada platform Windows 64-bit.

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Pelayar Peperiksaan Selamat

Pelayar Peperiksaan Selamat ialah persekitaran pelayar selamat untuk mengambil peperiksaan dalam talian dengan selamat. Perisian ini menukar mana-mana komputer menjadi stesen kerja yang selamat. Ia mengawal akses kepada mana-mana utiliti dan menghalang pelajar daripada menggunakan sumber yang tidak dibenarkan.

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

VSCode Windows 64-bit Muat Turun

Editor IDE percuma dan berkuasa yang dilancarkan oleh Microsoft