Artikel ini meneroka keupayaan model bahasa kecil (SLMS) dalam pengekstrakan entiti, tugas pemprosesan bahasa semulajadi (NLP) yang penting. Ia membandingkan prestasi Gemma 2B, Llama 3.2 (versi 1b dan 3b), dan Qwen 7b dalam mengenal pasti dan mengklasifikasikan entiti seperti orang, organisasi, dan lokasi dalam teks tidak berstruktur. Artikel ini menekankan kelebihan SLMS atas kaedah tradisional, menonjolkan pemahaman dan kecekapan kontekstual mereka.

Manfaat teras menggunakan SLMS untuk pengekstrakan entiti adalah keupayaan mereka untuk mentafsirkan konteks kata-kata sekitar, yang membawa kepada pengenalan entiti yang lebih tepat berbanding dengan pendekatan pembelajaran mesin berasaskan peraturan atau lebih tua. Kesedaran kontekstual ini mengurangkan kesilapan yang disebabkan oleh istilah yang samar -samar.

Artikel ini memberikan gambaran terperinci bagi setiap SLM:

-

Gemma 2b: Model Google yang dibangunkan dengan 2 bilion parameter, panjang konteks token 8192, dan seni bina pengubah decoder sahaja. Data latihannya termasuk dokumen web, kod, dan teks matematik. -

llama 3.2 (1b & 3b): model berbilang bahasa Meta, menawarkan versi dengan 1.23 bilion dan 3.2 bilion parameter masing -masing. Kedua -duanya membanggakan panjang konteks 128,000 token dan dioptimumkan untuk dialog berbilang bahasa.

-

qwen 7b: Model Alibaba Cloud yang memaparkan 7 bilion parameter dan panjang konteks token 8,192. Ia juga menggunakan seni bina pengubah decoder sahaja.

Rangka kerja penilaian yang ketat diterangkan, memberi tumpuan kepada ketepatan pengekstrakan entiti merentasi kategori yang berlainan (projek, syarikat, orang). Jadual perbandingan meringkaskan prestasi setiap model, mendedahkan Gemma 2b sebagai keseluruhan yang paling tepat, walaupun Llama 3.2 3b menunjukkan kekuatan dalam mengenal pasti orang.

Kesimpulan mengulangi prestasi unggul SLM dalam pengekstrakan entiti, menekankan kepentingan pemahaman kontekstual dan kebolehsuaian. Artikel ini disimpulkan dengan seksyen FAQ yang menangani soalan umum mengenai SLM dan model tertentu yang dibincangkan.

(Nota: URL imej tetap tidak berubah. Kandungan teras artikel telah diuraikan semasa memelihara makna dan struktur asal. Jadual meringkaskan prestasi model juga dikekalkan.)

Atas ialah kandungan terperinci Gemma 2b vs llama 3.2 vs Qwen 7b. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Tesla's Robovan adalah permata tersembunyi pada penggoda Robotaxi 2024Apr 22, 2025 am 11:48 AM

Tesla's Robovan adalah permata tersembunyi pada penggoda Robotaxi 2024Apr 22, 2025 am 11:48 AMSejak tahun 2008, saya telah memperjuangkan van yang dikongsi bersama-pada masa yang digelar "Robotjitney," kemudian "Vansit" -dan masa depan pengangkutan bandar. Saya meramalkan kenderaan ini sebagai penyelesaian transit generasi akan datang abad ke-21, Surpas

Pertaruhan Kelab Sam di AI untuk menghapuskan cek resit dan meningkatkan runcitApr 22, 2025 am 11:29 AM

Pertaruhan Kelab Sam di AI untuk menghapuskan cek resit dan meningkatkan runcitApr 22, 2025 am 11:29 AMMerevolusikan pengalaman checkout Sistem "Just Go" inovatif Sam Club membina teknologi "imbasan & pergi" yang sedia ada AI yang sedia ada, yang membolehkan ahli mengimbas pembelian melalui aplikasi Sam's Club semasa perjalanan membeli-belah mereka.

AI Omniverse Nvidia berkembang di GTC 2025Apr 22, 2025 am 11:28 AM

AI Omniverse Nvidia berkembang di GTC 2025Apr 22, 2025 am 11:28 AMPredictability dan barisan produk baru NVIDIA di GTC 2025 Nvidia, pemain utama dalam infrastruktur AI, memberi tumpuan kepada peningkatan ramalan untuk pelanggannya. Ini melibatkan penghantaran produk yang konsisten, memenuhi jangkaan prestasi, dan

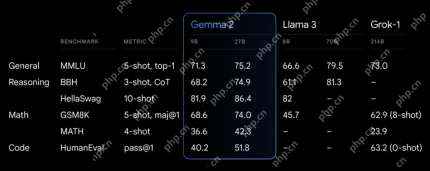

Meneroka keupayaan model Google ' s Gemma 2Apr 22, 2025 am 11:26 AM

Meneroka keupayaan model Google ' s Gemma 2Apr 22, 2025 am 11:26 AMGoogle's Gemma 2: Model bahasa yang kuat dan cekap Model Bahasa Gemma Google, yang disambut untuk kecekapan dan prestasi, telah berkembang dengan kedatangan Gemma 2. Siaran terbaru ini terdiri daripada dua model: parameter 27 bilion ver

Gelombang Seterusnya: Perspektif dengan Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AM

Gelombang Seterusnya: Perspektif dengan Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AMIni memimpin dengan episod data yang menampilkan Dr Kirk Borne, seorang saintis data terkemuka, astrofizik, dan pembesar suara TEDX. Pakar terkenal dalam Big Data, AI, dan Pembelajaran Mesin, Dr. Borne menawarkan pandangan yang tidak ternilai ke dalam keadaan semasa dan masa depan Traje

AI untuk pelari dan atlet: kami membuat kemajuan yang sangat baikApr 22, 2025 am 11:12 AM

AI untuk pelari dan atlet: kami membuat kemajuan yang sangat baikApr 22, 2025 am 11:12 AMTerdapat beberapa perspektif yang sangat berwawasan dalam maklumat ini mengenai maklumat mengenai kejuruteraan yang menunjukkan kepada kita mengapa kecerdasan buatan sangat baik untuk menyokong latihan fizikal orang. Saya akan menggariskan idea teras dari setiap perspektif penyumbang untuk menunjukkan tiga aspek reka bentuk yang merupakan bahagian penting dalam penerokaan penerokaan kecerdasan buatan dalam sukan. Peranti tepi dan data peribadi mentah Idea ini mengenai kecerdasan buatan sebenarnya mengandungi dua komponen -satu yang berkaitan dengan di mana kita meletakkan model bahasa yang besar dan yang lain berkaitan dengan perbezaan antara bahasa manusia dan bahasa yang kita tanda -tanda penting kita "menyatakan" apabila diukur dalam masa nyata. Alexander Amini tahu banyak tentang berlari dan tenis, tetapi dia masih

Jamie Engstrom mengenai Teknologi, Bakat dan Transformasi di CaterpillarApr 22, 2025 am 11:10 AM

Jamie Engstrom mengenai Teknologi, Bakat dan Transformasi di CaterpillarApr 22, 2025 am 11:10 AMKetua Pegawai Maklumat Caterpillar dan Naib Presiden Kanan IT, Jamie Engstrom, mengetuai pasukan global lebih dari 2,200 profesional IT di 28 negara. Dengan 26 tahun di Caterpillar, termasuk empat setengah tahun dalam peranannya sekarang, Engst

Kemas kini foto Google baru menjadikan sebarang foto pop dengan kualiti ultra HDRApr 22, 2025 am 11:09 AM

Kemas kini foto Google baru menjadikan sebarang foto pop dengan kualiti ultra HDRApr 22, 2025 am 11:09 AMAlat HDR Ultra baru Google Photos: Panduan Cepat Tingkatkan foto anda dengan alat Ultra HDR baru Google Photos, mengubah imej standard ke dalam karya-karya bertenaga, tinggi dinamik. Sesuai untuk media sosial, alat ini meningkatkan kesan foto,

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

MantisBT

Mantis ialah alat pengesan kecacatan berasaskan web yang mudah digunakan yang direka untuk membantu dalam pengesanan kecacatan produk. Ia memerlukan PHP, MySQL dan pelayan web. Lihat perkhidmatan demo dan pengehosan kami.

Penyesuai Pelayan SAP NetWeaver untuk Eclipse

Integrasikan Eclipse dengan pelayan aplikasi SAP NetWeaver.

ZendStudio 13.5.1 Mac

Persekitaran pembangunan bersepadu PHP yang berkuasa

VSCode Windows 64-bit Muat Turun

Editor IDE percuma dan berkuasa yang dilancarkan oleh Microsoft

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini