Latihan rangkaian saraf yang mendalam sering menghadapi halangan seperti kecerunan lenyap/meletup dan peralihan kovariat dalaman, melambatkan latihan dan menghalang pembelajaran. Teknik normalisasi menawarkan penyelesaian, dengan normalisasi batch (BN) yang sangat menonjol. BN mempercepatkan penumpuan, meningkatkan kestabilan, dan meningkatkan penyebaran dalam banyak seni bina pembelajaran mendalam. Tutorial ini menerangkan mekanik BN, asas matematiknya, dan pelaksanaan Tensorflow/Keras.

Normalisasi dalam pembelajaran mesin menyeragamkan data input, menggunakan kaedah seperti skala min-max, normalisasi z-skor, dan transformasi log kepada ciri-ciri rescale. Ini mengurangkan kesan luar, meningkatkan penumpuan, dan memastikan perbandingan ciri yang adil. Data yang dinormalisasi memastikan sumbangan ciri yang sama kepada proses pembelajaran, mencegah ciri-ciri skala yang lebih besar daripada mendominasi dan membawa kepada prestasi model suboptimal. Ia membolehkan model mengenal pasti corak yang bermakna dengan lebih berkesan.

Cabaran Latihan Pembelajaran Deep termasuk:

- Perubahan kovariat dalaman: perubahan pengedaran pengaktifan merentasi lapisan semasa latihan, menghalang penyesuaian dan pembelajaran.

- kecerunan lenyap/meletup: kecerunan menjadi terlalu kecil atau besar semasa backpropagation, menghalang kemas kini berat badan yang berkesan.

- Sensitiviti Inisialisasi: Berat awal mempengaruhi latihan; Inisialisasi yang lemah boleh menyebabkan penumpuan perlahan atau gagal.

normalisasi batch menangani ini dengan menormalkan pengaktifan dalam setiap batch mini, menstabilkan latihan dan meningkatkan prestasi model.

Normalisasi batch menormalkan pengaktifan lapisan dalam batch mini semasa latihan. Ia mengira min dan varians pengaktifan untuk setiap ciri, kemudian menormalkan menggunakan statistik ini. Skala parameter yang boleh dipelajari (γ dan β) dan mengalihkan pengaktifan yang dinormalisasi, yang membolehkan model mempelajari pengedaran pengaktifan optimum.

Bn biasanya digunakan selepas transformasi linear lapisan (mis., Multiplikasi matriks dalam lapisan yang disambungkan sepenuhnya atau konvolusi dalam lapisan konvolusi) dan sebelum fungsi pengaktifan bukan linear (mis., Relu). Komponen utama adalah statistik batch mini (min dan varians), normalisasi, dan skala/beralih dengan parameter yang boleh dipelajari.

BN menangani peralihan kovariat dalaman dengan menormalkan pengaktifan dalam setiap batch mini, membuat input ke lapisan berikutnya lebih stabil. Ini membolehkan penumpuan lebih cepat dengan kadar pembelajaran yang lebih tinggi dan mengurangkan kepekaan inisialisasi. Ia juga menghidupkan, mencegah overfitting dengan mengurangkan pergantungan pada corak pengaktifan tertentu.

Matematik normalisasi batch:

BN beroperasi secara berbeza semasa latihan dan kesimpulan.

Latihan:

- normalisasi: min (μ b ) dan varians (σ b 2 ) dikira untuk setiap ciri dalam mini-batch:

) dinormalisasi:

(ε adalah pemalar kecil untuk kestabilan berangka).

Pertimbangan pelaksanaan:

saiz batch: saiz batch kecil: statistik kelompok yang kurang dipercayai. Kesimpulan: Normalisasi batch adalah teknik yang kuat meningkatkan latihan rangkaian saraf yang mendalam. Ingat manfaat, butiran pelaksanaan, dan batasannya, dan pertimbangkan variannya untuk prestasi optimum dalam projek anda.

pengaktifan (x

pengaktifan (x

parameter yang boleh dipelajari γ dan skala β dan peralihan:

statistik batch digantikan dengan statistik berjalan (berjalan min dan varians) yang dikira semasa latihan menggunakan purata bergerak (faktor momentum α):

3 statistik batch:

Statistik berjalan dan γ dan β yang dipelajari digunakan untuk normalisasi semasa kesimpulan.  Pelaksanaan TensorFlow:

Pelaksanaan TensorFlow:

import tensorflow as tf

from tensorflow import keras

# Load and preprocess MNIST data (as described in the original text)

# ...

# Define the model architecture

model = keras.Sequential([

keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

keras.layers.BatchNormalization(),

keras.layers.Conv2D(64, (3, 3), activation='relu'),

keras.layers.BatchNormalization(),

keras.layers.MaxPooling2D((2, 2)),

keras.layers.Flatten(),

keras.layers.Dense(128, activation='relu'),

keras.layers.BatchNormalization(),

keras.layers.Dense(10, activation='softmax')

])

# Compile and train the model (as described in the original text)

# ... selepas transformasi linear dan sebelum fungsi pengaktifan.

Atas ialah kandungan terperinci Normalisasi Batch: Pelaksanaan Teori dan Tensorflow. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Tesla's Robovan adalah permata tersembunyi pada penggoda Robotaxi 2024Apr 22, 2025 am 11:48 AM

Tesla's Robovan adalah permata tersembunyi pada penggoda Robotaxi 2024Apr 22, 2025 am 11:48 AMSejak tahun 2008, saya telah memperjuangkan van yang dikongsi bersama-pada masa yang digelar "Robotjitney," kemudian "Vansit" -dan masa depan pengangkutan bandar. Saya meramalkan kenderaan ini sebagai penyelesaian transit generasi akan datang abad ke-21, Surpas

Pertaruhan Kelab Sam di AI untuk menghapuskan cek resit dan meningkatkan runcitApr 22, 2025 am 11:29 AM

Pertaruhan Kelab Sam di AI untuk menghapuskan cek resit dan meningkatkan runcitApr 22, 2025 am 11:29 AMMerevolusikan pengalaman checkout Sistem "Just Go" inovatif Sam Club membina teknologi "imbasan & pergi" yang sedia ada AI yang sedia ada, yang membolehkan ahli mengimbas pembelian melalui aplikasi Sam's Club semasa perjalanan membeli-belah mereka.

AI Omniverse Nvidia berkembang di GTC 2025Apr 22, 2025 am 11:28 AM

AI Omniverse Nvidia berkembang di GTC 2025Apr 22, 2025 am 11:28 AMPredictability dan barisan produk baru NVIDIA di GTC 2025 Nvidia, pemain utama dalam infrastruktur AI, memberi tumpuan kepada peningkatan ramalan untuk pelanggannya. Ini melibatkan penghantaran produk yang konsisten, memenuhi jangkaan prestasi, dan

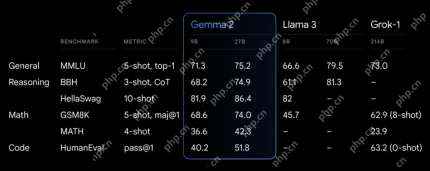

Meneroka keupayaan model Google ' s Gemma 2Apr 22, 2025 am 11:26 AM

Meneroka keupayaan model Google ' s Gemma 2Apr 22, 2025 am 11:26 AMGoogle's Gemma 2: Model bahasa yang kuat dan cekap Model Bahasa Gemma Google, yang disambut untuk kecekapan dan prestasi, telah berkembang dengan kedatangan Gemma 2. Siaran terbaru ini terdiri daripada dua model: parameter 27 bilion ver

Gelombang Seterusnya: Perspektif dengan Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AM

Gelombang Seterusnya: Perspektif dengan Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AMIni memimpin dengan episod data yang menampilkan Dr Kirk Borne, seorang saintis data terkemuka, astrofizik, dan pembesar suara TEDX. Pakar terkenal dalam Big Data, AI, dan Pembelajaran Mesin, Dr. Borne menawarkan pandangan yang tidak ternilai ke dalam keadaan semasa dan masa depan Traje

AI untuk pelari dan atlet: kami membuat kemajuan yang sangat baikApr 22, 2025 am 11:12 AM

AI untuk pelari dan atlet: kami membuat kemajuan yang sangat baikApr 22, 2025 am 11:12 AMTerdapat beberapa perspektif yang sangat berwawasan dalam maklumat ini mengenai maklumat mengenai kejuruteraan yang menunjukkan kepada kita mengapa kecerdasan buatan sangat baik untuk menyokong latihan fizikal orang. Saya akan menggariskan idea teras dari setiap perspektif penyumbang untuk menunjukkan tiga aspek reka bentuk yang merupakan bahagian penting dalam penerokaan penerokaan kecerdasan buatan dalam sukan. Peranti tepi dan data peribadi mentah Idea ini mengenai kecerdasan buatan sebenarnya mengandungi dua komponen -satu yang berkaitan dengan di mana kita meletakkan model bahasa yang besar dan yang lain berkaitan dengan perbezaan antara bahasa manusia dan bahasa yang kita tanda -tanda penting kita "menyatakan" apabila diukur dalam masa nyata. Alexander Amini tahu banyak tentang berlari dan tenis, tetapi dia masih

Jamie Engstrom mengenai Teknologi, Bakat dan Transformasi di CaterpillarApr 22, 2025 am 11:10 AM

Jamie Engstrom mengenai Teknologi, Bakat dan Transformasi di CaterpillarApr 22, 2025 am 11:10 AMKetua Pegawai Maklumat Caterpillar dan Naib Presiden Kanan IT, Jamie Engstrom, mengetuai pasukan global lebih dari 2,200 profesional IT di 28 negara. Dengan 26 tahun di Caterpillar, termasuk empat setengah tahun dalam peranannya sekarang, Engst

Kemas kini foto Google baru menjadikan sebarang foto pop dengan kualiti ultra HDRApr 22, 2025 am 11:09 AM

Kemas kini foto Google baru menjadikan sebarang foto pop dengan kualiti ultra HDRApr 22, 2025 am 11:09 AMAlat HDR Ultra baru Google Photos: Panduan Cepat Tingkatkan foto anda dengan alat Ultra HDR baru Google Photos, mengubah imej standard ke dalam karya-karya bertenaga, tinggi dinamik. Sesuai untuk media sosial, alat ini meningkatkan kesan foto,

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Muat turun versi mac editor Atom

Editor sumber terbuka yang paling popular

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini

mPDF

mPDF ialah perpustakaan PHP yang boleh menjana fail PDF daripada HTML yang dikodkan UTF-8. Pengarang asal, Ian Back, menulis mPDF untuk mengeluarkan fail PDF "dengan cepat" dari tapak webnya dan mengendalikan bahasa yang berbeza. Ia lebih perlahan dan menghasilkan fail yang lebih besar apabila menggunakan fon Unicode daripada skrip asal seperti HTML2FPDF, tetapi menyokong gaya CSS dsb. dan mempunyai banyak peningkatan. Menyokong hampir semua bahasa, termasuk RTL (Arab dan Ibrani) dan CJK (Cina, Jepun dan Korea). Menyokong elemen peringkat blok bersarang (seperti P, DIV),

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

SecLists

SecLists ialah rakan penguji keselamatan muktamad. Ia ialah koleksi pelbagai jenis senarai yang kerap digunakan semasa penilaian keselamatan, semuanya di satu tempat. SecLists membantu menjadikan ujian keselamatan lebih cekap dan produktif dengan menyediakan semua senarai yang mungkin diperlukan oleh penguji keselamatan dengan mudah. Jenis senarai termasuk nama pengguna, kata laluan, URL, muatan kabur, corak data sensitif, cangkerang web dan banyak lagi. Penguji hanya boleh menarik repositori ini ke mesin ujian baharu dan dia akan mempunyai akses kepada setiap jenis senarai yang dia perlukan.