Olmo 2: LLM sumber terbuka yang kuat untuk AI

boleh diaksesbidang pemprosesan bahasa semulajadi (NLP) telah melihat kemajuan pesat, terutamanya dengan model bahasa yang besar (LLM). Walaupun model proprietari telah didominasi secara historis, alternatif sumber terbuka dengan cepat menutup jurang. Olmo 2 mewakili lonjakan yang ketara ke hadapan, menawarkan prestasi yang setanding dengan model sumber tertutup sambil mengekalkan ketelusan dan akses sepenuhnya. Artikel ini menyelidiki Olmo 2, meneroka latihan, prestasi, dan aplikasi praktikalnya.

Titik pembelajaran utama:

- memahami kepentingan sumber terbuka LLMS dan sumbangan Olmo 2 kepada penyelidikan AI.

- memahami seni bina, kaedah latihan, dan hasil penanda aras Olmo 2.

- Membezakan antara arkitek model terbuka, sebahagian terbuka, dan terbuka sepenuhnya.

- belajar untuk menjalankan Olmo 2 secara tempatan menggunakan Gradio dan Langchain.

- Bina aplikasi chatbot menggunakan Olmo 2 dengan contoh kod python.

(artikel ini adalah sebahagian daripada Blogathon Sains Data.)

Jadual Kandungan:

- Keperluan untuk LLMS sumber terbuka

- memperkenalkan Olmo 2

- Dekonstruksi Latihan Olmo 2

- meneroka keupayaan Olmo 2

- membina chatbot dengan Olmo 2

- Kesimpulan

- Soalan Lazim

Permintaan untuk LLMS sumber terbuka

Penguasaan awal LLMS proprietari menimbulkan kebimbangan mengenai kebolehcapaian, ketelusan, dan kecenderungan. LLM sumber terbuka menangani isu-isu ini dengan memupuk kerjasama dan membolehkan pengawasan, pengubahsuaian, dan penambahbaikan. Pendekatan terbuka ini penting untuk memajukan bidang dan memastikan akses yang saksama kepada teknologi LLM.

Projek OLMO Institut Allen Institute for AI (AI2) mencontohkan komitmen ini. Olmo 2 melampaui hanya melepaskan berat model; Ia menyediakan data latihan, kod, resipi latihan, pusat pemeriksaan pertengahan, dan model yang disalurkan. Pelepasan komprehensif ini menggalakkan kebolehulangan dan inovasi selanjutnya.

Memahami Olmo 2

Olmo 2 meningkat dengan ketara pada pendahulunya, Olmo-0424. Model parameter 7B dan 13B menunjukkan prestasi yang setanding dengan, atau melebihi, model terbuka yang sama, walaupun menyaingi model berat terbuka seperti Llama 3.1 pada tanda aras akademik Inggeris-pencapaian yang luar biasa memandangkan flop latihan yang dikurangkan.

Penambahbaikan utama termasuk:

Penambahbaikan utama termasuk:

- Keuntungan prestasi yang besar: Olmo-2 (7b dan 13b) menunjukkan peningkatan yang ketara terhadap model Olmo yang terdahulu, menunjukkan kemajuan dalam seni bina, data, atau metodologi latihan.

- Kompetitif dengan Map-Neo-7b: Olmo-2, terutamanya versi 13b, mencapai skor yang setanding dengan Map-Neo-7b, garis dasar yang kuat di kalangan model terbuka sepenuhnya.

kaedah latihan Olmo 2

seni bina Olmo 2 dibina pada Olmo yang asal, menggabungkan penambahbaikan untuk kestabilan dan prestasi yang lebih baik. Proses latihan terdiri daripada dua peringkat:

- Latihan Yayasan: Menggunakan dataset Olmo-Mix-1124 (kira-kira 3.9 trilion token dari pelbagai sumber terbuka) untuk menubuhkan asas yang mantap untuk pemahaman bahasa.

- Refinement and Pengkhususan: menggunakan dataset Dolmino-Mix-1124, campuran data web yang berkualiti tinggi dan data khusus domain (kandungan akademik, forum Q & A, data arahan, buku kerja matematik), untuk memperbaiki pengetahuan dan kemahiran model. "Model Souping" terus meningkatkan pusat pemeriksaan akhir.

Sejak Olmo-2 adalah model terbuka sepenuhnya, mari kita jelaskan perbezaan antara tahap keterbukaan model yang berbeza:

- model terbuka:

- hanya berat model yang dikeluarkan. Model terbuka sebahagiannya:

- Lepaskan beberapa maklumat tambahan di luar berat, tetapi bukan gambaran lengkap proses latihan. Model terbuka sepenuhnya:

- Menyediakan ketelusan lengkap, termasuk berat, data latihan, kod, resipi, dan pusat pemeriksaan. Ini membolehkan reproducibility penuh. Jadual yang meringkaskan perbezaan utama disediakan di bawah.

Menjelajah dan menjalankan Olmo 2 tempatan

Olmo 2 mudah diakses. Arahan untuk memuat turun model dan data, bersama -sama dengan kod latihan dan metrik penilaian, tersedia. Untuk menjalankan Olmo 2 tempatan, gunakan Ollama. Selepas pemasangan, hanya jalankan ollama run olmo2:7b dalam baris arahan anda. Perpustakaan yang diperlukan (Langchain dan Gradio) boleh dipasang melalui PIP.

Membina chatbot dengan Olmo 2

Kod Python berikut menunjukkan membina chatbot menggunakan Olmo 2, Gradio, dan Langchain:

import gradio as gr

from langchain_core.prompts import ChatPromptTemplate

from langchain_ollama.llms import OllamaLLM

def generate_response(history, question):

template = """Question: {question}

Answer: Let's think step by step."""

prompt = ChatPromptTemplate.from_template(template)

model = OllamaLLM(model="olmo2")

chain = prompt | model

answer = chain.invoke({"question": question})

history.append({"role": "user", "content": question})

history.append({"role": "assistant", "content": answer})

return history

with gr.Blocks() as iface:

chatbot = gr.Chatbot(type='messages')

with gr.Row():

with gr.Column():

txt = gr.Textbox(show_label=False, placeholder="Type your question here...")

txt.submit(generate_response, [chatbot, txt], chatbot)

iface.launch()

Kod ini menyediakan antara muka chatbot asas. Aplikasi yang lebih canggih boleh dibina atas asas ini. Contoh output dan arahan ditunjukkan dalam artikel asal.

Kesimpulan

Olmo 2 mewakili sumbangan penting kepada ekosistem LLM sumber terbuka. Prestasi yang kuat, digabungkan dengan ketelusan penuhnya, menjadikannya alat yang berharga bagi penyelidik dan pemaju. Walaupun tidak unggul secara universal merentasi semua tugas, alam semulajadi terbuka memupuk kerjasama dan mempercepatkan kemajuan dalam bidang AI yang boleh diakses dan telus.

Takeaways utama:

- Model parameter 13B Olmo-2 menunjukkan prestasi yang sangat baik pada pelbagai tanda aras, mengatasi model terbuka yang lain.

- keterbukaan model penuh memudahkan pembangunan model yang lebih berkesan.

- Contoh chatbot mempamerkan kemudahan integrasi dengan Langchain dan Gradio.

Soalan Lazim (Soalan Lazim) (Soalan Lazim dari artikel asal dimasukkan di sini.)

(nota: URL imej kekal tidak berubah.)

Atas ialah kandungan terperinci Berjalan Olmo-2 secara tempatan dengan Vission dan Langchain. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Tesla's Robovan adalah permata tersembunyi pada penggoda Robotaxi 2024Apr 22, 2025 am 11:48 AM

Tesla's Robovan adalah permata tersembunyi pada penggoda Robotaxi 2024Apr 22, 2025 am 11:48 AMSejak tahun 2008, saya telah memperjuangkan van yang dikongsi bersama-pada masa yang digelar "Robotjitney," kemudian "Vansit" -dan masa depan pengangkutan bandar. Saya meramalkan kenderaan ini sebagai penyelesaian transit generasi akan datang abad ke-21, Surpas

Pertaruhan Kelab Sam di AI untuk menghapuskan cek resit dan meningkatkan runcitApr 22, 2025 am 11:29 AM

Pertaruhan Kelab Sam di AI untuk menghapuskan cek resit dan meningkatkan runcitApr 22, 2025 am 11:29 AMMerevolusikan pengalaman checkout Sistem "Just Go" inovatif Sam Club membina teknologi "imbasan & pergi" yang sedia ada AI yang sedia ada, yang membolehkan ahli mengimbas pembelian melalui aplikasi Sam's Club semasa perjalanan membeli-belah mereka.

AI Omniverse Nvidia berkembang di GTC 2025Apr 22, 2025 am 11:28 AM

AI Omniverse Nvidia berkembang di GTC 2025Apr 22, 2025 am 11:28 AMPredictability dan barisan produk baru NVIDIA di GTC 2025 Nvidia, pemain utama dalam infrastruktur AI, memberi tumpuan kepada peningkatan ramalan untuk pelanggannya. Ini melibatkan penghantaran produk yang konsisten, memenuhi jangkaan prestasi, dan

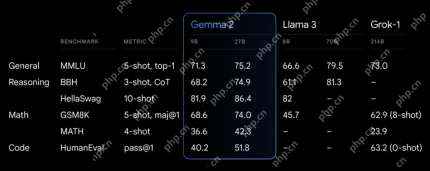

Meneroka keupayaan model Google ' s Gemma 2Apr 22, 2025 am 11:26 AM

Meneroka keupayaan model Google ' s Gemma 2Apr 22, 2025 am 11:26 AMGoogle's Gemma 2: Model bahasa yang kuat dan cekap Model Bahasa Gemma Google, yang disambut untuk kecekapan dan prestasi, telah berkembang dengan kedatangan Gemma 2. Siaran terbaru ini terdiri daripada dua model: parameter 27 bilion ver

Gelombang Seterusnya: Perspektif dengan Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AM

Gelombang Seterusnya: Perspektif dengan Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AMIni memimpin dengan episod data yang menampilkan Dr Kirk Borne, seorang saintis data terkemuka, astrofizik, dan pembesar suara TEDX. Pakar terkenal dalam Big Data, AI, dan Pembelajaran Mesin, Dr. Borne menawarkan pandangan yang tidak ternilai ke dalam keadaan semasa dan masa depan Traje

AI untuk pelari dan atlet: kami membuat kemajuan yang sangat baikApr 22, 2025 am 11:12 AM

AI untuk pelari dan atlet: kami membuat kemajuan yang sangat baikApr 22, 2025 am 11:12 AMTerdapat beberapa perspektif yang sangat berwawasan dalam maklumat ini mengenai maklumat mengenai kejuruteraan yang menunjukkan kepada kita mengapa kecerdasan buatan sangat baik untuk menyokong latihan fizikal orang. Saya akan menggariskan idea teras dari setiap perspektif penyumbang untuk menunjukkan tiga aspek reka bentuk yang merupakan bahagian penting dalam penerokaan penerokaan kecerdasan buatan dalam sukan. Peranti tepi dan data peribadi mentah Idea ini mengenai kecerdasan buatan sebenarnya mengandungi dua komponen -satu yang berkaitan dengan di mana kita meletakkan model bahasa yang besar dan yang lain berkaitan dengan perbezaan antara bahasa manusia dan bahasa yang kita tanda -tanda penting kita "menyatakan" apabila diukur dalam masa nyata. Alexander Amini tahu banyak tentang berlari dan tenis, tetapi dia masih

Jamie Engstrom mengenai Teknologi, Bakat dan Transformasi di CaterpillarApr 22, 2025 am 11:10 AM

Jamie Engstrom mengenai Teknologi, Bakat dan Transformasi di CaterpillarApr 22, 2025 am 11:10 AMKetua Pegawai Maklumat Caterpillar dan Naib Presiden Kanan IT, Jamie Engstrom, mengetuai pasukan global lebih dari 2,200 profesional IT di 28 negara. Dengan 26 tahun di Caterpillar, termasuk empat setengah tahun dalam peranannya sekarang, Engst

Kemas kini foto Google baru menjadikan sebarang foto pop dengan kualiti ultra HDRApr 22, 2025 am 11:09 AM

Kemas kini foto Google baru menjadikan sebarang foto pop dengan kualiti ultra HDRApr 22, 2025 am 11:09 AMAlat HDR Ultra baru Google Photos: Panduan Cepat Tingkatkan foto anda dengan alat Ultra HDR baru Google Photos, mengubah imej standard ke dalam karya-karya bertenaga, tinggi dinamik. Sesuai untuk media sosial, alat ini meningkatkan kesan foto,

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Muat turun versi mac editor Atom

Editor sumber terbuka yang paling popular

SublimeText3 versi Inggeris

Disyorkan: Versi Win, menyokong gesaan kod!

mPDF

mPDF ialah perpustakaan PHP yang boleh menjana fail PDF daripada HTML yang dikodkan UTF-8. Pengarang asal, Ian Back, menulis mPDF untuk mengeluarkan fail PDF "dengan cepat" dari tapak webnya dan mengendalikan bahasa yang berbeza. Ia lebih perlahan dan menghasilkan fail yang lebih besar apabila menggunakan fon Unicode daripada skrip asal seperti HTML2FPDF, tetapi menyokong gaya CSS dsb. dan mempunyai banyak peningkatan. Menyokong hampir semua bahasa, termasuk RTL (Arab dan Ibrani) dan CJK (Cina, Jepun dan Korea). Menyokong elemen peringkat blok bersarang (seperti P, DIV),

DVWA

Damn Vulnerable Web App (DVWA) ialah aplikasi web PHP/MySQL yang sangat terdedah. Matlamat utamanya adalah untuk menjadi bantuan bagi profesional keselamatan untuk menguji kemahiran dan alatan mereka dalam persekitaran undang-undang, untuk membantu pembangun web lebih memahami proses mengamankan aplikasi web, dan untuk membantu guru/pelajar mengajar/belajar dalam persekitaran bilik darjah Aplikasi web keselamatan. Matlamat DVWA adalah untuk mempraktikkan beberapa kelemahan web yang paling biasa melalui antara muka yang mudah dan mudah, dengan pelbagai tahap kesukaran. Sila ambil perhatian bahawa perisian ini

MinGW - GNU Minimalis untuk Windows

Projek ini dalam proses untuk dipindahkan ke osdn.net/projects/mingw, anda boleh terus mengikuti kami di sana. MinGW: Port Windows asli bagi GNU Compiler Collection (GCC), perpustakaan import yang boleh diedarkan secara bebas dan fail pengepala untuk membina aplikasi Windows asli termasuk sambungan kepada masa jalan MSVC untuk menyokong fungsi C99. Semua perisian MinGW boleh dijalankan pada platform Windows 64-bit.