Rumah >Peranti teknologi >AI >Matematik di belakang pembelajaran dalam konteks

Matematik di belakang pembelajaran dalam konteks

- 王林asal

- 2025-02-26 00:03:10645semak imbas

Pembelajaran In-Context (ICL), ciri utama model bahasa besar moden (LLMS), membolehkan transformer menyesuaikan diri berdasarkan contoh-contoh dalam prompt input. Beberapa tembakan yang mendorong, menggunakan beberapa contoh tugas, dengan berkesan menunjukkan tingkah laku yang dikehendaki. Tetapi bagaimana transformer mencapai penyesuaian ini? Artikel ini meneroka mekanisme yang berpotensi di belakang ICL.

perhatian softmax dan carian jiran terdekat

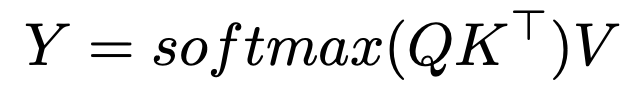

Formula Perhatian SoftMax adalah:

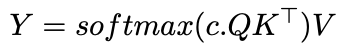

memperkenalkan parameter suhu songsang,

memperkenalkan parameter suhu songsang,

, mengubah peruntukan perhatian:

sebagai  c

c

c , perhatian menyerupai pelicinan kernel Gaussian. Ini menunjukkan ICL mungkin melaksanakan algoritma jiran terdekat pada pasangan input-output. Implikasi dan penyelidikan selanjutnya

Memahami Bagaimana Transformers Belajar Algoritma (seperti jiran terdekat) Membuka pintu untuk AUTOML. Hollmann et al. Menunjukkan Latihan Pengubah pada dataset sintetik untuk mempelajari keseluruhan saluran paip AUTOML, meramalkan model optimum dan hiperparameter dari data baru dalam satu pas.Penyelidikan Anthropic's 2022 mencadangkan "kepala induksi" sebagai mekanisme. Pasangan kepala perhatian ini menyalin dan corak lengkap; Sebagai contoh, diberi "... a, b ... a", mereka meramalkan "b" berdasarkan konteks terdahulu.

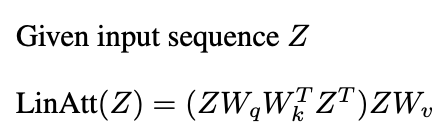

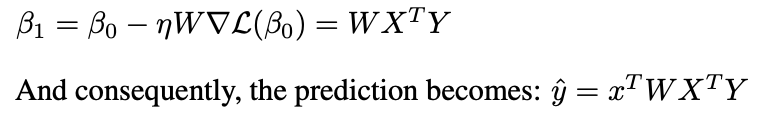

Kajian baru -baru ini (Garg et al 2022, Oswald et al 2023) menghubungkan ICL Transformers ke keturunan kecerunan. Perhatian linear, menghilangkan operasi softmax:

Satu lapisan perhatian linear melakukan satu langkah PGD.

Kesimpulan

Bacaan Lanjut:

- kepala pembelajaran dan induksi dalam konteks

- Apa yang boleh dilakukan oleh Transformers dalam konteks? Kajian kes kelas fungsi mudah

- Transformers Belajar dalam konteks oleh keturunan kecerunan

- Transformers belajar melaksanakan keturunan kecerunan prasyarat untuk pembelajaran dalam konteks

Pengakuan

Artikel ini diilhamkan oleh Kursus Kursus Siswazah 2024 di University of Michigan. Sebarang kesilapan semata -mata penulis.

Atas ialah kandungan terperinci Matematik di belakang pembelajaran dalam konteks. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI