Panduan praktikal untuk membina saluran paip ETL kejuruteraan data. Panduan ini menyediakan pendekatan langsung untuk memahami dan melaksanakan asas kejuruteraan data, meliputi penyimpanan, pemprosesan, automasi dan pemantauan.

Apakah Kejuruteraan Data?

Kejuruteraan data menumpukan pada mengatur, memproses dan mengautomasikan aliran kerja data untuk mengubah data mentah kepada cerapan berharga untuk analisis dan membuat keputusan. Panduan ini merangkumi:

- Storan Data: Menentukan tempat dan cara data disimpan.

- Pemprosesan Data: Teknik untuk membersihkan dan mengubah data mentah.

- Automasi Aliran Kerja: Melaksanakan pelaksanaan aliran kerja yang lancar dan cekap.

- Pemantauan Sistem: Memastikan kebolehpercayaan dan operasi lancar keseluruhan saluran paip data.

Jom terokai setiap peringkat!

Menyediakan Persekitaran Pembangunan Anda

Sebelum kami bermula, pastikan anda mempunyai perkara berikut:

-

Persediaan Persekitaran:

- Sistem berasaskan Unix (macOS) atau Windows Subsystem untuk Linux (WSL).

- Python 3.11 (atau lebih baru) dipasang.

- Pangkalan data PostgreSQL dipasang dan dijalankan secara setempat.

-

Prasyarat:

- Kecekapan baris arahan asas.

- Pengetahuan pengaturcaraan Python asas.

- Keistimewaan pentadbiran untuk pemasangan dan konfigurasi perisian.

-

Gambaran Keseluruhan Seni Bina:

Rajah menggambarkan interaksi antara komponen saluran paip. Reka bentuk modular ini memanfaatkan kekuatan setiap alat: Aliran udara untuk orkestrasi aliran kerja, Spark untuk pemprosesan data teragih dan PostgreSQL untuk penyimpanan data berstruktur.

-

Memasang Alat yang Diperlukan:

- PostgreSQL:

brew update brew install postgresql

- PySpark:

brew install apache-spark

- Aliran Udara:

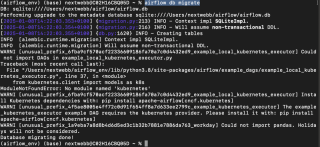

python -m venv airflow_env source airflow_env/bin/activate # macOS/Linux pip install "apache-airflow[postgres]==" --constraint "https://raw.githubusercontent.com/apache/airflow/constraints-2.10.4/constraints-3.11.txt" airflow db migrate

- PostgreSQL:

Dengan persekitaran yang disediakan, mari kita mendalami setiap komponen.

1. Penyimpanan Data: Pangkalan Data dan Sistem Fail

Storan data ialah asas kepada mana-mana saluran paip kejuruteraan data. Kami akan mempertimbangkan dua kategori utama:

-

Pangkalan data: Storan data tersusun dengan cekap dengan ciri seperti carian, replikasi dan pengindeksan. Contohnya termasuk:

- Pangkalan Data SQL: Untuk data berstruktur (cth., PostgreSQL, MySQL).

- Pangkalan Data NoSQL: Untuk data tanpa skema (cth., MongoDB, Redis).

- Sistem Fail: Sesuai untuk data tidak berstruktur, menawarkan ciri yang lebih sedikit daripada pangkalan data.

Menyediakan PostgreSQL

- Mulakan Perkhidmatan PostgreSQL:

brew update brew install postgresql

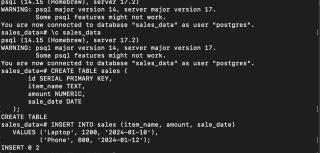

- Buat Pangkalan Data, Sambung dan Buat Jadual:

brew install apache-spark

- Masukkan Data Contoh:

python -m venv airflow_env source airflow_env/bin/activate # macOS/Linux pip install "apache-airflow[postgres]==" --constraint "https://raw.githubusercontent.com/apache/airflow/constraints-2.10.4/constraints-3.11.txt" airflow db migrate

Data anda kini disimpan dengan selamat dalam PostgreSQL.

2. Pemprosesan Data: PySpark dan Pengkomputeran Teragih

Rangka kerja pemprosesan data mengubah data mentah menjadi cerapan yang boleh diambil tindakan. Apache Spark, dengan keupayaan pengkomputeran yang diedarkan, adalah pilihan yang popular.

-

Mod Pemprosesan:

- Pemprosesan Kelompok: Memproses data dalam kelompok bersaiz tetap.

- Pemprosesan Strim: Memproses data dalam masa nyata.

- Alat Biasa: Apache Spark, Flink, Kafka, Hive.

Memproses Data dengan PySpark

- Pasang Java dan PySpark:

brew services start postgresql

- Muat Data daripada Fail CSV:

Buat fail sales.csv dengan data berikut:

CREATE DATABASE sales_data;

\c sales_data

CREATE TABLE sales (

id SERIAL PRIMARY KEY,

item_name TEXT,

amount NUMERIC,

sale_date DATE

);

Gunakan skrip Python berikut untuk memuatkan dan memproses data:

INSERT INTO sales (item_name, amount, sale_date)

VALUES ('Laptop', 1200, '2024-01-10'),

('Phone', 800, '2024-01-12');

- Tapis Jualan Bernilai Tinggi:

brew install openjdk@11 && brew install apache-spark

-

Sediakan pemacu DB Postgres: Muat turun pemacu PostgreSQL JDBC jika perlu dan kemas kini laluan dalam skrip di bawah.

-

Simpan Data Diproses ke PostgreSQL:

brew update brew install postgresql

Pemprosesan data dengan Spark selesai.

3. Automasi Aliran Kerja: Aliran Udara

Automasi memperkemas pengurusan aliran kerja menggunakan penjadualan dan definisi pergantungan. Alat seperti Aliran Udara, Oozie dan Luigi memudahkan perkara ini.

Mengautomasikan ETL dengan Aliran Udara

- Mulakan Aliran Udara:

brew install apache-spark

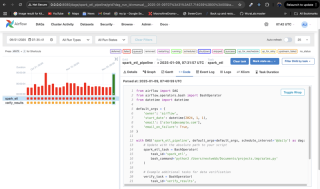

- Buat Aliran Kerja (DAG):

python -m venv airflow_env source airflow_env/bin/activate # macOS/Linux pip install "apache-airflow[postgres]==" --constraint "https://raw.githubusercontent.com/apache/airflow/constraints-2.10.4/constraints-3.11.txt" airflow db migrate

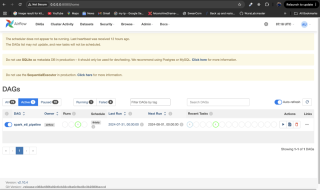

DAG ini berjalan setiap hari, melaksanakan skrip PySpark dan termasuk langkah pengesahan. Makluman e-mel dihantar apabila gagal.

-

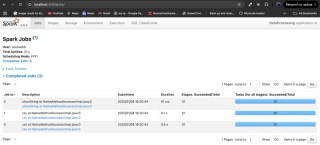

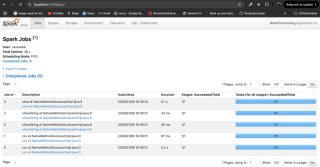

Pantau Aliran Kerja: Letakkan fail DAG dalam direktori

dags/Aliran Udara, mulakan semula perkhidmatan Aliran Udara dan pantau melalui UI Aliran Udara dihttp://localhost:8080.

4. Pemantauan Sistem

Pemantauan memastikan kebolehpercayaan saluran paip. Amaran aliran udara, atau penyepaduan dengan alatan seperti Grafana dan Prometheus, adalah strategi pemantauan yang berkesan. Gunakan UI Aliran Udara untuk menyemak status tugas dan log.

Kesimpulan

Anda telah belajar untuk menyediakan storan data, memproses data menggunakan PySpark, mengautomasikan aliran kerja dengan Aliran Udara dan memantau sistem anda. Kejuruteraan data ialah bidang yang penting, dan panduan ini menyediakan asas yang kukuh untuk penerokaan selanjutnya. Ingat untuk merujuk rujukan yang disediakan untuk mendapatkan maklumat yang lebih mendalam.

Atas ialah kandungan terperinci Asas Kejuruteraan Data: Panduan Hands-On. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Tujuan utama python: fleksibiliti dan kemudahan penggunaanApr 17, 2025 am 12:14 AM

Tujuan utama python: fleksibiliti dan kemudahan penggunaanApr 17, 2025 am 12:14 AMFleksibiliti Python dicerminkan dalam sokongan multi-paradigma dan sistem jenis dinamik, sementara kemudahan penggunaan berasal dari sintaks mudah dan perpustakaan standard yang kaya. 1. Fleksibiliti: Menyokong pengaturcaraan berorientasikan objek, fungsional dan prosedur, dan sistem jenis dinamik meningkatkan kecekapan pembangunan. 2. Kemudahan Penggunaan: Tatabahasa adalah dekat dengan bahasa semulajadi, perpustakaan standard merangkumi pelbagai fungsi, dan memudahkan proses pembangunan.

Python: Kekuatan pengaturcaraan serba bolehApr 17, 2025 am 12:09 AM

Python: Kekuatan pengaturcaraan serba bolehApr 17, 2025 am 12:09 AMPython sangat disukai kerana kesederhanaan dan kuasa, sesuai untuk semua keperluan dari pemula hingga pemaju canggih. Kepelbagaiannya dicerminkan dalam: 1) mudah dipelajari dan digunakan, sintaks mudah; 2) perpustakaan dan kerangka yang kaya, seperti numpy, panda, dan sebagainya; 3) sokongan silang platform, yang boleh dijalankan pada pelbagai sistem operasi; 4) Sesuai untuk tugas skrip dan automasi untuk meningkatkan kecekapan kerja.

Belajar python dalam 2 jam sehari: panduan praktikalApr 17, 2025 am 12:05 AM

Belajar python dalam 2 jam sehari: panduan praktikalApr 17, 2025 am 12:05 AMYa, pelajari Python dalam masa dua jam sehari. 1. Membangunkan pelan kajian yang munasabah, 2. Pilih sumber pembelajaran yang betul, 3 menyatukan pengetahuan yang dipelajari melalui amalan. Langkah -langkah ini dapat membantu anda menguasai Python dalam masa yang singkat.

Python vs C: Pro and Cons untuk PemajuApr 17, 2025 am 12:04 AM

Python vs C: Pro and Cons untuk PemajuApr 17, 2025 am 12:04 AMPython sesuai untuk pembangunan pesat dan pemprosesan data, manakala C sesuai untuk prestasi tinggi dan kawalan asas. 1) Python mudah digunakan, dengan sintaks ringkas, dan sesuai untuk sains data dan pembangunan web. 2) C mempunyai prestasi tinggi dan kawalan yang tepat, dan sering digunakan dalam pengaturcaraan permainan dan sistem.

Python: komitmen masa dan kadar pembelajaranApr 17, 2025 am 12:03 AM

Python: komitmen masa dan kadar pembelajaranApr 17, 2025 am 12:03 AMMasa yang diperlukan untuk belajar python berbeza dari orang ke orang, terutamanya dipengaruhi oleh pengalaman pengaturcaraan sebelumnya, motivasi pembelajaran, sumber pembelajaran dan kaedah, dan irama pembelajaran. Tetapkan matlamat pembelajaran yang realistik dan pelajari terbaik melalui projek praktikal.

Python: Automasi, skrip, dan pengurusan tugasApr 16, 2025 am 12:14 AM

Python: Automasi, skrip, dan pengurusan tugasApr 16, 2025 am 12:14 AMPython cemerlang dalam automasi, skrip, dan pengurusan tugas. 1) Automasi: Sandaran fail direalisasikan melalui perpustakaan standard seperti OS dan Shutil. 2) Penulisan Skrip: Gunakan Perpustakaan Psutil untuk memantau sumber sistem. 3) Pengurusan Tugas: Gunakan perpustakaan jadual untuk menjadualkan tugas. Kemudahan penggunaan Python dan sokongan perpustakaan yang kaya menjadikannya alat pilihan di kawasan ini.

Python dan Masa: Memanfaatkan masa belajar andaApr 14, 2025 am 12:02 AM

Python dan Masa: Memanfaatkan masa belajar andaApr 14, 2025 am 12:02 AMUntuk memaksimumkan kecekapan pembelajaran Python dalam masa yang terhad, anda boleh menggunakan modul, masa, dan modul Python. 1. Modul DateTime digunakan untuk merakam dan merancang masa pembelajaran. 2. Modul Masa membantu menetapkan kajian dan masa rehat. 3. Modul Jadual secara automatik mengatur tugas pembelajaran mingguan.

Python: Permainan, GUI, dan banyak lagiApr 13, 2025 am 12:14 AM

Python: Permainan, GUI, dan banyak lagiApr 13, 2025 am 12:14 AMPython cemerlang dalam permainan dan pembangunan GUI. 1) Pembangunan permainan menggunakan pygame, menyediakan lukisan, audio dan fungsi lain, yang sesuai untuk membuat permainan 2D. 2) Pembangunan GUI boleh memilih tkinter atau pyqt. TKInter adalah mudah dan mudah digunakan, PYQT mempunyai fungsi yang kaya dan sesuai untuk pembangunan profesional.

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Penyesuai Pelayan SAP NetWeaver untuk Eclipse

Integrasikan Eclipse dengan pelayan aplikasi SAP NetWeaver.

Pelayar Peperiksaan Selamat

Pelayar Peperiksaan Selamat ialah persekitaran pelayar selamat untuk mengambil peperiksaan dalam talian dengan selamat. Perisian ini menukar mana-mana komputer menjadi stesen kerja yang selamat. Ia mengawal akses kepada mana-mana utiliti dan menghalang pelajar daripada menggunakan sumber yang tidak dibenarkan.

Muat turun versi mac editor Atom

Editor sumber terbuka yang paling popular

Dreamweaver CS6

Alat pembangunan web visual

Dreamweaver Mac版

Alat pembangunan web visual