hujung hadapan web

hujung hadapan web tutorial js

tutorial js Membina Web Crawler dalam Node.js untuk Menemui Repos JavaScript Dikuasakan AI di GitHub

Membina Web Crawler dalam Node.js untuk Menemui Repos JavaScript Dikuasakan AI di GitHub

GitHub ialah harta karun projek inovatif, terutamanya dalam dunia kecerdasan buatan yang sentiasa berkembang. Tetapi menyaring repositori yang tidak terkira banyaknya untuk mencari mereka yang menggabungkan AI dan JavaScript? Itu seperti mencari permata dalam lautan kod yang luas. Masukkan perangkak web Node.js kami—skrip yang mengautomasikan carian, mengekstrak butiran repositori seperti nama, URL dan penerangan.

Dalam tutorial ini, kami akan membina perangkak yang menggunakan GitHub, memburu repositori yang berfungsi dengan AI dan JavaScript. Mari kita mendalami kod dan mula melombong permata tersebut.

Bahagian 1: Menyediakan Projek

Mulakan Projek Node.js

Mulakan dengan mencipta direktori baharu untuk projek anda dan memulakannya dengan npm:

mkdir github-ai-crawler cd github-ai-crawler npm init -y

Seterusnya, pasang kebergantungan yang diperlukan:

npm install axios cheerio

- axios : Untuk membuat permintaan HTTP kepada GitHub.

- cheerio : Untuk menghuraikan dan memanipulasi HTML, serupa dengan jQuery.

Bahagian 2: Memahami Carian GitHub

GitHub menyediakan ciri carian berkuasa yang boleh diakses melalui pertanyaan URL. Sebagai contoh, anda boleh mencari repositori JavaScript yang berkaitan dengan AI dengan pertanyaan ini:

https://github.com/search?q=ai+language:javascript&type=repositories

Perangkak kami akan meniru carian ini, menghuraikan hasil carian dan mengeluarkan butiran yang berkaitan.

Bahagian 3: Menulis Skrip Crawler

Buat fail bernama crawler.js dalam direktori projek anda dan mulakan pengekodan.

Langkah 1: Import Ketergantungan

const axios = require('axios');

const cheerio = require('cheerio');

Kami menggunakan axios untuk mengambil hasil carian GitHub dan cheerio untuk menghuraikan HTML.

Langkah 2: Tentukan URL Carian

const SEARCH_URL = 'https://github.com/search?q=ai+language:javascript&type=repositories';

URL ini menyasarkan repositori yang berkaitan dengan AI dan ditulis dalam JavaScript.

2220 PERCUMA SUMBER UNTUK PEMAJU!! ❤️ ?? (dikemas kini setiap hari)

1400 Templat HTML Percuma

351 Artikel Berita Percuma

67 Gesaan AI Percuma

315 Perpustakaan Kod Percuma

52 Coretan Kod & Plat Dandang untuk Nod, Nuxt, Vue dan banyak lagi!

25 Perpustakaan Ikon Sumber Terbuka Percuma

Lawati dailysandbox.pro untuk akses percuma kepada harta karun sumber!

Langkah 3: Ambil dan Parse HTML

const fetchRepositories = async () => {

try {

// Fetch the search results page

const { data } = await axios.get(SEARCH_URL);

const $ = cheerio.load(data); // Load the HTML into cheerio

// Extract repository details

const repositories = [];

$('.repo-list-item').each((_, element) => {

const repoName = $(element).find('a').text().trim();

const repoUrl = `https://github.com${$(element).find('a').attr('href')}`;

const repoDescription = $(element).find('.mb-1').text().trim();

repositories.push({

name: repoName,

url: repoUrl,

description: repoDescription,

});

});

return repositories;

} catch (error) {

console.error('Error fetching repositories:', error.message);

return [];

}

};

Berikut ialah perkara yang berlaku:

- Mengambil HTML : Kaedah axios.get mendapatkan semula halaman hasil carian.

- Menghuraikan dengan Cheerio : Kami menggunakan Cheerio untuk menavigasi DOM, menyasarkan elemen dengan kelas seperti .repo-list-item.

- Mengekstrak Butiran : Untuk setiap repositori, kami mengekstrak nama, URL dan penerangan.

Langkah 4: Paparkan Keputusan

Akhir sekali, panggil fungsi dan log keputusan:

mkdir github-ai-crawler cd github-ai-crawler npm init -y

Bahagian 4: Menjalankan Crawler

Simpan skrip anda dan jalankan dengan Node.js:

npm install axios cheerio

Anda akan melihat senarai repositori JavaScript berkaitan AI, setiap satu dengan nama, URL dan perihalannya, dipaparkan dengan kemas dalam terminal anda.

Bahagian 5: Mempertingkatkan Crawler

Ingin meneruskannya? Berikut ialah beberapa idea:

- Penomboran : Tambahkan sokongan untuk mengambil berbilang halaman hasil carian dengan mengubah suai URL dengan &p=2, &p=3, dsb.

- Penapisan : Tapis repositori mengikut bintang atau garpu untuk mengutamakan projek popular.

- Menyimpan Data : Simpan keputusan pada fail atau pangkalan data untuk analisis lanjut.

Contoh untuk menyimpan ke fail JSON:

https://github.com/search?q=ai+language:javascript&type=repositories

Keindahan Automasi

Dengan perangkak ini, anda telah mengautomasikan tugas yang membosankan untuk mencari repositori yang berkaitan di GitHub. Tiada lagi penyemakan imbas manual atau klik tanpa henti—skrip anda melakukan kerja keras, mempersembahkan hasilnya dalam beberapa saat.

Untuk mendapatkan lebih banyak petua tentang pembangunan web, lihat DailySandbox dan daftar untuk surat berita percuma kami untuk kekal di hadapan!

Atas ialah kandungan terperinci Membina Web Crawler dalam Node.js untuk Menemui Repos JavaScript Dikuasakan AI di GitHub. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Ganti aksara rentetan dalam javascriptMar 11, 2025 am 12:07 AM

Ganti aksara rentetan dalam javascriptMar 11, 2025 am 12:07 AMPenjelasan terperinci mengenai kaedah penggantian rentetan javascript dan Soalan Lazim Artikel ini akan meneroka dua cara untuk menggantikan watak rentetan dalam JavaScript: Kod JavaScript dalaman dan HTML dalaman untuk laman web. Ganti rentetan di dalam kod JavaScript Cara yang paling langsung ialah menggunakan kaedah pengganti (): str = str.replace ("cari", "ganti"); Kaedah ini hanya menggantikan perlawanan pertama. Untuk menggantikan semua perlawanan, gunakan ungkapan biasa dan tambahkan bendera global g: str = str.replace (/fi

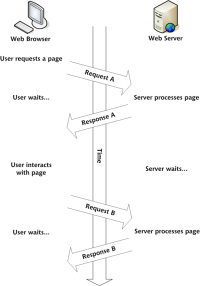

Bina Aplikasi Web Ajax anda sendiriMar 09, 2025 am 12:11 AM

Bina Aplikasi Web Ajax anda sendiriMar 09, 2025 am 12:11 AMJadi di sini anda, bersedia untuk mempelajari semua perkara ini yang dipanggil Ajax. Tetapi, apa sebenarnya? Istilah Ajax merujuk kepada kumpulan teknologi longgar yang digunakan untuk membuat kandungan web yang dinamik dan interaktif. Istilah Ajax, yang asalnya dicipta oleh Jesse J

Bagaimana saya membuat dan menerbitkan perpustakaan JavaScript saya sendiri?Mar 18, 2025 pm 03:12 PM

Bagaimana saya membuat dan menerbitkan perpustakaan JavaScript saya sendiri?Mar 18, 2025 pm 03:12 PMArtikel membincangkan membuat, menerbitkan, dan mengekalkan perpustakaan JavaScript, memberi tumpuan kepada perancangan, pembangunan, ujian, dokumentasi, dan strategi promosi.

Bagaimanakah saya mengoptimumkan kod JavaScript untuk prestasi dalam penyemak imbas?Mar 18, 2025 pm 03:14 PM

Bagaimanakah saya mengoptimumkan kod JavaScript untuk prestasi dalam penyemak imbas?Mar 18, 2025 pm 03:14 PMArtikel ini membincangkan strategi untuk mengoptimumkan prestasi JavaScript dalam pelayar, memberi tumpuan kepada mengurangkan masa pelaksanaan dan meminimumkan kesan pada kelajuan beban halaman.

Bagaimanakah saya boleh debug kod javascript dengan berkesan menggunakan alat pemaju pelayar?Mar 18, 2025 pm 03:16 PM

Bagaimanakah saya boleh debug kod javascript dengan berkesan menggunakan alat pemaju pelayar?Mar 18, 2025 pm 03:16 PMArtikel ini membincangkan debugging JavaScript yang berkesan menggunakan alat pemaju pelayar, memberi tumpuan kepada menetapkan titik putus, menggunakan konsol, dan menganalisis prestasi.

kesan matriks jQueryMar 10, 2025 am 12:52 AM

kesan matriks jQueryMar 10, 2025 am 12:52 AMBawa kesan filem matriks ke halaman anda! Ini adalah plugin jQuery yang sejuk berdasarkan filem terkenal "The Matrix". Plugin mensimulasikan kesan aksara hijau klasik dalam filem, dan hanya pilih gambar dan plugin akan mengubahnya menjadi gambar gaya matriks yang diisi dengan aksara angka. Datang dan cuba, sangat menarik! Bagaimana ia berfungsi Plugin memuat imej ke kanvas dan membaca nilai piksel dan warna: data = ctx.getimagedata (x, y, settings.grainsize, settings.grainsize) .data Plugin dengan bijak membaca kawasan segi empat tepat gambar dan menggunakan jQuery untuk mengira warna purata setiap kawasan. Kemudian, gunakan

Cara Membina Slider JQuery MudahMar 11, 2025 am 12:19 AM

Cara Membina Slider JQuery MudahMar 11, 2025 am 12:19 AMArtikel ini akan membimbing anda untuk membuat karusel gambar mudah menggunakan perpustakaan jQuery. Kami akan menggunakan perpustakaan BXSlider, yang dibina di atas jQuery dan menyediakan banyak pilihan konfigurasi untuk menubuhkan karusel. Pada masa kini, Gambar Carousel telah menjadi ciri yang mesti ada di laman web - satu gambar lebih baik daripada seribu perkataan! Selepas membuat keputusan untuk menggunakan karusel gambar, soalan seterusnya adalah bagaimana untuk menciptanya. Pertama, anda perlu mengumpul gambar-gambar resolusi tinggi yang berkualiti tinggi. Seterusnya, anda perlu membuat karusel gambar menggunakan HTML dan beberapa kod JavaScript. Terdapat banyak perpustakaan di web yang dapat membantu anda membuat karusel dengan cara yang berbeza. Kami akan menggunakan Perpustakaan BXSlider Sumber Terbuka. Perpustakaan BXSlider menyokong reka bentuk responsif, jadi karusel yang dibina dengan perpustakaan ini dapat disesuaikan dengan mana -mana

Cara memuat naik dan memuat turun fail CSV dengan sudutMar 10, 2025 am 01:01 AM

Cara memuat naik dan memuat turun fail CSV dengan sudutMar 10, 2025 am 01:01 AMSet data sangat penting dalam membina model API dan pelbagai proses perniagaan. Inilah sebabnya mengapa mengimport dan mengeksport CSV adalah fungsi yang sering diperlukan. Dalam tutorial ini, anda akan belajar cara memuat turun dan mengimport fail CSV dalam sudut

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

ZendStudio 13.5.1 Mac

Persekitaran pembangunan bersepadu PHP yang berkuasa

EditPlus versi Cina retak

Saiz kecil, penyerlahan sintaks, tidak menyokong fungsi gesaan kod

MantisBT

Mantis ialah alat pengesan kecacatan berasaskan web yang mudah digunakan yang direka untuk membantu dalam pengesanan kecacatan produk. Ia memerlukan PHP, MySQL dan pelayan web. Lihat perkhidmatan demo dan pengehosan kami.

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini

mPDF

mPDF ialah perpustakaan PHP yang boleh menjana fail PDF daripada HTML yang dikodkan UTF-8. Pengarang asal, Ian Back, menulis mPDF untuk mengeluarkan fail PDF "dengan cepat" dari tapak webnya dan mengendalikan bahasa yang berbeza. Ia lebih perlahan dan menghasilkan fail yang lebih besar apabila menggunakan fon Unicode daripada skrip asal seperti HTML2FPDF, tetapi menyokong gaya CSS dsb. dan mempunyai banyak peningkatan. Menyokong hampir semua bahasa, termasuk RTL (Arab dan Ibrani) dan CJK (Cina, Jepun dan Korea). Menyokong elemen peringkat blok bersarang (seperti P, DIV),