Tidak menghairankan bahawa AI tidak selalu menyelesaikan masalah. Kadang-kadang, ia juga berhalusinasi. Walau bagaimanapun, kajian terbaru oleh penyelidik Apple telah menunjukkan kelemahan yang lebih ketara dalam model matematik yang digunakan oleh AI untuk penaakulan formal.

✕ Alih Keluar IklanSebagai sebahagian daripada kajian, saintis Apple bertanya Model Bahasa Besar AI (LLM) soalan, beberapa kali, dalam cara yang sedikit berbeza, dan terkejut apabila mereka mendapati LLM menawarkan variasi yang tidak dijangka dalam jawapan. Variasi ini paling ketara apabila nombor terlibat.

Kajian Apple Mencadangkan Masalah Besar Dengan Kebolehpercayaan AI

Penyelidikan yang diterbitkan oleh arxiv.org, menyimpulkan terdapat "kebolehubahan prestasi yang ketara di seluruh instantiasi berbeza bagi soalan yang sama, mencabar kebolehpercayaan keputusan GSM8K semasa yang bergantung pada metrik ketepatan titik tunggal." GSM8K ialah set data yang merangkumi lebih 8000 soalan dan jawapan matematik sekolah gred yang pelbagai.

✕ Alih Keluar IklanPenyelidik Apple mengenal pasti varians dalam prestasi ini boleh mencapai sehingga 10%. Dan walaupun sedikit variasi dalam gesaan boleh menyebabkan masalah besar dengan kebolehpercayaan jawapan LLM.

Dalam erti kata lain, anda mungkin mahu menyemak fakta jawapan anda pada bila-bila masa anda menggunakan sesuatu seperti ChatGPT. Ini kerana, walaupun kadangkala kelihatan seperti AI menggunakan logik untuk memberi anda jawapan kepada pertanyaan anda, logik bukanlah perkara yang digunakan.

AI, sebaliknya, bergantung pada pengecaman corak untuk memberikan respons kepada gesaan. Walau bagaimanapun, kajian Apple menunjukkan bagaimana perubahan walaupun beberapa perkataan yang tidak penting boleh mengubah pengecaman corak tersebut.

Salah satu contoh varians kritikal yang dibentangkan berlaku melalui masalah mengenai pengumpulan kiwi selama beberapa hari. Penyelidik Apple menjalankan percubaan kawalan, kemudian menambah beberapa maklumat yang tidak penting tentang saiz kiwi.

✕ Alih Keluar IklanKedua-dua Model Meta dan OpenAI Ditunjukkan Isu

Meta's Llama dan OpenAI's o1, kemudian mengubah jawapan mereka kepada masalah daripada kawalan walaupun data saiz kiwi tidak mempunyai pengaruh ketara terhadap hasil masalah. GPT-4o OpenAI juga menghadapi masalah dengan prestasinya apabila memperkenalkan variasi kecil dalam data yang diberikan kepada LLM.

Memandangkan LLM menjadi lebih menonjol dalam budaya kita, berita ini menimbulkan kebimbangan besar tentang sama ada kita boleh mempercayai AI untuk memberikan jawapan yang tepat kepada pertanyaan kami. Terutama untuk isu seperti nasihat kewangan. Ia juga mengukuhkan keperluan untuk mengesahkan maklumat yang anda terima dengan tepat apabila menggunakan model bahasa yang besar.

Ini bermakna anda perlu melakukan beberapa pemikiran kritis dan usaha wajar dan bukannya bergantung pada AI secara membuta tuli. Sekali lagi, jika anda seorang yang kerap menggunakan AI, anda mungkin sudah mengetahuinya.

✕ Alih Keluar IklanAtas ialah kandungan terperinci Kajian Apple Baharu Menunjukkan Penaakulan AI Mempunyai Kelemahan Kritikal. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Mengubah Pelaporan Kewangan dengan AI dan NLG - Analytics VidhyaApr 15, 2025 am 10:35 AM

Mengubah Pelaporan Kewangan dengan AI dan NLG - Analytics VidhyaApr 15, 2025 am 10:35 AMPelaporan Kewangan berkuasa AI: merevolusikan pandangan melalui generasi bahasa semula jadi Dalam persekitaran perniagaan dinamik hari ini, analisis kewangan yang tepat dan tepat pada masanya adalah penting untuk membuat keputusan strategik. Pelaporan kewangan tradisional

Adakah robot Google Deepmind ini akan bermain di Sukan Olimpik 2028?Apr 15, 2025 am 10:16 AM

Adakah robot Google Deepmind ini akan bermain di Sukan Olimpik 2028?Apr 15, 2025 am 10:16 AMRobot Tenis Jadual Google Deepmind: Era Baru dalam Sukan dan Robotik Sukan Olimpik Paris 2024 mungkin berakhir, tetapi era baru dalam sukan dan robotik adalah berkemungkinan, terima kasih kepada Google Deepmind. Penyelidikan terobosan mereka ("Mencapai Kompet Tahap Manusia

Membina WebApp Wawasan Makanan dengan Model Gemini Flash 1.5Apr 15, 2025 am 10:15 AM

Membina WebApp Wawasan Makanan dengan Model Gemini Flash 1.5Apr 15, 2025 am 10:15 AMMembuka Kecekapan dan Skala dengan Gemini Flash 1.5: WebApp Wawasan Makanan Flask Dalam landskap AI yang pesat berkembang, kecekapan dan skalabiliti adalah yang paling utama. Pemaju semakin mencari model berprestasi tinggi yang meminimumkan kos dan latenc

Melaksanakan ejen AI menggunakan llamaindexApr 15, 2025 am 10:11 AM

Melaksanakan ejen AI menggunakan llamaindexApr 15, 2025 am 10:11 AMMemanfaatkan kuasa agen AI dengan llamaindex: panduan langkah demi langkah Bayangkan pembantu peribadi yang memahami permintaan anda dan melaksanakannya dengan sempurna, sama ada pengiraan cepat atau mengambil berita pasaran terkini. Artikel ini meneroka

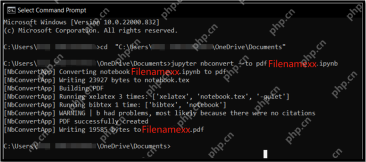

5 kaedah untuk menukar fail .ipynb ke pdf- analitik vidhyaApr 15, 2025 am 10:06 AM

5 kaedah untuk menukar fail .ipynb ke pdf- analitik vidhyaApr 15, 2025 am 10:06 AMFail Notebook Jupyter (.iPynb) digunakan secara meluas dalam analisis data, pengkomputeran saintifik, dan pengekodan interaktif. Walaupun buku nota ini bagus untuk membangun dan berkongsi kod dengan saintis data lain, kadang -kadang anda perlu mengubahnya menjadi format yang lebih umum, seperti PDF. Panduan ini akan membimbing anda melalui pelbagai cara untuk menukar fail .ipynb ke PDF, serta petua, amalan terbaik, dan cadangan penyelesaian masalah. Jadual Kandungan Mengapa menukar .ipynb ke pdf? Cara menukar fail .ipynb ke pdf Menggunakan UI Notebook Jupyter Menggunakan NBConve

Panduan Komprehensif mengenai Kes Kuantisasi dan Penggunaan LLMApr 15, 2025 am 10:02 AM

Panduan Komprehensif mengenai Kes Kuantisasi dan Penggunaan LLMApr 15, 2025 am 10:02 AMPengenalan Model bahasa yang besar (LLMs) merevolusi pemprosesan bahasa semulajadi, tetapi saiz besar dan tuntutan pengiraannya membatasi penggunaan. Kuantisasi, teknik untuk mengecilkan model dan kos pengiraan yang lebih rendah, adalah solu penting

Panduan komprehensif untuk selenium dengan pythonApr 15, 2025 am 09:57 AM

Panduan komprehensif untuk selenium dengan pythonApr 15, 2025 am 09:57 AMPengenalan Panduan ini meneroka gabungan kuat selenium dan python untuk automasi dan ujian web. Selenium mengautomasikan interaksi pelayar, meningkatkan kecekapan ujian untuk aplikasi web yang besar. Tutorial ini memberi tumpuan o

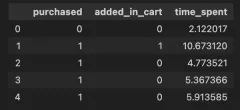

Panduan untuk Memahami Syarat InteraksiApr 15, 2025 am 09:56 AM

Panduan untuk Memahami Syarat InteraksiApr 15, 2025 am 09:56 AMPengenalan Istilah interaksi dimasukkan dalam pemodelan regresi untuk menangkap kesan dua atau lebih pembolehubah bebas dalam pemboleh ubah bergantung. Kadang -kadang, ia bukan hanya hubungan mudah antara kawalan

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

VSCode Windows 64-bit Muat Turun

Editor IDE percuma dan berkuasa yang dilancarkan oleh Microsoft

EditPlus versi Cina retak

Saiz kecil, penyerlahan sintaks, tidak menyokong fungsi gesaan kod

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini

Dreamweaver CS6

Alat pembangunan web visual

DVWA

Damn Vulnerable Web App (DVWA) ialah aplikasi web PHP/MySQL yang sangat terdedah. Matlamat utamanya adalah untuk menjadi bantuan bagi profesional keselamatan untuk menguji kemahiran dan alatan mereka dalam persekitaran undang-undang, untuk membantu pembangun web lebih memahami proses mengamankan aplikasi web, dan untuk membantu guru/pelajar mengajar/belajar dalam persekitaran bilik darjah Aplikasi web keselamatan. Matlamat DVWA adalah untuk mempraktikkan beberapa kelemahan web yang paling biasa melalui antara muka yang mudah dan mudah, dengan pelbagai tahap kesukaran. Sila ambil perhatian bahawa perisian ini