PRO |. Mengapa model besar berdasarkan MoE lebih patut diberi perhatian?

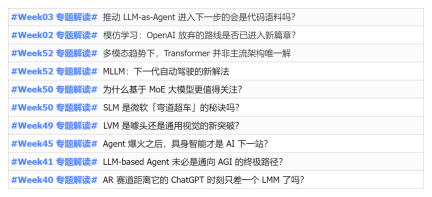

Pada tahun 2023, hampir setiap bidang AI berkembang pada kelajuan yang tidak pernah berlaku sebelum ini Pada masa yang sama, AI sentiasa menolak sempadan teknologi trek utama seperti kecerdasan yang terkandung dan pemanduan autonomi. Di bawah trend berbilang modal, adakah Transformer akan digoncang sebagai seni bina arus perdana untuk model AI yang besar? Mengapakah penerokaan model besar berdasarkan seni bina MoE (Campuran Pakar) menjadi trend baharu dalam industri? Bolehkah Model Penglihatan Besar (LVM) menjadi satu kejayaan baharu dalam penglihatan umum? ...Daripada surat berita ahli PRO 2023 laman web ini yang dikeluarkan dalam tempoh enam bulan lalu, kami telah memilih 10 tafsiran khas yang menyediakan analisis mendalam tentang aliran teknologi dan perubahan industri dalam bidang di atas untuk membantu anda mencapai matlamat anda dalam bidang baharu. tahun. Tafsiran ini datang daripada surat berita industri Week50 2023 ?

Tarikh: 12 Disember

Acara: Mistral AI sumber terbuka model Mixtral 8x7B berdasarkan seni bina MoE (Mixture-of-Experts, Mix of Experts) dan prestasinya mencapai tahap Llama 2 70B dan GPT-3.5" acara telah diadakan Tafsiran lanjutan

Pertama, jelaskan apa itu KPM dan selok-beloknya

1 Konsep:

MoE (Campuran Pakar) adalah model hibrid yang terdiri daripada pelbagai sub-model (iaitu pakar. setiap sub-model Ia adalah model tempatan yang mengkhusus dalam memproses subset ruang input Idea teras KPM ialah menggunakan rangkaian gating untuk memutuskan model mana yang harus dilatih oleh setiap data, dengan itu mengurangkan gangguan antara yang berbeza. jenis sampel.

2. Komponen utama:

Teknologi model pakar campuran (MoE) adalah teknologi pembelajaran mendalam yang dikawal oleh pintu jarang yang terdiri daripada model pakar dan model berpagar merealisasikan pengagihan tugas/data latihan di kalangan pakar yang berbeza model melalui rangkaian berpagar, membolehkan semua orang untuk Setiap model memberi tumpuan kepada tugas yang terbaik, dengan itu mencapai kesederhanaan model

① Dalam latihan rangkaian berpagar, setiap sampel akan diberikan kepada seorang atau lebih pakar; . Pembelajaran ensemble ialah proses melatih pelbagai model (pembelajar asas) untuk menyelesaikan masalah yang sama, dan hanya menggabungkan ramalan mereka (seperti mengundi atau purata). Matlamat utama pembelajaran ensemble adalah untuk meningkatkan prestasi ramalan dengan mengurangkan overfitting dan meningkatkan keupayaan generalisasi. Kaedah pembelajaran ensemble yang biasa termasuk Bagging, Boosting dan Stacking.

Mengapa model besar berasaskan KPM patut diberi perhatian?

1 Secara umumnya, pengembangan skala model akan membawa kepada peningkatan yang ketara dalam kos latihan, dan pengehadan sumber pengkomputeran telah menjadi halangan untuk latihan model intensif berskala besar. Untuk menyelesaikan masalah ini, seni bina model pembelajaran mendalam berdasarkan lapisan MoE yang jarang dicadangkan.2 Model Pakar Campuran Jarang (MoE) ialah seni bina rangkaian saraf khas yang boleh menambah parameter yang boleh dipelajari kepada model bahasa besar (LLM) tanpa meningkatkan kos inferens, manakala penalaan arahan ) ialah teknik untuk melatih LLM mengikut arahan. .

3 Gabungan teknologi penalaan halus arahan MoE+ boleh meningkatkan prestasi model bahasa. Pada Julai 2023, penyelidik dari Google, UC Berkeley, MIT dan institusi lain menerbitkan kertas kerja "Mixture-of-Experts Meets Instruction Tuning: A Winning Combination for Large Language Models", yang membuktikan bahawa model pakar hibrid (MoE) dan penalaan arahan Gabungan ini boleh meningkatkan prestasi model bahasa besar (LLM).① Khususnya, penyelidik menggunakan pengaktifan jarang MoE dalam satu set model pakar hibrid jarang FLAN-MOE yang diperhalusi mengikut arahan, dan menggantikan komponen suapan hadapan lapisan Transformer dengan lapisan MoE untuk menyediakan kapasiti model yang lebih baik dan fleksibiliti pengkomputeran .

② Berdasarkan kaedah di atas, penyelidik mengkaji penalaan halus langsung pada satu tugas hiliran tanpa penalaan arahan, generalisasi beberapa pukulan atau sifar pukulan dalam konteks pada tugas hiliran selepas penalaan arahan, dan dalam penalaan arahan Kemudian kami memperhalusi lagi satu tugas hiliran dan membandingkan perbezaan prestasi LLM di bawah tiga tetapan percubaan.

③ Keputusan eksperimen menunjukkan bahawa tanpa menggunakan penalaan arahan, model MoE selalunya berprestasi lebih teruk daripada model padat dengan kuasa pengiraan yang setanding. Tetapi apabila digabungkan dengan penalaan arahan, perkara berubah. Model MoE yang ditala arahan (Flan-MoE) mengatasi model padat yang lebih besar pada pelbagai tugas, walaupun model MoE hanya satu pertiga sebagai mahal dari segi pengiraan berbanding model padat. Berbanding dengan model padat. Model MoE memperoleh keuntungan prestasi yang lebih ketara daripada penalaan arahan, jadi apabila kecekapan dan prestasi pengkomputeran dipertimbangkan, MoE akan menjadi alat yang berkuasa untuk latihan model bahasa yang besar.

4 Kali ini, model Mixtral 8x7B yang dikeluarkan juga menggunakan rangkaian pakar campuran yang jarang.

① Mixtral 8x7B ialah model penyahkod sahaja. Modul suapan hadapan memilih daripada 8 set parameter yang berbeza. Dalam setiap lapisan rangkaian, untuk setiap token, rangkaian penghala memilih dua daripada lapan kumpulan (pakar) untuk memproses token dan mengagregatkan output mereka.

② Model Mixtral 8x7B sepadan atau mengatasi prestasi Llama 2 70B dan GPT3.5 pada kebanyakan penanda aras, dengan kelajuan inferens 6x lebih pantas.

Kelebihan penting KPM: Apakah sparsity?

1. Dalam model padat tradisional, setiap input perlu dikira dalam model lengkap. Dalam model pakar campuran jarang, hanya beberapa model pakar yang diaktifkan dan digunakan semasa memproses data input, manakala kebanyakan model pakar berada dalam keadaan tidak aktif model. Kelebihan juga merupakan kunci untuk meningkatkan kecekapan latihan model dan proses inferens

Atas ialah kandungan terperinci PRO |. Mengapa model besar berdasarkan MoE lebih patut diberi perhatian?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Skop Gemma: Mikroskop Google ' s untuk mengintip ke proses pemikiran AI 'Apr 17, 2025 am 11:55 AM

Skop Gemma: Mikroskop Google ' s untuk mengintip ke proses pemikiran AI 'Apr 17, 2025 am 11:55 AMMeneroka kerja -kerja dalam model bahasa dengan skop Gemma Memahami kerumitan model bahasa AI adalah satu cabaran penting. Pelepasan Google Gemma Skop, Toolkit Komprehensif, menawarkan penyelidik cara yang kuat untuk menyelidiki

Siapa penganalisis perisikan perniagaan dan bagaimana menjadi satu?Apr 17, 2025 am 11:44 AM

Siapa penganalisis perisikan perniagaan dan bagaimana menjadi satu?Apr 17, 2025 am 11:44 AMMembuka Kejayaan Perniagaan: Panduan untuk Menjadi Penganalisis Perisikan Perniagaan Bayangkan mengubah data mentah ke dalam pandangan yang boleh dilakukan yang mendorong pertumbuhan organisasi. Ini adalah kuasa penganalisis Perniagaan Perniagaan (BI) - peranan penting dalam GU

Bagaimana untuk menambah lajur dalam SQL? - Analytics VidhyaApr 17, 2025 am 11:43 AM

Bagaimana untuk menambah lajur dalam SQL? - Analytics VidhyaApr 17, 2025 am 11:43 AMPernyataan Jadual Alter SQL: Menambah lajur secara dinamik ke pangkalan data anda Dalam pengurusan data, kebolehsuaian SQL adalah penting. Perlu menyesuaikan struktur pangkalan data anda dengan cepat? Pernyataan Jadual ALTER adalah penyelesaian anda. Butiran panduan ini menambah colu

Penganalisis Perniagaan vs Penganalisis DataApr 17, 2025 am 11:38 AM

Penganalisis Perniagaan vs Penganalisis DataApr 17, 2025 am 11:38 AMPengenalan Bayangkan pejabat yang sibuk di mana dua profesional bekerjasama dalam projek kritikal. Penganalisis perniagaan memberi tumpuan kepada objektif syarikat, mengenal pasti bidang penambahbaikan, dan memastikan penjajaran strategik dengan trend pasaran. Simu

Apakah Count dan Counta dalam Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AM

Apakah Count dan Counta dalam Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AMPengiraan dan Analisis Data Excel: Penjelasan terperinci mengenai fungsi Count dan Counta Pengiraan dan analisis data yang tepat adalah kritikal dalam Excel, terutamanya apabila bekerja dengan set data yang besar. Excel menyediakan pelbagai fungsi untuk mencapai matlamat ini, dengan fungsi Count dan CountA menjadi alat utama untuk mengira bilangan sel di bawah keadaan yang berbeza. Walaupun kedua -dua fungsi digunakan untuk mengira sel, sasaran reka bentuk mereka disasarkan pada jenis data yang berbeza. Mari menggali butiran khusus fungsi Count dan Counta, menyerlahkan ciri dan perbezaan unik mereka, dan belajar cara menerapkannya dalam analisis data. Gambaran keseluruhan perkara utama Memahami kiraan dan cou

Chrome ada di sini dengan AI: mengalami sesuatu yang baru setiap hari !!Apr 17, 2025 am 11:29 AM

Chrome ada di sini dengan AI: mengalami sesuatu yang baru setiap hari !!Apr 17, 2025 am 11:29 AMRevolusi AI Google Chrome: Pengalaman melayari yang diperibadikan dan cekap Kecerdasan Buatan (AI) dengan cepat mengubah kehidupan seharian kita, dan Google Chrome mengetuai pertuduhan di arena pelayaran web. Artikel ini meneroka exciti

Sisi Manusia Ai ' s: Kesejahteraan dan garis bawah empat kali gandaApr 17, 2025 am 11:28 AM

Sisi Manusia Ai ' s: Kesejahteraan dan garis bawah empat kali gandaApr 17, 2025 am 11:28 AMImpak Reimagining: garis bawah empat kali ganda Selama terlalu lama, perbualan telah dikuasai oleh pandangan sempit kesan AI, terutama memberi tumpuan kepada keuntungan bawah. Walau bagaimanapun, pendekatan yang lebih holistik mengiktiraf kesalinghubungan BU

5 Kes Pengkomputeran Kuantum Mengubah Permainan Yang Harus Anda KetahuiApr 17, 2025 am 11:24 AM

5 Kes Pengkomputeran Kuantum Mengubah Permainan Yang Harus Anda KetahuiApr 17, 2025 am 11:24 AMPerkara bergerak terus ke arah itu. Pelaburan yang dicurahkan ke dalam penyedia perkhidmatan kuantum dan permulaan menunjukkan bahawa industri memahami kepentingannya. Dan semakin banyak kes penggunaan dunia nyata muncul untuk menunjukkan nilainya

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

VSCode Windows 64-bit Muat Turun

Editor IDE percuma dan berkuasa yang dilancarkan oleh Microsoft

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

MinGW - GNU Minimalis untuk Windows

Projek ini dalam proses untuk dipindahkan ke osdn.net/projects/mingw, anda boleh terus mengikuti kami di sana. MinGW: Port Windows asli bagi GNU Compiler Collection (GCC), perpustakaan import yang boleh diedarkan secara bebas dan fail pengepala untuk membina aplikasi Windows asli termasuk sambungan kepada masa jalan MSVC untuk menyokong fungsi C99. Semua perisian MinGW boleh dijalankan pada platform Windows 64-bit.

Versi Mac WebStorm

Alat pembangunan JavaScript yang berguna

SublimeText3 Linux versi baharu

SublimeText3 Linux versi terkini