Peranti teknologi

Peranti teknologi AI

AI Sesi perkongsian kertas model besar Xiaohongshu menghimpunkan pengarang dari empat persidangan antarabangsa utama

Sesi perkongsian kertas model besar Xiaohongshu menghimpunkan pengarang dari empat persidangan antarabangsa utamaSesi perkongsian kertas model besar Xiaohongshu menghimpunkan pengarang dari empat persidangan antarabangsa utama

Model besar menerajui pusingan baharu ledakan penyelidikan, dengan banyak hasil inovatif muncul dalam kedua-dua industri dan akademik.

Pasukan teknikal Xiaohongshu juga sentiasa meneroka dalam gelombang ini, dan hasil penyelidikan banyak kertas kerja telah kerap dibentangkan di persidangan antarabangsa terkemuka seperti ICLR, ACL, CVPR, AAI, SIGIR, dan WWW.

Apakah peluang dan cabaran baharu yang kami temui di persimpangan model besar dan pemprosesan bahasa semula jadi?

Apakah beberapa kaedah penilaian yang berkesan untuk model besar? Bagaimanakah ia boleh disepadukan dengan lebih baik ke dalam senario aplikasi?

Pada 27 Jun, 19:00-21:30, [REDtech akan datang] Terbitan kesebelas "Little Red Book 2024 Large Model Frontier Paper Sharing" akan disiarkan dalam talian!

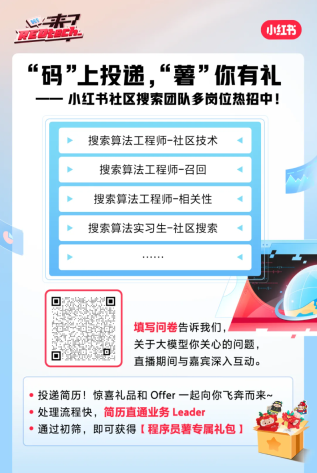

REDtech menjemput khas pasukan carian komuniti Xiaohongshu ke bilik siaran langsung mereka akan berkongsi 6 kertas penyelidikan model berskala besar yang diterbitkan oleh Xiaohongshu pada tahun 2024. Feng Shaoxiong, orang yang bertanggungjawab ke atas Xiaohongshu Jingpai LTR, berganding bahu dengan Li Yiwei, Wang Xinglin, Yuan Peiwen, Zhang Chao, dan lain-lain untuk membincangkan teknologi penyahkodan dan penyulingan model besar terkini, kaedah penilaian model besar, dan penggunaan besar. model dalam aplikasi Praktikal pada platform Xiaohongshu.

Ketekalan Diri (SC) sentiasa menjadi strategi penyahkodan yang digunakan secara meluas dalam penaakulan rantaian pemikiran dan mengambil jawapan majoriti sebagai jawapan akhir prestasi model. Tetapi ia adalah kaedah yang mahal yang memerlukan berbilang sampel saiz pratetap. Pada ICLR 2024, Xiaohongshu mencadangkan proses persampelan yang mudah dan berskala - Ketekalan Kendiri (ESC) Penghentian Awal, yang boleh mengurangkan Kos SC dengan ketara. Atas dasar ini, pasukan seterusnya memperoleh skim kawalan ESC untuk memilih keseimbangan kos prestasi secara dinamik untuk tugas dan model yang berbeza. Keputusan eksperimen pada tiga tugas penaakulan arus perdana (matematik, akal sehat dan penaakulan simbolik) menunjukkan bahawa ESC mengurangkan purata bilangan sampel merentas enam penanda aras sambil hampir mengekalkan prestasi asal.  Alamat kertas: https://arxiv.org/abs/2401.10480

Alamat kertas: https://arxiv.org/abs/2401.10480

02 Sepadukan Intipati dan Hilangkan Habuk: Ketekalan Diri Berbutir Halus untuk Penjanaan Bahasa Bentuk Percuma / Terpilih untuk ACL 2024

perkara yang lebih baik: Kaedah ketekalan diri yang halus untuk tugas penjanaan bentuk bebas| Pekongsi: Wang Xinglin

Xiaohongshu mencadangkan kaedah Ketekalan Diri Berbutir Halus (FSC) dalam ACL 2024, yang boleh meningkatkan diri dengan ketara -kaedah ketekalan dalam Prestasi pada tugas penjanaan bentuk bebas. Pasukan ini mula-mula menganalisis melalui eksperimen bahawa kelemahan kaedah konsisten kendiri sedia ada untuk tugas penjanaan bentuk bebas datang daripada pemilihan sampel biasa berbutir kasar, yang tidak dapat menggunakan pengetahuan umum antara serpihan halus sampel berbeza dengan berkesan. Atas dasar ini, pasukan mencadangkan kaedah FSC berdasarkan gabungan kendiri model besar, dan eksperimen mengesahkan bahawa ia mencapai prestasi yang lebih baik dengan ketara dalam penjanaan kod, penjanaan ringkasan dan tugasan penaakulan matematik, sambil mengekalkan penggunaan yang banyak. Alamat kertas: https://github.com/WangXinglin/FSC03 BatchEval: Towards Human-like Text Evaluation / Dipilih untuk ACL 2024, pengerusi bidang memberi markah penuh dan mengesyorkan kertas terbaik

Ke arah penilaian teks peringkat manusia| Shareer: Yuan Peiwen

Xiaohongshu mencadangkan kaedah BatchEval dalam ACL 2024, yang boleh mencapai kesan penilaian teks seperti manusia dengan overhed yang lebih rendah. Pasukan pertama menganalisis dari peringkat teori bahawa kelemahan kaedah penilaian teks sedia ada dalam keteguhan penilaian berpunca daripada pengagihan markah penilaian yang tidak sekata, dan prestasi suboptimum dalam penyepaduan skor datang daripada kekurangan kepelbagaian perspektif penilaian. Atas dasar ini, diilhamkan oleh perbandingan antara sampel dalam proses penilaian manusia untuk mewujudkan penanda aras penilaian yang lebih tiga dimensi dan komprehensif dengan pelbagai perspektif, BatchEval telah dicadangkan melalui analogi. Berbanding dengan beberapa kaedah terkini yang terkini, BatchEval mencapai prestasi yang lebih baik dengan ketara dalam kedua-dua overhed penilaian dan kesan penilaian. Alamat kertas: https://arxiv.org/abs/2401.00437 ketekalan Penilaian model bahasa besar|Pekongsi

: Yuan PeiwenXiaohongshu a proposé la méthode PEEM dans ACL 2024, qui permet d'obtenir une évaluation précise de grands modèles de langage au-delà du niveau humain grâce à une cohérence mutuelle entre les modèles. L’équipe a d’abord analysé que la tendance actuelle au développement rapide de grands modèles de langage accélérerait leur atteinte progressive, voire leur dépassement, à bien des égards, dans de nombreux aspects. Dans cette situation, les humains ne seraient plus en mesure de fournir des signaux d’évaluation précis. Afin de réaliser l'évaluation des capacités dans ce scénario, l'équipe a proposé l'idée d'utiliser la cohérence mutuelle entre les modèles comme signal d'évaluation, et en a déduit que lorsque les échantillons d'évaluation sont infinis, s'il existe une distribution de prédiction indépendante entre le modèle de référence. et le modèle à évaluer, alors cette cohérence entre les modèles de référence peut être utilisée comme une mesure précise de la capacité du modèle. Sur cette base, l'équipe a proposé la méthode PEEM basée sur l'algorithme EM, et les expériences ont confirmé qu'elle peut effectivement atténuer l'insuffisance des conditions ci-dessus dans la réalité, réalisant ainsi une évaluation précise de grands modèles de langage qui dépassent les niveaux humains. Adresse papier : https://github.com/ypw0102/PEEM 05 Transformer la poussière en or : distiller les capacités de raisonnement complexes des LLM en exploitant les données négatives / Sélectionné dans l'AAAI 2024 Oral Utiliser des échantillons négatifs pour promouvoir grands modèles Distillation des capacités de raisonnement | Sharer : Li Yiwei Les grands modèles de langage (LLM) fonctionnent bien sur diverses tâches de raisonnement, mais leurs propriétés de boîte noire et leur grand nombre de paramètres entravent leur application généralisée dans la pratique. Surtout lorsqu’ils traitent de problèmes mathématiques complexes, les LLM produisent parfois des chaînes de raisonnement erronées. Les méthodes de recherche traditionnelles transfèrent uniquement les connaissances des échantillons positifs et ignorent les données synthétiques contenant de mauvaises réponses. Lors de l'AAAI 2024, l'équipe d'algorithmes de recherche de Xiaohongshu a proposé un cadre innovant, a proposé et vérifié pour la première fois la valeur des échantillons négatifs dans le processus de distillation modèle et a construit un cadre de spécialisation de modèle qui, en plus d'utiliser des échantillons positifs, a également pleinement utilisation d'échantillons négatifs Pour affiner les connaissances du LLM. Le cadre comprend trois étapes de sérialisation, dont la formation assistée négative (NAT), l'amélioration de l'étalonnage négatif (NCE) et l'auto-cohérence dynamique (ASC), couvrant l'ensemble du processus, de la formation à l'inférence. Une vaste série d'expériences démontre le rôle essentiel des données négatives dans la distillation des connaissances LLM. Adresse papier : https://arxiv.org/abs/2312.12832 06 NoteLLM : Un modèle de langage large récupérable pour la recommandation de notes / Sélectionné pour la WWW 2024 Système de recommandation de représentation de contenu de notes basé sur un grand modèle de langage| Partagé par : Zhang Chao Comment regarder en direct Heure de diffusion en direct : 27 juin 2024, 19h00-21h30 Live Broadcast Platform : compte vidéo WeChat [REDtech], diffusion en direct sur les comptes Bilibili, Douyin et Xiaohongshu du même nom. Invitez des amis à prendre rendez-vous pour des cadeaux diffusés en direct

Dans le même temps, la diffusion en direct sera également diffusée simultanément sur les comptes vidéo partenaires [Jichi Platform], [Ce site] et [Datawhale] WeChat. Vous êtes invités à remplir le questionnaire et à nous dire quels sont les problèmes qui vous intéressent concernant le grand modèle, et à interagir en profondeur avec les invités pendant la diffusion en direct.

Atas ialah kandungan terperinci Sesi perkongsian kertas model besar Xiaohongshu menghimpunkan pengarang dari empat persidangan antarabangsa utama. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Skop Gemma: Mikroskop Google ' s untuk mengintip ke proses pemikiran AI 'Apr 17, 2025 am 11:55 AM

Skop Gemma: Mikroskop Google ' s untuk mengintip ke proses pemikiran AI 'Apr 17, 2025 am 11:55 AMMeneroka kerja -kerja dalam model bahasa dengan skop Gemma Memahami kerumitan model bahasa AI adalah satu cabaran penting. Pelepasan Google Gemma Skop, Toolkit Komprehensif, menawarkan penyelidik cara yang kuat untuk menyelidiki

Siapa penganalisis perisikan perniagaan dan bagaimana menjadi satu?Apr 17, 2025 am 11:44 AM

Siapa penganalisis perisikan perniagaan dan bagaimana menjadi satu?Apr 17, 2025 am 11:44 AMMembuka Kejayaan Perniagaan: Panduan untuk Menjadi Penganalisis Perisikan Perniagaan Bayangkan mengubah data mentah ke dalam pandangan yang boleh dilakukan yang mendorong pertumbuhan organisasi. Ini adalah kuasa penganalisis Perniagaan Perniagaan (BI) - peranan penting dalam GU

Bagaimana untuk menambah lajur dalam SQL? - Analytics VidhyaApr 17, 2025 am 11:43 AM

Bagaimana untuk menambah lajur dalam SQL? - Analytics VidhyaApr 17, 2025 am 11:43 AMPernyataan Jadual Alter SQL: Menambah lajur secara dinamik ke pangkalan data anda Dalam pengurusan data, kebolehsuaian SQL adalah penting. Perlu menyesuaikan struktur pangkalan data anda dengan cepat? Pernyataan Jadual ALTER adalah penyelesaian anda. Butiran panduan ini menambah colu

Penganalisis Perniagaan vs Penganalisis DataApr 17, 2025 am 11:38 AM

Penganalisis Perniagaan vs Penganalisis DataApr 17, 2025 am 11:38 AMPengenalan Bayangkan pejabat yang sibuk di mana dua profesional bekerjasama dalam projek kritikal. Penganalisis perniagaan memberi tumpuan kepada objektif syarikat, mengenal pasti bidang penambahbaikan, dan memastikan penjajaran strategik dengan trend pasaran. Simu

Apakah Count dan Counta dalam Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AM

Apakah Count dan Counta dalam Excel? - Analytics VidhyaApr 17, 2025 am 11:34 AMPengiraan dan Analisis Data Excel: Penjelasan terperinci mengenai fungsi Count dan Counta Pengiraan dan analisis data yang tepat adalah kritikal dalam Excel, terutamanya apabila bekerja dengan set data yang besar. Excel menyediakan pelbagai fungsi untuk mencapai matlamat ini, dengan fungsi Count dan CountA menjadi alat utama untuk mengira bilangan sel di bawah keadaan yang berbeza. Walaupun kedua -dua fungsi digunakan untuk mengira sel, sasaran reka bentuk mereka disasarkan pada jenis data yang berbeza. Mari menggali butiran khusus fungsi Count dan Counta, menyerlahkan ciri dan perbezaan unik mereka, dan belajar cara menerapkannya dalam analisis data. Gambaran keseluruhan perkara utama Memahami kiraan dan cou

Chrome ada di sini dengan AI: mengalami sesuatu yang baru setiap hari !!Apr 17, 2025 am 11:29 AM

Chrome ada di sini dengan AI: mengalami sesuatu yang baru setiap hari !!Apr 17, 2025 am 11:29 AMRevolusi AI Google Chrome: Pengalaman melayari yang diperibadikan dan cekap Kecerdasan Buatan (AI) dengan cepat mengubah kehidupan seharian kita, dan Google Chrome mengetuai pertuduhan di arena pelayaran web. Artikel ini meneroka exciti

Sisi Manusia Ai ' s: Kesejahteraan dan garis bawah empat kali gandaApr 17, 2025 am 11:28 AM

Sisi Manusia Ai ' s: Kesejahteraan dan garis bawah empat kali gandaApr 17, 2025 am 11:28 AMImpak Reimagining: garis bawah empat kali ganda Selama terlalu lama, perbualan telah dikuasai oleh pandangan sempit kesan AI, terutama memberi tumpuan kepada keuntungan bawah. Walau bagaimanapun, pendekatan yang lebih holistik mengiktiraf kesalinghubungan BU

5 Kes Pengkomputeran Kuantum Mengubah Permainan Yang Harus Anda KetahuiApr 17, 2025 am 11:24 AM

5 Kes Pengkomputeran Kuantum Mengubah Permainan Yang Harus Anda KetahuiApr 17, 2025 am 11:24 AMPerkara bergerak terus ke arah itu. Pelaburan yang dicurahkan ke dalam penyedia perkhidmatan kuantum dan permulaan menunjukkan bahawa industri memahami kepentingannya. Dan semakin banyak kes penggunaan dunia nyata muncul untuk menunjukkan nilainya

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Versi Mac WebStorm

Alat pembangunan JavaScript yang berguna

Dreamweaver CS6

Alat pembangunan web visual

Muat turun versi mac editor Atom

Editor sumber terbuka yang paling popular

DVWA

Damn Vulnerable Web App (DVWA) ialah aplikasi web PHP/MySQL yang sangat terdedah. Matlamat utamanya adalah untuk menjadi bantuan bagi profesional keselamatan untuk menguji kemahiran dan alatan mereka dalam persekitaran undang-undang, untuk membantu pembangun web lebih memahami proses mengamankan aplikasi web, dan untuk membantu guru/pelajar mengajar/belajar dalam persekitaran bilik darjah Aplikasi web keselamatan. Matlamat DVWA adalah untuk mempraktikkan beberapa kelemahan web yang paling biasa melalui antara muka yang mudah dan mudah, dengan pelbagai tahap kesukaran. Sila ambil perhatian bahawa perisian ini

Pelayar Peperiksaan Selamat

Pelayar Peperiksaan Selamat ialah persekitaran pelayar selamat untuk mengambil peperiksaan dalam talian dengan selamat. Perisian ini menukar mana-mana komputer menjadi stesen kerja yang selamat. Ia mengawal akses kepada mana-mana utiliti dan menghalang pelajar daripada menggunakan sumber yang tidak dibenarkan.