Rumah >Peranti teknologi >AI >MLLM berasaskan Mamba yang pertama ada di sini! Berat model, kod latihan, dsb. semuanya telah menjadi sumber terbuka

MLLM berasaskan Mamba yang pertama ada di sini! Berat model, kod latihan, dsb. semuanya telah menjadi sumber terbuka

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBasal

- 2024-07-17 02:46:301132semak imbas

Lajur AIxiv ialah lajur di mana tapak ini menerbitkan kandungan akademik dan teknikal. Dalam beberapa tahun kebelakangan ini, lajur AIxiv laman web ini telah menerima lebih daripada 2,000 laporan, meliputi makmal terkemuka dari universiti dan syarikat utama di seluruh dunia, mempromosikan pertukaran dan penyebaran akademik secara berkesan. Jika anda mempunyai kerja yang sangat baik yang ingin anda kongsikan, sila berasa bebas untuk menyumbang atau hubungi kami untuk melaporkan. E-mel penyerahan: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com.

- Eksperimen meluas telah dijalankan untuk menilai prestasi Cobra dengan kajian selari yang bertujuan untuk meningkatkan kecekapan pengiraan asas MLLM. Terutama, Cobra mencapai prestasi yang setanding dengan LLaVA walaupun dengan parameter yang lebih sedikit, menyerlahkan kecekapannya.

Pautan asal: https://arxiv.org/pdf/2403.14520v2.pdf Pautan projek: https://sites.google.com/view/cobravlm/ - tajuk

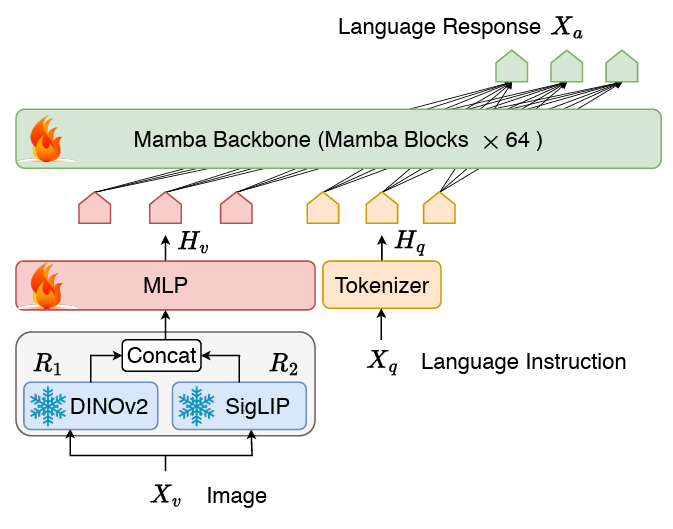

:CobraPaper Memperluaskan Mamba kepada Model Bahasa Besar Berbilang Modal untuk Inferens Cekap untuk menyambung dua model Struktur VLM terdiri daripada projektor stateful dan tulang belakang bahasa LLM. Bahagian tulang belakang LLM menggunakan model bahasa Mamba pra-latihan parameter 2.8B, yang telah dilatih pada set data SlimPajama dengan token 600B dan diperhalusi dengan arahan data perbualan.网络 Gambarajah struktur rangkaian Cobra

Berbeza daripada LLAVA, dsb., COBRA menggunakan perwakilan visual gabungan Dinov2 dan SIGLIP Dengan mencantumkan output kedua-dua pengekod visual bersama-sama Memasukkan ke dalam projektor, model boleh menangkap dengan lebih baik ciri semantik peringkat tinggi yang dibawa oleh SigLIP dan ciri imej berbutir halus peringkat rendah yang diekstrak oleh DINOv2.

Penyelidikan terkini menunjukkan bahawa untuk paradigma latihan sedia ada berdasarkan LLaVA (iaitu, hanya melatih peringkat pra-penjajaran lapisan unjuran dan tahap penalaan halus bagi LLM. setiap satu), peringkat prapenjajaran mungkin tidak diperlukan dan model yang diperhalusi mungkin masih kurang dipasang. Oleh itu, Cobra meninggalkan peringkat prapenjajaran dan terus memperhalusi keseluruhan tulang belakang dan projektor bahasa LLM. Proses penalaan halus ini dilakukan untuk dua zaman dengan pensampelan rawak pada set data gabungan yang terdiri daripada:

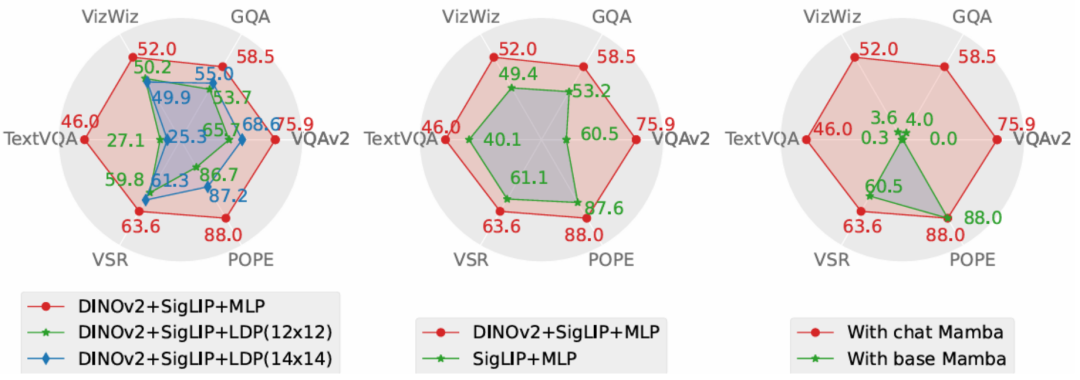

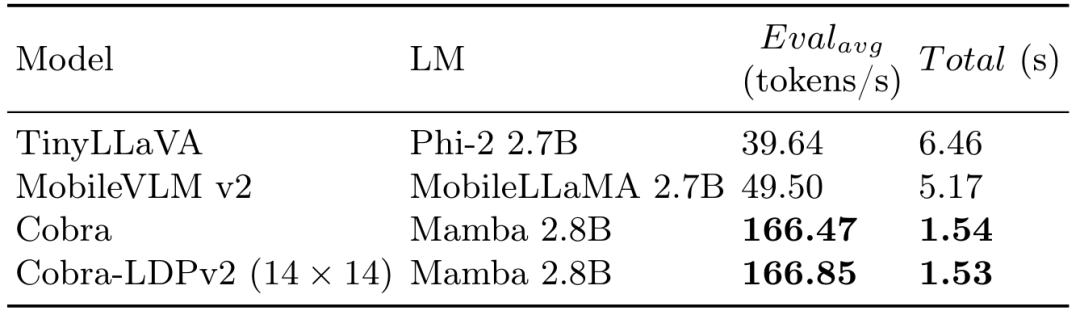

Dataset hibrid yang digunakan dalam LLaVA v1.5, yang mengandungi sejumlah 655K perbualan berbilang pusingan visual, termasuk Akademik Sampel VQA, serta data penalaan arahan visual dalam LLaVA-Instruct dan data penalaan arahan teks biasa dalam ShareGPT. LVIS-Instruct-4V, yang mengandungi 220K imej dengan penjajaran visual dan arahan peka konteks yang dijana oleh GPT-4V. Seluruh set data mengandungi kira-kira 1.2 juta imej dan berbilang pusingan data perbualan yang sepadan, serta data perbualan teks biasa. Eksperimen Experiment quantitative - Dalam bahagian eksperimen, makalah ini membandingkan model COBRA yang dicadangkan dan model SOTA VLM sumber terbuka pada penanda aras asas, dan membandingkannya dengan sama Magnitud adalah berdasarkan kelajuan menjawab model VLM berdasarkan seni bina Transformer. Pada masa yang sama, kelajuan penjanaan dan perbandingan prestasi graf pada masa yang sama, COBRA juga merupakan empat tugas VQA terbuka VQA-V2, GQA, Vizwiz, TextVQA dan VSR, POPE dua Untuk tugas ramalan set tertutup , markah dibandingkan pada sejumlah 6 penanda aras. Perbandingan peta pada Penanda Aras dan model sumber terbuka lain

Di samping itu, Cobra juga memberikan dua contoh VQA untuk objek secara kualitatif i. Keunggulan dalam keupayaan untuk mengenali hubungan ruang dan mengurangkan ilusi model.和 Rajah COBRA dan model garis dasar lain dalam pertimbangan hubungan ruang objek Dalam contoh, Llava V1.5 dan Mobilevlm diberi jawapan ralat, manakala COBRA melakukan Penerangan yang tepat telah diberikan, terutamanya dalam contoh kedua, Cobra mengenal pasti dengan tepat bahawa gambar itu datang dari persekitaran simulasi robot.

Eksperimen AblasiArtikel ini menjalankan penyelidikan ablasi mengenai penyelesaian yang diterima pakai oleh Cobra daripada dua dimensi prestasi dan kelajuan penjanaan. Pelan eksperimen menjalankan eksperimen ablasi masing-masing pada projektor, pengekod visual, dan tulang belakang bahasa LLM. Perbandingan prestasi prestasi eksperimen ablasi gambar rajah menunjukkan bahawa eksperimen ablasi bahagian projek projektor menunjukkan bahawa kesan projektor MLP yang diguna pakai dalam artikel ini adalah lebih baik secara signifikan daripada khusus untuk mengurangkan bilangan Token visual kepada LDP. modul meningkatkan kelajuan pengkomputeran Pada masa yang sama, kerana kelajuan pemprosesan jujukan dan kerumitan pengkomputeran Cobra adalah lebih baik daripada Transformer, modul LDP tidak mempunyai kelebihan yang jelas dalam kelajuan penjanaan. Oleh itu, model kelas Mamba digunakan untuk mengurangkan bilangan token visual dengan mengorbankan ketepatan Pensampel mungkin tidak diperlukan.和 Rajah COBRA dan model lain dalam julat perbandingan kelajuan penjanaan

Keputusan ablasi bahagian pengekod visual menunjukkan gabungan ciri Dinov2 secara berkesan meningkatkan prestasi COBRA. Dalam eksperimen tulang belakang bahasa, model bahasa Mamba tanpa penalaan halus arahan sama sekali tidak dapat memberikan jawapan yang munasabah dalam ujian soalan dan jawapan terbuka, manakala model bahasa Mamba yang ditala halus boleh mencapai prestasi yang besar dalam pelbagai tugas.

Kesimpulan Kertas ini mencadangkan Cobra, yang menyelesaikan kesesakan kecekapan model bahasa berskala besar berbilang mod sedia ada yang bergantung pada rangkaian Transformer dengan kompleksiti pengiraan kuadratik. Kertas kerja ini meneroka gabungan model bahasa dengan kerumitan pengiraan linear dan input multimodal. Dari segi penggabungan maklumat visual dan bahasa, kertas kerja ini berjaya mengoptimumkan integrasi maklumat dalaman model bahasa Mamba dan mencapai perwakilan pelbagai mod yang lebih berkesan melalui penyelidikan mendalam mengenai skema gabungan modal yang berbeza. Eksperimen menunjukkan bahawa Cobra bukan sahaja meningkatkan kecekapan pengiraan dengan ketara, tetapi juga setanding dalam prestasi kepada model lanjutan seperti LLaVA, terutamanya dalam mengatasi ilusi visual dan pertimbangan hubungan ruang. Malah ia mengurangkan bilangan parameter dengan ketara. Ini membuka kemungkinan baharu untuk penggunaan model AI berprestasi tinggi pada masa hadapan dalam persekitaran yang memerlukan pemprosesan maklumat visual frekuensi tinggi, seperti kawalan maklum balas robot berasaskan penglihatan.

Atas ialah kandungan terperinci MLLM berasaskan Mamba yang pertama ada di sini! Berat model, kod latihan, dsb. semuanya telah menjadi sumber terbuka. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI