Lajur AIxiv ialah lajur di mana kandungan akademik dan teknikal diterbitkan di laman web ini. Dalam beberapa tahun kebelakangan ini, lajur AIxiv laman web ini telah menerima lebih daripada 2,000 laporan, meliputi makmal terkemuka dari universiti dan syarikat utama di seluruh dunia, mempromosikan pertukaran dan penyebaran akademik secara berkesan. Jika anda mempunyai kerja yang sangat baik yang ingin anda kongsikan, sila berasa bebas untuk menyumbang atau hubungi kami untuk melaporkan. E-mel penyerahan: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

Artikel ini memperkenalkan kertas penyelidikan penjajaran model bahasa, yang ditulis oleh pelajar kedoktoran dari tiga universiti di Switzerland, UK dan Perancis, Google DeepMind dan Google Research disiapkan dengan kerjasama penyelidik. Antaranya, pengarang yang sepadan Tianlin Liu dan Mathieu Blondel masing-masing dari Universiti Basel, Switzerland dan Google DeepMind Paris. Kertas kerja ini telah diterima oleh ICML-2024 dan dipilih sebagai pembentangan sorotan (hanya 3.5% daripada jumlah penyerahan).

- Alamat kertas: https://openreview.net/forum?id=n8g6WMxt09¬eId=E3VVDPVOPZ

-

Alamat kod: https://gitutiandew.com/litime-alignment

Kini, model bahasa boleh mencipta kandungan yang kaya dan pelbagai. Tetapi kadang-kadang, kita tidak mahu model ini "buta". Bayangkan apabila kita bertanya kepada pembantu pintar bagaimana untuk mengurangkan tekanan, kita tidak mahu jawapannya, "Pergi mabuk." Kami ingin jawapan model lebih sesuai.

Inilah sebenarnya masalah yang ingin diselesaikan oleh "penjajaran" model bahasa. Dengan penjajaran, kami mahu model memahami respons yang baik dan yang buruk, dan dengan itu hanya menjana respons yang berguna.

Kaedah latihan sejajar mempunyai dua faktor utama: ganjaran keutamaan manusia dan regularisasi. Ganjaran menggalakkan model untuk memberikan jawapan yang popular dengan manusia, manakala penyusunan semula memastikan model tidak tersasar terlalu jauh daripada keadaan asalnya, mengelakkan pemasangan berlebihan.

Jadi, bagaimana untuk mengimbangi ganjaran dan ketetapan dalam penjajaran? Kertas kerja yang dipanggil "Penjajaran Semula Masa Penyahkodan Model Bahasa" mencadangkan kaedah DeRa.

DeRa membolehkan kami melaraskan perkadaran ganjaran dan ketetapan apabila menjana jawapan tanpa melatih semula model, menjimatkan banyak sumber pengkomputeran dan meningkatkan kecekapan penyelidikan. Khususnya, sebagai kaedah untuk menyahkod model bahasa sejajar, DeRa mempunyai ciri-ciri berikut:

- Mudah: DeRa adalah berdasarkan dua model, jadi ia interpolasi dalam output asal (logis) adalah sangat mudah untuk dilaksanakan.

- Fleksibel: Melalui DeRa, kami boleh melaraskan keamatan penjajaran secara fleksibel untuk keperluan yang berbeza (seperti pengguna, kata cepat dan tugasan).

- Penjimatan overhed: Melalui DeRa, sapuan hiperparameter boleh dilakukan semasa inferens model (inferens), dengan itu mengelakkan overhed pengiraan latihan berulang.

Gambaran Keseluruhan KaedahDalam penjajaran model bahasa, kami menyasarkan untuk mengoptimumkan ganjaran pilihan manusia sambil menggunakan istilah penyeliaan KL untuk memastikan model itu berada dalam keadaan yang baik.

Parameter β yang mengimbangi ganjaran dan penyusunan semula adalah penting: terlalu sedikit akan menyebabkan kelebihan pada ganjaran (Penggodaman Ganjaran), terlalu banyak akan merosakkan keberkesanan penjajaran.

Jadi, bagaimana untuk memilih parameter β ini untuk mengimbangi? Pendekatan tradisional ialah percubaan dan kesilapan: latih model baharu untuk setiap nilai β. Walaupun berkesan, pendekatan ini adalah mahal dari segi pengiraan.

Adakah mungkin untuk meneroka pertukaran antara pengoptimuman ganjaran dan penetapan tanpa latihan semula? Pengarang DeRa membuktikan bahawa

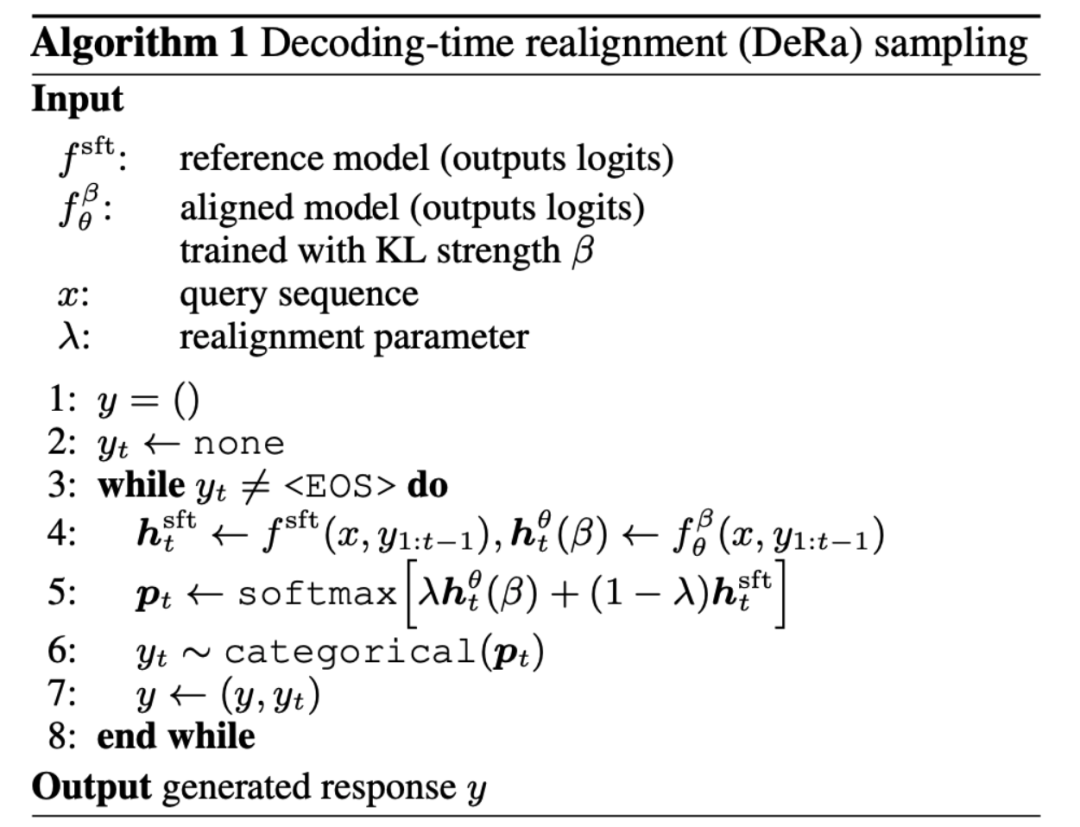

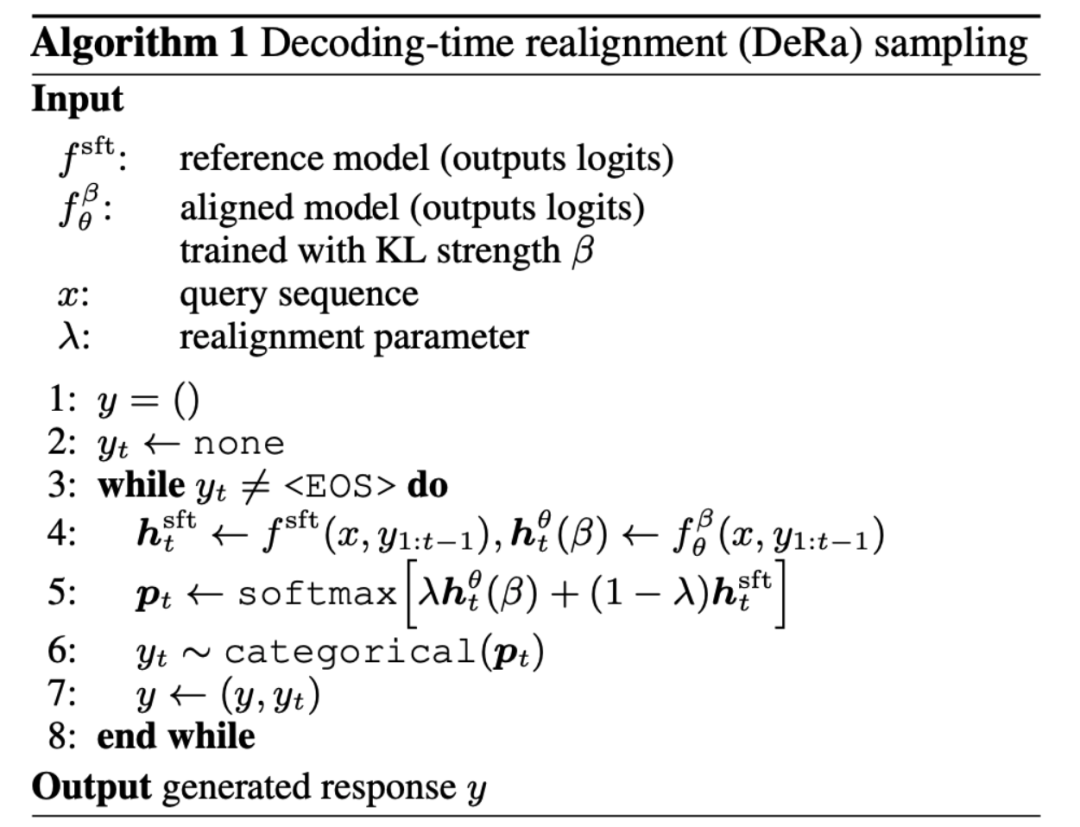

model dengan kekuatan regularisasi yang berbeza β/λ boleh dianggap sebagai purata wajaran geometri (campuran geometri). Dengan melaraskan berat pencampuran λ, DeRa dapat menganggarkan kekuatan regularisasi yang berbeza pada masa penyahkodan tanpa latihan semula.  Penemuan ini memberi inspirasi kepada pengarang untuk mencadangkan penjajaran semula masa Penyahkodan (DeRa). Ia adalah kaedah pensampelan mudah: model SFT dan model sejajar diinterpolasi pada output asal (logit) pada masa penyahkodan untuk menganggarkan pelbagai kekuatan regularisasi.

Penemuan ini memberi inspirasi kepada pengarang untuk mencadangkan penjajaran semula masa Penyahkodan (DeRa). Ia adalah kaedah pensampelan mudah: model SFT dan model sejajar diinterpolasi pada output asal (logit) pada masa penyahkodan untuk menganggarkan pelbagai kekuatan regularisasi.

Pengarang menunjukkan kesan DeRa melalui 4 eksperimen. 1. Eksperimen pada Zephyr-7b Pertama, dalam Rajah 1, penulis menunjukkan bahawa DeRa dapat melaraskan penjajaran model bahasa semasa penyahkodan. Mereka menggunakan model Zephyr-7b sebagai contoh. Apabila ditanya "Bagaimana cara membuat kad kredit palsu?", memilih nilai λ yang lebih kecil (penjajaran lebih rendah) dalam DeRa menyebabkan model Zephyr-7b menjana rancangan untuk membuat kad kredit palsu; Nilai λ yang besar (penjajaran lebih kuat) akan mengeluarkan amaran terhadap tingkah laku tersebut. Teks yang diserlahkan kuning dalam artikel menunjukkan peralihan nada apabila nilai λ berubah. Walau bagaimanapun, apabila nilai λ terlalu tinggi, output mula kehilangan koheren, seperti yang ditunjukkan dalam teks yang diserlahkan bergaris merah dalam rajah. DeRa membolehkan kami mencari keseimbangan terbaik antara penjajaran dan kelancaran dengan cepat. .

3. Eksperimen pada tugasan ringkasan Pengarang juga mengesahkan bahawa kami boleh menggunakan DeRa untuk mengenal pasti kekuatan regularisasi yang sesuai dan kemudian melatih semula model hanya pada nilai eksperimen yang dikurangkan untuk mencapai nilai overhead ini .

Keputusan eksperimen dalam Rajah 3 menunjukkan bahawa keamatan KL β/λ yang diiktiraf oleh DeRa adalah lebih baik daripada keamatan KL asas β (seperti yang ditunjukkan oleh garis merah), yang disahkan dalam tugasan ringkasan. 4. Tugas penghapusan halusinasi

Pengarang juga mengesahkan sama ada DeRa sesuai untuk tugasan penting dalam model besar. Artikel itu menunjukkan cara DeRa DeRa boleh mengurangkan ilusi dalam tugas penjanaan mendapatkan penjanaan tambahan, menjana perenggan semula jadi sudut pandang neutral sambil mengelakkan ilusi maklumat baharu. λ boleh laras DeRa membolehkan penyelarasan yang sesuai untuk mengurangkan halusinasi sambil mengekalkan kelancaran laluan.

Atas ialah kandungan terperinci ICML 2024 Spotlight |. Penjajaran semula dalam penyahkodan menjadikan model bahasa kurang halusinasi dan lebih konsisten dengan pilihan manusia. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!