Rumah >Peranti teknologi >AI >Cara Menggunakan Sembang Nvidia Dengan RTX AI Chatbot pada Komputer Anda

Cara Menggunakan Sembang Nvidia Dengan RTX AI Chatbot pada Komputer Anda

- 王林asal

- 2024-06-14 18:39:261212semak imbas

Nvidia telah melancarkan Sembang dengan RXT, bot sembang AI yang beroperasi pada PC anda dan menawarkan ciri yang serupa dengan ChatGPT dan banyak lagi! Apa yang anda perlukan ialah GPU Nvidia RTX, dan anda sudah bersedia untuk mula menggunakan chatbot AI baharu Nvidia.

Apakah Nvidia Chat dengan RTX?

Nvidia Chat dengan RTX ialah perisian AI yang membolehkan anda menjalankan model bahasa besar (LLM) secara setempat pada komputer anda. Jadi, daripada pergi ke dalam talian untuk menggunakan bot sembang AI seperti ChatGPT, anda boleh menggunakan Sembang dengan RTX di luar talian pada bila-bila masa anda mahu.

Sembang dengan RTX menggunakan TensorRT-LLM, pecutan RTX, dan Mistral 7-B LLM terkuantisasi untuk memberikan prestasi pantas dan respons berkualiti setanding dengan bot sembang AI dalam talian yang lain. Ia juga menyediakan penjanaan dipertingkatkan semula (RAG), membolehkan chatbot membaca fail anda dan mendayakan jawapan tersuai berdasarkan data yang anda berikan. Ini membolehkan anda menyesuaikan chatbot untuk memberikan pengalaman yang lebih peribadi.

Jika anda ingin mencuba Nvidia Chat dengan RTX, berikut ialah cara untuk memuat turun, memasang dan mengkonfigurasinya pada komputer anda.

Cara Muat Turun dan Pasang Sembang dengan RTX

Nvidia telah memudahkan menjalankan LLM secara setempat pada komputer anda. Untuk menjalankan Chat dengan RTX, anda hanya perlu memuat turun dan memasang apl, sama seperti yang anda lakukan dengan mana-mana perisian lain. Walau bagaimanapun, Sembang dengan RTX mempunyai beberapa keperluan spesifikasi minimum untuk dipasang dan digunakan dengan betul.

RTX 30-Series atau 40-Series GPU 16GB RAM 100GB ruang memori percuma Windows 11Jika PC anda melepasi keperluan sistem minimum, anda boleh meneruskan dan memasang apl itu.

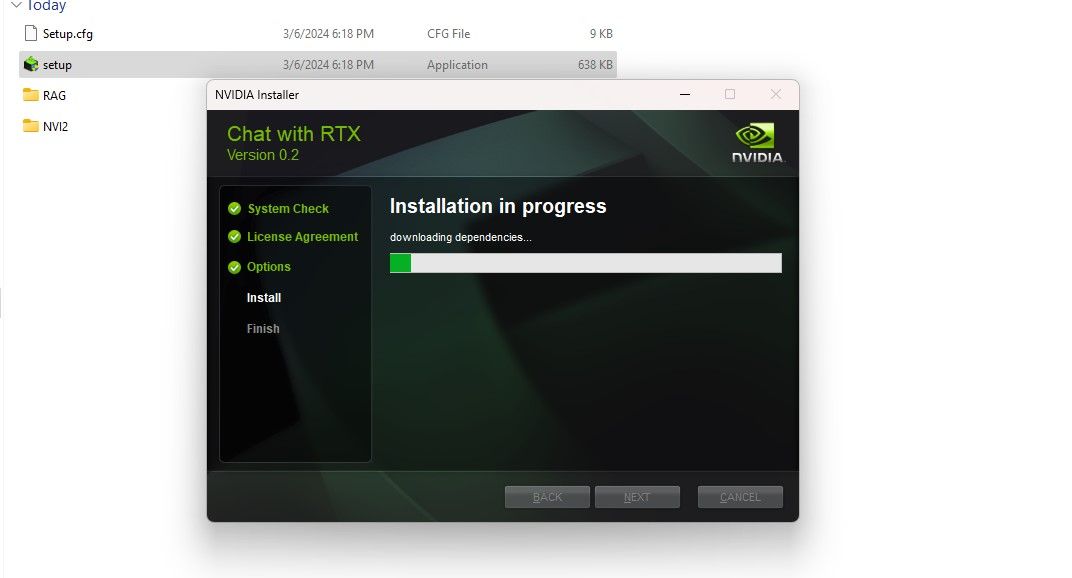

Langkah 1: Muat turun fail Sembang dengan RTX ZIP. Muat turun: Sembang dengan RTX (Percuma—muat turun 35GB)Langkah 2: Ekstrak fail ZIP dengan mengklik kanan dan memilih alat arkib fail seperti 7Zip atau mengklik dua kali pada fail dan memilih Ekstrak Semua. Langkah 3: Buka folder yang diekstrak dan klik dua kali setup.exe. Ikut arahan pada skrin dan tandai semua kotak semasa proses pemasangan tersuai. Selepas menekan Seterusnya, pemasang akan memuat turun dan memasang LLM dan semua kebergantungan.

Pemasangan Sembang dengan RTX akan mengambil sedikit masa untuk diselesaikan kerana ia memuat turun dan memasang sejumlah besar data. Selepas proses pemasangan, tekan Tutup, dan anda selesai. Kini, tiba masanya untuk anda mencuba aplikasinya.

Cara Menggunakan Nvidia Chat dengan RTX

Walaupun anda boleh menggunakan Chat dengan RTX seperti chatbot AI dalam talian biasa, saya amat menyarankan anda menyemak fungsi RAGnya, yang membolehkan anda menyesuaikan outputnya berdasarkan fail yang anda berikan akses.

Langkah 1: Cipta Folder RAG

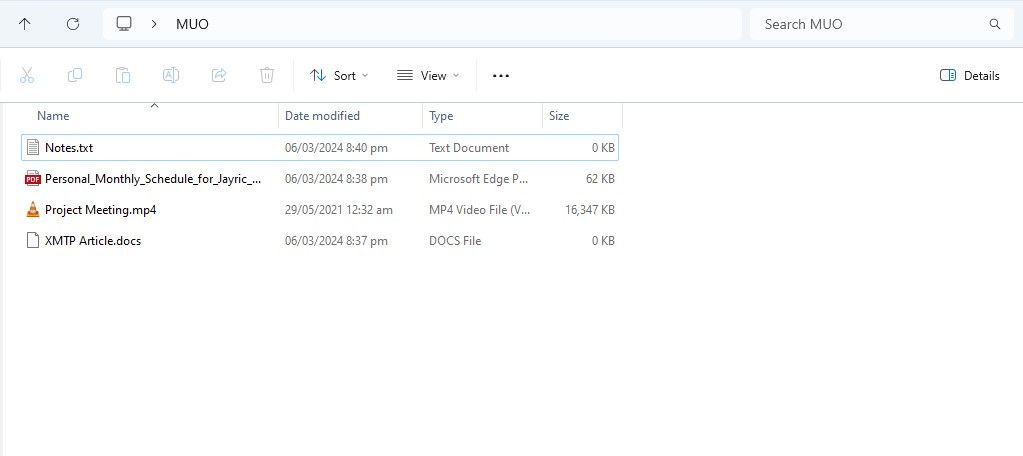

Untuk mula menggunakan RAG pada Chat dengan RTX, cipta folder baharu untuk menyimpan fail yang anda mahu AI analisis.

Selepas penciptaan, letakkan fail data anda ke dalam folder. Data yang anda simpan boleh merangkumi banyak topik dan jenis fail, seperti dokumen, PDF, teks dan video. Walau bagaimanapun, anda mungkin mahu mengehadkan bilangan fail yang anda letakkan dalam folder ini supaya tidak menjejaskan prestasi. Lebih banyak data untuk mencari melalui cara Sembang dengan RTX akan mengambil masa yang lebih lama untuk mengembalikan respons untuk pertanyaan tertentu (tetapi ini juga bergantung kepada perkakasan).

Kini pangkalan data anda sudah sedia, anda boleh menyediakan Sembang dengan RTX dan mula menggunakannya untuk menjawab soalan dan pertanyaan anda.

Langkah 2: Sediakan Persekitaran

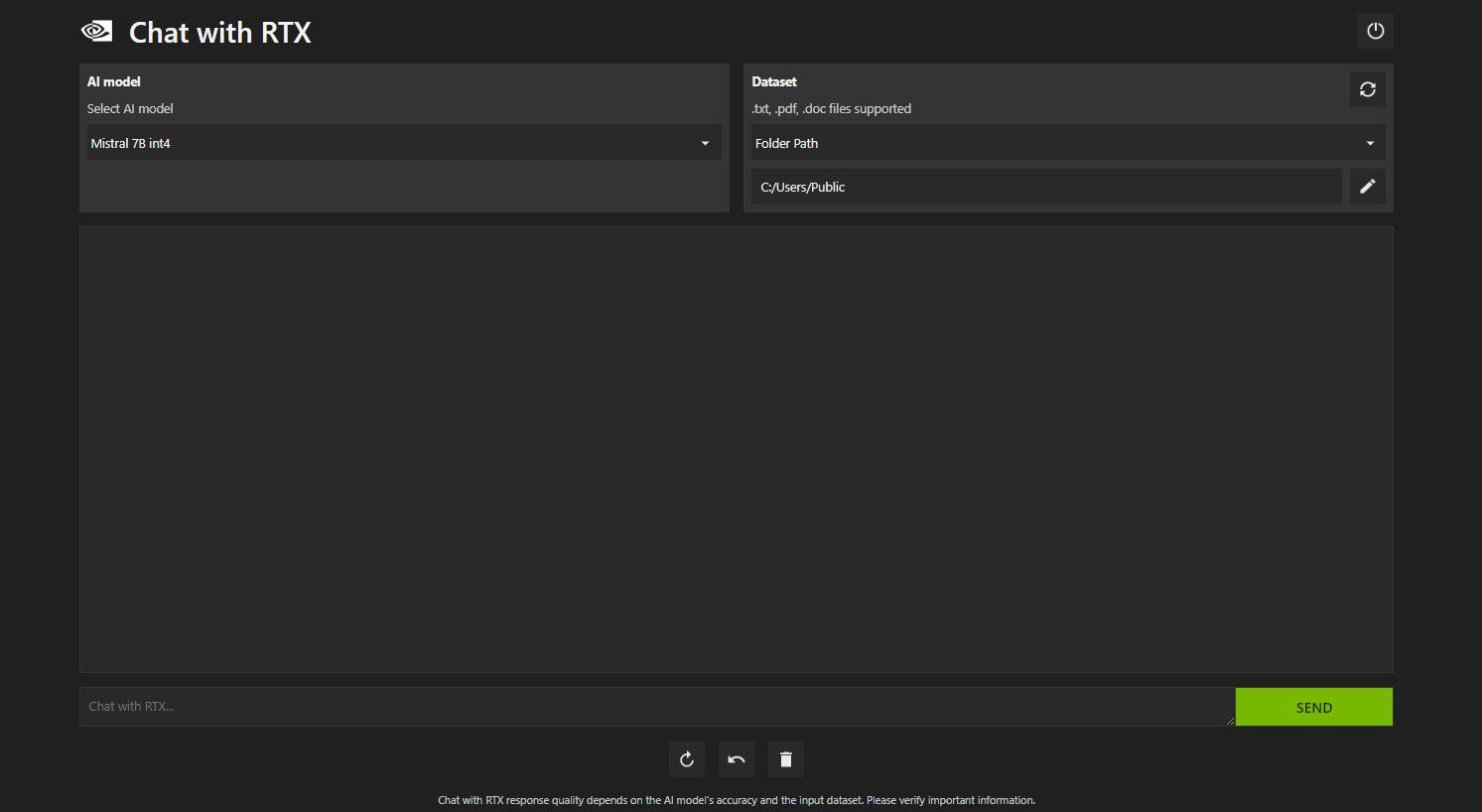

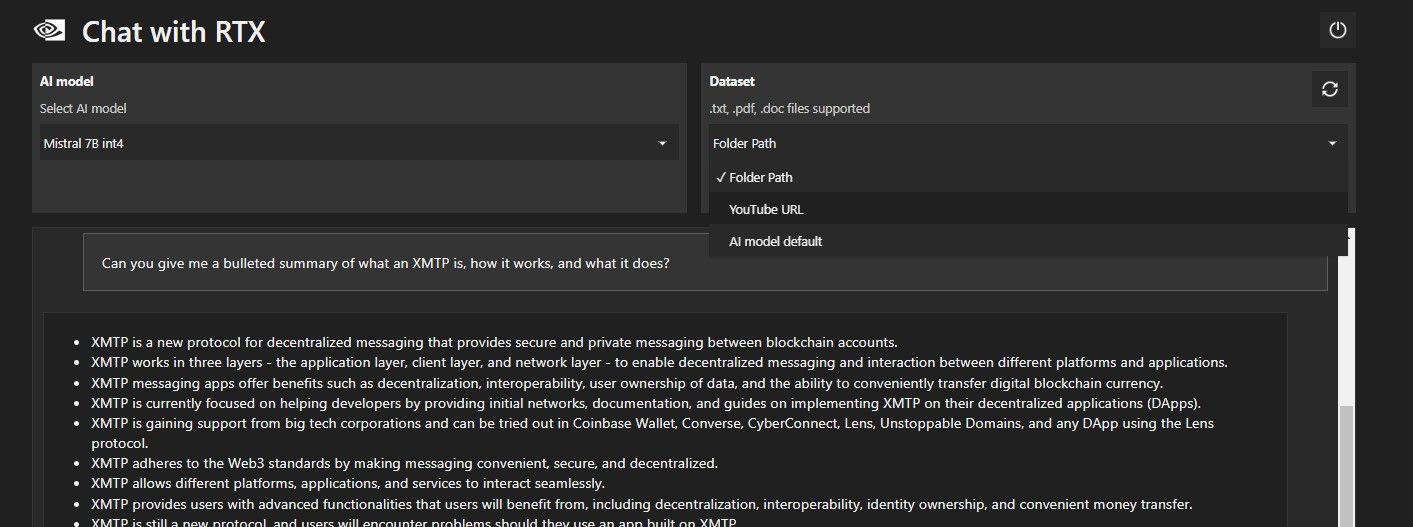

Buka Sembang dengan RTX. Ia sepatutnya kelihatan seperti imej di bawah.

Di bawah Set Data, pastikan pilihan Laluan Folder dipilih. Sekarang klik pada ikon edit di bawah (ikon pen) dan pilih folder yang mengandungi semua fail yang anda mahu Sembang dengan RTX baca. Anda juga boleh menukar model AI jika pilihan lain tersedia (pada masa penulisan, hanya Mistral 7B tersedia).

Anda kini bersedia untuk menggunakan Sembang dengan RTX.

Langkah 3: Tanya Sembang dengan RTX Soalan Anda!

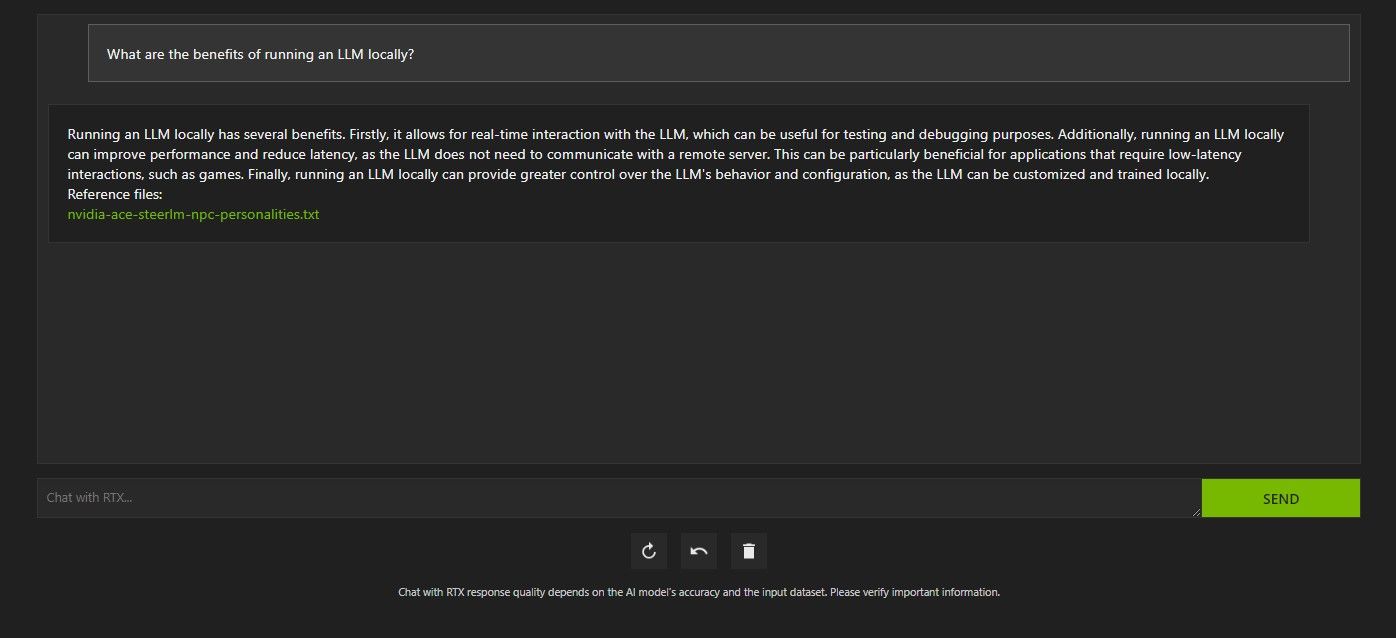

Terdapat beberapa cara untuk membuat pertanyaan Sembang dengan RTX. Yang pertama ialah menggunakannya seperti chatbot AI biasa. Saya bertanya Chat dengan RTX tentang faedah menggunakan LLM tempatan dan berpuas hati dengan jawapannya. Ia tidak begitu mendalam, tetapi cukup tepat.

Tetapi kerana Chat dengan RTX mampu RAG, anda juga boleh menggunakannya sebagai pembantu AI peribadi.

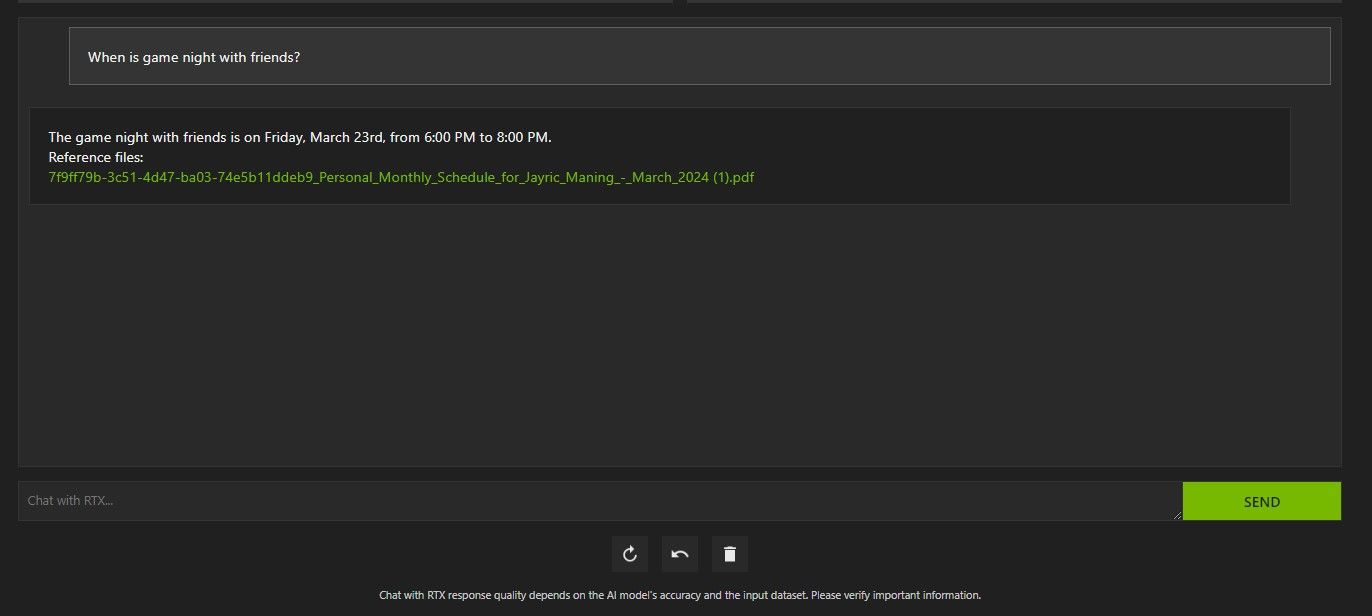

Di atas, saya telah menggunakan Chat dengan RTX untuk bertanya tentang jadual saya. Data datang daripada fail PDF yang mengandungi jadual saya, kalendar, acara, kerja dan sebagainya. Dalam kes ini, Sembang dengan RTX telah menarik data kalendar yang betul daripada data; anda perlu memastikan fail data dan tarikh kalendar anda dikemas kini agar ciri seperti ini berfungsi dengan betul sehingga terdapat penyepaduan dengan apl lain.

Terdapat banyak cara anda boleh menggunakan Sembang dengan RAG RTX untuk kelebihan anda. Contohnya, anda boleh menggunakannya untuk membaca kertas undang-undang dan memberikan ringkasan, menjana kod yang berkaitan dengan program yang anda sedang bangunkan, mendapatkan sorotan bertitik tumpu mengenai video yang anda terlalu sibuk untuk menonton dan banyak lagi!

Langkah 4: Ciri Bonus

Selain folder data setempat anda, anda boleh menggunakan Sembang dengan RTX untuk menganalisis video YouTube. Untuk berbuat demikian, di bawah Set Data, tukar Laluan Folder kepada URL YouTube.

Salin URL YouTube yang ingin anda analisis dan tampalkannya di bawah menu lungsur. Kemudian minta jauh!

Sembang dengan analisis video YouTube RTX cukup bagus dan menyampaikan maklumat yang tepat, jadi ia boleh berguna untuk penyelidikan, analisis pantas dan banyak lagi.

Adakah Sembang Nvidia dengan RTX Ada Kebaikan?

ChatGPT menyediakan fungsi RAG. Sesetengah chatbot AI tempatan mempunyai keperluan sistem yang jauh lebih rendah. Jadi, adakah Nvidia Chat dengan RTX berbaloi untuk digunakan?

Jawapannya ya! Sembang dengan RTX berbaloi untuk digunakan walaupun terdapat persaingan.

Salah satu nilai jualan terbesar menggunakan Nvidia Chat dengan RTX ialah keupayaannya untuk menggunakan RAG tanpa menghantar fail anda ke pelayan pihak ketiga. Menyesuaikan GPT melalui perkhidmatan dalam talian boleh mendedahkan data anda. Tetapi memandangkan Chat dengan RTX berjalan secara setempat dan tanpa sambungan internet, menggunakan RAG pada Chat dengan RTX memastikan data sensitif anda selamat dan hanya boleh diakses pada PC anda.

Bagi bot sembang AI lain yang menjalankan tempatan yang menjalankan Mistral 7B, Sembang dengan RTX berprestasi lebih baik dan lebih pantas. Walaupun sebahagian besar peningkatan prestasi datang daripada penggunaan GPU yang lebih tinggi, penggunaan Nvidia TensorRT-LLM dan pecutan RTX menjadikan Mistral 7B berjalan lebih pantas pada Chat dengan RTX jika dibandingkan dengan cara lain menjalankan LLM yang dioptimumkan sembang.

Perlu diingat bahawa versi Sembang dengan RTX yang sedang kami gunakan ialah demo. Keluaran Chat dengan RTX kemudiannya mungkin akan menjadi lebih dioptimumkan dan memberikan peningkatan prestasi.

Bagaimana jika Saya Tidak Mempunyai GPU Siri RTX 30 atau 40?

Sembang dengan RTX ialah cara yang mudah, pantas dan selamat untuk menjalankan LLM secara tempatan tanpa memerlukan sambungan internet. Jika anda juga berminat untuk menjalankan LLM atau tempatan tetapi tidak mempunyai GPU Siri RTX 30 atau 40, anda boleh mencuba cara lain untuk menjalankan LLM secara tempatan. Dua daripada yang paling popular ialah GPT4ALL dan Text Gen WebUI. Cuba GPT4ALL jika anda mahukan pengalaman plug-and-play yang menjalankan LLM secara tempatan. Tetapi jika anda lebih cenderung dari segi teknikal, menjalankan LLM melalui Text Gen WebUI akan memberikan penalaan halus dan fleksibiliti yang lebih baik.

Atas ialah kandungan terperinci Cara Menggunakan Sembang Nvidia Dengan RTX AI Chatbot pada Komputer Anda. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Aliran teknologi untuk ditonton pada tahun 2023

- Cara Kecerdasan Buatan Membawa Kerja Baharu Setiap Hari kepada Pasukan Pusat Data

- Bolehkah kecerdasan buatan atau automasi menyelesaikan masalah kecekapan tenaga yang rendah dalam bangunan?

- Pengasas bersama OpenAI ditemu bual oleh Huang Renxun: Keupayaan penaakulan GPT-4 belum mencapai jangkaan

- Bing Microsoft mengatasi Google dalam trafik carian terima kasih kepada teknologi OpenAI