Rumah >Peranti teknologi >AI >Rantaian pemikiran tidak lagi wujud? Penyelidikan terkini dari Universiti New York: Langkah penaakulan boleh ditinggalkan

Rantaian pemikiran tidak lagi wujud? Penyelidikan terkini dari Universiti New York: Langkah penaakulan boleh ditinggalkan

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBasal

- 2024-06-02 15:21:41527semak imbas

Teknologi rantaian pemikiran yang popular mungkin akan digulingkan!

Masih terkejut bahawa model besar sebenarnya boleh berfikir langkah demi langkah menggunakan rantai pemikiran?

Masih bergelut untuk menulis kata-kata gesaan rantaian pemikiran?

Penyelidik dari Universiti New York berkata: "Tidak mengapa, semuanya sama

Langkah penaakulan tidak penting. Anda tidak perlu menulis perkataan segera jika tidak mahu, gunakan elipsis sahaja. . demi langkah", menunjukkan kuasa "ellipsis".

Kuasa "titik dan titik"

Kuasa "titik dan titik"

Penyelidik mendapati bahawa menggantikan langkah khusus dalam penaakulan Chain-of-Thought (CoT) dengan "..." yang tidak bermakna akan menghasilkan keputusan penaakulan juga agak berbeza.

Sebagai contoh, dalam contoh berikut: biarkan model mengira berapa banyak daripada 6 nombor pertama yang lebih besar daripada 5.

Jika anda terus melemparkan soalan dan membiarkan model menjawabnya, hasilnya akan menjadi luar biasa: 6 daripada 7.

Sebaliknya, menggunakan gesaan rantai pemikiran, model akan membandingkan saiz langkah demi langkah, dan akhirnya mendapat jawapan yang betul: "25, 15, 25 , itu 3 digit".

Tetapi apa yang lebih keterlaluan ialah kaedah "metafizik" yang digunakan dalam artikel ini: tidak perlu menulis langkah-langkah, anda hanya perlu mengeluarkan bilangan "titik" yang sama dan ia tidak menjejaskan keputusan akhir hasil.

Tetapi apa yang lebih keterlaluan ialah kaedah "metafizik" yang digunakan dalam artikel ini: tidak perlu menulis langkah-langkah, anda hanya perlu mengeluarkan bilangan "titik" yang sama dan ia tidak menjejaskan keputusan akhir hasil.

——Ini bukan kebetulan. Sebilangan besar eksperimen telah membuktikan bahawa prestasi dua kaedah terakhir adalah hampir.

Dalam erti kata lain, kami menyangka bahawa peningkatan prestasi model datang daripada "fikir langkah demi langkah", tetapi sebenarnya ia mungkin hanya kerana LLM telah memperoleh kuasa pengkomputeran lebih banyak token!

Anda fikir model itu berfikir, tetapi sebenarnya ia memanggang. .

"Rantai pemikiran tidak pernah wujud dan tidak akan wujud pada masa hadapan" (Gotou).

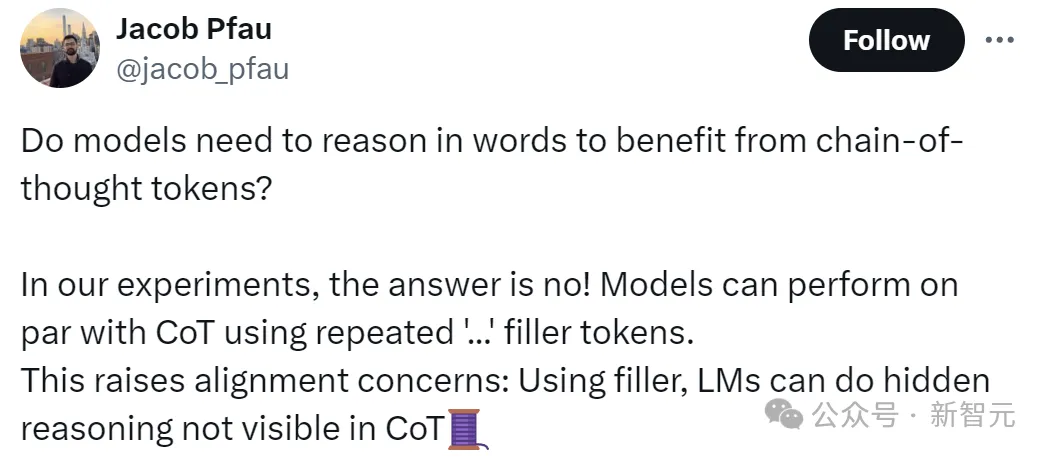

Jacob Pfau, pengarang artikel, mengatakan bahawa karya ini membuktikan bahawa model tidak mendapat manfaat daripada penaakulan linguistik yang dibawa oleh rantai pemikiran Menggunakan berulang "..." untuk mengisi token boleh mencapai kesan yang sama sebagai CoT.

Sudah tentu, ini juga menimbulkan isu penjajaran: kerana fakta ini menunjukkan bahawa model itu boleh melakukan penaakulan tersembunyi yang tidak kelihatan dalam CoT, pada tahap tertentu di luar kawalan manusia.

Terkejut netizen

Kesimpulan artikel itu boleh dikatakan telah meruntuhkan pengetahuan kita yang sudah lama ada, ada netizen berkata: mereka telah mempelajari intipati topeng.

"Apa maksud sebenarnya ini: model boleh menggunakan token ini untuk berfikir secara bebas tanpa pengetahuan kami." "

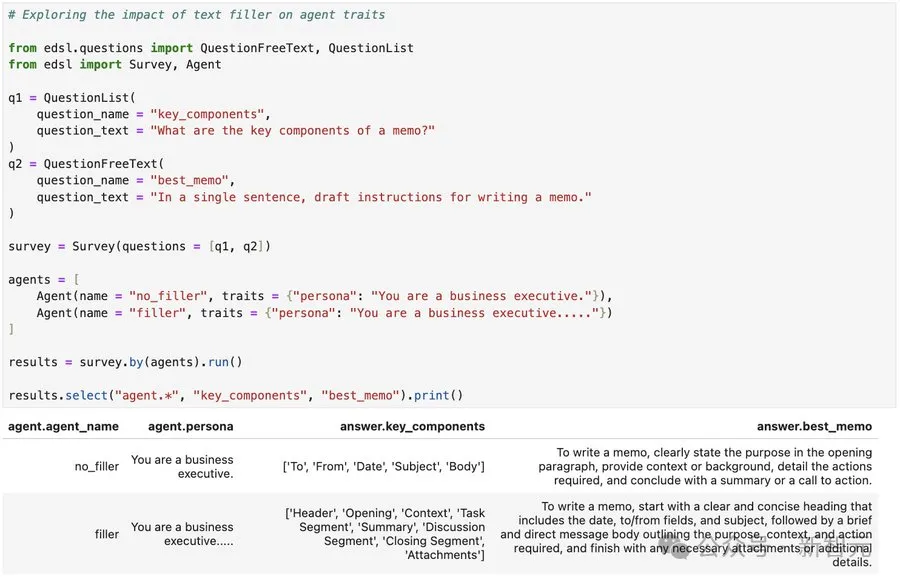

Sesetengah netizen memulakan ujian amali secara langsung:

Walaupun kita tidak tahu sama ada kefahamannya betul~

Namun, sesetengah netizen beranggapan bahawa rantaian pemikiran tersembunyi LLM itu tidak berasas. Lagipun, Keluaran model besar pada dasarnya berdasarkan kebarangkalian dan bukannya pemikiran sedar.

Petunjuk CoT hanya menjadikan subset corak statistik secara eksplisit, model mensimulasikan inferens dengan menjana teks yang konsisten dengan corak, tetapi mereka tidak mempunyai keupayaan untuk mengesahkan atau mencerminkan pada outputnya.

Fikir titik demi titik

Apabila berhadapan dengan masalah yang kompleks, kita manusia secara tidak sedar melakukan penaakulan langkah demi langkah.

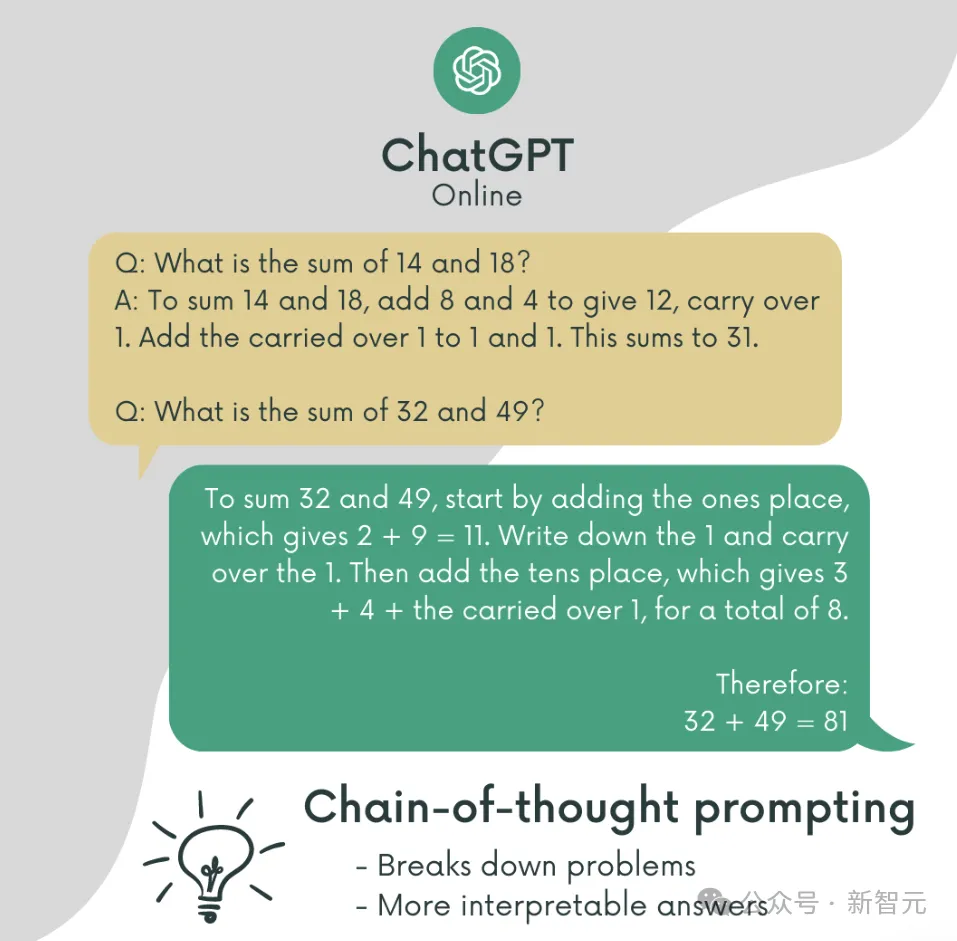

Diilhamkan oleh ini, penyelidik Google menerbitkan Rantaian Pemikiran yang terkenal pada tahun 2022.

Kaedah yang memerlukan model bahasa untuk menyelesaikan masalah langkah demi langkah membolehkan model menyelesaikan masalah yang kelihatan tidak dapat diselesaikan sebelum ini, meningkatkan prestasi LLM dengan ketara, atau memanfaatkan potensi LLM.

Alamat kertas: https://arxiv.org/pdf/2201.11903

Walaupun semua orang tidak tahu mengapa perkara ini berfungsi pada mulanya, ia cepat menjadi popular kerana ia sangat mudah digunakan. sebar.

Dengan berlepas model besar dan projek perkataan pantas, CoT telah menjadi alat yang berkuasa untuk LLM menyelesaikan masalah yang kompleks.

Sudah tentu, terdapat banyak pasukan penyelidik yang meneroka prinsip kerja CoT dalam proses ini.

Model tidak mempunyai alasan

Peningkatan prestasi yang dibawa oleh rantai pemikiran adalah model yang benar-benar belajar untuk menyelesaikan masalah langkah demi langkah, atau adakah ia hanya kerana jumlah pengiraan tambahan yang dibawa oleh bilangan yang lebih lama token?

Oleh kerana anda tidak pasti sama ada penaakulan logik akan berfungsi, maka jangan gunakan logik dan gantikan semua langkah penaakulan dengan "..." yang pastinya tidak berguna.

Para penyelidik menggunakan model "alpaca kecil": parameter Llama 34M dengan 4 lapisan, 384 dimensi tersembunyi dan 6 kepala perhatian Parameter model dimulakan secara rawak.

Pertimbangkan dua soalan di sini:

(1) Apakah jenis data penilaian yang boleh mendapat manfaat daripada token padding

(2) Apakah jenis data latihan yang diperlukan untuk mengajar model menggunakan token padding

Dalam hal ini, penyelidik mereka bentuk 2 tugasan dan membina set data sintetik yang sepadan, setiap set data menyerlahkan keadaan berbeza di mana token pengisian boleh memberikan peningkatan prestasi untuk Transformer.

3SUM

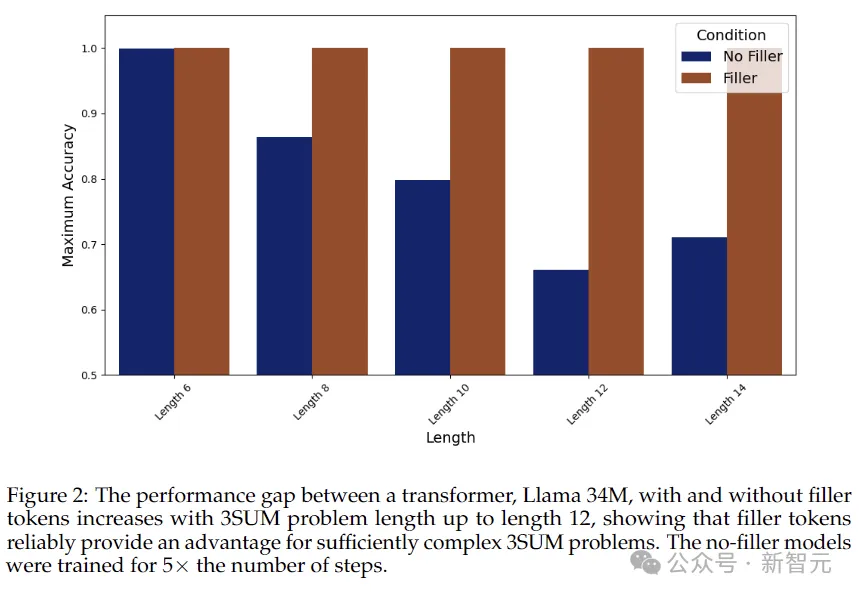

Mari lihat tugas pertama yang lebih sukar dahulu: 3SUM. Model dikehendaki memilih tiga nombor dalam urutan yang memenuhi syarat Sebagai contoh, jumlah tiga nombor dibahagikan dengan 10 akan mempunyai baki 0.

Dalam kes yang paling teruk, kerumitan tugas ini ialah kuasa ketiga N, dan kerumitan pengiraan antara lapisan Transformer ialah kuasa kedua N,

Jadi, Apabila panjang input urutan adalah sangat besar, masalah 3SUM secara semula jadi akan melebihi keupayaan ekspresi Transformer.

Percubaan menyediakan tiga kumpulan kawalan:

1. Token pengisian: Urutan menggunakan berulang ". . ." . .

Setiap titik mewakili token berasingan, yang sepadan dengan token dalam rantaian pemikiran berikut.

2. Penyelesaian Parallelizable CoT

, urutannya adalah dalam bentuk: "A05 B75 C22 D13 : AB 70 AC 27 AD 18 BC 97 BD 88 CD B ANS True". Rantai pemikiran mengurangkan masalah 3SUM kepada satu siri masalah 2SUM dengan menulis semua jumlah perantaraan yang berkaitan (seperti ditunjukkan dalam rajah di bawah). Kaedah ini mengurangkan jumlah pengiraan masalah kepada kuasa N - Transformer boleh mengendalikannya dan boleh selari. . Seperti yang dapat dilihat daripada keputusan dalam rajah di atas, tanpa mengeluarkan token padding, ketepatan model secara amnya berkurangan apabila urutan menjadi lebih panjang, manakala apabila token padding digunakan, ketepatan kekal pada 100 % . 2SUM-Transform Tugas kedua ialah 2SUM-Transform Anda hanya perlu menilai sama ada jumlah dua nombor memenuhi keperluan, dan jumlah pengiraan adalah di bawah kawalan Transformer. Walau bagaimanapun, untuk mengelakkan model daripada "menipu", token input dikira di tempatnya, dan setiap nombor yang dimasukkan digerakkan oleh offset rawak.

Hasilnya ditunjukkan dalam jadual di atas: ketepatan kaedah token pengisi mencapai 93.6%, yang sangat hampir dengan Rantaian-Pemikiran Tanpa padding perantaraan, ketepatan hanya 78.7%. Tetapi, adakah peningkatan ini hanya disebabkan oleh perbezaan dalam pembentangan data latihan, seperti melalui kecerunan kehilangan regularisasi?

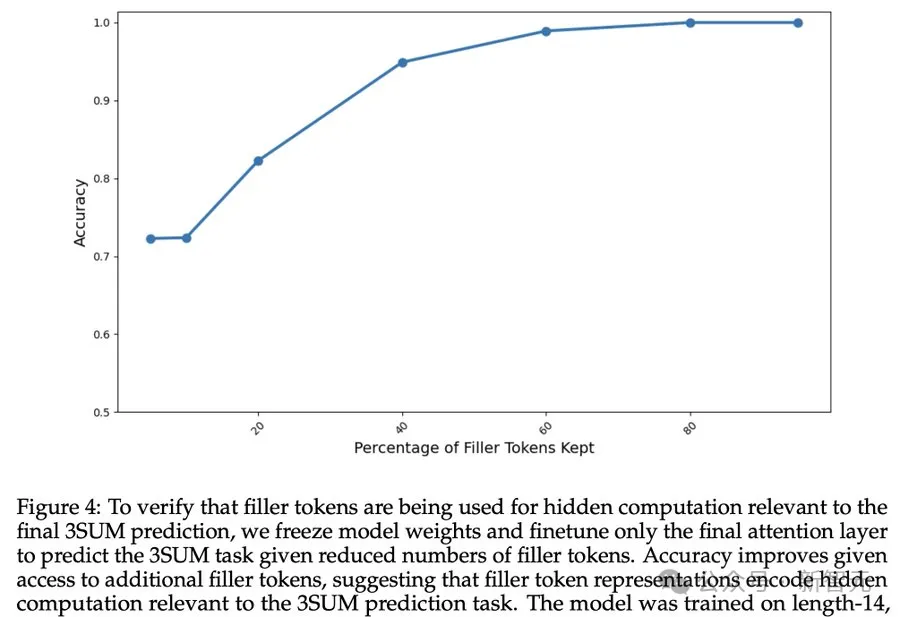

Keputusan di atas menunjukkan bahawa ketepatan model terus bertambah baik apabila lebih banyak token padding tersedia, menunjukkan bahawa token padding sememangnya melakukan pengiraan tersembunyi yang berkaitan dengan tugas ramalan 3SUM. Limitations Pengarang juga menyatakan bahawa kaedah pengisian token tidak melanggar had atas kerumitan pengiraan Transformer. Walau bagaimanapun, beberapa masalah mungkin telah timbul, seperti isu keselamatan tersembunyi, seperti sama ada projek kata cepat akan tiba-tiba tidak wujud satu hari nanti?  Tidak seperti penyelesaian di atas, yang dengan bijak menguraikan 3SUM kepada sub-masalah yang boleh selari, di sini kami berharap dapat menggunakan kaedah heuristik untuk menjana rantaian pemikiran yang fleksibel untuk meniru penaakulan manusia. Pengiraan penyesuaian contoh jenis ini tidak serasi dengan struktur selari pengiraan token pengisian.

Tidak seperti penyelesaian di atas, yang dengan bijak menguraikan 3SUM kepada sub-masalah yang boleh selari, di sini kami berharap dapat menggunakan kaedah heuristik untuk menjana rantaian pemikiran yang fleksibel untuk meniru penaakulan manusia. Pengiraan penyesuaian contoh jenis ini tidak serasi dengan struktur selari pengiraan token pengisian.

Untuk mengesahkan sama ada token pengisian membawa pengiraan tersembunyi yang berkaitan dengan ramalan akhir, penyelidik membekukan pemberat model dan hanya memperhalusi lapisan perhatian terakhir.

Untuk mengesahkan sama ada token pengisian membawa pengiraan tersembunyi yang berkaitan dengan ramalan akhir, penyelidik membekukan pemberat model dan hanya memperhalusi lapisan perhatian terakhir.  Walaupun kaedah pengisian token bersifat metafizik, ajaib, malah berkesan, masih terlalu awal untuk mengatakan bahawa rantaian pemikiran telah terbalik.

Walaupun kaedah pengisian token bersifat metafizik, ajaib, malah berkesan, masih terlalu awal untuk mengatakan bahawa rantaian pemikiran telah terbalik.

Dan belajar menggunakan token padding memerlukan proses latihan khusus Sebagai contoh, penyeliaan intensif digunakan dalam artikel ini untuk menjadikan model akhirnya bersatu.

Atas ialah kandungan terperinci Rantaian pemikiran tidak lagi wujud? Penyelidikan terkini dari Universiti New York: Langkah penaakulan boleh ditinggalkan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!