올해는 총 5개의 우수논문상과 11개의 우수가작이 선정되었습니다.

ICLR은 International Conference on Learning Representation의 약자로 올해로 12회째를 맞이하는 컨퍼런스로 오스트리아 비엔나에서 5월 7일부터 11일까지 개최됩니다.

머신러닝 커뮤니티에서 ICLR은 딥러닝 분야의 거물이자 Turing Award 수상자인 Yoshua Bengio와 Yann LeCun이 주최하는 비교적 "젊은" 최고 학술 컨퍼런스입니다. 2013년에 막 첫 번째 세션이 열렸습니다. 그러나 ICLR은 학계 연구자들로부터 빠르게 폭넓은 인정을 받았으며 딥러닝 분야 최고의 학술 컨퍼런스로 간주됩니다.

이번 컨퍼런스에는 총 7262편의 논문이 접수되었고, 2260편의 논문이 접수되었으며 전체 합격률은 약 31%로, 작년(31.8%)과 동일했습니다. 또한 Spotlights 논문의 비율은 5%, Oral 논문의 비율은 1.2%입니다.

전년도에 비해 참가자 수나 논문 투고 수에서 ICLR의 인기가 크게 높아졌다고 할 수 있습니다. R 이전 ICLR 논문 자료에 대하여

5개 우수 논문상

우수 논문 수상자

논문: 확산 모델의 일반화는 기하학 적응 조화 표현에서 발생합니다.

논문 주소: https://openreview.net / pdf?id=ANvmVS2Yr0

- 저자: Zahra Kadkhodaie, Florentin Guth, Eero P. Simoncelli, Stéphane Mallat

- 이 문서에서는 이미지 확산 모델을 일반화하고 중요 기억에 대한 심층 분석. 저자는 이미지 생성 모델이 메모리 입력에서 일반화 모드로 전환될 때 실증적으로 연구하고 이를 기하학적 적응 조화 표현을 통한 조화 분석 아이디어와 연결하고, 이 현상을 건축적 귀납 편향의 관점에서 더 설명합니다. 이 논문은 시각의 생성 모델에 대한 우리의 이해에서 누락된 핵심 부분을 다루며 향후 연구에 큰 영향을 미칩니다.

논문: 학습 대화형 실제 세계 시뮬레이터

논문 주소: https://openreview.net/forum?id=sFyTZEqmUY

- 저자: Sherry Yang, Yilun Du, Kamyar Ghasemipour, Jonathan Tompson, Leslie Kaelbling, Dale Schuurmans, Pieter Abbeel

- 로봇의 기본 모델을 교육하기 위해 여러 소스에서 데이터를 집계하는 것은 장기적인 작업입니다. 목표. 서로 다른 로봇은 서로 다른 감각운동 인터페이스를 가지고 있기 때문에 이는 대규모 데이터 세트에 대한 훈련에 상당한 어려움을 안겨줍니다.

-

UniSim

은 시각적 인식 및 제어에 대한 텍스트 설명을 기반으로 하는 통합 인터페이스를 활용하여 데이터를 집계하고 비전 및 언어의 최신 발전을 활용하는 이러한 방향의 중요한 단계이자 엔지니어링 업적입니다. .

아래 그림 3에서 볼 수 있듯이 UniSim은 주방 장면에서 손 씻기, 그릇 가져오기, 당근 자르기, 손 말리기 등 다양한 동작을 시뮬레이션할 수 있습니다. 그림 3은 두 가지 탐색 장면을 보여줍니다. ㅋㅋㅋ > 그림 3의 오른쪽 하단에 있는 탐색 장면

논제: 처음부터 훈련하지 마세요: 긴 시퀀스 모델의 공정한 비교에는 데이터 기반 사전 변수가 필요합니다

기관: Tel Aviv University, IBM

작성자: Ido Amos, Jonathan Berant, Ankit Gupta

이 문서에서는 장기 시퀀스 종속성을 모델링하기 위해 최근 제안된 상태 공간 모델 및 변환기 아키텍처.

이 문서에서는 장기 시퀀스 종속성을 모델링하기 위해 최근 제안된 상태 공간 모델 및 변환기 아키텍처.

- 놀랍게도 저자는 변환기 모델을 처음부터 훈련하면 성능이 과소평가되고 사전 훈련 및 미세 조정 설정을 통해 상당한 성능 향상을 달성할 수 있다는 사실을 발견했습니다. 이 논문은 단순성과 체계적인 통찰력에 중점을 두는 점에서 탁월합니다.

- 논문: 개별 걷기-점프 샘플링을 통한 단백질 발견

- 논문 주소: https://openreview.net/forum?id=zMPHKOmQNb

저자: Nathan C. Frey, Dan Berenberg, Karina Zadorozhny, Joseph Kleinhenz, Julien Lafrance-Vanasse, Isidro Hotzel, Yan Wu, Stephen Ra, Richard Bonneau, 조경현, Andreas Loukas, Vladimir Gligorijevic, Saeed Saremi

이 논문은 단백질 서열 생성 모델의 시의적절하고 중요한 적용인 서열 기반 항체 설계의 문제를 다루고 있습니다.

이 논문은 단백질 서열 생성 모델의 시의적절하고 중요한 적용인 서열 기반 항체 설계의 문제를 다루고 있습니다.

- 이를 위해 저자는 특히 개별 단백질 서열 데이터 처리 문제를 겨냥한 혁신적이고 효과적인 새로운 모델링 방법을 소개합니다. In silico 방법을 검증하는 것 외에도 저자는 시험관 내 항체 결합 친화도를 측정하기 위해 광범위한 습식 실험실 실험을 수행하여 생성된 방법의 효율성을 입증했습니다.

- 논문: Vision Transformers Need Registers

- 논문 주소: https://openreview.net/forum?id=2dnO3LLiJ1

저자: Timoth 에 다르세 t. Maxime Oquab, Julien Mairal, Piotr Bojanowski

이 문서는 낮은 정보 배경 영역에서 높은 표준 토큰을 특징으로 하는 비전 변환기 네트워크의 기능 맵에서 아티팩트를 식별합니다.

이 문서는 낮은 정보 배경 영역에서 높은 표준 토큰을 특징으로 하는 비전 변환기 네트워크의 기능 맵에서 아티팩트를 식별합니다.

- 저자는 이 현상이 어떻게 발생하는지에 대한 주요 가설을 제안하고 이러한 추적을 해결하기 위해 추가 등록 토큰을 사용하는 간단하면서도 우아한 솔루션을 제공함으로써 다양한 작업에서 모델의 성능을 향상시킵니다. 이 작업을 통해 얻은 통찰력은 다른 응용 분야에도 영향을 미칠 수 있습니다.

이 논문은 훌륭하게 작성되었으며 연구 수행의 좋은 예를 제공합니다. "문제를 식별하고, 문제가 발생하는 이유를 이해한 다음 해결책을 제안합니다."

- 11개의 우수 가작 5개의 뛰어난 논문 논문, ICLR 2024에서는 또한 11개의 Honorable Mentions을 선정했습니다.

- 논문: 대규모 언어 모델에서 다루기 힘든 추론을 상각

기관: 몬트리올 대학교, 옥스퍼드 대학교

저자: Edward J Hu, Moksh Jain, Eric Elmoznino, Younesse Kaddar, Guillaume Lajoie, Yoshua Bengio , Nikolay Malkin

논문 주소: https://openreview.net/forum?id=Ouj6p4ca60

이 논문은 베이지안 추론의 관점에서 대규모 언어 모델의 자동 회귀 디코딩에 대한 대안을 제안합니다. 후속 연구에 영감을 줄 수 있습니다.

- Paper : 확률 론적 최적화를 통한 정상 형식 게임에서 내쉬 평형을 근사화 : DeepMind

- Author : Ian Gemp, Luke Marris, Georgios Piliouras

- paper 주소 : https : // Open review .net/forum?id=cc8h3I3V4E

논문: Beyond Weisfeiler-Lehman: A Quantitative Framework for GNN Expressiveness

기관: Peking University, Beijing Zhiyuan Artificial Intelligence Research Institute

저자: Zhang Bohang Gai Jingchu Du Yiheng Ye Qiwei Hedi Wang Liwei

논문 주소: https://openreview.net/forum?id=HSKaGOi7Ar

GNN의 표현 능력은 중요한 주제이며, 현재 솔루션에는 여전히 큰 한계가 있습니다. 저자는 동형 계산에 기반한 새로운 표현성 이론을 제안합니다.

Paper: Flow Matching on General Geometries

기관: Meta

저자: Ricky T. Q. Chen, Yaron Lipman

논문 주소: https://openreview.net/forum?id=g7ohDlTITL

이 논문은 일반 기하 다양체에 대한 생성 모델링의 까다롭지만 중요한 문제를 탐구하고 실용적이고 효율적인 알고리즘을 제안합니다. 이 논문은 훌륭하게 제시되었으며 다양한 작업에 대해 완전히 실험적으로 검증되었습니다.

Paper: ImageNet이 1개의 비디오에 가치가 있나요? 1개의 긴 라벨이 없는 비디오에서 강력한 이미지 인코더를 학습하세요

기관: University of Central Florida, Google DeepMind, University of Amsterdam 등

저자: Shashanka Venkataramanan, Mamshad Nayeem Rizve, Joao Carreira, Yuki M Asano, Yannis Avrithis

논문 주소: https://openreview.net/forum?id=Yen1lGns2o

본 논문은 새로운 자기 지도 영상 사전 훈련 방법을 제안합니다. 즉, 연속 비디오를 통해 학습하여 학습합니다. 이 논문은 새로운 유형의 데이터와 새로운 데이터로부터 학습하는 방법을 모두 제공합니다.

논문: Meta Continual Learning Revisited: Implicitly Enhancing Online Hessian Approximation via Variance Reduction

기관: City University of Hong Kong, Tencent AI Lab, Xi'an Jiaotong University 등

저자: Yichen Wu, Long-Kai Huang, Renzhen Wang, Deyu Meng, and Ying Wei

논문 주소: https://openreview.net/forum?id=TpD2aG1h0D

저자는 새로운 메타 연속 학습 분산을 제안했습니다. 감소 방법. 이 방법은 효과적이며 실질적인 영향을 미칠 뿐만 아니라 후회 분석에서도 뒷받침됩니다.

논문: 모델이 알려 주는 폐기 항목: LLM용 적응형 KV 캐시 압축

기관: University of Illinois at Urbana-Champaign, Microsoft

저자: Suyu Ge, Yunan Zhang, Liyuan Liu, Minjia Zhang, Jiawei Han, Jianfeng Gao

논문 주소: https://openreview.net/forum?id=uNrFpDPMyo

이 기사는 KV 캐시 압축 문제에 중점을 둡니다(이 문제는 Transformer에 큰 영향을 미칩니다. based LLM)은 메모리를 줄이고 비용이 많이 드는 미세 조정이나 재교육 없이 배포할 수 있는 간단한 아이디어를 가지고 있습니다. 이 방법은 매우 간단하며 매우 효과적인 것으로 입증되었습니다.

논문: 블랙박스 언어 모델의 테스트 세트 오염 증명

기관: Stanford University, Columbia University

-

저자: Yonatan Oren, Nicole Meister, Niladri S. Chatterji, Faisal Ladhak, Tatsunori Hashimoto

논문 주소: https://openreview.net/forum?id=KS8mIvetg2

이 논문은 지도 학습 데이터 세트가 훈련의 대규모 언어 모델에 포함되었는지 테스트하기 위해 간단하고 우아한 방법을 사용합니다.

논문: 강력한 에이전트 학습 인과 세계 모델

기관: Google DeepMind

저자: Jonathan Richens, Tom Everitt

논문 주소: https://openreview.net/forum?id= pOoKI3ouv1

이 논문은 다양한 관련 분야에 대한 시사점과 함께 에이전트의 새로운 영역으로 일반화하는 능력에서 인과 추론의 역할을 이해하기 위한 이론적 토대를 마련하는 데 큰 진전을 이루었습니다.

논문: 상황 내 분류 작업에서 데이터 의존성과 갑작스러운 학습의 기계적 기초

기관: 프린스턴 대학교, 하버드 대학교 등

저자: Gautam Reddy

논문 주소 : https://openreview.net/forum?id=aN4Jf6Cx69

이것은 우리가 이러한 현상을 이해하기 시작하면서 상황 내 학습과 가중치 내 학습 사이의 관계를 탐구하는 시의적절하고 매우 체계적인 연구입니다.

논문: 약한 감독 하에서 데이터 선택의 통계적 이론을 향하여

기관: Granica Computing

저자: Germain Kolossov, Andrea Montanari, Pulkit Tandon

논문 주소: https://openreview .net/forum?id=HhfcNgQn6p

이 문서는 데이터 하위 집합 선택을 위한 통계적 기초를 확립하고 널리 사용되는 데이터 선택 방법의 단점을 식별합니다.

참조링크: https://blog.iclr.cc/2024/05/06/iclr-2024-outstanding-paper-awards/

위 내용은 7262편의 논문이 제출되어 ICLR 2024가 히트를 쳤고, 국내 논문 2편이 우수논문 후보로 지명됐다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

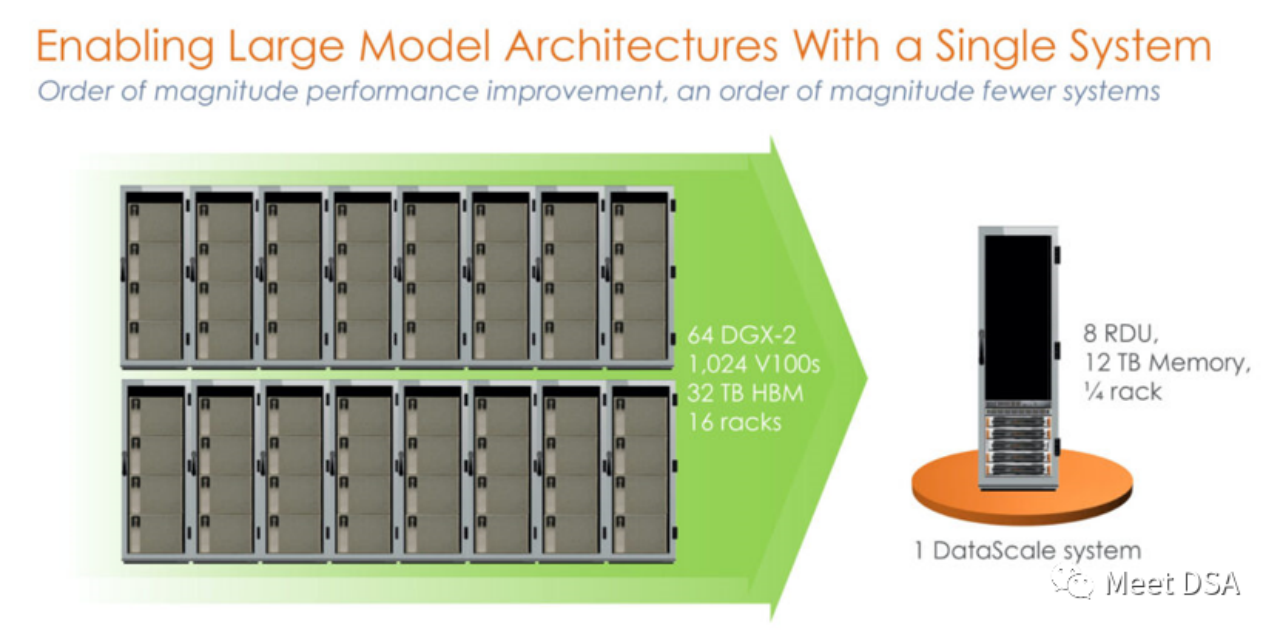

DSA如何弯道超车NVIDIA GPU?Sep 20, 2023 pm 06:09 PM

DSA如何弯道超车NVIDIA GPU?Sep 20, 2023 pm 06:09 PM你可能听过以下犀利的观点:1.跟着NVIDIA的技术路线,可能永远也追不上NVIDIA的脚步。2.DSA或许有机会追赶上NVIDIA,但目前的状况是DSA濒临消亡,看不到任何希望另一方面,我们都知道现在大模型正处于风口位置,业界很多人想做大模型芯片,也有很多人想投大模型芯片。但是,大模型芯片的设计关键在哪,大带宽大内存的重要性好像大家都知道,但做出来的芯片跟NVIDIA相比,又有何不同?带着问题,本文尝试给大家一点启发。纯粹以观点为主的文章往往显得形式主义,我们可以通过一个架构的例子来说明Sam

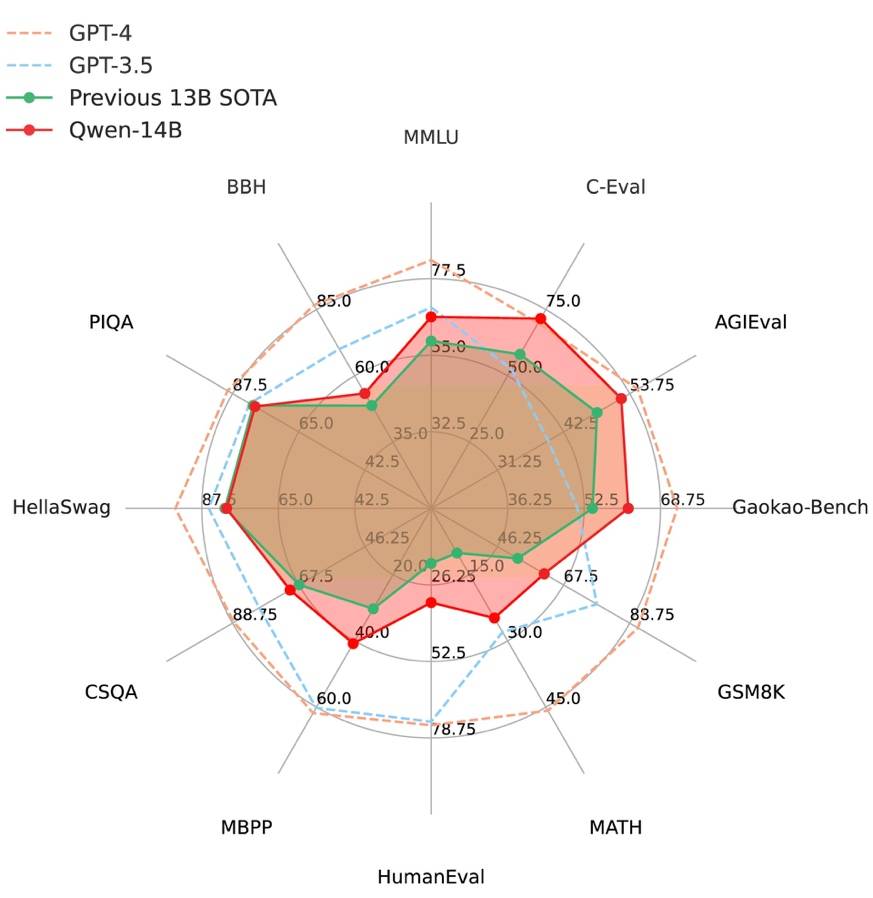

阿里云通义千问14B模型开源!性能超越Llama2等同等尺寸模型Sep 25, 2023 pm 10:25 PM

阿里云通义千问14B模型开源!性能超越Llama2等同等尺寸模型Sep 25, 2023 pm 10:25 PM2021年9月25日,阿里云发布了开源项目通义千问140亿参数模型Qwen-14B以及其对话模型Qwen-14B-Chat,并且可以免费商用。Qwen-14B在多个权威评测中表现出色,超过了同等规模的模型,甚至有些指标接近Llama2-70B。此前,阿里云还开源了70亿参数模型Qwen-7B,仅一个多月的时间下载量就突破了100万,成为开源社区的热门项目Qwen-14B是一款支持多种语言的高性能开源模型,相比同类模型使用了更多的高质量数据,整体训练数据超过3万亿Token,使得模型具备更强大的推

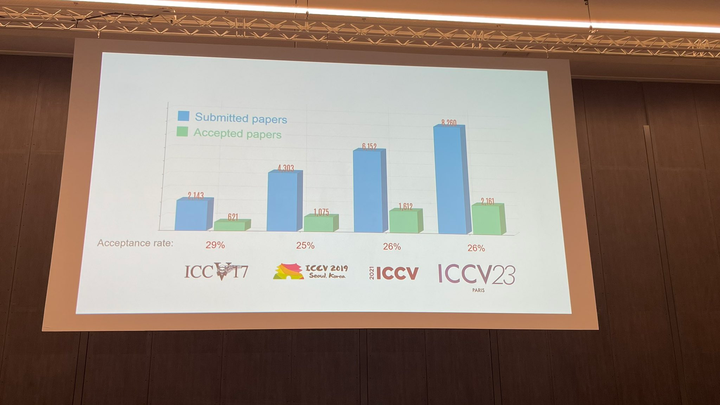

ICCV 2023揭晓:ControlNet、SAM等热门论文斩获奖项Oct 04, 2023 pm 09:37 PM

ICCV 2023揭晓:ControlNet、SAM等热门论文斩获奖项Oct 04, 2023 pm 09:37 PM在法国巴黎举行了国际计算机视觉大会ICCV(InternationalConferenceonComputerVision)本周开幕作为全球计算机视觉领域顶级的学术会议,ICCV每两年召开一次。ICCV的热度一直以来都与CVPR不相上下,屡创新高在今天的开幕式上,ICCV官方公布了今年的论文数据:本届ICCV共有8068篇投稿,其中有2160篇被接收,录用率为26.8%,略高于上一届ICCV2021的录用率25.9%在论文主题方面,官方也公布了相关数据:多视角和传感器的3D技术热度最高在今天的开

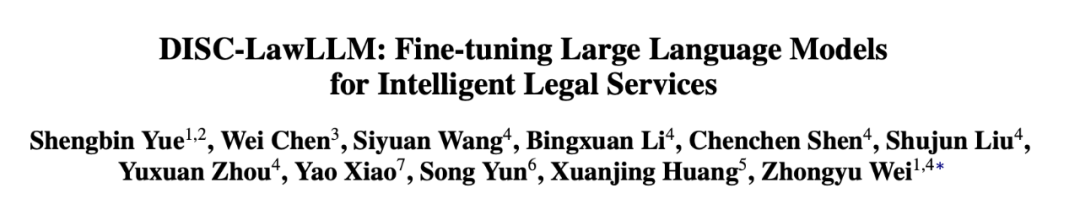

复旦大学团队发布中文智慧法律系统DISC-LawLLM,构建司法评测基准,开源30万微调数据Sep 29, 2023 pm 01:17 PM

复旦大学团队发布中文智慧法律系统DISC-LawLLM,构建司法评测基准,开源30万微调数据Sep 29, 2023 pm 01:17 PM随着智慧司法的兴起,智能化方法驱动的智能法律系统有望惠及不同群体。例如,为法律专业人员减轻文书工作,为普通民众提供法律咨询服务,为法学学生提供学习和考试辅导。由于法律知识的独特性和司法任务的多样性,此前的智慧司法研究方面主要着眼于为特定任务设计自动化算法,难以满足对司法领域提供支撑性服务的需求,离应用落地有不小的距离。而大型语言模型(LLMs)在不同的传统任务上展示出强大的能力,为智能法律系统的进一步发展带来希望。近日,复旦大学数据智能与社会计算实验室(FudanDISC)发布大语言模型驱动的中

百度文心一言全面向全社会开放,率先迈出重要一步Aug 31, 2023 pm 01:33 PM

百度文心一言全面向全社会开放,率先迈出重要一步Aug 31, 2023 pm 01:33 PM8月31日,文心一言首次向全社会全面开放。用户可以在应用商店下载“文心一言APP”或登录“文心一言官网”(https://yiyan.baidu.com)进行体验据报道,百度计划推出一系列经过全新重构的AI原生应用,以便让用户充分体验生成式AI的理解、生成、逻辑和记忆等四大核心能力今年3月16日,文心一言开启邀测。作为全球大厂中首个发布的生成式AI产品,文心一言的基础模型文心大模型早在2019年就在国内率先发布,近期升级的文心大模型3.5也持续在十余个国内外权威测评中位居第一。李彦宏表示,当文心

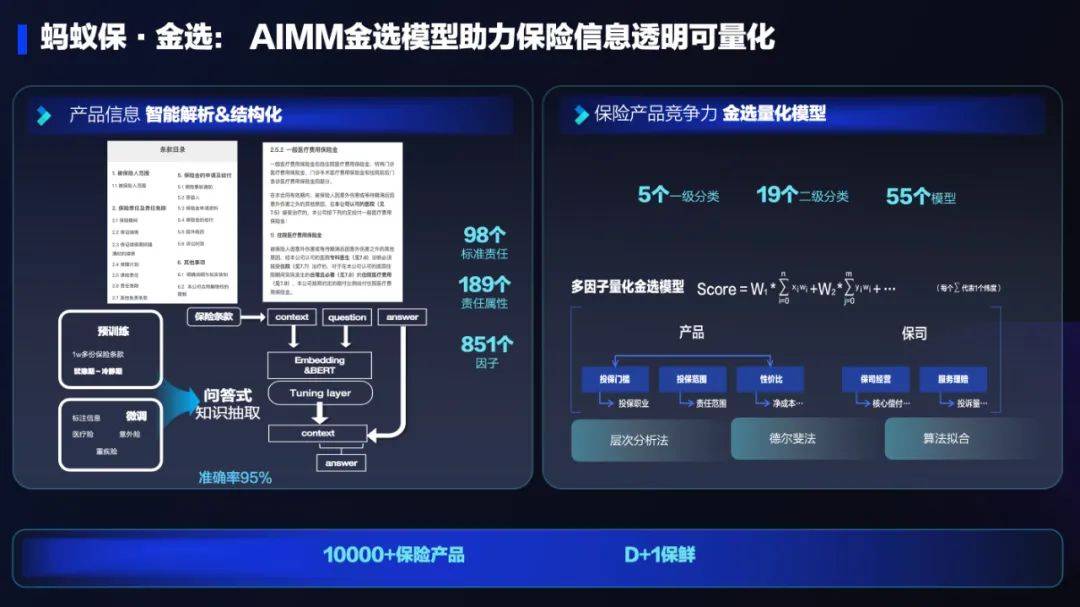

AI技术在蚂蚁集团保险业务中的应用:革新保险服务,带来全新体验Sep 20, 2023 pm 10:45 PM

AI技术在蚂蚁集团保险业务中的应用:革新保险服务,带来全新体验Sep 20, 2023 pm 10:45 PM保险行业对于社会民生和国民经济的重要性不言而喻。作为风险管理工具,保险为人民群众提供保障和福利,推动经济的稳定和可持续发展。在新的时代背景下,保险行业面临着新的机遇和挑战,需要不断创新和转型,以适应社会需求的变化和经济结构的调整近年来,中国的保险科技蓬勃发展。通过创新的商业模式和先进的技术手段,积极推动保险行业实现数字化和智能化转型。保险科技的目标是提升保险服务的便利性、个性化和智能化水平,以前所未有的速度改变传统保险业的面貌。这一发展趋势为保险行业注入了新的活力,使保险产品更贴近人民群众的实际

致敬TempleOS,有开发者创建了启动Llama 2的操作系统,网友:8G内存老电脑就能跑Oct 07, 2023 pm 10:09 PM

致敬TempleOS,有开发者创建了启动Llama 2的操作系统,网友:8G内存老电脑就能跑Oct 07, 2023 pm 10:09 PM不得不说,Llama2的「二创」项目越来越硬核、有趣了。自Meta发布开源大模型Llama2以来,围绕着该模型的「二创」项目便多了起来。此前7月,特斯拉前AI总监、重回OpenAI的AndrejKarpathy利用周末时间,做了一个关于Llama2的有趣项目llama2.c,让用户在PyTorch中训练一个babyLlama2模型,然后使用近500行纯C、无任何依赖性的文件进行推理。今天,在Karpathyllama2.c项目的基础上,又有开发者创建了一个启动Llama2的演示操作系统,以及一个

腾讯与中国宋庆龄基金会发布“AI编程第一课”,教育部等四部门联合推荐Sep 16, 2023 am 09:29 AM

腾讯与中国宋庆龄基金会发布“AI编程第一课”,教育部等四部门联合推荐Sep 16, 2023 am 09:29 AM腾讯与中国宋庆龄基金会合作,于9月1日发布了名为“AI编程第一课”的公益项目。该项目旨在为全国零基础的青少年提供AI和编程启蒙平台。只需在微信中搜索“腾讯AI编程第一课”,即可通过官方小程序免费体验该项目由北京师范大学任学术指导单位,邀请全球顶尖高校专家联合参研。“AI编程第一课”首批上线内容结合中国航天、未来交通两项国家重大科技议题,原创趣味探索故事,通过剧本式、“玩中学”的方式,让青少年在1小时的学习实践中认识A

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

MinGW - Windows용 미니멀리스트 GNU

이 프로젝트는 osdn.net/projects/mingw로 마이그레이션되는 중입니다. 계속해서 그곳에서 우리를 팔로우할 수 있습니다. MinGW: GCC(GNU Compiler Collection)의 기본 Windows 포트로, 기본 Windows 애플리케이션을 구축하기 위한 무료 배포 가능 가져오기 라이브러리 및 헤더 파일로 C99 기능을 지원하는 MSVC 런타임에 대한 확장이 포함되어 있습니다. 모든 MinGW 소프트웨어는 64비트 Windows 플랫폼에서 실행될 수 있습니다.

Atom Editor Mac 버전 다운로드

가장 인기 있는 오픈 소스 편집기

드림위버 CS6

시각적 웹 개발 도구

VSCode Windows 64비트 다운로드

Microsoft에서 출시한 강력한 무료 IDE 편집기