Alibaba Cloud는 사진과 오디오를 사용하여 노래하는 비디오를 생성하는 Tongyi App에서 자체 개발한 EMO 모델 출시를 발표했습니다.

- 王林앞으로

- 2024-04-26 08:00:381126검색

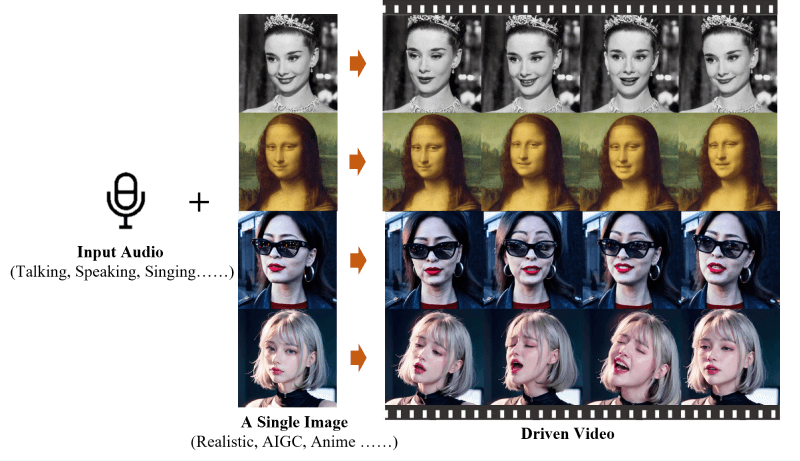

"4월 25일자 이 사이트의 소식에 따르면 EMO(Emote Portrait Alive)는 알리바바 그룹 지능형 컴퓨팅 연구소에서 개발한 프레임워크로 단일 참조 이미지와 음성 오디오를 입력할 수 있는 오디오 기반 AI 인물 영상 생성 시스템입니다.

알리바바 클라우드는 연구소를 통해 개발한 AI 모델인 EMO가 일반 앱에 정식 출시돼 모든 사용자에게 무료로 공개됐다고 오늘 밝혔다. 이 기능을 통해 사용자는 노래, 인기 밈, 이모티콘 중에서 템플릿을 선택한 다음 인물 사진을 업로드하여 EMO가 노래하는 비디오를 합성할 수 있습니다.

소개에 따르면 Tongyi App은 인기곡 "Shangchunshan", "Wild Wolf Disco" 등은 물론 인터넷 핫 밈을 포함하여 80개 이상의 EMO 템플릿을 첫 번째 배치로 출시했습니다. '보보치킨', '백핸드', '드로우' 등이 있지만 현재 커스텀 오디오는 지원되지 않습니다.

이 사이트는 EMO 공식 홈페이지에 첨부되어 있습니다:

공식 프로젝트 홈페이지: https://humanaigc.github.io/emote-portrait-alive/

arXiv 연구 논문: https:/ /arxiv.org/abs/2402.17485

GitHub:https://github.com/HumanAIGC/EMO(모델 및 소스 코드는 오픈 소스임)

주요 기능 EMO

EMO 오디오로 비디오 생성: EMO는 사전 녹음된 비디오 클립이나 3D 얼굴 모델에 의존하지 않고 대화나 노래와 같은 입력 오디오에서 직접 비디오를 생성할 수 있습니다.

표현력이 뛰어나고 사실적입니다. EMO로 생성된 비디오는 표현력이 뛰어나 미묘한 미세 표현, 오디오 리듬에 맞는 머리 움직임 등 인간 얼굴 표정의 뉘앙스를 포착하고 재현할 수 있습니다.

원활한 프레임 전환: EMO는 비디오 프레임 간의 전환이 자연스럽고 부드럽게 이루어지도록 보장하여 얼굴 왜곡이나 프레임 간 지터 문제를 방지하여 비디오의 전반적인 품질을 향상시킵니다.

신원 보존: EMO는 FrameEncoding 모듈을 통해 비디오 생성 과정에서 캐릭터 신원의 일관성을 유지하여 캐릭터의 외모가 입력 참조 이미지와 일치하는지 확인할 수 있습니다.

안정적인 제어 메커니즘: EMO는 속도 컨트롤러, 안면 영역 컨트롤러 등 안정적인 제어 메커니즘을 채택하여 비디오 생성 중 안정성을 높이고 비디오 충돌과 같은 문제를 방지합니다.

유연한 비디오 지속 시간: EMO는 입력 오디오의 길이에 따라 모든 길이의 비디오를 생성하여 사용자에게 유연하고 창의적인 공간을 제공할 수 있습니다.

교차 언어 및 교차 스타일: EMO의 훈련 데이터 세트는 중국어, 영어는 물론 사실주의, 애니메이션, 3D 스타일을 포함한 다양한 언어와 스타일을 포함하므로 EMO가 다양한 문화와 스타일에 적응할 수 있습니다. 예술적 스타일.

위 내용은 Alibaba Cloud는 사진과 오디오를 사용하여 노래하는 비디오를 생성하는 Tongyi App에서 자체 개발한 EMO 모델 출시를 발표했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!