하이브리드 깊이를 도입한 DeepMind의 새로운 디자인은 Transformer 효율성을 크게 향상시킬 수 있습니다.

논문 제목: Mixture-of-Depths: 동적으로 컴퓨팅 할당 변환기 기반 언어 모델 논문 주소: https://arxiv.org/pdf/2404.02258.pdf

정적 컴퓨팅 예산을 기존의 동등한 수준보다 낮게 설정합니다. Transformer에 필요한 계산 방법은 모듈 계산(즉, self-attention 모듈 및 후속 MLP)에 참여할 수 있는 시퀀스의 토큰 수를 제한하는 것입니다. 예를 들어 일반 변환기는 시퀀스의 모든 토큰이 self-attention 계산에 참여하도록 허용할 수 있지만 MoD 변환기는 시퀀스에서 토큰의 50%만 사용하도록 제한할 수 있습니다. 각 토큰에는 스칼라 가중치를 제공하는 라우팅 알고리즘이 있습니다. 이 가중치는 모듈 계산에 참여할지 아니면 우회할지 여부와 같이 각 토큰의 라우팅 선호도를 나타냅니다. 각 모듈에서 상위 k개의 가장 큰 스칼라 가중치를 찾으면 해당 토큰이 모듈 계산에 참여합니다. k개의 토큰만 이 모듈의 계산에 참여해야 하므로 계산 그래프와 텐서 크기는 훈련 과정에서 정적입니다. 이러한 토큰은 라우팅 알고리즘에 의해 인식되는 동적 및 컨텍스트 관련 토큰입니다.

위 내용은 DeepMind는 Transformer를 업그레이드하여 순방향 패스 FLOP를 최대 절반까지 줄일 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

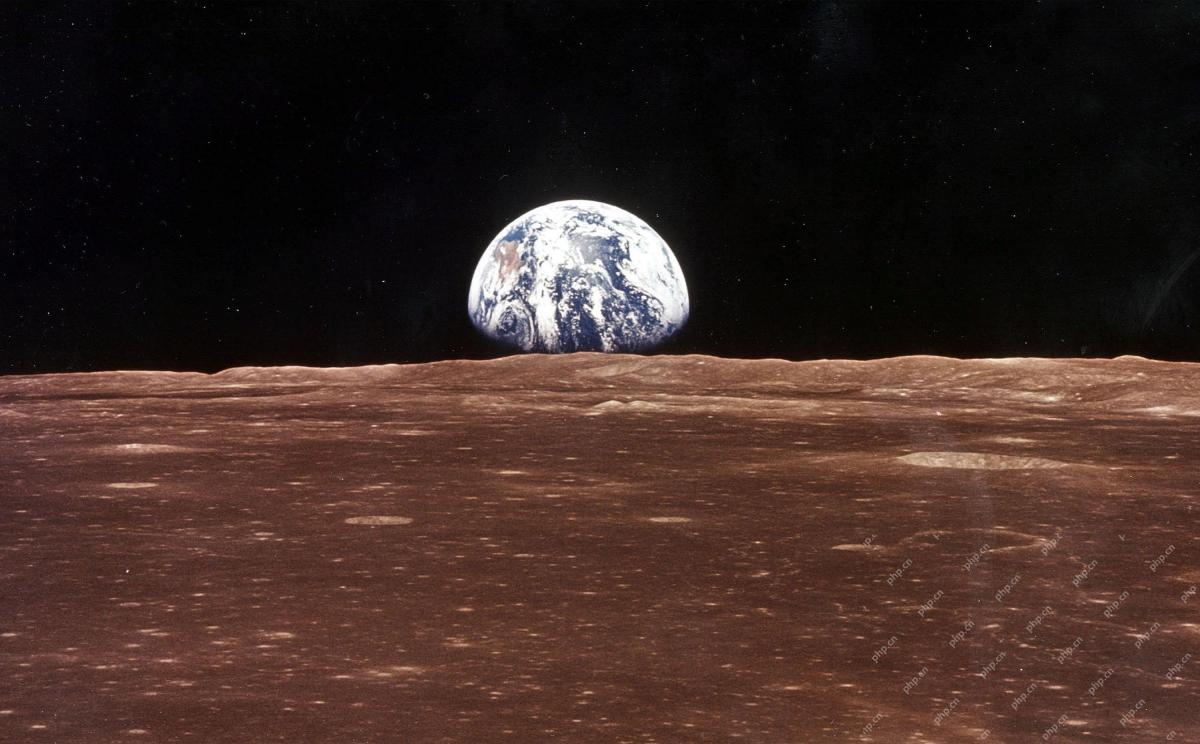

AI 우주 회사가 탄생했습니다May 12, 2025 am 11:07 AM

AI 우주 회사가 탄생했습니다May 12, 2025 am 11:07 AM이 기사는 AI가 Tomorrow.io를 사용하여 우주 산업에 혁명을 일으키는 방법을 보여줍니다. Core에서 AI로 제작되지 않은 SpaceX와 같은 기존의 우주 회사와 달리 Tomorrow.io는 AI- 기업입니다. 탐험합시다

인도의 기계 학습 인턴쉽 10 (2025)May 12, 2025 am 10:47 AM

인도의 기계 학습 인턴쉽 10 (2025)May 12, 2025 am 10:47 AM인도에 꿈의 기계 학습 인턴쉽을 착륙 시키십시오 (2025)! 학생과 초기 전문가에게는 기계 학습 인턴쉽이 보람있는 경력을위한 완벽한 런치 패드입니다. 최첨단 제나에서 다양한 부문의 인도 기업

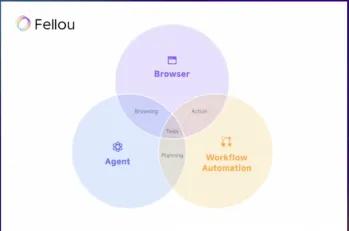

Fellou ai를 시도하고 Google 및 Chatgpt에 작별 인사May 12, 2025 am 10:26 AM

Fellou ai를 시도하고 Google 및 Chatgpt에 작별 인사May 12, 2025 am 10:26 AM온라인 브라우징의 환경은 작년에 상당한 변화를 겪었습니다. 이러한 변화는 Perplexity 및 Copilot과 같은 플랫폼의 향상된 개인 검색 결과로 시작되었으며 Chatgpt의 Web S 통합으로 가속화되었습니다.

개인 해킹은 꽤 치열한 곰이 될 것입니다May 11, 2025 am 11:09 AM

개인 해킹은 꽤 치열한 곰이 될 것입니다May 11, 2025 am 11:09 AM사이버 공격이 발전하고 있습니다. 일반 피싱 이메일의 시대는 지났습니다. 사이버 범죄의 미래는 과인간화되어 온라인 데이터와 AI를 활용하여 고도로 표적화 된 공격을 만들어냅니다. 당신의 직업을 아는 사기꾼을 상상해보십시오. f

교황 레오 XIVMay 11, 2025 am 11:07 AM

교황 레오 XIVMay 11, 2025 am 11:07 AM시카고 출신의 로버트 프랜시스 프레 보스 (Robert Francis Prevost)는 카디널스 대학 (Cardinals) 대학의 첫 연설에서 새로 선출 된 교황 레오 14 세는 교황 (1878-1903)이 자동차의 새벽과 일치하는 교황 레오 XIII의 영향에 대해 논의했다.

초보자 및 전문가를위한 Fastapi -MCP 튜토리얼 - 분석 VidhyaMay 11, 2025 am 10:56 AM

초보자 및 전문가를위한 Fastapi -MCP 튜토리얼 - 분석 VidhyaMay 11, 2025 am 10:56 AM이 튜토리얼은 MCP (Model Context Protocol) 및 Fastapi를 사용하여 LLM (Large Language Model)을 외부 도구와 통합하는 방법을 보여줍니다. Fastapi를 사용하여 간단한 웹 응용 프로그램을 구축하고이를 MCP 서버로 변환하여 L을 활성화합니다.

DIA-1.6B TTS : 최고의 텍스트-다이얼그 생성 모델-분석 VidhyaMay 11, 2025 am 10:27 AM

DIA-1.6B TTS : 최고의 텍스트-다이얼그 생성 모델-분석 VidhyaMay 11, 2025 am 10:27 AMDIA-1.6B : 자금이없는 두 명의 학부생이 개발 한 획기적인 텍스트 음성 연설 모델을 탐색하십시오! 이 16 억 개의 매개 변수 모델은 웃음과 재채기와 같은 비언어적 신호를 포함하여 현저하게 현실적인 연설을 생성합니다. 이 기사 안내서

AI가 멘토링을 그 어느 때보 다 의미있게 만들 수있는 3 가지 방법May 10, 2025 am 11:17 AM

AI가 멘토링을 그 어느 때보 다 의미있게 만들 수있는 3 가지 방법May 10, 2025 am 11:17 AM나는 진심으로 동의합니다. 나의 성공은 멘토의지도와 불가분의 관계입니다. 특히 비즈니스 관리에 관한 그들의 통찰력은 나의 믿음과 관행의 기반을 형성했습니다. 이 경험은 멘토에 대한 나의 약속을 강조합니다

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

SublimeText3 영어 버전

권장 사항: Win 버전, 코드 프롬프트 지원!

에디트플러스 중국어 크랙 버전

작은 크기, 구문 강조, 코드 프롬프트 기능을 지원하지 않음

ZendStudio 13.5.1 맥

강력한 PHP 통합 개발 환경

안전한 시험 브라우저

안전한 시험 브라우저는 온라인 시험을 안전하게 치르기 위한 보안 브라우저 환경입니다. 이 소프트웨어는 모든 컴퓨터를 안전한 워크스테이션으로 바꿔줍니다. 이는 모든 유틸리티에 대한 액세스를 제어하고 학생들이 승인되지 않은 리소스를 사용하는 것을 방지합니다.

VSCode Windows 64비트 다운로드

Microsoft에서 출시한 강력한 무료 IDE 편집기