CVPR\'24 | LightDiff: 저조도 장면의 확산 모델로 밤을 직접 조명합니다!

- 王林앞으로

- 2024-04-15 12:40:121153검색

원제: Light the Night: A Multi-Condition Diffusion Framework for Unpaired Low-Light Enhancement in Autonomous Driving

논문 링크: https://arxiv.org/pdf/2404.04804.pdf

저자 소속: Cleveland State University University of Texas at Austin A*STAR New York University, University of California, Los Angeles

논문 아이디어:

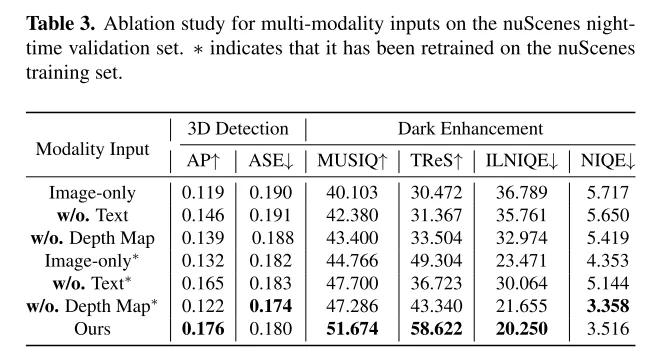

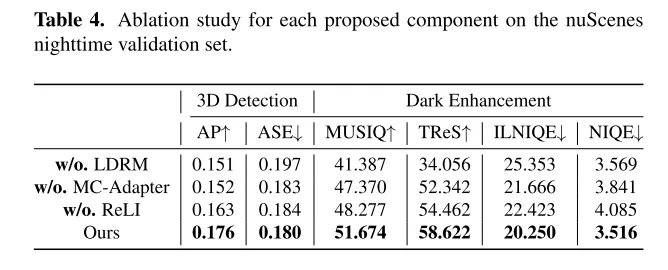

LightDiff는 자율주행의 시각 중심 인식 시스템의 효율성과 확장성을 향상시키는 기술입니다. LiDAR 시스템은 최근 상당한 주목을 받았습니다. 그러나 이러한 시스템은 저조도 조건에서 어려움을 겪는 경우가 많으며 잠재적으로 성능과 안전에 영향을 미칠 수 있습니다. 이 문제를 해결하기 위해 이 기사에서는 자율 주행 애플리케이션에서 저조도 이미지 품질을 개선하도록 설계된 자동화된 프레임워크인 LightDiff를 소개합니다. 구체적으로 본 논문에서는 다중 조건 제어 확산 모델을 채택합니다. LightDiff는 쌍별 데이터를 수동으로 수집할 필요가 없으며 대신 동적 데이터 저하 프로세스를 활용합니다. 깊이 맵, RGB 이미지, 텍스트 캡션 등 다양한 양식의 입력 가중치를 적응적으로 제어하여 저조도 및 저조도 조건에서 콘텐츠 일관성을 동시에 유지할 수 있는 새로운 다중 조건 어댑터가 통합되어 있습니다. 또한, LightDiff는 증강된 이미지를 탐지 모델의 지식과 일치시키기 위해 퍼셉트론별 점수를 보상으로 사용하여 강화 학습을 통한 확산 훈련 프로세스를 안내합니다. NuScenes 데이터세트에 대한 광범위한 실험에서는 LightDiff가 야간 조건에서 여러 최첨단 3D 감지기의 성능을 크게 향상시키는 동시에 높은 시각적 품질 점수를 달성하여 자율 주행 안전을 보장할 수 있는 잠재력을 강조할 수 있음을 보여줍니다.

주요 기여:

본 논문에서는 자율 주행에서 저조도 카메라 이미지를 향상시켜 광범위한 야간 데이터 수집의 필요성을 줄이고 주간 성능을 유지하기 위한 조명 확산(LightDiff) 모델을 제안합니다.

본 논문에서는 깊이 맵과 이미지 캡션을 포함한 여러 입력 모드를 통합하고, 높은 시각적 품질을 유지하면서 이미지 변환 시 의미 무결성을 보장하기 위한 다중 조건 어댑터를 제안합니다. 본 논문에서는 효율적인 모델 훈련을 달성하기 위해 주간 데이터에서 주야간 이미지 쌍을 생성하는 실용적인 프로세스를 채택합니다.

이 문서에서는 확산 프로세스가 인간의 시각적 인식에 도움이 되는 강점을 갖고 지각 모델 수행을 활용하도록 하기 위해 지각적으로 맞춤화된 도메인 지식(신뢰할 수 있는 LiDAR 및 통계 분포의 일관성)과 결합된 강화 학습을 사용하는 미세 조정 메커니즘을 소개합니다. 지각 모델링. 이 방법은 인간의 시각적 인식에 있어 상당한 이점을 가지며, 지각 모델의 장점도 가지고 있습니다.

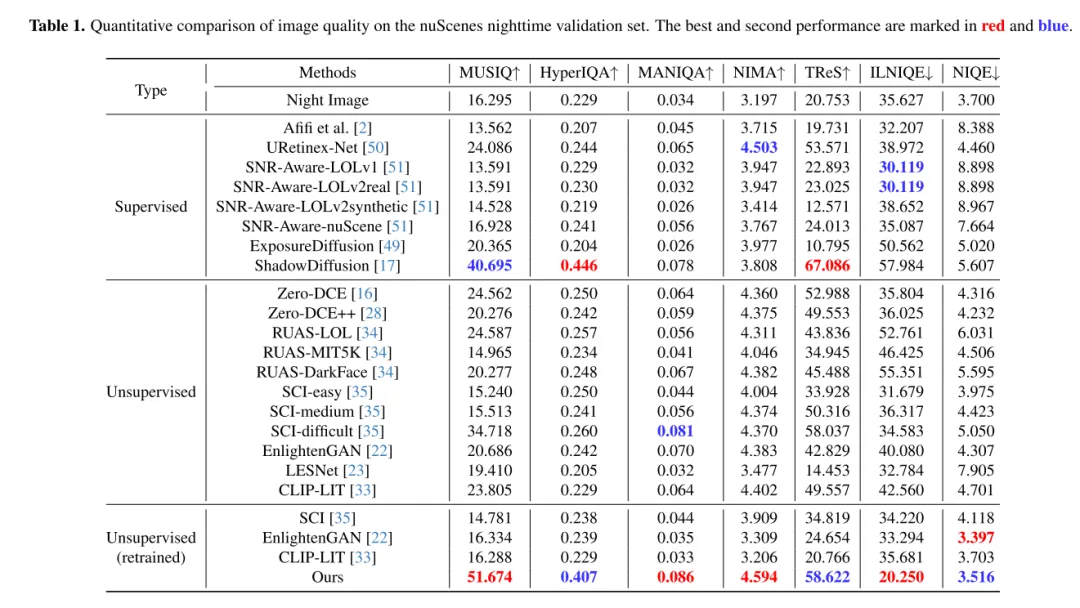

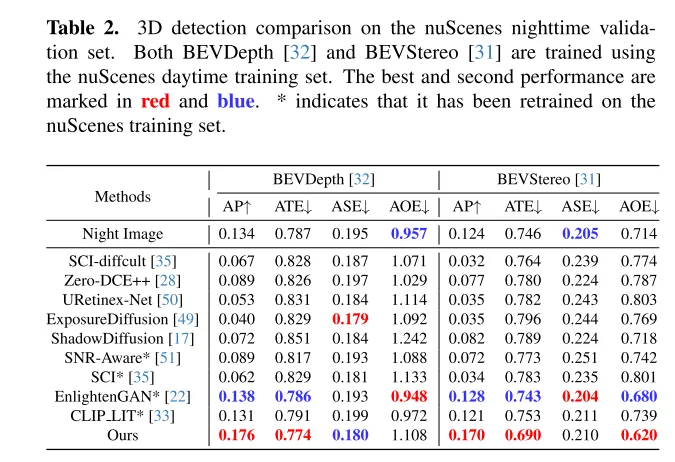

nuScenes 데이터세트에 대한 광범위한 실험에서는 LightDiff가 야간의 3D 차량 감지 성능을 크게 향상시키고 여러 시야각 측정 항목에서 다른 생성 모델보다 성능이 뛰어난 것으로 나타났습니다.

웹 디자인:

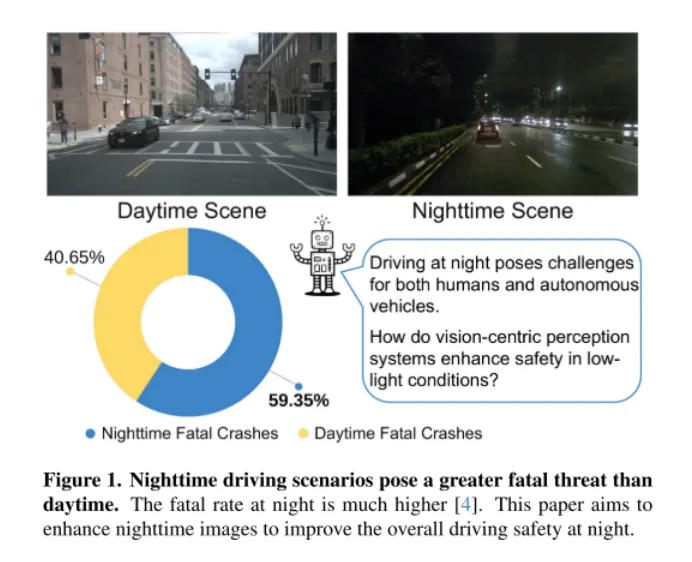

그림 1. 밤의 운전 시나리오는 낮보다 더 치명적입니다. 밤에는 사망률이 훨씬 높습니다 [4]. 이 글은 야간 운전의 전반적인 안전성을 향상시키기 위해 야간 이미지를 향상시키는 것을 목표로 합니다.

그림 1에서 볼 수 있듯이 야간 운전은 인간에게 어려운 일이며, 특히 자율주행차의 경우 더욱 그렇습니다. 이 과제는 2018년 3월 18일 Uber Advanced Technologies Group의 자율주행차가 애리조나에서 보행자를 들이받아 사망한 재앙적인 사건으로 강조되었습니다[37]. 저조도 환경에서 차량이 보행자를 정확하게 감지하지 못해 발생한 이번 사건은 특히 이러한 까다로운 환경에서 자율주행차의 안전 문제를 전면에 불러일으켰습니다. 비전 중심 자율 주행 시스템이 카메라 센서에 점점 더 의존함에 따라, 차량의 전반적인 안전을 보장하기 위해 저조도 조건에서 안전 문제를 해결하는 것이 점점 더 중요해지고 있습니다.

직관적인 해결책은 대량의 야간 운전 데이터를 수집하는 것입니다. 그러나 이 방법은 노동집약적이고 비용이 많이 들 뿐만 아니라, 야간과 주간의 영상 분포 차이로 인해 주간 모델의 성능을 저하시킬 수도 있다. 이러한 과제를 해결하기 위해 이 논문에서는 수동 데이터 수집의 필요성을 없애고 주간 모델 성능을 유지하는 새로운 접근 방식인 조명 확산(LightDiff) 모델을 제안합니다.

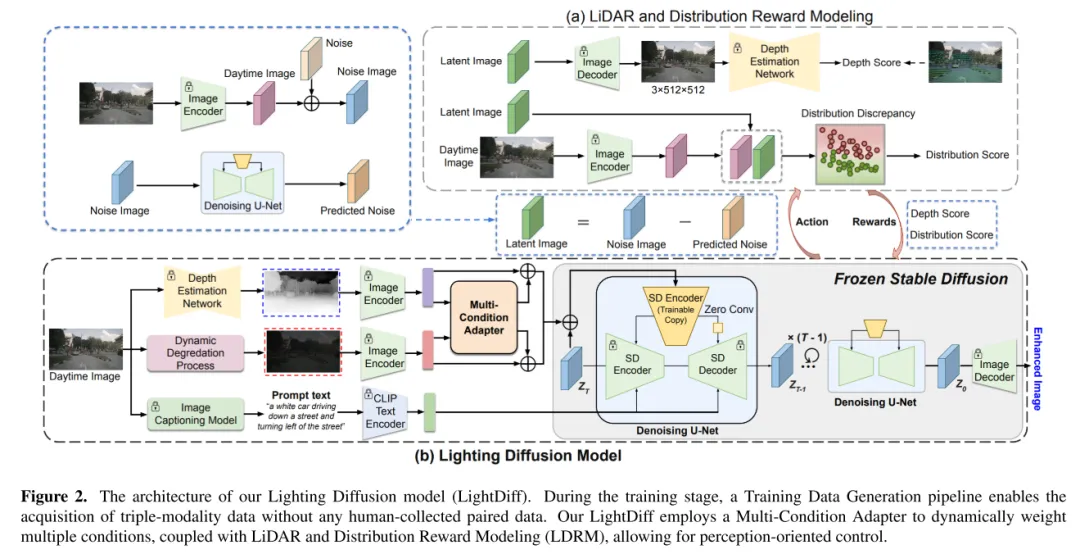

LightDiff의 목표는 저조도 카메라 이미지를 향상하고 지각 모델의 성능을 향상시키는 것입니다. LightDiff는 동적 저조도 감쇠 프로세스를 사용하여 기존 주간 데이터로부터 훈련을 위한 합성 주야간 이미지 쌍을 생성합니다. 다음으로, 이 논문에서는 야간 장면을 주간 장면으로 효과적으로 변환하는 고품질 시각 효과를 생성할 수 있는 Stable Diffusion[44] 기술을 채택합니다. 그러나 원래의 Stable Diffusion 모델이 직면했던 과제였던 자율주행에서는 의미적 일관성을 유지하는 것이 매우 중요합니다. 이를 극복하기 위해 LightDiff는 추정 깊이 맵 및 카메라 이미지 캡션과 같은 여러 입력 양식을 다중 조건 어댑터와 결합합니다. 이 어댑터는 각 입력 형식의 가중치를 지능적으로 결정하여 높은 시각적 품질을 유지하면서 변환된 이미지의 의미적 무결성을 보장합니다. 인간의 시각뿐만 아니라 인식 모델에 대해서도 확산 프로세스를 더 밝게 하기 위해 이 백서에서는 강화 학습을 사용하여 이 백서의 LightDiff를 미세 조정하고 인식에 맞게 조정된 도메인 지식을 루프에 추가합니다. 이 논문은 자율 주행 데이터 세트인 nuScenes[7]에 대한 광범위한 실험을 수행하고 LightDiff가 두 가지 최첨단 모델인 BEVDepth[32] 및 BEVStereo에 대한 야간 3D 차량 감지의 평균 정확도(AP)를 크게 향상시킬 수 있음을 보여줍니다. .[31]은 4.2%, 4.6% 개선되었다.

그림 2. 이 기사의 조명 확산 모델(LightDiff) 아키텍처. 훈련 단계에서 훈련 데이터 생성 프로세스를 통해 쌍을 이루는 데이터를 수동으로 수집하지 않고도 삼봉 데이터를 획득할 수 있습니다. 이 백서의 LightDiff는 다중 조건 어댑터를 사용하여 LiDAR 및 분산 보상 모델링(LDRM)과 결합된 여러 조건에 동적으로 가중치를 부여하여 인식 중심 제어를 가능하게 합니다.

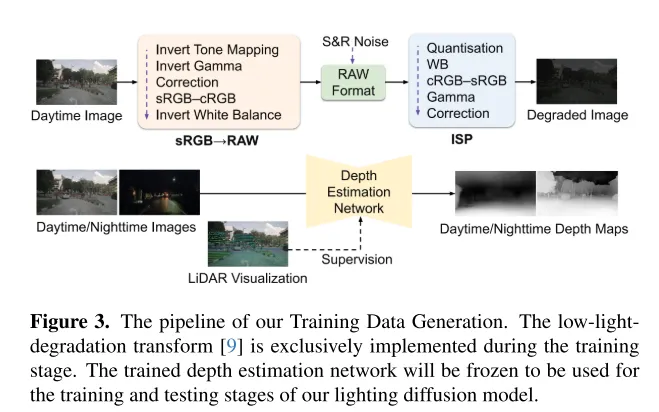

그림 3. 이 기사의 훈련 데이터 생성 프로세스. 저조도 저하 변환[9]은 훈련 단계에서만 구현됩니다. 훈련된 깊이 추정 네트워크는 동결되어 이 문서의 조명 확산 모델의 훈련 및 테스트 단계에 사용됩니다.

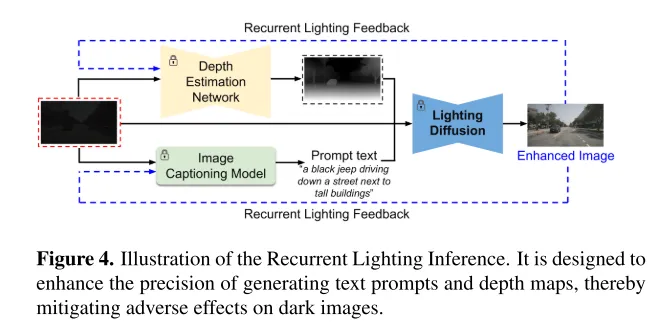

그림 4. 반복 조명 추론의 개략도. 텍스트 힌트 및 깊이 맵 생성의 정확성을 향상시켜 어두운 이미지의 해로운 영향을 완화하도록 설계되었습니다.

실험 결과:

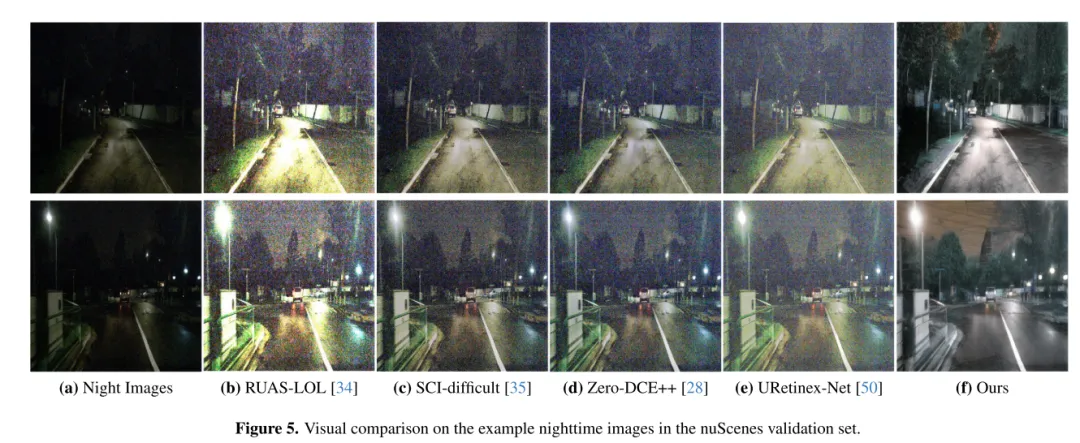

그림 5. nuScenes 검증 세트의 야간 이미지 샘플에 대한 시각적 비교.

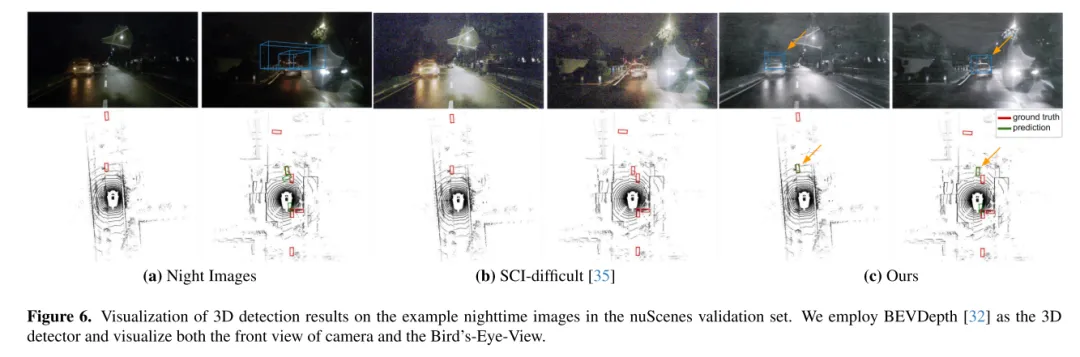

그림 6. nuScenes 검증 세트의 샘플 야간 이미지에 대한 3D 감지 결과 시각화. 본 논문에서는 BEVDepth[32]를 3차원 검출기로 사용하여 카메라의 정면도와 Bird's-Eye-View를 시각화한다.

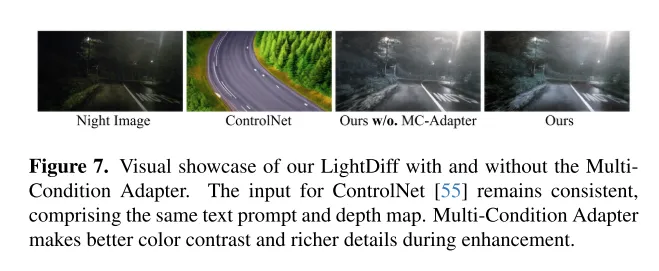

그림 7. MultiCondition Adapter가 있거나 없는 이 기사의 LightDiff의 시각적 효과를 보여줍니다. ControlNet [55]에 대한 입력은 동일한 텍스트 큐 및 깊이 맵을 포함하여 일관되게 유지됩니다. 다중 조건 어댑터를 사용하면 향상 중에 더 나은 색상 대비와 더 풍부한 세부 정보를 얻을 수 있습니다.

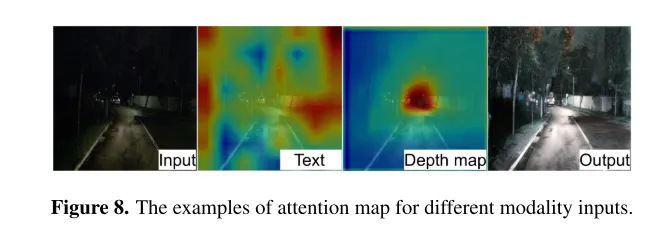

그림 8. 다양한 모달 입력에 대한 주의 지도의 예.

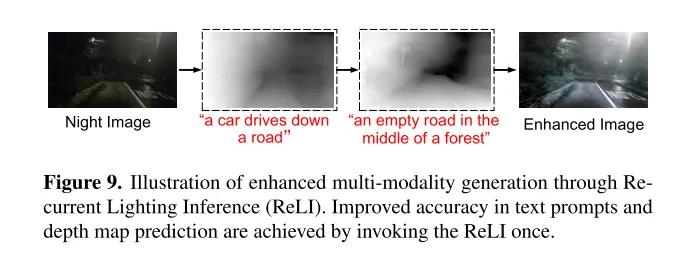

그림 9. ReLI(반복 조명 추론)를 통한 향상된 다중 모드 생성의 개략도. ReLI를 한 번 호출하면 텍스트 힌트 및 깊이 맵 예측의 정확도가 향상됩니다.

요약:

이 기사에서는 저조도 환경에서 이미지 품질을 개선하고 인식으로 인해 직면한 비전 중심 문제를 완화하는 것을 목표로 하는 자율 주행 애플리케이션용으로 설계된 도메인별 프레임워크인 LightDiff를 소개합니다. 시스템. 동적 데이터 저하 프로세스, 다양한 입력 양식에 대한 다중 조건 어댑터, 강화 학습을 사용한 지각별 점수 기반 보상 모델링을 활용함으로써 LightDiff는 nuScenes 데이터세트의 야간 이미지 품질과 3D 성능을 크게 향상시킵니다. 차량 감지 성능. 이 혁신은 대량의 야간 데이터가 필요하지 않을 뿐만 아니라 이미지 변환의 의미 무결성을 보장하여 자율 주행 시나리오에서 안전성과 신뢰성을 향상시킬 수 있는 잠재력을 보여줍니다. 사실적인 주야간 이미지 쌍이 없으면 어두운 주행 이미지를 자동차 조명과 합성하기가 매우 어려워 이 분야에 대한 연구가 제한됩니다. 향후 연구는 고품질 교육 데이터를 더 잘 수집하거나 생성하는 데 중점을 둘 수 있습니다.

인용:

@ARTICLE{2024arXiv240404804L,

author = {{Li}, Jinlong 및 {Li}, Baolu 및 {Tu}, Zhengzhong 및 {Liu}, Xinyu 및 {Guo}, Qing 및 {Juefei- Xu}, Felix 및 {Xu}, Runsheng 및 {Yu}, Hongkai},

title = "{Light the Night: A Multi-Condition Diffusion Framework for Unpaired Low-Light Enhancement in Autonomous Driving}",

journal = {arXiv e-prints},

keywords = {컴퓨터 과학 - 컴퓨터 비전 및 패턴 인식},

연도 = 2024,

월 = 4월,

eid = {arXiv:2404.04804},

pages = {arXiv:2404.04804},

doi = {10.48550/arXiv.2404.04804},

archivePrefix = {arXiv},

eprint = {2404.04804},

primaryClass = {cs.CV},

adsurl = {https://ui.adsabs.harvard.edu/abs/2024arXiv240404804L },

adsnote = {SAO/NASA 천체 물리학 데이터 시스템에서 제공}

}

위 내용은 CVPR\'24 | LightDiff: 저조도 장면의 확산 모델로 밤을 직접 조명합니다!의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!