Vision Pro를 사용하여 로봇 개를 실시간으로 훈련시키세요! MIT 박사과정생 오픈소스 프로젝트 인기

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2024-03-12 21:40:02789검색

Vision Pro에는 또 다른 뜨거운 새로운 게임 플레이가 있습니다. 이번에는 구체화된 지능과 연결됩니다~

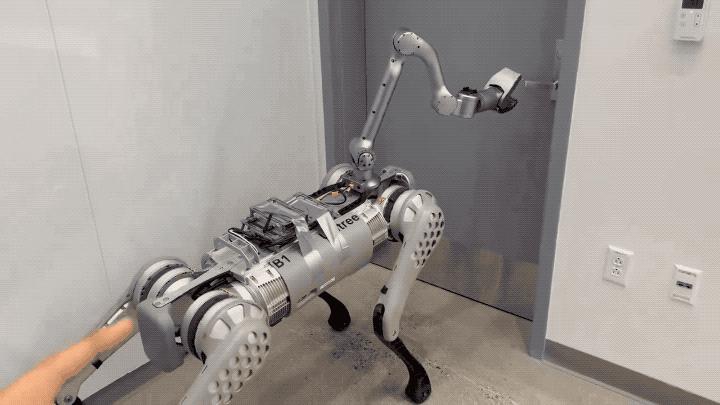

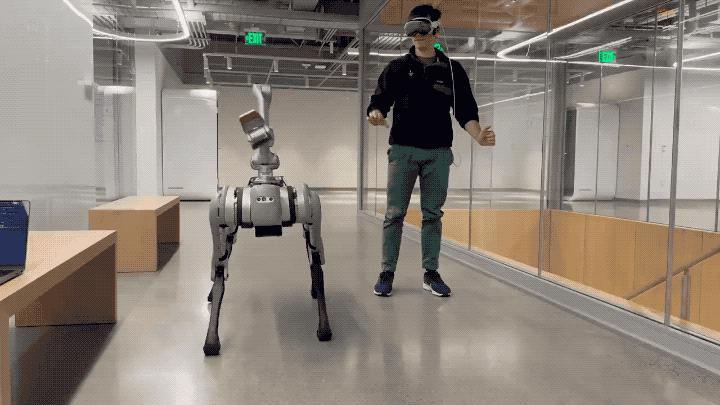

이렇게 MIT 남자는 Vision Pro의 핸드 트래킹 기능을 사용하여 로봇견의 실시간 제어에 성공했습니다.

문을 여는 등의 동작을 정확하게 할 수 있을 뿐만 아니라 지연도 거의 없습니다.

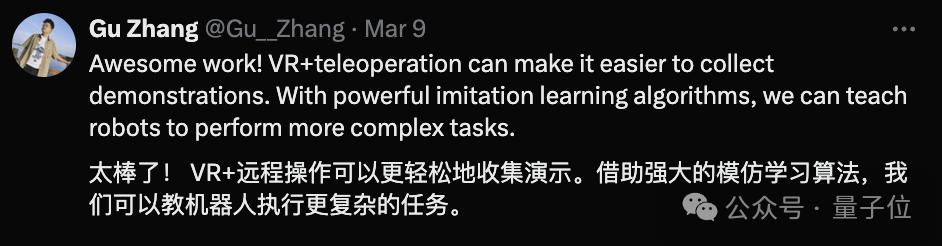

데모가 나오자마자 네티즌들은 구스걸을 칭찬했을 뿐만 아니라 다양한 체화지능 연구자들도 열광했습니다.

예를 들어 칭화 대학교의 박사 과정 학생은 다음과 같습니다.

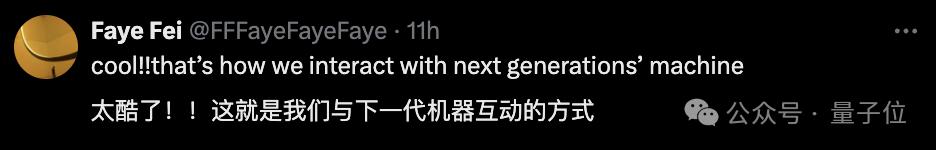

어떤 사람들은 다음과 같이 대담하게 예측합니다. 이것이 우리가 차세대 기계와 상호 작용하는 방식입니다.

저자가 개발한 앱인 Tracking Steamer를 자세히 살펴보겠습니다.

저자가 개발한 앱인 Tracking Steamer를 자세히 살펴보겠습니다.

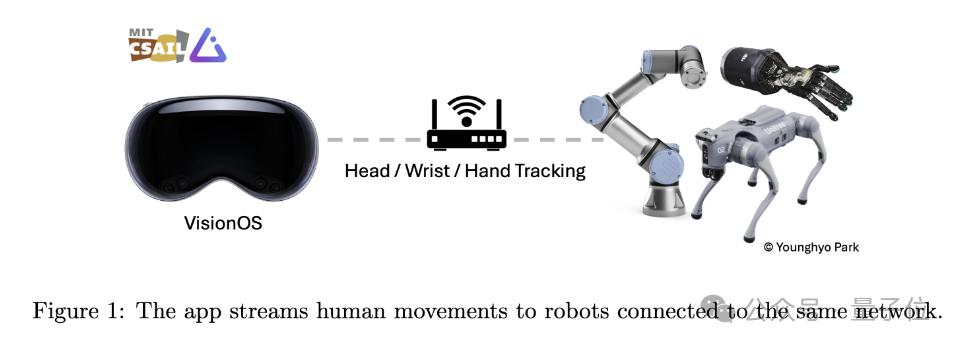

이름에서 알 수 있듯이 이 애플리케이션은 Vision Pro를 사용하여 인간의 움직임을 추적하고 이러한 움직임 데이터를 동일한 Wi-Fi를 사용하는 다른 로봇 장치에 실시간으로 전송하도록 설계되었습니다.

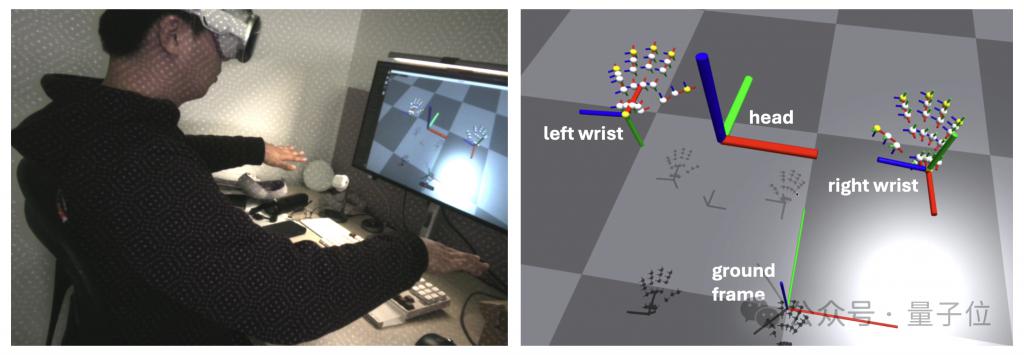

모션 추적 부분은 주로 Apple의 ARKit 라이브러리에 의존합니다.

머리 추적은 queryDeviceAnchor를 호출합니다. 사용자는 Digital Crown을 길게 눌러 헤드 프레임을 현재 위치로 재설정할 수 있습니다.

네트워크 통신 측면에서 이 앱은 gRPC를 네트워크 통신 프로토콜로 사용하여 데이터를 스트리밍합니다. 이를 통해 Linux, Mac 및 Windows 장치를 포함한 더 많은 장치에 데이터를 구독할 수 있습니다.

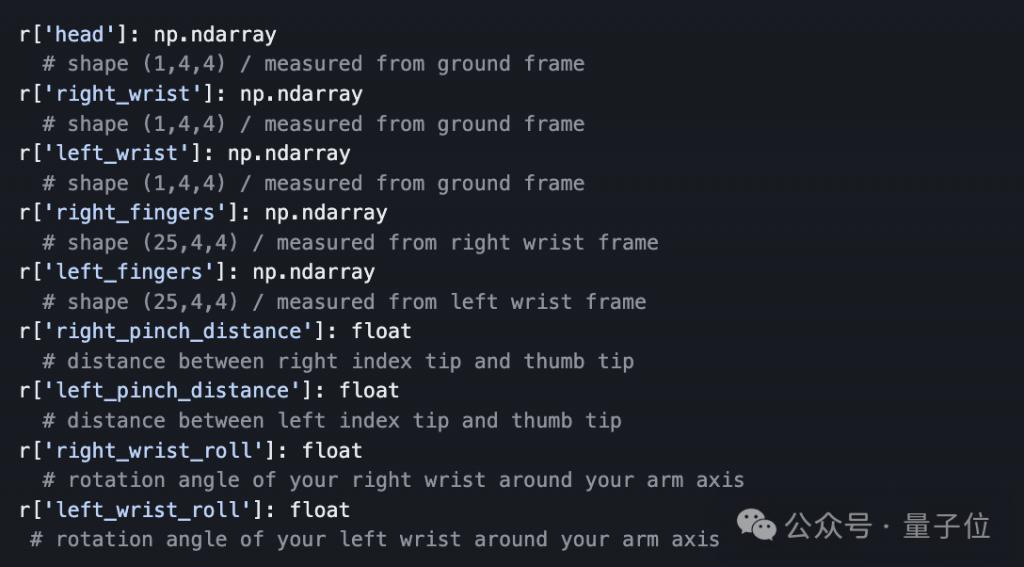

또한 데이터 전송을 용이하게 하기 위해 저자는 개발자가 프로그래밍 방식으로 Vision Pro에서 스트리밍되는 추적 데이터를 구독하고 수신할 수 있는 Python API도 준비했습니다.

많은 전문가들이 지적한 것처럼, 로봇개의 움직임이 여전히 인간에 의해 제어되는지 여부에 관계없이 실제로는 모방 학습 알고리즘과 결합된 "제어" 자체에 비해 인간이 더 많은 능력을 발휘합니다. 이 과정은 로봇 트레이너와 같습니다.

Vision Pro는 사용자의 움직임을 추적하여 직관적이고 간단한 상호 작용 방법을 제공하므로 전문가가 아니더라도 정확한 로봇 훈련 데이터를 제공할 수 있습니다.

위 내용은 Vision Pro를 사용하여 로봇 개를 실시간으로 훈련시키세요! MIT 박사과정생 오픈소스 프로젝트 인기의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!