Intel 오픈 소스 NPU 가속 라이브러리, Core Ultra 프로세서 AI PC는 경량의 대규모 언어 모델을 실행할 수 있습니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2024-03-05 11:13:021654검색

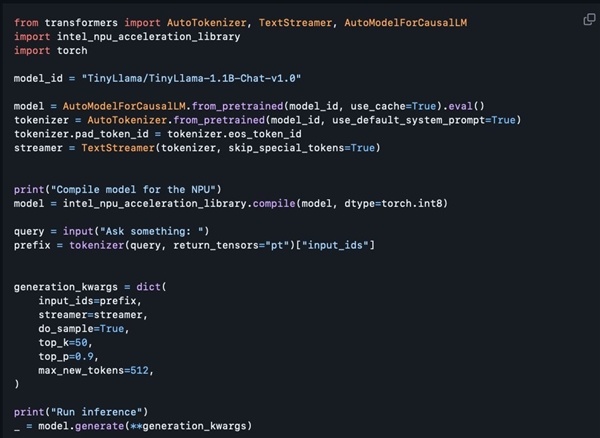

3월 4일자 뉴스에 따르면 Intel은 최근 GitHub에 NPU 가속 라이브러리를 공개했습니다. 이를 통해 Core Ultra 프로세서가 탑재된 AI PC에서 TinyLlama 및 Gemma-2b와 같은 경량의 대규모 언어 모델을 보다 원활하게 실행할 수 있습니다.

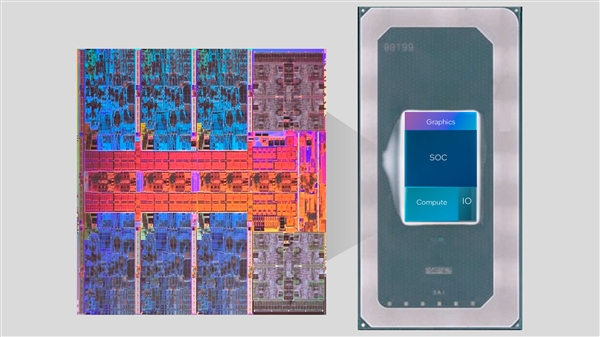

Core Ultra 시리즈는 처음으로 NPU AI 엔진을 통합합니다. 이 엔진은 일부 가벼운 AI 추론 작업을 처리하고 CPU 및 GPU와 함께 작동하여 다양한 AI 애플리케이션의 요구 사항을 충족할 수 있습니다.

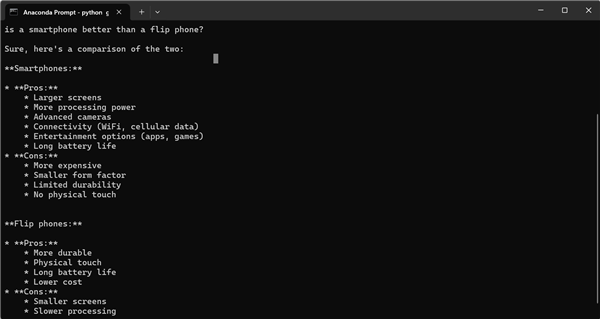

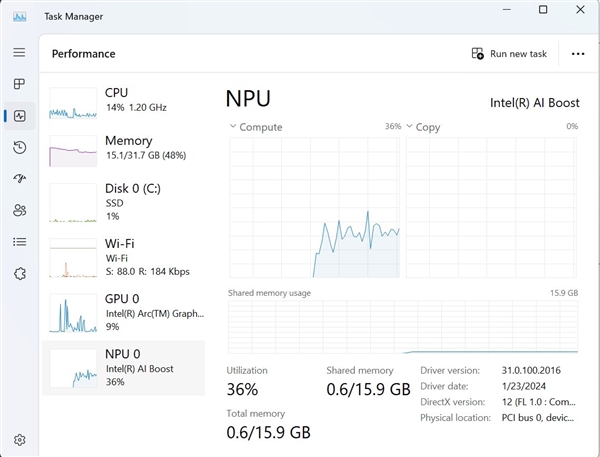

이번에 출시된 NPU 가속 라이브러리는 주로 개발자를 대상으로 준비되었지만 특정 프로그래밍 경험이 있는 사용자도 사용해 볼 수 있는 것으로 이해됩니다. Intel의 소프트웨어 설계자인 Tony Mongkolsmai는 간단한 대화를 수행할 수 있는 MSI Monarch 14 AI Evo 노트북에서 11억 개의 매개변수 TinyLlama 대형 모델을 기반으로 하는 AI 챗봇을 실행하는 방법을 시연했습니다. 동시에 Windows 작업 관리자에는 NPU에 대한 유효한 호출도 표시됩니다.

그러나 현재 오픈 소스 NPU 가속 라이브러리는 여전히 기능면에서 일부 단점이 있습니다. 8비트 양자화 및 FP16 정밀도를 지원하지만 아직 4비트 양자화, BF16 정밀도 및 NPU와 같은 고급 기능을 지원하지 않습니다. /GPU 하이브리드 컴퓨팅 및 관련 기술 문서가 아직 제공되지 않았습니다. 하지만 인텔은 앞으로 점진적으로 기능을 확장하겠다고 약속했는데, 이는 기존 기능을 두 배로 늘려 AI 개발자들에게 의심할 여지 없이 더 많은 편의성과 가능성을 가져다줄 것입니다.

위 내용은 Intel 오픈 소스 NPU 가속 라이브러리, Core Ultra 프로세서 AI PC는 경량의 대규모 언어 모델을 실행할 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!