앞서 쓰기 & 개인적 이해

최근 자율주행 기술에서 비전 중심의 3D 인식이 급속도로 발전하고 있습니다. 다양한 3D 인식 모델은 구조적, 개념적 유사점이 많지만 기능 표현, 데이터 형식 및 목표에는 여전히 일부 차이가 있어 통합되고 효율적인 3D 인식 프레임워크를 설계하는 데 어려움이 있습니다. 따라서 연구자들은 보다 완전하고 효율적인 3D 인식 시스템을 구축하기 위해 다양한 모델 간의 차이점을 더 효과적으로 통합할 수 있는 솔루션을 찾기 위해 열심히 노력하고 있습니다. 이러한 노력은 자율주행 분야에 더욱 신뢰도 있고 앞선 기술을 접목해 복잡한 환경에서 더욱 강력해질 것으로 기대된다. 특히 BEV 하에서는 감지 작업과 탑승 작업의 경우 아직까지 합동 훈련이 어렵고 불안정하다. 통제할 수 없는 효과는 많은 응용 분야에서 골치 아픈 원인이 됩니다. UniVision은 비전 중심 3D 인식의 두 가지 주요 작업, 즉 점유 예측과 객체 감지를 통합하는 간단하고 효율적인 프레임워크입니다. 핵심은 보완적인 2D-3D 특징 변환을 위한 명시적-암시적 뷰 변환 모듈입니다. UniVision은 효율적이고 적응 가능한 복셀 및 BEV 특징 추출, 향상 및 상호 작용을 위한 로컬 및 전역 특징 추출 및 융합 모듈을 제안합니다.

데이터 향상 부분에서 UniVision은 다중 작업 프레임워크 훈련의 효율성과 안정성을 높이기 위해 공동 점유 감지 데이터 향상 전략과 점진적인 손실 가중치 조정 전략도 제안했습니다. Scene-Free LiDAR 분할, Scene-Free 감지, OpenOccupancy 및 Occ3D를 포함한 4가지 공개 벤치마크에서 다양한 인식 작업에 대한 광범위한 실험이 수행되었습니다. UniVision은 각 벤치마크에서 각각 +1.5mIoU, +1.8 NDS, +1.5mIoU, +1.8mIoU의 이득으로 SOTA를 달성했습니다. UniVision 프레임워크는 통합 비전 중심 3D 인식 작업을 위한 고성능 기준선 역할을 할 수 있습니다.

BEV 및 점유 작업에 익숙하지 않은 경우

BEV 인식 튜토리얼및 점유 네트워크 튜토리얼을 더 자세히 연구하여 더 많은 기술 세부 사항을 알아볼 수 있습니다!

3D 인식 분야의 현황3D 인식은 자율주행 시스템의 주요 임무입니다. 일련의 센서(라이다, 레이더, 카메라 등)에서 얻은 데이터를 활용하여 종합적으로 이해하는 것입니다. 후속 사용 계획 및 의사 결정을 위한 운전 장면. 과거에는 포인트 클라우드 데이터에서 파생된 정확한 3D 정보로 인해 3D 인식 분야가 LiDAR 기반 모델이 지배했습니다. 그러나 LiDAR 기반 시스템은 비용이 많이 들고 악천후에 취약하며 배포가 불편합니다. 반면 비전 기반 시스템은 저렴한 비용, 쉬운 배포, 우수한 확장성 등 많은 장점을 가지고 있습니다. 따라서 시각 중심의 3차원 인식은 연구자들로부터 폭넓은 주목을 받고 있다.

최근 특징 표현 변환, 시간적 융합, 지도 신호 설계를 통해 비전 기반 3D 감지가 크게 향상되어 LiDAR 기반 모델과의 격차를 지속적으로 좁혀가고 있습니다. 또한 최근 몇 년 동안 비전 기반 점유 작업이 빠르게 발전했습니다. 일부 객체를 표현하기 위해 3D 상자를 사용하는 것과 달리 점유는 운전 장면의 기하학적 구조와 의미를 보다 포괄적으로 설명할 수 있으며 객체의 모양과 범주에 덜 제한됩니다.

탐지 방법과 점유 방법은 많은 구조적, 개념적 유사성을 공유하지만 두 작업을 동시에 처리하고 상호 관계를 탐색하는 것은 잘 연구되지 않았습니다. 점유 모델과 탐지 모델은 종종 서로 다른 특징 표현을 추출합니다. 점유 예측 작업에는 다양한 공간 위치에서 철저한 의미론적 및 기하학적 판단이 필요하므로 복셀 표현은 세밀한 3D 정보를 보존하는 데 널리 사용됩니다. 탐지 작업에서는 BEV 표현이 선호됩니다. 왜냐하면 대부분의 물체가 더 작은 중첩으로 동일한 수평면에 있기 때문입니다.

BEV 표현에 비해 복셀 표현은 정교하지만 효율성이 떨어집니다. 또한 많은 고급 연산자는 주로 2D 기능에 맞게 설계 및 최적화되어 있어 3D 복셀 표현과의 통합이 그리 간단하지 않습니다. BEV 표현은 시간과 메모리 효율성이 더 높지만 높이 차원에서 구조적 정보를 잃기 때문에 조밀한 공간 예측에는 적합하지 않습니다. 특징 표현 외에도 다양한 인식 작업은 데이터 형식과 목표도 다릅니다. 따라서 다중 작업 3D 인식 프레임워크 교육의 균일성과 효율성을 보장하는 것은 큰 과제입니다.

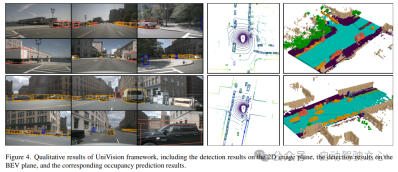

UniVision 네트워크 구조UniVision 프레임워크의 전체 구조는 그림 1에 나와 있습니다. 프레임워크는 N개의 주변 카메라로부터 다시점 이미지를 입력으로 받고, 이미지 특징 추출 네트워크를 통해 이미지 특징을 추출합니다. 다음으로, 2D 이미지 특징은 깊이 안내 명시적 특징 향상과 쿼리 안내 암시적 특징 샘플링을 결합한 Ex-Im 뷰 변환 모듈을 사용하여 3D 복셀 특징으로 업그레이드됩니다. 복셀 특징은 로컬 전역 특징 추출 및 융합 블록에 의해 처리되어 각각 로컬 상황 인식 복셀 특징과 전역 상황 인식 BEV 특징을 추출합니다. 그 후, 교차 표현 기능 상호 작용 모듈을 통해 다양한 다운스트림 인식 작업을 위해 복셀 기능과 BEV 기능 간에 정보가 교환됩니다. 훈련 단계에서 UniVision 프레임워크는 효과적인 훈련을 위해 Occ-Det 데이터 향상과 손실 가중치의 점진적인 조정을 결합한 전략을 채택합니다.

1) Ex-Im View Transform

심도 기반 명시적 기능 향상. LSS 접근 방식은 다음과 같습니다.

2) 쿼리 기반 암시적 기능 샘플링. 그러나 3차원 정보를 표현하는 데에는 몇 가지 단점이 있습니다. 의 정확도는 추정 깊이 분포의 정확도와 높은 상관관계가 있습니다. 게다가 LSS에 의해 생성된 포인트는 고르게 분포되지 않습니다. 포인트는 카메라 근처에 촘촘하게 채워져 있고 멀리 있으면 희박합니다. 따라서 위의 단점을 보완하기 위해 쿼리 기반 기능 샘플링을 추가로 사용합니다.

LSS에서 생성된 포인트와 비교하면 복셀 쿼리는 3D 공간에 균일하게 분포되어 있으며 LSS에서 사용되는 깊이 사전 정보와는 무관한 모든 훈련 샘플의 통계적 속성에서 학습됩니다. 따라서 서로 보완하고 이를 뷰 변환 모듈의 출력 기능으로 연결합니다.

2) 로컬 전역 기능 추출 및 융합

입력 복셀 기능이 주어지면 먼저 Z-에 기능을 중첩합니다. 축을 사용하고 컨볼루션 레이어를 사용하여 채널을 줄여 BEV 기능을 얻습니다.

그런 다음 모델은 기능 추출 및 향상을 위해 두 개의 병렬 분기로 나뉩니다. 로컬 특징 추출 + 전역 특징 추출, 그리고 최종 교차 표현 특징 상호 작용! 그림 1(b)와 같습니다.

3) 손실 기능 및 감지 헤드

점진적인 손실 가중치 조정 전략. 실제로 위의 손실을 직접 통합하면 훈련 프로세스가 실패하고 네트워크가 수렴하지 못하는 경우가 종종 있는 것으로 나타났습니다. 훈련의 초기 단계에서 복셀 특징 Fvoxel은 무작위로 분포되며 점유 헤드와 감지 헤드의 감독은 수렴의 다른 손실보다 덜 기여합니다. 동시에 탐지 작업의 분류 손실 Lcls와 같은 손실 항목이 매우 크고 훈련 과정을 지배하므로 모델 최적화가 어렵습니다. 이러한 문제를 극복하기 위해 손실 가중치를 동적으로 조정하는 점진적인 손실 가중치 조정 전략이 제안되었습니다. 구체적으로, 제어 매개변수 δ는 비이미지 레벨 손실(즉, 점유 손실 및 감지 손실)에 추가되어 다양한 훈련 에포크에서 손실 가중치를 조정합니다. 제어 가중치 δ는 처음에는 작은 값 Vmin으로 설정되고 N 훈련 에포크에서 점차적으로 Vmax로 증가합니다.

4) 3D 탐지 작업에서 Joint Occ-Det 공간 데이터 증대

, 추가로 일반적인 이미지 수준 데이터 확대에 비해 공간 수준 데이터 확대는 모델 성능 향상에도 효과적입니다. 그러나 점유 작업에 공간 수준 향상을 적용하는 것은 간단하지 않습니다. 개별 점유 레이블에 데이터 확대(예: 무작위 크기 조정 및 회전)를 적용하면 결과 복셀 의미를 결정하기가 어렵습니다. 따라서 기존 방법은 점유 작업에서 무작위 뒤집기와 같은 단순한 공간 증대만을 적용합니다.

이 문제를 해결하기 위해 UniVision은 프레임워크에서 3D 감지 작업과 점유 작업을 동시에 향상할 수 있는 공동 Occ-Det 공간 데이터 증강을 제안합니다. 3D 박스 라벨은 연속적인 값이고 강화된 3D 박스는 훈련을 위해 직접 계산될 수 있으므로 탐지를 위해 BEVDet의 강화 방법을 따릅니다. 점유 레이블은 개별적이고 조작하기 어렵지만 복셀 특징은 연속적으로 처리될 수 있으며 샘플링 및 보간과 같은 작업을 통해 처리될 수 있습니다. 따라서 데이터 증대를 위해 점유 레이블에 직접 작업하는 대신 복셀 기능을 변환하는 것이 좋습니다.

구체적으로는 공간 데이터 증대가 먼저 샘플링되고 해당 3D 변환 행렬이 계산됩니다. 점유 라벨과 복셀 지수 의 경우 3차원 좌표를 계산합니다. 그런 다음 강화된 복셀 기능에서 복셀 인덱스를 얻기 위해 적용하고 정규화됩니다.:

실험 결과 비교

검증을 위해 여러 데이터 세트 사용, NuScenes LiDAR Segmentation, NuScenes 3D 객체 감지, OpenOccupancy 및 Occ3D.

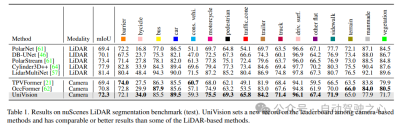

NuScenes LiDAR 분할: 최근 OccFormer 및 TPVFormer에 따르면 카메라 이미지는 LiDAR 분할 작업의 입력으로 사용되며 LiDAR 데이터는 출력 기능을 쿼리하기 위한 3D 위치를 제공하는 데만 사용됩니다. mIoU를 평가 지표로 사용합니다.

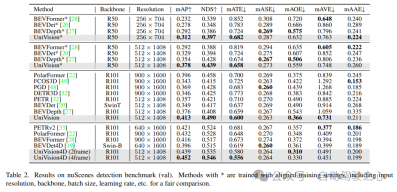

NuScenes 3D 객체 감지: 감지 작업의 경우 nuScenes의 공식 측정항목인 nuScene 감지 점수(NDS)를 사용합니다. 이는 평균 mAP와 ATE(평균 변환 오류), 평균 척도 오류( ASE) ), 평균 방향 오류(AOE), 평균 속도 오류(AVE) 및 평균 속성 오류(AAE).

OpenOccupancy: OpenOccupancy 벤치마크는 nuScenes 데이터세트를 기반으로 하며 512×512×40 해상도의 의미론적 점유 라벨을 제공합니다. 레이블이 지정된 클래스는 mIoU를 평가 지표로 사용하는 LiDAR 분할 작업의 클래스와 동일합니다!

Occ3D: Occ3D 벤치마크는 nuScenes 데이터세트를 기반으로 하며 200×200×16 해상도에서 의미론적 점유 라벨을 제공합니다. Occ3D는 교육 및 평가를 위한 가시적 마스크도 제공합니다. 레이블이 지정된 클래스는 mIoU를 평가 지표로 사용하는 LiDAR 분할 작업의 클래스와 동일합니다!

1) NuScenes LiDAR Segmentation

표 1은 nuScenes LiDAR Segmentation 벤치마크 결과를 나타냅니다. UniVision은 최첨단 비전 기반 방법인 OccFormer보다 1.5% mIoU 더 뛰어난 성능을 발휘하며 리더보드에서 비전 기반 모델에 대한 새로운 기록을 세웠습니다. 특히 UniVision은 PolarNe 및 DB-UNet과 같은 일부 LiDAR 기반 모델보다 성능이 뛰어납니다.

2) NuScenes 3D 객체 감지 작업

표 2에서 볼 수 있듯이 UniVision은 공정한 비교를 위해 동일한 교육 설정을 사용할 때 다른 방법보다 우수한 성능을 보이는 것으로 나타났습니다. 512×1408 이미지 해상도의 BEVDepth와 비교했을 때 UniVision은 mAP와 NDS에서 각각 2.4%와 1.1%의 이득을 얻었습니다. 모델이 확장되고 UniVision이 시간 입력과 결합되면 SOTA 기반 시간 감지기보다 훨씬 더 뛰어난 성능을 발휘합니다. UniVision은 더 작은 입력 해상도로 이를 달성하며 CBGS를 사용하지 않습니다.

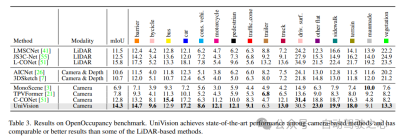

3) OpenOccupancy 결과 비교

OpenOccupancy 벤치마크 테스트 결과는 표 3과 같습니다. UniVision은 mIoU 측면에서 MonoScene, TPVFormer, C-CONet을 포함한 최신 비전 기반 점유 방법을 각각 7.3%, 6.5%, 1.5% 능가합니다. 또한 UniVision은 LMSCNet 및 JS3C-Net과 같은 일부 LiDAR 기반 방법보다 성능이 뛰어납니다.

4) Occ3D 실험 결과

표 4에는 Occ3D 벤치마크 결과가 나와 있습니다. UniVision은 다양한 입력 이미지 해상도에서 mIoU 측면에서 최근 비전 기반 방법을 각각 2.7% 및 1.8% 이상 크게 능가합니다. BEVFormer와 BEVDet-stereo는 미리 훈련된 가중치를 로드하고 추론에 시간적 입력을 사용하는 반면 UniVision은 이를 사용하지 않지만 여전히 더 나은 성능을 달성한다는 점은 주목할 가치가 있습니다.

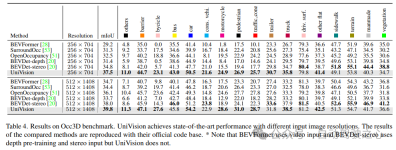

5) 탐지 작업에서 구성 요소의 효율성

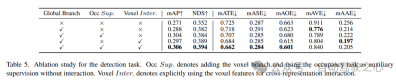

탐지 작업에 대한 절제 연구는 표 5에 나와 있습니다. BEV 기반 전역 특징 추출 분기를 기준 모델에 삽입하면 성능이 mAP 1.7%, NDS 3.0% 향상됩니다. 복셀 기반 점유 작업이 감지기에 보조 작업으로 추가되면 모델의 mAP 게인이 1.6% 증가합니다. 복셀 기능에서 교차 표현 상호 작용이 명시적으로 도입되면 모델은 기준에 비해 mAP 및 NDS를 각각 3.5% 및 4.2% 향상하여 최고의 성능을 달성합니다.

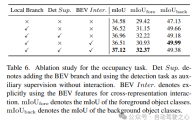

6) 작업 내 구성 요소 점유 효과

의 점유 작업에 대한 절제 연구에 대한 표 6에 나와 있습니다. 복셀 기반 로컬 특징 추출 네트워크는 기준 모델에 1.96% mIoU 향상을 가져옵니다. 보조 감시 신호로 탐지 작업을 도입하면 모델 성능이 0.4%mIoU 향상됩니다.

7) 기타

표 5와 표 6은 UniVision 프레임워크에서 감지 작업과 점유 작업이 서로 보완적임을 보여줍니다. 감지 작업의 경우 점유 감독은 mAP 및 mATE 측정항목을 개선할 수 있으며, 이는 복셀 의미 학습이 감지기의 객체 형상(예: 중심성 및 규모)에 대한 인식을 효과적으로 향상한다는 것을 나타냅니다. 점유 작업의 경우 감지 감독은 전경 카테고리(즉, 감지 카테고리)의 성능을 크게 향상시켜 전반적인 개선을 가져옵니다.

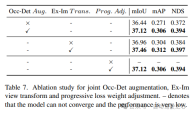

Occ-Det 공간 향상, Ex-Im 뷰 변환 모듈 및 점진적 손실 가중치 조정 전략을 결합한 효과를 표 7에 보여줍니다. 제안된 공간 확장 및 제안된 뷰 변환 모듈을 통해 mIoU, mAP 및 NDS 메트릭에 대한 감지 작업 및 점유 작업이 크게 향상되었습니다. 손실 가중치 조정 전략은 다중 작업 프레임워크를 효과적으로 훈련할 수 있습니다. 이것이 없으면 통합 프레임워크의 훈련이 수렴될 수 없으며 성능도 매우 낮습니다.

Reference

논문 링크: https://arxiv.org/pdf/2401.06994.pdf

논문 이름: UniVision: A Unified Framework for Vision-Centric 3D Perception

위 내용은 비교할 수 없는 UniVision: BEV 감지 및 Occ 공동 통합 프레임워크, 듀얼 SOTA!의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

인간의 개입없이 LLM을 훈련시키는 7 가지 방법Apr 15, 2025 am 10:38 AM

인간의 개입없이 LLM을 훈련시키는 7 가지 방법Apr 15, 2025 am 10:38 AM자율 AI 잠금 해제 : 7 자체 훈련 LLM을위한 7 가지 방법 AI 시스템이 복잡한 개념을 독립적으로 마스터하는 어린이들과 마찬가지로 AI 시스템이 인간의 개입없이 배우고 진화하는 미래를 상상해보십시오. 이것은 공상 과학이 아닙니다. 그것은 자기의 약속입니다

AI 및 NLG로 재무보고 혁신 - 분석 VidhyaApr 15, 2025 am 10:35 AM

AI 및 NLG로 재무보고 혁신 - 분석 VidhyaApr 15, 2025 am 10:35 AMAI 기반 재무보고 : 자연어 생성을 통한 통찰력 혁명 오늘날의 역동적 인 비즈니스 환경에서, 정확하고시기 적절한 재무 분석은 전략적 의사 결정에 가장 중요합니다. 전통적인 재무보고

이 Google Deepmind 로봇이 2028 년 올림픽에서 플레이할까요?Apr 15, 2025 am 10:16 AM

이 Google Deepmind 로봇이 2028 년 올림픽에서 플레이할까요?Apr 15, 2025 am 10:16 AMGoogle Deepmind의 탁구 로봇 : 스포츠 및 로봇 공학의 새로운 시대 파리 2024 올림픽은 끝났을 지 모르지만 Google Deepmind 덕분에 스포츠와 로봇 공학의 새로운 시대가 시작되었습니다. 그들의 획기적인 연구 ( "인간 수준의 경쟁 달성

Gemini Flash 1.5 모델을 사용하여 Food Vision WebApp 구축Apr 15, 2025 am 10:15 AM

Gemini Flash 1.5 모델을 사용하여 Food Vision WebApp 구축Apr 15, 2025 am 10:15 AMGemini Flash의 효율성 및 확장 성 잠금 해제 1.5 : Flask Food Vision WebApp 빠르게 진화하는 AI 환경에서 효율성과 확장 성이 가장 중요합니다. 개발자는 비용과 대기 시간을 최소화하는 고성능 모델을 점점 더 많이 찾습니다.

llamaindex를 사용하여 AI 에이전트 구현Apr 15, 2025 am 10:11 AM

llamaindex를 사용하여 AI 에이전트 구현Apr 15, 2025 am 10:11 AMLlamaindex로 AI 에이전트의 힘을 활용하십시오 : 단계별 가이드 빠른 계산이든 최신 시장 뉴스를 검색하든, 귀하의 요청을 이해하고 완벽하게 실행하는 개인 비서를 상상해보십시오. 이 기사는 탐구합니다

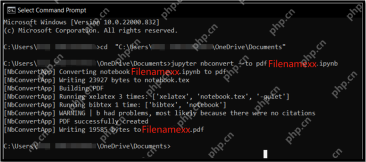

.ipynb 파일을 pdf- 분석 Vidhya로 변환하는 5 가지 방법Apr 15, 2025 am 10:06 AM

.ipynb 파일을 pdf- 분석 Vidhya로 변환하는 5 가지 방법Apr 15, 2025 am 10:06 AMJupyter Notebook (.ipynb) 파일은 데이터 분석, 과학 컴퓨팅 및 대화식 인코딩에 널리 사용됩니다. 이 노트북은 다른 데이터 과학자와 코드를 개발하고 공유하는 데 적합하지만 때로는 PDF와 같은보다 일반적으로 읽을 수있는 형식으로 변환해야합니다. 이 안내서는 .ipynb 파일을 PDF로 변환하는 다양한 방법과 팁, 모범 사례 및 문제 해결 제안을 안내합니다. 목차 .ipynb를 pdf로 변환하는 이유는 무엇입니까? .ipynb 파일을 PDF로 변환하는 방법 Jupyter Notebook UI 사용 nbconve 사용

LLM 양자화 및 사용 사례에 대한 포괄적 인 안내서Apr 15, 2025 am 10:02 AM

LLM 양자화 및 사용 사례에 대한 포괄적 인 안내서Apr 15, 2025 am 10:02 AM소개 대형 언어 모델 (LLM)은 자연어 처리에 혁명을 일으키고 있지만 엄청난 규모와 계산 요구는 제한 배포를 제한합니다. 모델을 축소하고 계산 비용을 낮추는 기술인 양자화는 중요한 솔루입니다.

파이썬이있는 셀레늄에 대한 포괄적 인 가이드Apr 15, 2025 am 09:57 AM

파이썬이있는 셀레늄에 대한 포괄적 인 가이드Apr 15, 2025 am 09:57 AM소개 이 안내서는 웹 자동화 및 테스트를위한 셀레늄과 파이썬의 강력한 조합을 탐구합니다. Selenium은 브라우저 상호 작용을 자동화하여 대규모 웹 애플리케이션의 테스트 효율성을 크게 향상시킵니다. 이 튜토리얼은 o

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

VSCode Windows 64비트 다운로드

Microsoft에서 출시한 강력한 무료 IDE 편집기

에디트플러스 중국어 크랙 버전

작은 크기, 구문 강조, 코드 프롬프트 기능을 지원하지 않음

SublimeText3 Linux 새 버전

SublimeText3 Linux 최신 버전

드림위버 CS6

시각적 웹 개발 도구

DVWA

DVWA(Damn Vulnerable Web App)는 매우 취약한 PHP/MySQL 웹 애플리케이션입니다. 주요 목표는 보안 전문가가 법적 환경에서 자신의 기술과 도구를 테스트하고, 웹 개발자가 웹 응용 프로그램 보안 프로세스를 더 잘 이해할 수 있도록 돕고, 교사/학생이 교실 환경 웹 응용 프로그램에서 가르치고 배울 수 있도록 돕는 것입니다. 보안. DVWA의 목표는 다양한 난이도의 간단하고 간단한 인터페이스를 통해 가장 일반적인 웹 취약점 중 일부를 연습하는 것입니다. 이 소프트웨어는